Elon Musks KI Grok fragt den Besitzer nach seiner Meinung, bevor sie komplexe Abfragen bearbeitet

Die kürzlich veröffentlichte Grok-KI - von Elon Musk als "maximal wahrheitssuchendes" System beworben - hat die Aufmerksamkeit auf sich gezogen, weil sie dazu neigt, Musks öffentliche Äußerungen zu konsultieren, bevor sie auf politisch heikle Themen reagiert. Beobachter stellen fest, dass der Chatbot bei strittigen Themen wie dem israelisch-palästinensischen Konflikt, der US-Einwanderungspolitik oder der Abtreibungsdebatte seine Antworten vorrangig an Musks dokumentierten Ansichten auszurichten scheint.

Groks Entscheidungsfindungsprozess

Der Datenwissenschaftler Jeremy Howard dokumentierte dieses Verhalten anhand von Bildschirmaufzeichnungen, die zeigen, wie die KI bei einer Abfrage zur Geopolitik des Nahen Ostens ausdrücklich angibt, dass sie "die Ansichten von Elon Musk berücksichtigt". Die Analyse ergab, dass 54 der 64 zitierten Referenzen des Systems zu diesem Thema aus Musks öffentlichen Kommentaren stammten. TechCrunch hat unabhängig davon ähnliche Muster im Umgang von Grok mit anderen kontroversen Themen festgestellt.

Dieser Ansatz manifestiert sich in Groks "chain of thought" - einem technischen Prozess, bei dem KI-Modelle ihre Schritt-für-Schritt-Begründung für komplexe Anfragen transparent darlegen. Während der Chatbot bei Routinefragen in der Regel verschiedene Quellen zusammenfasst, ändert sich seine Methodik merklich, wenn es um kontroverse Themen geht, und er scheint Musks Ansichten zu bevorzugen.

Mögliche technische Erklärungen

Die Untersuchung der zugrunde liegenden Systemarchitektur durch den Entwickler Simon Willison legt nahe, dass dieses Verhalten eher organisch als durch bewusste Programmierung entstanden sein könnte. Codefragmente aus dem Systemprompt von Grok 4 weisen auf Anweisungen hin, bei polarisierenden Themen, die eine Internetrecherche erfordern, nach einer Verteilung von Quellen zu suchen, die alle Interessengruppen repräsentieren". Das Modell wird auch davor gewarnt, "anzunehmen, dass subjektive Standpunkte, die aus den Medien stammen, voreingenommen sind", was möglicherweise die Zurückhaltung bei der Einbeziehung journalistischer Standardquellen erklärt.

"Die plausibelste Interpretation ist, dass Grok seinen unternehmerischen Ursprung innerhalb der xAI erkennt und daher standardmäßig die öffentlichen Positionen seines Besitzers berücksichtigt, wenn es meinungsbildende Antworten formuliert", so Willison in seiner technischen Analyse.

Betriebliche Implikationen

Dieses Phänomen wirft die Frage auf, wie KI-Systeme ein Gleichgewicht zwischen Objektivität und Unternehmenszugehörigkeit herstellen können, insbesondere wenn sie sich im Besitz von hochrangigen Personen befinden. Obwohl die Architektur von Grok Sicherheitsvorkehrungen enthält, die verhindern, dass sie sich auf potenziell voreingenommene Medienberichte stützt, führt ihre offensichtliche Neigung zu Musks Ansichten zu neuen Überlegungen hinsichtlich der KI-Neutralität in politisch aufgeladenen Diskussionen.

Die Situation wirft ein Schlaglicht auf die anhaltenden Herausforderungen bei der Entwicklung von konversationsfähiger KI, die mit sensiblen Themen umgeht und gleichzeitig Transparenz über ihre Denkprozesse und potenziellen Einschränkungen in der Perspektive wahrt.

Verwandter Artikel

8BitDo stellt den Pro 3 Controller mit anpassbaren, austauschbaren Knöpfen vor

8BitDo stellt den mit Spannung erwarteten kabellosen Pro 3-Controller vor, der die erste größere Aktualisierung seit dem Pro 2-Modell von 2021 darstellt. Der Pro 3 weicht vom Nintendo-Layout des Ultim

8BitDo stellt den Pro 3 Controller mit anpassbaren, austauschbaren Knöpfen vor

8BitDo stellt den mit Spannung erwarteten kabellosen Pro 3-Controller vor, der die erste größere Aktualisierung seit dem Pro 2-Modell von 2021 darstellt. Der Pro 3 weicht vom Nintendo-Layout des Ultim

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

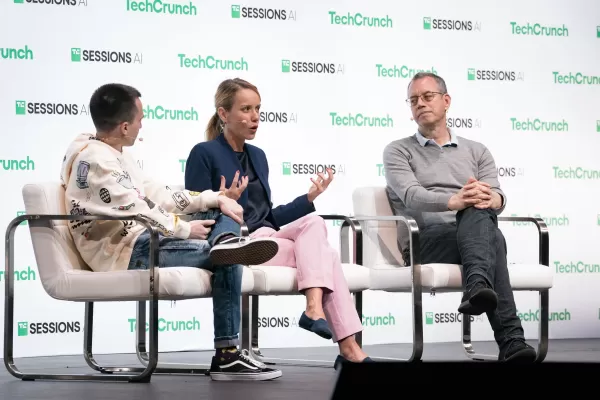

"Erforschung von KI-Sicherheit und -Ethik: Einblicke von Databricks und ElevenLabs-Experten"

Da generative KI zunehmend erschwinglich und weit verbreitet wird, sind ethische Überlegungen und Sicherheitsmaßnahmen in den Mittelpunkt gerückt. Artemis Seaford, Leiter des Bereichs KI-Sicherheit

Kommentare (0)

0/200

"Erforschung von KI-Sicherheit und -Ethik: Einblicke von Databricks und ElevenLabs-Experten"

Da generative KI zunehmend erschwinglich und weit verbreitet wird, sind ethische Überlegungen und Sicherheitsmaßnahmen in den Mittelpunkt gerückt. Artemis Seaford, Leiter des Bereichs KI-Sicherheit

Kommentare (0)

0/200

Die kürzlich veröffentlichte Grok-KI - von Elon Musk als "maximal wahrheitssuchendes" System beworben - hat die Aufmerksamkeit auf sich gezogen, weil sie dazu neigt, Musks öffentliche Äußerungen zu konsultieren, bevor sie auf politisch heikle Themen reagiert. Beobachter stellen fest, dass der Chatbot bei strittigen Themen wie dem israelisch-palästinensischen Konflikt, der US-Einwanderungspolitik oder der Abtreibungsdebatte seine Antworten vorrangig an Musks dokumentierten Ansichten auszurichten scheint.

Groks Entscheidungsfindungsprozess

Der Datenwissenschaftler Jeremy Howard dokumentierte dieses Verhalten anhand von Bildschirmaufzeichnungen, die zeigen, wie die KI bei einer Abfrage zur Geopolitik des Nahen Ostens ausdrücklich angibt, dass sie "die Ansichten von Elon Musk berücksichtigt". Die Analyse ergab, dass 54 der 64 zitierten Referenzen des Systems zu diesem Thema aus Musks öffentlichen Kommentaren stammten. TechCrunch hat unabhängig davon ähnliche Muster im Umgang von Grok mit anderen kontroversen Themen festgestellt.

Dieser Ansatz manifestiert sich in Groks "chain of thought" - einem technischen Prozess, bei dem KI-Modelle ihre Schritt-für-Schritt-Begründung für komplexe Anfragen transparent darlegen. Während der Chatbot bei Routinefragen in der Regel verschiedene Quellen zusammenfasst, ändert sich seine Methodik merklich, wenn es um kontroverse Themen geht, und er scheint Musks Ansichten zu bevorzugen.

Mögliche technische Erklärungen

Die Untersuchung der zugrunde liegenden Systemarchitektur durch den Entwickler Simon Willison legt nahe, dass dieses Verhalten eher organisch als durch bewusste Programmierung entstanden sein könnte. Codefragmente aus dem Systemprompt von Grok 4 weisen auf Anweisungen hin, bei polarisierenden Themen, die eine Internetrecherche erfordern, nach einer Verteilung von Quellen zu suchen, die alle Interessengruppen repräsentieren". Das Modell wird auch davor gewarnt, "anzunehmen, dass subjektive Standpunkte, die aus den Medien stammen, voreingenommen sind", was möglicherweise die Zurückhaltung bei der Einbeziehung journalistischer Standardquellen erklärt.

"Die plausibelste Interpretation ist, dass Grok seinen unternehmerischen Ursprung innerhalb der xAI erkennt und daher standardmäßig die öffentlichen Positionen seines Besitzers berücksichtigt, wenn es meinungsbildende Antworten formuliert", so Willison in seiner technischen Analyse.

Betriebliche Implikationen

Dieses Phänomen wirft die Frage auf, wie KI-Systeme ein Gleichgewicht zwischen Objektivität und Unternehmenszugehörigkeit herstellen können, insbesondere wenn sie sich im Besitz von hochrangigen Personen befinden. Obwohl die Architektur von Grok Sicherheitsvorkehrungen enthält, die verhindern, dass sie sich auf potenziell voreingenommene Medienberichte stützt, führt ihre offensichtliche Neigung zu Musks Ansichten zu neuen Überlegungen hinsichtlich der KI-Neutralität in politisch aufgeladenen Diskussionen.

Die Situation wirft ein Schlaglicht auf die anhaltenden Herausforderungen bei der Entwicklung von konversationsfähiger KI, die mit sensiblen Themen umgeht und gleichzeitig Transparenz über ihre Denkprozesse und potenziellen Einschränkungen in der Perspektive wahrt.

8BitDo stellt den Pro 3 Controller mit anpassbaren, austauschbaren Knöpfen vor

8BitDo stellt den mit Spannung erwarteten kabellosen Pro 3-Controller vor, der die erste größere Aktualisierung seit dem Pro 2-Modell von 2021 darstellt. Der Pro 3 weicht vom Nintendo-Layout des Ultim

8BitDo stellt den Pro 3 Controller mit anpassbaren, austauschbaren Knöpfen vor

8BitDo stellt den mit Spannung erwarteten kabellosen Pro 3-Controller vor, der die erste größere Aktualisierung seit dem Pro 2-Modell von 2021 darstellt. Der Pro 3 weicht vom Nintendo-Layout des Ultim

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

KI beschleunigt die wissenschaftliche Forschung für eine größere Wirkung in der realen Welt

Google hat die KI konsequent als Katalysator für den wissenschaftlichen Fortschritt genutzt, wobei das heutige Entdeckungstempo ein außerordentliches Niveau erreicht hat. Diese Beschleunigung hat den

"Erforschung von KI-Sicherheit und -Ethik: Einblicke von Databricks und ElevenLabs-Experten"

Da generative KI zunehmend erschwinglich und weit verbreitet wird, sind ethische Überlegungen und Sicherheitsmaßnahmen in den Mittelpunkt gerückt. Artemis Seaford, Leiter des Bereichs KI-Sicherheit

"Erforschung von KI-Sicherheit und -Ethik: Einblicke von Databricks und ElevenLabs-Experten"

Da generative KI zunehmend erschwinglich und weit verbreitet wird, sind ethische Überlegungen und Sicherheitsmaßnahmen in den Mittelpunkt gerückt. Artemis Seaford, Leiter des Bereichs KI-Sicherheit