ScrapeGraphAI:革新网页抓取指南

在当今数据驱动的世界中,从网站提取信息对于商业智能、市场研究和竞争分析等各种用途至关重要。网络爬取,即从网站自动提取数据的过程,已成为一项重要工具。然而,传统网络爬取方法通常需要复杂的编码,并且由于网站结构的变化需要定期更新。这就是 ScrapeGraphAI 的用武之地——一个创新的开源 Python 库,旨在通过利用大型语言模型(LLMs)的能力来变革网络爬取。

关键点

- ScrapeGraphAI 是一个开源 Python 库,简化了网络爬取。

- 它使用大型语言模型(LLMs)更有效地从网站提取数据。

- 该工具通过适应网站的变化,减少了开发者的持续干预需求。

- 它支持多种 LLMs,包括 GPT、Gemini、Groq、Azure 和 Hugging Face。

- 安装简单,使用 pip,建议使用虚拟环境。

- 与传统方法相比,ScrapeGraphAI 使用户能够以更少的代码爬取数据并提取特定信息。

- 通过 Ollama 进行本地托管,提供了一个私密高效的爬取环境。

理解网络爬取及其演变

传统网络爬取时代

网络爬取自1990年代末和2000年代初互联网开始发展时就已存在。当时,爬取涉及大量编码以从 HTML 页面提取数据。定制编码对于导航在线找到的各种 HTML 结构至关重要。正则表达式常用于解析 HTML 数据,这既繁琐又复杂。这种方法主要用于离线应用程序,需要手动更新以在线运行。整个过程需要大量时间和专业知识,主要只有具备高级编码技能的人才能使用。

随着时间推移,出现了许多工具和技术来简化网络爬取。Python 凭借其强大的库生态系统,已成为这项任务的首选语言。Beautiful Soup 和 Scrapy 等库提供了更结构化的数据提取方法,但适应不断变化的网站结构仍然是一个挑战。

随着大型语言模型(LLMs)的引入,网络爬取的格局现已显著转变,自动化了许多传统网络爬取的复杂性。让我们来探索一个让这一切变得更简单的工具。

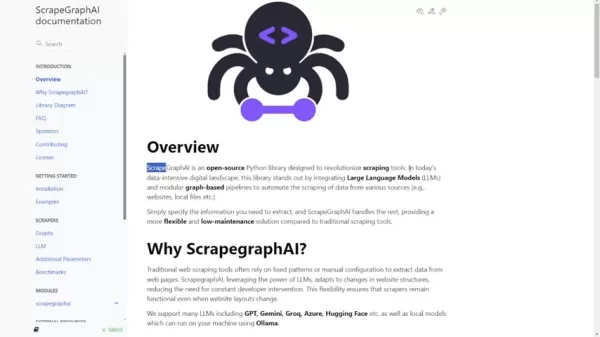

介绍 ScrapeGraphAI:重新定义网络爬取

ScrapeGraphAI 作为一个强大的解决方案,利用 AI 驱动的大型语言模型来自动化和简化网络爬取过程。它是一个开源 Python 库,旨在彻底改变我们处理网络爬取的方式。

与传统网络爬取工具不同,传统工具通常依赖固定的模式或手动调整,ScrapeGraphAI 能够适应网站结构的变化,最大限度地减少对开发者的持续干预需求。它通过整合大型语言模型(LLMs)和模块化的基于图的管道,自动从各种来源爬取数据,从而脱颖而出。

与传统爬取工具相比,该库提供了一个更灵活、维护成本更低的解决方案。它允许用户轻松地从 HTML 标记中提取特定信息,而无需大量的编码或处理复杂的正则表达式。你只需指定需要什么信息,ScrapeGraphAI 会处理其余部分。它支持多种 LLMs,包括 GPT、Gemini、Groq 和 Azure,以及使用 Ollama 在本地运行的模型。

关键组件和架构

ScrapeGraphAI 使用不同的解析节点来处理各个部分的 HTML 节点。它使用搜索节点来定位 HTML 页面中的特定区域。智能图构建器管理所有 HTML 标记语言。

以下是其架构的简要概述:

- 节点类型: ScrapeGraphAI 使用各种解析节点来处理 HTML 的不同部分,包括条件节点、获取节点、解析节点、Rag 节点和搜索节点。这些节点支持条件解析、数据获取、内容解析以及在 HTML 结构中搜索相关信息。

- 图构建器: ScrapeGraphAI 的智能图构建器通过处理所有 HTML 标记语言,简化了所需信息的提取。

- 大型语言模型(LLMs): ScrapeGraphAI 支持 Gemini 和 OpenAI 等 LLMs,利用它们的自然语言处理能力进行高效的数据提取。

该库能够手动定义图或让 LLM 根据提示创建图,增加了一层灵活性,以满足不同用户需求和项目要求。这种高级架构使实现复杂的爬取管道变得更简单,只需最少的编码。

设置 ScrapeGraphAI:安装和配置

前提条件和安装步骤

在开始使用 ScrapeGraphAI 之前,请确保你的系统满足必要的前提条件。

以下是设置的详细指南:

- Python 版本: ScrapeGraphAI 需要 Python 3.9 或更高版本,但不超过 3.12。Python 3.10 通常就足够了。

- PIP: 确保你拥有最新版本的 PIP,Python 包安装器。你可以使用命令 pip install --upgrade pip 更新它。

- Ollama(可选): 如果你计划运行本地大型语言模型,你需要安装 Ollama。请查看文档以获取详细的安装和设置说明。

在确认这些前提条件后,安装 ScrapeGraphAI 非常简单:

pip install scrapegraphai

强烈建议在虚拟环境(conda、venv 等)中安装 ScrapeGraphAI,以避免与系统中其他 Python 包的冲突。

对于 Windows 用户,可以使用 Windows 子系统 Linux(WSL)来安装额外的库。

选择合适的大型语言模型

使用 ScrapeGraphAI 时的一个关键决定是选择适合你网络爬取需求的大型语言模型(LLM)。ScrapeGraphAI 支持多种 LLMs,每种都有其优势和能力:

- OpenAI 的 GPT 模型: GPT-3.5 Turbo 和 GPT-4 是通用网络爬取任务的强大选择。这些模型能够有效理解和提取来自不同网站结构的信息。

- Gemini: 提供先进的自然语言处理能力,适合复杂的数据提取任务。

- Groq: 以其速度和效率著称,Groq 是处理大量网页数据时的绝佳选择。

- Azure: 提供企业级的安全性和可扩展性,适合对数据隐私要求严格的组织。

- Hugging Face: 提供广泛的开源 LLMs,允许你为特定的网络爬取任务定制和优化模型。

对于关心数据隐私或成本的用户,ScrapeGraphAI 允许使用 Ollama 运行本地 LLMs。这种设置使你无需依赖外部服务即可利用 LLMs 的强大功能。

实际示例:使用 ScrapeGraphAI 进行爬取

设置 OpenAI 模型

要连接和使用 OpenAI 模型,你需要导入必要的库并设置你的 API 密钥。以下是如何配置 ScrapeGraphAI 与 OpenAI 的 GPT 模型的示例:

textimport os

from dotenv import load_dotenv

from scrapegraphai.graphs import SmartScraperGraph

from scrapegraphai.utils import prettify_exec_info

,[object Object],

,[object Object],

,[object Object],

,[object Object],

,[object Object],textresult = smart_scraper_graph.run()

print(result)

在这个示例中,graph_config 字典被定义为指定 API 密钥和你希望使用的模型(gpt-3.5-turbo)。然后,使用提示、源 URL 和配置初始化 SmartScraperGraph。最后,调用 run() 方法来执行爬取过程并打印结果。

配置本地模型

对于本地模型,ScrapeGraphAI 需要稍多的配置,但仍然很简单:

textfrom scrapegraphai.graphs import SmartScraperGraph

from scrapegraphai.utils import prettify_exec_info

,[object Object],

,[object Object],

,[object Object],

,[object Object],textresult = smart_scraper_graph.run()

print(result)

此配置包括指定模型(ollama/llama3)、温度、格式以及 LLM 和嵌入的基 URL。你可以根据特定的网络爬取需求调整模型和其他参数。

了解成本和许可

开源性质

由于 ScrapeGraphAI 是一个开源库,它是免费使用的。你可以根据许可条款下载、修改和分发它。这种开源性质鼓励社区贡献,并确保该库对广大用户保持可访问性。

然而,请注意,使用某些大型语言模型(如 OpenAI 的模型)可能会产生费用。OpenAI、Bardeen AI 等采用基于令牌的定价模型。当你向 LLM 发送提示时,它会处理请求并生成响应。费用取决于提示和响应中使用的令牌数量。因此,监控你的使用情况并管理你的 API 密钥以避免意外费用非常重要。拥有自己的 OpenAI API 密钥会有所帮助。

ScrapeGraphAI 的优势与劣势

优势

- 使用 LLMs 简化网络爬取过程。

- 减少持续维护和调整的需求。

- 支持多种大型语言模型。

- 提供本地 LLM 托管选项,增强隐私和安全性。

- 通过基于图的管道增加灵活性和定制化。

劣势

- 使用外部 LLM 服务可能会产生费用。

- 依赖所选 LLM 的准确性和能力。

- 需要对 Python 和虚拟环境有一定了解。

- 相对较新的库,社区支持和文档可能仍在发展。

关键功能

LLM 集成

ScrapeGraphAI 利用大型语言模型(LLMs)进行智能网络爬取。它可以自动检测和适应网站结构的变化,减少持续手动调整的需求。这一功能本身就节省了大量的开发和维护时间。

基于图的管道

该库采用模块化的基于图的管道,允许高效和结构化的数据提取。这些管道可以根据不同的网络爬取场景进行定制,提供灵活性和对提取过程的控制。

支持多种 LLMs

ScrapeGraphAI 支持多种 LLMs,包括 GPT、Gemini、Groq、Azure 和 Hugging Face。这种支持使用户能够选择最适合其需求的模型,无论是通用爬取还是更专业的任务。

本地 LLM 托管

通过与 Ollama 的集成,ScrapeGraphAI 允许你在本地托管大型语言模型。这提供了一个安全且私密的网络爬取环境,无需依赖外部服务。

ScrapeGraphAI 的多样化用例

电子商务商业智能

ScrapeGraphAI 可用于监控产品价格、跟踪竞争对手产品和收集客户评论,为电子商务企业提供竞争优势。通过自动化收集这些数据,企业可以做出数据驱动的决策来优化其策略。

投资者研究

投资者可以利用 ScrapeGraphAI 提取财务数据、分析公司新闻和监控市场趋势。这些数据为投资者提供了做出明智投资决策和有效管理风险所需的洞察。

营销和竞争分析

营销团队可以使用 ScrapeGraphAI 收集客户反馈、分析社交媒体趋势和跟踪竞争对手策略。这些洞察使营销人员能够创建有针对性的活动、优化内容并改善客户参与度。

常见问题

什么是 ScrapeGraphAI?

ScrapeGraphAI 是一个开源 Python 库,旨在使用大型语言模型(LLMs)简化和自动化网络爬取。它使用户能够更高效地从网站提取数据,并减少手动编码。

安装 ScrapeGraphAI 的前提条件是什么?

前提条件包括 Python 3.9 或更高版本(但不超过 3.12)、PIP,以及可选的 Ollama 用于运行本地 LLMs。

如何安装 ScrapeGraphAI?

你可以使用 PIP 命令 pip install scrapegraphai 安装 ScrapeGraphAI。建议在虚拟环境中安装。

ScrapeGraphAI 支持哪些大型语言模型?

ScrapeGraphAI 支持 GPT、Gemini、Groq、Azure、Hugging Face 以及使用 Ollama 运行的本地模型。

如何配置 ScrapeGraphAI 以使用 OpenAI 的 GPT 模型?

你需要在 graph_config 字典中设置你的 OpenAI API 密钥,并指定你想使用的模型。

我可以免费使用 ScrapeGraphAI 吗?

是的,ScrapeGraphAI 是一个开源库,免费使用。然而,使用 OpenAI 等某些 LLMs 可能会根据令牌使用量产生费用。

相关问题

ScrapeGraphAI 与传统网络爬取工具相比如何?

ScrapeGraphAI 利用 AI 驱动的大型语言模型,减少了因网站结构变化而需要的持续手动调整。传统工具通常需要更多编码和维护。ScrapeGraphAI 适应不断变化的网站结构,减少了开发者的持续干预需求。这种灵活性确保即使网站布局发生变化,爬取器仍能正常运行。使用 ScrapeGraphAI,你只需指定需要什么信息,库会处理其余部分。传统网络爬取方法自1990年代末和2000年代初互联网开始形成时就已存在。那时,网络爬取涉及大量编码以从 HTML 网页提取数据。正则表达式常用于解析 HTML 数据,这是一项繁琐且复杂的任务。这种方法主要用于离线应用程序,需要开发人员手动将其上线。

使用 ScrapeGraphAI 时可以定义哪些提示?

此配置包括指定模型(ollama/llama3)、温度、格式以及 LLM 和嵌入的基 URL。你可以根据特定的网络爬取需求调整模型和其他参数。一些常见的提示包括:

- 列出所有项目的标题和描述。

- 列出所有内容。

相关文章

DaVinci Resolve 中的音频编辑大师:专业音效指南

清晰的音频将业余制作与专业视频内容区分开来。DaVinci Resolve 的 Fairlight 页面为电影制作者和内容创作者提供了完善音效设计的先进工具。本深入教程将介绍基本技巧、最佳设备选择和专业工作流程,让您从基本录音到后期制作母带制作,都能获得完美的音频效果。要点原始音频在专业视频制作中的关键作用选择与录音环境和人声特点相匹配的麦克风优化录音空间,尽量减少反射和背景噪音掌握 Fairli

DaVinci Resolve 中的音频编辑大师:专业音效指南

清晰的音频将业余制作与专业视频内容区分开来。DaVinci Resolve 的 Fairlight 页面为电影制作者和内容创作者提供了完善音效设计的先进工具。本深入教程将介绍基本技巧、最佳设备选择和专业工作流程,让您从基本录音到后期制作母带制作,都能获得完美的音频效果。要点原始音频在专业视频制作中的关键作用选择与录音环境和人声特点相匹配的麦克风优化录音空间,尽量减少反射和背景噪音掌握 Fairli

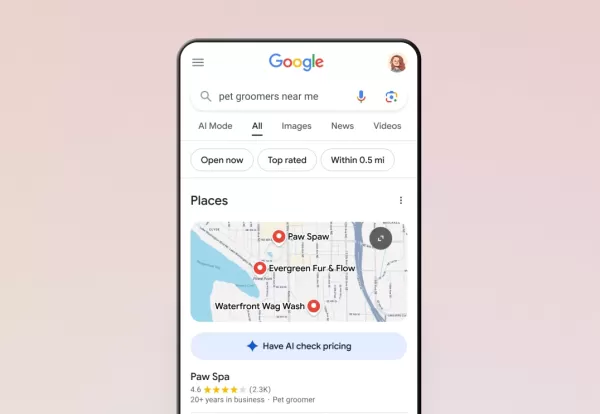

谷歌的人工智能现在能帮你处理电话了

谷歌已通过搜索将人工智能呼叫功能扩展到所有美国用户,使客户无需电话交谈即可向本地企业询问价格和可用性。该功能最初于 1 月份进行测试,目前支持服务型企业,包括宠物美容师、洗衣服务和汽车修理店。搜索者会发现,在符合条件的企业列表下方出现了 "让人工智能查询价格 "选项。人工智能界面会提示用户服务的具体内容--对于宠物美容查询,它会要求用户提供动物类型、品种、所需服务等详细信息,以及更新信息的首选联系

谷歌的人工智能现在能帮你处理电话了

谷歌已通过搜索将人工智能呼叫功能扩展到所有美国用户,使客户无需电话交谈即可向本地企业询问价格和可用性。该功能最初于 1 月份进行测试,目前支持服务型企业,包括宠物美容师、洗衣服务和汽车修理店。搜索者会发现,在符合条件的企业列表下方出现了 "让人工智能查询价格 "选项。人工智能界面会提示用户服务的具体内容--对于宠物美容查询,它会要求用户提供动物类型、品种、所需服务等详细信息,以及更新信息的首选联系

特朗普豁免智能手机、电脑和芯片关税上涨

据彭博社报道,特朗普政府已允许智能手机、电脑和各种电子设备免受近期关税上调的影响,即使是从中国进口。不过,这些产品仍需遵守4月9日之前实施的关税。彭博社的消息来源证实,美国海关和边境保护局周三晚些时候发布了最新的指导方针,对包括智能手机、笔记本电脑、计算机组件和半导体制造设备在内的重要科技产品免征新的125%的中国进口关税,以及对大多数国家征收的10%的基准关税。*彭博社随后对其报道进行了补充,澄

评论 (8)

0/200

特朗普豁免智能手机、电脑和芯片关税上涨

据彭博社报道,特朗普政府已允许智能手机、电脑和各种电子设备免受近期关税上调的影响,即使是从中国进口。不过,这些产品仍需遵守4月9日之前实施的关税。彭博社的消息来源证实,美国海关和边境保护局周三晚些时候发布了最新的指导方针,对包括智能手机、笔记本电脑、计算机组件和半导体制造设备在内的重要科技产品免征新的125%的中国进口关税,以及对大多数国家征收的10%的基准关税。*彭博社随后对其报道进行了补充,澄

评论 (8)

0/200

![HenryDavis]() HenryDavis

HenryDavis

2025-08-05 17:00:59

2025-08-05 17:00:59

This ScrapeGraphAI guide is a game-changer! Web scraping’s always been a hassle, but this makes it sound so seamless. Curious how it handles dynamic sites—any real-world examples out there? 😎

0

0

![RyanJackson]() RyanJackson

RyanJackson

2025-08-01 14:45:46

2025-08-01 14:45:46

Super cool guide on ScrapeGraphAI! Makes web scraping sound like a breeze. Anyone tried this for market research yet? 😎

0

0

![KevinAnderson]() KevinAnderson

KevinAnderson

2025-07-28 09:19:30

2025-07-28 09:19:30

This ScrapeGraphAI guide is a game-changer! 😍 Web scraping always felt like a techy maze, but this makes it sound so slick and efficient. I’m curious how it handles tricky dynamic sites—any tips for beginners diving in?

0

0

![BillyWilson]() BillyWilson

BillyWilson

2025-05-14 05:23:52

2025-05-14 05:23:52

ScrapeGraphAI 덕분에 웹사이트에서 데이터를 수집하는 게 훨씬 쉬워졌어요! 효율적이고 시간도 많이 절약됩니다. 다만 복잡한 사이트 구조에는 어려움을 겪어서 조금 짜증나요. 그래도 데이터 애호가라면 꼭 필요한 도구입니다! 😎

0

0

![ThomasLewis]() ThomasLewis

ThomasLewis

2025-05-14 04:47:14

2025-05-14 04:47:14

ScrapeGraphAIを使ってウェブサイトからデータを収集するのが楽になりました!効率的で時間も節約できます。ただ、複雑なサイト構造には苦労することがあり、少しイライラします。それでもデータ愛好者には必須ですね!😎

0

0

![SamuelAllen]() SamuelAllen

SamuelAllen

2025-05-13 23:53:23

2025-05-13 23:53:23

ScrapeGraphAI has totally transformed how I gather data from websites! It's super efficient and saves me tons of time. But sometimes it struggles with complex site structures, which can be a bit frustrating. Still, a must-have for any data enthusiast! 😎

0

0

在当今数据驱动的世界中,从网站提取信息对于商业智能、市场研究和竞争分析等各种用途至关重要。网络爬取,即从网站自动提取数据的过程,已成为一项重要工具。然而,传统网络爬取方法通常需要复杂的编码,并且由于网站结构的变化需要定期更新。这就是 ScrapeGraphAI 的用武之地——一个创新的开源 Python 库,旨在通过利用大型语言模型(LLMs)的能力来变革网络爬取。

关键点

- ScrapeGraphAI 是一个开源 Python 库,简化了网络爬取。

- 它使用大型语言模型(LLMs)更有效地从网站提取数据。

- 该工具通过适应网站的变化,减少了开发者的持续干预需求。

- 它支持多种 LLMs,包括 GPT、Gemini、Groq、Azure 和 Hugging Face。

- 安装简单,使用 pip,建议使用虚拟环境。

- 与传统方法相比,ScrapeGraphAI 使用户能够以更少的代码爬取数据并提取特定信息。

- 通过 Ollama 进行本地托管,提供了一个私密高效的爬取环境。

理解网络爬取及其演变

传统网络爬取时代

网络爬取自1990年代末和2000年代初互联网开始发展时就已存在。当时,爬取涉及大量编码以从 HTML 页面提取数据。定制编码对于导航在线找到的各种 HTML 结构至关重要。正则表达式常用于解析 HTML 数据,这既繁琐又复杂。这种方法主要用于离线应用程序,需要手动更新以在线运行。整个过程需要大量时间和专业知识,主要只有具备高级编码技能的人才能使用。

随着时间推移,出现了许多工具和技术来简化网络爬取。Python 凭借其强大的库生态系统,已成为这项任务的首选语言。Beautiful Soup 和 Scrapy 等库提供了更结构化的数据提取方法,但适应不断变化的网站结构仍然是一个挑战。

随着大型语言模型(LLMs)的引入,网络爬取的格局现已显著转变,自动化了许多传统网络爬取的复杂性。让我们来探索一个让这一切变得更简单的工具。

介绍 ScrapeGraphAI:重新定义网络爬取

ScrapeGraphAI 作为一个强大的解决方案,利用 AI 驱动的大型语言模型来自动化和简化网络爬取过程。它是一个开源 Python 库,旨在彻底改变我们处理网络爬取的方式。

与传统网络爬取工具不同,传统工具通常依赖固定的模式或手动调整,ScrapeGraphAI 能够适应网站结构的变化,最大限度地减少对开发者的持续干预需求。它通过整合大型语言模型(LLMs)和模块化的基于图的管道,自动从各种来源爬取数据,从而脱颖而出。

与传统爬取工具相比,该库提供了一个更灵活、维护成本更低的解决方案。它允许用户轻松地从 HTML 标记中提取特定信息,而无需大量的编码或处理复杂的正则表达式。你只需指定需要什么信息,ScrapeGraphAI 会处理其余部分。它支持多种 LLMs,包括 GPT、Gemini、Groq 和 Azure,以及使用 Ollama 在本地运行的模型。

关键组件和架构

ScrapeGraphAI 使用不同的解析节点来处理各个部分的 HTML 节点。它使用搜索节点来定位 HTML 页面中的特定区域。智能图构建器管理所有 HTML 标记语言。

以下是其架构的简要概述:

- 节点类型: ScrapeGraphAI 使用各种解析节点来处理 HTML 的不同部分,包括条件节点、获取节点、解析节点、Rag 节点和搜索节点。这些节点支持条件解析、数据获取、内容解析以及在 HTML 结构中搜索相关信息。

- 图构建器: ScrapeGraphAI 的智能图构建器通过处理所有 HTML 标记语言,简化了所需信息的提取。

- 大型语言模型(LLMs): ScrapeGraphAI 支持 Gemini 和 OpenAI 等 LLMs,利用它们的自然语言处理能力进行高效的数据提取。

该库能够手动定义图或让 LLM 根据提示创建图,增加了一层灵活性,以满足不同用户需求和项目要求。这种高级架构使实现复杂的爬取管道变得更简单,只需最少的编码。

设置 ScrapeGraphAI:安装和配置

前提条件和安装步骤

在开始使用 ScrapeGraphAI 之前,请确保你的系统满足必要的前提条件。

以下是设置的详细指南:

- Python 版本: ScrapeGraphAI 需要 Python 3.9 或更高版本,但不超过 3.12。Python 3.10 通常就足够了。

- PIP: 确保你拥有最新版本的 PIP,Python 包安装器。你可以使用命令 pip install --upgrade pip 更新它。

- Ollama(可选): 如果你计划运行本地大型语言模型,你需要安装 Ollama。请查看文档以获取详细的安装和设置说明。

在确认这些前提条件后,安装 ScrapeGraphAI 非常简单:

强烈建议在虚拟环境(conda、venv 等)中安装 ScrapeGraphAI,以避免与系统中其他 Python 包的冲突。

对于 Windows 用户,可以使用 Windows 子系统 Linux(WSL)来安装额外的库。

选择合适的大型语言模型

使用 ScrapeGraphAI 时的一个关键决定是选择适合你网络爬取需求的大型语言模型(LLM)。ScrapeGraphAI 支持多种 LLMs,每种都有其优势和能力:

- OpenAI 的 GPT 模型: GPT-3.5 Turbo 和 GPT-4 是通用网络爬取任务的强大选择。这些模型能够有效理解和提取来自不同网站结构的信息。

- Gemini: 提供先进的自然语言处理能力,适合复杂的数据提取任务。

- Groq: 以其速度和效率著称,Groq 是处理大量网页数据时的绝佳选择。

- Azure: 提供企业级的安全性和可扩展性,适合对数据隐私要求严格的组织。

- Hugging Face: 提供广泛的开源 LLMs,允许你为特定的网络爬取任务定制和优化模型。

对于关心数据隐私或成本的用户,ScrapeGraphAI 允许使用 Ollama 运行本地 LLMs。这种设置使你无需依赖外部服务即可利用 LLMs 的强大功能。

实际示例:使用 ScrapeGraphAI 进行爬取

设置 OpenAI 模型

要连接和使用 OpenAI 模型,你需要导入必要的库并设置你的 API 密钥。以下是如何配置 ScrapeGraphAI 与 OpenAI 的 GPT 模型的示例:

import os

from dotenv import load_dotenv

from scrapegraphai.graphs import SmartScraperGraph

from scrapegraphai.utils import prettify_exec_info

,[object Object],

,[object Object],

,[object Object],

,[object Object],

,[object Object],result = smart_scraper_graph.run()

print(result)在这个示例中,graph_config 字典被定义为指定 API 密钥和你希望使用的模型(gpt-3.5-turbo)。然后,使用提示、源 URL 和配置初始化 SmartScraperGraph。最后,调用 run() 方法来执行爬取过程并打印结果。

配置本地模型

对于本地模型,ScrapeGraphAI 需要稍多的配置,但仍然很简单:

from scrapegraphai.graphs import SmartScraperGraph

from scrapegraphai.utils import prettify_exec_info

,[object Object],

,[object Object],

,[object Object],

,[object Object],result = smart_scraper_graph.run()

print(result)此配置包括指定模型(ollama/llama3)、温度、格式以及 LLM 和嵌入的基 URL。你可以根据特定的网络爬取需求调整模型和其他参数。

了解成本和许可

开源性质

由于 ScrapeGraphAI 是一个开源库,它是免费使用的。你可以根据许可条款下载、修改和分发它。这种开源性质鼓励社区贡献,并确保该库对广大用户保持可访问性。

然而,请注意,使用某些大型语言模型(如 OpenAI 的模型)可能会产生费用。OpenAI、Bardeen AI 等采用基于令牌的定价模型。当你向 LLM 发送提示时,它会处理请求并生成响应。费用取决于提示和响应中使用的令牌数量。因此,监控你的使用情况并管理你的 API 密钥以避免意外费用非常重要。拥有自己的 OpenAI API 密钥会有所帮助。

ScrapeGraphAI 的优势与劣势

优势

- 使用 LLMs 简化网络爬取过程。

- 减少持续维护和调整的需求。

- 支持多种大型语言模型。

- 提供本地 LLM 托管选项,增强隐私和安全性。

- 通过基于图的管道增加灵活性和定制化。

劣势

- 使用外部 LLM 服务可能会产生费用。

- 依赖所选 LLM 的准确性和能力。

- 需要对 Python 和虚拟环境有一定了解。

- 相对较新的库,社区支持和文档可能仍在发展。

关键功能

LLM 集成

ScrapeGraphAI 利用大型语言模型(LLMs)进行智能网络爬取。它可以自动检测和适应网站结构的变化,减少持续手动调整的需求。这一功能本身就节省了大量的开发和维护时间。

基于图的管道

该库采用模块化的基于图的管道,允许高效和结构化的数据提取。这些管道可以根据不同的网络爬取场景进行定制,提供灵活性和对提取过程的控制。

支持多种 LLMs

ScrapeGraphAI 支持多种 LLMs,包括 GPT、Gemini、Groq、Azure 和 Hugging Face。这种支持使用户能够选择最适合其需求的模型,无论是通用爬取还是更专业的任务。

本地 LLM 托管

通过与 Ollama 的集成,ScrapeGraphAI 允许你在本地托管大型语言模型。这提供了一个安全且私密的网络爬取环境,无需依赖外部服务。

ScrapeGraphAI 的多样化用例

电子商务商业智能

ScrapeGraphAI 可用于监控产品价格、跟踪竞争对手产品和收集客户评论,为电子商务企业提供竞争优势。通过自动化收集这些数据,企业可以做出数据驱动的决策来优化其策略。

投资者研究

投资者可以利用 ScrapeGraphAI 提取财务数据、分析公司新闻和监控市场趋势。这些数据为投资者提供了做出明智投资决策和有效管理风险所需的洞察。

营销和竞争分析

营销团队可以使用 ScrapeGraphAI 收集客户反馈、分析社交媒体趋势和跟踪竞争对手策略。这些洞察使营销人员能够创建有针对性的活动、优化内容并改善客户参与度。

常见问题

什么是 ScrapeGraphAI?

ScrapeGraphAI 是一个开源 Python 库,旨在使用大型语言模型(LLMs)简化和自动化网络爬取。它使用户能够更高效地从网站提取数据,并减少手动编码。

安装 ScrapeGraphAI 的前提条件是什么?

前提条件包括 Python 3.9 或更高版本(但不超过 3.12)、PIP,以及可选的 Ollama 用于运行本地 LLMs。

如何安装 ScrapeGraphAI?

你可以使用 PIP 命令 pip install scrapegraphai 安装 ScrapeGraphAI。建议在虚拟环境中安装。

ScrapeGraphAI 支持哪些大型语言模型?

ScrapeGraphAI 支持 GPT、Gemini、Groq、Azure、Hugging Face 以及使用 Ollama 运行的本地模型。

如何配置 ScrapeGraphAI 以使用 OpenAI 的 GPT 模型?

你需要在 graph_config 字典中设置你的 OpenAI API 密钥,并指定你想使用的模型。

我可以免费使用 ScrapeGraphAI 吗?

是的,ScrapeGraphAI 是一个开源库,免费使用。然而,使用 OpenAI 等某些 LLMs 可能会根据令牌使用量产生费用。

相关问题

ScrapeGraphAI 与传统网络爬取工具相比如何?

ScrapeGraphAI 利用 AI 驱动的大型语言模型,减少了因网站结构变化而需要的持续手动调整。传统工具通常需要更多编码和维护。ScrapeGraphAI 适应不断变化的网站结构,减少了开发者的持续干预需求。这种灵活性确保即使网站布局发生变化,爬取器仍能正常运行。使用 ScrapeGraphAI,你只需指定需要什么信息,库会处理其余部分。传统网络爬取方法自1990年代末和2000年代初互联网开始形成时就已存在。那时,网络爬取涉及大量编码以从 HTML 网页提取数据。正则表达式常用于解析 HTML 数据,这是一项繁琐且复杂的任务。这种方法主要用于离线应用程序,需要开发人员手动将其上线。

使用 ScrapeGraphAI 时可以定义哪些提示?

此配置包括指定模型(ollama/llama3)、温度、格式以及 LLM 和嵌入的基 URL。你可以根据特定的网络爬取需求调整模型和其他参数。一些常见的提示包括:

- 列出所有项目的标题和描述。

- 列出所有内容。

DaVinci Resolve 中的音频编辑大师:专业音效指南

清晰的音频将业余制作与专业视频内容区分开来。DaVinci Resolve 的 Fairlight 页面为电影制作者和内容创作者提供了完善音效设计的先进工具。本深入教程将介绍基本技巧、最佳设备选择和专业工作流程,让您从基本录音到后期制作母带制作,都能获得完美的音频效果。要点原始音频在专业视频制作中的关键作用选择与录音环境和人声特点相匹配的麦克风优化录音空间,尽量减少反射和背景噪音掌握 Fairli

DaVinci Resolve 中的音频编辑大师:专业音效指南

清晰的音频将业余制作与专业视频内容区分开来。DaVinci Resolve 的 Fairlight 页面为电影制作者和内容创作者提供了完善音效设计的先进工具。本深入教程将介绍基本技巧、最佳设备选择和专业工作流程,让您从基本录音到后期制作母带制作,都能获得完美的音频效果。要点原始音频在专业视频制作中的关键作用选择与录音环境和人声特点相匹配的麦克风优化录音空间,尽量减少反射和背景噪音掌握 Fairli

谷歌的人工智能现在能帮你处理电话了

谷歌已通过搜索将人工智能呼叫功能扩展到所有美国用户,使客户无需电话交谈即可向本地企业询问价格和可用性。该功能最初于 1 月份进行测试,目前支持服务型企业,包括宠物美容师、洗衣服务和汽车修理店。搜索者会发现,在符合条件的企业列表下方出现了 "让人工智能查询价格 "选项。人工智能界面会提示用户服务的具体内容--对于宠物美容查询,它会要求用户提供动物类型、品种、所需服务等详细信息,以及更新信息的首选联系

谷歌的人工智能现在能帮你处理电话了

谷歌已通过搜索将人工智能呼叫功能扩展到所有美国用户,使客户无需电话交谈即可向本地企业询问价格和可用性。该功能最初于 1 月份进行测试,目前支持服务型企业,包括宠物美容师、洗衣服务和汽车修理店。搜索者会发现,在符合条件的企业列表下方出现了 "让人工智能查询价格 "选项。人工智能界面会提示用户服务的具体内容--对于宠物美容查询,它会要求用户提供动物类型、品种、所需服务等详细信息,以及更新信息的首选联系

特朗普豁免智能手机、电脑和芯片关税上涨

据彭博社报道,特朗普政府已允许智能手机、电脑和各种电子设备免受近期关税上调的影响,即使是从中国进口。不过,这些产品仍需遵守4月9日之前实施的关税。彭博社的消息来源证实,美国海关和边境保护局周三晚些时候发布了最新的指导方针,对包括智能手机、笔记本电脑、计算机组件和半导体制造设备在内的重要科技产品免征新的125%的中国进口关税,以及对大多数国家征收的10%的基准关税。*彭博社随后对其报道进行了补充,澄

特朗普豁免智能手机、电脑和芯片关税上涨

据彭博社报道,特朗普政府已允许智能手机、电脑和各种电子设备免受近期关税上调的影响,即使是从中国进口。不过,这些产品仍需遵守4月9日之前实施的关税。彭博社的消息来源证实,美国海关和边境保护局周三晚些时候发布了最新的指导方针,对包括智能手机、笔记本电脑、计算机组件和半导体制造设备在内的重要科技产品免征新的125%的中国进口关税,以及对大多数国家征收的10%的基准关税。*彭博社随后对其报道进行了补充,澄

2025-08-05 17:00:59

2025-08-05 17:00:59

This ScrapeGraphAI guide is a game-changer! Web scraping’s always been a hassle, but this makes it sound so seamless. Curious how it handles dynamic sites—any real-world examples out there? 😎

0

0

2025-08-01 14:45:46

2025-08-01 14:45:46

Super cool guide on ScrapeGraphAI! Makes web scraping sound like a breeze. Anyone tried this for market research yet? 😎

0

0

2025-07-28 09:19:30

2025-07-28 09:19:30

This ScrapeGraphAI guide is a game-changer! 😍 Web scraping always felt like a techy maze, but this makes it sound so slick and efficient. I’m curious how it handles tricky dynamic sites—any tips for beginners diving in?

0

0

2025-05-14 05:23:52

2025-05-14 05:23:52

ScrapeGraphAI 덕분에 웹사이트에서 데이터를 수집하는 게 훨씬 쉬워졌어요! 효율적이고 시간도 많이 절약됩니다. 다만 복잡한 사이트 구조에는 어려움을 겪어서 조금 짜증나요. 그래도 데이터 애호가라면 꼭 필요한 도구입니다! 😎

0

0

2025-05-14 04:47:14

2025-05-14 04:47:14

ScrapeGraphAIを使ってウェブサイトからデータを収集するのが楽になりました!効率的で時間も節約できます。ただ、複雑なサイト構造には苦労することがあり、少しイライラします。それでもデータ愛好者には必須ですね!😎

0

0

2025-05-13 23:53:23

2025-05-13 23:53:23

ScrapeGraphAI has totally transformed how I gather data from websites! It's super efficient and saves me tons of time. But sometimes it struggles with complex site structures, which can be a bit frustrating. Still, a must-have for any data enthusiast! 😎

0

0