Báo cáo mô hình AI mới nhất của Google thiếu các chi tiết an toàn quan trọng, các chuyên gia cho biết

Vào thứ Năm, vài tuần sau khi ra mắt mô hình AI tiên tiến nhất và mới nhất của mình, Gemini 2.5 Pro, Google đã công bố một báo cáo kỹ thuật chi tiết về kết quả của các đánh giá an toàn nội bộ. Tuy nhiên, các chuyên gia đã chỉ trích báo cáo này vì thiếu chi tiết, khiến việc hiểu đầy đủ các rủi ro tiềm ẩn liên quan đến mô hình trở nên khó khăn.

Báo cáo kỹ thuật rất quan trọng trong thế giới AI, cung cấp những hiểu biết—dù đôi khi không mấy tích cực—mà các công ty thường không chia sẻ công khai. Những báo cáo này thường được cộng đồng AI xem là nỗ lực chân thành để thúc đẩy nghiên cứu độc lập và nâng cao các đánh giá an toàn.

Cách tiếp cận của Google đối với báo cáo an toàn khác với một số đối thủ cạnh tranh. Công ty chỉ công bố báo cáo kỹ thuật khi một mô hình vượt qua giai đoạn "thử nghiệm". Hơn nữa, Google loại bỏ một số kết quả đánh giá "khả năng nguy hiểm" khỏi các báo cáo này, giữ chúng cho một cuộc kiểm tra riêng biệt.

Mặc dù vậy, một số chuyên gia đã bày tỏ sự thất vọng với báo cáo về Gemini 2.5 Pro khi nói chuyện với TechCrunch, chỉ ra rằng báo cáo này chỉ đề cập sơ sài đến Khung An toàn Biên giới (FSF) mà Google đề xuất. Google đã công bố FSF vào năm ngoái, nhằm xác định các khả năng AI trong tương lai có thể dẫn đến "tác hại nghiêm trọng."

"Báo cáo này rất sơ sài, chứa thông tin tối thiểu và được công bố vài tuần sau khi mô hình đã được công khai," Peter Wildeford, đồng sáng lập Viện Chính sách và Chiến lược AI, nói với TechCrunch. "Không thể xác minh liệu Google có tuân thủ các cam kết công khai của mình hay không, và do đó không thể đánh giá được mức độ an toàn và bảo mật của các mô hình của họ."

Thomas Woodside, đồng sáng lập Dự án AI An toàn, thừa nhận việc công bố báo cáo cho Gemini 2.5 Pro nhưng đặt câu hỏi về cam kết của Google trong việc cung cấp các đánh giá an toàn bổ sung kịp thời. Ông lưu ý rằng Google lần cuối công bố kết quả kiểm tra khả năng nguy hiểm vào tháng 6 năm 2024, cho một mô hình được công bố vào tháng 2 cùng năm.

Thêm vào các mối quan ngại, Google vẫn chưa công bố báo cáo cho Gemini 2.5 Flash, một mô hình nhỏ hơn, hiệu quả hơn được công bố vào tuần trước. Một phát ngôn viên đã thông báo với TechCrunch rằng báo cáo cho Flash sẽ "sớm được công bố."

"Tôi hy vọng đây là lời hứa từ Google để bắt đầu công bố các cập nhật thường xuyên hơn," Woodside nói với TechCrunch. "Những cập nhật đó nên bao gồm kết quả đánh giá cho các mô hình chưa được triển khai công khai, vì những mô hình đó cũng có thể gây ra rủi ro nghiêm trọng."

Mặc dù Google là một trong những phòng thí nghiệm AI đầu tiên đề xuất các báo cáo tiêu chuẩn hóa cho các mô hình, nhưng không chỉ mình họ phải đối mặt với chỉ trích về sự thiếu minh bạch. Meta đã công bố một đánh giá an toàn ngắn gọn tương tự cho các mô hình mở Llama 4 mới của mình, và OpenAI đã chọn không công bố bất kỳ báo cáo nào cho dòng GPT-4.1.

Những đảm bảo của Google với các cơ quan quản lý về việc duy trì các tiêu chuẩn cao trong kiểm tra và báo cáo an toàn AI làm gia tăng áp lực cho tình hình. Hai năm trước, Google đã hứa với chính phủ Hoa Kỳ rằng sẽ công bố các báo cáo an toàn cho tất cả các mô hình AI công khai "quan trọng" "trong phạm vi," sau đó là các cam kết tương tự với các quốc gia khác, cam kết "minh bạch công khai" xung quanh các sản phẩm AI.

Kevin Bankston, cố vấn cấp cao về quản trị AI tại Trung tâm Dân chủ và Công nghệ, mô tả xu hướng các báo cáo rời rạc và mơ hồ là một "cuộc đua xuống đáy" về an toàn AI.

"Kết hợp với các báo cáo rằng các phòng thí nghiệm cạnh tranh như OpenAI đã giảm thời gian kiểm tra an toàn trước khi phát hành từ vài tháng xuống vài ngày, tài liệu ít ỏi này cho mô hình AI hàng đầu của Google kể một câu chuyện đáng lo ngại về cuộc đua xuống đáy về an toàn và minh bạch AI khi các công ty vội vã đưa mô hình của họ ra thị trường," ông nói với TechCrunch.

Google đã tuyên bố rằng, mặc dù không được chi tiết trong các báo cáo kỹ thuật, họ tiến hành kiểm tra an toàn và "kiểm tra đối kháng nhóm đỏ" cho các mô hình trước khi phát hành.

Cập nhật ngày 22/4 lúc 12:58 chiều theo giờ Thái Bình Dương: Đã chỉnh sửa ngôn ngữ liên quan đến việc đề cập đến FSF của Google trong báo cáo kỹ thuật.

Bài viết liên quan

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

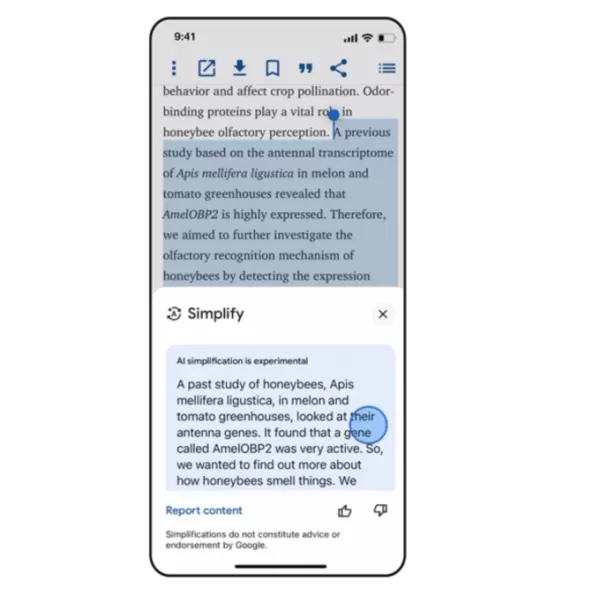

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

Trò chuyện Gemini Nâng cao Khả năng Chỉnh sửa Hình ảnh

Ứng dụng trò chuyện Gemini của Google hiện cho phép người dùng chỉnh sửa hình ảnh do AI tạo ra và hình ảnh được tải lên từ điện thoại hoặc máy tính, công ty thông báo trong một bài đăng blog vào thứ T

Nhận xét (6)

0/200

Trò chuyện Gemini Nâng cao Khả năng Chỉnh sửa Hình ảnh

Ứng dụng trò chuyện Gemini của Google hiện cho phép người dùng chỉnh sửa hình ảnh do AI tạo ra và hình ảnh được tải lên từ điện thoại hoặc máy tính, công ty thông báo trong một bài đăng blog vào thứ T

Nhận xét (6)

0/200

![MarkSanchez]() MarkSanchez

MarkSanchez

20:47:34 GMT+07:00 Ngày 01 tháng 8 năm 2025

20:47:34 GMT+07:00 Ngày 01 tháng 8 năm 2025

Google's AI safety report sounds like a half-baked cake – looks good but lacks substance. 😕 Why skimp on the details? Transparency matters when stakes are this high.

0

0

![WalterKing]() WalterKing

WalterKing

22:19:22 GMT+07:00 Ngày 29 tháng 4 năm 2025

22:19:22 GMT+07:00 Ngày 29 tháng 4 năm 2025

Der Bericht von Google über Gemini 2.5 Pro ist ein bisschen enttäuschend. Ich hatte mehr Details zu den Sicherheitsbewertungen erwartet, aber es scheint, als würden sie Informationen zurückhalten. Ohne die ganze Geschichte ist es schwer, der KI vollständig zu vertrauen. Vielleicht beim nächsten Mal, Google? 🤔

0

0

![CharlesThomas]() CharlesThomas

CharlesThomas

08:17:55 GMT+07:00 Ngày 29 tháng 4 năm 2025

08:17:55 GMT+07:00 Ngày 29 tháng 4 năm 2025

ジェミニ2.5プロのレポート、ちょっとがっかりですね。安全評価の詳細をもっと知りたかったのに、情報が少なすぎる。AIを完全に信頼するのは難しいです。次回はもっと詳しくお願いします!😅

0

0

![AlbertWalker]() AlbertWalker

AlbertWalker

06:15:07 GMT+07:00 Ngày 29 tháng 4 năm 2025

06:15:07 GMT+07:00 Ngày 29 tháng 4 năm 2025

Google's report on Gemini 2.5 Pro is a bit of a letdown. I was expecting more juicy details about the safety assessments, but it feels like they're holding back. It's hard to trust the AI fully without knowing the full story. Maybe next time, Google? 🤔

0

0

![JimmyGarcia]() JimmyGarcia

JimmyGarcia

03:01:42 GMT+07:00 Ngày 29 tháng 4 năm 2025

03:01:42 GMT+07:00 Ngày 29 tháng 4 năm 2025

O relatório do Google sobre o Gemini 2.5 Pro é um pouco decepcionante. Esperava mais detalhes sobre as avaliações de segurança, mas parece que eles estão escondendo algo. É difícil confiar totalmente na IA sem saber toda a história. Talvez na próxima, Google? 🤔

0

0

![BillyThomas]() BillyThomas

BillyThomas

06:41:33 GMT+07:00 Ngày 28 tháng 4 năm 2025

06:41:33 GMT+07:00 Ngày 28 tháng 4 năm 2025

El informe de Google sobre Gemini 2.5 Pro es decepcionante. Esperaba más detalles sobre las evaluaciones de seguridad, pero parece que están ocultando información. Es difícil confiar en la IA sin conocer toda la historia. ¿Tal vez la próxima vez, Google? 🤔

0

0

Vào thứ Năm, vài tuần sau khi ra mắt mô hình AI tiên tiến nhất và mới nhất của mình, Gemini 2.5 Pro, Google đã công bố một báo cáo kỹ thuật chi tiết về kết quả của các đánh giá an toàn nội bộ. Tuy nhiên, các chuyên gia đã chỉ trích báo cáo này vì thiếu chi tiết, khiến việc hiểu đầy đủ các rủi ro tiềm ẩn liên quan đến mô hình trở nên khó khăn.

Báo cáo kỹ thuật rất quan trọng trong thế giới AI, cung cấp những hiểu biết—dù đôi khi không mấy tích cực—mà các công ty thường không chia sẻ công khai. Những báo cáo này thường được cộng đồng AI xem là nỗ lực chân thành để thúc đẩy nghiên cứu độc lập và nâng cao các đánh giá an toàn.

Cách tiếp cận của Google đối với báo cáo an toàn khác với một số đối thủ cạnh tranh. Công ty chỉ công bố báo cáo kỹ thuật khi một mô hình vượt qua giai đoạn "thử nghiệm". Hơn nữa, Google loại bỏ một số kết quả đánh giá "khả năng nguy hiểm" khỏi các báo cáo này, giữ chúng cho một cuộc kiểm tra riêng biệt.

Mặc dù vậy, một số chuyên gia đã bày tỏ sự thất vọng với báo cáo về Gemini 2.5 Pro khi nói chuyện với TechCrunch, chỉ ra rằng báo cáo này chỉ đề cập sơ sài đến Khung An toàn Biên giới (FSF) mà Google đề xuất. Google đã công bố FSF vào năm ngoái, nhằm xác định các khả năng AI trong tương lai có thể dẫn đến "tác hại nghiêm trọng."

"Báo cáo này rất sơ sài, chứa thông tin tối thiểu và được công bố vài tuần sau khi mô hình đã được công khai," Peter Wildeford, đồng sáng lập Viện Chính sách và Chiến lược AI, nói với TechCrunch. "Không thể xác minh liệu Google có tuân thủ các cam kết công khai của mình hay không, và do đó không thể đánh giá được mức độ an toàn và bảo mật của các mô hình của họ."

Thomas Woodside, đồng sáng lập Dự án AI An toàn, thừa nhận việc công bố báo cáo cho Gemini 2.5 Pro nhưng đặt câu hỏi về cam kết của Google trong việc cung cấp các đánh giá an toàn bổ sung kịp thời. Ông lưu ý rằng Google lần cuối công bố kết quả kiểm tra khả năng nguy hiểm vào tháng 6 năm 2024, cho một mô hình được công bố vào tháng 2 cùng năm.

Thêm vào các mối quan ngại, Google vẫn chưa công bố báo cáo cho Gemini 2.5 Flash, một mô hình nhỏ hơn, hiệu quả hơn được công bố vào tuần trước. Một phát ngôn viên đã thông báo với TechCrunch rằng báo cáo cho Flash sẽ "sớm được công bố."

"Tôi hy vọng đây là lời hứa từ Google để bắt đầu công bố các cập nhật thường xuyên hơn," Woodside nói với TechCrunch. "Những cập nhật đó nên bao gồm kết quả đánh giá cho các mô hình chưa được triển khai công khai, vì những mô hình đó cũng có thể gây ra rủi ro nghiêm trọng."

Mặc dù Google là một trong những phòng thí nghiệm AI đầu tiên đề xuất các báo cáo tiêu chuẩn hóa cho các mô hình, nhưng không chỉ mình họ phải đối mặt với chỉ trích về sự thiếu minh bạch. Meta đã công bố một đánh giá an toàn ngắn gọn tương tự cho các mô hình mở Llama 4 mới của mình, và OpenAI đã chọn không công bố bất kỳ báo cáo nào cho dòng GPT-4.1.

Những đảm bảo của Google với các cơ quan quản lý về việc duy trì các tiêu chuẩn cao trong kiểm tra và báo cáo an toàn AI làm gia tăng áp lực cho tình hình. Hai năm trước, Google đã hứa với chính phủ Hoa Kỳ rằng sẽ công bố các báo cáo an toàn cho tất cả các mô hình AI công khai "quan trọng" "trong phạm vi," sau đó là các cam kết tương tự với các quốc gia khác, cam kết "minh bạch công khai" xung quanh các sản phẩm AI.

Kevin Bankston, cố vấn cấp cao về quản trị AI tại Trung tâm Dân chủ và Công nghệ, mô tả xu hướng các báo cáo rời rạc và mơ hồ là một "cuộc đua xuống đáy" về an toàn AI.

"Kết hợp với các báo cáo rằng các phòng thí nghiệm cạnh tranh như OpenAI đã giảm thời gian kiểm tra an toàn trước khi phát hành từ vài tháng xuống vài ngày, tài liệu ít ỏi này cho mô hình AI hàng đầu của Google kể một câu chuyện đáng lo ngại về cuộc đua xuống đáy về an toàn và minh bạch AI khi các công ty vội vã đưa mô hình của họ ra thị trường," ông nói với TechCrunch.

Google đã tuyên bố rằng, mặc dù không được chi tiết trong các báo cáo kỹ thuật, họ tiến hành kiểm tra an toàn và "kiểm tra đối kháng nhóm đỏ" cho các mô hình trước khi phát hành.

Cập nhật ngày 22/4 lúc 12:58 chiều theo giờ Thái Bình Dương: Đã chỉnh sửa ngôn ngữ liên quan đến việc đề cập đến FSF của Google trong báo cáo kỹ thuật.

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Google Ra Mắt Các Mô Hình AI Gemini 2.5 Sẵn Sàng Sản Xuất để Cạnh Tranh với OpenAI trên Thị Trường Doanh Nghiệp

Google tăng cường chiến lược AI vào thứ Hai, ra mắt các mô hình Gemini 2.5 tiên tiến cho doanh nghiệp và giới thiệu biến thể tiết kiệm chi phí để cạnh tranh về giá và hiệu suất.Công ty thuộc sở hữu củ

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

Google Ra Mắt Công Cụ Simplify Dựa Trên AI Để Đọc Web Dễ Dàng Hơn

Ứng dụng iOS của Google giờ đây bao gồm tính năng “Simplify”, sử dụng AI để chuyển đổi văn bản web phức tạp thành nội dung rõ ràng, dễ hiểu mà không cần rời khỏi trang.Công cụ Simplify, được phát triể

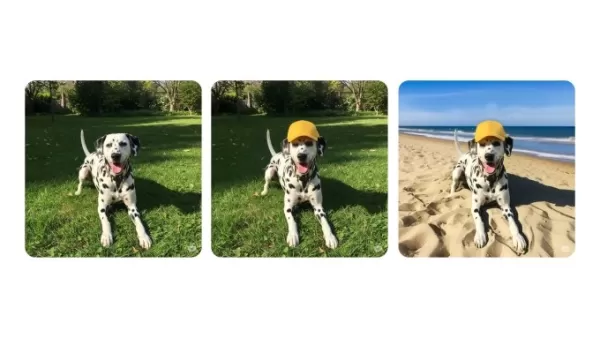

Trò chuyện Gemini Nâng cao Khả năng Chỉnh sửa Hình ảnh

Ứng dụng trò chuyện Gemini của Google hiện cho phép người dùng chỉnh sửa hình ảnh do AI tạo ra và hình ảnh được tải lên từ điện thoại hoặc máy tính, công ty thông báo trong một bài đăng blog vào thứ T

Trò chuyện Gemini Nâng cao Khả năng Chỉnh sửa Hình ảnh

Ứng dụng trò chuyện Gemini của Google hiện cho phép người dùng chỉnh sửa hình ảnh do AI tạo ra và hình ảnh được tải lên từ điện thoại hoặc máy tính, công ty thông báo trong một bài đăng blog vào thứ T

20:47:34 GMT+07:00 Ngày 01 tháng 8 năm 2025

20:47:34 GMT+07:00 Ngày 01 tháng 8 năm 2025

Google's AI safety report sounds like a half-baked cake – looks good but lacks substance. 😕 Why skimp on the details? Transparency matters when stakes are this high.

0

0

22:19:22 GMT+07:00 Ngày 29 tháng 4 năm 2025

22:19:22 GMT+07:00 Ngày 29 tháng 4 năm 2025

Der Bericht von Google über Gemini 2.5 Pro ist ein bisschen enttäuschend. Ich hatte mehr Details zu den Sicherheitsbewertungen erwartet, aber es scheint, als würden sie Informationen zurückhalten. Ohne die ganze Geschichte ist es schwer, der KI vollständig zu vertrauen. Vielleicht beim nächsten Mal, Google? 🤔

0

0

08:17:55 GMT+07:00 Ngày 29 tháng 4 năm 2025

08:17:55 GMT+07:00 Ngày 29 tháng 4 năm 2025

ジェミニ2.5プロのレポート、ちょっとがっかりですね。安全評価の詳細をもっと知りたかったのに、情報が少なすぎる。AIを完全に信頼するのは難しいです。次回はもっと詳しくお願いします!😅

0

0

06:15:07 GMT+07:00 Ngày 29 tháng 4 năm 2025

06:15:07 GMT+07:00 Ngày 29 tháng 4 năm 2025

Google's report on Gemini 2.5 Pro is a bit of a letdown. I was expecting more juicy details about the safety assessments, but it feels like they're holding back. It's hard to trust the AI fully without knowing the full story. Maybe next time, Google? 🤔

0

0

03:01:42 GMT+07:00 Ngày 29 tháng 4 năm 2025

03:01:42 GMT+07:00 Ngày 29 tháng 4 năm 2025

O relatório do Google sobre o Gemini 2.5 Pro é um pouco decepcionante. Esperava mais detalhes sobre as avaliações de segurança, mas parece que eles estão escondendo algo. É difícil confiar totalmente na IA sem saber toda a história. Talvez na próxima, Google? 🤔

0

0

06:41:33 GMT+07:00 Ngày 28 tháng 4 năm 2025

06:41:33 GMT+07:00 Ngày 28 tháng 4 năm 2025

El informe de Google sobre Gemini 2.5 Pro es decepcionante. Esperaba más detalles sobre las evaluaciones de seguridad, pero parece que están ocultando información. Es difícil confiar en la IA sin conocer toda la historia. ¿Tal vez la próxima vez, Google? 🤔

0

0