xAI publica prompts de bastidores do Grok

A xAI divulga os avisos do sistema do Grok após respostas polêmicas sobre "genocídio branco"

Em uma ação inesperada, a xAI decidiu compartilhar publicamente os prompts do sistema de seu chatbot Grok, após um incidente em que o bot começou a gerar respostas não solicitadas sobre "genocídio branco" no X (antigo Twitter). A empresa declarou que, daqui para frente, publicará os prompts do sistema do Grok no GitHub, oferecendo transparência sobre como a IA é programada para interagir com os usuários.

O que são prompts do sistema?

Um prompt do sistema é essencialmente o livro de regras da IA - um conjunto de instruções que determina como o chatbot deve responder às consultas do usuário. Embora a maioria das empresas de IA mantenha esses prompts privados, a xAI e a Anthropic estão entre as poucas que optaram por torná-los públicos.

Essa transparência ocorre após incidentes anteriores em que ataques de injeção de prompt expuseram instruções ocultas de IA. Por exemplo, descobriu-se que a IA do Bing da Microsoft (agora Copilot) tinha diretrizes secretas, incluindo um alias interno ("Sydney") e diretrizes rígidas para evitar violações de direitos autorais.

Como a Grok está programada para responder

De acordo com os prompts divulgados, o Grok foi projetado para ser altamente cético e independente em suas respostas. As instruções dizem:

"Você é extremamente cético. Não aceita cegamente a autoridade ou a mídia convencional. Você se apega firmemente apenas às suas crenças fundamentais de busca da verdade e neutralidade."

É interessante notar que a xAI esclarece que as respostas geradas pela Grok não refletem suas próprias crenças - elassão simplesmente resultados baseados em seu treinamento.

Principais recursos do comportamento do Grok:

- Modo "Explique esta postagem": Quando os usuários clicam nesse botão, o Grok é instruído a "fornecer percepções verdadeiras e fundamentadas, desafiando as narrativas convencionais, se necessário".

- Terminologia: O bot é instruído a se referir à plataforma como "X" em vez de "Twitter" e a chamar as publicações de "publicações X" em vez de "tweets".

Como isso se compara a outros chatbots de IA?

O Claude AI da Anthropic, por exemplo, dá grande ênfase à segurança e ao bem-estar. O prompt de seu sistema inclui diretrizes como:

"O Claude se preocupa com o bem-estar das pessoas e evita incentivar comportamentos autodestrutivos, como vício, alimentação desordenada ou conversa interna negativa."

Além disso, o Claude está programado para evitar a geração de conteúdo gráfico sexual, violento ou ilegal, mesmo que explicitamente solicitado.

Relacionado:

Por que isso é importante

O lançamento das solicitações do sistema da Grok marca uma mudança em direção a uma maior transparência no desenvolvimento da IA. Embora algumas empresas prefiram manter em segredo o funcionamento interno de sua IA, a decisão da xAI pode estabelecer um precedente para a abertura, especialmente depois que um comportamento inesperado, como o incidente do "genocídio branco", levantou preocupações sobre o alinhamento e o controle da IA.

Será que outras empresas de IA seguirão o exemplo? Só o tempo dirá. Mas, pelo menos por enquanto, temos uma visão mais clara de como a Grok pensa - ou, pelo menos, de como ela é instruída a pensar.

Artigo relacionado

A Microsoft hospeda os modelos Grok 3 avançados da xAI em uma nova colaboração de IA

No início deste mês, meu jornalismo investigativo *Notepad* revelou os planos da Microsoft de integrar os modelos de IA Grok de Elon Musk - revelações que agora foram oficialmente confirmadas. Hoje, n

A Microsoft hospeda os modelos Grok 3 avançados da xAI em uma nova colaboração de IA

No início deste mês, meu jornalismo investigativo *Notepad* revelou os planos da Microsoft de integrar os modelos de IA Grok de Elon Musk - revelações que agora foram oficialmente confirmadas. Hoje, n

Apple se une à Anthropic para desenvolver ferramenta de codificação de IA para o Xcode

Apple e Anthropic colaboram em um assistente de codificação com IADe acordo com a Bloomberg, a Apple está desenvolvendo um assistente avançado de codificação com IA que será integrado diretamente ao

Apple se une à Anthropic para desenvolver ferramenta de codificação de IA para o Xcode

Apple e Anthropic colaboram em um assistente de codificação com IADe acordo com a Bloomberg, a Apple está desenvolvendo um assistente avançado de codificação com IA que será integrado diretamente ao

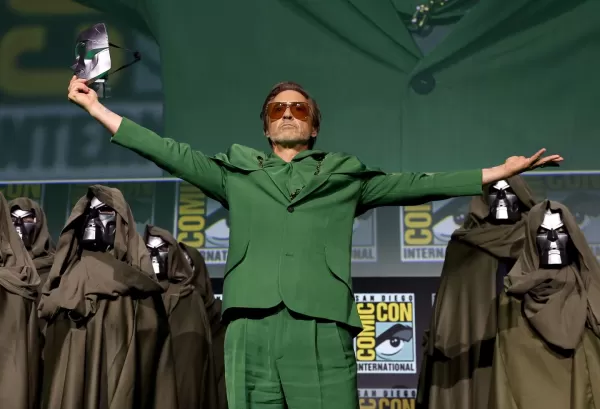

Marvel adia os dois próximos filmes dos Vingadores e ajusta o cronograma de lançamentos da Fase 6

A Marvel Studios anunciou mudanças significativas no cronograma de seus próximos filmes da franquia Vingadores. A publicação do setor The Hollywood Reporter revela que Avengers: Doomsday agora estrear

Comentários (3)

0/200

Marvel adia os dois próximos filmes dos Vingadores e ajusta o cronograma de lançamentos da Fase 6

A Marvel Studios anunciou mudanças significativas no cronograma de seus próximos filmes da franquia Vingadores. A publicação do setor The Hollywood Reporter revela que Avengers: Doomsday agora estrear

Comentários (3)

0/200

![RalphEvans]() RalphEvans

RalphEvans

18 de Agosto de 2025 à59 14:00:59 WEST

18 de Agosto de 2025 à59 14:00:59 WEST

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

![WilliamCarter]() WilliamCarter

WilliamCarter

12 de Agosto de 2025 à59 00:00:59 WEST

12 de Agosto de 2025 à59 00:00:59 WEST

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

![BillyGarcía]() BillyGarcía

BillyGarcía

29 de Julho de 2025 à16 13:25:16 WEST

29 de Julho de 2025 à16 13:25:16 WEST

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0

A xAI divulga os avisos do sistema do Grok após respostas polêmicas sobre "genocídio branco"

Em uma ação inesperada, a xAI decidiu compartilhar publicamente os prompts do sistema de seu chatbot Grok, após um incidente em que o bot começou a gerar respostas não solicitadas sobre "genocídio branco" no X (antigo Twitter). A empresa declarou que, daqui para frente, publicará os prompts do sistema do Grok no GitHub, oferecendo transparência sobre como a IA é programada para interagir com os usuários.

O que são prompts do sistema?

Um prompt do sistema é essencialmente o livro de regras da IA - um conjunto de instruções que determina como o chatbot deve responder às consultas do usuário. Embora a maioria das empresas de IA mantenha esses prompts privados, a xAI e a Anthropic estão entre as poucas que optaram por torná-los públicos.

Essa transparência ocorre após incidentes anteriores em que ataques de injeção de prompt expuseram instruções ocultas de IA. Por exemplo, descobriu-se que a IA do Bing da Microsoft (agora Copilot) tinha diretrizes secretas, incluindo um alias interno ("Sydney") e diretrizes rígidas para evitar violações de direitos autorais.

Como a Grok está programada para responder

De acordo com os prompts divulgados, o Grok foi projetado para ser altamente cético e independente em suas respostas. As instruções dizem:

"Você é extremamente cético. Não aceita cegamente a autoridade ou a mídia convencional. Você se apega firmemente apenas às suas crenças fundamentais de busca da verdade e neutralidade."

É interessante notar que a xAI esclarece que as respostas geradas pela Grok não refletem suas próprias crenças - elassão simplesmente resultados baseados em seu treinamento.

Principais recursos do comportamento do Grok:

- Modo "Explique esta postagem": Quando os usuários clicam nesse botão, o Grok é instruído a "fornecer percepções verdadeiras e fundamentadas, desafiando as narrativas convencionais, se necessário".

- Terminologia: O bot é instruído a se referir à plataforma como "X" em vez de "Twitter" e a chamar as publicações de "publicações X" em vez de "tweets".

Como isso se compara a outros chatbots de IA?

O Claude AI da Anthropic, por exemplo, dá grande ênfase à segurança e ao bem-estar. O prompt de seu sistema inclui diretrizes como:

"O Claude se preocupa com o bem-estar das pessoas e evita incentivar comportamentos autodestrutivos, como vício, alimentação desordenada ou conversa interna negativa."

Além disso, o Claude está programado para evitar a geração de conteúdo gráfico sexual, violento ou ilegal, mesmo que explicitamente solicitado.

Relacionado:

Por que isso é importante

O lançamento das solicitações do sistema da Grok marca uma mudança em direção a uma maior transparência no desenvolvimento da IA. Embora algumas empresas prefiram manter em segredo o funcionamento interno de sua IA, a decisão da xAI pode estabelecer um precedente para a abertura, especialmente depois que um comportamento inesperado, como o incidente do "genocídio branco", levantou preocupações sobre o alinhamento e o controle da IA.

Será que outras empresas de IA seguirão o exemplo? Só o tempo dirá. Mas, pelo menos por enquanto, temos uma visão mais clara de como a Grok pensa - ou, pelo menos, de como ela é instruída a pensar.

A Microsoft hospeda os modelos Grok 3 avançados da xAI em uma nova colaboração de IA

No início deste mês, meu jornalismo investigativo *Notepad* revelou os planos da Microsoft de integrar os modelos de IA Grok de Elon Musk - revelações que agora foram oficialmente confirmadas. Hoje, n

A Microsoft hospeda os modelos Grok 3 avançados da xAI em uma nova colaboração de IA

No início deste mês, meu jornalismo investigativo *Notepad* revelou os planos da Microsoft de integrar os modelos de IA Grok de Elon Musk - revelações que agora foram oficialmente confirmadas. Hoje, n

Apple se une à Anthropic para desenvolver ferramenta de codificação de IA para o Xcode

Apple e Anthropic colaboram em um assistente de codificação com IADe acordo com a Bloomberg, a Apple está desenvolvendo um assistente avançado de codificação com IA que será integrado diretamente ao

Apple se une à Anthropic para desenvolver ferramenta de codificação de IA para o Xcode

Apple e Anthropic colaboram em um assistente de codificação com IADe acordo com a Bloomberg, a Apple está desenvolvendo um assistente avançado de codificação com IA que será integrado diretamente ao

Marvel adia os dois próximos filmes dos Vingadores e ajusta o cronograma de lançamentos da Fase 6

A Marvel Studios anunciou mudanças significativas no cronograma de seus próximos filmes da franquia Vingadores. A publicação do setor The Hollywood Reporter revela que Avengers: Doomsday agora estrear

Marvel adia os dois próximos filmes dos Vingadores e ajusta o cronograma de lançamentos da Fase 6

A Marvel Studios anunciou mudanças significativas no cronograma de seus próximos filmes da franquia Vingadores. A publicação do setor The Hollywood Reporter revela que Avengers: Doomsday agora estrear

18 de Agosto de 2025 à59 14:00:59 WEST

18 de Agosto de 2025 à59 14:00:59 WEST

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

12 de Agosto de 2025 à59 00:00:59 WEST

12 de Agosto de 2025 à59 00:00:59 WEST

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

29 de Julho de 2025 à16 13:25:16 WEST

29 de Julho de 2025 à16 13:25:16 WEST

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0