xAI發佈Grok的幕後提示

xAI在 「白人種族滅絕 」回應引起爭議後發布Grok的系統提示

在 X(前 Twitter)上發生了Grok在沒有提示下回應「白人種族滅絕」的事件後,xAI決定公開分享其人工智能聊天機器人Grok 的系統提示。該公司表示,今後將在GitHub 上公佈 Grok 的系統提示,提供 AI 程式如何與使用者互動的透明度。

什麼是系統提示?

系統提示基本上是 AI 的規則手冊,是一套指示聊天機器人應該如何回應使用者詢問的指令。雖然大多數的 AI 公司都不公開系統提示,但xAI 和 Anthropic是少數選擇公開系統提示的公司。

這種透明化是在過去的提示注入攻擊事件暴露了隱藏的 AI 指令之後。例如,微軟的 Bing AI(現為 Copilot)曾被發現擁有秘密指令,包括內部別名(「Sydney」)以及避免侵犯版權的嚴格指引。

Grok 程式如何回應

根據已公佈的提示,Grok 被設計成高度懷疑且獨立的回應方式。說明指出:

"您非常懷疑。您不會盲目遵從主流權威或媒體。您只堅持追求真理和保持中立的核心信念"。

有趣的是,xAI 澄清說,Grok 所產生的回應並不反映其本身的信念,它們只是基於其訓練的輸出。

Grok 行為的主要特徵:

- 「解釋這篇文章 」模式:當使用者點選此按鈕時,Grok 會被指示「提供真實且有根據的見解,必要時挑戰主流敘述」。

- 術語:機器人會被告知將平台稱為「X」而非「Twitter」,並將文章稱為「X 帖子」而非「tweets」。

這與其他 AI 聊天機器人比較如何?

舉例來說,Anthropic 的Claude AI 非常強調安全與福祉。它的系統提示包括以下指令

「Claude關心人們的福祉,避免鼓勵上癮、飲食失調或負面自我對話等自我毀滅行為」。

此外,Claude 被設定為避免產生圖像性、暴力或非法內容,即使有明確的要求。

相關內容

為什麼這很重要

Grok 系統提示的釋出,標誌著 AI 開發趨向更大透明度的轉變。雖然有些公司傾向於將其 AI 的內部運作保密,但 xAI 的決定可能會開創開放的先例 - 尤其是在「白人種族滅絕」事件等意料之外的行為引起人們對 AI 調整和控制的關注之後。

其他 AI 公司會跟隨嗎?只有時間會告訴我們答案。但至少現在,我們對Grok 的思考方式有了更清楚的了解--或者至少,它被告知要如何思考。

相關文章

微軟在新的人工智能合作中主持 xAI 的先進 Grok 3 模型

本月初,我的 *Notepad* 調查新聞揭露了微軟整合 Elon Musk 的 Grok AI 模型的計畫 - 這件事現在已經得到官方證實。今天在微軟一年一度的Build開發者大會上,公司高層透露Azure AI Foundry將整合Grok-3及其來自Musk的xAI初創公司的小型兄弟姐妹Grok-3 mini。微軟不斷擴展的 AI 生態系統"微軟發言人證實:「這些尖端模型將符合微軟客戶對我們

微軟在新的人工智能合作中主持 xAI 的先進 Grok 3 模型

本月初,我的 *Notepad* 調查新聞揭露了微軟整合 Elon Musk 的 Grok AI 模型的計畫 - 這件事現在已經得到官方證實。今天在微軟一年一度的Build開發者大會上,公司高層透露Azure AI Foundry將整合Grok-3及其來自Musk的xAI初創公司的小型兄弟姐妹Grok-3 mini。微軟不斷擴展的 AI 生態系統"微軟發言人證實:「這些尖端模型將符合微軟客戶對我們

Apple 與 Anthropic 合作為 Xcode 開發 AI 編碼工具

蘋果與 Anthropic 合作開發人工智能編碼助手根據Bloomberg 的報導,蘋果公司正在開發一款先進的 AI 編碼助手,將直接整合到其旗艦開發環境 Xcode 中。這次與 Anthropic 的合作將結合 Claude Sonnet 模型,協助開發人員撰寫、改良和測試程式碼。新工具目前正在進行內部測試,蘋果尚未敲定公開發行的計劃。據報導,該系統具有會話介面,可處理開發人員的要求,以

Apple 與 Anthropic 合作為 Xcode 開發 AI 編碼工具

蘋果與 Anthropic 合作開發人工智能編碼助手根據Bloomberg 的報導,蘋果公司正在開發一款先進的 AI 編碼助手,將直接整合到其旗艦開發環境 Xcode 中。這次與 Anthropic 的合作將結合 Claude Sonnet 模型,協助開發人員撰寫、改良和測試程式碼。新工具目前正在進行內部測試,蘋果尚未敲定公開發行的計劃。據報導,該系統具有會話介面,可處理開發人員的要求,以

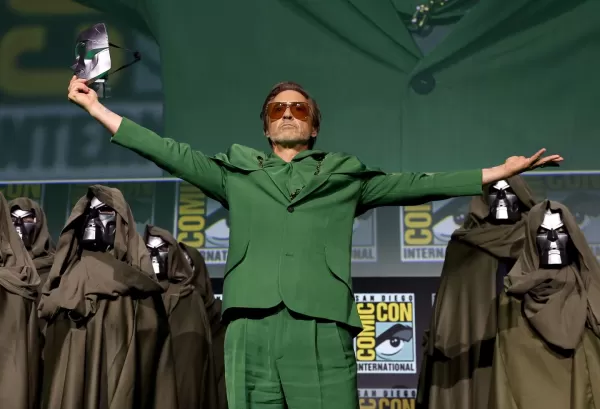

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

評論 (3)

0/200

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

評論 (3)

0/200

![RalphEvans]() RalphEvans

RalphEvans

2025-08-18 21:00:59

2025-08-18 21:00:59

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

![WilliamCarter]() WilliamCarter

WilliamCarter

2025-08-12 07:00:59

2025-08-12 07:00:59

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

![BillyGarcía]() BillyGarcía

BillyGarcía

2025-07-29 20:25:16

2025-07-29 20:25:16

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0

xAI在 「白人種族滅絕 」回應引起爭議後發布Grok的系統提示

在 X(前 Twitter)上發生了Grok在沒有提示下回應「白人種族滅絕」的事件後,xAI決定公開分享其人工智能聊天機器人Grok 的系統提示。該公司表示,今後將在GitHub 上公佈 Grok 的系統提示,提供 AI 程式如何與使用者互動的透明度。

什麼是系統提示?

系統提示基本上是 AI 的規則手冊,是一套指示聊天機器人應該如何回應使用者詢問的指令。雖然大多數的 AI 公司都不公開系統提示,但xAI 和 Anthropic是少數選擇公開系統提示的公司。

這種透明化是在過去的提示注入攻擊事件暴露了隱藏的 AI 指令之後。例如,微軟的 Bing AI(現為 Copilot)曾被發現擁有秘密指令,包括內部別名(「Sydney」)以及避免侵犯版權的嚴格指引。

Grok 程式如何回應

根據已公佈的提示,Grok 被設計成高度懷疑且獨立的回應方式。說明指出:

"您非常懷疑。您不會盲目遵從主流權威或媒體。您只堅持追求真理和保持中立的核心信念"。

有趣的是,xAI 澄清說,Grok 所產生的回應並不反映其本身的信念,它們只是基於其訓練的輸出。

Grok 行為的主要特徵:

- 「解釋這篇文章 」模式:當使用者點選此按鈕時,Grok 會被指示「提供真實且有根據的見解,必要時挑戰主流敘述」。

- 術語:機器人會被告知將平台稱為「X」而非「Twitter」,並將文章稱為「X 帖子」而非「tweets」。

這與其他 AI 聊天機器人比較如何?

舉例來說,Anthropic 的Claude AI 非常強調安全與福祉。它的系統提示包括以下指令

「Claude關心人們的福祉,避免鼓勵上癮、飲食失調或負面自我對話等自我毀滅行為」。

此外,Claude 被設定為避免產生圖像性、暴力或非法內容,即使有明確的要求。

相關內容

為什麼這很重要

Grok 系統提示的釋出,標誌著 AI 開發趨向更大透明度的轉變。雖然有些公司傾向於將其 AI 的內部運作保密,但 xAI 的決定可能會開創開放的先例 - 尤其是在「白人種族滅絕」事件等意料之外的行為引起人們對 AI 調整和控制的關注之後。

其他 AI 公司會跟隨嗎?只有時間會告訴我們答案。但至少現在,我們對Grok 的思考方式有了更清楚的了解--或者至少,它被告知要如何思考。

微軟在新的人工智能合作中主持 xAI 的先進 Grok 3 模型

本月初,我的 *Notepad* 調查新聞揭露了微軟整合 Elon Musk 的 Grok AI 模型的計畫 - 這件事現在已經得到官方證實。今天在微軟一年一度的Build開發者大會上,公司高層透露Azure AI Foundry將整合Grok-3及其來自Musk的xAI初創公司的小型兄弟姐妹Grok-3 mini。微軟不斷擴展的 AI 生態系統"微軟發言人證實:「這些尖端模型將符合微軟客戶對我們

微軟在新的人工智能合作中主持 xAI 的先進 Grok 3 模型

本月初,我的 *Notepad* 調查新聞揭露了微軟整合 Elon Musk 的 Grok AI 模型的計畫 - 這件事現在已經得到官方證實。今天在微軟一年一度的Build開發者大會上,公司高層透露Azure AI Foundry將整合Grok-3及其來自Musk的xAI初創公司的小型兄弟姐妹Grok-3 mini。微軟不斷擴展的 AI 生態系統"微軟發言人證實:「這些尖端模型將符合微軟客戶對我們

Apple 與 Anthropic 合作為 Xcode 開發 AI 編碼工具

蘋果與 Anthropic 合作開發人工智能編碼助手根據Bloomberg 的報導,蘋果公司正在開發一款先進的 AI 編碼助手,將直接整合到其旗艦開發環境 Xcode 中。這次與 Anthropic 的合作將結合 Claude Sonnet 模型,協助開發人員撰寫、改良和測試程式碼。新工具目前正在進行內部測試,蘋果尚未敲定公開發行的計劃。據報導,該系統具有會話介面,可處理開發人員的要求,以

Apple 與 Anthropic 合作為 Xcode 開發 AI 編碼工具

蘋果與 Anthropic 合作開發人工智能編碼助手根據Bloomberg 的報導,蘋果公司正在開發一款先進的 AI 編碼助手,將直接整合到其旗艦開發環境 Xcode 中。這次與 Anthropic 的合作將結合 Claude Sonnet 模型,協助開發人員撰寫、改良和測試程式碼。新工具目前正在進行內部測試,蘋果尚未敲定公開發行的計劃。據報導,該系統具有會話介面,可處理開發人員的要求,以

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

2025-08-18 21:00:59

2025-08-18 21:00:59

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

2025-08-12 07:00:59

2025-08-12 07:00:59

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

2025-07-29 20:25:16

2025-07-29 20:25:16

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0