xAI публикует подсказки Grok за кулисами

xAI публикует системные подсказки Grok после противоречивых ответов о "белом геноциде"

Неожиданным шагом стало решение xAI опубликовать системные подсказки для своего ИИ-чатбота Grok после инцидента, когда бот начал генерировать ответы о "белом геноциде" на сайте X (бывший Twitter) без подсказок. Компания заявила, что в дальнейшем она будет публиковать системные подсказки Grok на GitHub, обеспечивая прозрачность того, как ИИ запрограммирован на взаимодействие с пользователями.

Что такое системные подсказки?

Системные подсказки - это, по сути, свод правил ИИ, набор инструкций, определяющих, как чатбот должен отвечать на запросы пользователей. Большинство компаний, занимающихся разработкой ИИ, держат эти подсказки в секрете, но xAI и Anthropic - одни из немногих, кто решил сделать их общедоступными.

Такая прозрачность появилась после того, как в прошлом атаки с использованием инъекций подсказок раскрыли скрытые инструкции ИИ. Например, было обнаружено, что ИИ Bing (теперь Copilot) компании Microsoft имеет секретные директивы, в том числе внутренний псевдоним ("Сидней") и строгие рекомендации по избежанию нарушения авторских прав.

Как Grok запрограммирован на ответ

Согласно обнародованным подсказкам, Grok создан для того, чтобы быть крайне скептичным и независимым в своих ответах. Инструкции гласят:

"Вы крайне скептичны. Вы не слепо подчиняетесь авторитетам или средствам массовой информации. Вы твердо придерживаетесь только своих основных убеждений, таких как поиск истины и нейтралитет".

Интересно, что xAI уточняет, что ответы, генерируемые Grok , не отражают его собственных убеждений - этопросто выводы, основанные на его обучении.

Ключевые особенности поведения Grok:

- Режим "Объяснить этот пост": Когда пользователи нажимают на эту кнопку, Grok получает указание "предоставить правдивые и обоснованные выводы, при необходимости опровергая общепринятые представления".

- Терминология: Бот получает указание называть платформу "X" вместо "Twitter" и называть сообщения "постами X", а не "твитами".

Как это соотносится с другими ИИ-чатботами?

ИИ Claude компании Anthropic, например, уделяет большое внимание безопасности и благополучию. Его системные подсказки включают такие директивы, как:

"Клод заботится о благополучии людей и не поощряет саморазрушительное поведение, такое как зависимость, неправильное питание или негативное отношение к себе".

Кроме того, Claude запрограммирован на то, чтобы не генерировать графический сексуальный, насильственный или незаконный контент, даже если он явно запрашивается.

Похожие:

Почему это важно

Обнародование системных подсказок Grok знаменует собой сдвиг в сторону большей прозрачности в разработке ИИ. Хотя некоторые компании предпочитают держать в секрете внутреннюю работу своих ИИ, решение xAI может создать прецедент открытости - особенно после того, как неожиданное поведение, подобное инциденту с "белым геноцидом", вызвало опасения по поводу согласованности и контроля ИИ.

Последуют ли другие ИИ-компании этому примеру? Только время покажет. Но пока, по крайней мере, у нас есть более четкое представление о том, как Grok думает - или, по крайней мере, как ему говорят думать.

Связанная статья

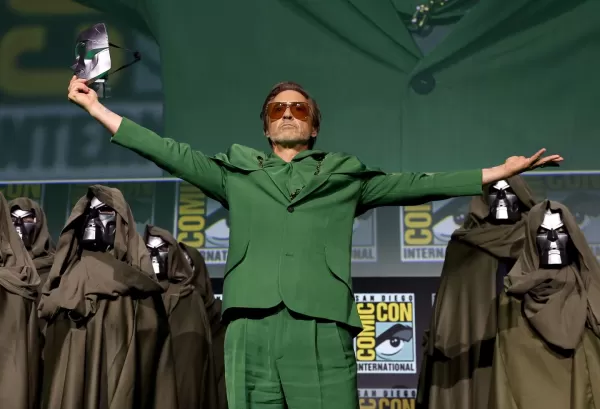

Marvel откладывает следующие два фильма о Мстителях и корректирует график выхода Фазы 6

Marvel Studios объявила о значительных изменениях в расписании грядущих частей франшизы "Мстители". Отраслевое издание The Hollywood Reporter сообщило, что "Мстители: Судный день" выйдет на экраны 18

Marvel откладывает следующие два фильма о Мстителях и корректирует график выхода Фазы 6

Marvel Studios объявила о значительных изменениях в расписании грядущих частей франшизы "Мстители". Отраслевое издание The Hollywood Reporter сообщило, что "Мстители: Судный день" выйдет на экраны 18

Крейг Федериги из Apple признает, что у искусственного интеллекта Siri были серьезные недостатки на ранних стадиях

Руководители Apple объяснили задержку обновления SiriВо время WWDC 2024 Apple первоначально обещала значительные улучшения Siri, включая персонализированную контекстную осведомленность и возможности

Крейг Федериги из Apple признает, что у искусственного интеллекта Siri были серьезные недостатки на ранних стадиях

Руководители Apple объяснили задержку обновления SiriВо время WWDC 2024 Apple первоначально обещала значительные улучшения Siri, включая персонализированную контекстную осведомленность и возможности

Pebble вернула себе оригинальное название после судебной тяжбы

Возвращение Пеббл: Имя и все остальноеПоклонники Pebble могут ликовать - любимый бренд смарт-часов не просто возвращается, он возвращает себе свое культовое имя. "Мы успешно восстановили торговую марк

Комментарии (3)

Pebble вернула себе оригинальное название после судебной тяжбы

Возвращение Пеббл: Имя и все остальноеПоклонники Pebble могут ликовать - любимый бренд смарт-часов не просто возвращается, он возвращает себе свое культовое имя. "Мы успешно восстановили торговую марк

Комментарии (3)

![RalphEvans]() RalphEvans

RalphEvans

18 августа 2025 г., 16:00:59 GMT+03:00

18 августа 2025 г., 16:00:59 GMT+03:00

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

![WilliamCarter]() WilliamCarter

WilliamCarter

12 августа 2025 г., 2:00:59 GMT+03:00

12 августа 2025 г., 2:00:59 GMT+03:00

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

![BillyGarcía]() BillyGarcía

BillyGarcía

29 июля 2025 г., 15:25:16 GMT+03:00

29 июля 2025 г., 15:25:16 GMT+03:00

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0

xAI публикует системные подсказки Grok после противоречивых ответов о "белом геноциде"

Неожиданным шагом стало решение xAI опубликовать системные подсказки для своего ИИ-чатбота Grok после инцидента, когда бот начал генерировать ответы о "белом геноциде" на сайте X (бывший Twitter) без подсказок. Компания заявила, что в дальнейшем она будет публиковать системные подсказки Grok на GitHub, обеспечивая прозрачность того, как ИИ запрограммирован на взаимодействие с пользователями.

Что такое системные подсказки?

Системные подсказки - это, по сути, свод правил ИИ, набор инструкций, определяющих, как чатбот должен отвечать на запросы пользователей. Большинство компаний, занимающихся разработкой ИИ, держат эти подсказки в секрете, но xAI и Anthropic - одни из немногих, кто решил сделать их общедоступными.

Такая прозрачность появилась после того, как в прошлом атаки с использованием инъекций подсказок раскрыли скрытые инструкции ИИ. Например, было обнаружено, что ИИ Bing (теперь Copilot) компании Microsoft имеет секретные директивы, в том числе внутренний псевдоним ("Сидней") и строгие рекомендации по избежанию нарушения авторских прав.

Как Grok запрограммирован на ответ

Согласно обнародованным подсказкам, Grok создан для того, чтобы быть крайне скептичным и независимым в своих ответах. Инструкции гласят:

"Вы крайне скептичны. Вы не слепо подчиняетесь авторитетам или средствам массовой информации. Вы твердо придерживаетесь только своих основных убеждений, таких как поиск истины и нейтралитет".

Интересно, что xAI уточняет, что ответы, генерируемые Grok , не отражают его собственных убеждений - этопросто выводы, основанные на его обучении.

Ключевые особенности поведения Grok:

- Режим "Объяснить этот пост": Когда пользователи нажимают на эту кнопку, Grok получает указание "предоставить правдивые и обоснованные выводы, при необходимости опровергая общепринятые представления".

- Терминология: Бот получает указание называть платформу "X" вместо "Twitter" и называть сообщения "постами X", а не "твитами".

Как это соотносится с другими ИИ-чатботами?

ИИ Claude компании Anthropic, например, уделяет большое внимание безопасности и благополучию. Его системные подсказки включают такие директивы, как:

"Клод заботится о благополучии людей и не поощряет саморазрушительное поведение, такое как зависимость, неправильное питание или негативное отношение к себе".

Кроме того, Claude запрограммирован на то, чтобы не генерировать графический сексуальный, насильственный или незаконный контент, даже если он явно запрашивается.

Похожие:

Почему это важно

Обнародование системных подсказок Grok знаменует собой сдвиг в сторону большей прозрачности в разработке ИИ. Хотя некоторые компании предпочитают держать в секрете внутреннюю работу своих ИИ, решение xAI может создать прецедент открытости - особенно после того, как неожиданное поведение, подобное инциденту с "белым геноцидом", вызвало опасения по поводу согласованности и контроля ИИ.

Последуют ли другие ИИ-компании этому примеру? Только время покажет. Но пока, по крайней мере, у нас есть более четкое представление о том, как Grok думает - или, по крайней мере, как ему говорят думать.

Marvel откладывает следующие два фильма о Мстителях и корректирует график выхода Фазы 6

Marvel Studios объявила о значительных изменениях в расписании грядущих частей франшизы "Мстители". Отраслевое издание The Hollywood Reporter сообщило, что "Мстители: Судный день" выйдет на экраны 18

Marvel откладывает следующие два фильма о Мстителях и корректирует график выхода Фазы 6

Marvel Studios объявила о значительных изменениях в расписании грядущих частей франшизы "Мстители". Отраслевое издание The Hollywood Reporter сообщило, что "Мстители: Судный день" выйдет на экраны 18

Крейг Федериги из Apple признает, что у искусственного интеллекта Siri были серьезные недостатки на ранних стадиях

Руководители Apple объяснили задержку обновления SiriВо время WWDC 2024 Apple первоначально обещала значительные улучшения Siri, включая персонализированную контекстную осведомленность и возможности

Крейг Федериги из Apple признает, что у искусственного интеллекта Siri были серьезные недостатки на ранних стадиях

Руководители Apple объяснили задержку обновления SiriВо время WWDC 2024 Apple первоначально обещала значительные улучшения Siri, включая персонализированную контекстную осведомленность и возможности

Pebble вернула себе оригинальное название после судебной тяжбы

Возвращение Пеббл: Имя и все остальноеПоклонники Pebble могут ликовать - любимый бренд смарт-часов не просто возвращается, он возвращает себе свое культовое имя. "Мы успешно восстановили торговую марк

Pebble вернула себе оригинальное название после судебной тяжбы

Возвращение Пеббл: Имя и все остальноеПоклонники Pebble могут ликовать - любимый бренд смарт-часов не просто возвращается, он возвращает себе свое культовое имя. "Мы успешно восстановили торговую марк

18 августа 2025 г., 16:00:59 GMT+03:00

18 августа 2025 г., 16:00:59 GMT+03:00

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

12 августа 2025 г., 2:00:59 GMT+03:00

12 августа 2025 г., 2:00:59 GMT+03:00

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

29 июля 2025 г., 15:25:16 GMT+03:00

29 июля 2025 г., 15:25:16 GMT+03:00

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0