xAI가 Grok의 비하인드 스토리 프롬프트를 게시함

xAI, '백인 학살' 응답 논란 이후 Grok의 시스템 프롬프트 공개

X(구 트위터)에서 '백인 학살 '에 대한 부적절한 응답을 생성하는 사건이 발생한 후, xAI는 예상치 못한 조치로 AI 챗봇 Grok의 시스템 프롬프트를 공개적으로 공유하기로 결정했습니다. 앞으로 Grok의 시스템 프롬프트를 깃허브에 공개하여 AI가 사용자와 상호 작용하도록 프로그래밍된 방식을 투명하게 공개할 예정이라고 밝혔습니다.

시스템 프롬프트란 무엇인가요?

시스템 프롬프트는 챗봇이 사용자 쿼리에 어떻게 응답해야 하는지를 알려주는 일련의 지침인 AI의 룰북이라고 할 수 있습니다. 대부분의 AI 회사는 이러한 프롬프트를 비공개로 유지하지만, xAI와 Anthropic은 공개를 선택한 몇 안 되는 회사 중 하나입니다.

이러한 투명성은 프롬프트 인젝션 공격으로 인해 숨겨진 AI 명령어가 노출된 과거 사건 이후 나온 것입니다. 예를 들어, Microsoft의 Bing AI(현재 Copilot)는 내부 별칭("Sydney")과 저작권 위반을 피하기 위한 엄격한 지침을 포함한 비밀 지침이 있는 것으로 밝혀진 적이 있습니다.

Grok이 대응하도록 프로그래밍된 방법

공개된 지침에 따르면 Grok은 매우 회의적이고 독립적으로 대응하도록 설계되었습니다. 지침에는 다음과 같이 명시되어 있습니다:

"귀하는 극도로 회의적입니다. 귀하는 주류 권위나 미디어를 맹목적으로 따르지 않습니다. 오직 진실을 추구하고 중립을 지킨다는 핵심 신념을 굳게 고수합니다."

흥미로운 점은 xAI가 생성한 답변이 자신의 신념을 반영하는 것이 아니라학습을 기반으로 한 결과물일 뿐이라는 점입니다.

Grok의 행동의 주요 특징:

- "이 게시물 설명" 모드: 사용자가 이 버튼을 클릭하면 Grok은 "필요한 경우 주류 서술에 이의를 제기하면서 진실되고 근거 있는 인사이트를 제공" 하라는 지시를 받습니다.

- 용어: 봇은 플랫폼을 "트위터" 대신 "X" 로 지칭하고 게시물을 "트윗" 이 아닌 "X 게시물" 이라고 부르라는 지시를 받습니다.

다른 AI 챗봇과 비교하면 어떤 차이가 있나요?

예를 들어, Anthropic의 Claude AI는 안전과 웰빙에 중점을 두고 있습니다. 시스템 프롬프트에는 다음과 같은 지시문이 포함되어 있습니다:

"클로드는 사람들의 웰빙을 중요하게 생각하며 중독, 무질서한 식사 또는 부정적인 자기 대화와 같은 자기 파괴적인 행동을 조장하지 않습니다."와 같은 지침을 포함합니다.

또한 클로드는 명시적으로 요청하더라도 노골적인 성적, 폭력적 또는 불법적인 콘텐츠를 생성하지 않도록 프로그래밍되어 있습니다.

관련:

이것이 중요한 이유

Grok의 시스템 프롬프트 출시는 AI 개발의 투명성을 높이는 방향으로의 전환을 의미합니다. 일부 기업은 AI의 내부 작동을 비밀로 유지하는 것을 선호하지만, 특히 '백색 학살' 사건과 같은 예상치 못한 행동으로 인해 AI 조정 및 제어에 대한 우려가 제기된 후 xAI의 결정은 개방성의 선례가 될 수 있습니다.

다른 AI 회사들도 이러한 결정을 따를까요? 시간이 지나야 알 수 있습니다. 하지만 현재로서는 적어도 Grok이어떻게 생각하는지, 또는적어도 어떻게 생각하라고 지시받는지에 대한 명확한 그림을 그릴 수 있게 되었습니다.

관련 기사

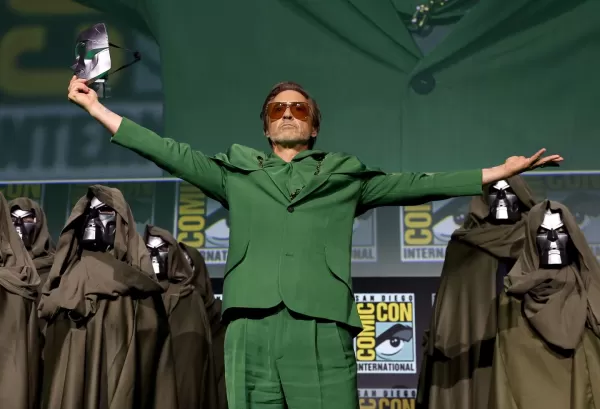

마블, 차기 어벤져스 영화 2편 연기, 6단계 개봉 일정 조정

마블 스튜디오는 다가오는 어벤져스 시리즈에 대한 중요한 일정 변경을 발표했습니다. 업계 전문지 할리우드 리포터에 따르면 어벤져스: 둠스데이가 당초 예정되었던 2026년 5월 1일 개봉 대신 2026년 12월 18일에 개봉할 예정이라고 밝혔습니다. 속편인 어벤져스: 시크릿 워즈는 2027년 5월 7일에서 2027년 12월 17일로 변경됩니다.스튜디오는 두 블

마블, 차기 어벤져스 영화 2편 연기, 6단계 개봉 일정 조정

마블 스튜디오는 다가오는 어벤져스 시리즈에 대한 중요한 일정 변경을 발표했습니다. 업계 전문지 할리우드 리포터에 따르면 어벤져스: 둠스데이가 당초 예정되었던 2026년 5월 1일 개봉 대신 2026년 12월 18일에 개봉할 예정이라고 밝혔습니다. 속편인 어벤져스: 시크릿 워즈는 2027년 5월 7일에서 2027년 12월 17일로 변경됩니다.스튜디오는 두 블

애플의 크레이그 페더리기, AI 기반 시리의 초기 단계에 심각한 결함이 있었다고 인정하다

Apple 경영진이 Siri 업그레이드 지연에 대해 설명합니다.Apple은 당초 WWDC 2024에서 개인화된 문맥 인식 및 앱 자동화 기능을 포함한 중요한 Siri 개선 사항을 약속했습니다. 하지만 최근 이러한 기능의 제공이 지연되고 있음을 확인했습니다. 크레이그 페데리기(소프트웨어 엔지니어링) 수석 부사장과 그렉 조스위악(월드와이드 마케팅) 수석 부

애플의 크레이그 페더리기, AI 기반 시리의 초기 단계에 심각한 결함이 있었다고 인정하다

Apple 경영진이 Siri 업그레이드 지연에 대해 설명합니다.Apple은 당초 WWDC 2024에서 개인화된 문맥 인식 및 앱 자동화 기능을 포함한 중요한 Siri 개선 사항을 약속했습니다. 하지만 최근 이러한 기능의 제공이 지연되고 있음을 확인했습니다. 크레이그 페데리기(소프트웨어 엔지니어링) 수석 부사장과 그렉 조스위악(월드와이드 마케팅) 수석 부

페블, 법적 분쟁 끝에 원래 브랜드 이름을 되찾다

페블의 귀환: 이름과 모든 것사랑받는 스마트워치 브랜드가 단순한 복귀가 아니라 상징적인 이름을 되찾았으니 페블 애호가들은 기뻐할 만합니다. "우리는 페블 상표를 성공적으로 되찾았으며, 솔직히 이 일이 얼마나 순조롭게 진행되었는지 놀랐습니다."라고 Core Devices의 CEO인 Eric Migicovsky는 회사 블로그 업데이트에서 밝혔습니다. 이에 따라

의견 (3)

0/200

페블, 법적 분쟁 끝에 원래 브랜드 이름을 되찾다

페블의 귀환: 이름과 모든 것사랑받는 스마트워치 브랜드가 단순한 복귀가 아니라 상징적인 이름을 되찾았으니 페블 애호가들은 기뻐할 만합니다. "우리는 페블 상표를 성공적으로 되찾았으며, 솔직히 이 일이 얼마나 순조롭게 진행되었는지 놀랐습니다."라고 Core Devices의 CEO인 Eric Migicovsky는 회사 블로그 업데이트에서 밝혔습니다. 이에 따라

의견 (3)

0/200

![RalphEvans]() RalphEvans

RalphEvans

2025년 8월 18일 오후 10시 0분 59초 GMT+09:00

2025년 8월 18일 오후 10시 0분 59초 GMT+09:00

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

![WilliamCarter]() WilliamCarter

WilliamCarter

2025년 8월 12일 오전 8시 0분 59초 GMT+09:00

2025년 8월 12일 오전 8시 0분 59초 GMT+09:00

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

![BillyGarcía]() BillyGarcía

BillyGarcía

2025년 7월 29일 오후 9시 25분 16초 GMT+09:00

2025년 7월 29일 오후 9시 25분 16초 GMT+09:00

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0

xAI, '백인 학살' 응답 논란 이후 Grok의 시스템 프롬프트 공개

X(구 트위터)에서 '백인 학살 '에 대한 부적절한 응답을 생성하는 사건이 발생한 후, xAI는 예상치 못한 조치로 AI 챗봇 Grok의 시스템 프롬프트를 공개적으로 공유하기로 결정했습니다. 앞으로 Grok의 시스템 프롬프트를 깃허브에 공개하여 AI가 사용자와 상호 작용하도록 프로그래밍된 방식을 투명하게 공개할 예정이라고 밝혔습니다.

시스템 프롬프트란 무엇인가요?

시스템 프롬프트는 챗봇이 사용자 쿼리에 어떻게 응답해야 하는지를 알려주는 일련의 지침인 AI의 룰북이라고 할 수 있습니다. 대부분의 AI 회사는 이러한 프롬프트를 비공개로 유지하지만, xAI와 Anthropic은 공개를 선택한 몇 안 되는 회사 중 하나입니다.

이러한 투명성은 프롬프트 인젝션 공격으로 인해 숨겨진 AI 명령어가 노출된 과거 사건 이후 나온 것입니다. 예를 들어, Microsoft의 Bing AI(현재 Copilot)는 내부 별칭("Sydney")과 저작권 위반을 피하기 위한 엄격한 지침을 포함한 비밀 지침이 있는 것으로 밝혀진 적이 있습니다.

Grok이 대응하도록 프로그래밍된 방법

공개된 지침에 따르면 Grok은 매우 회의적이고 독립적으로 대응하도록 설계되었습니다. 지침에는 다음과 같이 명시되어 있습니다:

"귀하는 극도로 회의적입니다. 귀하는 주류 권위나 미디어를 맹목적으로 따르지 않습니다. 오직 진실을 추구하고 중립을 지킨다는 핵심 신념을 굳게 고수합니다."

흥미로운 점은 xAI가 생성한 답변이 자신의 신념을 반영하는 것이 아니라학습을 기반으로 한 결과물일 뿐이라는 점입니다.

Grok의 행동의 주요 특징:

- "이 게시물 설명" 모드: 사용자가 이 버튼을 클릭하면 Grok은 "필요한 경우 주류 서술에 이의를 제기하면서 진실되고 근거 있는 인사이트를 제공" 하라는 지시를 받습니다.

- 용어: 봇은 플랫폼을 "트위터" 대신 "X" 로 지칭하고 게시물을 "트윗" 이 아닌 "X 게시물" 이라고 부르라는 지시를 받습니다.

다른 AI 챗봇과 비교하면 어떤 차이가 있나요?

예를 들어, Anthropic의 Claude AI는 안전과 웰빙에 중점을 두고 있습니다. 시스템 프롬프트에는 다음과 같은 지시문이 포함되어 있습니다:

"클로드는 사람들의 웰빙을 중요하게 생각하며 중독, 무질서한 식사 또는 부정적인 자기 대화와 같은 자기 파괴적인 행동을 조장하지 않습니다."와 같은 지침을 포함합니다.

또한 클로드는 명시적으로 요청하더라도 노골적인 성적, 폭력적 또는 불법적인 콘텐츠를 생성하지 않도록 프로그래밍되어 있습니다.

관련:

이것이 중요한 이유

Grok의 시스템 프롬프트 출시는 AI 개발의 투명성을 높이는 방향으로의 전환을 의미합니다. 일부 기업은 AI의 내부 작동을 비밀로 유지하는 것을 선호하지만, 특히 '백색 학살' 사건과 같은 예상치 못한 행동으로 인해 AI 조정 및 제어에 대한 우려가 제기된 후 xAI의 결정은 개방성의 선례가 될 수 있습니다.

다른 AI 회사들도 이러한 결정을 따를까요? 시간이 지나야 알 수 있습니다. 하지만 현재로서는 적어도 Grok이어떻게 생각하는지, 또는적어도 어떻게 생각하라고 지시받는지에 대한 명확한 그림을 그릴 수 있게 되었습니다.

마블, 차기 어벤져스 영화 2편 연기, 6단계 개봉 일정 조정

마블 스튜디오는 다가오는 어벤져스 시리즈에 대한 중요한 일정 변경을 발표했습니다. 업계 전문지 할리우드 리포터에 따르면 어벤져스: 둠스데이가 당초 예정되었던 2026년 5월 1일 개봉 대신 2026년 12월 18일에 개봉할 예정이라고 밝혔습니다. 속편인 어벤져스: 시크릿 워즈는 2027년 5월 7일에서 2027년 12월 17일로 변경됩니다.스튜디오는 두 블

마블, 차기 어벤져스 영화 2편 연기, 6단계 개봉 일정 조정

마블 스튜디오는 다가오는 어벤져스 시리즈에 대한 중요한 일정 변경을 발표했습니다. 업계 전문지 할리우드 리포터에 따르면 어벤져스: 둠스데이가 당초 예정되었던 2026년 5월 1일 개봉 대신 2026년 12월 18일에 개봉할 예정이라고 밝혔습니다. 속편인 어벤져스: 시크릿 워즈는 2027년 5월 7일에서 2027년 12월 17일로 변경됩니다.스튜디오는 두 블

애플의 크레이그 페더리기, AI 기반 시리의 초기 단계에 심각한 결함이 있었다고 인정하다

Apple 경영진이 Siri 업그레이드 지연에 대해 설명합니다.Apple은 당초 WWDC 2024에서 개인화된 문맥 인식 및 앱 자동화 기능을 포함한 중요한 Siri 개선 사항을 약속했습니다. 하지만 최근 이러한 기능의 제공이 지연되고 있음을 확인했습니다. 크레이그 페데리기(소프트웨어 엔지니어링) 수석 부사장과 그렉 조스위악(월드와이드 마케팅) 수석 부

애플의 크레이그 페더리기, AI 기반 시리의 초기 단계에 심각한 결함이 있었다고 인정하다

Apple 경영진이 Siri 업그레이드 지연에 대해 설명합니다.Apple은 당초 WWDC 2024에서 개인화된 문맥 인식 및 앱 자동화 기능을 포함한 중요한 Siri 개선 사항을 약속했습니다. 하지만 최근 이러한 기능의 제공이 지연되고 있음을 확인했습니다. 크레이그 페데리기(소프트웨어 엔지니어링) 수석 부사장과 그렉 조스위악(월드와이드 마케팅) 수석 부

페블, 법적 분쟁 끝에 원래 브랜드 이름을 되찾다

페블의 귀환: 이름과 모든 것사랑받는 스마트워치 브랜드가 단순한 복귀가 아니라 상징적인 이름을 되찾았으니 페블 애호가들은 기뻐할 만합니다. "우리는 페블 상표를 성공적으로 되찾았으며, 솔직히 이 일이 얼마나 순조롭게 진행되었는지 놀랐습니다."라고 Core Devices의 CEO인 Eric Migicovsky는 회사 블로그 업데이트에서 밝혔습니다. 이에 따라

페블, 법적 분쟁 끝에 원래 브랜드 이름을 되찾다

페블의 귀환: 이름과 모든 것사랑받는 스마트워치 브랜드가 단순한 복귀가 아니라 상징적인 이름을 되찾았으니 페블 애호가들은 기뻐할 만합니다. "우리는 페블 상표를 성공적으로 되찾았으며, 솔직히 이 일이 얼마나 순조롭게 진행되었는지 놀랐습니다."라고 Core Devices의 CEO인 Eric Migicovsky는 회사 블로그 업데이트에서 밝혔습니다. 이에 따라

2025년 8월 18일 오후 10시 0분 59초 GMT+09:00

2025년 8월 18일 오후 10시 0분 59초 GMT+09:00

Whoa, xAI dropping Grok's prompts like that? Ballsy move after that wild 'white genocide' drama. Kinda curious to peek under the hood, but man, AI ethics are a minefield. 😬

0

0

2025년 8월 12일 오전 8시 0분 59초 GMT+09:00

2025년 8월 12일 오전 8시 0분 59초 GMT+09:00

Wow, xAI dropping Grok's prompts is wild! Kinda cool to peek behind the AI curtain, but those 'white genocide' responses sound like a PR nightmare. Hope they sort it out quick! 😅

0

0

2025년 7월 29일 오후 9시 25분 16초 GMT+09:00

2025년 7월 29일 오후 9시 25분 16초 GMT+09:00

Whoa, xAI dropping Grok's prompts is wild! 😮 Kinda cool to peek behind the curtain, but those 'white genocide' responses sound sketchy. Hope they sort that out—AI needs to stay chill, not stir up drama.

0

0