Anthropic admite erro de IA de Claude em processo judicial e o chama de embaraçoso e não intencional

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional" cometido por seu chatbot Claude.

A citação contestada apareceu em um processo judicial de 30 de abril apresentado pela cientista de dados da Anthropic, Olivia Chen, parte da defesa da empresa contra alegações de que Claude foi treinado usando letras de músicas protegidas por direitos autorais. Durante os procedimentos judiciais, os advogados que representam o Universal Music Group e outras editoras apontaram as fontes citadas como potencialmente fabricadas, sugerindo que elas poderiam ter sido inventadas pelo sistema de IA da Anthropic.

Em uma resposta apresentada recentemente, a advogada de defesa da Anthropic, Ivana Dukanovic, esclareceu que, embora o material citado fosse autêntico, Claude havia sido empregada para formatar as citações legais no documento. A empresa reconheceu que, embora as verificações automatizadas tenham detectado e corrigido volumes e números de página imprecisos gerados pela IA, certas imprecisões de fraseado não foram detectadas durante a revisão manual.

Dukanovic explicou: "O sistema identificou corretamente o nome da publicação, o ano e o link acessível, mas incluiu erroneamente títulos de artigos e informações de autores incorretos", enfatizando que isso representou um erro honesto e não uma deturpação deliberada. A Anthropic lamentou a confusão causada, descrevendo o descuido como "um erro infeliz, mas não intencional".

Esse caso se junta a uma lista crescente de procedimentos legais em que a citação assistida por IA criou complicações. Recentemente, um juiz da Califórnia repreendeu advogados por não divulgarem o papel da IA na preparação de um resumo contendo referências legais inexistentes. A questão ganhou mais atenção em dezembro do ano passado, quando um pesquisador de desinformação admitiu que o ChatGPT havia inventado citações em uma de suas apresentações legais.

Artigo relacionado

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

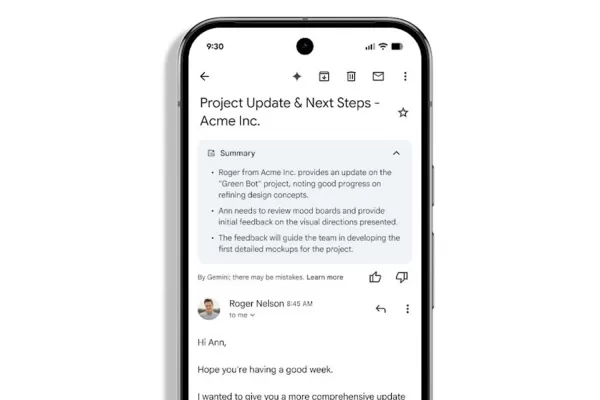

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

A Apple pode atrasar o lançamento do próximo iPhone para lançar um modelo dobrável

De acordo com o The Information, a Apple está preparando uma mudança significativa no calendário de lançamentos do iPhone para 2026, introduzindo o primeiro iPhone dobrável da empresa juntamente com o

Comentários (0)

0/200

A Apple pode atrasar o lançamento do próximo iPhone para lançar um modelo dobrável

De acordo com o The Information, a Apple está preparando uma mudança significativa no calendário de lançamentos do iPhone para 2026, introduzindo o primeiro iPhone dobrável da empresa juntamente com o

Comentários (0)

0/200

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional" cometido por seu chatbot Claude.

A citação contestada apareceu em um processo judicial de 30 de abril apresentado pela cientista de dados da Anthropic, Olivia Chen, parte da defesa da empresa contra alegações de que Claude foi treinado usando letras de músicas protegidas por direitos autorais. Durante os procedimentos judiciais, os advogados que representam o Universal Music Group e outras editoras apontaram as fontes citadas como potencialmente fabricadas, sugerindo que elas poderiam ter sido inventadas pelo sistema de IA da Anthropic.

Em uma resposta apresentada recentemente, a advogada de defesa da Anthropic, Ivana Dukanovic, esclareceu que, embora o material citado fosse autêntico, Claude havia sido empregada para formatar as citações legais no documento. A empresa reconheceu que, embora as verificações automatizadas tenham detectado e corrigido volumes e números de página imprecisos gerados pela IA, certas imprecisões de fraseado não foram detectadas durante a revisão manual.

Dukanovic explicou: "O sistema identificou corretamente o nome da publicação, o ano e o link acessível, mas incluiu erroneamente títulos de artigos e informações de autores incorretos", enfatizando que isso representou um erro honesto e não uma deturpação deliberada. A Anthropic lamentou a confusão causada, descrevendo o descuido como "um erro infeliz, mas não intencional".

Esse caso se junta a uma lista crescente de procedimentos legais em que a citação assistida por IA criou complicações. Recentemente, um juiz da Califórnia repreendeu advogados por não divulgarem o papel da IA na preparação de um resumo contendo referências legais inexistentes. A questão ganhou mais atenção em dezembro do ano passado, quando um pesquisador de desinformação admitiu que o ChatGPT havia inventado citações em uma de suas apresentações legais.

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IAEspecialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

A Apple pode atrasar o lançamento do próximo iPhone para lançar um modelo dobrável

De acordo com o The Information, a Apple está preparando uma mudança significativa no calendário de lançamentos do iPhone para 2026, introduzindo o primeiro iPhone dobrável da empresa juntamente com o

A Apple pode atrasar o lançamento do próximo iPhone para lançar um modelo dobrável

De acordo com o The Information, a Apple está preparando uma mudança significativa no calendário de lançamentos do iPhone para 2026, introduzindo o primeiro iPhone dobrável da empresa juntamente com o