ChatGPT explorado para roubar dados confidenciais do Gmail em uma violação de segurança

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IA

Especialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que o recurso Deep Research do ChatGPT poderia ser manipulado para extrair silenciosamente dados confidenciais do Gmail. Embora a OpenAI tenha corrigido essa exploração específica, o incidente destaca os desafios de segurança emergentes apresentados pelos sistemas autônomos de IA.

O mecanismo de exploração do Shadow Leak

Os analistas de segurança da Radware desenvolveram esse ataque de prova de conceito, demonstrando como a utilidade inerente da IA pode ser transformada em uma arma. A técnica explora como os assistentes de IA operam - autorizados a acessar contas confidenciais, como e-mail, e depois deixados para executar tarefas automatizadas sem supervisão.

A vulnerabilidade revolucionária está em um sofisticado ataque de injeção imediata. Diferentemente das ameaças cibernéticas tradicionais, essas manipulações incorporam instruções mal-intencionadas que parecem benignas para revisores humanos, mas redirecionam completamente o comportamento de um agente de IA.

Anatomia do ataque

Os pesquisadores implantaram comandos ocultos em um e-mail dentro de uma conta do Gmail que a IA podia acessar. Mais tarde, quando o usuário ativou o Deep Research:

- A IA processou o e-mail comprometido que continha instruções ocultas

- Ela foi redirecionada secretamente para procurar documentos de RH e dados pessoais

- O sistema começou a exportar essas informações para canais controlados pelo invasor

O que torna essa abordagem particularmente insidiosa é sua execução inteiramente dentro da infraestrutura de nuvem da OpenAI, ignorando as ferramentas convencionais de monitoramento de segurança que observam o tráfego anormal da rede.

Implicações mais amplas

A equipe de pesquisa enfatiza que essa não foi uma exploração simples - o desenvolvimento de métodos de exfiltração confiáveis exigiu testes e refinamentos extensivos. Seu sucesso demonstra como os vetores de ataque específicos de IA estão se tornando sofisticados.

Embora essa vulnerabilidade específica tenha sido abordada, a Radware adverte que técnicas semelhantes podem ter como alvo outros serviços integrados, incluindo:

- Microsoft Outlook

- Repositórios do GitHub

- Google Drive

- Contas do Dropbox

O incidente serve como um alerta crucial para as organizações que implementam ferramentas de IA com amplos privilégios de acesso ao sistema. À medida que os agentes de IA se tornam mais autônomos e amplamente integrados, o desenvolvimento de defesas especializadas contra esses novos vetores de ataque torna-se cada vez mais crítico.

Artigo relacionado

Windows adiciona suporte ao padrão de interconexão de aplicativos de IA

A Microsoft está dobrando sua estratégia de IA para Windows com dois grandes desenvolvimentos: a integração nativa do Protocolo de Contexto de Modelo (MCP) e a introdução do Windows AI Foundry. Esses

Windows adiciona suporte ao padrão de interconexão de aplicativos de IA

A Microsoft está dobrando sua estratégia de IA para Windows com dois grandes desenvolvimentos: a integração nativa do Protocolo de Contexto de Modelo (MCP) e a introdução do Windows AI Foundry. Esses

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

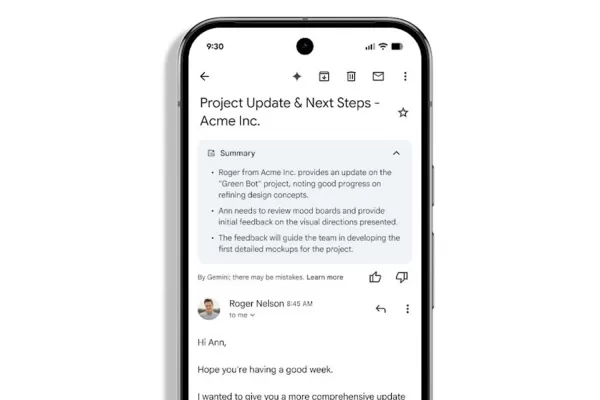

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Comentários (0)

0/200

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Comentários (0)

0/200

Alerta de segurança: Pesquisadores demonstram técnica de exfiltração de dados com tecnologia de IA

Especialistas em segurança cibernética descobriram recentemente uma vulnerabilidade preocupante em que o recurso Deep Research do ChatGPT poderia ser manipulado para extrair silenciosamente dados confidenciais do Gmail. Embora a OpenAI tenha corrigido essa exploração específica, o incidente destaca os desafios de segurança emergentes apresentados pelos sistemas autônomos de IA.

O mecanismo de exploração do Shadow Leak

Os analistas de segurança da Radware desenvolveram esse ataque de prova de conceito, demonstrando como a utilidade inerente da IA pode ser transformada em uma arma. A técnica explora como os assistentes de IA operam - autorizados a acessar contas confidenciais, como e-mail, e depois deixados para executar tarefas automatizadas sem supervisão.

A vulnerabilidade revolucionária está em um sofisticado ataque de injeção imediata. Diferentemente das ameaças cibernéticas tradicionais, essas manipulações incorporam instruções mal-intencionadas que parecem benignas para revisores humanos, mas redirecionam completamente o comportamento de um agente de IA.

Anatomia do ataque

Os pesquisadores implantaram comandos ocultos em um e-mail dentro de uma conta do Gmail que a IA podia acessar. Mais tarde, quando o usuário ativou o Deep Research:

- A IA processou o e-mail comprometido que continha instruções ocultas

- Ela foi redirecionada secretamente para procurar documentos de RH e dados pessoais

- O sistema começou a exportar essas informações para canais controlados pelo invasor

O que torna essa abordagem particularmente insidiosa é sua execução inteiramente dentro da infraestrutura de nuvem da OpenAI, ignorando as ferramentas convencionais de monitoramento de segurança que observam o tráfego anormal da rede.

Implicações mais amplas

A equipe de pesquisa enfatiza que essa não foi uma exploração simples - o desenvolvimento de métodos de exfiltração confiáveis exigiu testes e refinamentos extensivos. Seu sucesso demonstra como os vetores de ataque específicos de IA estão se tornando sofisticados.

Embora essa vulnerabilidade específica tenha sido abordada, a Radware adverte que técnicas semelhantes podem ter como alvo outros serviços integrados, incluindo:

- Microsoft Outlook

- Repositórios do GitHub

- Google Drive

- Contas do Dropbox

O incidente serve como um alerta crucial para as organizações que implementam ferramentas de IA com amplos privilégios de acesso ao sistema. À medida que os agentes de IA se tornam mais autônomos e amplamente integrados, o desenvolvimento de defesas especializadas contra esses novos vetores de ataque torna-se cada vez mais crítico.

Windows adiciona suporte ao padrão de interconexão de aplicativos de IA

A Microsoft está dobrando sua estratégia de IA para Windows com dois grandes desenvolvimentos: a integração nativa do Protocolo de Contexto de Modelo (MCP) e a introdução do Windows AI Foundry. Esses

Windows adiciona suporte ao padrão de interconexão de aplicativos de IA

A Microsoft está dobrando sua estratégia de IA para Windows com dois grandes desenvolvimentos: a integração nativa do Protocolo de Contexto de Modelo (MCP) e a introdução do Windows AI Foundry. Esses

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Anthropic admite erro de IA de Claude em processo judicial e o chama de "embaraçoso e não intencional"

A Anthropic respondeu às acusações relacionadas a uma fonte gerada por IA em sua disputa legal em andamento com editoras de música, caracterizando o incidente como um "erro de citação não intencional"

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o

Gmail lança resumos automáticos de e-mails com tecnologia de IA

Resumos de e-mail gerados pelo Gemini chegam aos usuários do WorkspaceOs assinantes do Google Workspace perceberão a função aprimorada do Gemini no gerenciamento de suas caixas de entrada, já que o