Openai अपने ट्रांसक्रिप्शन और वॉयस-जनरेटिंग AI मॉडल को अपग्रेड करता है

OpenAI अपने API के माध्यम से ट्रांसक्रिप्शन और वॉयस जनरेशन के लिए नए AI मॉडल लॉन्च कर रहा है, जो अपने पिछले संस्करणों की तुलना में महत्वपूर्ण सुधार का वादा करते हैं। ये अपडेट OpenAI की व्यापक "एजेंटिक" दृष्टि का हिस्सा हैं, जो उपयोगकर्ताओं के लिए स्वतंत्र रूप से कार्य करने में सक्षम स्वायत्त प्रणालियों को बनाने पर केंद्रित है। हालांकि "एजेंट" शब्द पर बहस हो सकती है, OpenAI के प्रोडक्ट हेड, ओलिवियर गोडमेंट, इसे एक चैटबॉट के रूप में देखते हैं जो किसी व्यवसाय के ग्राहकों के साथ बातचीत कर सकता है।

"हम आने वाले महीनों में और अधिक एजेंट्स उभरते हुए देखेंगे," गोडमेंट ने टेकक्रंच के साथ एक ब्रीफिंग के दौरान साझा किया। "मुख्य लक्ष्य ग्राहकों और डेवलपर्स को उपयोगी, सुलभ और सटीक एजेंट्स का उपयोग करने में सहायता करना है।"

OpenAI का नवीनतम टेक्स्ट-टू-स्पीच मॉडल, जिसे "gpt-4o-mini-tts" नाम दिया गया है, न केवल अधिक जीवंत और सूक्ष्म भाषण उत्पन्न करने का लक्ष्य रखता है, बल्कि यह अपने पूर्ववर्तियों की तुलना में अधिक अनुकूलनीय भी है। डेवलपर्स अब प्राकृतिक भाषा कमांड का उपयोग करके मॉडल को निर्देशित कर सकते हैं, जैसे "पागल वैज्ञानिक की तरह बोलें" या "मनन शिक्षक की तरह शांत स्वर का उपयोग करें।" नियंत्रण का यह स्तर अधिक व्यक्तिगत वॉयस अनुभव की अनुमति देता है।

यहाँ एक "ट्रू क्राइम-स्टाइल," पुरानी आवाज का नमूना है:

और यहाँ एक महिला "पेशेवर" आवाज का उदाहरण है:

OpenAI की प्रोडक्ट टीम के सदस्य जेफ हैरिस ने टेकक्रंच को बताया कि लक्ष्य डेवलपर्स को वॉयस "अनुभव" और "संदर्भ" दोनों को अनुकूलित करने में सक्षम बनाना है। "विभिन्न परिदृश्यों में, आप एकरस आवाज नहीं चाहते," हैरिस ने समझाया। "उदाहरण के लिए, ग्राहक सहायता सेटिंग में जहां आवाज को किसी गलती के लिए खेद व्यक्त करने की आवश्यकता होती है, आप उस भावना को आवाज में डाल सकते हैं। हम दृढ़ता से मानते हैं कि डेवलपर्स और उपयोगकर्ता न केवल सामग्री, बल्कि बोलने के तरीके को भी नियंत्रित करना चाहते हैं।"

OpenAI के नए स्पीच-टू-टेक्स्ट ऑफरिंग्स, "gpt-4o-transcribe" और "gpt-4o-mini-transcribe," पुराने Whisper ट्रांसक्रिप्शन मॉडल को प्रतिस्थापित करने के लिए तैयार हैं। उच्च गुणवत्ता वाले विविध ऑडियो डेटा पर प्रशिक्षित, वे दावा करते हैं कि वे उच्चारण और विविध भाषण को बेहतर ढंग से संभालते हैं, यहां तक कि शोरगुल वाले वातावरण में भी। इसके अतिरिक्त, ये मॉडल "हैलुसिनेशन" की समस्या से कम प्रभावित हैं, जहां Whisper कभी-कभी शब्दों या पूरे अंशों का आविष्कार करता था, जिससे ट्रांसक्रिप्ट में नस्लीय टिप्पणियां या काल्पनिक चिकित्सा उपचार जैसे अशुद्धियां जुड़ जाती थीं।

"इस मामले में ये मॉडल Whisper की तुलना में महत्वपूर्ण सुधार दिखाते हैं," हैरिस ने उल्लेख किया। "मॉडल की सटीकता सुनिश्चित करना एक भरोसेमंद वॉयस अनुभव के लिए महत्वपूर्ण है, और सटीकता से हमारा मतलब है कि मॉडल बोले गए शब्दों को सही ढंग से कैप्चर करते हैं बिना अनकहे सामग्री को जोड़े।"

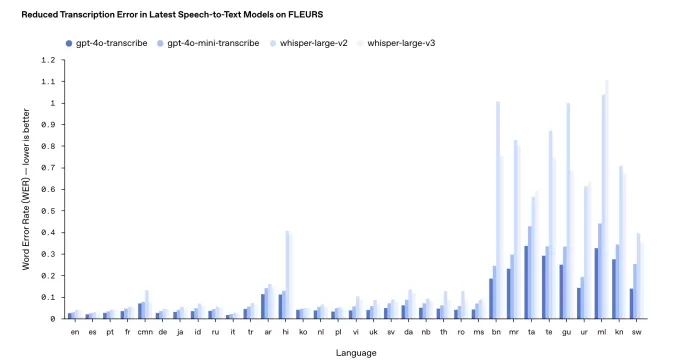

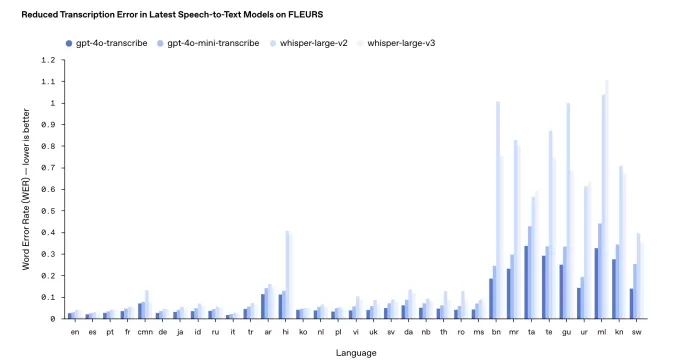

हालांकि, प्रदर्शन विभिन्न भाषाओं में भिन्न हो सकता है। OpenAI के आंतरिक बेंचमार्क इंगित करते हैं कि gpt-4o-transcribe, जो दोनों में अधिक सटीक है, तमिल, तेलुगु, मलयालम और कन्नड़ जैसी इंडिक और द्रविड़ भाषाओं के लिए "वर्ड एरर रेट" लगभग 30% है। इसका मतलब है कि इन भाषाओं में प्रत्येक दस में से लगभग तीन शब्द मानव ट्रांसक्रिप्शन से भिन्न हो सकते हैं।

OpenAI ट्रांसक्रिप्शन बेंचमार्किंग के परिणाम। चित्र साभार: OpenAI अपनी सामान्य प्रथा से हटकर, OpenAI इन नए ट्रांसक्रिप्शन मॉडल को मुफ्त में उपलब्ध नहीं कराएगा। ऐतिहासिक रूप से, उन्होंने नए Whisper संस्करणों को व्यावसायिक उपयोग के लिए MIT लाइसेंस के तहत जारी किया था। हैरिस ने बताया कि gpt-4o-transcribe और gpt-4o-mini-transcribe Whisper की तुलना में काफी बड़े हैं, जिससे वे खुले रिलीज के लिए उपयुक्त नहीं हैं।

"ये मॉडल Whisper की तरह एक सामान्य लैपटॉप पर चलाने के लिए बहुत बड़े हैं," हैरिस ने कहा। "जब हम मॉडल को खुला रिलीज करते हैं, तो हम इसे सोच-समझकर करना चाहते हैं, यह सुनिश्चित करते हुए कि वे विशिष्ट आवश्यकताओं के लिए अनुकूलित हों। हम अंतिम उपयोगकर्ता उपकरणों को ओपन-सोर्स मॉडल के लिए एक प्रमुख क्षेत्र के रूप में देखते हैं।"

20 मार्च, 2025, सुबह 11:54 बजे PT को अपडेट किया गया ताकि वर्ड एरर रेट के आसपास की भाषा को स्पष्ट किया जाए और बेंचमार्क परिणाम चार्ट को अधिक हाल के संस्करण के साथ अपडेट किया जाए।

संबंधित लेख

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

सूचना (31)

0/200

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

सूचना (31)

0/200

![BenHernández]() BenHernández

BenHernández

23 जुलाई 2025 2:20:48 अपराह्न IST

23 जुलाई 2025 2:20:48 अपराह्न IST

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

![GeorgeTaylor]() GeorgeTaylor

GeorgeTaylor

21 अप्रैल 2025 1:27:07 पूर्वाह्न IST

21 अप्रैल 2025 1:27:07 पूर्वाह्न IST

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

![GregoryAllen]() GregoryAllen

GregoryAllen

17 अप्रैल 2025 10:20:37 पूर्वाह्न IST

17 अप्रैल 2025 10:20:37 पूर्वाह्न IST

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

![StevenAllen]() StevenAllen

StevenAllen

17 अप्रैल 2025 10:08:26 पूर्वाह्न IST

17 अप्रैल 2025 10:08:26 पूर्वाह्न IST

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

![NicholasClark]() NicholasClark

NicholasClark

16 अप्रैल 2025 11:24:41 पूर्वाह्न IST

16 अप्रैल 2025 11:24:41 पूर्वाह्न IST

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0

![SamuelRoberts]() SamuelRoberts

SamuelRoberts

16 अप्रैल 2025 2:54:36 पूर्वाह्न IST

16 अप्रैल 2025 2:54:36 पूर्वाह्न IST

Os novos modelos de transcrição e geração de voz da OpenAI são incríveis! A qualidade melhorou muito em comparação com as versões anteriores. Só queria que fossem um pouco mais rápidos, mas no geral, estou muito satisfeito! 😊

0

0

OpenAI अपने API के माध्यम से ट्रांसक्रिप्शन और वॉयस जनरेशन के लिए नए AI मॉडल लॉन्च कर रहा है, जो अपने पिछले संस्करणों की तुलना में महत्वपूर्ण सुधार का वादा करते हैं। ये अपडेट OpenAI की व्यापक "एजेंटिक" दृष्टि का हिस्सा हैं, जो उपयोगकर्ताओं के लिए स्वतंत्र रूप से कार्य करने में सक्षम स्वायत्त प्रणालियों को बनाने पर केंद्रित है। हालांकि "एजेंट" शब्द पर बहस हो सकती है, OpenAI के प्रोडक्ट हेड, ओलिवियर गोडमेंट, इसे एक चैटबॉट के रूप में देखते हैं जो किसी व्यवसाय के ग्राहकों के साथ बातचीत कर सकता है।

"हम आने वाले महीनों में और अधिक एजेंट्स उभरते हुए देखेंगे," गोडमेंट ने टेकक्रंच के साथ एक ब्रीफिंग के दौरान साझा किया। "मुख्य लक्ष्य ग्राहकों और डेवलपर्स को उपयोगी, सुलभ और सटीक एजेंट्स का उपयोग करने में सहायता करना है।"

OpenAI का नवीनतम टेक्स्ट-टू-स्पीच मॉडल, जिसे "gpt-4o-mini-tts" नाम दिया गया है, न केवल अधिक जीवंत और सूक्ष्म भाषण उत्पन्न करने का लक्ष्य रखता है, बल्कि यह अपने पूर्ववर्तियों की तुलना में अधिक अनुकूलनीय भी है। डेवलपर्स अब प्राकृतिक भाषा कमांड का उपयोग करके मॉडल को निर्देशित कर सकते हैं, जैसे "पागल वैज्ञानिक की तरह बोलें" या "मनन शिक्षक की तरह शांत स्वर का उपयोग करें।" नियंत्रण का यह स्तर अधिक व्यक्तिगत वॉयस अनुभव की अनुमति देता है।

यहाँ एक "ट्रू क्राइम-स्टाइल," पुरानी आवाज का नमूना है:

और यहाँ एक महिला "पेशेवर" आवाज का उदाहरण है:

OpenAI की प्रोडक्ट टीम के सदस्य जेफ हैरिस ने टेकक्रंच को बताया कि लक्ष्य डेवलपर्स को वॉयस "अनुभव" और "संदर्भ" दोनों को अनुकूलित करने में सक्षम बनाना है। "विभिन्न परिदृश्यों में, आप एकरस आवाज नहीं चाहते," हैरिस ने समझाया। "उदाहरण के लिए, ग्राहक सहायता सेटिंग में जहां आवाज को किसी गलती के लिए खेद व्यक्त करने की आवश्यकता होती है, आप उस भावना को आवाज में डाल सकते हैं। हम दृढ़ता से मानते हैं कि डेवलपर्स और उपयोगकर्ता न केवल सामग्री, बल्कि बोलने के तरीके को भी नियंत्रित करना चाहते हैं।"

OpenAI के नए स्पीच-टू-टेक्स्ट ऑफरिंग्स, "gpt-4o-transcribe" और "gpt-4o-mini-transcribe," पुराने Whisper ट्रांसक्रिप्शन मॉडल को प्रतिस्थापित करने के लिए तैयार हैं। उच्च गुणवत्ता वाले विविध ऑडियो डेटा पर प्रशिक्षित, वे दावा करते हैं कि वे उच्चारण और विविध भाषण को बेहतर ढंग से संभालते हैं, यहां तक कि शोरगुल वाले वातावरण में भी। इसके अतिरिक्त, ये मॉडल "हैलुसिनेशन" की समस्या से कम प्रभावित हैं, जहां Whisper कभी-कभी शब्दों या पूरे अंशों का आविष्कार करता था, जिससे ट्रांसक्रिप्ट में नस्लीय टिप्पणियां या काल्पनिक चिकित्सा उपचार जैसे अशुद्धियां जुड़ जाती थीं।

"इस मामले में ये मॉडल Whisper की तुलना में महत्वपूर्ण सुधार दिखाते हैं," हैरिस ने उल्लेख किया। "मॉडल की सटीकता सुनिश्चित करना एक भरोसेमंद वॉयस अनुभव के लिए महत्वपूर्ण है, और सटीकता से हमारा मतलब है कि मॉडल बोले गए शब्दों को सही ढंग से कैप्चर करते हैं बिना अनकहे सामग्री को जोड़े।"

हालांकि, प्रदर्शन विभिन्न भाषाओं में भिन्न हो सकता है। OpenAI के आंतरिक बेंचमार्क इंगित करते हैं कि gpt-4o-transcribe, जो दोनों में अधिक सटीक है, तमिल, तेलुगु, मलयालम और कन्नड़ जैसी इंडिक और द्रविड़ भाषाओं के लिए "वर्ड एरर रेट" लगभग 30% है। इसका मतलब है कि इन भाषाओं में प्रत्येक दस में से लगभग तीन शब्द मानव ट्रांसक्रिप्शन से भिन्न हो सकते हैं।

अपनी सामान्य प्रथा से हटकर, OpenAI इन नए ट्रांसक्रिप्शन मॉडल को मुफ्त में उपलब्ध नहीं कराएगा। ऐतिहासिक रूप से, उन्होंने नए Whisper संस्करणों को व्यावसायिक उपयोग के लिए MIT लाइसेंस के तहत जारी किया था। हैरिस ने बताया कि gpt-4o-transcribe और gpt-4o-mini-transcribe Whisper की तुलना में काफी बड़े हैं, जिससे वे खुले रिलीज के लिए उपयुक्त नहीं हैं।

"ये मॉडल Whisper की तरह एक सामान्य लैपटॉप पर चलाने के लिए बहुत बड़े हैं," हैरिस ने कहा। "जब हम मॉडल को खुला रिलीज करते हैं, तो हम इसे सोच-समझकर करना चाहते हैं, यह सुनिश्चित करते हुए कि वे विशिष्ट आवश्यकताओं के लिए अनुकूलित हों। हम अंतिम उपयोगकर्ता उपकरणों को ओपन-सोर्स मॉडल के लिए एक प्रमुख क्षेत्र के रूप में देखते हैं।"

20 मार्च, 2025, सुबह 11:54 बजे PT को अपडेट किया गया ताकि वर्ड एरर रेट के आसपास की भाषा को स्पष्ट किया जाए और बेंचमार्क परिणाम चार्ट को अधिक हाल के संस्करण के साथ अपडेट किया जाए।

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

Google ने उद्यम बाजार में OpenAI के साथ प्रतिस्पर्धा करने के लिए उत्पादन-तैयार Gemini 2.5 AI मॉडल्स का अनावरण किया

Google ने सोमवार को अपनी AI रणनीति को और मजबूत किया, उद्यम उपयोग के लिए अपने उन्नत Gemini 2.5 मॉडल्स को लॉन्च किया और कीमत व प्रदर्शन पर प्रतिस्पर्धा करने के लिए एक लागत-कुशल संस्करण पेश किया।Alphabet

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

मेटा AI प्रतिभा के लिए उच्च वेतन प्रदान करता है, 100 मिलियन डॉलर के साइनिंग बोनस से इनकार

मेटा अपने नए सुपरइंटेलिजेंस लैब में AI शोधकर्ताओं को आकर्षित करने के लिए लाखों डॉलर के मुआवजे पैकेज प्रदान कर रहा है। हालांकि, एक भर्ती किए गए शोधकर्ता और लीक हुई आंतरिक बैठक की टिप्पणियों के अनुसार,

23 जुलाई 2025 2:20:48 अपराह्न IST

23 जुलाई 2025 2:20:48 अपराह्न IST

Wow, OpenAI's new transcription and voice models sound like a game-changer! I'm curious how these 'agentic' systems will stack up against real-world tasks. Could they finally nail natural-sounding convos? 🤔

0

0

21 अप्रैल 2025 1:27:07 पूर्वाह्न IST

21 अप्रैल 2025 1:27:07 पूर्वाह्न IST

Os novos modelos de transcrição e geração de voz da OpenAI são um divisor de águas! Estou usando no meu podcast e as melhorias são impressionantes. O único ponto negativo? São um pouco caros, mas se você puder pagar, vale cada centavo! 🎙️💸

0

0

17 अप्रैल 2025 10:20:37 पूर्वाह्न IST

17 अप्रैल 2025 10:20:37 पूर्वाह्न IST

OpenAI's new transcription and voice models are a game changer! I've been using them for my podcast and the improvements are night and day. The only downside? They're a bit pricey, but if you can swing it, they're worth every penny! 🎙️💸

0

0

17 अप्रैल 2025 10:08:26 पूर्वाह्न IST

17 अप्रैल 2025 10:08:26 पूर्वाह्न IST

OpenAI의 새로운 음성 인식 및 음성 생성 모델은 정말 혁신적이에요! 제 팟캐스트에서 사용 중인데, 개선이 눈에 띄어요. 단점은 조금 비싸다는 건데, 감당할 수 있다면 그만한 가치가 있어요! 🎙️💸

0

0

16 अप्रैल 2025 11:24:41 पूर्वाह्न IST

16 अप्रैल 2025 11:24:41 पूर्वाह्न IST

OpenAIの新しい音声認識と音声生成モデルは革命的です!ポッドキャストで使っていますが、改善が劇的です。唯一の欠点は少し高価なことですが、払えるならその価値は十分にあります!🎙️💸

0

0

16 अप्रैल 2025 2:54:36 पूर्वाह्न IST

16 अप्रैल 2025 2:54:36 पूर्वाह्न IST

Os novos modelos de transcrição e geração de voz da OpenAI são incríveis! A qualidade melhorou muito em comparação com as versões anteriores. Só queria que fossem um pouco mais rápidos, mas no geral, estou muito satisfeito! 😊

0

0