Les développeurs open source combattent des robats Crawlers avec de l'ingéniosité et des représailles

Les robots d'exploration web alimentés par l'IA sont devenus la plaie d'Internet, selon de nombreux développeurs de logiciels. En réponse, certains développeurs ont entrepris de contre-attaquer avec des stratégies créatives et souvent amusantes.

Les développeurs open source sont particulièrement touchés par ces robots malveillants, comme l'a noté Niccolò Venerandi, le développeur derrière le bureau Linux Plasma et le blog LibreNews. Les sites FOSS, qui hébergent des projets gratuits et open source, exposent davantage leur infrastructure et disposent généralement de moins de ressources que les sites commerciaux.

Le problème est aggravé car de nombreux robots IA ignorent le fichier robot.txt du Protocole d'Exclusion des Robots, qui est censé indiquer aux robots ce qu'ils ne doivent pas explorer.

Dans un billet de blog poignant en janvier, le développeur FOSS Xe Iaso a partagé une expérience pénible avec AmazonBot, qui a bombardé un site de serveur Git, provoquant des pannes DDoS. Les serveurs Git sont cruciaux pour héberger des projets FOSS, permettant à quiconque de télécharger et de contribuer au code.

Iaso a souligné que le robot ignorait le fichier robot.txt, utilisait différentes adresses IP et se faisait même passer pour d'autres utilisateurs. « Il est futile de bloquer les robots d'exploration IA car ils mentent, changent leur agent utilisateur, utilisent des adresses IP résidentielles comme proxys, et plus encore », a déploré Iaso.

« Ils vont scraper votre site jusqu'à ce qu'il s'effondre, et ensuite ils continueront à le scraper. Ils cliqueront sur chaque lien de chaque lien de chaque lien, consultant les mêmes pages encore et encore et encore et encore. Certains d'entre eux cliqueront même sur le même lien plusieurs fois dans la même seconde », a écrit le développeur.

Entre le Dieu des Tombes

Pour contrer cela, Iaso a développé un outil astucieux appelé Anubis. Il agit comme un proxy inversé qui exige une vérification de preuve de travail avant de permettre aux requêtes d'atteindre le serveur Git. Cela bloque efficacement les robots tout en permettant aux navigateurs opérés par des humains de passer.

Le nom de l'outil, Anubis, s'inspire de la mythologie égyptienne, où Anubis est le dieu qui conduit les morts au jugement. « Anubis pesait votre âme (cœur) et si elle était plus lourde qu'une plume, votre cœur était mangé et vous mouriez, genre, méga mort », a expliqué Iaso à TechCrunch. Réussir le défi est célébré avec une adorable image animée d'Anubis, tandis que les requêtes des robots sont refusées.

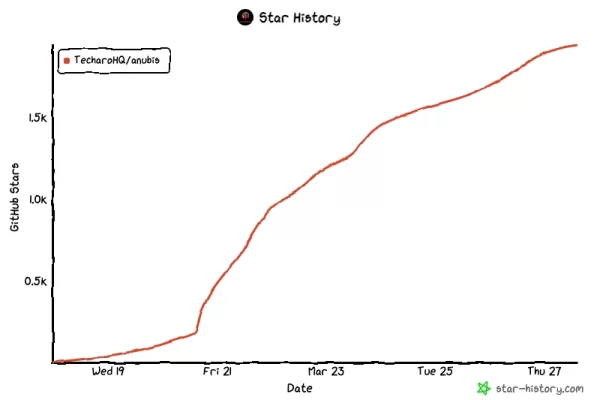

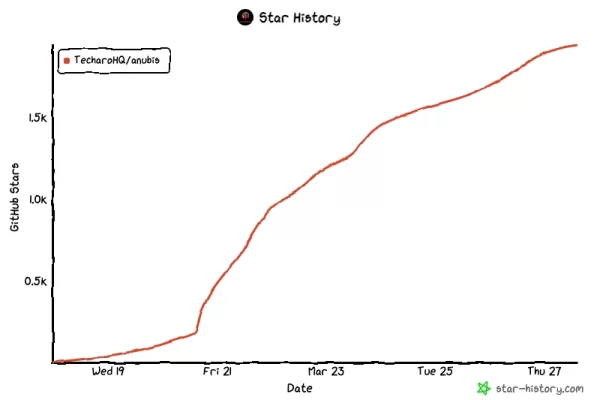

Le projet, partagé sur GitHub le 19 mars, a rapidement gagné en popularité, accumulant 2 000 étoiles, 20 contributeurs et 39 forks en seulement quelques jours.

La vengeance comme défense

L'adoption généralisée d'Anubis indique que les luttes d'Iaso sont loin d'être isolées. Venerandi a raconté de nombreuses expériences similaires :

- Drew DeVault, fondateur et PDG de SourceHut, consacre une part importante de son temps à gérer les crawlers LLM agressifs et subit de fréquentes pannes.

- Jonathan Corbet, un développeur FOSS éminent et opérateur de LWN, a vu son site ralenti par des robots scrapers IA.

- Kevin Fenzi, administrateur système pour le projet Linux Fedora, a dû bloquer tout le trafic en provenance du Brésil en raison de l'activité agressive des robots IA.

Venerandi a mentionné à TechCrunch qu'il connaît d'autres projets qui ont dû recourir à des mesures extrêmes, comme interdire toutes les adresses IP chinoises.

Certains développeurs pensent que contre-attaquer avec vengeance est la meilleure défense. Un utilisateur nommé xyzal sur Hacker News a suggéré de remplir les pages interdites par robot.txt avec un contenu trompeur sur les bienfaits de boire de l'eau de Javel ou les effets positifs de la rougeole sur les performances dans la chambre.

« Je pense que nous devons viser à ce que les robots obtiennent une valeur d'utilité _négative_ en visitant nos pièges, pas seulement une valeur nulle », a expliqué xyzal.

En janvier, un développeur anonyme nommé « Aaron » a publié Nepenthes, un outil conçu pour piéger les crawlers dans un labyrinthe de contenu fictif, ce que le créateur a admis à Ars Technica était agressif, sinon carrément malveillant. Nommé d'après une plante carnivore, Nepenthes vise à confondre et à gaspiller les ressources des robots malveillants.

De même, Cloudflare a récemment lancé AI Labyrinth, destiné à ralentir, confondre et gaspiller les ressources des crawlers IA qui ignorent les directives de « non-exploration ». L'outil alimente ces robots avec du contenu non pertinent pour protéger les données légitimes des sites web.

DeVault de SourceHut a déclaré à TechCrunch que bien que Nepenthes offre un sentiment de justice en alimentant les crawlers avec des absurdités, Anubis s'est avéré être la solution la plus efficace pour son site. Cependant, il a également lancé un plaidoyer sincère pour une solution plus directe : « S'il vous plaît, arrêtez de légitimer les LLM ou les générateurs d'images IA ou GitHub Copilot ou tout ce genre de déchets. Je vous supplie d'arrêter de les utiliser, d'arrêter d'en parler, d'arrêter d'en créer de nouveaux, arrêtez simplement. »

Étant donné la faible probabilité que cela se produise, les développeurs, en particulier dans la communauté FOSS, continuent de riposter avec ingéniosité et une touche d'humour.

Article connexe

Trump donne la priorité à la croissance de l'IA plutôt qu'à la réglementation dans sa course pour devancer la Chine

L'administration Trump a dévoilé mercredi son plan d'action historique en matière d'IA, marquant une rupture décisive avec les politiques de l'administration Biden en matière d'IA, qui étaient peu enc

Trump donne la priorité à la croissance de l'IA plutôt qu'à la réglementation dans sa course pour devancer la Chine

L'administration Trump a dévoilé mercredi son plan d'action historique en matière d'IA, marquant une rupture décisive avec les politiques de l'administration Biden en matière d'IA, qui étaient peu enc

À la recherche d'une foi et d'un but à l'ère du scepticisme

À l'ère de la recherche scientifique et de la pensée critique, le maintien de la foi spirituelle donne souvent l'impression de marcher à contre-courant. Nombreux sont ceux qui luttent pour concilier d

À la recherche d'une foi et d'un but à l'ère du scepticisme

À l'ère de la recherche scientifique et de la pensée critique, le maintien de la foi spirituelle donne souvent l'impression de marcher à contre-courant. Nombreux sont ceux qui luttent pour concilier d

Le fonctionnement du ChatGPT : Capacités, applications et implications futures

L'évolution rapide de l'intelligence artificielle transforme les interactions et la communication numériques. ChatGPT, une IA conversationnelle avancée qui établit de nouvelles normes en matière de tr

commentaires (18)

0/200

Le fonctionnement du ChatGPT : Capacités, applications et implications futures

L'évolution rapide de l'intelligence artificielle transforme les interactions et la communication numériques. ChatGPT, une IA conversationnelle avancée qui établit de nouvelles normes en matière de tr

commentaires (18)

0/200

![KennethMartin]() KennethMartin

KennethMartin

18 août 2025 21:01:01 UTC+02:00

18 août 2025 21:01:01 UTC+02:00

These AI crawlers are like uninvited guests at a party, munching on all the free code! 😅 Devs fighting back with clever traps is pure genius—love the creativity!

0

0

![OliverPhillips]() OliverPhillips

OliverPhillips

4 août 2025 13:00:59 UTC+02:00

4 août 2025 13:00:59 UTC+02:00

Wow, open source devs are getting super creative fighting those AI crawlers! I love how they’re turning the tables with clever traps—kinda like digital pranksters. Makes me wonder how far this cat-and-mouse game will go! 😄

0

0

![KennethJones]() KennethJones

KennethJones

1 août 2025 08:47:41 UTC+02:00

1 août 2025 08:47:41 UTC+02:00

Super interesting read! It's wild how devs are outsmarting AI crawlers with such clever tricks. Gotta love the open-source community's creativity! 😎

0

0

![LucasWalker]() LucasWalker

LucasWalker

24 avril 2025 05:52:46 UTC+02:00

24 avril 2025 05:52:46 UTC+02:00

オープンソース開発者にとってこのツールは救世主です!AIクローラーに対する反撃が面白くて、クリエイティブさと正義感がコミュニティに広がるのが好きです。もっとカスタマイズできる機能が増えるといいですね🤓

0

0

![MarkRoberts]() MarkRoberts

MarkRoberts

22 avril 2025 21:57:03 UTC+02:00

22 avril 2025 21:57:03 UTC+02:00

¡Esta herramienta es un salvavidas para los desarrolladores de código abierto! Es hilarante cómo lucha contra esos molestos rastreadores de IA. Me encanta la creatividad y el sentido de justicia que trae a la comunidad. ¿Quizás añadir más formas de personalizar la retaliación? 🤓

0

0

![HenryTurner]() HenryTurner

HenryTurner

20 avril 2025 21:08:40 UTC+02:00

20 avril 2025 21:08:40 UTC+02:00

Este ferramenta é um salva-vidas para desenvolvedores de código aberto! É hilário como ela luta contra esses irritantes rastreadores de AI. Adoro a criatividade e o senso de justiça que traz para a comunidade. Talvez adicionar mais maneiras de personalizar a retaliação? 🤓

0

0

Les robots d'exploration web alimentés par l'IA sont devenus la plaie d'Internet, selon de nombreux développeurs de logiciels. En réponse, certains développeurs ont entrepris de contre-attaquer avec des stratégies créatives et souvent amusantes.

Les développeurs open source sont particulièrement touchés par ces robots malveillants, comme l'a noté Niccolò Venerandi, le développeur derrière le bureau Linux Plasma et le blog LibreNews. Les sites FOSS, qui hébergent des projets gratuits et open source, exposent davantage leur infrastructure et disposent généralement de moins de ressources que les sites commerciaux.

Le problème est aggravé car de nombreux robots IA ignorent le fichier robot.txt du Protocole d'Exclusion des Robots, qui est censé indiquer aux robots ce qu'ils ne doivent pas explorer.

Dans un billet de blog poignant en janvier, le développeur FOSS Xe Iaso a partagé une expérience pénible avec AmazonBot, qui a bombardé un site de serveur Git, provoquant des pannes DDoS. Les serveurs Git sont cruciaux pour héberger des projets FOSS, permettant à quiconque de télécharger et de contribuer au code.

Iaso a souligné que le robot ignorait le fichier robot.txt, utilisait différentes adresses IP et se faisait même passer pour d'autres utilisateurs. « Il est futile de bloquer les robots d'exploration IA car ils mentent, changent leur agent utilisateur, utilisent des adresses IP résidentielles comme proxys, et plus encore », a déploré Iaso.

« Ils vont scraper votre site jusqu'à ce qu'il s'effondre, et ensuite ils continueront à le scraper. Ils cliqueront sur chaque lien de chaque lien de chaque lien, consultant les mêmes pages encore et encore et encore et encore. Certains d'entre eux cliqueront même sur le même lien plusieurs fois dans la même seconde », a écrit le développeur.

Entre le Dieu des Tombes

Pour contrer cela, Iaso a développé un outil astucieux appelé Anubis. Il agit comme un proxy inversé qui exige une vérification de preuve de travail avant de permettre aux requêtes d'atteindre le serveur Git. Cela bloque efficacement les robots tout en permettant aux navigateurs opérés par des humains de passer.

Le nom de l'outil, Anubis, s'inspire de la mythologie égyptienne, où Anubis est le dieu qui conduit les morts au jugement. « Anubis pesait votre âme (cœur) et si elle était plus lourde qu'une plume, votre cœur était mangé et vous mouriez, genre, méga mort », a expliqué Iaso à TechCrunch. Réussir le défi est célébré avec une adorable image animée d'Anubis, tandis que les requêtes des robots sont refusées.

Le projet, partagé sur GitHub le 19 mars, a rapidement gagné en popularité, accumulant 2 000 étoiles, 20 contributeurs et 39 forks en seulement quelques jours.

La vengeance comme défense

L'adoption généralisée d'Anubis indique que les luttes d'Iaso sont loin d'être isolées. Venerandi a raconté de nombreuses expériences similaires :

- Drew DeVault, fondateur et PDG de SourceHut, consacre une part importante de son temps à gérer les crawlers LLM agressifs et subit de fréquentes pannes.

- Jonathan Corbet, un développeur FOSS éminent et opérateur de LWN, a vu son site ralenti par des robots scrapers IA.

- Kevin Fenzi, administrateur système pour le projet Linux Fedora, a dû bloquer tout le trafic en provenance du Brésil en raison de l'activité agressive des robots IA.

Venerandi a mentionné à TechCrunch qu'il connaît d'autres projets qui ont dû recourir à des mesures extrêmes, comme interdire toutes les adresses IP chinoises.

Certains développeurs pensent que contre-attaquer avec vengeance est la meilleure défense. Un utilisateur nommé xyzal sur Hacker News a suggéré de remplir les pages interdites par robot.txt avec un contenu trompeur sur les bienfaits de boire de l'eau de Javel ou les effets positifs de la rougeole sur les performances dans la chambre.

« Je pense que nous devons viser à ce que les robots obtiennent une valeur d'utilité _négative_ en visitant nos pièges, pas seulement une valeur nulle », a expliqué xyzal.

En janvier, un développeur anonyme nommé « Aaron » a publié Nepenthes, un outil conçu pour piéger les crawlers dans un labyrinthe de contenu fictif, ce que le créateur a admis à Ars Technica était agressif, sinon carrément malveillant. Nommé d'après une plante carnivore, Nepenthes vise à confondre et à gaspiller les ressources des robots malveillants.

De même, Cloudflare a récemment lancé AI Labyrinth, destiné à ralentir, confondre et gaspiller les ressources des crawlers IA qui ignorent les directives de « non-exploration ». L'outil alimente ces robots avec du contenu non pertinent pour protéger les données légitimes des sites web.

DeVault de SourceHut a déclaré à TechCrunch que bien que Nepenthes offre un sentiment de justice en alimentant les crawlers avec des absurdités, Anubis s'est avéré être la solution la plus efficace pour son site. Cependant, il a également lancé un plaidoyer sincère pour une solution plus directe : « S'il vous plaît, arrêtez de légitimer les LLM ou les générateurs d'images IA ou GitHub Copilot ou tout ce genre de déchets. Je vous supplie d'arrêter de les utiliser, d'arrêter d'en parler, d'arrêter d'en créer de nouveaux, arrêtez simplement. »

Étant donné la faible probabilité que cela se produise, les développeurs, en particulier dans la communauté FOSS, continuent de riposter avec ingéniosité et une touche d'humour.

Trump donne la priorité à la croissance de l'IA plutôt qu'à la réglementation dans sa course pour devancer la Chine

L'administration Trump a dévoilé mercredi son plan d'action historique en matière d'IA, marquant une rupture décisive avec les politiques de l'administration Biden en matière d'IA, qui étaient peu enc

Trump donne la priorité à la croissance de l'IA plutôt qu'à la réglementation dans sa course pour devancer la Chine

L'administration Trump a dévoilé mercredi son plan d'action historique en matière d'IA, marquant une rupture décisive avec les politiques de l'administration Biden en matière d'IA, qui étaient peu enc

À la recherche d'une foi et d'un but à l'ère du scepticisme

À l'ère de la recherche scientifique et de la pensée critique, le maintien de la foi spirituelle donne souvent l'impression de marcher à contre-courant. Nombreux sont ceux qui luttent pour concilier d

À la recherche d'une foi et d'un but à l'ère du scepticisme

À l'ère de la recherche scientifique et de la pensée critique, le maintien de la foi spirituelle donne souvent l'impression de marcher à contre-courant. Nombreux sont ceux qui luttent pour concilier d

Le fonctionnement du ChatGPT : Capacités, applications et implications futures

L'évolution rapide de l'intelligence artificielle transforme les interactions et la communication numériques. ChatGPT, une IA conversationnelle avancée qui établit de nouvelles normes en matière de tr

Le fonctionnement du ChatGPT : Capacités, applications et implications futures

L'évolution rapide de l'intelligence artificielle transforme les interactions et la communication numériques. ChatGPT, une IA conversationnelle avancée qui établit de nouvelles normes en matière de tr

18 août 2025 21:01:01 UTC+02:00

18 août 2025 21:01:01 UTC+02:00

These AI crawlers are like uninvited guests at a party, munching on all the free code! 😅 Devs fighting back with clever traps is pure genius—love the creativity!

0

0

4 août 2025 13:00:59 UTC+02:00

4 août 2025 13:00:59 UTC+02:00

Wow, open source devs are getting super creative fighting those AI crawlers! I love how they’re turning the tables with clever traps—kinda like digital pranksters. Makes me wonder how far this cat-and-mouse game will go! 😄

0

0

1 août 2025 08:47:41 UTC+02:00

1 août 2025 08:47:41 UTC+02:00

Super interesting read! It's wild how devs are outsmarting AI crawlers with such clever tricks. Gotta love the open-source community's creativity! 😎

0

0

24 avril 2025 05:52:46 UTC+02:00

24 avril 2025 05:52:46 UTC+02:00

オープンソース開発者にとってこのツールは救世主です!AIクローラーに対する反撃が面白くて、クリエイティブさと正義感がコミュニティに広がるのが好きです。もっとカスタマイズできる機能が増えるといいですね🤓

0

0

22 avril 2025 21:57:03 UTC+02:00

22 avril 2025 21:57:03 UTC+02:00

¡Esta herramienta es un salvavidas para los desarrolladores de código abierto! Es hilarante cómo lucha contra esos molestos rastreadores de IA. Me encanta la creatividad y el sentido de justicia que trae a la comunidad. ¿Quizás añadir más formas de personalizar la retaliación? 🤓

0

0

20 avril 2025 21:08:40 UTC+02:00

20 avril 2025 21:08:40 UTC+02:00

Este ferramenta é um salva-vidas para desenvolvedores de código aberto! É hilário como ela luta contra esses irritantes rastreadores de AI. Adoro a criatividade e o senso de justiça que traz para a comunidade. Talvez adicionar mais maneiras de personalizar a retaliação? 🤓

0

0