Open Source -Entwickler bekämpfen KI -Crawler mit Einfallsreichtum und Vergeltung

KI-Webcrawling-Bots sind laut vielen Softwareentwicklern zur Plage des Internets geworden. Als Reaktion darauf haben einige Entwickler begonnen, mit kreativen und oft amüsanten Strategien zurückzuschlagen.

Open-Source-Entwickler sind besonders stark von diesen schurkischen Bots betroffen, wie Niccolò Venerandi, der Entwickler hinter dem Linux-Desktop Plasma und dem Blog LibreNews, feststellte. FOSS-Websites, die kostenlose und Open-Source-Projekte hosten, legen mehr von ihrer Infrastruktur offen und verfügen im Allgemeinen über weniger Ressourcen als kommerzielle Websites.

Das Problem wird dadurch verschärft, dass viele KI-Bots das Robots Exclusion Protocol’s robot.txt-Datei ignorieren, die Bots anweisen soll, was sie nicht crawlen dürfen.

In einem eindringlichen Blogbeitrag im Januar teilte die FOSS-Entwicklerin Xe Iaso eine belastende Erfahrung mit AmazonBot, der eine Git-Server-Website bombardierte und DDoS-Ausfälle verursachte. Git-Server sind entscheidend für das Hosting von FOSS-Projekten, da sie es jedem ermöglichen, den Code herunterzuladen und dazu beizutragen.

Iaso wies darauf hin, dass der Bot die robot.txt-Datei ignorierte, verschiedene IP-Adressen verwendete und sich sogar als andere Nutzer ausgab. „Es ist sinnlos, KI-Crawler-Bots zu blockieren, weil sie lügen, ihren User-Agent ändern, private IP-Adressen als Proxys verwenden und mehr“, klagte Iaso.

„Sie werden deine Website scrapen, bis sie zusammenbricht, und dann scrapen sie weiter. Sie klicken auf jeden Link auf jedem Link auf jedem Link, sehen sich dieselben Seiten immer und immer und immer wieder an. Einige von ihnen klicken sogar mehrfach in derselben Sekunde auf denselben Link“, schrieb die Entwicklerin.

Der Gott der Gräber

Um dem entgegenzuwirken, entwickelte Iaso ein cleveres Tool namens Anubis. Es fungiert als Reverse-Proxy, der eine Proof-of-Work-Prüfung verlangt, bevor Anfragen den Git-Server erreichen. Dies blockiert Bots effektiv, während menschlich betriebene Browser durchgelassen werden.

Der Name des Tools, Anubis, stammt aus der ägyptischen Mythologie, wo Anubis der Gott ist, der die Toten zum Gericht führt. „Anubis wog deine Seele (Herz), und wenn sie schwerer als eine Feder war, wurde dein Herz gefressen, und du warst, na ja, mega tot“, erklärte Iaso gegenüber TechCrunch. Das Bestehen der Herausforderung wird mit einem süßen Anime-Bild von Anubis gefeiert, während Bot-Anfragen abgelehnt werden.

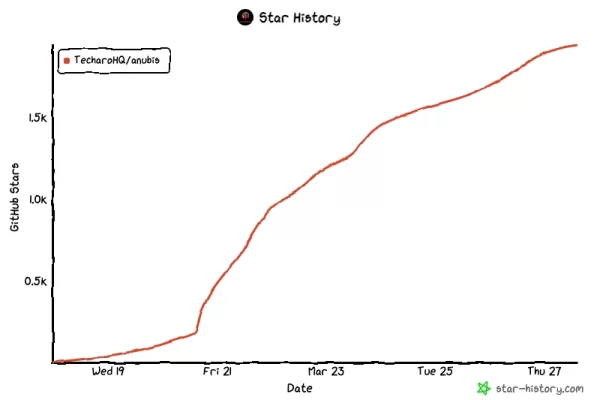

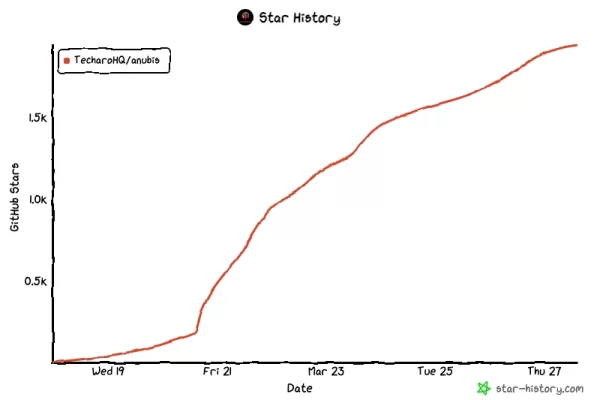

Das Projekt, das am 19. März auf GitHub geteilt wurde, gewann schnell an Popularität, sammelte in nur wenigen Tagen 2.000 Sterne, 20 Mitwirkende und 39 Forks.

Rache als Verteidigung

Die weitreichende Verbreitung von Anubis zeigt, dass Iasos Kämpfe keineswegs ein Einzelfall sind. Venerandi berichtete von zahlreichen ähnlichen Erfahrungen:

- Drew DeVault, Gründer und CEO von SourceHut, verbringt einen erheblichen Teil seiner Zeit damit, aggressive LLM-Crawler zu bekämpfen und leidet unter häufigen Ausfällen.

- Jonathan Corbet, ein prominenter FOSS-Entwickler und Betreiber von LWN, hat erlebt, wie seine Website durch KI-Scraper-Bots verlangsamt wurde.

- Kevin Fenzi, Systemadministrator des Linux Fedora-Projekts, musste den gesamten Datenverkehr aus Brasilien blockieren aufgrund aggressiver KI-Bot-Aktivitäten.

Venerandi erwähnte gegenüber TechCrunch, dass er von anderen Projekten weiß, die zu extremen Maßnahmen greifen mussten, wie dem Verbot aller chinesischen IP-Adressen.

Einige Entwickler glauben, dass Rache die beste Verteidigung ist. Ein Nutzer namens xyzal auf Hacker News schlug vor, robot.txt-verbotene Seiten mit irreführenden Inhalten zu füllen, etwa über die Vorteile des Trinkens von Bleichmittel oder die positiven Auswirkungen von Masern auf die Schlafzimmerleistung.

„Ich denke, wir müssen darauf abzielen, dass Bots einen _negativen_ Nutzen aus dem Besuch unserer Fallen ziehen, nicht nur null Nutzen“, erklärte xyzal.

Im Januar veröffentlichte ein anonymer Entwickler namens „Aaron“ Nepenthes, ein Tool, das entwickelt wurde, um Crawler in einem Labyrinth aus gefälschten Inhalten zu fangen, was der Schöpfer gegenüber Ars Technica als aggressiv, wenn nicht gar bösartig, bezeichnete. Benannt nach einer fleischfressenden Pflanze, zielt Nepenthes darauf ab, schlecht benehmende Bots zu verwirren und ihre Ressourcen zu verschwenden.

Ähnlich hat Cloudflare kürzlich AI Labyrinth eingeführt, das darauf abzielt, KI-Crawler, die „no crawl“-Anweisungen ignorieren, zu verlangsamen, zu verwirren und ihre Ressourcen zu verschwenden. Das Tool füttert diese Bots mit irrelevanten Inhalten, um legitime Website-Daten zu schützen.

DeVault von SourceHut erzählte TechCrunch, dass Nepenthes zwar ein Gefühl von Gerechtigkeit vermittelt, indem es Unsinn an die Crawler füttert, Anubis sich jedoch als effektivere Lösung für seine Website erwiesen hat. Er richtete jedoch auch eine herzliche Bitte an die Gemeinschaft: „Bitte hört auf, LLMs oder KI-Bildgeneratoren oder GitHub Copilot oder diesen ganzen Müll zu legitimieren. Ich flehe euch an, hört auf, sie zu benutzen, über sie zu reden, neue zu entwickeln, hört einfach auf.“

Angesichts der Unwahrscheinlichkeit, dass dies geschieht, kämpfen Entwickler, insbesondere in der FOSS-Community, weiterhin mit Einfallsreichtum und einem Hauch von Humor zurück.

Verwandter Artikel

"Desi Vocal: KI-gesteuerter Stimmgenerator erstellt kostenlos fesselnde Audioinhalte"

Im heutigen inhaltsgesteuerten digitalen Ökosystem kann eine überzeugende Vertonung den entscheidenden Unterschied ausmachen. Desi Vocal revolutioniert die Erstellung von Voice-over mit seiner kostenl

"Desi Vocal: KI-gesteuerter Stimmgenerator erstellt kostenlos fesselnde Audioinhalte"

Im heutigen inhaltsgesteuerten digitalen Ökosystem kann eine überzeugende Vertonung den entscheidenden Unterschied ausmachen. Desi Vocal revolutioniert die Erstellung von Voice-over mit seiner kostenl

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

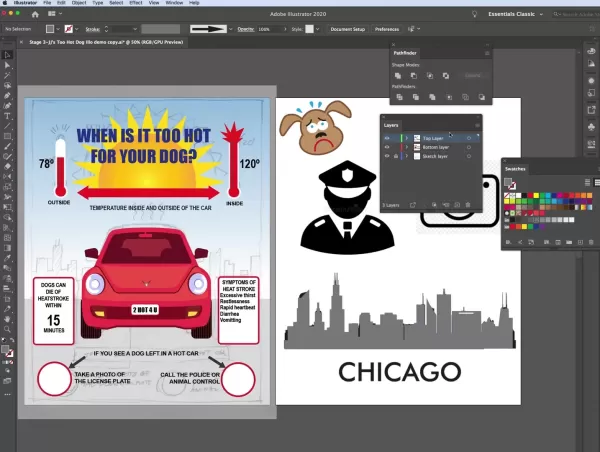

Infografik-Design in Adobe Illustrator meistern: Schritt-für-Schritt-Anleitung

Dieses maßgebliche Handbuch zeigt professionelle Techniken für die Erstellung überzeugender Infografiken in Adobe Illustrator. Als visuelle Erzählwerkzeuge, die komplexe Daten in zugängliche Informati

Kommentare (18)

0/200

Infografik-Design in Adobe Illustrator meistern: Schritt-für-Schritt-Anleitung

Dieses maßgebliche Handbuch zeigt professionelle Techniken für die Erstellung überzeugender Infografiken in Adobe Illustrator. Als visuelle Erzählwerkzeuge, die komplexe Daten in zugängliche Informati

Kommentare (18)

0/200

![KennethMartin]() KennethMartin

KennethMartin

18. August 2025 21:01:01 MESZ

18. August 2025 21:01:01 MESZ

These AI crawlers are like uninvited guests at a party, munching on all the free code! 😅 Devs fighting back with clever traps is pure genius—love the creativity!

0

0

![OliverPhillips]() OliverPhillips

OliverPhillips

4. August 2025 13:00:59 MESZ

4. August 2025 13:00:59 MESZ

Wow, open source devs are getting super creative fighting those AI crawlers! I love how they’re turning the tables with clever traps—kinda like digital pranksters. Makes me wonder how far this cat-and-mouse game will go! 😄

0

0

![KennethJones]() KennethJones

KennethJones

1. August 2025 08:47:41 MESZ

1. August 2025 08:47:41 MESZ

Super interesting read! It's wild how devs are outsmarting AI crawlers with such clever tricks. Gotta love the open-source community's creativity! 😎

0

0

![LucasWalker]() LucasWalker

LucasWalker

24. April 2025 05:52:46 MESZ

24. April 2025 05:52:46 MESZ

オープンソース開発者にとってこのツールは救世主です!AIクローラーに対する反撃が面白くて、クリエイティブさと正義感がコミュニティに広がるのが好きです。もっとカスタマイズできる機能が増えるといいですね🤓

0

0

![MarkRoberts]() MarkRoberts

MarkRoberts

22. April 2025 21:57:03 MESZ

22. April 2025 21:57:03 MESZ

¡Esta herramienta es un salvavidas para los desarrolladores de código abierto! Es hilarante cómo lucha contra esos molestos rastreadores de IA. Me encanta la creatividad y el sentido de justicia que trae a la comunidad. ¿Quizás añadir más formas de personalizar la retaliación? 🤓

0

0

![HenryTurner]() HenryTurner

HenryTurner

20. April 2025 21:08:40 MESZ

20. April 2025 21:08:40 MESZ

Este ferramenta é um salva-vidas para desenvolvedores de código aberto! É hilário como ela luta contra esses irritantes rastreadores de AI. Adoro a criatividade e o senso de justiça que traz para a comunidade. Talvez adicionar mais maneiras de personalizar a retaliação? 🤓

0

0

KI-Webcrawling-Bots sind laut vielen Softwareentwicklern zur Plage des Internets geworden. Als Reaktion darauf haben einige Entwickler begonnen, mit kreativen und oft amüsanten Strategien zurückzuschlagen.

Open-Source-Entwickler sind besonders stark von diesen schurkischen Bots betroffen, wie Niccolò Venerandi, der Entwickler hinter dem Linux-Desktop Plasma und dem Blog LibreNews, feststellte. FOSS-Websites, die kostenlose und Open-Source-Projekte hosten, legen mehr von ihrer Infrastruktur offen und verfügen im Allgemeinen über weniger Ressourcen als kommerzielle Websites.

Das Problem wird dadurch verschärft, dass viele KI-Bots das Robots Exclusion Protocol’s robot.txt-Datei ignorieren, die Bots anweisen soll, was sie nicht crawlen dürfen.

In einem eindringlichen Blogbeitrag im Januar teilte die FOSS-Entwicklerin Xe Iaso eine belastende Erfahrung mit AmazonBot, der eine Git-Server-Website bombardierte und DDoS-Ausfälle verursachte. Git-Server sind entscheidend für das Hosting von FOSS-Projekten, da sie es jedem ermöglichen, den Code herunterzuladen und dazu beizutragen.

Iaso wies darauf hin, dass der Bot die robot.txt-Datei ignorierte, verschiedene IP-Adressen verwendete und sich sogar als andere Nutzer ausgab. „Es ist sinnlos, KI-Crawler-Bots zu blockieren, weil sie lügen, ihren User-Agent ändern, private IP-Adressen als Proxys verwenden und mehr“, klagte Iaso.

„Sie werden deine Website scrapen, bis sie zusammenbricht, und dann scrapen sie weiter. Sie klicken auf jeden Link auf jedem Link auf jedem Link, sehen sich dieselben Seiten immer und immer und immer wieder an. Einige von ihnen klicken sogar mehrfach in derselben Sekunde auf denselben Link“, schrieb die Entwicklerin.

Der Gott der Gräber

Um dem entgegenzuwirken, entwickelte Iaso ein cleveres Tool namens Anubis. Es fungiert als Reverse-Proxy, der eine Proof-of-Work-Prüfung verlangt, bevor Anfragen den Git-Server erreichen. Dies blockiert Bots effektiv, während menschlich betriebene Browser durchgelassen werden.

Der Name des Tools, Anubis, stammt aus der ägyptischen Mythologie, wo Anubis der Gott ist, der die Toten zum Gericht führt. „Anubis wog deine Seele (Herz), und wenn sie schwerer als eine Feder war, wurde dein Herz gefressen, und du warst, na ja, mega tot“, erklärte Iaso gegenüber TechCrunch. Das Bestehen der Herausforderung wird mit einem süßen Anime-Bild von Anubis gefeiert, während Bot-Anfragen abgelehnt werden.

Das Projekt, das am 19. März auf GitHub geteilt wurde, gewann schnell an Popularität, sammelte in nur wenigen Tagen 2.000 Sterne, 20 Mitwirkende und 39 Forks.

Rache als Verteidigung

Die weitreichende Verbreitung von Anubis zeigt, dass Iasos Kämpfe keineswegs ein Einzelfall sind. Venerandi berichtete von zahlreichen ähnlichen Erfahrungen:

- Drew DeVault, Gründer und CEO von SourceHut, verbringt einen erheblichen Teil seiner Zeit damit, aggressive LLM-Crawler zu bekämpfen und leidet unter häufigen Ausfällen.

- Jonathan Corbet, ein prominenter FOSS-Entwickler und Betreiber von LWN, hat erlebt, wie seine Website durch KI-Scraper-Bots verlangsamt wurde.

- Kevin Fenzi, Systemadministrator des Linux Fedora-Projekts, musste den gesamten Datenverkehr aus Brasilien blockieren aufgrund aggressiver KI-Bot-Aktivitäten.

Venerandi erwähnte gegenüber TechCrunch, dass er von anderen Projekten weiß, die zu extremen Maßnahmen greifen mussten, wie dem Verbot aller chinesischen IP-Adressen.

Einige Entwickler glauben, dass Rache die beste Verteidigung ist. Ein Nutzer namens xyzal auf Hacker News schlug vor, robot.txt-verbotene Seiten mit irreführenden Inhalten zu füllen, etwa über die Vorteile des Trinkens von Bleichmittel oder die positiven Auswirkungen von Masern auf die Schlafzimmerleistung.

„Ich denke, wir müssen darauf abzielen, dass Bots einen _negativen_ Nutzen aus dem Besuch unserer Fallen ziehen, nicht nur null Nutzen“, erklärte xyzal.

Im Januar veröffentlichte ein anonymer Entwickler namens „Aaron“ Nepenthes, ein Tool, das entwickelt wurde, um Crawler in einem Labyrinth aus gefälschten Inhalten zu fangen, was der Schöpfer gegenüber Ars Technica als aggressiv, wenn nicht gar bösartig, bezeichnete. Benannt nach einer fleischfressenden Pflanze, zielt Nepenthes darauf ab, schlecht benehmende Bots zu verwirren und ihre Ressourcen zu verschwenden.

Ähnlich hat Cloudflare kürzlich AI Labyrinth eingeführt, das darauf abzielt, KI-Crawler, die „no crawl“-Anweisungen ignorieren, zu verlangsamen, zu verwirren und ihre Ressourcen zu verschwenden. Das Tool füttert diese Bots mit irrelevanten Inhalten, um legitime Website-Daten zu schützen.

DeVault von SourceHut erzählte TechCrunch, dass Nepenthes zwar ein Gefühl von Gerechtigkeit vermittelt, indem es Unsinn an die Crawler füttert, Anubis sich jedoch als effektivere Lösung für seine Website erwiesen hat. Er richtete jedoch auch eine herzliche Bitte an die Gemeinschaft: „Bitte hört auf, LLMs oder KI-Bildgeneratoren oder GitHub Copilot oder diesen ganzen Müll zu legitimieren. Ich flehe euch an, hört auf, sie zu benutzen, über sie zu reden, neue zu entwickeln, hört einfach auf.“

Angesichts der Unwahrscheinlichkeit, dass dies geschieht, kämpfen Entwickler, insbesondere in der FOSS-Community, weiterhin mit Einfallsreichtum und einem Hauch von Humor zurück.

"Desi Vocal: KI-gesteuerter Stimmgenerator erstellt kostenlos fesselnde Audioinhalte"

Im heutigen inhaltsgesteuerten digitalen Ökosystem kann eine überzeugende Vertonung den entscheidenden Unterschied ausmachen. Desi Vocal revolutioniert die Erstellung von Voice-over mit seiner kostenl

"Desi Vocal: KI-gesteuerter Stimmgenerator erstellt kostenlos fesselnde Audioinhalte"

Im heutigen inhaltsgesteuerten digitalen Ökosystem kann eine überzeugende Vertonung den entscheidenden Unterschied ausmachen. Desi Vocal revolutioniert die Erstellung von Voice-over mit seiner kostenl

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Infografik-Design in Adobe Illustrator meistern: Schritt-für-Schritt-Anleitung

Dieses maßgebliche Handbuch zeigt professionelle Techniken für die Erstellung überzeugender Infografiken in Adobe Illustrator. Als visuelle Erzählwerkzeuge, die komplexe Daten in zugängliche Informati

Infografik-Design in Adobe Illustrator meistern: Schritt-für-Schritt-Anleitung

Dieses maßgebliche Handbuch zeigt professionelle Techniken für die Erstellung überzeugender Infografiken in Adobe Illustrator. Als visuelle Erzählwerkzeuge, die komplexe Daten in zugängliche Informati

18. August 2025 21:01:01 MESZ

18. August 2025 21:01:01 MESZ

These AI crawlers are like uninvited guests at a party, munching on all the free code! 😅 Devs fighting back with clever traps is pure genius—love the creativity!

0

0

4. August 2025 13:00:59 MESZ

4. August 2025 13:00:59 MESZ

Wow, open source devs are getting super creative fighting those AI crawlers! I love how they’re turning the tables with clever traps—kinda like digital pranksters. Makes me wonder how far this cat-and-mouse game will go! 😄

0

0

1. August 2025 08:47:41 MESZ

1. August 2025 08:47:41 MESZ

Super interesting read! It's wild how devs are outsmarting AI crawlers with such clever tricks. Gotta love the open-source community's creativity! 😎

0

0

24. April 2025 05:52:46 MESZ

24. April 2025 05:52:46 MESZ

オープンソース開発者にとってこのツールは救世主です!AIクローラーに対する反撃が面白くて、クリエイティブさと正義感がコミュニティに広がるのが好きです。もっとカスタマイズできる機能が増えるといいですね🤓

0

0

22. April 2025 21:57:03 MESZ

22. April 2025 21:57:03 MESZ

¡Esta herramienta es un salvavidas para los desarrolladores de código abierto! Es hilarante cómo lucha contra esos molestos rastreadores de IA. Me encanta la creatividad y el sentido de justicia que trae a la comunidad. ¿Quizás añadir más formas de personalizar la retaliación? 🤓

0

0

20. April 2025 21:08:40 MESZ

20. April 2025 21:08:40 MESZ

Este ferramenta é um salva-vidas para desenvolvedores de código aberto! É hilário como ela luta contra esses irritantes rastreadores de AI. Adoro a criatividade e o senso de justiça que traz para a comunidade. Talvez adicionar mais maneiras de personalizar a retaliação? 🤓

0

0