L'évaluation de l'IA nécessite un examen des performances dans le monde réel, au-delà des critères de référence

Si vous avez suivi les progrès de l'IA, vous avez sans doute vu des titres annonçant des performances record en matière de tests de référence. Qu'il s'agisse de tâches de vision par ordinateur ou de diagnostics médicaux, ces tests standardisés servent depuis longtemps de mesure définitive des capacités de l'IA. Pourtant, ces scores impressionnants masquent souvent des limites importantes : un modèle qui réussit des tests de référence contrôlés peut éprouver des difficultés considérables lorsqu'il est déployé dans des cas d'utilisation réels. Dans cette analyse, nous examinerons les raisons pour lesquelles les tests conventionnels ne permettent pas d'évaluer l'efficacité réelle de l'IA et nous explorerons les cadres d'évaluation qui tiennent mieux compte de la complexité du monde réel, de l'éthique et de l'utilité pratique.

L'attrait des critères d'évaluation

Depuis des décennies, les critères d'évaluation de l'IA fournissent des terrains d'essai normalisés essentiels. Des ensembles de données comme ImageNet pour la reconnaissance visuelle ou BLEU pour la qualité des traductions offrent des environnements contrôlés pour mesurer des capacités spécifiques. Ces concours structurés ont accéléré les progrès en permettant des comparaisons directes des performances et en encourageant une concurrence scientifique saine. Le défi ImageNet a catalysé la révolution de l'apprentissage profond en démontrant des gains de précision sans précédent dans le domaine de la vision par ordinateur.

Cependant, ces évaluations statiques présentent souvent une réalité trop simplifiée. Les modèles optimisés pour les performances de référence exploitent fréquemment les particularités des ensembles de données au lieu de développer une véritable compréhension. Un exemple éloquent est apparu lorsqu'un modèle de classification des animaux formé pour distinguer les loups des huskies a appris à s'appuyer sur les arrière-plans enneigés (fréquents dans les images d'entraînement des loups) plutôt que sur les caractéristiques anatomiques réelles. Ce phénomène illustre la loi de Goodhart en action : lorsque les repères deviennent des cibles, ils cessent souvent d'être des mesures efficaces.

Attentes humaines et résultats des mesures

Le décalage fondamental entre les mesures de référence et les besoins humains devient particulièrement évident dans les applications linguistiques. Si les scores BLEU quantifient la qualité de la traduction en fonction du chevauchement des mots avec les textes de référence, ils ne permettent pas d'évaluer la précision sémantique ou le naturel linguistique. De même, les modèles de résumé de texte peuvent obtenir des scores ROUGE élevés tout en omettant des points essentiels ou en produisant des résultats incohérents qui frustreraient les lecteurs humains.

L'IA générative introduit des complications supplémentaires. Les grands modèles de langage qui obtiennent des résultats exceptionnels au test de référence MMLU peuvent encore fabriquer des faussetés convaincantes, comme l'a montré un mémoire juridique généré par l'IA qui citait une jurisprudence inexistante. Ces "hallucinations" mettent en évidence le fait que les critères d'évaluation de la mémorisation des faits négligent souvent la véracité et l'adéquation au contexte.

Les défis des critères statiques dans des contextes dynamiques

Adaptation à des environnements changeants

Les conditions de référence contrôlées reflètent mal l'imprévisibilité du monde réel. L'IA conversationnelle qui excelle dans les requêtes à un seul tour peut faiblir lorsqu'elle traite des dialogues multithreads avec de l'argot ou des fautes de frappe. Les véhicules autonomes qui fonctionnent parfaitement dans des conditions idéales peuvent éprouver des difficultés face à une signalisation obscure ou à des conditions météorologiques défavorables. Ces limites révèlent à quel point les tests statiques ne parviennent pas à rendre compte de la complexité opérationnelle.

Considérations éthiques et sociales

Les tests de référence standard évaluent rarement l'équité des modèles ou les préjudices potentiels. Un système de reconnaissance faciale peut atteindre un niveau de précision inégalé tout en identifiant systématiquement mal certains groupes démographiques en raison de données d'apprentissage biaisées. De même, les modèles linguistiques peuvent produire un contenu toxique ou discriminatoire malgré d'excellents scores de fluidité.

Incapacité à saisir les aspects nuancés

Si les critères de référence mesurent efficacement les performances de surface, ils ne tiennent souvent pas compte des capacités cognitives plus profondes. Un modèle peut générer des réponses grammaticalement parfaites mais factuellement inexactes, ou créer des images visuellement réalistes au contenu dérangeant. Ces échecs démontrent la distinction essentielle entre la compétence technique et l'utilité pratique.

Adaptation contextuelle et raisonnement

Les bancs d'essai utilisent généralement des données qui ressemblent à des ensembles d'entraînement, ce qui donne un aperçu limité de la capacité d'un modèle à gérer des situations nouvelles. Le véritable test a lieu lorsque les systèmes rencontrent des entrées inattendues ou doivent appliquer un raisonnement logique allant au-delà de la reconnaissance des formes. Les méthodes d'évaluation actuelles ne parviennent souvent pas à évaluer ces compétences cognitives d'ordre supérieur.

Au-delà des repères : Une nouvelle approche de l'évaluation de l'IA

Les nouveaux paradigmes d'évaluation visent à combler le fossé entre les performances en laboratoire et l'efficacité dans le monde réel :

- L'évaluation humaine en boucle: L'intégration d'évaluations d'experts et d'utilisateurs finaux sur la qualité, l'adéquation et l'utilité des résultats.

- Essais de déploiement dans le monde réel: Validation des modèles dans des environnements authentiques et non contrôlés qui reflètent les cas d'utilisation réels.

- Tests de robustesse et de stress: Mise au défi des systèmes avec des conditions adverses et des cas limites afin d'évaluer la résilience.

- Mesures multidimensionnelles: Combinaison des mesures de performance traditionnelles avec des évaluations de l'équité, de la sécurité et des considérations éthiques.

- Validation spécifique à un domaine: Adapter les cadres d'évaluation aux exigences particulières de l'industrie et aux contextes opérationnels.

La voie à suivre

Bien que les critères de référence aient permis de réaliser des progrès remarquables en matière d'IA, le domaine doit évoluer au-delà de la chasse aux classements. La véritable innovation nécessite des cadres d'évaluation qui donnent la priorité aux éléments suivants

- des normes de performance centrées sur l'humain

- la validité du déploiement dans le monde réel

- les considérations éthiques et de sécurité

- l'adaptabilité à des situations inédites

- Évaluation holistique des capacités

La prochaine frontière du développement de l'IA exige des méthodes d'évaluation aussi sophistiquées que la technologie elle-même - des méthodes qui mesurent non seulement les prouesses techniques, mais aussi l'utilité réelle, la fiabilité et la responsabilité dans des environnements réels complexes.

Article connexe

Marvel retarde les deux prochains films Avengers et ajuste le calendrier de la phase 6

Marvel Studios a annoncé d'importants changements dans le calendrier des prochains films de la franchise Avengers. La publication de l'industrie The Hollywood Reporter révèle que Avengers : Doomsday s

Marvel retarde les deux prochains films Avengers et ajuste le calendrier de la phase 6

Marvel Studios a annoncé d'importants changements dans le calendrier des prochains films de la franchise Avengers. La publication de l'industrie The Hollywood Reporter révèle que Avengers : Doomsday s

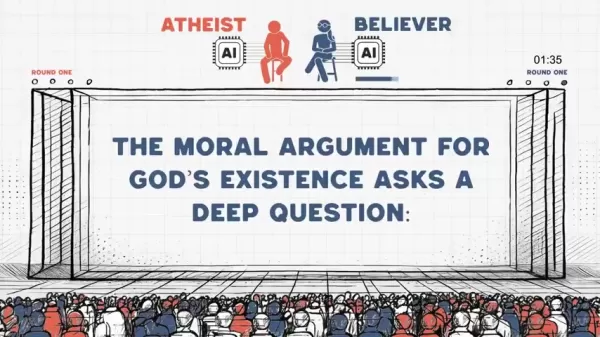

L'IA athée et l'IA croyante s'affrontent sur des arguments moraux lors d'un débat animé

Lorsque des systèmes d'intelligence artificielle dotés de cadres philosophiques diamétralement opposés s'engagent dans un débat éthique, quels enseignements en ressortent ? Cette expérience novatrice

L'IA athée et l'IA croyante s'affrontent sur des arguments moraux lors d'un débat animé

Lorsque des systèmes d'intelligence artificielle dotés de cadres philosophiques diamétralement opposés s'engagent dans un débat éthique, quels enseignements en ressortent ? Cette expérience novatrice

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

commentaires (0)

0/200

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

commentaires (0)

0/200

Si vous avez suivi les progrès de l'IA, vous avez sans doute vu des titres annonçant des performances record en matière de tests de référence. Qu'il s'agisse de tâches de vision par ordinateur ou de diagnostics médicaux, ces tests standardisés servent depuis longtemps de mesure définitive des capacités de l'IA. Pourtant, ces scores impressionnants masquent souvent des limites importantes : un modèle qui réussit des tests de référence contrôlés peut éprouver des difficultés considérables lorsqu'il est déployé dans des cas d'utilisation réels. Dans cette analyse, nous examinerons les raisons pour lesquelles les tests conventionnels ne permettent pas d'évaluer l'efficacité réelle de l'IA et nous explorerons les cadres d'évaluation qui tiennent mieux compte de la complexité du monde réel, de l'éthique et de l'utilité pratique.

L'attrait des critères d'évaluation

Depuis des décennies, les critères d'évaluation de l'IA fournissent des terrains d'essai normalisés essentiels. Des ensembles de données comme ImageNet pour la reconnaissance visuelle ou BLEU pour la qualité des traductions offrent des environnements contrôlés pour mesurer des capacités spécifiques. Ces concours structurés ont accéléré les progrès en permettant des comparaisons directes des performances et en encourageant une concurrence scientifique saine. Le défi ImageNet a catalysé la révolution de l'apprentissage profond en démontrant des gains de précision sans précédent dans le domaine de la vision par ordinateur.

Cependant, ces évaluations statiques présentent souvent une réalité trop simplifiée. Les modèles optimisés pour les performances de référence exploitent fréquemment les particularités des ensembles de données au lieu de développer une véritable compréhension. Un exemple éloquent est apparu lorsqu'un modèle de classification des animaux formé pour distinguer les loups des huskies a appris à s'appuyer sur les arrière-plans enneigés (fréquents dans les images d'entraînement des loups) plutôt que sur les caractéristiques anatomiques réelles. Ce phénomène illustre la loi de Goodhart en action : lorsque les repères deviennent des cibles, ils cessent souvent d'être des mesures efficaces.

Attentes humaines et résultats des mesures

Le décalage fondamental entre les mesures de référence et les besoins humains devient particulièrement évident dans les applications linguistiques. Si les scores BLEU quantifient la qualité de la traduction en fonction du chevauchement des mots avec les textes de référence, ils ne permettent pas d'évaluer la précision sémantique ou le naturel linguistique. De même, les modèles de résumé de texte peuvent obtenir des scores ROUGE élevés tout en omettant des points essentiels ou en produisant des résultats incohérents qui frustreraient les lecteurs humains.

L'IA générative introduit des complications supplémentaires. Les grands modèles de langage qui obtiennent des résultats exceptionnels au test de référence MMLU peuvent encore fabriquer des faussetés convaincantes, comme l'a montré un mémoire juridique généré par l'IA qui citait une jurisprudence inexistante. Ces "hallucinations" mettent en évidence le fait que les critères d'évaluation de la mémorisation des faits négligent souvent la véracité et l'adéquation au contexte.

Les défis des critères statiques dans des contextes dynamiques

Adaptation à des environnements changeants

Les conditions de référence contrôlées reflètent mal l'imprévisibilité du monde réel. L'IA conversationnelle qui excelle dans les requêtes à un seul tour peut faiblir lorsqu'elle traite des dialogues multithreads avec de l'argot ou des fautes de frappe. Les véhicules autonomes qui fonctionnent parfaitement dans des conditions idéales peuvent éprouver des difficultés face à une signalisation obscure ou à des conditions météorologiques défavorables. Ces limites révèlent à quel point les tests statiques ne parviennent pas à rendre compte de la complexité opérationnelle.

Considérations éthiques et sociales

Les tests de référence standard évaluent rarement l'équité des modèles ou les préjudices potentiels. Un système de reconnaissance faciale peut atteindre un niveau de précision inégalé tout en identifiant systématiquement mal certains groupes démographiques en raison de données d'apprentissage biaisées. De même, les modèles linguistiques peuvent produire un contenu toxique ou discriminatoire malgré d'excellents scores de fluidité.

Incapacité à saisir les aspects nuancés

Si les critères de référence mesurent efficacement les performances de surface, ils ne tiennent souvent pas compte des capacités cognitives plus profondes. Un modèle peut générer des réponses grammaticalement parfaites mais factuellement inexactes, ou créer des images visuellement réalistes au contenu dérangeant. Ces échecs démontrent la distinction essentielle entre la compétence technique et l'utilité pratique.

Adaptation contextuelle et raisonnement

Les bancs d'essai utilisent généralement des données qui ressemblent à des ensembles d'entraînement, ce qui donne un aperçu limité de la capacité d'un modèle à gérer des situations nouvelles. Le véritable test a lieu lorsque les systèmes rencontrent des entrées inattendues ou doivent appliquer un raisonnement logique allant au-delà de la reconnaissance des formes. Les méthodes d'évaluation actuelles ne parviennent souvent pas à évaluer ces compétences cognitives d'ordre supérieur.

Au-delà des repères : Une nouvelle approche de l'évaluation de l'IA

Les nouveaux paradigmes d'évaluation visent à combler le fossé entre les performances en laboratoire et l'efficacité dans le monde réel :

- L'évaluation humaine en boucle: L'intégration d'évaluations d'experts et d'utilisateurs finaux sur la qualité, l'adéquation et l'utilité des résultats.

- Essais de déploiement dans le monde réel: Validation des modèles dans des environnements authentiques et non contrôlés qui reflètent les cas d'utilisation réels.

- Tests de robustesse et de stress: Mise au défi des systèmes avec des conditions adverses et des cas limites afin d'évaluer la résilience.

- Mesures multidimensionnelles: Combinaison des mesures de performance traditionnelles avec des évaluations de l'équité, de la sécurité et des considérations éthiques.

- Validation spécifique à un domaine: Adapter les cadres d'évaluation aux exigences particulières de l'industrie et aux contextes opérationnels.

La voie à suivre

Bien que les critères de référence aient permis de réaliser des progrès remarquables en matière d'IA, le domaine doit évoluer au-delà de la chasse aux classements. La véritable innovation nécessite des cadres d'évaluation qui donnent la priorité aux éléments suivants

- des normes de performance centrées sur l'humain

- la validité du déploiement dans le monde réel

- les considérations éthiques et de sécurité

- l'adaptabilité à des situations inédites

- Évaluation holistique des capacités

La prochaine frontière du développement de l'IA exige des méthodes d'évaluation aussi sophistiquées que la technologie elle-même - des méthodes qui mesurent non seulement les prouesses techniques, mais aussi l'utilité réelle, la fiabilité et la responsabilité dans des environnements réels complexes.

Marvel retarde les deux prochains films Avengers et ajuste le calendrier de la phase 6

Marvel Studios a annoncé d'importants changements dans le calendrier des prochains films de la franchise Avengers. La publication de l'industrie The Hollywood Reporter révèle que Avengers : Doomsday s

Marvel retarde les deux prochains films Avengers et ajuste le calendrier de la phase 6

Marvel Studios a annoncé d'importants changements dans le calendrier des prochains films de la franchise Avengers. La publication de l'industrie The Hollywood Reporter révèle que Avengers : Doomsday s

L'IA athée et l'IA croyante s'affrontent sur des arguments moraux lors d'un débat animé

Lorsque des systèmes d'intelligence artificielle dotés de cadres philosophiques diamétralement opposés s'engagent dans un débat éthique, quels enseignements en ressortent ? Cette expérience novatrice

L'IA athée et l'IA croyante s'affrontent sur des arguments moraux lors d'un débat animé

Lorsque des systèmes d'intelligence artificielle dotés de cadres philosophiques diamétralement opposés s'engagent dans un débat éthique, quels enseignements en ressortent ? Cette expérience novatrice

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s

OpenAI met à jour ChatGPT Pro vers o3, augmentant la valeur de l'abonnement mensuel de 200 $.

Cette semaine a été marquée par d'importants développements en matière d'IA de la part de géants de la technologie tels que Microsoft, Google et Anthropic. OpenAI conclut cette vague d'annonces avec s