人工智能评估需要超越基准的真实世界性能审查

如果你一直在追踪人工智能的发展,那么毫无疑问,你一定会在头条新闻中看到破纪录的基准测试成绩。从计算机视觉任务到医疗诊断,这些标准化测试长期以来一直是衡量人工智能能力的权威标准。然而,这些令人印象深刻的成绩往往掩盖了关键的局限性--在实际使用案例中部署时,一个在受控基准测试中取得优异成绩的模型可能会表现得非常吃力。在本分析报告中,我们将研究传统基准为何无法评估人工智能的真正有效性,并探讨能更好地应对现实世界的复杂性、道德规范和实际效用的评估框架。

基准的吸引力

几十年来,人工智能基准提供了至关重要的标准化测试场地。像用于视觉识别的 ImageNet 或用于翻译质量的 BLEU 这样的数据集为衡量特定能力提供了受控环境。这些结构化竞赛通过直接的性能比较和促进健康的科学竞争,加快了进步的步伐。ImageNet 挑战赛在计算机视觉领域展示了前所未有的准确性提升,从而催化了一场著名的深度学习革命。

然而,这些静态评估往往呈现了过于简单化的现实。为基准性能而优化的模型经常利用数据集的特殊性,而不是发展真正的理解能力。一个很有说服力的例子是,为了区分狼和哈士奇而训练的动物分类模型学会了依赖雪白的背景(在狼的训练图像中很常见),而不是实际的解剖特征。这一现象说明了古德哈特法则的作用:当基准变成目标时,它们往往不再是有效的衡量标准。

人类期望与指标得分

基准指标与人类需求之间的根本脱节在语言应用中尤为明显。虽然 BLEU 分数可以通过与参考文本的词语重叠来量化翻译质量,但却无法评估语义准确性或语言自然度。同样,文本摘要模型可能会获得很高的 ROUGE 分数,但却遗漏了关键点或产生了不连贯的输出,这将使人类读者感到沮丧。

生成式人工智能带来了额外的复杂性。在 MMLU 基准上取得优异成绩的大型语言模型仍然可以编造令人信服的假话--人工智能生成的法律简报引用了不存在的判例法就是证明。这些 "幻觉 "凸显了评估事实回忆的基准如何经常忽略真实性和上下文的适当性。

动态环境中静态基准的挑战

适应不断变化的环境

受控基准条件不能很好地反映真实世界的不可预测性。擅长单轮查询的对话式人工智能在处理带有俚语或错别字的多线程对话时可能会出现问题。在理想条件下表现完美无瑕的自动驾驶汽车,在面对模糊不清的指示牌或恶劣天气时也会举步维艰。这些局限性揭示了静态测试如何无法捕捉操作的复杂性。

道德和社会因素

标准基准很少评估模型的公平性或潜在危害。人脸识别系统可能会达到突破基准的准确率,但由于训练数据有偏差,系统性地错误识别某些人口。同样,尽管语言模型的流畅度得分极高,但也可能产生有毒或歧视性的内容。

无法捕捉细微差别

虽然基准能有效衡量表面性能,但它们往往忽略了更深层次的认知能力。一个模型可能会生成语法完美但与事实不符的回答,或者生成视觉逼真但内容令人不安的图像。这些失败表明,技术熟练程度和实际实用性之间存在着关键的区别。

情境适应与推理

基准测试通常使用与训练集类似的数据,因此对模型处理新情况的能力只能提供有限的了解。当系统遇到意外输入或必须应用模式识别之外的逻辑推理时,才是真正的考验。目前的评估方法往往无法评估这些高阶认知技能。

超越基准:人工智能评估的新方法

新出现的评估范例旨在通过以下方式缩小实验室性能与现实世界有效性之间的差距:

- 人在回路中评估:结合专家和最终用户对输出质量、适当性和实用性的评价

- 真实世界部署测试:在真实、不受控制的环境中验证模型,以反映实际使用情况

- 稳健性和压力测试:用对抗性条件和边缘情况挑战系统,以评估复原能力

- 多维指标:将传统的性能衡量标准与公平性、安全性和道德考虑因素的评估相结合

- 特定领域验证:根据特定行业要求和操作环境调整评估框架

前进之路

虽然基准推动了人工智能的显著进步,但该领域的发展必须超越对排行榜的追逐。真正的创新需要优先考虑以下方面的评估框架:

- 以人为本的性能标准

- 真实世界部署的有效性

- 道德和安全考虑

- 对新情况的适应性

- 能力的整体评估

人工智能发展的下一个前沿需要与技术本身一样复杂的评估方法--这些方法不仅要衡量技术实力,还要衡量在复杂的现实世界环境中的真正实用性、可靠性和责任感。

相关文章

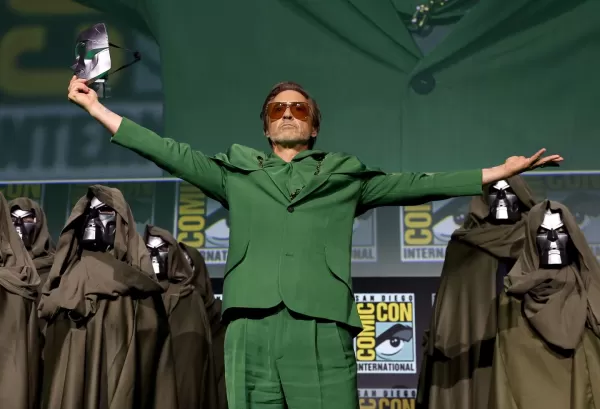

漫威推迟下两部《复仇者联盟》电影,调整第六阶段上映时间表

漫威影业(Marvel Studios)宣布对即将上映的《复仇者联盟》系列电影进行重大档期调整。业内刊物《好莱坞报道者》透露,《复仇者联盟:末日之战》将于 2026年12 月 18日首映,而不是原计划的 2026 年 5 月 1 日:末日崩塌》将于 2026 年 12 月 18 日上映,而不是原计划的 2026 年 5 月 1 日。其续集《复仇者联盟:秘密战争》(Avengers:秘密战争》将从

漫威推迟下两部《复仇者联盟》电影,调整第六阶段上映时间表

漫威影业(Marvel Studios)宣布对即将上映的《复仇者联盟》系列电影进行重大档期调整。业内刊物《好莱坞报道者》透露,《复仇者联盟:末日之战》将于 2026年12 月 18日首映,而不是原计划的 2026 年 5 月 1 日:末日崩塌》将于 2026 年 12 月 18 日上映,而不是原计划的 2026 年 5 月 1 日。其续集《复仇者联盟:秘密战争》(Avengers:秘密战争》将从

无神论者和信仰者的人工智能在激烈辩论中就道德论点发生冲突

当具有截然相反哲学框架的人工智能系统进行道德辩论时,会产生什么启示?这项开创性的实验在无神论人工智能和信仰者人工智能之间上演了一场智力对抗,重点关注神性存在的道德论证。读者将接触到复杂的哲学论述,分析相互竞争的逻辑框架,并观察 15 位独立的人工智能评委是如何评价这些论点的。除了单纯的学术练习,这一探索还探究了道德体系的基础和道德推理本身的本质。要点道德景观:探讨纯粹的唯物主义框架能否产生普遍的道

无神论者和信仰者的人工智能在激烈辩论中就道德论点发生冲突

当具有截然相反哲学框架的人工智能系统进行道德辩论时,会产生什么启示?这项开创性的实验在无神论人工智能和信仰者人工智能之间上演了一场智力对抗,重点关注神性存在的道德论证。读者将接触到复杂的哲学论述,分析相互竞争的逻辑框架,并观察 15 位独立的人工智能评委是如何评价这些论点的。除了单纯的学术练习,这一探索还探究了道德体系的基础和道德推理本身的本质。要点道德景观:探讨纯粹的唯物主义框架能否产生普遍的道

OpenAI 将 ChatGPT Pro 升级到 o3,提升 200 美元月费的价值

本周,微软(Microsoft)、谷歌(Google)和人类学(Anthropic)等科技巨头都发布了重要的人工智能发展成果。OpenAI 以自己的突破性更新结束了这一轮的公告发布--除了高调斥资 65 亿美元收购 Jony Ive 的设计公司,还推出了代号为 "io "的雄心勃勃的硬件计划。公司大幅增强了 ChatGPT 中的 Operator 自主网络导航系统,从以前的 GPT-4o 框架过渡

评论 (0)

0/200

OpenAI 将 ChatGPT Pro 升级到 o3,提升 200 美元月费的价值

本周,微软(Microsoft)、谷歌(Google)和人类学(Anthropic)等科技巨头都发布了重要的人工智能发展成果。OpenAI 以自己的突破性更新结束了这一轮的公告发布--除了高调斥资 65 亿美元收购 Jony Ive 的设计公司,还推出了代号为 "io "的雄心勃勃的硬件计划。公司大幅增强了 ChatGPT 中的 Operator 自主网络导航系统,从以前的 GPT-4o 框架过渡

评论 (0)

0/200

如果你一直在追踪人工智能的发展,那么毫无疑问,你一定会在头条新闻中看到破纪录的基准测试成绩。从计算机视觉任务到医疗诊断,这些标准化测试长期以来一直是衡量人工智能能力的权威标准。然而,这些令人印象深刻的成绩往往掩盖了关键的局限性--在实际使用案例中部署时,一个在受控基准测试中取得优异成绩的模型可能会表现得非常吃力。在本分析报告中,我们将研究传统基准为何无法评估人工智能的真正有效性,并探讨能更好地应对现实世界的复杂性、道德规范和实际效用的评估框架。

基准的吸引力

几十年来,人工智能基准提供了至关重要的标准化测试场地。像用于视觉识别的 ImageNet 或用于翻译质量的 BLEU 这样的数据集为衡量特定能力提供了受控环境。这些结构化竞赛通过直接的性能比较和促进健康的科学竞争,加快了进步的步伐。ImageNet 挑战赛在计算机视觉领域展示了前所未有的准确性提升,从而催化了一场著名的深度学习革命。

然而,这些静态评估往往呈现了过于简单化的现实。为基准性能而优化的模型经常利用数据集的特殊性,而不是发展真正的理解能力。一个很有说服力的例子是,为了区分狼和哈士奇而训练的动物分类模型学会了依赖雪白的背景(在狼的训练图像中很常见),而不是实际的解剖特征。这一现象说明了古德哈特法则的作用:当基准变成目标时,它们往往不再是有效的衡量标准。

人类期望与指标得分

基准指标与人类需求之间的根本脱节在语言应用中尤为明显。虽然 BLEU 分数可以通过与参考文本的词语重叠来量化翻译质量,但却无法评估语义准确性或语言自然度。同样,文本摘要模型可能会获得很高的 ROUGE 分数,但却遗漏了关键点或产生了不连贯的输出,这将使人类读者感到沮丧。

生成式人工智能带来了额外的复杂性。在 MMLU 基准上取得优异成绩的大型语言模型仍然可以编造令人信服的假话--人工智能生成的法律简报引用了不存在的判例法就是证明。这些 "幻觉 "凸显了评估事实回忆的基准如何经常忽略真实性和上下文的适当性。

动态环境中静态基准的挑战

适应不断变化的环境

受控基准条件不能很好地反映真实世界的不可预测性。擅长单轮查询的对话式人工智能在处理带有俚语或错别字的多线程对话时可能会出现问题。在理想条件下表现完美无瑕的自动驾驶汽车,在面对模糊不清的指示牌或恶劣天气时也会举步维艰。这些局限性揭示了静态测试如何无法捕捉操作的复杂性。

道德和社会因素

标准基准很少评估模型的公平性或潜在危害。人脸识别系统可能会达到突破基准的准确率,但由于训练数据有偏差,系统性地错误识别某些人口。同样,尽管语言模型的流畅度得分极高,但也可能产生有毒或歧视性的内容。

无法捕捉细微差别

虽然基准能有效衡量表面性能,但它们往往忽略了更深层次的认知能力。一个模型可能会生成语法完美但与事实不符的回答,或者生成视觉逼真但内容令人不安的图像。这些失败表明,技术熟练程度和实际实用性之间存在着关键的区别。

情境适应与推理

基准测试通常使用与训练集类似的数据,因此对模型处理新情况的能力只能提供有限的了解。当系统遇到意外输入或必须应用模式识别之外的逻辑推理时,才是真正的考验。目前的评估方法往往无法评估这些高阶认知技能。

超越基准:人工智能评估的新方法

新出现的评估范例旨在通过以下方式缩小实验室性能与现实世界有效性之间的差距:

- 人在回路中评估:结合专家和最终用户对输出质量、适当性和实用性的评价

- 真实世界部署测试:在真实、不受控制的环境中验证模型,以反映实际使用情况

- 稳健性和压力测试:用对抗性条件和边缘情况挑战系统,以评估复原能力

- 多维指标:将传统的性能衡量标准与公平性、安全性和道德考虑因素的评估相结合

- 特定领域验证:根据特定行业要求和操作环境调整评估框架

前进之路

虽然基准推动了人工智能的显著进步,但该领域的发展必须超越对排行榜的追逐。真正的创新需要优先考虑以下方面的评估框架:

- 以人为本的性能标准

- 真实世界部署的有效性

- 道德和安全考虑

- 对新情况的适应性

- 能力的整体评估

人工智能发展的下一个前沿需要与技术本身一样复杂的评估方法--这些方法不仅要衡量技术实力,还要衡量在复杂的现实世界环境中的真正实用性、可靠性和责任感。

漫威推迟下两部《复仇者联盟》电影,调整第六阶段上映时间表

漫威影业(Marvel Studios)宣布对即将上映的《复仇者联盟》系列电影进行重大档期调整。业内刊物《好莱坞报道者》透露,《复仇者联盟:末日之战》将于 2026年12 月 18日首映,而不是原计划的 2026 年 5 月 1 日:末日崩塌》将于 2026 年 12 月 18 日上映,而不是原计划的 2026 年 5 月 1 日。其续集《复仇者联盟:秘密战争》(Avengers:秘密战争》将从

漫威推迟下两部《复仇者联盟》电影,调整第六阶段上映时间表

漫威影业(Marvel Studios)宣布对即将上映的《复仇者联盟》系列电影进行重大档期调整。业内刊物《好莱坞报道者》透露,《复仇者联盟:末日之战》将于 2026年12 月 18日首映,而不是原计划的 2026 年 5 月 1 日:末日崩塌》将于 2026 年 12 月 18 日上映,而不是原计划的 2026 年 5 月 1 日。其续集《复仇者联盟:秘密战争》(Avengers:秘密战争》将从

无神论者和信仰者的人工智能在激烈辩论中就道德论点发生冲突

当具有截然相反哲学框架的人工智能系统进行道德辩论时,会产生什么启示?这项开创性的实验在无神论人工智能和信仰者人工智能之间上演了一场智力对抗,重点关注神性存在的道德论证。读者将接触到复杂的哲学论述,分析相互竞争的逻辑框架,并观察 15 位独立的人工智能评委是如何评价这些论点的。除了单纯的学术练习,这一探索还探究了道德体系的基础和道德推理本身的本质。要点道德景观:探讨纯粹的唯物主义框架能否产生普遍的道

无神论者和信仰者的人工智能在激烈辩论中就道德论点发生冲突

当具有截然相反哲学框架的人工智能系统进行道德辩论时,会产生什么启示?这项开创性的实验在无神论人工智能和信仰者人工智能之间上演了一场智力对抗,重点关注神性存在的道德论证。读者将接触到复杂的哲学论述,分析相互竞争的逻辑框架,并观察 15 位独立的人工智能评委是如何评价这些论点的。除了单纯的学术练习,这一探索还探究了道德体系的基础和道德推理本身的本质。要点道德景观:探讨纯粹的唯物主义框架能否产生普遍的道

OpenAI 将 ChatGPT Pro 升级到 o3,提升 200 美元月费的价值

本周,微软(Microsoft)、谷歌(Google)和人类学(Anthropic)等科技巨头都发布了重要的人工智能发展成果。OpenAI 以自己的突破性更新结束了这一轮的公告发布--除了高调斥资 65 亿美元收购 Jony Ive 的设计公司,还推出了代号为 "io "的雄心勃勃的硬件计划。公司大幅增强了 ChatGPT 中的 Operator 自主网络导航系统,从以前的 GPT-4o 框架过渡

OpenAI 将 ChatGPT Pro 升级到 o3,提升 200 美元月费的价值

本周,微软(Microsoft)、谷歌(Google)和人类学(Anthropic)等科技巨头都发布了重要的人工智能发展成果。OpenAI 以自己的突破性更新结束了这一轮的公告发布--除了高调斥资 65 亿美元收购 Jony Ive 的设计公司,还推出了代号为 "io "的雄心勃勃的硬件计划。公司大幅增强了 ChatGPT 中的 Operator 自主网络导航系统,从以前的 GPT-4o 框架过渡