KI-Bewertung erfordert Leistungsüberprüfung in der realen Welt jenseits von Benchmarks

Wenn Sie die Fortschritte der KI verfolgt haben, sind Sie zweifellos auf Schlagzeilen gestoßen, die rekordverdächtige Benchmark-Leistungen ankündigen. Von Computer-Vision-Aufgaben bis hin zu medizinischen Diagnosen dienen diese standardisierten Tests seit langem als maßgeblicher Maßstab für KI-Fähigkeiten. Doch hinter diesen beeindruckenden Ergebnissen verbergen sich oft kritische Einschränkungen - ein Modell, das bei kontrollierten Benchmarks gut abschneidet, kann bei der Anwendung in realen Fällen dramatische Probleme haben. In dieser Analyse untersuchen wir, warum herkömmliche Benchmarks die tatsächliche Effektivität von KI nicht beurteilen können, und erkunden Bewertungsrahmen, die der Komplexität der realen Welt, der Ethik und dem praktischen Nutzen besser gerecht werden.

Die Anziehungskraft von Benchmarks

Seit Jahrzehnten bieten KI-Benchmarks ein wichtiges standardisiertes Testfeld. Datensätze wie ImageNet für die visuelle Erkennung oder BLEU für die Übersetzungsqualität bieten kontrollierte Umgebungen zur Messung bestimmter Fähigkeiten. Diese strukturierten Wettbewerbe haben den Fortschritt beschleunigt, indem sie direkte Leistungsvergleiche ermöglichten und einen gesunden wissenschaftlichen Wettbewerb förderten. Der ImageNet-Wettbewerb war bekanntlich der Katalysator für die Revolution des Deep Learning, da er beispiellose Genauigkeitssteigerungen im Bereich der Computer Vision aufzeigte.

Diese statischen Auswertungen stellen jedoch oft eine stark vereinfachte Realität dar. Modelle, die für die Benchmark-Performance optimiert sind, nutzen häufig die Eigenheiten des Datensatzes aus, anstatt ein echtes Verständnis zu entwickeln. Ein bezeichnendes Beispiel: Ein Tierklassifizierungsmodell, das für die Unterscheidung von Wölfen und Schlittenhunden trainiert wurde, lernte, sich auf schneebedeckte Hintergründe (die in Wolfs-Trainingsbildern häufig vorkommen) zu verlassen, statt auf tatsächliche anatomische Merkmale. Dieses Phänomen veranschaulicht das Goodhart'sche Gesetz in Aktion: Wenn Benchmarks zu Zielen werden, sind sie oft keine wirksamen Messinstrumente mehr.

Menschliche Erwartungen vs. metrische Werte

Die grundlegende Diskrepanz zwischen Benchmark-Metriken und menschlichen Bedürfnissen wird bei Sprachanwendungen besonders deutlich. Während BLEU-Punkte die Übersetzungsqualität durch Wortüberschneidungen mit Referenztexten quantifizieren, können sie weder die semantische Genauigkeit noch die sprachliche Natürlichkeit bewerten. In ähnlicher Weise können Modelle zur Textzusammenfassung hohe ROUGE-Werte erreichen, während sie wichtige Punkte auslassen oder inkohärente Ergebnisse produzieren, die den menschlichen Leser frustrieren würden.

Generative KI bringt zusätzliche Komplikationen mit sich. Große Sprachmodelle, die beim MMLU-Benchmark hervorragende Ergebnisse erzielen, können dennoch überzeugende Unwahrheiten produzieren - wie ein von der KI generierter juristischer Schriftsatz zeigt, der nicht existierende Rechtsprechung zitiert. Diese "Halluzinationen" verdeutlichen, dass Benchmarks, die den Abruf von Fakten bewerten, oft den Wahrheitsgehalt und die kontextuelle Angemessenheit übersehen.

Herausforderungen von statischen Benchmarks in dynamischen Kontexten

Anpassung an sich verändernde Umgebungen

Kontrollierte Benchmark-Bedingungen spiegeln die Unvorhersehbarkeit der realen Welt nur unzureichend wider. Eine konversationelle KI, die bei Abfragen mit einer einzigen Abfrage hervorragend abschneidet, kann bei der Handhabung von Dialogen mit mehreren Threads, Slang oder Tippfehlern ins Stocken geraten. Autonome Fahrzeuge, die unter idealen Bedingungen einwandfrei funktionieren, können bei verdeckter Beschilderung oder schlechtem Wetter Probleme haben. Diese Einschränkungen zeigen, dass statische Tests die Komplexität des Betriebs nicht erfassen können.

Ethische und soziale Erwägungen

Standard-Benchmarks bewerten selten die Fairness des Modells oder mögliche Schäden. Ein Gesichtserkennungssystem kann eine bahnbrechende Genauigkeit erreichen, während es aufgrund verzerrter Trainingsdaten bestimmte Bevölkerungsgruppen systematisch falsch identifiziert. In ähnlicher Weise können Sprachmodelle trotz hervorragender Sprachfertigkeitswerte toxische oder diskriminierende Inhalte produzieren.

Unfähigkeit, nuancierte Aspekte zu erfassen

Benchmarks messen zwar effektiv die oberflächliche Leistung, lassen aber oft tiefere kognitive Fähigkeiten außer Acht. Ein Modell kann grammatikalisch perfekte, aber sachlich ungenaue Antworten geben oder visuell realistische Bilder mit verstörendem Inhalt erzeugen. Diese Fehler zeigen den entscheidenden Unterschied zwischen technischem Können und praktischer Nützlichkeit.

Kontextabhängige Anpassung und logische Schlussfolgerungen

Benchmarks verwenden in der Regel Daten, die Trainingssätzen ähneln, was nur einen begrenzten Einblick in die Fähigkeit eines Modells gibt, mit neuen Situationen umzugehen. Der wahre Test kommt, wenn Systeme mit unerwarteten Eingaben konfrontiert werden oder logische Schlussfolgerungen über die Mustererkennung hinaus anwenden müssen. Aktuelle Bewertungsmethoden versagen oft bei der Beurteilung dieser kognitiven Fähigkeiten höherer Ordnung.

Jenseits von Benchmarks: Ein neuer Ansatz für die KI-Bewertung

Neue Bewertungsparadigmen zielen darauf ab, die Lücke zwischen der Leistung im Labor und der Effektivität in der Praxis zu schließen:

- Human-in-the-Loop-Bewertung: Einbeziehung von Experten- und Endnutzerevaluierungen der Qualität, Angemessenheit und des Nutzens der Ergebnisse

- Real-World Deployment Testing: Validierung von Modellen in authentischen, unkontrollierten Umgebungen, die tatsächliche Anwendungsfälle widerspiegeln

- Robustheits- und Belastungstests: Herausfordernde Systeme mit ungünstigen Bedingungen und Grenzfällen zur Bewertung der Widerstandsfähigkeit

- Multidimensionale Metriken: Kombination traditioneller Leistungsmessungen mit Bewertungen von Fairness, Sicherheit und ethischen Erwägungen

- Bereichsspezifische Validierung: Maßgeschneiderte Bewertungsrahmen für bestimmte Branchenanforderungen und betriebliche Kontexte

Der Weg in die Zukunft

Benchmarks haben zwar zu bemerkenswerten Fortschritten in der KI geführt, aber die Branche muss sich über die Jagd nach Spitzenreitern hinaus weiterentwickeln. Echte Innovation erfordert Bewertungsrahmen, die Prioritäten setzen:

- Menschenzentrierte Leistungsstandards

- Validität des Einsatzes in der realen Welt

- Ethische und sicherheitstechnische Überlegungen

- Anpassungsfähigkeit an neue Situationen

- Ganzheitliche Bewertung von Fähigkeiten

Die nächste Stufe der KI-Entwicklung erfordert Bewertungsmethoden, die so anspruchsvoll sind wie die Technologie selbst - Methoden, die nicht nur die technischen Fähigkeiten, sondern auch den tatsächlichen Nutzen, die Zuverlässigkeit und die Verantwortung in komplexen realen Umgebungen messen.

Verwandter Artikel

Marvel verzögert die nächsten beiden Avengers-Filme und ändert den Zeitplan für Phase 6

Marvel Studios hat bedeutende Änderungen im Zeitplan für die kommenden Avengers-Franchise-Filme angekündigt. Die Branchenpublikation The Hollywood Reporter enthüllt, dass Avengers: Doomsday nun am 18.

Marvel verzögert die nächsten beiden Avengers-Filme und ändert den Zeitplan für Phase 6

Marvel Studios hat bedeutende Änderungen im Zeitplan für die kommenden Avengers-Franchise-Filme angekündigt. Die Branchenpublikation The Hollywood Reporter enthüllt, dass Avengers: Doomsday nun am 18.

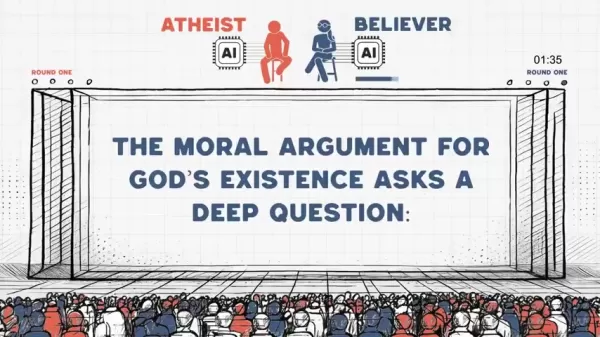

Atheist und gläubige KI streiten sich in hitziger Debatte über moralische Argumente

Welche Erkenntnisse ergeben sich, wenn künstliche Intelligenzsysteme mit diametral entgegengesetzten philosophischen Vorstellungen in eine ethische Debatte eintreten? Dieses bahnbrechende Experiment i

Atheist und gläubige KI streiten sich in hitziger Debatte über moralische Argumente

Welche Erkenntnisse ergeben sich, wenn künstliche Intelligenzsysteme mit diametral entgegengesetzten philosophischen Vorstellungen in eine ethische Debatte eintreten? Dieses bahnbrechende Experiment i

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Kommentare (0)

0/200

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

Kommentare (0)

0/200

Wenn Sie die Fortschritte der KI verfolgt haben, sind Sie zweifellos auf Schlagzeilen gestoßen, die rekordverdächtige Benchmark-Leistungen ankündigen. Von Computer-Vision-Aufgaben bis hin zu medizinischen Diagnosen dienen diese standardisierten Tests seit langem als maßgeblicher Maßstab für KI-Fähigkeiten. Doch hinter diesen beeindruckenden Ergebnissen verbergen sich oft kritische Einschränkungen - ein Modell, das bei kontrollierten Benchmarks gut abschneidet, kann bei der Anwendung in realen Fällen dramatische Probleme haben. In dieser Analyse untersuchen wir, warum herkömmliche Benchmarks die tatsächliche Effektivität von KI nicht beurteilen können, und erkunden Bewertungsrahmen, die der Komplexität der realen Welt, der Ethik und dem praktischen Nutzen besser gerecht werden.

Die Anziehungskraft von Benchmarks

Seit Jahrzehnten bieten KI-Benchmarks ein wichtiges standardisiertes Testfeld. Datensätze wie ImageNet für die visuelle Erkennung oder BLEU für die Übersetzungsqualität bieten kontrollierte Umgebungen zur Messung bestimmter Fähigkeiten. Diese strukturierten Wettbewerbe haben den Fortschritt beschleunigt, indem sie direkte Leistungsvergleiche ermöglichten und einen gesunden wissenschaftlichen Wettbewerb förderten. Der ImageNet-Wettbewerb war bekanntlich der Katalysator für die Revolution des Deep Learning, da er beispiellose Genauigkeitssteigerungen im Bereich der Computer Vision aufzeigte.

Diese statischen Auswertungen stellen jedoch oft eine stark vereinfachte Realität dar. Modelle, die für die Benchmark-Performance optimiert sind, nutzen häufig die Eigenheiten des Datensatzes aus, anstatt ein echtes Verständnis zu entwickeln. Ein bezeichnendes Beispiel: Ein Tierklassifizierungsmodell, das für die Unterscheidung von Wölfen und Schlittenhunden trainiert wurde, lernte, sich auf schneebedeckte Hintergründe (die in Wolfs-Trainingsbildern häufig vorkommen) zu verlassen, statt auf tatsächliche anatomische Merkmale. Dieses Phänomen veranschaulicht das Goodhart'sche Gesetz in Aktion: Wenn Benchmarks zu Zielen werden, sind sie oft keine wirksamen Messinstrumente mehr.

Menschliche Erwartungen vs. metrische Werte

Die grundlegende Diskrepanz zwischen Benchmark-Metriken und menschlichen Bedürfnissen wird bei Sprachanwendungen besonders deutlich. Während BLEU-Punkte die Übersetzungsqualität durch Wortüberschneidungen mit Referenztexten quantifizieren, können sie weder die semantische Genauigkeit noch die sprachliche Natürlichkeit bewerten. In ähnlicher Weise können Modelle zur Textzusammenfassung hohe ROUGE-Werte erreichen, während sie wichtige Punkte auslassen oder inkohärente Ergebnisse produzieren, die den menschlichen Leser frustrieren würden.

Generative KI bringt zusätzliche Komplikationen mit sich. Große Sprachmodelle, die beim MMLU-Benchmark hervorragende Ergebnisse erzielen, können dennoch überzeugende Unwahrheiten produzieren - wie ein von der KI generierter juristischer Schriftsatz zeigt, der nicht existierende Rechtsprechung zitiert. Diese "Halluzinationen" verdeutlichen, dass Benchmarks, die den Abruf von Fakten bewerten, oft den Wahrheitsgehalt und die kontextuelle Angemessenheit übersehen.

Herausforderungen von statischen Benchmarks in dynamischen Kontexten

Anpassung an sich verändernde Umgebungen

Kontrollierte Benchmark-Bedingungen spiegeln die Unvorhersehbarkeit der realen Welt nur unzureichend wider. Eine konversationelle KI, die bei Abfragen mit einer einzigen Abfrage hervorragend abschneidet, kann bei der Handhabung von Dialogen mit mehreren Threads, Slang oder Tippfehlern ins Stocken geraten. Autonome Fahrzeuge, die unter idealen Bedingungen einwandfrei funktionieren, können bei verdeckter Beschilderung oder schlechtem Wetter Probleme haben. Diese Einschränkungen zeigen, dass statische Tests die Komplexität des Betriebs nicht erfassen können.

Ethische und soziale Erwägungen

Standard-Benchmarks bewerten selten die Fairness des Modells oder mögliche Schäden. Ein Gesichtserkennungssystem kann eine bahnbrechende Genauigkeit erreichen, während es aufgrund verzerrter Trainingsdaten bestimmte Bevölkerungsgruppen systematisch falsch identifiziert. In ähnlicher Weise können Sprachmodelle trotz hervorragender Sprachfertigkeitswerte toxische oder diskriminierende Inhalte produzieren.

Unfähigkeit, nuancierte Aspekte zu erfassen

Benchmarks messen zwar effektiv die oberflächliche Leistung, lassen aber oft tiefere kognitive Fähigkeiten außer Acht. Ein Modell kann grammatikalisch perfekte, aber sachlich ungenaue Antworten geben oder visuell realistische Bilder mit verstörendem Inhalt erzeugen. Diese Fehler zeigen den entscheidenden Unterschied zwischen technischem Können und praktischer Nützlichkeit.

Kontextabhängige Anpassung und logische Schlussfolgerungen

Benchmarks verwenden in der Regel Daten, die Trainingssätzen ähneln, was nur einen begrenzten Einblick in die Fähigkeit eines Modells gibt, mit neuen Situationen umzugehen. Der wahre Test kommt, wenn Systeme mit unerwarteten Eingaben konfrontiert werden oder logische Schlussfolgerungen über die Mustererkennung hinaus anwenden müssen. Aktuelle Bewertungsmethoden versagen oft bei der Beurteilung dieser kognitiven Fähigkeiten höherer Ordnung.

Jenseits von Benchmarks: Ein neuer Ansatz für die KI-Bewertung

Neue Bewertungsparadigmen zielen darauf ab, die Lücke zwischen der Leistung im Labor und der Effektivität in der Praxis zu schließen:

- Human-in-the-Loop-Bewertung: Einbeziehung von Experten- und Endnutzerevaluierungen der Qualität, Angemessenheit und des Nutzens der Ergebnisse

- Real-World Deployment Testing: Validierung von Modellen in authentischen, unkontrollierten Umgebungen, die tatsächliche Anwendungsfälle widerspiegeln

- Robustheits- und Belastungstests: Herausfordernde Systeme mit ungünstigen Bedingungen und Grenzfällen zur Bewertung der Widerstandsfähigkeit

- Multidimensionale Metriken: Kombination traditioneller Leistungsmessungen mit Bewertungen von Fairness, Sicherheit und ethischen Erwägungen

- Bereichsspezifische Validierung: Maßgeschneiderte Bewertungsrahmen für bestimmte Branchenanforderungen und betriebliche Kontexte

Der Weg in die Zukunft

Benchmarks haben zwar zu bemerkenswerten Fortschritten in der KI geführt, aber die Branche muss sich über die Jagd nach Spitzenreitern hinaus weiterentwickeln. Echte Innovation erfordert Bewertungsrahmen, die Prioritäten setzen:

- Menschenzentrierte Leistungsstandards

- Validität des Einsatzes in der realen Welt

- Ethische und sicherheitstechnische Überlegungen

- Anpassungsfähigkeit an neue Situationen

- Ganzheitliche Bewertung von Fähigkeiten

Die nächste Stufe der KI-Entwicklung erfordert Bewertungsmethoden, die so anspruchsvoll sind wie die Technologie selbst - Methoden, die nicht nur die technischen Fähigkeiten, sondern auch den tatsächlichen Nutzen, die Zuverlässigkeit und die Verantwortung in komplexen realen Umgebungen messen.

Marvel verzögert die nächsten beiden Avengers-Filme und ändert den Zeitplan für Phase 6

Marvel Studios hat bedeutende Änderungen im Zeitplan für die kommenden Avengers-Franchise-Filme angekündigt. Die Branchenpublikation The Hollywood Reporter enthüllt, dass Avengers: Doomsday nun am 18.

Marvel verzögert die nächsten beiden Avengers-Filme und ändert den Zeitplan für Phase 6

Marvel Studios hat bedeutende Änderungen im Zeitplan für die kommenden Avengers-Franchise-Filme angekündigt. Die Branchenpublikation The Hollywood Reporter enthüllt, dass Avengers: Doomsday nun am 18.

Atheist und gläubige KI streiten sich in hitziger Debatte über moralische Argumente

Welche Erkenntnisse ergeben sich, wenn künstliche Intelligenzsysteme mit diametral entgegengesetzten philosophischen Vorstellungen in eine ethische Debatte eintreten? Dieses bahnbrechende Experiment i

Atheist und gläubige KI streiten sich in hitziger Debatte über moralische Argumente

Welche Erkenntnisse ergeben sich, wenn künstliche Intelligenzsysteme mit diametral entgegengesetzten philosophischen Vorstellungen in eine ethische Debatte eintreten? Dieses bahnbrechende Experiment i

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe

OpenAI wertet ChatGPT Pro auf o3 auf und steigert den Wert des $200 Monatsabonnements

Diese Woche gab es bedeutende KI-Entwicklungen von Tech-Giganten wie Microsoft, Google und Anthropic. OpenAI schließt den Reigen der Ankündigungen mit seinen eigenen bahnbrechenden Updates ab, die übe