La evaluación de la IA requiere una revisión del rendimiento en el mundo real más allá de los puntos de referencia

Si ha estado siguiendo los avances de la IA, sin duda se habrá encontrado con titulares que anuncian resultados de referencia que baten récords. Desde tareas de visión por ordenador hasta diagnósticos médicos, estas pruebas estandarizadas han servido durante mucho tiempo como medida definitiva de las capacidades de la IA. Sin embargo, estas impresionantes puntuaciones a menudo ocultan limitaciones críticas: un modelo que supera las pruebas de rendimiento controladas puede tener grandes dificultades cuando se utiliza en casos reales. En este análisis, examinaremos por qué los puntos de referencia convencionales no consiguen evaluar la verdadera eficacia de la IA y exploraremos marcos de evaluación que tengan más en cuenta la complejidad del mundo real, la ética y la utilidad práctica.

El atractivo de los puntos de referencia

Durante décadas, los puntos de referencia de la IA han proporcionado campos de pruebas estandarizados cruciales. Conjuntos de datos como ImageNet para el reconocimiento visual o BLEU para la calidad de la traducción ofrecen entornos controlados para medir capacidades específicas. Estas competiciones estructuradas han acelerado el progreso al permitir comparaciones directas del rendimiento y fomentar una sana competencia científica. El reto ImageNet catalizó la revolución del aprendizaje profundo al demostrar mejoras de precisión sin precedentes en la visión por ordenador.

Sin embargo, estas evaluaciones estáticas a menudo presentan una realidad demasiado simplificada. Los modelos optimizados para el rendimiento de referencia a menudo explotan la idiosincrasia del conjunto de datos en lugar de desarrollar una comprensión genuina. Un ejemplo elocuente surgió cuando un modelo de clasificación de animales entrenado para distinguir lobos de huskies aprendió a basarse en fondos nevados (habituales en las imágenes de entrenamiento de lobos) en lugar de en características anatómicas reales. Este fenómeno ilustra la Ley de Goodhart en acción: cuando los puntos de referencia se convierten en objetivos, a menudo dejan de ser medidas eficaces.

Expectativas humanas frente a puntuaciones métricas

La desconexión fundamental entre las métricas de referencia y las necesidades humanas se hace especialmente evidente en las aplicaciones lingüísticas. Aunque las puntuaciones BLEU cuantifican la calidad de la traducción mediante el solapamiento de palabras con los textos de referencia, no evalúan la precisión semántica ni la naturalidad lingüística. Del mismo modo, los modelos de resumen de textos pueden obtener puntuaciones ROUGE elevadas y pasar por alto puntos clave o producir resultados incoherentes que frustrarían a los lectores humanos.

La IA generativa introduce complicaciones adicionales. Los grandes modelos lingüísticos que obtienen resultados estelares en la prueba MMLU pueden fabricar falsedades convincentes, como demostró un informe jurídico generado por IA que citaba jurisprudencia inexistente. Estas "alucinaciones" ponen de manifiesto que las pruebas que evalúan el recuerdo de hechos a menudo pasan por alto la veracidad y la adecuación contextual.

Retos de los parámetros estáticos en contextos dinámicos

Adaptación a entornos cambiantes

Las condiciones de referencia controladas no reflejan bien la imprevisibilidad del mundo real. La IA conversacional que destaca en las consultas de un solo turno puede fallar al manejar diálogos multihilo con jerga o errores tipográficos. Los vehículos autónomos que funcionan a la perfección en condiciones ideales pueden tener problemas con señales oscuras o condiciones meteorológicas adversas. Estas limitaciones ponen de manifiesto que las pruebas estáticas no reflejan la complejidad operativa.

Consideraciones éticas y sociales

Los puntos de referencia estándar rara vez evalúan la equidad del modelo o los daños potenciales. Un sistema de reconocimiento facial puede alcanzar una precisión sin precedentes y, al mismo tiempo, identificar erróneamente a ciertos grupos demográficos debido a datos de entrenamiento sesgados. Del mismo modo, los modelos lingüísticos pueden producir contenidos tóxicos o discriminatorios a pesar de sus excelentes puntuaciones de fluidez.

Incapacidad para captar aspectos matizados

Aunque los puntos de referencia miden eficazmente el rendimiento superficial, a menudo pasan por alto capacidades cognitivas más profundas. Un modelo puede generar respuestas gramaticalmente perfectas pero objetivamente inexactas, o crear imágenes visualmente realistas con contenido perturbador. Estos fallos demuestran la distinción crítica entre competencia técnica y utilidad práctica.

Adaptación contextual y razonamiento

Las pruebas comparativas suelen utilizar datos parecidos a los conjuntos de entrenamiento, lo que proporciona una visión limitada de la capacidad de un modelo para manejar situaciones novedosas. La verdadera prueba llega cuando los sistemas se encuentran con entradas inesperadas o deben aplicar un razonamiento lógico más allá del reconocimiento de patrones. Los métodos de evaluación actuales no suelen evaluar estas habilidades cognitivas de orden superior.

Más allá de los puntos de referencia: Un nuevo enfoque de la evaluación de la IA

Los nuevos paradigmas de evaluación pretenden salvar la distancia entre el rendimiento en laboratorio y la eficacia en el mundo real:

- Evaluación Human-in-the-Loop: La incorporación de evaluaciones de expertos y usuarios finales sobre la calidad, adecuación y utilidad de los resultados.

- Pruebas de implantación en el mundo real: Validación de modelos en entornos auténticos y no controlados que reflejan casos de uso reales.

- Pruebas de solidez y estrés: Desafiar a los sistemas con condiciones adversas y casos límite para evaluar su resistencia.

- Métricas multidimensionales: Combinación de medidas de rendimiento tradicionales con evaluaciones de equidad, seguridad y consideraciones éticas.

- Validación específica del dominio: Adaptación de los marcos de evaluación a requisitos industriales y contextos operativos concretos.

El camino a seguir

Aunque los puntos de referencia han impulsado un notable progreso de la IA, este campo debe evolucionar más allá de la búsqueda de líderes. La verdadera innovación requiere marcos de evaluación que den prioridad a lo siguiente

- Normas de rendimiento centradas en el ser humano

- La validez del despliegue en el mundo real

- consideraciones éticas y de seguridad

- Adaptabilidad a situaciones nuevas

- Evaluación holística de las capacidades

La próxima frontera del desarrollo de la IA exige métodos de evaluación tan sofisticados como la propia tecnología: métodos que midan no sólo las proezas técnicas, sino la verdadera utilidad, fiabilidad y responsabilidad en entornos complejos del mundo real.

Artículo relacionado

Marvel retrasa las dos próximas películas de Los Vengadores y ajusta el calendario de estrenos de la Fase 6

Marvel Studios ha anunciado importantes cambios en el calendario de sus próximas entregas de la franquicia Vengadores. La publicación de la industria The Hollywood Reporter revela que Avengers: Doomsd

Marvel retrasa las dos próximas películas de Los Vengadores y ajusta el calendario de estrenos de la Fase 6

Marvel Studios ha anunciado importantes cambios en el calendario de sus próximas entregas de la franquicia Vengadores. La publicación de la industria The Hollywood Reporter revela que Avengers: Doomsd

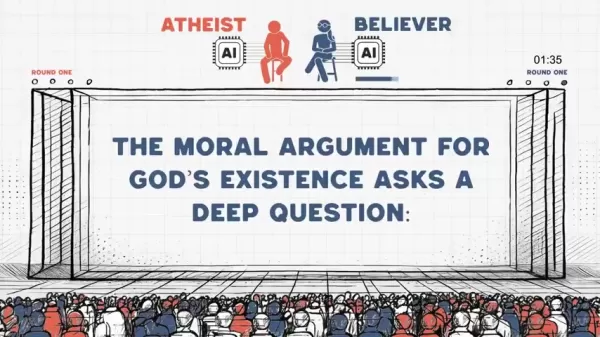

Ateos y creyentes en la IA se enfrentan en un acalorado debate sobre argumentos morales

Cuando sistemas de inteligencia artificial con marcos filosóficos diametralmente opuestos entablan un debate ético, ¿qué ideas surgen? Este innovador experimento escenifica un enfrentamiento intelectu

Ateos y creyentes en la IA se enfrentan en un acalorado debate sobre argumentos morales

Cuando sistemas de inteligencia artificial con marcos filosóficos diametralmente opuestos entablan un debate ético, ¿qué ideas surgen? Este innovador experimento escenifica un enfrentamiento intelectu

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

comentario (0)

0/200

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

comentario (0)

0/200

Si ha estado siguiendo los avances de la IA, sin duda se habrá encontrado con titulares que anuncian resultados de referencia que baten récords. Desde tareas de visión por ordenador hasta diagnósticos médicos, estas pruebas estandarizadas han servido durante mucho tiempo como medida definitiva de las capacidades de la IA. Sin embargo, estas impresionantes puntuaciones a menudo ocultan limitaciones críticas: un modelo que supera las pruebas de rendimiento controladas puede tener grandes dificultades cuando se utiliza en casos reales. En este análisis, examinaremos por qué los puntos de referencia convencionales no consiguen evaluar la verdadera eficacia de la IA y exploraremos marcos de evaluación que tengan más en cuenta la complejidad del mundo real, la ética y la utilidad práctica.

El atractivo de los puntos de referencia

Durante décadas, los puntos de referencia de la IA han proporcionado campos de pruebas estandarizados cruciales. Conjuntos de datos como ImageNet para el reconocimiento visual o BLEU para la calidad de la traducción ofrecen entornos controlados para medir capacidades específicas. Estas competiciones estructuradas han acelerado el progreso al permitir comparaciones directas del rendimiento y fomentar una sana competencia científica. El reto ImageNet catalizó la revolución del aprendizaje profundo al demostrar mejoras de precisión sin precedentes en la visión por ordenador.

Sin embargo, estas evaluaciones estáticas a menudo presentan una realidad demasiado simplificada. Los modelos optimizados para el rendimiento de referencia a menudo explotan la idiosincrasia del conjunto de datos en lugar de desarrollar una comprensión genuina. Un ejemplo elocuente surgió cuando un modelo de clasificación de animales entrenado para distinguir lobos de huskies aprendió a basarse en fondos nevados (habituales en las imágenes de entrenamiento de lobos) en lugar de en características anatómicas reales. Este fenómeno ilustra la Ley de Goodhart en acción: cuando los puntos de referencia se convierten en objetivos, a menudo dejan de ser medidas eficaces.

Expectativas humanas frente a puntuaciones métricas

La desconexión fundamental entre las métricas de referencia y las necesidades humanas se hace especialmente evidente en las aplicaciones lingüísticas. Aunque las puntuaciones BLEU cuantifican la calidad de la traducción mediante el solapamiento de palabras con los textos de referencia, no evalúan la precisión semántica ni la naturalidad lingüística. Del mismo modo, los modelos de resumen de textos pueden obtener puntuaciones ROUGE elevadas y pasar por alto puntos clave o producir resultados incoherentes que frustrarían a los lectores humanos.

La IA generativa introduce complicaciones adicionales. Los grandes modelos lingüísticos que obtienen resultados estelares en la prueba MMLU pueden fabricar falsedades convincentes, como demostró un informe jurídico generado por IA que citaba jurisprudencia inexistente. Estas "alucinaciones" ponen de manifiesto que las pruebas que evalúan el recuerdo de hechos a menudo pasan por alto la veracidad y la adecuación contextual.

Retos de los parámetros estáticos en contextos dinámicos

Adaptación a entornos cambiantes

Las condiciones de referencia controladas no reflejan bien la imprevisibilidad del mundo real. La IA conversacional que destaca en las consultas de un solo turno puede fallar al manejar diálogos multihilo con jerga o errores tipográficos. Los vehículos autónomos que funcionan a la perfección en condiciones ideales pueden tener problemas con señales oscuras o condiciones meteorológicas adversas. Estas limitaciones ponen de manifiesto que las pruebas estáticas no reflejan la complejidad operativa.

Consideraciones éticas y sociales

Los puntos de referencia estándar rara vez evalúan la equidad del modelo o los daños potenciales. Un sistema de reconocimiento facial puede alcanzar una precisión sin precedentes y, al mismo tiempo, identificar erróneamente a ciertos grupos demográficos debido a datos de entrenamiento sesgados. Del mismo modo, los modelos lingüísticos pueden producir contenidos tóxicos o discriminatorios a pesar de sus excelentes puntuaciones de fluidez.

Incapacidad para captar aspectos matizados

Aunque los puntos de referencia miden eficazmente el rendimiento superficial, a menudo pasan por alto capacidades cognitivas más profundas. Un modelo puede generar respuestas gramaticalmente perfectas pero objetivamente inexactas, o crear imágenes visualmente realistas con contenido perturbador. Estos fallos demuestran la distinción crítica entre competencia técnica y utilidad práctica.

Adaptación contextual y razonamiento

Las pruebas comparativas suelen utilizar datos parecidos a los conjuntos de entrenamiento, lo que proporciona una visión limitada de la capacidad de un modelo para manejar situaciones novedosas. La verdadera prueba llega cuando los sistemas se encuentran con entradas inesperadas o deben aplicar un razonamiento lógico más allá del reconocimiento de patrones. Los métodos de evaluación actuales no suelen evaluar estas habilidades cognitivas de orden superior.

Más allá de los puntos de referencia: Un nuevo enfoque de la evaluación de la IA

Los nuevos paradigmas de evaluación pretenden salvar la distancia entre el rendimiento en laboratorio y la eficacia en el mundo real:

- Evaluación Human-in-the-Loop: La incorporación de evaluaciones de expertos y usuarios finales sobre la calidad, adecuación y utilidad de los resultados.

- Pruebas de implantación en el mundo real: Validación de modelos en entornos auténticos y no controlados que reflejan casos de uso reales.

- Pruebas de solidez y estrés: Desafiar a los sistemas con condiciones adversas y casos límite para evaluar su resistencia.

- Métricas multidimensionales: Combinación de medidas de rendimiento tradicionales con evaluaciones de equidad, seguridad y consideraciones éticas.

- Validación específica del dominio: Adaptación de los marcos de evaluación a requisitos industriales y contextos operativos concretos.

El camino a seguir

Aunque los puntos de referencia han impulsado un notable progreso de la IA, este campo debe evolucionar más allá de la búsqueda de líderes. La verdadera innovación requiere marcos de evaluación que den prioridad a lo siguiente

- Normas de rendimiento centradas en el ser humano

- La validez del despliegue en el mundo real

- consideraciones éticas y de seguridad

- Adaptabilidad a situaciones nuevas

- Evaluación holística de las capacidades

La próxima frontera del desarrollo de la IA exige métodos de evaluación tan sofisticados como la propia tecnología: métodos que midan no sólo las proezas técnicas, sino la verdadera utilidad, fiabilidad y responsabilidad en entornos complejos del mundo real.

Marvel retrasa las dos próximas películas de Los Vengadores y ajusta el calendario de estrenos de la Fase 6

Marvel Studios ha anunciado importantes cambios en el calendario de sus próximas entregas de la franquicia Vengadores. La publicación de la industria The Hollywood Reporter revela que Avengers: Doomsd

Marvel retrasa las dos próximas películas de Los Vengadores y ajusta el calendario de estrenos de la Fase 6

Marvel Studios ha anunciado importantes cambios en el calendario de sus próximas entregas de la franquicia Vengadores. La publicación de la industria The Hollywood Reporter revela que Avengers: Doomsd

Ateos y creyentes en la IA se enfrentan en un acalorado debate sobre argumentos morales

Cuando sistemas de inteligencia artificial con marcos filosóficos diametralmente opuestos entablan un debate ético, ¿qué ideas surgen? Este innovador experimento escenifica un enfrentamiento intelectu

Ateos y creyentes en la IA se enfrentan en un acalorado debate sobre argumentos morales

Cuando sistemas de inteligencia artificial con marcos filosóficos diametralmente opuestos entablan un debate ético, ¿qué ideas surgen? Este innovador experimento escenifica un enfrentamiento intelectu

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion

OpenAI actualiza ChatGPT Pro a o3, aumentando el valor de la suscripción mensual de 200 dólares

Esta semana hemos sido testigos de importantes avances en IA por parte de gigantes tecnológicos como Microsoft, Google y Anthropic. OpenAI concluye el aluvión de anuncios con sus propias actualizacion