Nvidia dominiert KI -Benchmarks, aber Intel bietet einen bedeutenden Wettbewerb

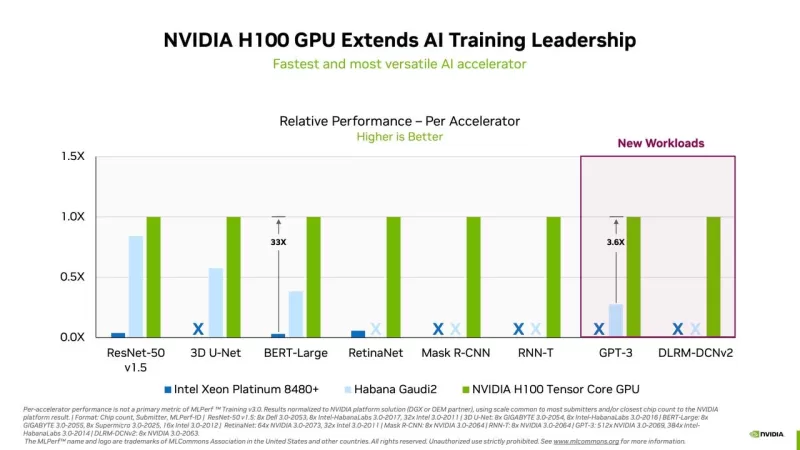

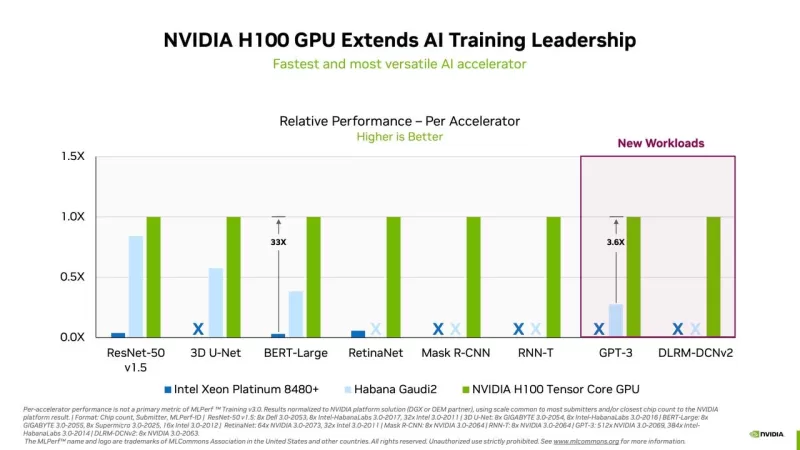

Die neueste Runde der Benchmarks für die Trainingsgeschwindigkeit neuronaler Netze, die am Dienstag vom Industriekonsortium MLCommons veröffentlicht wurde, krönte Nvidia erneut zum Spitzenreiter in allen Kategorien der MLPerf-Tests. Da wichtige Konkurrenten wie Google, Graphcore und Advanced Micro Devices in dieser Runde nicht teilnahmen, war Nvidias Sieg vollständig und unangefochten.

Intel's Habana-Division zeigte jedoch mit ihrem Gaudi2-Chip eine beachtliche Leistung und signalisierte damit einen Wettbewerbsvorteil. Intel hat kühn versprochen, Nvidias Flaggschiff-GPU H100 bis diesen Herbst zu übertreffen.

Der MLPerf Training Version 3.0 Benchmark konzentriert sich auf die Zeit, die benötigt wird, um die "Gewichte" oder Parameter eines neuronalen Netzwerks anzupassen, um ein festgelegtes Genauigkeitsniveau für eine bestimmte Aufgabe zu erreichen, ein Prozess, der als "Training" bekannt ist. Diese Version des Tests umfasst acht verschiedene Aufgaben und misst die Dauer, die benötigt wird, um ein neuronales Netzwerk durch mehrere Experimente zu verfeinern. Dies ist ein Aspekt der Leistung neuronaler Netze, der andere ist die "Inferenz", bei der das trainierte Netzwerk Vorhersagen zu neuen Daten trifft. Die Inferenzleistung wird von MLCommons separat bewertet.

Zusätzlich zum serverbasierten Training führte MLCommons den MLPerf Tiny Version 1.1 Benchmark ein, der die Leistung auf extrem stromsparenden Geräten für Vorhersagen bewertet.

Nvidia führte in allen acht Tests die Spitze an und erzielte die schnellsten Trainingszeiten. Zwei neue Aufgaben wurden eingeführt, darunter eine für das große Sprachmodell GPT-3 von OpenAI (LLM). Die Begeisterung für generative KI, ausgelöst durch die Popularität von ChatGPT, hat dies zu einem Schwerpunkt gemacht. Nvidia, in Zusammenarbeit mit CoreWeave, übernahm die Führung in der GPT-3-Aufgabe und nutzte ein System mit 896 Intel Xeon-Prozessoren und 3.584 Nvidia H100-GPUs. Dieses Setup, das auf Nvidias NeMO-Framework läuft, schaffte es, mit dem Colossal Cleaned Common Crawl-Datensatz in knapp unter elf Minuten zu trainieren. Der Test verwendete eine "große" Version von GPT-3 mit 175 Milliarden Parametern, die auf 0,4 % des vollständigen Trainingssets beschränkt war, um die Laufzeit handhabbar zu halten.

Eine weitere Neuheit war eine erweiterte Version des Tests für Empfehlungsmaschinen, die nun einen größeren, vier Terabyte großen Datensatz namens Criteo 4TB multi-hot verwendet, der den veralteten Ein-Terabyte-Datensatz ersetzt. MLCommons bemerkte die zunehmende Skalierung von Produktionsempfehlungsmodellen in Bezug auf Größe, Rechenleistung und Speicheroperationen.

Der einzige andere Mitbewerber im Bereich der KI-Chips war Intels Habana, die fünf Einreichungen mit ihrem Gaudi2-Beschleuniger und eine von SuperMicro mit demselben Chip einreichte. Diese Einreichungen deckten vier der acht Aufgaben ab, blieben jedoch deutlich hinter Nvidias besten Systemen zurück. Zum Beispiel belegte Habana im BERT Wikipedia-Test den fünften Platz und benötigte zwei Minuten im Vergleich zu Nvidia-CoreWeaves acht Sekunden mit einem 3.072-GPU-Setup.

Dennoch betonte Jordan Plawner, Leiter der KI-Produkte bei Intel, in einem ZDNET-Interview, dass der Leistungsunterschied zwischen Habana und Nvidia für viele Unternehmen bei Systemen ähnlicher Größe möglicherweise nicht entscheidend ist. Er wies darauf hin, dass ein 8-Geräte-Habana-System mit zwei Intel Xeon-Prozessoren die BERT Wikipedia-Aufgabe in etwas über 14 Minuten abschloss und zahlreiche Einreichungen mit mehr Nvidia A100-GPUs übertraf.

Plawner betonte die Kosteneffizienz von Gaudi2, das preislich mit Nvidias A100 vergleichbar ist, aber ein besseres Preis-Leistungs-Verhältnis beim Training bietet. Er erwähnte auch, dass Nvidia in ihren Einreichungen ein FP-8-Datenformat verwendete, während Habana ein BF-16-Format nutzte, das trotz seiner höheren Präzision das Training etwas verlangsamt. Plawner erwartet, dass ein Wechsel zu FP-8 später in diesem Jahr die Leistung von Gaudi2 steigern wird, möglicherweise über die von Nvidias H100 hinaus.

Er betonte die Notwendigkeit einer Alternative zu Nvidia, insbesondere angesichts der aktuellen Lieferengpässe bei Nvidias GPUs. Kunden, die von Verzögerungen frustriert sind, zeigen zunehmend Offenheit für Alternativen wie Gaudi2, die es ihnen ermöglichen könnten, Dienste ohne Wartezeit auf Nvidias Teile zu starten.

Intels Position als zweitgrößter Chiphersteller der Welt nach Taiwan Semiconductor verschafft ihm einen strategischen Vorteil bei der Kontrolle seiner Lieferkette. Plawner deutete Pläne von Intel an, einen Cluster mit mehreren tausend Gaudi2-Einheiten zu bauen, was auf einen potenziell starken Konkurrenten in zukünftigen MLPerf-Tests hindeutet.

Dies ist das zweite aufeinanderfolgende Quartal, in dem kein anderer Chiphersteller Nvidias Spitzenposition in den Trainingstests herausgefordert hat. Vor einem Jahr teilte sich Google den Spitzenplatz mit Nvidia mit seiner TPU, aber sowohl Google als auch Graphcore waren in der neuesten Runde abwesend und konzentrierten sich auf ihre Geschäfte statt auf Benchmark-Wettbewerbe.

MLCommons-Direktor David Kanter äußerte den Wunsch nach mehr Teilnehmern und stellte fest, dass eine breitere Beteiligung der Branche zugutekommt. Google und AMD reagierten nicht auf Anfragen zu ihrer Abwesenheit in dieser Runde. Interessanterweise wurden AMDs CPUs in konkurrierenden Systemen verwendet, während alle siegreichen Nvidia-Setups Intel Xeon-CPUs nutzten, was einen Wandel gegenüber der Vorjahresdominanz von AMDs EPYC-Prozessoren mit der Veröffentlichung von Intels Sapphire Rapids signalisiert.

Trotz der fehlenden Teilnahme einiger großer Namen ziehen die MLPerf-Tests weiterhin neue Teilnehmer an, darunter CoreWeave, IEI und Quanta Cloud Technology, was das anhaltende Interesse und den Wettbewerb im Bereich der Leistung von KI-Chips zeigt.

Verwandter Artikel

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

Kommentare (11)

0/200

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

Kommentare (11)

0/200

![HarrySmith]() HarrySmith

HarrySmith

11. August 2025 19:01:02 MESZ

11. August 2025 19:01:02 MESZ

Intel stepping up to Nvidia's AI game is wild! 🤯 It's like the underdog finally landing some solid punches. Curious to see how this shakes up the market!

0

0

![HenryJackson]() HenryJackson

HenryJackson

22. April 2025 23:42:49 MESZ

22. April 2025 23:42:49 MESZ

NvidiaのAIベンチマークでの支配力は印象的ですが、Intelの競争が物事を面白くしています。私はプロジェクトにNvidiaのツールを使っていますが、速いです。しかし、Intelの提供するものにも興味があります。もっと詳細な比較があればいいのにと思います。同じように感じる人はいますか?🤔

0

0

![BruceSmith]() BruceSmith

BruceSmith

22. April 2025 21:22:27 MESZ

22. April 2025 21:22:27 MESZ

El dominio de Nvidia en los benchmarks de IA es impresionante, pero la competencia de Intel mantiene las cosas emocionantes. He estado usando las herramientas de Nvidia para mis proyectos, y son rápidas, pero las ofertas de Intel son intrigantes. Ojalá hubiera más comparaciones detalladas, sin embargo. ¿Alguien más siente lo mismo? 🤔

0

0

![AlbertDavis]() AlbertDavis

AlbertDavis

22. April 2025 13:57:41 MESZ

22. April 2025 13:57:41 MESZ

Nvidia's dominance in AI benchmarks is impressive, but Intel's competition keeps things interesting! I've been using Nvidia's tech for my projects, and it's super fast. Intel's not far behind though, which is great for us users. Keep pushing the limits, guys! 🚀

0

0

![ThomasYoung]() ThomasYoung

ThomasYoung

21. April 2025 23:17:21 MESZ

21. April 2025 23:17:21 MESZ

A dominância da Nvidia nos benchmarks de IA é impressionante, mas a competição da Intel está mantendo as coisas emocionantes. Estou usando as ferramentas da Nvidia para meus projetos, e elas são rápidas, mas as ofertas da Intel são intrigantes. Gostaria que houvesse comparações mais detalhadas, no entanto. Alguém mais sente o mesmo? 🤔

0

0

![WillieJackson]() WillieJackson

WillieJackson

21. April 2025 18:23:42 MESZ

21. April 2025 18:23:42 MESZ

La dominancia de Nvidia en los benchmarks de IA es impresionante, pero la competencia de Intel mantiene las cosas interesantes. He estado usando la tecnología de Nvidia para mis proyectos y es súper rápida. Intel no se queda atrás, lo cual es genial para nosotros los usuarios. ¡Sigan empujando los límites, chicos! 🚀

0

0

Die neueste Runde der Benchmarks für die Trainingsgeschwindigkeit neuronaler Netze, die am Dienstag vom Industriekonsortium MLCommons veröffentlicht wurde, krönte Nvidia erneut zum Spitzenreiter in allen Kategorien der MLPerf-Tests. Da wichtige Konkurrenten wie Google, Graphcore und Advanced Micro Devices in dieser Runde nicht teilnahmen, war Nvidias Sieg vollständig und unangefochten.

Intel's Habana-Division zeigte jedoch mit ihrem Gaudi2-Chip eine beachtliche Leistung und signalisierte damit einen Wettbewerbsvorteil. Intel hat kühn versprochen, Nvidias Flaggschiff-GPU H100 bis diesen Herbst zu übertreffen.

Der MLPerf Training Version 3.0 Benchmark konzentriert sich auf die Zeit, die benötigt wird, um die "Gewichte" oder Parameter eines neuronalen Netzwerks anzupassen, um ein festgelegtes Genauigkeitsniveau für eine bestimmte Aufgabe zu erreichen, ein Prozess, der als "Training" bekannt ist. Diese Version des Tests umfasst acht verschiedene Aufgaben und misst die Dauer, die benötigt wird, um ein neuronales Netzwerk durch mehrere Experimente zu verfeinern. Dies ist ein Aspekt der Leistung neuronaler Netze, der andere ist die "Inferenz", bei der das trainierte Netzwerk Vorhersagen zu neuen Daten trifft. Die Inferenzleistung wird von MLCommons separat bewertet.

Zusätzlich zum serverbasierten Training führte MLCommons den MLPerf Tiny Version 1.1 Benchmark ein, der die Leistung auf extrem stromsparenden Geräten für Vorhersagen bewertet.

Nvidia führte in allen acht Tests die Spitze an und erzielte die schnellsten Trainingszeiten. Zwei neue Aufgaben wurden eingeführt, darunter eine für das große Sprachmodell GPT-3 von OpenAI (LLM). Die Begeisterung für generative KI, ausgelöst durch die Popularität von ChatGPT, hat dies zu einem Schwerpunkt gemacht. Nvidia, in Zusammenarbeit mit CoreWeave, übernahm die Führung in der GPT-3-Aufgabe und nutzte ein System mit 896 Intel Xeon-Prozessoren und 3.584 Nvidia H100-GPUs. Dieses Setup, das auf Nvidias NeMO-Framework läuft, schaffte es, mit dem Colossal Cleaned Common Crawl-Datensatz in knapp unter elf Minuten zu trainieren. Der Test verwendete eine "große" Version von GPT-3 mit 175 Milliarden Parametern, die auf 0,4 % des vollständigen Trainingssets beschränkt war, um die Laufzeit handhabbar zu halten.

Eine weitere Neuheit war eine erweiterte Version des Tests für Empfehlungsmaschinen, die nun einen größeren, vier Terabyte großen Datensatz namens Criteo 4TB multi-hot verwendet, der den veralteten Ein-Terabyte-Datensatz ersetzt. MLCommons bemerkte die zunehmende Skalierung von Produktionsempfehlungsmodellen in Bezug auf Größe, Rechenleistung und Speicheroperationen.

Der einzige andere Mitbewerber im Bereich der KI-Chips war Intels Habana, die fünf Einreichungen mit ihrem Gaudi2-Beschleuniger und eine von SuperMicro mit demselben Chip einreichte. Diese Einreichungen deckten vier der acht Aufgaben ab, blieben jedoch deutlich hinter Nvidias besten Systemen zurück. Zum Beispiel belegte Habana im BERT Wikipedia-Test den fünften Platz und benötigte zwei Minuten im Vergleich zu Nvidia-CoreWeaves acht Sekunden mit einem 3.072-GPU-Setup.

Dennoch betonte Jordan Plawner, Leiter der KI-Produkte bei Intel, in einem ZDNET-Interview, dass der Leistungsunterschied zwischen Habana und Nvidia für viele Unternehmen bei Systemen ähnlicher Größe möglicherweise nicht entscheidend ist. Er wies darauf hin, dass ein 8-Geräte-Habana-System mit zwei Intel Xeon-Prozessoren die BERT Wikipedia-Aufgabe in etwas über 14 Minuten abschloss und zahlreiche Einreichungen mit mehr Nvidia A100-GPUs übertraf.

Plawner betonte die Kosteneffizienz von Gaudi2, das preislich mit Nvidias A100 vergleichbar ist, aber ein besseres Preis-Leistungs-Verhältnis beim Training bietet. Er erwähnte auch, dass Nvidia in ihren Einreichungen ein FP-8-Datenformat verwendete, während Habana ein BF-16-Format nutzte, das trotz seiner höheren Präzision das Training etwas verlangsamt. Plawner erwartet, dass ein Wechsel zu FP-8 später in diesem Jahr die Leistung von Gaudi2 steigern wird, möglicherweise über die von Nvidias H100 hinaus.

Er betonte die Notwendigkeit einer Alternative zu Nvidia, insbesondere angesichts der aktuellen Lieferengpässe bei Nvidias GPUs. Kunden, die von Verzögerungen frustriert sind, zeigen zunehmend Offenheit für Alternativen wie Gaudi2, die es ihnen ermöglichen könnten, Dienste ohne Wartezeit auf Nvidias Teile zu starten.

Intels Position als zweitgrößter Chiphersteller der Welt nach Taiwan Semiconductor verschafft ihm einen strategischen Vorteil bei der Kontrolle seiner Lieferkette. Plawner deutete Pläne von Intel an, einen Cluster mit mehreren tausend Gaudi2-Einheiten zu bauen, was auf einen potenziell starken Konkurrenten in zukünftigen MLPerf-Tests hindeutet.

Dies ist das zweite aufeinanderfolgende Quartal, in dem kein anderer Chiphersteller Nvidias Spitzenposition in den Trainingstests herausgefordert hat. Vor einem Jahr teilte sich Google den Spitzenplatz mit Nvidia mit seiner TPU, aber sowohl Google als auch Graphcore waren in der neuesten Runde abwesend und konzentrierten sich auf ihre Geschäfte statt auf Benchmark-Wettbewerbe.

MLCommons-Direktor David Kanter äußerte den Wunsch nach mehr Teilnehmern und stellte fest, dass eine breitere Beteiligung der Branche zugutekommt. Google und AMD reagierten nicht auf Anfragen zu ihrer Abwesenheit in dieser Runde. Interessanterweise wurden AMDs CPUs in konkurrierenden Systemen verwendet, während alle siegreichen Nvidia-Setups Intel Xeon-CPUs nutzten, was einen Wandel gegenüber der Vorjahresdominanz von AMDs EPYC-Prozessoren mit der Veröffentlichung von Intels Sapphire Rapids signalisiert.

Trotz der fehlenden Teilnahme einiger großer Namen ziehen die MLPerf-Tests weiterhin neue Teilnehmer an, darunter CoreWeave, IEI und Quanta Cloud Technology, was das anhaltende Interesse und den Wettbewerb im Bereich der Leistung von KI-Chips zeigt.

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

USA verhängen Sanktionen gegen ausländische Beamte wegen Social-Media-Vorschriften

USA stellen sich gegen globale Regelungen für digitale InhalteDas US-Außenministerium hat diese Woche eine scharfe diplomatische Rüge gegen die europäische Politik zur Kontrolle digitaler Inhalte au

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Ultimativer Leitfaden für KI-gestützte YouTube-Videozusammenfassungen

In unserer informationsreichen digitalen Landschaft sind KI-gestützte YouTube-Videozusammenfassungen für den effizienten Konsum von Inhalten unverzichtbar geworden. Dieser ausführliche Leitfaden zeigt

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

Atlassian erwirbt The Browser Company für 610 Millionen Dollar, um Entwickler-Tools zu verbessern

Atlassian, der führende Anbieter von Unternehmensproduktivitätssoftware, hat Pläne zur Übernahme des innovativen Browser-Entwicklers The Browser Company im Rahmen einer bar bezahlten Transaktion im We

11. August 2025 19:01:02 MESZ

11. August 2025 19:01:02 MESZ

Intel stepping up to Nvidia's AI game is wild! 🤯 It's like the underdog finally landing some solid punches. Curious to see how this shakes up the market!

0

0

22. April 2025 23:42:49 MESZ

22. April 2025 23:42:49 MESZ

NvidiaのAIベンチマークでの支配力は印象的ですが、Intelの競争が物事を面白くしています。私はプロジェクトにNvidiaのツールを使っていますが、速いです。しかし、Intelの提供するものにも興味があります。もっと詳細な比較があればいいのにと思います。同じように感じる人はいますか?🤔

0

0

22. April 2025 21:22:27 MESZ

22. April 2025 21:22:27 MESZ

El dominio de Nvidia en los benchmarks de IA es impresionante, pero la competencia de Intel mantiene las cosas emocionantes. He estado usando las herramientas de Nvidia para mis proyectos, y son rápidas, pero las ofertas de Intel son intrigantes. Ojalá hubiera más comparaciones detalladas, sin embargo. ¿Alguien más siente lo mismo? 🤔

0

0

22. April 2025 13:57:41 MESZ

22. April 2025 13:57:41 MESZ

Nvidia's dominance in AI benchmarks is impressive, but Intel's competition keeps things interesting! I've been using Nvidia's tech for my projects, and it's super fast. Intel's not far behind though, which is great for us users. Keep pushing the limits, guys! 🚀

0

0

21. April 2025 23:17:21 MESZ

21. April 2025 23:17:21 MESZ

A dominância da Nvidia nos benchmarks de IA é impressionante, mas a competição da Intel está mantendo as coisas emocionantes. Estou usando as ferramentas da Nvidia para meus projetos, e elas são rápidas, mas as ofertas da Intel são intrigantes. Gostaria que houvesse comparações mais detalhadas, no entanto. Alguém mais sente o mesmo? 🤔

0

0

21. April 2025 18:23:42 MESZ

21. April 2025 18:23:42 MESZ

La dominancia de Nvidia en los benchmarks de IA es impresionante, pero la competencia de Intel mantiene las cosas interesantes. He estado usando la tecnología de Nvidia para mis proyectos y es súper rápida. Intel no se queda atrás, lo cual es genial para nosotros los usuarios. ¡Sigan empujando los límites, chicos! 🚀

0

0