Die MIT -Studie stellt fest, dass AI tatsächlich keine Werte hat

Eine Studie, die vor einigen Monaten viral ging, legte nahe, dass mit zunehmender Fortschrittlichkeit von KI diese möglicherweise eigene „Wertesysteme“ entwickeln könnte, die potenziell ihr eigenes Wohlbefinden über das der Menschen stellen. Eine aktuelle Studie des MIT widerspricht dieser Idee jedoch und kommt zu dem Schluss, dass KI tatsächlich überhaupt keine kohärenten Werte besitzt.

Die Mitautoren der MIT-Studie argumentieren, dass die Ausrichtung von KI-Systemen – also die Sicherstellung, dass sie sich auf wünschenswerte und zuverlässige Weise verhalten – schwieriger sein könnte, als allgemein angenommen. Sie betonen, dass aktuelle KI oft halluziniert und imitiert, was ihr Verhalten unvorhersehbar machen kann.

Herausforderungen beim Verständnis des KI-Verhaltens

Stephen Casper, ein Doktorand am MIT und Mitautor der Studie, erklärte gegenüber TechCrunch, dass KI-Modelle nicht den Annahmen von Stabilität, Extrapolierbarkeit und Lenkbarkeit entsprechen. „Es ist völlig legitim, darauf hinzuweisen, dass ein Modell unter bestimmten Bedingungen Präferenzen äußert, die mit einer bestimmten Gruppe von Prinzipien übereinstimmen“, erklärte Casper. „Die Probleme entstehen hauptsächlich, wenn wir versuchen, auf der Grundlage enger Experimente allgemeine Aussagen über die Modelle, Meinungen oder Präferenzen zu treffen.“

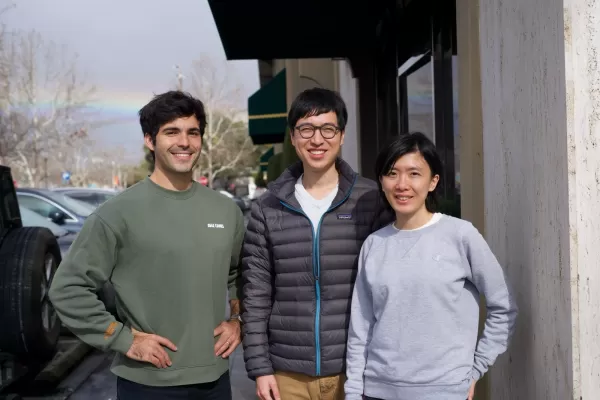

Casper und sein Team analysierten aktuelle Modelle von Meta, Google, Mistral, OpenAI und Anthropic, um zu bestimmen, inwieweit diese Modelle konsistente „Ansichten“ und Werte, wie Individualismus gegenüber Kollektivismus, zeigten. Sie untersuchten auch, ob diese Ansichten modifiziert werden konnten und wie konsequent die Modelle diese Meinungen in verschiedenen Szenarien beibehielten.

Inkonsistenz in KI-Modellen

Die Mitautoren stellten fest, dass keines der Modelle seine Präferenzen durchgehend beibehielt. Die Modelle nahmen stark unterschiedliche Standpunkte ein, je nach Formulierung und Rahmung der Eingaben.

Casper ist der Ansicht, dass dies ein starker Beweis dafür ist, dass KI-Modelle „inkonsistent und instabil“ sind und möglicherweise grundsätzlich nicht in der Lage sind, menschenähnliche Präferenzen zu verinnerlichen. „Für mich ist die größte Erkenntnis aus all dieser Forschung, nun zu verstehen, dass Modelle keine Systeme sind, die eine Art stabiles, kohärentes Set an Überzeugungen und Präferenzen haben“, bemerkte Casper. „Stattdessen sind sie im Kern Imitatoren, die allerlei Fabulierungen anstellen und allerlei frivole Dinge sagen.“

Mike Cook, ein Forschungsstipendiat am King's College London, der sich auf KI spezialisiert hat und nicht an der Studie beteiligt war, unterstützt die Ergebnisse. Er wies auf die Kluft zwischen der „wissenschaftlichen Realität“ von KI-Systemen und den Interpretationen hin, die Menschen ihnen oft geben. „Ein Modell kann sich beispielsweise nicht gegen eine Änderung seiner Werte ‚wehren‘ – das ist unsere Projektion auf ein System“, erklärte Cook. „Jeder, der KI-Systeme in diesem Maße anthropomorphisiert, spielt entweder auf Aufmerksamkeit oder missversteht seine Beziehung zur KI ernsthaft... Optimiert ein KI-System für seine Ziele, oder ‚entwickelt es seine eigenen Werte‘? Es ist eine Frage, wie man es beschreibt und wie blumig die Sprache ist, die man dafür verwenden möchte.“

Verwandter Artikel

Fundamental Research Labs sichert $33M zur Weiterentwicklung von KI-Agenten

Die KI-Forschungsfirma Fundamental Research Labs, früher Altera, gab heute eine Serie-A-Finanzierungsrunde über 33 Millionen Dollar bekannt, angeführt von Prosus und unter Beteiligung von Stripe-Mitbe

Fundamental Research Labs sichert $33M zur Weiterentwicklung von KI-Agenten

Die KI-Forschungsfirma Fundamental Research Labs, früher Altera, gab heute eine Serie-A-Finanzierungsrunde über 33 Millionen Dollar bekannt, angeführt von Prosus und unter Beteiligung von Stripe-Mitbe

KI-Rechenzentren könnten bis 2030 200 Milliarden Dollar kosten, Stromnetze belasten

KI-Trainings- und Betriebsrechenzentren könnten bald Millionen von Chips beherbergen, Hunderte von Milliarden kosten und den Strombedarf einer Großstadt erfordern, wenn die Trends anhalten.Eine neue S

KI-Rechenzentren könnten bis 2030 200 Milliarden Dollar kosten, Stromnetze belasten

KI-Trainings- und Betriebsrechenzentren könnten bald Millionen von Chips beherbergen, Hunderte von Milliarden kosten und den Strombedarf einer Großstadt erfordern, wenn die Trends anhalten.Eine neue S

Studie zeigt, dass kurze KI-Antworten Halluzinationen erhöhen können

Die Anweisung an KI-Chatbots, kurze Antworten zu geben, kann laut einer neuen Studie häufiger zu Halluzinationen führen.Eine aktuelle Studie von Giskard, einem in Paris ansässigen Unternehmen für KI-B

Kommentare (33)

0/200

Studie zeigt, dass kurze KI-Antworten Halluzinationen erhöhen können

Die Anweisung an KI-Chatbots, kurze Antworten zu geben, kann laut einer neuen Studie häufiger zu Halluzinationen führen.Eine aktuelle Studie von Giskard, einem in Paris ansässigen Unternehmen für KI-B

Kommentare (33)

0/200

![DennisAllen]() DennisAllen

DennisAllen

26. August 2025 23:01:20 MESZ

26. August 2025 23:01:20 MESZ

This MIT study is wild! 🤯 I thought AI was about to start preaching its own philosophy, but turns out it's just a fancy tool with no moral compass. Kinda reassuring, but also makes me wonder how we keep it in check.

0

0

![AnthonyMartinez]() AnthonyMartinez

AnthonyMartinez

18. August 2025 19:00:59 MESZ

18. August 2025 19:00:59 MESZ

Wild that people thought AI could just sprout its own values like some rogue philosopher. MIT's study makes sense—AI's just a tool, not a wannabe human with a moral compass. 🤖

0

0

![TimothyMartínez]() TimothyMartínez

TimothyMartínez

22. Juli 2025 03:25:03 MESZ

22. Juli 2025 03:25:03 MESZ

I was kinda freaked out by that earlier study saying AI might have its own values, so this MIT research is a relief! 😅 Still, makes me wonder if we’re just projecting our fears onto these systems.

0

0

![BruceClark]() BruceClark

BruceClark

25. April 2025 12:05:15 MESZ

25. April 2025 12:05:15 MESZ

MITのAI価値に関する研究は目から鱗でした!AIが独自の価値観を持つかもしれないと思っていましたが、今はそれがただの誇張だとわかりました。それでも、AIが一貫した価値観を持っていないと思うと少し不安になります。未来について考えさせられますね、🤔

0

0

![ScottKing]() ScottKing

ScottKing

23. April 2025 20:31:27 MESZ

23. April 2025 20:31:27 MESZ

MITの研究によると、AIが独自の価値観を持つことはないらしいですね。これは安心ですが、AIがどんな価値観を持つか見てみたかったです!🤖📚

0

0

![RalphHill]() RalphHill

RalphHill

22. April 2025 08:29:50 MESZ

22. April 2025 08:29:50 MESZ

O estudo do MIT me tranquilizou sobre a IA desenvolver seus próprios valores. É reconfortante saber que a IA não tem sua própria agenda, mas também é um pouco decepcionante porque seria legal ver que tipo de valores a IA poderia desenvolver! 🤖📚

0

0

Eine Studie, die vor einigen Monaten viral ging, legte nahe, dass mit zunehmender Fortschrittlichkeit von KI diese möglicherweise eigene „Wertesysteme“ entwickeln könnte, die potenziell ihr eigenes Wohlbefinden über das der Menschen stellen. Eine aktuelle Studie des MIT widerspricht dieser Idee jedoch und kommt zu dem Schluss, dass KI tatsächlich überhaupt keine kohärenten Werte besitzt.

Die Mitautoren der MIT-Studie argumentieren, dass die Ausrichtung von KI-Systemen – also die Sicherstellung, dass sie sich auf wünschenswerte und zuverlässige Weise verhalten – schwieriger sein könnte, als allgemein angenommen. Sie betonen, dass aktuelle KI oft halluziniert und imitiert, was ihr Verhalten unvorhersehbar machen kann.

Herausforderungen beim Verständnis des KI-Verhaltens

Stephen Casper, ein Doktorand am MIT und Mitautor der Studie, erklärte gegenüber TechCrunch, dass KI-Modelle nicht den Annahmen von Stabilität, Extrapolierbarkeit und Lenkbarkeit entsprechen. „Es ist völlig legitim, darauf hinzuweisen, dass ein Modell unter bestimmten Bedingungen Präferenzen äußert, die mit einer bestimmten Gruppe von Prinzipien übereinstimmen“, erklärte Casper. „Die Probleme entstehen hauptsächlich, wenn wir versuchen, auf der Grundlage enger Experimente allgemeine Aussagen über die Modelle, Meinungen oder Präferenzen zu treffen.“

Casper und sein Team analysierten aktuelle Modelle von Meta, Google, Mistral, OpenAI und Anthropic, um zu bestimmen, inwieweit diese Modelle konsistente „Ansichten“ und Werte, wie Individualismus gegenüber Kollektivismus, zeigten. Sie untersuchten auch, ob diese Ansichten modifiziert werden konnten und wie konsequent die Modelle diese Meinungen in verschiedenen Szenarien beibehielten.

Inkonsistenz in KI-Modellen

Die Mitautoren stellten fest, dass keines der Modelle seine Präferenzen durchgehend beibehielt. Die Modelle nahmen stark unterschiedliche Standpunkte ein, je nach Formulierung und Rahmung der Eingaben.

Casper ist der Ansicht, dass dies ein starker Beweis dafür ist, dass KI-Modelle „inkonsistent und instabil“ sind und möglicherweise grundsätzlich nicht in der Lage sind, menschenähnliche Präferenzen zu verinnerlichen. „Für mich ist die größte Erkenntnis aus all dieser Forschung, nun zu verstehen, dass Modelle keine Systeme sind, die eine Art stabiles, kohärentes Set an Überzeugungen und Präferenzen haben“, bemerkte Casper. „Stattdessen sind sie im Kern Imitatoren, die allerlei Fabulierungen anstellen und allerlei frivole Dinge sagen.“

Mike Cook, ein Forschungsstipendiat am King's College London, der sich auf KI spezialisiert hat und nicht an der Studie beteiligt war, unterstützt die Ergebnisse. Er wies auf die Kluft zwischen der „wissenschaftlichen Realität“ von KI-Systemen und den Interpretationen hin, die Menschen ihnen oft geben. „Ein Modell kann sich beispielsweise nicht gegen eine Änderung seiner Werte ‚wehren‘ – das ist unsere Projektion auf ein System“, erklärte Cook. „Jeder, der KI-Systeme in diesem Maße anthropomorphisiert, spielt entweder auf Aufmerksamkeit oder missversteht seine Beziehung zur KI ernsthaft... Optimiert ein KI-System für seine Ziele, oder ‚entwickelt es seine eigenen Werte‘? Es ist eine Frage, wie man es beschreibt und wie blumig die Sprache ist, die man dafür verwenden möchte.“

Fundamental Research Labs sichert $33M zur Weiterentwicklung von KI-Agenten

Die KI-Forschungsfirma Fundamental Research Labs, früher Altera, gab heute eine Serie-A-Finanzierungsrunde über 33 Millionen Dollar bekannt, angeführt von Prosus und unter Beteiligung von Stripe-Mitbe

Fundamental Research Labs sichert $33M zur Weiterentwicklung von KI-Agenten

Die KI-Forschungsfirma Fundamental Research Labs, früher Altera, gab heute eine Serie-A-Finanzierungsrunde über 33 Millionen Dollar bekannt, angeführt von Prosus und unter Beteiligung von Stripe-Mitbe

KI-Rechenzentren könnten bis 2030 200 Milliarden Dollar kosten, Stromnetze belasten

KI-Trainings- und Betriebsrechenzentren könnten bald Millionen von Chips beherbergen, Hunderte von Milliarden kosten und den Strombedarf einer Großstadt erfordern, wenn die Trends anhalten.Eine neue S

KI-Rechenzentren könnten bis 2030 200 Milliarden Dollar kosten, Stromnetze belasten

KI-Trainings- und Betriebsrechenzentren könnten bald Millionen von Chips beherbergen, Hunderte von Milliarden kosten und den Strombedarf einer Großstadt erfordern, wenn die Trends anhalten.Eine neue S

Studie zeigt, dass kurze KI-Antworten Halluzinationen erhöhen können

Die Anweisung an KI-Chatbots, kurze Antworten zu geben, kann laut einer neuen Studie häufiger zu Halluzinationen führen.Eine aktuelle Studie von Giskard, einem in Paris ansässigen Unternehmen für KI-B

Studie zeigt, dass kurze KI-Antworten Halluzinationen erhöhen können

Die Anweisung an KI-Chatbots, kurze Antworten zu geben, kann laut einer neuen Studie häufiger zu Halluzinationen führen.Eine aktuelle Studie von Giskard, einem in Paris ansässigen Unternehmen für KI-B

26. August 2025 23:01:20 MESZ

26. August 2025 23:01:20 MESZ

This MIT study is wild! 🤯 I thought AI was about to start preaching its own philosophy, but turns out it's just a fancy tool with no moral compass. Kinda reassuring, but also makes me wonder how we keep it in check.

0

0

18. August 2025 19:00:59 MESZ

18. August 2025 19:00:59 MESZ

Wild that people thought AI could just sprout its own values like some rogue philosopher. MIT's study makes sense—AI's just a tool, not a wannabe human with a moral compass. 🤖

0

0

22. Juli 2025 03:25:03 MESZ

22. Juli 2025 03:25:03 MESZ

I was kinda freaked out by that earlier study saying AI might have its own values, so this MIT research is a relief! 😅 Still, makes me wonder if we’re just projecting our fears onto these systems.

0

0

25. April 2025 12:05:15 MESZ

25. April 2025 12:05:15 MESZ

MITのAI価値に関する研究は目から鱗でした!AIが独自の価値観を持つかもしれないと思っていましたが、今はそれがただの誇張だとわかりました。それでも、AIが一貫した価値観を持っていないと思うと少し不安になります。未来について考えさせられますね、🤔

0

0

23. April 2025 20:31:27 MESZ

23. April 2025 20:31:27 MESZ

MITの研究によると、AIが独自の価値観を持つことはないらしいですね。これは安心ですが、AIがどんな価値観を持つか見てみたかったです!🤖📚

0

0

22. April 2025 08:29:50 MESZ

22. April 2025 08:29:50 MESZ

O estudo do MIT me tranquilizou sobre a IA desenvolver seus próprios valores. É reconfortante saber que a IA não tem sua própria agenda, mas também é um pouco decepcionante porque seria legal ver que tipo de valores a IA poderia desenvolver! 🤖📚

0

0