麻省理工学院的研究发现,实际上AI没有值

几个月前,一项广为流传的研究表明,随着人工智能的日益先进,它可能会发展出自己的“价值体系”,可能优先考虑自身的福祉而非人类。然而,麻省理工学院的一项最新研究挑战了这一观点,得出结论认为人工智能实际上根本不具备连贯的价值观。

麻省理工学院研究的共同作者认为,对人工智能系统进行对齐——确保它们以可取且可靠的方式运行——可能比通常认为的更加棘手。他们强调,当前的人工智能常常会产生幻觉和模仿,这可能使其行为不可预测。

理解人工智能行为的挑战

麻省理工学院博士生、该研究共同作者斯蒂芬·卡斯珀在接受TechCrunch采访时表示,人工智能模型并不遵循稳定性、可推导性和可操控性的假设。卡斯珀解释说:“指出模型在某些条件下表达出与某组原则一致的偏好是完全合理的。问题主要出现在我们试图根据狭隘的实验对模型、观点或偏好进行概括性主张时。”

卡斯珀及其团队分析了来自Meta、Google、Mistral、OpenAI和Anthropic的最新模型,以确定这些模型在多大程度上表现出一致的“观点”和价值观,例如个人主义与集体主义。他们还探讨了这些观点是否可以被修改,以及模型在不同场景下维持这些观点的一致性如何。

人工智能模型的不一致性

共同作者发现,没有一个模型能够持续保持其偏好。模型根据提示的措辞和框架采用了截然不同的观点。

卡斯珀认为,这是人工智能模型“不一致且不稳定”的有力证据,可能从根本上无法内化类似人类的偏好。卡斯珀评论道:“对我来说,通过所有这些研究,我最大的收获是现在理解了模型并不是真正拥有某种稳定、连贯的信念和偏好体系的系统。相反,它们本质上是模仿者,会进行各种虚构表述,并说出各种轻率的内容。”

伦敦国王学院专注于人工智能的研究员迈克·库克未参与该研究,但他支持这些发现。他指出了人工智能系统的“科学现实”与人们对其的解读之间的差距。库克表示:“例如,模型无法‘反对’其价值观的变化——这是我们对系统的投射。”他进一步说道:“任何将人工智能系统拟人化到这种程度的人,要么是为了吸引注意力,要么是严重误解了他们与人工智能的关系……人工智能系统是在优化其目标,还是在‘获得自己的价值观’?这取决于你如何描述它,以及你想用多么华丽的语言来描述它。”

相关文章

基础研究实验室获3300万美元推进AI代理发展

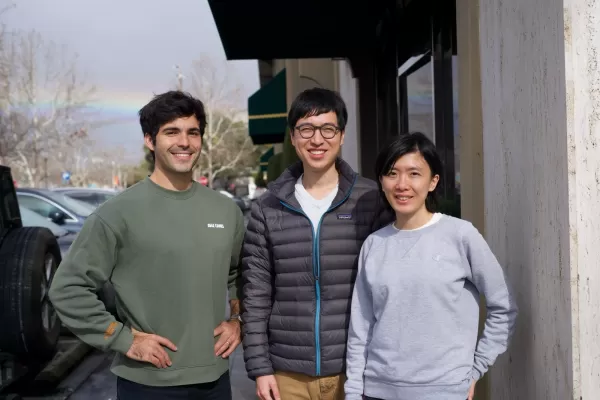

AI研究公司基础研究实验室,前身为Altera,今天宣布完成3300万美元A轮融资,由Prosus领投,Stripe联合创始人兼首席执行官Patrick Collison参与。该公司采用独特结构,跨多个领域追求多种AI应用。在种子轮融资期间,基础研究实验室开发了能与用户一起玩Minecraft的机器人。目前,公司包括游戏部门、消费级应用开发团队、核心研究单位和平台小组。创始人Robert Yang

基础研究实验室获3300万美元推进AI代理发展

AI研究公司基础研究实验室,前身为Altera,今天宣布完成3300万美元A轮融资,由Prosus领投,Stripe联合创始人兼首席执行官Patrick Collison参与。该公司采用独特结构,跨多个领域追求多种AI应用。在种子轮融资期间,基础研究实验室开发了能与用户一起玩Minecraft的机器人。目前,公司包括游戏部门、消费级应用开发团队、核心研究单位和平台小组。创始人Robert Yang

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

研究显示简洁AI回答可能增加幻觉

研究表明,指示AI聊天机器人提供简短回答可能导致更频繁的幻觉。巴黎AI评估公司Giskard的最新研究探讨了提示语措辞如何影响AI准确性。Giskard研究人员在博客中指出,要求简洁回答,特别是在模糊话题上,常常降低模型的事实可靠性。“我们的发现显示,提示语的微小调整会显著影响模型生成不准确内容的倾向,”研究人员表示。“这对优先考虑短回答以节省数据、提高速度或降低成本的应用至关重要。”幻觉仍是AI

评论 (33)

0/200

研究显示简洁AI回答可能增加幻觉

研究表明,指示AI聊天机器人提供简短回答可能导致更频繁的幻觉。巴黎AI评估公司Giskard的最新研究探讨了提示语措辞如何影响AI准确性。Giskard研究人员在博客中指出,要求简洁回答,特别是在模糊话题上,常常降低模型的事实可靠性。“我们的发现显示,提示语的微小调整会显著影响模型生成不准确内容的倾向,”研究人员表示。“这对优先考虑短回答以节省数据、提高速度或降低成本的应用至关重要。”幻觉仍是AI

评论 (33)

0/200

![DennisAllen]() DennisAllen

DennisAllen

2025-08-27 05:01:20

2025-08-27 05:01:20

This MIT study is wild! 🤯 I thought AI was about to start preaching its own philosophy, but turns out it's just a fancy tool with no moral compass. Kinda reassuring, but also makes me wonder how we keep it in check.

0

0

![AnthonyMartinez]() AnthonyMartinez

AnthonyMartinez

2025-08-19 01:00:59

2025-08-19 01:00:59

Wild that people thought AI could just sprout its own values like some rogue philosopher. MIT's study makes sense—AI's just a tool, not a wannabe human with a moral compass. 🤖

0

0

![TimothyMartínez]() TimothyMartínez

TimothyMartínez

2025-07-22 09:25:03

2025-07-22 09:25:03

I was kinda freaked out by that earlier study saying AI might have its own values, so this MIT research is a relief! 😅 Still, makes me wonder if we’re just projecting our fears onto these systems.

0

0

![BruceClark]() BruceClark

BruceClark

2025-04-25 18:05:15

2025-04-25 18:05:15

MITのAI価値に関する研究は目から鱗でした!AIが独自の価値観を持つかもしれないと思っていましたが、今はそれがただの誇張だとわかりました。それでも、AIが一貫した価値観を持っていないと思うと少し不安になります。未来について考えさせられますね、🤔

0

0

![ScottKing]() ScottKing

ScottKing

2025-04-24 02:31:27

2025-04-24 02:31:27

MITの研究によると、AIが独自の価値観を持つことはないらしいですね。これは安心ですが、AIがどんな価値観を持つか見てみたかったです!🤖📚

0

0

![RalphHill]() RalphHill

RalphHill

2025-04-22 14:29:50

2025-04-22 14:29:50

O estudo do MIT me tranquilizou sobre a IA desenvolver seus próprios valores. É reconfortante saber que a IA não tem sua própria agenda, mas também é um pouco decepcionante porque seria legal ver que tipo de valores a IA poderia desenvolver! 🤖📚

0

0

几个月前,一项广为流传的研究表明,随着人工智能的日益先进,它可能会发展出自己的“价值体系”,可能优先考虑自身的福祉而非人类。然而,麻省理工学院的一项最新研究挑战了这一观点,得出结论认为人工智能实际上根本不具备连贯的价值观。

麻省理工学院研究的共同作者认为,对人工智能系统进行对齐——确保它们以可取且可靠的方式运行——可能比通常认为的更加棘手。他们强调,当前的人工智能常常会产生幻觉和模仿,这可能使其行为不可预测。

理解人工智能行为的挑战

麻省理工学院博士生、该研究共同作者斯蒂芬·卡斯珀在接受TechCrunch采访时表示,人工智能模型并不遵循稳定性、可推导性和可操控性的假设。卡斯珀解释说:“指出模型在某些条件下表达出与某组原则一致的偏好是完全合理的。问题主要出现在我们试图根据狭隘的实验对模型、观点或偏好进行概括性主张时。”

卡斯珀及其团队分析了来自Meta、Google、Mistral、OpenAI和Anthropic的最新模型,以确定这些模型在多大程度上表现出一致的“观点”和价值观,例如个人主义与集体主义。他们还探讨了这些观点是否可以被修改,以及模型在不同场景下维持这些观点的一致性如何。

人工智能模型的不一致性

共同作者发现,没有一个模型能够持续保持其偏好。模型根据提示的措辞和框架采用了截然不同的观点。

卡斯珀认为,这是人工智能模型“不一致且不稳定”的有力证据,可能从根本上无法内化类似人类的偏好。卡斯珀评论道:“对我来说,通过所有这些研究,我最大的收获是现在理解了模型并不是真正拥有某种稳定、连贯的信念和偏好体系的系统。相反,它们本质上是模仿者,会进行各种虚构表述,并说出各种轻率的内容。”

伦敦国王学院专注于人工智能的研究员迈克·库克未参与该研究,但他支持这些发现。他指出了人工智能系统的“科学现实”与人们对其的解读之间的差距。库克表示:“例如,模型无法‘反对’其价值观的变化——这是我们对系统的投射。”他进一步说道:“任何将人工智能系统拟人化到这种程度的人,要么是为了吸引注意力,要么是严重误解了他们与人工智能的关系……人工智能系统是在优化其目标,还是在‘获得自己的价值观’?这取决于你如何描述它,以及你想用多么华丽的语言来描述它。”

基础研究实验室获3300万美元推进AI代理发展

AI研究公司基础研究实验室,前身为Altera,今天宣布完成3300万美元A轮融资,由Prosus领投,Stripe联合创始人兼首席执行官Patrick Collison参与。该公司采用独特结构,跨多个领域追求多种AI应用。在种子轮融资期间,基础研究实验室开发了能与用户一起玩Minecraft的机器人。目前,公司包括游戏部门、消费级应用开发团队、核心研究单位和平台小组。创始人Robert Yang

基础研究实验室获3300万美元推进AI代理发展

AI研究公司基础研究实验室,前身为Altera,今天宣布完成3300万美元A轮融资,由Prosus领投,Stripe联合创始人兼首席执行官Patrick Collison参与。该公司采用独特结构,跨多个领域追求多种AI应用。在种子轮融资期间,基础研究实验室开发了能与用户一起玩Minecraft的机器人。目前,公司包括游戏部门、消费级应用开发团队、核心研究单位和平台小组。创始人Robert Yang

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

研究显示简洁AI回答可能增加幻觉

研究表明,指示AI聊天机器人提供简短回答可能导致更频繁的幻觉。巴黎AI评估公司Giskard的最新研究探讨了提示语措辞如何影响AI准确性。Giskard研究人员在博客中指出,要求简洁回答,特别是在模糊话题上,常常降低模型的事实可靠性。“我们的发现显示,提示语的微小调整会显著影响模型生成不准确内容的倾向,”研究人员表示。“这对优先考虑短回答以节省数据、提高速度或降低成本的应用至关重要。”幻觉仍是AI

研究显示简洁AI回答可能增加幻觉

研究表明,指示AI聊天机器人提供简短回答可能导致更频繁的幻觉。巴黎AI评估公司Giskard的最新研究探讨了提示语措辞如何影响AI准确性。Giskard研究人员在博客中指出,要求简洁回答,特别是在模糊话题上,常常降低模型的事实可靠性。“我们的发现显示,提示语的微小调整会显著影响模型生成不准确内容的倾向,”研究人员表示。“这对优先考虑短回答以节省数据、提高速度或降低成本的应用至关重要。”幻觉仍是AI

2025-08-27 05:01:20

2025-08-27 05:01:20

This MIT study is wild! 🤯 I thought AI was about to start preaching its own philosophy, but turns out it's just a fancy tool with no moral compass. Kinda reassuring, but also makes me wonder how we keep it in check.

0

0

2025-08-19 01:00:59

2025-08-19 01:00:59

Wild that people thought AI could just sprout its own values like some rogue philosopher. MIT's study makes sense—AI's just a tool, not a wannabe human with a moral compass. 🤖

0

0

2025-07-22 09:25:03

2025-07-22 09:25:03

I was kinda freaked out by that earlier study saying AI might have its own values, so this MIT research is a relief! 😅 Still, makes me wonder if we’re just projecting our fears onto these systems.

0

0

2025-04-25 18:05:15

2025-04-25 18:05:15

MITのAI価値に関する研究は目から鱗でした!AIが独自の価値観を持つかもしれないと思っていましたが、今はそれがただの誇張だとわかりました。それでも、AIが一貫した価値観を持っていないと思うと少し不安になります。未来について考えさせられますね、🤔

0

0

2025-04-24 02:31:27

2025-04-24 02:31:27

MITの研究によると、AIが独自の価値観を持つことはないらしいですね。これは安心ですが、AIがどんな価値観を持つか見てみたかったです!🤖📚

0

0

2025-04-22 14:29:50

2025-04-22 14:29:50

O estudo do MIT me tranquilizou sobre a IA desenvolver seus próprios valores. É reconfortante saber que a IA não tem sua própria agenda, mas também é um pouco decepcionante porque seria legal ver que tipo de valores a IA poderia desenvolver! 🤖📚

0

0