Vollständiger Leitfaden zur Beherrschung von Inpainting mit stabiler Diffusion

Stable Diffusion hat die KI-gestützte Bilderzeugung verändert, indem es eine noch nie dagewesene kreative Kontrolle bietet, insbesondere durch seine leistungsstarke Inpainting-Funktion. Dieses umfassende Tutorial zeigt Ihnen, wie Sie die intuitive Benutzeroberfläche von Forge UI nutzen, um die Inpainting-Funktionen von Stable Diffusion zu meistern - von grundlegenden Techniken bis hin zu professionellen Verfeinerungen für atemberaubende visuelle Ergebnisse.

Wichtigste Punkte

Präzise lokalisierte Bildbearbeitung durch gezieltes Maskieren

Optimierte Arbeitsabläufe mit der optimierten Oberfläche von Forge UI

Strategische Parameteranpassungen für makellose Integrationen

Kreative Erkundung durch verschiedene Sampling-Ansätze

Iterativer Verfeinerungsprozess zur Perfektionierung der Ergebnisse

Verständnis von Stable Diffusion Inpainting mit Forge UI

Was ist Stable Diffusion Inpainting?

Die Inpainting-Funktion von Stable Diffusion revolutioniert die Bildbearbeitung, indem sie selektive Änderungen an bestimmten Regionen ermöglicht, während die Gesamtkomposition erhalten bleibt. Dieses intelligente System nutzt fortschrittliche Maskierungstechniken, bei denen der Benutzer bearbeitbare Bereiche definiert, so dass die KI Inhalte kontextbezogen neu generieren kann, die sich nahtlos in die vorhandenen Elemente einfügen.

Durch die Analyse umliegender Pixel und die Interpretation von Benutzeranweisungen rekonstruiert das Diffusionsmodell maskierte Bereiche mit bemerkenswerter Kohärenz. Diese Technologie eignet sich hervorragend für verschiedene Anwendungen wie die Entfernung von Objekten, kreative Ergänzungen, stilistische Transformationen, Korrektur von Fehlern und kompositorische Erweiterungen.

Forge UI: Eine benutzerfreundliche Oberfläche für Stable Diffusion

Forge UI entmystifiziert Stable Diffusion mit einer leicht zugänglichen visuellen Oberfläche, die keine Kodierung mehr erfordert. Der durchdachte Arbeitsbereich ermöglicht müheloses Modellmanagement, Prompt Crafting, Parameteranpassungen und Bilderzeugung über intuitive Bedienelemente.

Die Plattform verbessert die Arbeitsabläufe beim Inpainting durch:

- Visuelle Maskierung durch direktes Zeichnen oder Uploads

- Parameteroptimierung mit interaktiven Schiebereglern

- Sofortige Vorschaubilder für iterative Verfeinerungen

- Nahtlose Integration mit anderen Stable Diffusion-Funktionen

Erweiterte Inpainting-Techniken

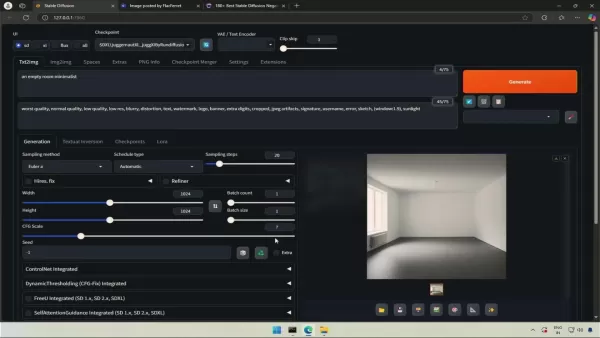

Nutzung von ControlNet für präzise Steuerung

ControlNet erweitert die Inpainting-Funktionen durch die Einführung von struktureller Führung durch Referenzbilder. Dies ist besonders wertvoll, wenn es darum geht, architektonische Präzision zu bewahren oder sicherzustellen, dass neue Elemente perfekt mit bestehenden Kompositionen übereinstimmen. Der Arbeitsablauf umfasst:

- Installieren der ControlNet-Erweiterung

- Vorbereiten von strukturellen Referenzbildern (Kantenkarten, Tiefenkarten, Skizzen)

- Laden von Kontrollbildern in Forge UI

- Feinabstimmung der Einflussparameter

- Generieren mit erweiterter Anleitung

Latentes Rauschen für kreative Effekte verwenden

Die Einführung kontrollierter Zufälligkeit durch die Injektion von latentem Rauschen kann zu unerwartet kreativen Ergebnissen führen. Diese Technik eignet sich hervorragend, um künstlerische Variationen oder surreale Interpretationen in unbemalten Bereichen zu erzielen. Mit den einstellbaren Parametern für die Stärke des Rauschens können Kreative das Gleichgewicht zwischen Kohärenz und Innovation in ihren Ergebnissen fein abstimmen.

Schritt-für-Schritt-Anleitung zum Inpainting mit Forge UI

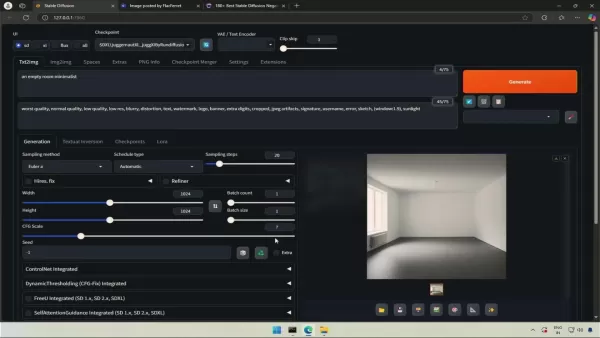

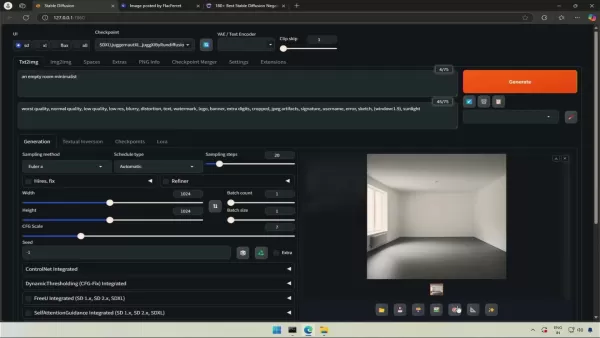

Ersteinrichtung und Modellauswahl

- Starten Sie die Anwendung Forge UI

- Wählen Sie das entsprechende Modell aus dem Dropdown-Menü (empfohlen: sdxl_juggernautXL_juggernautFlusio)

- Geben Sie beschreibende positive und negative Eingabeaufforderungen ein

- Basisbild mit Text-zu-Bild-Funktion generieren

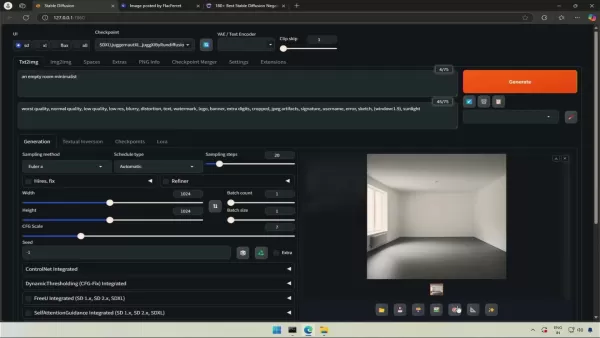

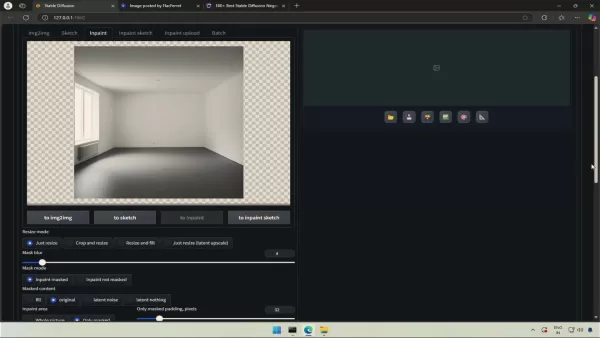

Übergabe an die Registerkarte Inpaint

- Basisbild generieren oder importieren

- Klicken Sie auf das rosa Palettensymbol unter dem Bild

- Es erfolgt eine automatische Übertragung zur Registerkarte Inpainting

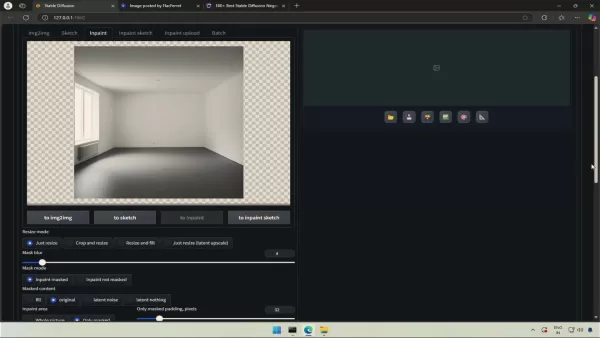

Einstellen der Parameter für die Übermalung

- Übermalungsbereich auf "Nur maskiert" setzen

- Original-Sampling-Methoden/Schema anpassen

- Wählen Sie das Pinselwerkzeug und passen Sie die Größe für die Präzision an.

Anwenden der Maske und Übermalen

- Maske über den Zielbereich malen

- Detaillierte Generierungsaufforderung eingeben

- Ergebnisse generieren und auswerten

- Iterative Verfeinerung der Parameter und Maskierung

Preisgestaltung bei stabiler Diffusion

Kostenüberlegungen für Stable Diffusion Inpainting

Während die Kernsoftware kostenlos ist, müssen für eine effektive Implementierung folgende Faktoren berücksichtigt werden:

- Investition in einen Grafikprozessor (High-End empfohlen)

- Anforderungen an den Arbeitsspeicher (mindestens 16 GB, bevorzugt 32 GB+)

- SSD-Speicher für optimale Leistung

- Mögliche Kosten für Cloud Computing/API-Dienste

Vor- und Nachteile von Stable Diffusion Inpainting

Vorteile

Unerreichte kreative Flexibilität

Nahtlose Ergebnisse in Profiqualität

Open-Source-Zugänglichkeit

Durch Erweiterungen ausbaufähig

Präzise lokalisierte Kontrolle

Nachteile

Hardware-intensive Anforderungen

Komplexe Erstkonfiguration

Ergebnisse variieren mit der Qualität der Eingabeaufforderung

Erfordert iterative Verfeinerung

Steile Lernkurve

Wesentliche Merkmale für erfolgreiches Inpainting

Wesentliche Merkmale für stabiles Diffusions-Inpainting

Beherrschen Sie diese Kernkomponenten für professionelle Ergebnisse:

- Erweiterte Maskierungswerkzeuge (Pinsel/Lasso/Polygon)

- Strategische Prompting-Techniken

- Parameter-Feinabstimmung (Rauschunterdrückung, CFG-Skala, Sampling)

- Echtzeit-Vorschau-Funktionalität

- Integration von Erweiterungen (ControlNet, etc.)

Inspirierende Anwendungsfälle für Inpainting

Kreative Anwendungen von Stable Diffusion Inpainting

Transformative Möglichkeiten umfassen:

- Restaurierung historischer Fotos

- Bereinigung von Kompositionen und Entfernung von Objekten

- Dynamische Ersetzung von Hintergründen

- Variationen des Charakterdesigns

- Visualisierung architektonischer Konzepte

- Experimentieren mit Modedesign

Häufig gestellte Fragen

Welches ist die beste Sampling-Methode für Inpainting?

Die Leistung variiert je nach Projekt - experimentieren Sie mit Euler a, DPM++ 2M Karras und DDIM, um optimale Ansätze für bestimmte Anwendungsfälle zu ermitteln.

Wie kann ich meine Inpainting-Ergebnisse verbessern?

- Beginnen Sie mit hochauflösenden Quellbildern

- Erstellen Sie präzise, detaillierte Masken

- Entwickeln Sie klare, beschreibende Prompts

- Systematische Anpassung der Parameter

- Einen iterativen Verfeinerungsprozess einführen

Kann ich völlig neue Elemente hinzufügen?

Auf jeden Fall - strategische Maskierung und gut formulierte Anweisungen ermöglichen die nahtlose Integration völlig neuer Komponenten in bestehende Kompositionen.

Verwandte Fragen

Welche häufigen Fehler sollte ich vermeiden?

Zu den häufigsten Fehlern gehören minderwertiges Ausgangsmaterial, ungenaue Maskierung, ungenaue Eingabeaufforderungen, ungeeignete Parameterkonfigurationen und unzureichende Verfeinerungsiterationen.

Wie lässt sich Stable Diffusion mit Alternativen vergleichen?

Zu den Vorteilen von Stable Diffusion gehören die Zugänglichkeit zu Open Source, die umfangreichen Anpassungsoptionen, das leistungsstarke Ökosystem für Erweiterungen und die fortschrittlichen KI-Funktionen für mehr Realismus und Integration.

Verwandter Artikel

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

Nvidia meldet zwei Großkunden, die 39 % des Q2-Umsatzes generieren

Nvidias Umsatzkonzentration verdeutlicht Abhängigkeiten vom KI-BoomDer jüngste SEC-Bericht des Chipherstellers offenbart eine atemberaubende Kundenkonzentration: Zwei ungenannte Kunden machen 39 % des

Kommentare (0)

0/200

Nvidia meldet zwei Großkunden, die 39 % des Q2-Umsatzes generieren

Nvidias Umsatzkonzentration verdeutlicht Abhängigkeiten vom KI-BoomDer jüngste SEC-Bericht des Chipherstellers offenbart eine atemberaubende Kundenkonzentration: Zwei ungenannte Kunden machen 39 % des

Kommentare (0)

0/200

Stable Diffusion hat die KI-gestützte Bilderzeugung verändert, indem es eine noch nie dagewesene kreative Kontrolle bietet, insbesondere durch seine leistungsstarke Inpainting-Funktion. Dieses umfassende Tutorial zeigt Ihnen, wie Sie die intuitive Benutzeroberfläche von Forge UI nutzen, um die Inpainting-Funktionen von Stable Diffusion zu meistern - von grundlegenden Techniken bis hin zu professionellen Verfeinerungen für atemberaubende visuelle Ergebnisse.

Wichtigste Punkte

Präzise lokalisierte Bildbearbeitung durch gezieltes Maskieren

Optimierte Arbeitsabläufe mit der optimierten Oberfläche von Forge UI

Strategische Parameteranpassungen für makellose Integrationen

Kreative Erkundung durch verschiedene Sampling-Ansätze

Iterativer Verfeinerungsprozess zur Perfektionierung der Ergebnisse

Verständnis von Stable Diffusion Inpainting mit Forge UI

Was ist Stable Diffusion Inpainting?

Die Inpainting-Funktion von Stable Diffusion revolutioniert die Bildbearbeitung, indem sie selektive Änderungen an bestimmten Regionen ermöglicht, während die Gesamtkomposition erhalten bleibt. Dieses intelligente System nutzt fortschrittliche Maskierungstechniken, bei denen der Benutzer bearbeitbare Bereiche definiert, so dass die KI Inhalte kontextbezogen neu generieren kann, die sich nahtlos in die vorhandenen Elemente einfügen.

Durch die Analyse umliegender Pixel und die Interpretation von Benutzeranweisungen rekonstruiert das Diffusionsmodell maskierte Bereiche mit bemerkenswerter Kohärenz. Diese Technologie eignet sich hervorragend für verschiedene Anwendungen wie die Entfernung von Objekten, kreative Ergänzungen, stilistische Transformationen, Korrektur von Fehlern und kompositorische Erweiterungen.

Forge UI: Eine benutzerfreundliche Oberfläche für Stable Diffusion

Forge UI entmystifiziert Stable Diffusion mit einer leicht zugänglichen visuellen Oberfläche, die keine Kodierung mehr erfordert. Der durchdachte Arbeitsbereich ermöglicht müheloses Modellmanagement, Prompt Crafting, Parameteranpassungen und Bilderzeugung über intuitive Bedienelemente.

Die Plattform verbessert die Arbeitsabläufe beim Inpainting durch:

- Visuelle Maskierung durch direktes Zeichnen oder Uploads

- Parameteroptimierung mit interaktiven Schiebereglern

- Sofortige Vorschaubilder für iterative Verfeinerungen

- Nahtlose Integration mit anderen Stable Diffusion-Funktionen

Erweiterte Inpainting-Techniken

Nutzung von ControlNet für präzise Steuerung

ControlNet erweitert die Inpainting-Funktionen durch die Einführung von struktureller Führung durch Referenzbilder. Dies ist besonders wertvoll, wenn es darum geht, architektonische Präzision zu bewahren oder sicherzustellen, dass neue Elemente perfekt mit bestehenden Kompositionen übereinstimmen. Der Arbeitsablauf umfasst:

- Installieren der ControlNet-Erweiterung

- Vorbereiten von strukturellen Referenzbildern (Kantenkarten, Tiefenkarten, Skizzen)

- Laden von Kontrollbildern in Forge UI

- Feinabstimmung der Einflussparameter

- Generieren mit erweiterter Anleitung

Latentes Rauschen für kreative Effekte verwenden

Die Einführung kontrollierter Zufälligkeit durch die Injektion von latentem Rauschen kann zu unerwartet kreativen Ergebnissen führen. Diese Technik eignet sich hervorragend, um künstlerische Variationen oder surreale Interpretationen in unbemalten Bereichen zu erzielen. Mit den einstellbaren Parametern für die Stärke des Rauschens können Kreative das Gleichgewicht zwischen Kohärenz und Innovation in ihren Ergebnissen fein abstimmen.

Schritt-für-Schritt-Anleitung zum Inpainting mit Forge UI

Ersteinrichtung und Modellauswahl

- Starten Sie die Anwendung Forge UI

- Wählen Sie das entsprechende Modell aus dem Dropdown-Menü (empfohlen: sdxl_juggernautXL_juggernautFlusio)

- Geben Sie beschreibende positive und negative Eingabeaufforderungen ein

- Basisbild mit Text-zu-Bild-Funktion generieren

Übergabe an die Registerkarte Inpaint

- Basisbild generieren oder importieren

- Klicken Sie auf das rosa Palettensymbol unter dem Bild

- Es erfolgt eine automatische Übertragung zur Registerkarte Inpainting

Einstellen der Parameter für die Übermalung

- Übermalungsbereich auf "Nur maskiert" setzen

- Original-Sampling-Methoden/Schema anpassen

- Wählen Sie das Pinselwerkzeug und passen Sie die Größe für die Präzision an.

Anwenden der Maske und Übermalen

- Maske über den Zielbereich malen

- Detaillierte Generierungsaufforderung eingeben

- Ergebnisse generieren und auswerten

- Iterative Verfeinerung der Parameter und Maskierung

Preisgestaltung bei stabiler Diffusion

Kostenüberlegungen für Stable Diffusion Inpainting

Während die Kernsoftware kostenlos ist, müssen für eine effektive Implementierung folgende Faktoren berücksichtigt werden:

- Investition in einen Grafikprozessor (High-End empfohlen)

- Anforderungen an den Arbeitsspeicher (mindestens 16 GB, bevorzugt 32 GB+)

- SSD-Speicher für optimale Leistung

- Mögliche Kosten für Cloud Computing/API-Dienste

Vor- und Nachteile von Stable Diffusion Inpainting

Vorteile

Unerreichte kreative Flexibilität

Nahtlose Ergebnisse in Profiqualität

Open-Source-Zugänglichkeit

Durch Erweiterungen ausbaufähig

Präzise lokalisierte Kontrolle

Nachteile

Hardware-intensive Anforderungen

Komplexe Erstkonfiguration

Ergebnisse variieren mit der Qualität der Eingabeaufforderung

Erfordert iterative Verfeinerung

Steile Lernkurve

Wesentliche Merkmale für erfolgreiches Inpainting

Wesentliche Merkmale für stabiles Diffusions-Inpainting

Beherrschen Sie diese Kernkomponenten für professionelle Ergebnisse:

- Erweiterte Maskierungswerkzeuge (Pinsel/Lasso/Polygon)

- Strategische Prompting-Techniken

- Parameter-Feinabstimmung (Rauschunterdrückung, CFG-Skala, Sampling)

- Echtzeit-Vorschau-Funktionalität

- Integration von Erweiterungen (ControlNet, etc.)

Inspirierende Anwendungsfälle für Inpainting

Kreative Anwendungen von Stable Diffusion Inpainting

Transformative Möglichkeiten umfassen:

- Restaurierung historischer Fotos

- Bereinigung von Kompositionen und Entfernung von Objekten

- Dynamische Ersetzung von Hintergründen

- Variationen des Charakterdesigns

- Visualisierung architektonischer Konzepte

- Experimentieren mit Modedesign

Häufig gestellte Fragen

Welches ist die beste Sampling-Methode für Inpainting?

Die Leistung variiert je nach Projekt - experimentieren Sie mit Euler a, DPM++ 2M Karras und DDIM, um optimale Ansätze für bestimmte Anwendungsfälle zu ermitteln.

Wie kann ich meine Inpainting-Ergebnisse verbessern?

- Beginnen Sie mit hochauflösenden Quellbildern

- Erstellen Sie präzise, detaillierte Masken

- Entwickeln Sie klare, beschreibende Prompts

- Systematische Anpassung der Parameter

- Einen iterativen Verfeinerungsprozess einführen

Kann ich völlig neue Elemente hinzufügen?

Auf jeden Fall - strategische Maskierung und gut formulierte Anweisungen ermöglichen die nahtlose Integration völlig neuer Komponenten in bestehende Kompositionen.

Verwandte Fragen

Welche häufigen Fehler sollte ich vermeiden?

Zu den häufigsten Fehlern gehören minderwertiges Ausgangsmaterial, ungenaue Maskierung, ungenaue Eingabeaufforderungen, ungeeignete Parameterkonfigurationen und unzureichende Verfeinerungsiterationen.

Wie lässt sich Stable Diffusion mit Alternativen vergleichen?

Zu den Vorteilen von Stable Diffusion gehören die Zugänglichkeit zu Open Source, die umfangreichen Anpassungsoptionen, das leistungsstarke Ökosystem für Erweiterungen und die fortschrittlichen KI-Funktionen für mehr Realismus und Integration.

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

Nvidia meldet zwei Großkunden, die 39 % des Q2-Umsatzes generieren

Nvidias Umsatzkonzentration verdeutlicht Abhängigkeiten vom KI-BoomDer jüngste SEC-Bericht des Chipherstellers offenbart eine atemberaubende Kundenkonzentration: Zwei ungenannte Kunden machen 39 % des

Nvidia meldet zwei Großkunden, die 39 % des Q2-Umsatzes generieren

Nvidias Umsatzkonzentration verdeutlicht Abhängigkeiten vom KI-BoomDer jüngste SEC-Bericht des Chipherstellers offenbart eine atemberaubende Kundenkonzentration: Zwei ungenannte Kunden machen 39 % des