Data Engineering Interview Prep: Ultimate Guide und Cheat Sheet

30. April 2025

30. April 2025

FrankJackson

FrankJackson

0

0

Navigieren in der Welt der Data Engineering -Interviews

Wenn Sie sich auf die Reise von Daten technischen Interviews einlassen, können Sie sich in ein Labyrinth von Technologien und Konzepten einsetzen. Es ist leicht, sich überfordert zu fühlen, aber mit dem richtigen Fokus können Sie Ihre Energie effektiv kanalisieren. Dieser Leitfaden dient als Ihr Kompass und bietet einen strukturierten Ansatz für die Vorbereitung auf Data Engineering -Interviews. Von wesentlichen technischen Fähigkeiten bis hin zum Verständnis des Projektlebenszyklus soll es sowohl erfahrene Datenfachleute als auch Neuankömmlinge auf diesem Gebiet mit dem Wissen und dem Selbstvertrauen befähigen, um erfolgreich zu sein.

Schlüsselpunkte zum Master

- Erfassen Sie die Kernkonzepte des Daten Engineering wie ETL, Datenmodellierung und Data Warehousing.

- Schärfen Sie Ihre technischen Fähigkeiten, einschließlich SQL, Python und Kompetenz mit Cloud -Diensten wie AWS, Azure und GCP.

- Erstellen Sie ein Portfolio, das Ihre Daten Engineering -Projekte zeigt, um Ihr Fachwissen und Ihre Erfahrung zu demonstrieren.

- Bereiten Sie sich auf typische Interviewfragen vor, mit Schwerpunkt auf Problemlösung und Systemdesign.

- Verstehen Sie den vollständigen Zyklus eines Dateningenieurprojekts, von der Erfassung von Anforderungen bis hin zum Erstellen von Dashboards.

Konzentrieren Sie sich auf Datenmodellierung und Datendesign

Es ist entscheidend, ETL- und Datenpipelines zu beherrschen. Diese Fähigkeiten bilden das Rückgrat des effektiven Datenmanagements und sind in diesem Bereich hoch geschätzt.

Verständnis der Grundlagen des Data Engineering

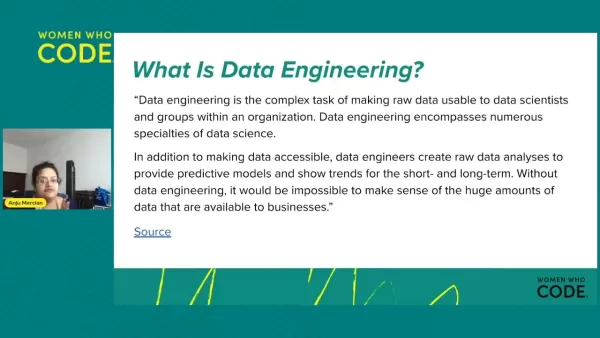

Was ist Data Engineering?

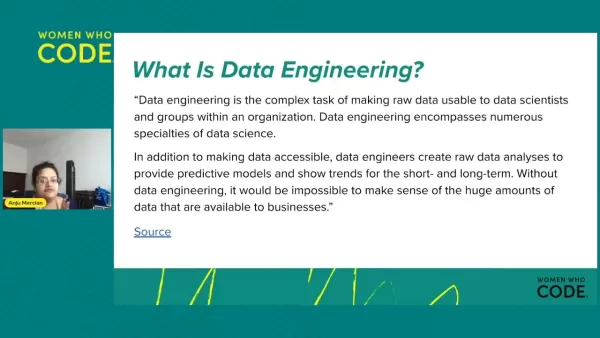

Data Engineering ist der unbesungene Held hinter datengesteuerten Organisationen. Es ist die Kunst und Wissenschaft, Rohdaten in ein nutzbares Format für Datenwissenschaftler, Wirtschaftsanalysten und Stakeholder zu verwandeln. Dateningenieure sind Architekten, die die Infrastruktur entwerfen, bauen und pflegen, mit der Unternehmen massive Datenmengen sammeln, verarbeiten, speichern und analysieren können.

Das Feld umfasst eine Reihe von Spezialitäten, von Datenaufnahme und Extraktion über Transformation, Reinigung, Speicherung, Lagerung, Pipeline -Entwicklung, Automatisierung und Sicherheitsregierung. Dateningenieure erzeugen robuste, skalierbare und zuverlässige Datensysteme, die die Entscheidungsfindung fördern. Abgesehen davon, dass Daten zugänglich gemacht werden, tauchen sie auch in die Rohdatenanalyse ein, um Trends aufzudecken und prädiktive Modelle aufzubauen, die kurz- und langfristige Geschäftsstrategien formen. Ohne Data Engineering wäre es nahezu unmöglich, durch das riesige Datenmeer zu navigieren.

Die Rolle eines Dateningenieurs

Dateningenieure arbeiten in verschiedenen Umgebungen und konstruieren Systeme, die Rohdaten sammeln, verwalten und in umsetzbare Erkenntnisse für Datenwissenschaftler und Geschäftsanalysten umwandeln. Ihre Hauptaufgabe ist es, Daten für Unternehmen zugänglich und nützlich zu machen, um ihre Leistung zu bewerten und zu verbessern.

Zu ihren wichtigsten Verantwortlichkeiten gehören:

- Entwicklung und Wartung von Datenpipelines.

- Erstellen und Optimieren von Data Warehouses und Data Lakes.

- Datenqualität und Integrität sicherstellen.

- Automatisierung von Datenverarbeitungsaufgaben.

- Zusammenarbeit mit Datenwissenschaftlern und Geschäftsanalysten, um ihre Datenanforderungen zu erfüllen.

- Implementierung von Datensicherheitsmaßnahmen.

- Fehlerbehebung mit datenbezogenen Problemen.

Wichtige technische Fähigkeiten für Dateningenieure

Um in Datenentwicklung zu gedeihen, sind bestimmte technische Fähigkeiten nicht verhandelbar:

- SQL: Der Eckpfeiler zum Abfragen, Manipulieren und Verwalten von Daten in relationalen Datenbanken.

- Python: Eine vielseitige Sprache, die ausgiebig für die Datenverarbeitung, Automatisierung und Skripten verwendet wird.

- Cloud Computing: Kompetenz mit Plattformen wie AWS, Azure oder GCP für Datenspeicher, Verarbeitung und Analyse.

- ETL -Tools: Vertrautheit mit Tools wie Apache Airstrom zum Orchestrieren von Datenpipelines.

- Spark: Ein leistungsstarkes Framework für die Verarbeitung großer Datensätze.

Navigieren des Lebenszyklus des Daten Engineering Project

Datenentwicklungsprojektschritte

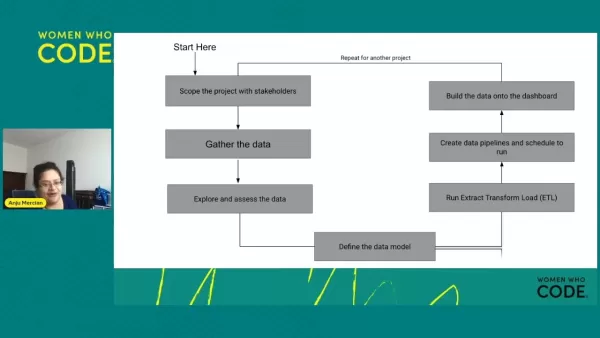

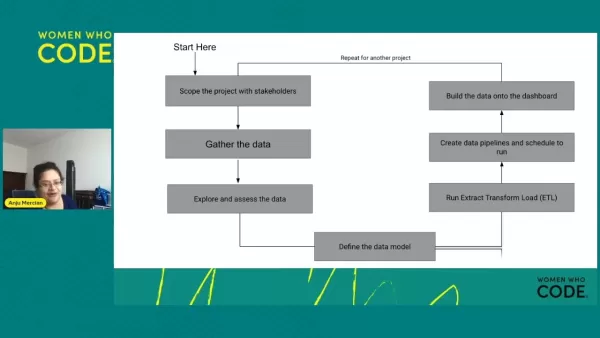

Das Verständnis der verschiedenen Phasen eines Daten Engineering -Projekts ist für den Erfolg von entscheidender Bedeutung. Hier ist ein typischer Projektlebenszyklus:

- Geben Sie das Projekt mit Stakeholdern aus: Definieren Sie zunächst Projektziele und -anforderungen. Es ist wichtig, die Geschäftsbedürfnisse und technischen Einschränkungen zu verstehen, um ein erfolgreiches Ergebnis zu erzielen.

- Sammeln Sie die Daten: Sammeln Sie Daten aus verschiedenen internen und externen Quellen, wie z. B. Datenbanken, APIs oder Datenströme.

- Erforschen und bewerten Sie die Daten: Analysieren Sie die Daten, um ihre Struktur, Qualität und potenzielle Probleme zu verstehen, um zu identifizieren, was gereinigt und transformiert werden muss.

- Definieren Sie das Datenmodell: Entwerfen Sie das Datenmodell, um Daten effizient zu strukturieren und zu speichern. Dies beinhaltet die Auswahl von Datentypen, die Definition von Beziehungen und die Optimierung der Abfrageleistung.

- Ausführen von Extract Transform Last (ETL): Implementieren Sie den ETL -Prozess, um Daten zu extrahieren, sie in ein verwendbares Format umzuwandeln und in das Zieldatenhause oder den Data Lake zu laden.

- Erstellen Sie Datenpipelines und Zeitplan, um automatisierte Datenpipelines zu entwickeln, um regelmäßige Datenverarbeitung und -aktualisierungen zu gewährleisten, einschließlich Planungsaufgaben, Überwachung des Datenflusss und Handhabungsfehler.

- Erstellen Sie die Daten auf dem Dashboard: Erstellen Sie Dashboards und Visualisierungen, um die verarbeiteten Daten in einem verständlichen Format zu präsentieren, sodass die Stakeholder Erkenntnisse gewinnen und fundierte Entscheidungen treffen können. Beachten Sie, dass Datenanalysten diese Phase häufig verarbeiten.

Vorbereitung des Datenentwicklungsinterviews

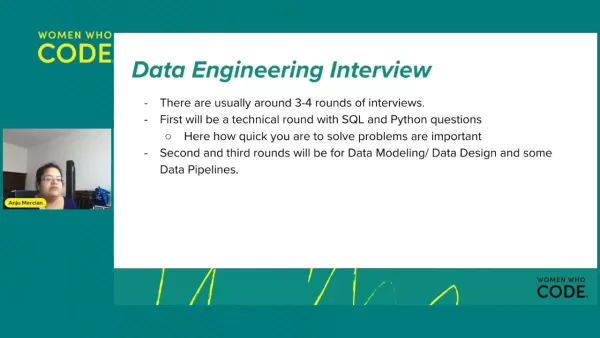

Verständnis der Daten technischen Interviewstruktur

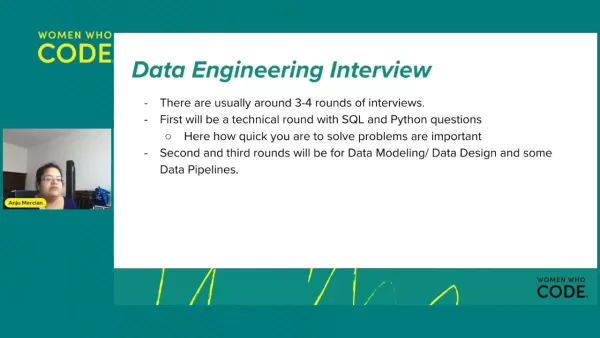

Data Engineering -Interviews folgen normalerweise einer Struktur, die den Interviews mit Software -Engineering ähnelt, die normalerweise aus drei bis vier Runden bestehen:

- Technische Runde: Diese Fokussierung auf kern technische Fähigkeiten wie SQL und Python mit Codierungsherausforderungen, Fragen zur Problemlösung und Diskussionen über Datenstrukturen und Algorithmen.

- Datenmodellierung und -design: Dies bewertet Ihre Fähigkeit, Datenmodelle zu entwerfen, Data Warehousing -Konzepte zu verstehen und effiziente Datenpipelines zu erstellen.

- Datenpipelines: Dies bewertet Ihre Fähigkeiten bei der Gestaltung und Wartung von Datenpipelines.

Bereiten Sie sich auf technische Interviews vor: SQL und Python

Konzentrieren Sie sich auf SQL und Python an technische Interviews:

SQL:

- Beherrschen Sie die Grundlagen: Überprüfen Sie die SQL -Syntax, Datentypen und gemeinsame Abfragemuster.

- Üben Sie komplexe Abfragen: Arbeiten Sie daran, Daten aus mehreren Tabellen zu filtern, zu aggregieren und zu verbinden, mit Blick auf die Optimierung und Leistung von Abfragen.

- Verstehen Sie Data Warehousing -Konzepte: Machen Sie sich mit Sternschemata, Schneeflockenschemata und anderen Data Warehousing -Konzepten vertraut.

Python:

- Datenmanipulationsbibliotheken: Mit Bibliotheken wie Pandas und Numpy für Datenmanipulation, Reinigung und Analyse beherrscht.

- Skript und Automatisierung: Üben Sie das Schreiben von Skripten, um gemeinsame Datenentwicklungsaufgaben wie Datenaufnahme, Transformation und Laden zu automatisieren.

- Datenstrukturen und Algorithmen: Aktualisieren Sie Ihr Wissen über grundlegende Datenstrukturen und Algorithmen, um eine effiziente Datenverarbeitung sicherzustellen.

Mastering -Datenmodellierung

Betrachten Sie für Datenmodellierung und -entwurf Folgendes:

- Dimensionale Modellierung: Verstehen Sie die Prinzipien der dimensionalen Modellierung, einschließlich der Identifizierung von Fakten, Dimensionen und Maßnahmen.

- Datennormalisierung: Erfahren Sie mehr über die Datennormalisierungstechniken, um Redundanz zu verringern und die Datenintegrität zu verbessern.

- Data Warehousing -Konzepte: Überprüfen Sie Konzepte wie Sternschemata, Schneeflockenschemata und Datenverbrückungsmodellierung.

- Szenarien in realer Welt: Üben Sie das Entwerfen von Datenmodellen für reale Szenarien, berücksichtigen Faktoren wie Datenvolumen, Abfragemuster und Geschäftsanforderungen.

- Verständnis gemeinsamer Datenformate: Erfahren Sie über strukturierte, halbstrukturierte und unstrukturierte Datenformate, einschließlich CSV, JSON, XML und anderen.

Interview -Tipps: Gemeinsame Fragetypen

Seien Sie bereit für verschiedene Arten von Fragen in Daten technischen Interviews:

- Verhaltensfragen: Bereiten Sie sich darauf vor, Ihre Erfahrungen, Ihre Fähigkeiten zur Problemlösung und Ihre Teamarbeit zu erörtern. Verwenden Sie die Sternmethode (Situation, Aufgabe, Aktion, Ergebnis), um Ihre Antworten zu strukturieren.

- Technische Fragen: Erwarten Sie Fragen zu Codierung, SQL und Datenpipeline -Designs.

- Datenreinigung und Transformation: Seien Sie bereit, Techniken zum Umgang mit fehlenden Daten, Ausreißer und Inkonsistenzen zu diskutieren.

- Datenpipeline-Design: Bereiten Sie sich auf die Entwurf von End-to-End-Datenpipelines vor, unter Berücksichtigung von Faktoren wie Datenvolumen, Latenz und Fehlerbehandlung.

Für die Datenmodellierung in der realen Welt sind Sie bereit, Ihre Erfahrungen mit der Cloud-Infrastruktur und anderen proprietären Informationen zu besprechen.

Vorteile und Herausforderungen in der Datentechnik

Profis

- Hohe Nachfrage und wettbewerbsfähige Gehälter: Dateningenieure sind hoher Nachfrage, was zu wettbewerbsfähigen Gehältern führt.

- Intellektuell stimulierende Arbeit: Die Rolle besteht darin, komplexe technische Herausforderungen anzugehen und mit modernsten Technologien zu arbeiten.

- Wirkliche Beiträge: Dateningenieure spielen eine entscheidende Rolle, um Unternehmen datengesteuerte Entscheidungen zu treffen und einen Wettbewerbsvorteil zu erreichen.

- Karrierewachstumschancen: Das Feld bietet zahlreiche Karrierewege, darunter spezielle Rollen in Data Warehousing, Data Pipelines und Data Governance.

Nachteile

- Technische Komplexität: Der Job erfordert ein tiefes Verständnis verschiedener Technologien und Konzepte.

- Ständiges Lernen: Die Landschaft des Datentechnik entwickelt sich immer wieder und erfordert kontinuierliches Lernen und Fähigkeiten.

- Hochdruck: Dateningenieure sind für die Zuverlässigkeit und Leistung kritischer Datensysteme verantwortlich.

- Herausforderungen für die Zusammenarbeit: Die Rolle besteht häufig darin, mit verschiedenen Teams zusammenzuarbeiten und starke Kommunikations- und Zusammenarbeitskompetenz zu erfordern.

Häufig gestellte Fragen

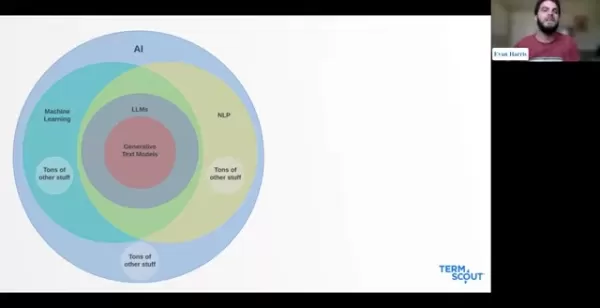

Was ist der Unterschied zwischen Data Engineering und Data Science?

Dateningenieure konzentrieren sich auf den Aufbau und die Aufrechterhaltung der Infrastruktur, die Daten verwaltet, während Datenwissenschaftler diese Daten analysieren, um Erkenntnisse zu extrahieren und prädiktive Modelle zu erstellen. Im Wesentlichen bereiten Dateningenieure die Daten vor, und Datenwissenschaftler verwenden sie.

Ist ein Informatik -Abschluss erforderlich, um Dateningenieur zu werden?

Obwohl ein Informatik -Abschluss hilfreich sein kann, ist dies nicht immer erforderlich. Was wichtig ist, ist ein starkes Verständnis für Programmierung, Datenbanken und Datenstrukturen, die auf verschiedenen Bildungspfaden erfasst werden können.

Was sind einige beliebte Tools für Datentechnik?

Zu den beliebten Tools in Data Engineering gehören Apache Airstrow, Apache Spark, Hadoop, Kafka und Cloud-basierte Dienste wie AWS, Azure und GCP.

Wie kann ich ein Data Engineering -Portfolio erstellen?

Der Aufbau eines Portfolios kann durch die Arbeit an personenbezogenen Datenprojekten, bei Beitrag zu Open-Source-Projekten und der Teilnahme an Datenentwicklungswettbewerben erreicht werden.

Verwandte Fragen

Was sind die wichtigsten Fähigkeiten für einen Dateningenieur im Jahr 2025?

Im Jahr 2025 benötigen Dateningenieure eine Mischung aus technischen Fähigkeiten, Geschäftssinn und Soft Skills, um sich zu übertreffen. Hier ist ein detaillierter Blick:

Technische Kenntnisse:

- Cloud Computing: Fachwissen in AWS, Azure oder GCP ist entscheidend. Die Vertrautheit mit Diensten wie AWS S3 für Speicherung und Rotverschiebung für Data Warehousing oder Azure Synapse Analytics, Data Lake Storage und Data Factory, wird hoch geschätzt.

- SQL- und NOSQL -Datenbanken: Die Fähigkeiten in SQL sind grundlegend, während Erfahrung mit NoSQL -Datenbanken wie MongoDB oder Cassandra immer wichtiger für den Umgang mit unstrukturierten Daten ist.

- Programmiersprachen: Python ist die Anlaufstelle, gefolgt von Java und Scala, die für die Datenverarbeitung, Automatisierung und Skripten von wesentlicher Bedeutung sind.

- Big Data Technologies: Die Beherrschung von Technologien wie Apache Spark und Hadoop zur Verarbeitung und Analyse großer Datensätze ist unerlässlich.

- Datenpipeline -Tools: Kenntnisse in Tools wie Apache Airstrow, Jenkins und Kubeflow zum Orchestrieren und Automatisieren von Datenworkflows sind entscheidend.

- Datenmodellierung: Ein starkes Verständnis der Datenmodellierungstechniken, einschließlich dimensionaler Modellierung und Datennormalisierung, ist für die Gestaltung effizienter Datenlager von entscheidender Bedeutung.

- ETL/ELT -Prozesse: Kenntnis von ETL- und ELT -Prozessen ist für die Datenintegration und -Transformation von wesentlicher Bedeutung.

Geschäftssinn:

- Data Governance: Das Verständnis der Datenregierungsgrundsätze, einschließlich Datenqualität, Sicherheit und Einhaltung, ist entscheidend für die Sicherstellung der Datenintegrität.

- Datenkompetenz: Die Fähigkeit, Dateneinsichten effektiv zu verstehen, zu interpretieren und zu kommunizieren, wird immer wichtiger.

- Business Intelligence (BI) Tools: Vertrautheit mit BI -Tools wie Tableau oder Power BI kann für den Aufbau von Dashboards und zum Visualisieren von Daten von Vorteil sein.

Soft Skills:

- Kommunikation: Effektive Kommunikation ist der Schlüssel zur Zusammenarbeit mit Stakeholdern und zur Vermittlung technischer Informationen.

- Problemlösung: Die Fähigkeit, datenbezogene Probleme schnell zu identifizieren und zu lösen, ist für die Aufrechterhaltung der Systemzuverlässigkeit von wesentlicher Bedeutung.

- Teamwork: Die Arbeit in funktionsübergreifenden Teams erfordert starke Teamarbeit und Zusammenarbeit.

- Anpassungsfähigkeit: Die sich ständig verändernde Natur des Data Engineering erfordert Anpassungsfähigkeit und die Bereitschaft, neue Technologien zu lernen.

Verwandter Artikel

KI in Verträgen: Ein umfassender Leitfaden für Anwaltsfachleute

Die künstliche Intelligenz (KI) hat in verschiedenen Branchen tiefgreifende Auswirkungen genommen, und der Rechtssektor ist keine Ausnahme. Da die KI -Technologie weiter voranschreitet, ist es für die juristischen Fachkräfte von entscheidender Bedeutung, ihr Potenzial und seine Einschränkungen, insbesondere im Bereich des Vertragsmanagements, zu erfassen. Dieser Leitfaden delv

KI in Verträgen: Ein umfassender Leitfaden für Anwaltsfachleute

Die künstliche Intelligenz (KI) hat in verschiedenen Branchen tiefgreifende Auswirkungen genommen, und der Rechtssektor ist keine Ausnahme. Da die KI -Technologie weiter voranschreitet, ist es für die juristischen Fachkräfte von entscheidender Bedeutung, ihr Potenzial und seine Einschränkungen, insbesondere im Bereich des Vertragsmanagements, zu erfassen. Dieser Leitfaden delv

Rekind: Kundenbetreuung durch KI -Videoanalyse transformieren

In der heutigen schnelllebigen Geschäftswelt ist die Bereitstellung erstklassiger Kundenunterstützung von entscheidender Bedeutung. Geben Sie die Realporation ein, einen Spielveränderer, der die Kraft von KI nutzt, um Kundenunterstützungsvideos zu analysieren. Es geht nicht nur darum, Probleme zu lösen. Es geht darum, die Kundenstimmung zu verstehen und Sprachbarrieren abzubauen

Rekind: Kundenbetreuung durch KI -Videoanalyse transformieren

In der heutigen schnelllebigen Geschäftswelt ist die Bereitstellung erstklassiger Kundenunterstützung von entscheidender Bedeutung. Geben Sie die Realporation ein, einen Spielveränderer, der die Kraft von KI nutzt, um Kundenunterstützungsvideos zu analysieren. Es geht nicht nur darum, Probleme zu lösen. Es geht darum, die Kundenstimmung zu verstehen und Sprachbarrieren abzubauen

Pixar enthüllt KI Tierarztkreationsstil -Leitfaden

Künstliche Intelligenz revolutioniert die kreative Welt und ermöglicht es jedem, mit nur wenigen Worten atemberaubende Bilder zu beschwören. Dies schließt das Handwerk von tierischen Charakteren im ikonischen Pixar -Stil ein, der für seinen Charme und seine emotionale Tiefe bekannt ist. Dieser Leitfaden führt Sie durch die Verwendung eines

Kommentare (0)

0/200

Pixar enthüllt KI Tierarztkreationsstil -Leitfaden

Künstliche Intelligenz revolutioniert die kreative Welt und ermöglicht es jedem, mit nur wenigen Worten atemberaubende Bilder zu beschwören. Dies schließt das Handwerk von tierischen Charakteren im ikonischen Pixar -Stil ein, der für seinen Charme und seine emotionale Tiefe bekannt ist. Dieser Leitfaden führt Sie durch die Verwendung eines

Kommentare (0)

0/200

30. April 2025

30. April 2025

FrankJackson

FrankJackson

0

0

Navigieren in der Welt der Data Engineering -Interviews

Wenn Sie sich auf die Reise von Daten technischen Interviews einlassen, können Sie sich in ein Labyrinth von Technologien und Konzepten einsetzen. Es ist leicht, sich überfordert zu fühlen, aber mit dem richtigen Fokus können Sie Ihre Energie effektiv kanalisieren. Dieser Leitfaden dient als Ihr Kompass und bietet einen strukturierten Ansatz für die Vorbereitung auf Data Engineering -Interviews. Von wesentlichen technischen Fähigkeiten bis hin zum Verständnis des Projektlebenszyklus soll es sowohl erfahrene Datenfachleute als auch Neuankömmlinge auf diesem Gebiet mit dem Wissen und dem Selbstvertrauen befähigen, um erfolgreich zu sein.

Schlüsselpunkte zum Master

- Erfassen Sie die Kernkonzepte des Daten Engineering wie ETL, Datenmodellierung und Data Warehousing.

- Schärfen Sie Ihre technischen Fähigkeiten, einschließlich SQL, Python und Kompetenz mit Cloud -Diensten wie AWS, Azure und GCP.

- Erstellen Sie ein Portfolio, das Ihre Daten Engineering -Projekte zeigt, um Ihr Fachwissen und Ihre Erfahrung zu demonstrieren.

- Bereiten Sie sich auf typische Interviewfragen vor, mit Schwerpunkt auf Problemlösung und Systemdesign.

- Verstehen Sie den vollständigen Zyklus eines Dateningenieurprojekts, von der Erfassung von Anforderungen bis hin zum Erstellen von Dashboards.

Konzentrieren Sie sich auf Datenmodellierung und Datendesign

Es ist entscheidend, ETL- und Datenpipelines zu beherrschen. Diese Fähigkeiten bilden das Rückgrat des effektiven Datenmanagements und sind in diesem Bereich hoch geschätzt.

Verständnis der Grundlagen des Data Engineering

Was ist Data Engineering?

Data Engineering ist der unbesungene Held hinter datengesteuerten Organisationen. Es ist die Kunst und Wissenschaft, Rohdaten in ein nutzbares Format für Datenwissenschaftler, Wirtschaftsanalysten und Stakeholder zu verwandeln. Dateningenieure sind Architekten, die die Infrastruktur entwerfen, bauen und pflegen, mit der Unternehmen massive Datenmengen sammeln, verarbeiten, speichern und analysieren können.

Das Feld umfasst eine Reihe von Spezialitäten, von Datenaufnahme und Extraktion über Transformation, Reinigung, Speicherung, Lagerung, Pipeline -Entwicklung, Automatisierung und Sicherheitsregierung. Dateningenieure erzeugen robuste, skalierbare und zuverlässige Datensysteme, die die Entscheidungsfindung fördern. Abgesehen davon, dass Daten zugänglich gemacht werden, tauchen sie auch in die Rohdatenanalyse ein, um Trends aufzudecken und prädiktive Modelle aufzubauen, die kurz- und langfristige Geschäftsstrategien formen. Ohne Data Engineering wäre es nahezu unmöglich, durch das riesige Datenmeer zu navigieren.

Die Rolle eines Dateningenieurs

Dateningenieure arbeiten in verschiedenen Umgebungen und konstruieren Systeme, die Rohdaten sammeln, verwalten und in umsetzbare Erkenntnisse für Datenwissenschaftler und Geschäftsanalysten umwandeln. Ihre Hauptaufgabe ist es, Daten für Unternehmen zugänglich und nützlich zu machen, um ihre Leistung zu bewerten und zu verbessern.

Zu ihren wichtigsten Verantwortlichkeiten gehören:

- Entwicklung und Wartung von Datenpipelines.

- Erstellen und Optimieren von Data Warehouses und Data Lakes.

- Datenqualität und Integrität sicherstellen.

- Automatisierung von Datenverarbeitungsaufgaben.

- Zusammenarbeit mit Datenwissenschaftlern und Geschäftsanalysten, um ihre Datenanforderungen zu erfüllen.

- Implementierung von Datensicherheitsmaßnahmen.

- Fehlerbehebung mit datenbezogenen Problemen.

Wichtige technische Fähigkeiten für Dateningenieure

Um in Datenentwicklung zu gedeihen, sind bestimmte technische Fähigkeiten nicht verhandelbar:

- SQL: Der Eckpfeiler zum Abfragen, Manipulieren und Verwalten von Daten in relationalen Datenbanken.

- Python: Eine vielseitige Sprache, die ausgiebig für die Datenverarbeitung, Automatisierung und Skripten verwendet wird.

- Cloud Computing: Kompetenz mit Plattformen wie AWS, Azure oder GCP für Datenspeicher, Verarbeitung und Analyse.

- ETL -Tools: Vertrautheit mit Tools wie Apache Airstrom zum Orchestrieren von Datenpipelines.

- Spark: Ein leistungsstarkes Framework für die Verarbeitung großer Datensätze.

Navigieren des Lebenszyklus des Daten Engineering Project

Datenentwicklungsprojektschritte

Das Verständnis der verschiedenen Phasen eines Daten Engineering -Projekts ist für den Erfolg von entscheidender Bedeutung. Hier ist ein typischer Projektlebenszyklus:

- Geben Sie das Projekt mit Stakeholdern aus: Definieren Sie zunächst Projektziele und -anforderungen. Es ist wichtig, die Geschäftsbedürfnisse und technischen Einschränkungen zu verstehen, um ein erfolgreiches Ergebnis zu erzielen.

- Sammeln Sie die Daten: Sammeln Sie Daten aus verschiedenen internen und externen Quellen, wie z. B. Datenbanken, APIs oder Datenströme.

- Erforschen und bewerten Sie die Daten: Analysieren Sie die Daten, um ihre Struktur, Qualität und potenzielle Probleme zu verstehen, um zu identifizieren, was gereinigt und transformiert werden muss.

- Definieren Sie das Datenmodell: Entwerfen Sie das Datenmodell, um Daten effizient zu strukturieren und zu speichern. Dies beinhaltet die Auswahl von Datentypen, die Definition von Beziehungen und die Optimierung der Abfrageleistung.

- Ausführen von Extract Transform Last (ETL): Implementieren Sie den ETL -Prozess, um Daten zu extrahieren, sie in ein verwendbares Format umzuwandeln und in das Zieldatenhause oder den Data Lake zu laden.

- Erstellen Sie Datenpipelines und Zeitplan, um automatisierte Datenpipelines zu entwickeln, um regelmäßige Datenverarbeitung und -aktualisierungen zu gewährleisten, einschließlich Planungsaufgaben, Überwachung des Datenflusss und Handhabungsfehler.

- Erstellen Sie die Daten auf dem Dashboard: Erstellen Sie Dashboards und Visualisierungen, um die verarbeiteten Daten in einem verständlichen Format zu präsentieren, sodass die Stakeholder Erkenntnisse gewinnen und fundierte Entscheidungen treffen können. Beachten Sie, dass Datenanalysten diese Phase häufig verarbeiten.

Vorbereitung des Datenentwicklungsinterviews

Verständnis der Daten technischen Interviewstruktur

Data Engineering -Interviews folgen normalerweise einer Struktur, die den Interviews mit Software -Engineering ähnelt, die normalerweise aus drei bis vier Runden bestehen:

- Technische Runde: Diese Fokussierung auf kern technische Fähigkeiten wie SQL und Python mit Codierungsherausforderungen, Fragen zur Problemlösung und Diskussionen über Datenstrukturen und Algorithmen.

- Datenmodellierung und -design: Dies bewertet Ihre Fähigkeit, Datenmodelle zu entwerfen, Data Warehousing -Konzepte zu verstehen und effiziente Datenpipelines zu erstellen.

- Datenpipelines: Dies bewertet Ihre Fähigkeiten bei der Gestaltung und Wartung von Datenpipelines.

Bereiten Sie sich auf technische Interviews vor: SQL und Python

Konzentrieren Sie sich auf SQL und Python an technische Interviews:

SQL:

- Beherrschen Sie die Grundlagen: Überprüfen Sie die SQL -Syntax, Datentypen und gemeinsame Abfragemuster.

- Üben Sie komplexe Abfragen: Arbeiten Sie daran, Daten aus mehreren Tabellen zu filtern, zu aggregieren und zu verbinden, mit Blick auf die Optimierung und Leistung von Abfragen.

- Verstehen Sie Data Warehousing -Konzepte: Machen Sie sich mit Sternschemata, Schneeflockenschemata und anderen Data Warehousing -Konzepten vertraut.

Python:

- Datenmanipulationsbibliotheken: Mit Bibliotheken wie Pandas und Numpy für Datenmanipulation, Reinigung und Analyse beherrscht.

- Skript und Automatisierung: Üben Sie das Schreiben von Skripten, um gemeinsame Datenentwicklungsaufgaben wie Datenaufnahme, Transformation und Laden zu automatisieren.

- Datenstrukturen und Algorithmen: Aktualisieren Sie Ihr Wissen über grundlegende Datenstrukturen und Algorithmen, um eine effiziente Datenverarbeitung sicherzustellen.

Mastering -Datenmodellierung

Betrachten Sie für Datenmodellierung und -entwurf Folgendes:

- Dimensionale Modellierung: Verstehen Sie die Prinzipien der dimensionalen Modellierung, einschließlich der Identifizierung von Fakten, Dimensionen und Maßnahmen.

- Datennormalisierung: Erfahren Sie mehr über die Datennormalisierungstechniken, um Redundanz zu verringern und die Datenintegrität zu verbessern.

- Data Warehousing -Konzepte: Überprüfen Sie Konzepte wie Sternschemata, Schneeflockenschemata und Datenverbrückungsmodellierung.

- Szenarien in realer Welt: Üben Sie das Entwerfen von Datenmodellen für reale Szenarien, berücksichtigen Faktoren wie Datenvolumen, Abfragemuster und Geschäftsanforderungen.

- Verständnis gemeinsamer Datenformate: Erfahren Sie über strukturierte, halbstrukturierte und unstrukturierte Datenformate, einschließlich CSV, JSON, XML und anderen.

Interview -Tipps: Gemeinsame Fragetypen

Seien Sie bereit für verschiedene Arten von Fragen in Daten technischen Interviews:

- Verhaltensfragen: Bereiten Sie sich darauf vor, Ihre Erfahrungen, Ihre Fähigkeiten zur Problemlösung und Ihre Teamarbeit zu erörtern. Verwenden Sie die Sternmethode (Situation, Aufgabe, Aktion, Ergebnis), um Ihre Antworten zu strukturieren.

- Technische Fragen: Erwarten Sie Fragen zu Codierung, SQL und Datenpipeline -Designs.

- Datenreinigung und Transformation: Seien Sie bereit, Techniken zum Umgang mit fehlenden Daten, Ausreißer und Inkonsistenzen zu diskutieren.

- Datenpipeline-Design: Bereiten Sie sich auf die Entwurf von End-to-End-Datenpipelines vor, unter Berücksichtigung von Faktoren wie Datenvolumen, Latenz und Fehlerbehandlung.

Für die Datenmodellierung in der realen Welt sind Sie bereit, Ihre Erfahrungen mit der Cloud-Infrastruktur und anderen proprietären Informationen zu besprechen.

Vorteile und Herausforderungen in der Datentechnik

Profis

- Hohe Nachfrage und wettbewerbsfähige Gehälter: Dateningenieure sind hoher Nachfrage, was zu wettbewerbsfähigen Gehältern führt.

- Intellektuell stimulierende Arbeit: Die Rolle besteht darin, komplexe technische Herausforderungen anzugehen und mit modernsten Technologien zu arbeiten.

- Wirkliche Beiträge: Dateningenieure spielen eine entscheidende Rolle, um Unternehmen datengesteuerte Entscheidungen zu treffen und einen Wettbewerbsvorteil zu erreichen.

- Karrierewachstumschancen: Das Feld bietet zahlreiche Karrierewege, darunter spezielle Rollen in Data Warehousing, Data Pipelines und Data Governance.

Nachteile

- Technische Komplexität: Der Job erfordert ein tiefes Verständnis verschiedener Technologien und Konzepte.

- Ständiges Lernen: Die Landschaft des Datentechnik entwickelt sich immer wieder und erfordert kontinuierliches Lernen und Fähigkeiten.

- Hochdruck: Dateningenieure sind für die Zuverlässigkeit und Leistung kritischer Datensysteme verantwortlich.

- Herausforderungen für die Zusammenarbeit: Die Rolle besteht häufig darin, mit verschiedenen Teams zusammenzuarbeiten und starke Kommunikations- und Zusammenarbeitskompetenz zu erfordern.

Häufig gestellte Fragen

Was ist der Unterschied zwischen Data Engineering und Data Science?

Dateningenieure konzentrieren sich auf den Aufbau und die Aufrechterhaltung der Infrastruktur, die Daten verwaltet, während Datenwissenschaftler diese Daten analysieren, um Erkenntnisse zu extrahieren und prädiktive Modelle zu erstellen. Im Wesentlichen bereiten Dateningenieure die Daten vor, und Datenwissenschaftler verwenden sie.

Ist ein Informatik -Abschluss erforderlich, um Dateningenieur zu werden?

Obwohl ein Informatik -Abschluss hilfreich sein kann, ist dies nicht immer erforderlich. Was wichtig ist, ist ein starkes Verständnis für Programmierung, Datenbanken und Datenstrukturen, die auf verschiedenen Bildungspfaden erfasst werden können.

Was sind einige beliebte Tools für Datentechnik?

Zu den beliebten Tools in Data Engineering gehören Apache Airstrow, Apache Spark, Hadoop, Kafka und Cloud-basierte Dienste wie AWS, Azure und GCP.

Wie kann ich ein Data Engineering -Portfolio erstellen?

Der Aufbau eines Portfolios kann durch die Arbeit an personenbezogenen Datenprojekten, bei Beitrag zu Open-Source-Projekten und der Teilnahme an Datenentwicklungswettbewerben erreicht werden.

Verwandte Fragen

Was sind die wichtigsten Fähigkeiten für einen Dateningenieur im Jahr 2025?

Im Jahr 2025 benötigen Dateningenieure eine Mischung aus technischen Fähigkeiten, Geschäftssinn und Soft Skills, um sich zu übertreffen. Hier ist ein detaillierter Blick:

Technische Kenntnisse:

- Cloud Computing: Fachwissen in AWS, Azure oder GCP ist entscheidend. Die Vertrautheit mit Diensten wie AWS S3 für Speicherung und Rotverschiebung für Data Warehousing oder Azure Synapse Analytics, Data Lake Storage und Data Factory, wird hoch geschätzt.

- SQL- und NOSQL -Datenbanken: Die Fähigkeiten in SQL sind grundlegend, während Erfahrung mit NoSQL -Datenbanken wie MongoDB oder Cassandra immer wichtiger für den Umgang mit unstrukturierten Daten ist.

- Programmiersprachen: Python ist die Anlaufstelle, gefolgt von Java und Scala, die für die Datenverarbeitung, Automatisierung und Skripten von wesentlicher Bedeutung sind.

- Big Data Technologies: Die Beherrschung von Technologien wie Apache Spark und Hadoop zur Verarbeitung und Analyse großer Datensätze ist unerlässlich.

- Datenpipeline -Tools: Kenntnisse in Tools wie Apache Airstrow, Jenkins und Kubeflow zum Orchestrieren und Automatisieren von Datenworkflows sind entscheidend.

- Datenmodellierung: Ein starkes Verständnis der Datenmodellierungstechniken, einschließlich dimensionaler Modellierung und Datennormalisierung, ist für die Gestaltung effizienter Datenlager von entscheidender Bedeutung.

- ETL/ELT -Prozesse: Kenntnis von ETL- und ELT -Prozessen ist für die Datenintegration und -Transformation von wesentlicher Bedeutung.

Geschäftssinn:

- Data Governance: Das Verständnis der Datenregierungsgrundsätze, einschließlich Datenqualität, Sicherheit und Einhaltung, ist entscheidend für die Sicherstellung der Datenintegrität.

- Datenkompetenz: Die Fähigkeit, Dateneinsichten effektiv zu verstehen, zu interpretieren und zu kommunizieren, wird immer wichtiger.

- Business Intelligence (BI) Tools: Vertrautheit mit BI -Tools wie Tableau oder Power BI kann für den Aufbau von Dashboards und zum Visualisieren von Daten von Vorteil sein.

Soft Skills:

- Kommunikation: Effektive Kommunikation ist der Schlüssel zur Zusammenarbeit mit Stakeholdern und zur Vermittlung technischer Informationen.

- Problemlösung: Die Fähigkeit, datenbezogene Probleme schnell zu identifizieren und zu lösen, ist für die Aufrechterhaltung der Systemzuverlässigkeit von wesentlicher Bedeutung.

- Teamwork: Die Arbeit in funktionsübergreifenden Teams erfordert starke Teamarbeit und Zusammenarbeit.

- Anpassungsfähigkeit: Die sich ständig verändernde Natur des Data Engineering erfordert Anpassungsfähigkeit und die Bereitschaft, neue Technologien zu lernen.

KI in Verträgen: Ein umfassender Leitfaden für Anwaltsfachleute

Die künstliche Intelligenz (KI) hat in verschiedenen Branchen tiefgreifende Auswirkungen genommen, und der Rechtssektor ist keine Ausnahme. Da die KI -Technologie weiter voranschreitet, ist es für die juristischen Fachkräfte von entscheidender Bedeutung, ihr Potenzial und seine Einschränkungen, insbesondere im Bereich des Vertragsmanagements, zu erfassen. Dieser Leitfaden delv

KI in Verträgen: Ein umfassender Leitfaden für Anwaltsfachleute

Die künstliche Intelligenz (KI) hat in verschiedenen Branchen tiefgreifende Auswirkungen genommen, und der Rechtssektor ist keine Ausnahme. Da die KI -Technologie weiter voranschreitet, ist es für die juristischen Fachkräfte von entscheidender Bedeutung, ihr Potenzial und seine Einschränkungen, insbesondere im Bereich des Vertragsmanagements, zu erfassen. Dieser Leitfaden delv

Rekind: Kundenbetreuung durch KI -Videoanalyse transformieren

In der heutigen schnelllebigen Geschäftswelt ist die Bereitstellung erstklassiger Kundenunterstützung von entscheidender Bedeutung. Geben Sie die Realporation ein, einen Spielveränderer, der die Kraft von KI nutzt, um Kundenunterstützungsvideos zu analysieren. Es geht nicht nur darum, Probleme zu lösen. Es geht darum, die Kundenstimmung zu verstehen und Sprachbarrieren abzubauen

Rekind: Kundenbetreuung durch KI -Videoanalyse transformieren

In der heutigen schnelllebigen Geschäftswelt ist die Bereitstellung erstklassiger Kundenunterstützung von entscheidender Bedeutung. Geben Sie die Realporation ein, einen Spielveränderer, der die Kraft von KI nutzt, um Kundenunterstützungsvideos zu analysieren. Es geht nicht nur darum, Probleme zu lösen. Es geht darum, die Kundenstimmung zu verstehen und Sprachbarrieren abzubauen

Pixar enthüllt KI Tierarztkreationsstil -Leitfaden

Künstliche Intelligenz revolutioniert die kreative Welt und ermöglicht es jedem, mit nur wenigen Worten atemberaubende Bilder zu beschwören. Dies schließt das Handwerk von tierischen Charakteren im ikonischen Pixar -Stil ein, der für seinen Charme und seine emotionale Tiefe bekannt ist. Dieser Leitfaden führt Sie durch die Verwendung eines

Pixar enthüllt KI Tierarztkreationsstil -Leitfaden

Künstliche Intelligenz revolutioniert die kreative Welt und ermöglicht es jedem, mit nur wenigen Worten atemberaubende Bilder zu beschwören. Dies schließt das Handwerk von tierischen Charakteren im ikonischen Pixar -Stil ein, der für seinen Charme und seine emotionale Tiefe bekannt ist. Dieser Leitfaden führt Sie durch die Verwendung eines