Künstliche Intelligenz und Stimmensimulation: Wählerschutz vor gefälschten Stimmen

Der Aufstieg der künstlichen Intelligenz verändert unsere Welt und beeinflusst alles, von der Art und Weise, wie wir kommunizieren, bis hin zu unserer Stimmabgabe. Doch er wirft auch ernsthafte Herausforderungen für die Demokratie auf, insbesondere mit dem Aufkommen der AI-Stimmenklon-Technologie. Diese Technologie wird erschreckend gut darin, Stimmen nachzuahmen, und ist nicht nur ein cooler Partytrick – sie wird genutzt, um gefälschte Audios von politischen Persönlichkeiten zu erstellen und Lügen zu verbreiten, die Wahlen beeinflussen könnten. In diesem Artikel beleuchten wir die Gefahren dieser Technologie und untersuchen die Bemühungen, dieser neuen Bedrohung für faire Wahlen entgegenzuwirken.

Die wachsende Bedrohung durch AI-Stimmenklonen bei Wahlen

AI-Stimmenklonen verstehen

AI-Stimmenklonen verwendet künstliche Intelligenz, um eine digitale Version der Stimme einer Person zu erstellen. Es ist, als würde die Technologie eine Reihe deiner alten Reden anhören, deine einzigartigen stimmlichen Merkmale – wie die Höhe oder Tiefe deiner Stimme, deinen Tonfall und sogar deinen Rhythmus – erfassen und dann neue Audios erzeugen, die klingen, als wärst du es selbst. Das ist ziemlich praktisch für Dinge wie Hörbücher oder um Menschen zu helfen, die ihre Stimme verloren haben. Aber hier ist der Haken: Es kann auch für zwielichtige Dinge genutzt werden, wie gefälschte Nachrichten oder Betrug. Und weil es so überzeugend ist, sind die Fälschungen schwer zu erkennen, was ein großes Problem für Wahlen darstellt.

Je intelligenter AI wird, desto größer ist das Potenzial für Missbrauch. Es ist entscheidend, dass jeder diese Technologie versteht und aufmerksam bleibt, was er hört. Bei Wahlen könnte Stimmenklonen genutzt werden, um gefälschte Unterstützungsbekundungen zu erstellen, Lügen über Kandidaten zu verbreiten oder sich sogar als Kandidaten selbst auszugeben. Es ist leicht zu erkennen, wie dies Wähler verwirren und Wahlergebnisse beeinflussen könnte.

Die Leichtigkeit und Schnelligkeit der Erstellung gefälschter Audios

Was wirklich beunruhigend ist, ist, wie schnell und einfach diese gefälschten Audios erstellt werden können. Laut der Abgeordneten Penelope Serneglou hat jemand in weniger als fünf Minuten einen Stimmklon von Präsident Biden erstellt. Das ist erschreckend, weil es bedeutet, dass böswillige Akteure irreführende Audios in kürzester Zeit produzieren können, kurz vor Wahlen. Und die Herkunft dieser Fälschungen zurückzuverfolgen? Das ist, als würde man eine Nadel im Heuhaufen suchen, weil die Technologie so gut darin ist, Stimmen nachzuahmen.

Die Kosten für die Erstellung solcher Klone sind ebenfalls gesunken, was bedeutet, dass jeder mit einer Internetverbindung mitmischen kann. Keine High-Tech-Fähigkeiten oder tiefen Taschen nötig. Diese Demokratisierung der Technologie macht sie zu einer größeren Bedrohung für Wahlen. Wir brauchen Regeln, um dies unter Kontrolle zu halten und unser Wahlsystem zu schützen.

AI-generierte Robocalls: Ein Werkzeug zur Wählerunterdrückung

AI-Stimmenklonen ist nicht nur eine beängstigende Vorstellung – es passiert bereits. Die FCC hat AI-generierte Robocalls untersucht, die vorgaben, Präsident Biden zu sein und den Leuten sagten, ihre Stimme für November „aufzusparen“ und die Vorwahlen zu überspringen. Diese Anrufe sind eine hinterhältige Methode, um Menschen vom Wählen abzuhalten, und sie können schnell viele Menschen erreichen.

Während Robocalls nützlich sein können, sind sie auch ein Werkzeug, um Lügen zu verbreiten und Wähler einzuschüchtern. In vielen Orten ist es illegal, sie zur Wählerunterdrückung einzusetzen, aber die Täter zu fassen ist schwierig, wenn die Anrufe mit AI erstellt werden. Wir müssen Wähler aufklären, Werkzeuge entwickeln, um diese Anrufe zu erkennen, und sicherstellen, dass diejenigen, die sie missbrauchen, zur Rechenschaft gezogen werden.

Die Rolle sozialer Medien bei der Verbreitung AI-generierter Desinformation

Soziale Medien sind ein zweischneidiges Schwert. Sie sind toll, um Informationen schnell zu teilen, aber auch ein Nährboden für AI-generierte Lügen. Irina Raicu, eine Expertin für Internetethik, sagt, dass Social-Media-Plattformen nicht genug tun, um die Verbreitung von Deepfakes zu stoppen. Menschen teilen Inhalte, ohne zu prüfen, ob sie wahr sind, was das Problem verschlimmert.

Die Kombination aus AI-Stimmenklonen und der Reichweite sozialer Medien ist ein echtes Problem. Ein gefälschtes Audio kann in kürzester Zeit viral gehen und Millionen erreichen, bevor jemand beweisen kann, dass es falsch ist. Es wird auch genutzt, um gezielt bestimmte Wählergruppen mit maßgeschneiderten Lügen anzusprechen, was den Kampf dagegen noch schwieriger macht. Wir müssen Nutzer aufklären, Werkzeuge entwickeln, um AI-Fälschungen zu erkennen, und Social-Media-Plattformen zur Verantwortung ziehen.

Gesetzgeberische Bemühungen zur Regulierung von AI in politischer Werbung

Michigans bahnbrechende Gesetzgebung

Einige Staaten gehen das Problem direkt an. Michigan zum Beispiel hat dank der Abgeordneten Penelope Serneglou Gesetze verabschiedet, die vorschreiben, dass politische Werbung angeben muss, ob AI verwendet wurde. Dies hilft Wählern, AI-Inhalte zu erkennen und informiert über potenzielle Manipulationen zu bleiben.

Michigan prüft auch die Regulierung von AI in Robocalls, insbesondere solchen, die Wählern sagen, wohin sie gehen sollen. Das ist ein großer Schritt, um Wahlen fair zu halten, aber es ist nur der Anfang. Es gibt noch viel zu klären, wie zum Beispiel, wie man AI-Inhalte erkennt und Meinungsfreiheit mit dem Schutz der Wähler in Einklang bringt.

Wie können Bürger sich vor AI-generierter Desinformation schützen?

Wachsam bleiben und Informationen überprüfen

In der heutigen Welt, in der AI überzeugende Fälschungen erstellen kann, ist Wachsamkeit entscheidend. Überprüfe immer die Fakten, achte auf Voreingenommenheit und sei dir bewusst, dass das, was du siehst oder hörst, möglicherweise nicht echt ist. Nutze Werkzeuge wie Snopes oder PolitiFact, um Behauptungen zu verifizieren, und sei vorsichtig bei allem, was zu perfekt oder untypisch erscheint.

- Zweifle an Audio- und Videoaufnahmen: Wenn es zu schön klingt, um wahr zu sein, ist es das wahrscheinlich auch. Überprüfe die Audioqualität und das Verhalten der Person im Video.

- Achte auf Anzeichen von Manipulation: AI-Fälschungen könnten seltsame Pausen, komisches Audio oder unpassende Beleuchtung haben.

- Überprüfe Behauptungen: Bevor du etwas teilst, stelle sicher, dass es wahr ist, indem du es mit zuverlässigen Quellen abgleichst.

- Achte auf Voreingenommenheit: Sei vorsichtig bei einseitigen Geschichten oder übertrieben dramatischen Nachrichten.

- Aufklärung verbreiten: Teile dein Wissen über AI-Fälschungen, um anderen zu helfen, informiert zu bleiben.

Deepfakes und synthetische Medien erkennen

Deepfakes und andere synthetische Medien tauchen überall auf. Sie werden mit AI erstellt, um uns zu täuschen, und sie sind schwer zu erkennen. Achte auf unnatürliche Gesichtsausdrücke, verzerrtes Audio, inkonsistente Beleuchtung oder Gesichter, die zu perfekt aussehen. Wenn du diese Anzeichen siehst, sei vorsichtig und recherchiere, bevor du den Inhalt glaubst oder teilst.

Die Vor- und Nachteile der Regulierung von AI bei Wahlen

Vorteile

- Schützt die Integrität von Wahlen, indem die Verbreitung falscher Informationen gestoppt wird.

- Stärkt das Vertrauen der Wähler und das Bewusstsein für den Wahlprozess.

- Fördert Transparenz in politischer Werbung.

- Entmutigt böswillige Akteure, AI zu nutzen, um die Wahlbeteiligung zu beeinflussen.

- Bietet einen Plan zur Bewältigung zukünftiger AI-Herausforderungen.

Nachteile

- Könnte Innovationen und die Nutzung von AI für gute Zwecke einschränken.

- Könnte schwer durchzusetzen sein und von böswilligen Akteuren umgangen werden.

- Weckt Bedenken hinsichtlich Meinungsfreiheit und politischer Ausdrucksmöglichkeiten.

- Könnte genutzt werden, um unterschiedliche Meinungen zu unterdrücken oder zu zensieren.

- Könnte teuer in der Einrichtung und Aufrechterhaltung sein.

Häufig gestellte Fragen zu AI-Stimmenklonen

Was ist AI-Stimmenklonen und wie funktioniert es?

AI-Stimmenklonen ist, wenn AI vorhandene Stimm-Aufnahmen analysiert, einzigartige Merkmale wie Tonhöhe und Tonfall erfasst und dann neue Audios erstellt, die klingen wie der ursprüngliche Sprecher. Es wird für alles verwendet, von Hörbüchern bis hin zu Betrug, und es ist so gut geworden, dass es schwer ist, die Fälschungen vom Original zu unterscheiden.

Wie schnell können AI-Stimmklone erstellt werden?

Erschreckend schnell. Ein überzeugender Stimmklon kann in weniger als fünf Minuten erstellt werden, was besonders während Wahlen besorgniserregend ist, wenn falsche Audios sich wie ein Lauffeuer verbreiten können.

Was sind AI-generierte Robocalls und wie werden sie zur Wählerunterdrückung eingesetzt?

AI-generierte Robocalls sind automatisierte Anrufe, die geklonte Stimmen verwenden, um sich als jemand auszugeben, oft um falsche Informationen zu verbreiten oder das Wählen zu entmutigen. Sie sind eine hinterhältige Methode, um Wahlergebnisse zu beeinflussen, indem sie schnell viele Menschen erreichen.

Wie können Social-Media-Plattformen unbeabsichtigt AI-generierte Desinformation verbreiten?

Soziale Medien verbreiten Desinformation, weil sie darauf ausgelegt sind, Informationen schnell zu teilen, und Nutzer teilen oft Inhalte, ohne deren Wahrheit zu überprüfen. Das macht es schwer, AI-generierte Lügen zu stoppen.

Welche Beispiele gibt es für AI-generierte Desinformation?

Beispiele sind gefälschte Aussagen von politischen Kandidaten, erfundene Unterstützungsbekundungen von Prominenten, falsche Informationen über Wahllokale und Robocalls, die sich als Kandidaten ausgeben. AI-Bilder in Werbung sind ein weiterer Einsatzbereich.

Was tut Michigan, um AI-Desinformation in politischer Werbung entgegenzuwirken?

Michigan hat Gesetze verabschiedet, die vorschreiben, dass politische Werbung angeben muss, ob AI verwendet wurde, um Wählern zu helfen, AI-Inhalte zu erkennen. Sie arbeiten auch an der Regulierung von AI in Anrufen über Wahllokale, um Desinformation zu verhindern.

Gibt es Werkzeuge oder Ressourcen zur Identifizierung von AI-generierter Desinformation?

Ja, Werkzeuge wie Snopes, PolitiFact und Google Bildersuche können helfen, Behauptungen und Bilder zu verifizieren. Die Fähigkeit, AI-Fälschungen zu erkennen, ist entscheidend, um dein Geld und den demokratischen Prozess zu schützen.

Verwandter Artikel

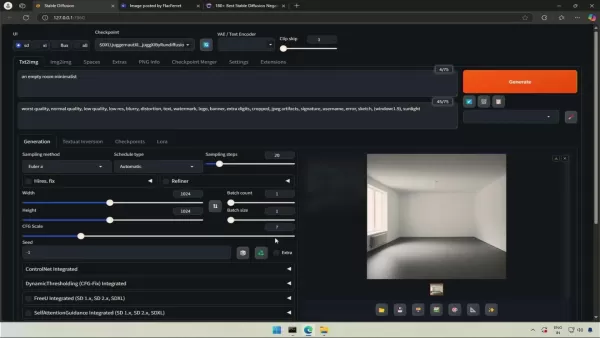

Vollständiger Leitfaden zur Beherrschung von Inpainting mit stabiler Diffusion

Stable Diffusion hat die KI-gestützte Bilderzeugung verändert, indem es eine noch nie dagewesene kreative Kontrolle bietet, insbesondere durch seine leistungsstarke Inpainting-Funktion. Dieses umfasse

Vollständiger Leitfaden zur Beherrschung von Inpainting mit stabiler Diffusion

Stable Diffusion hat die KI-gestützte Bilderzeugung verändert, indem es eine noch nie dagewesene kreative Kontrolle bietet, insbesondere durch seine leistungsstarke Inpainting-Funktion. Dieses umfasse

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

Kommentare (2)

0/200

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

Kommentare (2)

0/200

![JuanScott]() JuanScott

JuanScott

28. Juli 2025 03:19:30 MESZ

28. Juli 2025 03:19:30 MESZ

This AI voice cloning stuff is wild! It’s like something out of a sci-fi movie, but it’s real and messing with elections? That’s scary. I wonder how we can even trust what we hear anymore. 🫣

0

0

![JackWilson]() JackWilson

JackWilson

23. Juli 2025 06:59:29 MESZ

23. Juli 2025 06:59:29 MESZ

Whoa, AI voice cloning is wild! It’s creepy how real it sounds, but I’m worried about it messing with elections. Gotta stay sharp and check sources! 😬

0

0

Der Aufstieg der künstlichen Intelligenz verändert unsere Welt und beeinflusst alles, von der Art und Weise, wie wir kommunizieren, bis hin zu unserer Stimmabgabe. Doch er wirft auch ernsthafte Herausforderungen für die Demokratie auf, insbesondere mit dem Aufkommen der AI-Stimmenklon-Technologie. Diese Technologie wird erschreckend gut darin, Stimmen nachzuahmen, und ist nicht nur ein cooler Partytrick – sie wird genutzt, um gefälschte Audios von politischen Persönlichkeiten zu erstellen und Lügen zu verbreiten, die Wahlen beeinflussen könnten. In diesem Artikel beleuchten wir die Gefahren dieser Technologie und untersuchen die Bemühungen, dieser neuen Bedrohung für faire Wahlen entgegenzuwirken.

Die wachsende Bedrohung durch AI-Stimmenklonen bei Wahlen

AI-Stimmenklonen verstehen

AI-Stimmenklonen verwendet künstliche Intelligenz, um eine digitale Version der Stimme einer Person zu erstellen. Es ist, als würde die Technologie eine Reihe deiner alten Reden anhören, deine einzigartigen stimmlichen Merkmale – wie die Höhe oder Tiefe deiner Stimme, deinen Tonfall und sogar deinen Rhythmus – erfassen und dann neue Audios erzeugen, die klingen, als wärst du es selbst. Das ist ziemlich praktisch für Dinge wie Hörbücher oder um Menschen zu helfen, die ihre Stimme verloren haben. Aber hier ist der Haken: Es kann auch für zwielichtige Dinge genutzt werden, wie gefälschte Nachrichten oder Betrug. Und weil es so überzeugend ist, sind die Fälschungen schwer zu erkennen, was ein großes Problem für Wahlen darstellt.

Je intelligenter AI wird, desto größer ist das Potenzial für Missbrauch. Es ist entscheidend, dass jeder diese Technologie versteht und aufmerksam bleibt, was er hört. Bei Wahlen könnte Stimmenklonen genutzt werden, um gefälschte Unterstützungsbekundungen zu erstellen, Lügen über Kandidaten zu verbreiten oder sich sogar als Kandidaten selbst auszugeben. Es ist leicht zu erkennen, wie dies Wähler verwirren und Wahlergebnisse beeinflussen könnte.

Die Leichtigkeit und Schnelligkeit der Erstellung gefälschter Audios

Was wirklich beunruhigend ist, ist, wie schnell und einfach diese gefälschten Audios erstellt werden können. Laut der Abgeordneten Penelope Serneglou hat jemand in weniger als fünf Minuten einen Stimmklon von Präsident Biden erstellt. Das ist erschreckend, weil es bedeutet, dass böswillige Akteure irreführende Audios in kürzester Zeit produzieren können, kurz vor Wahlen. Und die Herkunft dieser Fälschungen zurückzuverfolgen? Das ist, als würde man eine Nadel im Heuhaufen suchen, weil die Technologie so gut darin ist, Stimmen nachzuahmen.

Die Kosten für die Erstellung solcher Klone sind ebenfalls gesunken, was bedeutet, dass jeder mit einer Internetverbindung mitmischen kann. Keine High-Tech-Fähigkeiten oder tiefen Taschen nötig. Diese Demokratisierung der Technologie macht sie zu einer größeren Bedrohung für Wahlen. Wir brauchen Regeln, um dies unter Kontrolle zu halten und unser Wahlsystem zu schützen.

AI-generierte Robocalls: Ein Werkzeug zur Wählerunterdrückung

AI-Stimmenklonen ist nicht nur eine beängstigende Vorstellung – es passiert bereits. Die FCC hat AI-generierte Robocalls untersucht, die vorgaben, Präsident Biden zu sein und den Leuten sagten, ihre Stimme für November „aufzusparen“ und die Vorwahlen zu überspringen. Diese Anrufe sind eine hinterhältige Methode, um Menschen vom Wählen abzuhalten, und sie können schnell viele Menschen erreichen.

Während Robocalls nützlich sein können, sind sie auch ein Werkzeug, um Lügen zu verbreiten und Wähler einzuschüchtern. In vielen Orten ist es illegal, sie zur Wählerunterdrückung einzusetzen, aber die Täter zu fassen ist schwierig, wenn die Anrufe mit AI erstellt werden. Wir müssen Wähler aufklären, Werkzeuge entwickeln, um diese Anrufe zu erkennen, und sicherstellen, dass diejenigen, die sie missbrauchen, zur Rechenschaft gezogen werden.

Die Rolle sozialer Medien bei der Verbreitung AI-generierter Desinformation

Soziale Medien sind ein zweischneidiges Schwert. Sie sind toll, um Informationen schnell zu teilen, aber auch ein Nährboden für AI-generierte Lügen. Irina Raicu, eine Expertin für Internetethik, sagt, dass Social-Media-Plattformen nicht genug tun, um die Verbreitung von Deepfakes zu stoppen. Menschen teilen Inhalte, ohne zu prüfen, ob sie wahr sind, was das Problem verschlimmert.

Die Kombination aus AI-Stimmenklonen und der Reichweite sozialer Medien ist ein echtes Problem. Ein gefälschtes Audio kann in kürzester Zeit viral gehen und Millionen erreichen, bevor jemand beweisen kann, dass es falsch ist. Es wird auch genutzt, um gezielt bestimmte Wählergruppen mit maßgeschneiderten Lügen anzusprechen, was den Kampf dagegen noch schwieriger macht. Wir müssen Nutzer aufklären, Werkzeuge entwickeln, um AI-Fälschungen zu erkennen, und Social-Media-Plattformen zur Verantwortung ziehen.

Gesetzgeberische Bemühungen zur Regulierung von AI in politischer Werbung

Michigans bahnbrechende Gesetzgebung

Einige Staaten gehen das Problem direkt an. Michigan zum Beispiel hat dank der Abgeordneten Penelope Serneglou Gesetze verabschiedet, die vorschreiben, dass politische Werbung angeben muss, ob AI verwendet wurde. Dies hilft Wählern, AI-Inhalte zu erkennen und informiert über potenzielle Manipulationen zu bleiben.

Michigan prüft auch die Regulierung von AI in Robocalls, insbesondere solchen, die Wählern sagen, wohin sie gehen sollen. Das ist ein großer Schritt, um Wahlen fair zu halten, aber es ist nur der Anfang. Es gibt noch viel zu klären, wie zum Beispiel, wie man AI-Inhalte erkennt und Meinungsfreiheit mit dem Schutz der Wähler in Einklang bringt.

Wie können Bürger sich vor AI-generierter Desinformation schützen?

Wachsam bleiben und Informationen überprüfen

In der heutigen Welt, in der AI überzeugende Fälschungen erstellen kann, ist Wachsamkeit entscheidend. Überprüfe immer die Fakten, achte auf Voreingenommenheit und sei dir bewusst, dass das, was du siehst oder hörst, möglicherweise nicht echt ist. Nutze Werkzeuge wie Snopes oder PolitiFact, um Behauptungen zu verifizieren, und sei vorsichtig bei allem, was zu perfekt oder untypisch erscheint.

- Zweifle an Audio- und Videoaufnahmen: Wenn es zu schön klingt, um wahr zu sein, ist es das wahrscheinlich auch. Überprüfe die Audioqualität und das Verhalten der Person im Video.

- Achte auf Anzeichen von Manipulation: AI-Fälschungen könnten seltsame Pausen, komisches Audio oder unpassende Beleuchtung haben.

- Überprüfe Behauptungen: Bevor du etwas teilst, stelle sicher, dass es wahr ist, indem du es mit zuverlässigen Quellen abgleichst.

- Achte auf Voreingenommenheit: Sei vorsichtig bei einseitigen Geschichten oder übertrieben dramatischen Nachrichten.

- Aufklärung verbreiten: Teile dein Wissen über AI-Fälschungen, um anderen zu helfen, informiert zu bleiben.

Deepfakes und synthetische Medien erkennen

Deepfakes und andere synthetische Medien tauchen überall auf. Sie werden mit AI erstellt, um uns zu täuschen, und sie sind schwer zu erkennen. Achte auf unnatürliche Gesichtsausdrücke, verzerrtes Audio, inkonsistente Beleuchtung oder Gesichter, die zu perfekt aussehen. Wenn du diese Anzeichen siehst, sei vorsichtig und recherchiere, bevor du den Inhalt glaubst oder teilst.

Die Vor- und Nachteile der Regulierung von AI bei Wahlen

Vorteile

- Schützt die Integrität von Wahlen, indem die Verbreitung falscher Informationen gestoppt wird.

- Stärkt das Vertrauen der Wähler und das Bewusstsein für den Wahlprozess.

- Fördert Transparenz in politischer Werbung.

- Entmutigt böswillige Akteure, AI zu nutzen, um die Wahlbeteiligung zu beeinflussen.

- Bietet einen Plan zur Bewältigung zukünftiger AI-Herausforderungen.

Nachteile

- Könnte Innovationen und die Nutzung von AI für gute Zwecke einschränken.

- Könnte schwer durchzusetzen sein und von böswilligen Akteuren umgangen werden.

- Weckt Bedenken hinsichtlich Meinungsfreiheit und politischer Ausdrucksmöglichkeiten.

- Könnte genutzt werden, um unterschiedliche Meinungen zu unterdrücken oder zu zensieren.

- Könnte teuer in der Einrichtung und Aufrechterhaltung sein.

Häufig gestellte Fragen zu AI-Stimmenklonen

Was ist AI-Stimmenklonen und wie funktioniert es?

AI-Stimmenklonen ist, wenn AI vorhandene Stimm-Aufnahmen analysiert, einzigartige Merkmale wie Tonhöhe und Tonfall erfasst und dann neue Audios erstellt, die klingen wie der ursprüngliche Sprecher. Es wird für alles verwendet, von Hörbüchern bis hin zu Betrug, und es ist so gut geworden, dass es schwer ist, die Fälschungen vom Original zu unterscheiden.

Wie schnell können AI-Stimmklone erstellt werden?

Erschreckend schnell. Ein überzeugender Stimmklon kann in weniger als fünf Minuten erstellt werden, was besonders während Wahlen besorgniserregend ist, wenn falsche Audios sich wie ein Lauffeuer verbreiten können.

Was sind AI-generierte Robocalls und wie werden sie zur Wählerunterdrückung eingesetzt?

AI-generierte Robocalls sind automatisierte Anrufe, die geklonte Stimmen verwenden, um sich als jemand auszugeben, oft um falsche Informationen zu verbreiten oder das Wählen zu entmutigen. Sie sind eine hinterhältige Methode, um Wahlergebnisse zu beeinflussen, indem sie schnell viele Menschen erreichen.

Wie können Social-Media-Plattformen unbeabsichtigt AI-generierte Desinformation verbreiten?

Soziale Medien verbreiten Desinformation, weil sie darauf ausgelegt sind, Informationen schnell zu teilen, und Nutzer teilen oft Inhalte, ohne deren Wahrheit zu überprüfen. Das macht es schwer, AI-generierte Lügen zu stoppen.

Welche Beispiele gibt es für AI-generierte Desinformation?

Beispiele sind gefälschte Aussagen von politischen Kandidaten, erfundene Unterstützungsbekundungen von Prominenten, falsche Informationen über Wahllokale und Robocalls, die sich als Kandidaten ausgeben. AI-Bilder in Werbung sind ein weiterer Einsatzbereich.

Was tut Michigan, um AI-Desinformation in politischer Werbung entgegenzuwirken?

Michigan hat Gesetze verabschiedet, die vorschreiben, dass politische Werbung angeben muss, ob AI verwendet wurde, um Wählern zu helfen, AI-Inhalte zu erkennen. Sie arbeiten auch an der Regulierung von AI in Anrufen über Wahllokale, um Desinformation zu verhindern.

Gibt es Werkzeuge oder Ressourcen zur Identifizierung von AI-generierter Desinformation?

Ja, Werkzeuge wie Snopes, PolitiFact und Google Bildersuche können helfen, Behauptungen und Bilder zu verifizieren. Die Fähigkeit, AI-Fälschungen zu erkennen, ist entscheidend, um dein Geld und den demokratischen Prozess zu schützen.

Vollständiger Leitfaden zur Beherrschung von Inpainting mit stabiler Diffusion

Stable Diffusion hat die KI-gestützte Bilderzeugung verändert, indem es eine noch nie dagewesene kreative Kontrolle bietet, insbesondere durch seine leistungsstarke Inpainting-Funktion. Dieses umfasse

Vollständiger Leitfaden zur Beherrschung von Inpainting mit stabiler Diffusion

Stable Diffusion hat die KI-gestützte Bilderzeugung verändert, indem es eine noch nie dagewesene kreative Kontrolle bietet, insbesondere durch seine leistungsstarke Inpainting-Funktion. Dieses umfasse

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

Adobe Substance 3D Viewer integriert AI für erweiterte 3D-Modellierung

Mit dem revolutionären Substance 3D Viewer erweitert Adobe die kreativen Grenzen und verändert die Art und Weise, wie Designer mit 3D-Inhalten in ihrem digitalen Workflow interagieren. Mit diesem bahn

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

AI-Fotobearbeitung mit CapCut meistern: Professionelle Anleitung & Tipps

CapCut ist nicht nur für die Videobearbeitung bekannt, sondern bietet auch erstaunlich robuste KI-gestützte Fotobearbeitungsfunktionen. Dieses umfassende Tutorial zeigt, wie Sie die intelligenten Werk

28. Juli 2025 03:19:30 MESZ

28. Juli 2025 03:19:30 MESZ

This AI voice cloning stuff is wild! It’s like something out of a sci-fi movie, but it’s real and messing with elections? That’s scary. I wonder how we can even trust what we hear anymore. 🫣

0

0

23. Juli 2025 06:59:29 MESZ

23. Juli 2025 06:59:29 MESZ

Whoa, AI voice cloning is wild! It’s creepy how real it sounds, but I’m worried about it messing with elections. Gotta stay sharp and check sources! 😬

0

0