AI語音克隆:選舉威脅與如何保護自己

人工智能的崛起正在重塑我們的世界,影響從我們如何溝通到如何投票的一切。然而,它也對民主帶來了一些嚴重的挑戰,特別是隨著AI語音克隆技術的出現。這項技術在模仿語音方面變得越來越逼真,不僅僅是一個有趣的派對把戲——它被用來製作政治人物的假語音,傳播可能影響選舉的謊言。在本文中,我們將深入探討這項技術的危險性,並探索應對這一新興威脅以確保公平投票的努力。

AI語音克隆在選舉中的日益增長的威脅

了解AI語音克隆

AI語音克隆使用人工智能來創建某人語音的數位版本。這項技術會分析你過去的演講,捕捉你獨特的語音特徵——比如聲音的高低、語調,甚至是你的節奏——然後生成聽起來像你的新語音。這對有聲書或幫助失去聲音的人來說非常有用。但問題在於:它也可能被用於一些不道德的事情,比如偽造新聞或詐騙他人。由於它如此逼真,很難分辨真假,這對選舉來說是一個重大隱憂。

隨著AI變得越來越聰明,濫用的可能性也在增加。每個人都需要了解這項技術,並對聽到的內容保持警覺。在選舉中,語音克隆可能被用來偽造背書、傳播關於候選人的謊言,甚至假冒候選人本人。很容易看出這可能會讓選民感到困惑,並干擾選舉結果。

製作假語音的簡單與快速

真正令人震驚的是製作這些假語音的速度和簡單程度。根據州議員Penelope Serneglou的說法,有人能在不到五分鐘內製作出一段拜登總統的語音克隆。這太可怕了,因為這意味著不良行為者可以在選舉前迅速製造出誤導性語音。追蹤這些假語音的來源?就像大海撈針,因為這項技術在複製語音方面太厲害了。

製作這些克隆的成本也在下降,這意味著任何有網路連線的人都可以參與其中。不需要高科技技能或雄厚的資金。這種技術的普及使其對選舉構成更大的威脅。我們需要制定規則來控制這一問題,保護我們的投票系統。

AI生成的自動語音電話:選民壓制的工具

AI語音克隆不僅是一個可怕的想法——它已經在發生。聯邦通訊委員會(FCC)一直在調查假冒拜登總統的AI生成自動語音電話,這些電話告訴人們將他們的選票「留到十一月」,跳過初選。這些電話是一種阻止人們投票的隱秘方式,而且它們可以迅速接觸到大量人群。

雖然自動語音電話可能很有用,但它們也被用來傳播謊言和恐嚇選民。在許多地方,使用它們來壓制選民是非法的,但當這些電話是用AI製作時,抓到罪魁禍首很困難。我們需要教育選民,開發工具來識別這些電話,並確保濫用者的行為得到懲罰。

社交媒體在傳播AI生成誤信息的角色

社交媒體是一把雙刃劍。它非常適合快速分享資訊,但也為AI生成的謊言提供了滋生地。網路倫理專家Irina Raicu表示,社交媒體平台在阻止深度偽造的傳播方面做得還不夠。人們在分享內容時不檢查是否真實,這讓問題變得更糟。

AI語音克隆與社交媒體的廣泛影響相結合,真是讓人頭痛。假語音可以在短時間內迅速傳播,影響數百萬人,而在有人證明它是假的之前已經傳得沸沸揚揚。它還被用來針對特定選民群體,散布量身定制的謊言,使反擊更加困難。我們需要教育用戶,開發工具來捕捉AI偽造內容,並讓社交媒體平台承擔責任。

規範政治廣告中AI的立法努力

密西根的開創性立法

一些州正在積極應對這個問題。例如,密西根在州議員Penelope Serneglou的推動下通過了法律,要求政治廣告必須說明是否使用了AI。這有助於選民識別AI內容,並了解可能的操縱行為。

密西根也在考慮規範自動語音電話中的AI使用,特別是那些告訴選民去哪投票的電話。這是確保選舉公平的一大舉措,但這只是開始。還有許多問題需要解決,比如如何識別AI內容,以及如何在保護選民和平衡言論自由之間找到平衡。

公民如何保護自己免受AI生成的誤信息影響?

保持警覺並驗證資訊

在當今世界,AI可以創造出令人信服的偽造內容,保持敏銳至關重要。始終進行事實核查,尋找偏見,並意識到你看到或聽到的東西可能不是真的。使用Snopes或PolitiFact等工具來驗證說法,對任何看起來太完美或不尋常的內容保持警惕。

- 對音頻和影片保持懷疑:如果聽起來好得令人難以置信,可能就是假的。檢查音頻質量和影片中人的行為。

- 尋找操縱痕跡:AI偽造內容可能有奇怪的停頓、異常的音頻或不協調的燈光。

- 核查事實:在分享任何內容之前,確保它是真的,通過可靠來源進行檢查。

- 注意偏見:小心單方面的故事或過於誇張的新聞。

- 教育他人:分享你對AI偽造的了解,幫助他人保持警覺。

識別深度偽造與合成媒體

深度偽造和其他合成媒體無處不在。它們使用AI製作,目的是欺騙我們,而且很難識別。注意不自然的臉部表情、扭曲的音頻、不一致的燈光或看起來過於完美的面孔。如果看到這些跡象,要謹慎,在相信或分享內容之前進行研究。

規範選舉中AI的利與弊

優點

- 通過阻止虛假資訊的傳播,保護選舉的完整性。

- 提升選民對投票過程的信任和意識。

- 促進政治廣告的透明度。

- 阻止不良行為者使用AI影響選民參與。

- 為應對未來的AI挑戰提供計畫。

缺點

- 可能限制創新和AI的正當用途。

- 可能難以執行,且可能被不良行為者規避。

- 引發對言論自由和政治表達權利的擔憂。

- 可能被用來壓制或審查不同意見。

- 建立和維持可能成本高昂。

關於AI語音克隆的常見問題

什麼是AI語音克隆,它是如何運作的?

AI語音克隆是AI分析現有語音錄音,捕捉語調和音高等獨特特徵,然後創建聽起來與原講者相同的新語音。它被用於從有聲書到詐騙的各種用途,而且越來越逼真,很難分辨真假。

AI語音克隆的製作速度有多快?

快得可怕。一個可信的語音克隆可以在不到五分鐘內製作完成,這在選舉期間尤其令人擔憂,因為假語音可能像野火般迅速傳播。

什麼是AI生成的自動語音電話,它們如何被用於選民壓制?

AI生成的自動語音電話是使用克隆語音冒充某人的自動電話,通常用來傳播虛假資訊或阻止投票。它們是一種影響選舉結果的隱秘方式,可以迅速接觸到大量人群。

社交媒體平台如何無意中傳播AI語音克隆生成的誤信息?

社交媒體因其快速分享資訊的設計而傳播誤信息,用戶常常在不核查真偽的情況下分享內容。這使得阻止AI生成的謊言傳播變得困難。

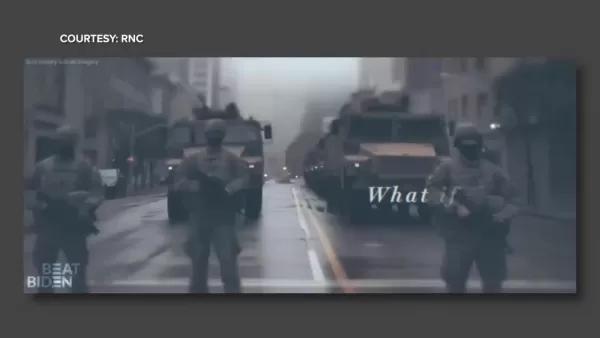

AI生成的誤信息有哪些例子?

例子包括政治候選人的假聲明、名人虛構的背書、關於投票地點的錯誤資訊,以及假冒候選人的自動語音電話。廣告中的AI圖像也是另一種使用方式。

密西根在應對政治廣告中的AI誤信息方面做了什麼?

密西根通過法律要求政治廣告披露是否使用了AI,幫助選民識別AI內容。他們也在努力規範關於投票地點的電話中的AI使用,以防止誤信息。

有哪些工具或資源可以用來識別AI生成的誤信息?

是的,Snopes、PolitiFact和Google圖像搜尋等工具可以幫助你驗證說法和圖像。能夠識別AI偽造內容對於保護你的錢包和民主進程至關重要。

相關文章

Nvidia 公布第二季營收的 39% 來自兩大客戶

Nvidia 的營收集中度突顯 AI 蓬勃發展的依賴性這家晶片製造商最近向美國證券交易委員會(SEC)提交的文件顯示了驚人的客戶集中度,在 Nvidia 創紀錄的 467 億美元第二季營收中,兩家未具名客戶就佔了 39%,在 AI 基礎設施需求激增的推動下,年增幅達 56%。根據監管文件:單一客戶(「客戶 A」)貢獻了季度總營收的 23另一位買家 (「客戶 B」) 佔第二季銷售額的 16另外四位直

Nvidia 公布第二季營收的 39% 來自兩大客戶

Nvidia 的營收集中度突顯 AI 蓬勃發展的依賴性這家晶片製造商最近向美國證券交易委員會(SEC)提交的文件顯示了驚人的客戶集中度,在 Nvidia 創紀錄的 467 億美元第二季營收中,兩家未具名客戶就佔了 39%,在 AI 基礎設施需求激增的推動下,年增幅達 56%。根據監管文件:單一客戶(「客戶 A」)貢獻了季度總營收的 23另一位買家 (「客戶 B」) 佔第二季銷售額的 16另外四位直

AI 商業計劃生成器:快速建立您的致勝策略

當 AI 解決方案能在數分鐘內提供專業品質的策略文件時,現代企業家已經無法再花費數週的時間來撰寫業務計劃。透過智慧型平台分析資料、識別機會,並比傳統方法更快速地產生可執行的計劃,商業規劃的面貌已大幅改變。本指南將探討人工智慧如何消除專業商業策略發展的障礙,讓初創公司和成熟公司都能進行精密的規劃。主要優勢閃電式快速轉換:人工智慧可在 15 分鐘內制定出適合投資人的商業計畫。Partita IVA 平

AI 商業計劃生成器:快速建立您的致勝策略

當 AI 解決方案能在數分鐘內提供專業品質的策略文件時,現代企業家已經無法再花費數週的時間來撰寫業務計劃。透過智慧型平台分析資料、識別機會,並比傳統方法更快速地產生可執行的計劃,商業規劃的面貌已大幅改變。本指南將探討人工智慧如何消除專業商業策略發展的障礙,讓初創公司和成熟公司都能進行精密的規劃。主要優勢閃電式快速轉換:人工智慧可在 15 分鐘內制定出適合投資人的商業計畫。Partita IVA 平

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

評論 (2)

0/200

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

評論 (2)

0/200

![JuanScott]() JuanScott

JuanScott

2025-07-28 09:19:30

2025-07-28 09:19:30

This AI voice cloning stuff is wild! It’s like something out of a sci-fi movie, but it’s real and messing with elections? That’s scary. I wonder how we can even trust what we hear anymore. 🫣

0

0

![JackWilson]() JackWilson

JackWilson

2025-07-23 12:59:29

2025-07-23 12:59:29

Whoa, AI voice cloning is wild! It’s creepy how real it sounds, but I’m worried about it messing with elections. Gotta stay sharp and check sources! 😬

0

0

人工智能的崛起正在重塑我們的世界,影響從我們如何溝通到如何投票的一切。然而,它也對民主帶來了一些嚴重的挑戰,特別是隨著AI語音克隆技術的出現。這項技術在模仿語音方面變得越來越逼真,不僅僅是一個有趣的派對把戲——它被用來製作政治人物的假語音,傳播可能影響選舉的謊言。在本文中,我們將深入探討這項技術的危險性,並探索應對這一新興威脅以確保公平投票的努力。

AI語音克隆在選舉中的日益增長的威脅

了解AI語音克隆

AI語音克隆使用人工智能來創建某人語音的數位版本。這項技術會分析你過去的演講,捕捉你獨特的語音特徵——比如聲音的高低、語調,甚至是你的節奏——然後生成聽起來像你的新語音。這對有聲書或幫助失去聲音的人來說非常有用。但問題在於:它也可能被用於一些不道德的事情,比如偽造新聞或詐騙他人。由於它如此逼真,很難分辨真假,這對選舉來說是一個重大隱憂。

隨著AI變得越來越聰明,濫用的可能性也在增加。每個人都需要了解這項技術,並對聽到的內容保持警覺。在選舉中,語音克隆可能被用來偽造背書、傳播關於候選人的謊言,甚至假冒候選人本人。很容易看出這可能會讓選民感到困惑,並干擾選舉結果。

製作假語音的簡單與快速

真正令人震驚的是製作這些假語音的速度和簡單程度。根據州議員Penelope Serneglou的說法,有人能在不到五分鐘內製作出一段拜登總統的語音克隆。這太可怕了,因為這意味著不良行為者可以在選舉前迅速製造出誤導性語音。追蹤這些假語音的來源?就像大海撈針,因為這項技術在複製語音方面太厲害了。

製作這些克隆的成本也在下降,這意味著任何有網路連線的人都可以參與其中。不需要高科技技能或雄厚的資金。這種技術的普及使其對選舉構成更大的威脅。我們需要制定規則來控制這一問題,保護我們的投票系統。

AI生成的自動語音電話:選民壓制的工具

AI語音克隆不僅是一個可怕的想法——它已經在發生。聯邦通訊委員會(FCC)一直在調查假冒拜登總統的AI生成自動語音電話,這些電話告訴人們將他們的選票「留到十一月」,跳過初選。這些電話是一種阻止人們投票的隱秘方式,而且它們可以迅速接觸到大量人群。

雖然自動語音電話可能很有用,但它們也被用來傳播謊言和恐嚇選民。在許多地方,使用它們來壓制選民是非法的,但當這些電話是用AI製作時,抓到罪魁禍首很困難。我們需要教育選民,開發工具來識別這些電話,並確保濫用者的行為得到懲罰。

社交媒體在傳播AI生成誤信息的角色

社交媒體是一把雙刃劍。它非常適合快速分享資訊,但也為AI生成的謊言提供了滋生地。網路倫理專家Irina Raicu表示,社交媒體平台在阻止深度偽造的傳播方面做得還不夠。人們在分享內容時不檢查是否真實,這讓問題變得更糟。

AI語音克隆與社交媒體的廣泛影響相結合,真是讓人頭痛。假語音可以在短時間內迅速傳播,影響數百萬人,而在有人證明它是假的之前已經傳得沸沸揚揚。它還被用來針對特定選民群體,散布量身定制的謊言,使反擊更加困難。我們需要教育用戶,開發工具來捕捉AI偽造內容,並讓社交媒體平台承擔責任。

規範政治廣告中AI的立法努力

密西根的開創性立法

一些州正在積極應對這個問題。例如,密西根在州議員Penelope Serneglou的推動下通過了法律,要求政治廣告必須說明是否使用了AI。這有助於選民識別AI內容,並了解可能的操縱行為。

密西根也在考慮規範自動語音電話中的AI使用,特別是那些告訴選民去哪投票的電話。這是確保選舉公平的一大舉措,但這只是開始。還有許多問題需要解決,比如如何識別AI內容,以及如何在保護選民和平衡言論自由之間找到平衡。

公民如何保護自己免受AI生成的誤信息影響?

保持警覺並驗證資訊

在當今世界,AI可以創造出令人信服的偽造內容,保持敏銳至關重要。始終進行事實核查,尋找偏見,並意識到你看到或聽到的東西可能不是真的。使用Snopes或PolitiFact等工具來驗證說法,對任何看起來太完美或不尋常的內容保持警惕。

- 對音頻和影片保持懷疑:如果聽起來好得令人難以置信,可能就是假的。檢查音頻質量和影片中人的行為。

- 尋找操縱痕跡:AI偽造內容可能有奇怪的停頓、異常的音頻或不協調的燈光。

- 核查事實:在分享任何內容之前,確保它是真的,通過可靠來源進行檢查。

- 注意偏見:小心單方面的故事或過於誇張的新聞。

- 教育他人:分享你對AI偽造的了解,幫助他人保持警覺。

識別深度偽造與合成媒體

深度偽造和其他合成媒體無處不在。它們使用AI製作,目的是欺騙我們,而且很難識別。注意不自然的臉部表情、扭曲的音頻、不一致的燈光或看起來過於完美的面孔。如果看到這些跡象,要謹慎,在相信或分享內容之前進行研究。

規範選舉中AI的利與弊

優點

- 通過阻止虛假資訊的傳播,保護選舉的完整性。

- 提升選民對投票過程的信任和意識。

- 促進政治廣告的透明度。

- 阻止不良行為者使用AI影響選民參與。

- 為應對未來的AI挑戰提供計畫。

缺點

- 可能限制創新和AI的正當用途。

- 可能難以執行,且可能被不良行為者規避。

- 引發對言論自由和政治表達權利的擔憂。

- 可能被用來壓制或審查不同意見。

- 建立和維持可能成本高昂。

關於AI語音克隆的常見問題

什麼是AI語音克隆,它是如何運作的?

AI語音克隆是AI分析現有語音錄音,捕捉語調和音高等獨特特徵,然後創建聽起來與原講者相同的新語音。它被用於從有聲書到詐騙的各種用途,而且越來越逼真,很難分辨真假。

AI語音克隆的製作速度有多快?

快得可怕。一個可信的語音克隆可以在不到五分鐘內製作完成,這在選舉期間尤其令人擔憂,因為假語音可能像野火般迅速傳播。

什麼是AI生成的自動語音電話,它們如何被用於選民壓制?

AI生成的自動語音電話是使用克隆語音冒充某人的自動電話,通常用來傳播虛假資訊或阻止投票。它們是一種影響選舉結果的隱秘方式,可以迅速接觸到大量人群。

社交媒體平台如何無意中傳播AI語音克隆生成的誤信息?

社交媒體因其快速分享資訊的設計而傳播誤信息,用戶常常在不核查真偽的情況下分享內容。這使得阻止AI生成的謊言傳播變得困難。

AI生成的誤信息有哪些例子?

例子包括政治候選人的假聲明、名人虛構的背書、關於投票地點的錯誤資訊,以及假冒候選人的自動語音電話。廣告中的AI圖像也是另一種使用方式。

密西根在應對政治廣告中的AI誤信息方面做了什麼?

密西根通過法律要求政治廣告披露是否使用了AI,幫助選民識別AI內容。他們也在努力規範關於投票地點的電話中的AI使用,以防止誤信息。

有哪些工具或資源可以用來識別AI生成的誤信息?

是的,Snopes、PolitiFact和Google圖像搜尋等工具可以幫助你驗證說法和圖像。能夠識別AI偽造內容對於保護你的錢包和民主進程至關重要。

Nvidia 公布第二季營收的 39% 來自兩大客戶

Nvidia 的營收集中度突顯 AI 蓬勃發展的依賴性這家晶片製造商最近向美國證券交易委員會(SEC)提交的文件顯示了驚人的客戶集中度,在 Nvidia 創紀錄的 467 億美元第二季營收中,兩家未具名客戶就佔了 39%,在 AI 基礎設施需求激增的推動下,年增幅達 56%。根據監管文件:單一客戶(「客戶 A」)貢獻了季度總營收的 23另一位買家 (「客戶 B」) 佔第二季銷售額的 16另外四位直

Nvidia 公布第二季營收的 39% 來自兩大客戶

Nvidia 的營收集中度突顯 AI 蓬勃發展的依賴性這家晶片製造商最近向美國證券交易委員會(SEC)提交的文件顯示了驚人的客戶集中度,在 Nvidia 創紀錄的 467 億美元第二季營收中,兩家未具名客戶就佔了 39%,在 AI 基礎設施需求激增的推動下,年增幅達 56%。根據監管文件:單一客戶(「客戶 A」)貢獻了季度總營收的 23另一位買家 (「客戶 B」) 佔第二季銷售額的 16另外四位直

AI 商業計劃生成器:快速建立您的致勝策略

當 AI 解決方案能在數分鐘內提供專業品質的策略文件時,現代企業家已經無法再花費數週的時間來撰寫業務計劃。透過智慧型平台分析資料、識別機會,並比傳統方法更快速地產生可執行的計劃,商業規劃的面貌已大幅改變。本指南將探討人工智慧如何消除專業商業策略發展的障礙,讓初創公司和成熟公司都能進行精密的規劃。主要優勢閃電式快速轉換:人工智慧可在 15 分鐘內制定出適合投資人的商業計畫。Partita IVA 平

AI 商業計劃生成器:快速建立您的致勝策略

當 AI 解決方案能在數分鐘內提供專業品質的策略文件時,現代企業家已經無法再花費數週的時間來撰寫業務計劃。透過智慧型平台分析資料、識別機會,並比傳統方法更快速地產生可執行的計劃,商業規劃的面貌已大幅改變。本指南將探討人工智慧如何消除專業商業策略發展的障礙,讓初創公司和成熟公司都能進行精密的規劃。主要優勢閃電式快速轉換:人工智慧可在 15 分鐘內制定出適合投資人的商業計畫。Partita IVA 平

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

漫威延遲《復仇者聯盟》下兩部電影,調整第六階段上映時間表

Marvel Studios 宣佈即將上映的《復仇者聯盟》系列電影在時間表上有重大變更。業界刊物The Hollywood Reporter透露《復仇者聯盟》將於 2026年12 月 18日上映,而非原定的 2026 年 5 月 1 日:末日危機》將於 2026 年 12 月 18 日上映,而非原定的 2026 年 5 月 1 日。其續集《復仇者聯盟:秘密戰爭》(Avengers:Secret W

2025-07-28 09:19:30

2025-07-28 09:19:30

This AI voice cloning stuff is wild! It’s like something out of a sci-fi movie, but it’s real and messing with elections? That’s scary. I wonder how we can even trust what we hear anymore. 🫣

0

0

2025-07-23 12:59:29

2025-07-23 12:59:29

Whoa, AI voice cloning is wild! It’s creepy how real it sounds, but I’m worried about it messing with elections. Gotta stay sharp and check sources! 😬

0

0