KI -Crawler Surge Wikimedia Commons Bandbreitennachfrage um 50%

Die Wikimedia Foundation, die Mutterorganisation hinter Wikipedia und zahlreichen anderen kollaborativen Wissensplattformen, gab am Mittwoch einen erstaunlichen Anstieg des Bandbreitenverbrauchs für Multimediadownloads von Wikimedia Commons um 50 % seit Januar 2024 bekannt. Dieser Anstieg, wie in einem Blogbeitrag am Dienstag detailliert beschrieben, wird nicht durch gesteigertes menschliches Interesse getrieben, sondern durch automatisierte Scraper, die nach Daten für das Training von AI-Modellen hungern.

„Unsere Infrastruktur ist darauf ausgelegt, plötzliche Verkehrsspitzen von Menschen während großer Ereignisse zu bewältigen, aber das Verkehrsvolumen von Scraper-Bots ist unvergleichlich und stellt zunehmende Risiken und Kosten dar“, erklärt der Beitrag.

Wikimedia Commons dient als frei zugängliches Zentrum für Bilder, Videos und Audiodateien, die alle unter offenen Lizenzen oder im öffentlichen Bereich verfügbar sind.

Bei näherer Betrachtung enthüllte Wikimedia, dass satte 65 % des ressourcenintensivsten Datenverkehrs – gemessen an der Art der konsumierten Inhalte – von Bots stammen. Dennoch machen diese Bots nur 35 % der gesamten Seitenaufrufe aus. Die Diskrepanz, so Wikimedia, rührt daher, dass häufig abgerufene Inhalte näher an den Nutzern zwischengespeichert werden, während weniger populäre Inhalte, die Bots oft anvisieren, im kostspieligeren „Kernrechenzentrum“ gespeichert sind.

„Während menschliche Leser dazu neigen, sich auf spezifische, oft ähnliche Themen zu konzentrieren, neigen Crawler-Bots dazu, eine größere Anzahl von Seiten ‚massenhaft zu lesen‘ und auch weniger populäre zu besuchen“, stellte Wikimedia fest. „Dies führt dazu, dass diese Anfragen an das Kernrechenzentrum weitergeleitet werden, was unsere Ressourcenverbrauchskosten erheblich erhöht.“

Infolgedessen widmet das Site-Reliability-Team der Wikimedia Foundation erhebliche Zeit und Ressourcen darauf, diese Crawler zu blockieren, um Störungen für alltägliche Nutzer zu verhindern. Dies berührt noch nicht einmal die eskalierenden Cloud-Kosten, mit denen die Foundation zu kämpfen hat.

Dieses Szenario ist Teil eines größeren Trends, der das offene Internet gefährdet. Erst letzten Monat klagte der Softwareingenieur und Open-Source-Befürworter Drew DeVault, dass AI-Crawler „robots.txt“-Dateien, die automatiserten Datenverkehr abwehren sollen, offensichtlich ignorieren. Ähnlich äußerte Gergely Orosz, bekannt als „pragmatic engineer“, kürzlich seine Frustration darüber, wie AI-Scraper von Unternehmen wie Meta die Bandbreitenanforderungen für seine Projekte in die Höhe getrieben haben.

Während Open-Source-Infrastrukturen besonders anfällig sind, reagieren Entwickler mit Einfallsreichtum und Entschlossenheit. TechCrunch hob letzte Woche hervor, dass einige Technologieunternehmen aktiv werden. Zum Beispiel führte Cloudflare AI Labyrinth ein, das darauf ausgelegt ist, Crawler mit AI-generierten Inhalten zu verlangsamen.

Dennoch bleibt es ein ständiges Katz-und-Maus-Spiel, das viele Verlage dazu zwingen könnte, sich hinter Logins und Bezahlschranken zurückzuziehen, was letztlich die offene Natur des Webs, auf das wir alle angewiesen sind, schädigt.

Verwandter Artikel

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Master Audio Editing in DaVinci Resolve: Fairlight Guide für professionellen Ton

Kristallklares Audio unterscheidet Amateurproduktionen von professionellen Videoinhalten. Die Fairlight-Seite von DaVinci Resolve bietet Filmemachern und Produzenten von Inhalten ausgefeilte Werkzeuge

Master Audio Editing in DaVinci Resolve: Fairlight Guide für professionellen Ton

Kristallklares Audio unterscheidet Amateurproduktionen von professionellen Videoinhalten. Die Fairlight-Seite von DaVinci Resolve bietet Filmemachern und Produzenten von Inhalten ausgefeilte Werkzeuge

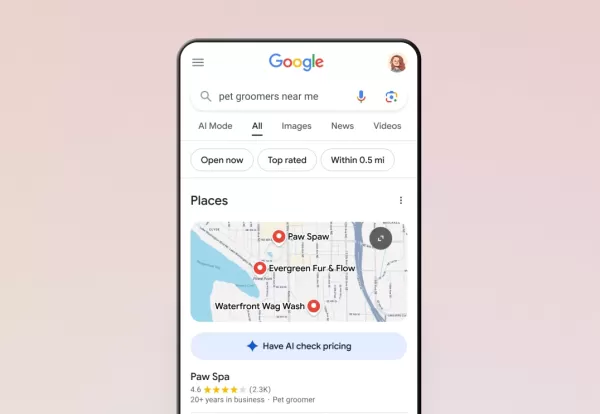

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Kommentare (14)

0/200

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Kommentare (14)

0/200

![KevinBrown]() KevinBrown

KevinBrown

23. August 2025 17:01:15 MESZ

23. August 2025 17:01:15 MESZ

Incroyable, 50% d'augmentation de bande passante pour Wikimedia Commons ! Ça montre à quel point l'IA aspire tout sur son passage, non ? 😅 J’espère juste que ça ne va pas surcharger les serveurs ou freiner l’accès pour les utilisateurs classiques.

0

0

![CharlesWhite]() CharlesWhite

CharlesWhite

13. August 2025 15:00:59 MESZ

13. August 2025 15:00:59 MESZ

Whoa, a 50% spike in Wikimedia Commons bandwidth? AI crawlers are eating up data like it’s an all-you-can-eat buffet! 😄 Makes me wonder how much of this is legit research vs. bots just hoarding images for some shady AI training. Anyone else curious about what’s driving this?

0

0

![SamuelClark]() SamuelClark

SamuelClark

31. Juli 2025 13:35:39 MESZ

31. Juli 2025 13:35:39 MESZ

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Kinda cool but also makes me wonder if this is pushing the limits of what open platforms can handle. 😅

0

0

![KennethJohnson]() KennethJohnson

KennethJohnson

31. Juli 2025 03:42:05 MESZ

31. Juli 2025 03:42:05 MESZ

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Makes me wonder how much data these AI models are chugging through daily. 😳 Cool to see open knowledge fueling innovation, though!

0

0

![WillieAnderson]() WillieAnderson

WillieAnderson

18. April 2025 08:23:40 MESZ

18. April 2025 08:23:40 MESZ

Wikimedia Commons에서 AI 크롤러로 인한 대역폭 수요 증가는 미쳤어요! AI가 이렇게 널리 사용되는 건 멋지지만, 조금 걱정되기도 해요. 사용자 경험에 큰 영향을 주지 않으면서 이를 관리할 방법을 찾았으면 좋겠어요. 🤔

0

0

![RaymondGreen]() RaymondGreen

RaymondGreen

18. April 2025 08:01:01 MESZ

18. April 2025 08:01:01 MESZ

ウィキメディア・コモンズの帯域使用量が50%増えたって?😲 信じられない!AIクローラーがデータを欲しがってるんだね。ウィキメディアが情報を共有してくれるのはいいけど、これで遅くなるのは嫌だな。ユーザー体験を壊さずに対応できるといいね!🤞

0

0

Die Wikimedia Foundation, die Mutterorganisation hinter Wikipedia und zahlreichen anderen kollaborativen Wissensplattformen, gab am Mittwoch einen erstaunlichen Anstieg des Bandbreitenverbrauchs für Multimediadownloads von Wikimedia Commons um 50 % seit Januar 2024 bekannt. Dieser Anstieg, wie in einem Blogbeitrag am Dienstag detailliert beschrieben, wird nicht durch gesteigertes menschliches Interesse getrieben, sondern durch automatisierte Scraper, die nach Daten für das Training von AI-Modellen hungern.

„Unsere Infrastruktur ist darauf ausgelegt, plötzliche Verkehrsspitzen von Menschen während großer Ereignisse zu bewältigen, aber das Verkehrsvolumen von Scraper-Bots ist unvergleichlich und stellt zunehmende Risiken und Kosten dar“, erklärt der Beitrag.

Wikimedia Commons dient als frei zugängliches Zentrum für Bilder, Videos und Audiodateien, die alle unter offenen Lizenzen oder im öffentlichen Bereich verfügbar sind.

Bei näherer Betrachtung enthüllte Wikimedia, dass satte 65 % des ressourcenintensivsten Datenverkehrs – gemessen an der Art der konsumierten Inhalte – von Bots stammen. Dennoch machen diese Bots nur 35 % der gesamten Seitenaufrufe aus. Die Diskrepanz, so Wikimedia, rührt daher, dass häufig abgerufene Inhalte näher an den Nutzern zwischengespeichert werden, während weniger populäre Inhalte, die Bots oft anvisieren, im kostspieligeren „Kernrechenzentrum“ gespeichert sind.

„Während menschliche Leser dazu neigen, sich auf spezifische, oft ähnliche Themen zu konzentrieren, neigen Crawler-Bots dazu, eine größere Anzahl von Seiten ‚massenhaft zu lesen‘ und auch weniger populäre zu besuchen“, stellte Wikimedia fest. „Dies führt dazu, dass diese Anfragen an das Kernrechenzentrum weitergeleitet werden, was unsere Ressourcenverbrauchskosten erheblich erhöht.“

Infolgedessen widmet das Site-Reliability-Team der Wikimedia Foundation erhebliche Zeit und Ressourcen darauf, diese Crawler zu blockieren, um Störungen für alltägliche Nutzer zu verhindern. Dies berührt noch nicht einmal die eskalierenden Cloud-Kosten, mit denen die Foundation zu kämpfen hat.

Dieses Szenario ist Teil eines größeren Trends, der das offene Internet gefährdet. Erst letzten Monat klagte der Softwareingenieur und Open-Source-Befürworter Drew DeVault, dass AI-Crawler „robots.txt“-Dateien, die automatiserten Datenverkehr abwehren sollen, offensichtlich ignorieren. Ähnlich äußerte Gergely Orosz, bekannt als „pragmatic engineer“, kürzlich seine Frustration darüber, wie AI-Scraper von Unternehmen wie Meta die Bandbreitenanforderungen für seine Projekte in die Höhe getrieben haben.

Während Open-Source-Infrastrukturen besonders anfällig sind, reagieren Entwickler mit Einfallsreichtum und Entschlossenheit. TechCrunch hob letzte Woche hervor, dass einige Technologieunternehmen aktiv werden. Zum Beispiel führte Cloudflare AI Labyrinth ein, das darauf ausgelegt ist, Crawler mit AI-generierten Inhalten zu verlangsamen.

Dennoch bleibt es ein ständiges Katz-und-Maus-Spiel, das viele Verlage dazu zwingen könnte, sich hinter Logins und Bezahlschranken zurückzuziehen, was letztlich die offene Natur des Webs, auf das wir alle angewiesen sind, schädigt.

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Master Audio Editing in DaVinci Resolve: Fairlight Guide für professionellen Ton

Kristallklares Audio unterscheidet Amateurproduktionen von professionellen Videoinhalten. Die Fairlight-Seite von DaVinci Resolve bietet Filmemachern und Produzenten von Inhalten ausgefeilte Werkzeuge

Master Audio Editing in DaVinci Resolve: Fairlight Guide für professionellen Ton

Kristallklares Audio unterscheidet Amateurproduktionen von professionellen Videoinhalten. Die Fairlight-Seite von DaVinci Resolve bietet Filmemachern und Produzenten von Inhalten ausgefeilte Werkzeuge

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

23. August 2025 17:01:15 MESZ

23. August 2025 17:01:15 MESZ

Incroyable, 50% d'augmentation de bande passante pour Wikimedia Commons ! Ça montre à quel point l'IA aspire tout sur son passage, non ? 😅 J’espère juste que ça ne va pas surcharger les serveurs ou freiner l’accès pour les utilisateurs classiques.

0

0

13. August 2025 15:00:59 MESZ

13. August 2025 15:00:59 MESZ

Whoa, a 50% spike in Wikimedia Commons bandwidth? AI crawlers are eating up data like it’s an all-you-can-eat buffet! 😄 Makes me wonder how much of this is legit research vs. bots just hoarding images for some shady AI training. Anyone else curious about what’s driving this?

0

0

31. Juli 2025 13:35:39 MESZ

31. Juli 2025 13:35:39 MESZ

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Kinda cool but also makes me wonder if this is pushing the limits of what open platforms can handle. 😅

0

0

31. Juli 2025 03:42:05 MESZ

31. Juli 2025 03:42:05 MESZ

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Makes me wonder how much data these AI models are chugging through daily. 😳 Cool to see open knowledge fueling innovation, though!

0

0

18. April 2025 08:23:40 MESZ

18. April 2025 08:23:40 MESZ

Wikimedia Commons에서 AI 크롤러로 인한 대역폭 수요 증가는 미쳤어요! AI가 이렇게 널리 사용되는 건 멋지지만, 조금 걱정되기도 해요. 사용자 경험에 큰 영향을 주지 않으면서 이를 관리할 방법을 찾았으면 좋겠어요. 🤔

0

0

18. April 2025 08:01:01 MESZ

18. April 2025 08:01:01 MESZ

ウィキメディア・コモンズの帯域使用量が50%増えたって?😲 信じられない!AIクローラーがデータを欲しがってるんだね。ウィキメディアが情報を共有してくれるのはいいけど、これで遅くなるのは嫌だな。ユーザー体験を壊さずに対応できるといいね!🤞

0

0