AI Crawlers Surge Wikimedia Commons пропускная способность на 50%

Фонд Викимедиа, головная организация, стоящая за Википедией и множеством других краудсорсинговых платформ знаний, объявил в среду о поразительном увеличении использования пропускной способности на 50% для загрузки мультимедиа из Wikimedia Commons с января 2024 года. Этот всплеск, как подробно описано в блоге во вторник, вызван не ростом человеческого любопытства, а автоматическими скрейперами, жаждущими данных для обучения моделей ИИ.

«Наша инфраструктура рассчитана на обработку внезапных всплесков трафика от людей во время крупных событий, но объем трафика от ботов-скрейперов не имеет аналогов и создает нарастающие риски и затраты», — объясняется в посте.

Wikimedia Commons служит свободно доступным центром для изображений, видео и аудиофайлов, все из которых доступны по открытым лицензиям или находятся в общественном достоянии.

Углубляясь в детали, Викимедиа сообщила, что колоссальные 65% наиболее ресурсоемкого трафика — измеряемого по типу потребляемого контента — приходится на ботов. При этом эти боты составляют лишь 35% от общего числа просмотров страниц. Разрыв, по словам Викимедиа, объясняется тем, что часто запрашиваемый контент кэшируется ближе к пользователям, тогда как менее популярный контент, который часто выбирают боты, хранится в более дорогостоящем «основном центре данных».

«В то время как человеческие читатели склонны сосредотачиваться на конкретных, часто схожих темах, боты-краулеры склонны к ‘массовому чтению’ большего числа страниц и посещают менее популярные из них», — отметила Викимедиа. «Это приводит к тому, что такие запросы перенаправляются в основной центр данных, что значительно увеличивает наши затраты на потребление ресурсов».

В результате команда надежности сайта Фонда Викимедиа тратит значительное время и ресурсы на блокировку этих краулеров, чтобы предотвратить сбои для обычных пользователей. Это даже не затрагивает нарастающие расходы на облачные сервисы, с которыми сталкивается Фонд.

Эта ситуация является частью более широкой тенденции, угрожающей открытому интернету. В прошлом месяце инженер-программист и сторонник открытого исходного кода Дрю ДеВолт сетовал, что краулеры ИИ откровенно игнорируют файлы «robots.txt», предназначенные для сдерживания автоматического трафика. Аналогично, Гергели Орош, известный как «прагматичный инженер», недавно выразил свое разочарование тем, как скрейперы ИИ от компаний, таких как Meta, резко увеличили требования к пропускной способности для его проектов.

Хотя инфраструктуры с открытым исходным кодом особенно уязвимы, разработчики отвечают изобретательностью и решимостью. TechCrunch на прошлой неделе отметил, что некоторые технологические компании активизируются. Например, Cloudflare представила AI Labyrinth, разработанную для замедления краулеров с контентом, сгенерированным ИИ.

Тем не менее, это остается постоянной игрой в кошки-мышки, которая может подтолкнуть многих издателей к отступлению за логины и платные стены, что в конечном итоге вредит открытой природе интернета, на которую мы все полагаемся.

Связанная статья

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

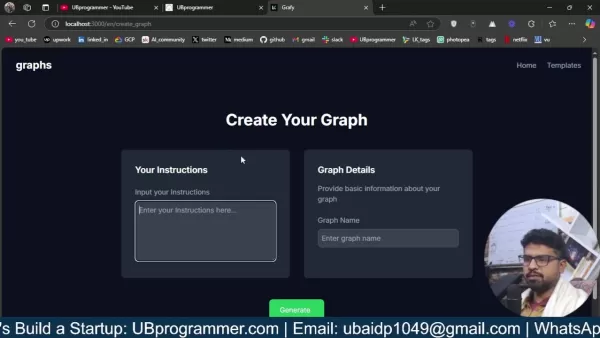

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

Комментарии (14)

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

Комментарии (14)

![KevinBrown]() KevinBrown

KevinBrown

23 августа 2025 г., 18:01:15 GMT+03:00

23 августа 2025 г., 18:01:15 GMT+03:00

Incroyable, 50% d'augmentation de bande passante pour Wikimedia Commons ! Ça montre à quel point l'IA aspire tout sur son passage, non ? 😅 J’espère juste que ça ne va pas surcharger les serveurs ou freiner l’accès pour les utilisateurs classiques.

0

0

![CharlesWhite]() CharlesWhite

CharlesWhite

13 августа 2025 г., 16:00:59 GMT+03:00

13 августа 2025 г., 16:00:59 GMT+03:00

Whoa, a 50% spike in Wikimedia Commons bandwidth? AI crawlers are eating up data like it’s an all-you-can-eat buffet! 😄 Makes me wonder how much of this is legit research vs. bots just hoarding images for some shady AI training. Anyone else curious about what’s driving this?

0

0

![SamuelClark]() SamuelClark

SamuelClark

31 июля 2025 г., 14:35:39 GMT+03:00

31 июля 2025 г., 14:35:39 GMT+03:00

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Kinda cool but also makes me wonder if this is pushing the limits of what open platforms can handle. 😅

0

0

![KennethJohnson]() KennethJohnson

KennethJohnson

31 июля 2025 г., 4:42:05 GMT+03:00

31 июля 2025 г., 4:42:05 GMT+03:00

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Makes me wonder how much data these AI models are chugging through daily. 😳 Cool to see open knowledge fueling innovation, though!

0

0

![WillieAnderson]() WillieAnderson

WillieAnderson

18 апреля 2025 г., 9:23:40 GMT+03:00

18 апреля 2025 г., 9:23:40 GMT+03:00

Wikimedia Commons에서 AI 크롤러로 인한 대역폭 수요 증가는 미쳤어요! AI가 이렇게 널리 사용되는 건 멋지지만, 조금 걱정되기도 해요. 사용자 경험에 큰 영향을 주지 않으면서 이를 관리할 방법을 찾았으면 좋겠어요. 🤔

0

0

![RaymondGreen]() RaymondGreen

RaymondGreen

18 апреля 2025 г., 9:01:01 GMT+03:00

18 апреля 2025 г., 9:01:01 GMT+03:00

ウィキメディア・コモンズの帯域使用量が50%増えたって?😲 信じられない!AIクローラーがデータを欲しがってるんだね。ウィキメディアが情報を共有してくれるのはいいけど、これで遅くなるのは嫌だな。ユーザー体験を壊さずに対応できるといいね!🤞

0

0

Фонд Викимедиа, головная организация, стоящая за Википедией и множеством других краудсорсинговых платформ знаний, объявил в среду о поразительном увеличении использования пропускной способности на 50% для загрузки мультимедиа из Wikimedia Commons с января 2024 года. Этот всплеск, как подробно описано в блоге во вторник, вызван не ростом человеческого любопытства, а автоматическими скрейперами, жаждущими данных для обучения моделей ИИ.

«Наша инфраструктура рассчитана на обработку внезапных всплесков трафика от людей во время крупных событий, но объем трафика от ботов-скрейперов не имеет аналогов и создает нарастающие риски и затраты», — объясняется в посте.

Wikimedia Commons служит свободно доступным центром для изображений, видео и аудиофайлов, все из которых доступны по открытым лицензиям или находятся в общественном достоянии.

Углубляясь в детали, Викимедиа сообщила, что колоссальные 65% наиболее ресурсоемкого трафика — измеряемого по типу потребляемого контента — приходится на ботов. При этом эти боты составляют лишь 35% от общего числа просмотров страниц. Разрыв, по словам Викимедиа, объясняется тем, что часто запрашиваемый контент кэшируется ближе к пользователям, тогда как менее популярный контент, который часто выбирают боты, хранится в более дорогостоящем «основном центре данных».

«В то время как человеческие читатели склонны сосредотачиваться на конкретных, часто схожих темах, боты-краулеры склонны к ‘массовому чтению’ большего числа страниц и посещают менее популярные из них», — отметила Викимедиа. «Это приводит к тому, что такие запросы перенаправляются в основной центр данных, что значительно увеличивает наши затраты на потребление ресурсов».

В результате команда надежности сайта Фонда Викимедиа тратит значительное время и ресурсы на блокировку этих краулеров, чтобы предотвратить сбои для обычных пользователей. Это даже не затрагивает нарастающие расходы на облачные сервисы, с которыми сталкивается Фонд.

Эта ситуация является частью более широкой тенденции, угрожающей открытому интернету. В прошлом месяце инженер-программист и сторонник открытого исходного кода Дрю ДеВолт сетовал, что краулеры ИИ откровенно игнорируют файлы «robots.txt», предназначенные для сдерживания автоматического трафика. Аналогично, Гергели Орош, известный как «прагматичный инженер», недавно выразил свое разочарование тем, как скрейперы ИИ от компаний, таких как Meta, резко увеличили требования к пропускной способности для его проектов.

Хотя инфраструктуры с открытым исходным кодом особенно уязвимы, разработчики отвечают изобретательностью и решимостью. TechCrunch на прошлой неделе отметил, что некоторые технологические компании активизируются. Например, Cloudflare представила AI Labyrinth, разработанную для замедления краулеров с контентом, сгенерированным ИИ.

Тем не менее, это остается постоянной игрой в кошки-мышки, которая может подтолкнуть многих издателей к отступлению за логины и платные стены, что в конечном итоге вредит открытой природе интернета, на которую мы все полагаемся.

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Искусственный интеллект создает образ Майкла Джексона в метавселенной с помощью потрясающих цифровых трансформаций

Искусственный интеллект кардинально меняет наше представление о творчестве, развлечениях и культурном наследии. Это исследование интерпретаций Майкла Джексона, созданных искусственным интеллектом, пок

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

23 августа 2025 г., 18:01:15 GMT+03:00

23 августа 2025 г., 18:01:15 GMT+03:00

Incroyable, 50% d'augmentation de bande passante pour Wikimedia Commons ! Ça montre à quel point l'IA aspire tout sur son passage, non ? 😅 J’espère juste que ça ne va pas surcharger les serveurs ou freiner l’accès pour les utilisateurs classiques.

0

0

13 августа 2025 г., 16:00:59 GMT+03:00

13 августа 2025 г., 16:00:59 GMT+03:00

Whoa, a 50% spike in Wikimedia Commons bandwidth? AI crawlers are eating up data like it’s an all-you-can-eat buffet! 😄 Makes me wonder how much of this is legit research vs. bots just hoarding images for some shady AI training. Anyone else curious about what’s driving this?

0

0

31 июля 2025 г., 14:35:39 GMT+03:00

31 июля 2025 г., 14:35:39 GMT+03:00

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Kinda cool but also makes me wonder if this is pushing the limits of what open platforms can handle. 😅

0

0

31 июля 2025 г., 4:42:05 GMT+03:00

31 июля 2025 г., 4:42:05 GMT+03:00

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Makes me wonder how much data these AI models are chugging through daily. 😳 Cool to see open knowledge fueling innovation, though!

0

0

18 апреля 2025 г., 9:23:40 GMT+03:00

18 апреля 2025 г., 9:23:40 GMT+03:00

Wikimedia Commons에서 AI 크롤러로 인한 대역폭 수요 증가는 미쳤어요! AI가 이렇게 널리 사용되는 건 멋지지만, 조금 걱정되기도 해요. 사용자 경험에 큰 영향을 주지 않으면서 이를 관리할 방법을 찾았으면 좋겠어요. 🤔

0

0

18 апреля 2025 г., 9:01:01 GMT+03:00

18 апреля 2025 г., 9:01:01 GMT+03:00

ウィキメディア・コモンズの帯域使用量が50%増えたって?😲 信じられない!AIクローラーがデータを欲しがってるんだね。ウィキメディアが情報を共有してくれるのはいいけど、これで遅くなるのは嫌だな。ユーザー体験を壊さずに対応できるといいね!🤞

0

0