AI爬行者涌现Wikimedia Commons带宽需求50%

维基媒体基金会,维基百科及众多其他众包知识平台的母体,于周三宣布,自2024年1月以来,来自维基媒体共享资源的的多媒体下载带宽使用量惊人地增长了50%。周二的一篇博客文章详细说明,这一激增并非源于人类好奇心的增加,而是由于自动化抓取工具对训练AI模型的数据的渴求。

“我们的基础设施设计能够应对重大事件期间来自人类的突发流量激增,但抓取机器人的流量规模无与伦比,且带来了日益增加的风险和成本,”该文章解释道。

维基媒体共享资源作为一个可自由访问的图片、视频和音频文件中心,所有内容均采用开放许可或属于公共领域。

深入研究后,维基媒体透露,最耗费资源的流量中——以消耗的内容类型衡量——高达65%来自机器人。然而,这些机器人仅占总页面浏览量的35%。维基媒体表示,这种差异源于经常访问的内容被缓存到靠近用户的地方,而机器人常针对的较不受欢迎的内容则存储在成本更高的“核心数据中心”。

“人类读者倾向于关注特定且往往相似的主题,而爬虫机器人则倾向于‘批量阅读’更多页面,并访问较不受欢迎的页面,”维基媒体指出。“这导致这些请求被转发到核心数据中心,显著增加了我们的资源消耗成本。”

因此,维基媒体基金会的站点可靠性团队正投入大量时间和资源来阻止这些爬虫,以防止对日常用户的干扰。这还未涉及基金会正在应对的不断上升的云端成本。

这一情景是威胁开放互联网的更广泛趋势的一部分。就在上个月,软件工程师和开源倡导者德鲁·德沃特(Drew DeVault)感叹,AI爬虫公然无视旨在阻止自动化流量的“robots.txt”文件。同样,被称为“实用工程师”的格尔盖伊·奥罗斯(Gergely Orosz)最近也表达了对AI抓取工具(例如来自Meta的公司)对其项目带宽需求激增的沮丧。

虽然开源基础设施尤其脆弱,但开发者们正以创造力和决心应对。上周,TechCrunch报道了一些科技公司正在采取行动。例如,Cloudflare推出了AI Labyrinth,旨在通过AI生成的内容减缓爬虫速度。

然而,这仍然是一场持续的猫鼠游戏,可能迫使许多出版商退回到登录和付费墙之后,最终损害我们赖以生存的网络的开放性。

相关文章

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

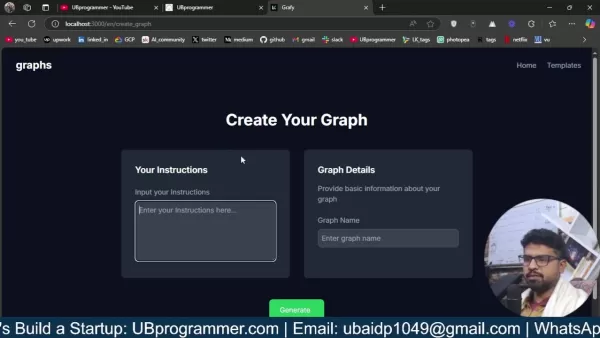

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

评论 (14)

0/200

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

评论 (14)

0/200

![KevinBrown]() KevinBrown

KevinBrown

2025-08-23 23:01:15

2025-08-23 23:01:15

Incroyable, 50% d'augmentation de bande passante pour Wikimedia Commons ! Ça montre à quel point l'IA aspire tout sur son passage, non ? 😅 J’espère juste que ça ne va pas surcharger les serveurs ou freiner l’accès pour les utilisateurs classiques.

0

0

![CharlesWhite]() CharlesWhite

CharlesWhite

2025-08-13 21:00:59

2025-08-13 21:00:59

Whoa, a 50% spike in Wikimedia Commons bandwidth? AI crawlers are eating up data like it’s an all-you-can-eat buffet! 😄 Makes me wonder how much of this is legit research vs. bots just hoarding images for some shady AI training. Anyone else curious about what’s driving this?

0

0

![SamuelClark]() SamuelClark

SamuelClark

2025-07-31 19:35:39

2025-07-31 19:35:39

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Kinda cool but also makes me wonder if this is pushing the limits of what open platforms can handle. 😅

0

0

![KennethJohnson]() KennethJohnson

KennethJohnson

2025-07-31 09:42:05

2025-07-31 09:42:05

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Makes me wonder how much data these AI models are chugging through daily. 😳 Cool to see open knowledge fueling innovation, though!

0

0

![WillieAnderson]() WillieAnderson

WillieAnderson

2025-04-18 14:23:40

2025-04-18 14:23:40

Wikimedia Commons에서 AI 크롤러로 인한 대역폭 수요 증가는 미쳤어요! AI가 이렇게 널리 사용되는 건 멋지지만, 조금 걱정되기도 해요. 사용자 경험에 큰 영향을 주지 않으면서 이를 관리할 방법을 찾았으면 좋겠어요. 🤔

0

0

![RaymondGreen]() RaymondGreen

RaymondGreen

2025-04-18 14:01:01

2025-04-18 14:01:01

ウィキメディア・コモンズの帯域使用量が50%増えたって?😲 信じられない!AIクローラーがデータを欲しがってるんだね。ウィキメディアが情報を共有してくれるのはいいけど、これで遅くなるのは嫌だな。ユーザー体験を壊さずに対応できるといいね!🤞

0

0

维基媒体基金会,维基百科及众多其他众包知识平台的母体,于周三宣布,自2024年1月以来,来自维基媒体共享资源的的多媒体下载带宽使用量惊人地增长了50%。周二的一篇博客文章详细说明,这一激增并非源于人类好奇心的增加,而是由于自动化抓取工具对训练AI模型的数据的渴求。

“我们的基础设施设计能够应对重大事件期间来自人类的突发流量激增,但抓取机器人的流量规模无与伦比,且带来了日益增加的风险和成本,”该文章解释道。

维基媒体共享资源作为一个可自由访问的图片、视频和音频文件中心,所有内容均采用开放许可或属于公共领域。

深入研究后,维基媒体透露,最耗费资源的流量中——以消耗的内容类型衡量——高达65%来自机器人。然而,这些机器人仅占总页面浏览量的35%。维基媒体表示,这种差异源于经常访问的内容被缓存到靠近用户的地方,而机器人常针对的较不受欢迎的内容则存储在成本更高的“核心数据中心”。

“人类读者倾向于关注特定且往往相似的主题,而爬虫机器人则倾向于‘批量阅读’更多页面,并访问较不受欢迎的页面,”维基媒体指出。“这导致这些请求被转发到核心数据中心,显著增加了我们的资源消耗成本。”

因此,维基媒体基金会的站点可靠性团队正投入大量时间和资源来阻止这些爬虫,以防止对日常用户的干扰。这还未涉及基金会正在应对的不断上升的云端成本。

这一情景是威胁开放互联网的更广泛趋势的一部分。就在上个月,软件工程师和开源倡导者德鲁·德沃特(Drew DeVault)感叹,AI爬虫公然无视旨在阻止自动化流量的“robots.txt”文件。同样,被称为“实用工程师”的格尔盖伊·奥罗斯(Gergely Orosz)最近也表达了对AI抓取工具(例如来自Meta的公司)对其项目带宽需求激增的沮丧。

虽然开源基础设施尤其脆弱,但开发者们正以创造力和决心应对。上周,TechCrunch报道了一些科技公司正在采取行动。例如,Cloudflare推出了AI Labyrinth,旨在通过AI生成的内容减缓爬虫速度。

然而,这仍然是一场持续的猫鼠游戏,可能迫使许多出版商退回到登录和付费墙之后,最终损害我们赖以生存的网络的开放性。

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

2025-08-23 23:01:15

2025-08-23 23:01:15

Incroyable, 50% d'augmentation de bande passante pour Wikimedia Commons ! Ça montre à quel point l'IA aspire tout sur son passage, non ? 😅 J’espère juste que ça ne va pas surcharger les serveurs ou freiner l’accès pour les utilisateurs classiques.

0

0

2025-08-13 21:00:59

2025-08-13 21:00:59

Whoa, a 50% spike in Wikimedia Commons bandwidth? AI crawlers are eating up data like it’s an all-you-can-eat buffet! 😄 Makes me wonder how much of this is legit research vs. bots just hoarding images for some shady AI training. Anyone else curious about what’s driving this?

0

0

2025-07-31 19:35:39

2025-07-31 19:35:39

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Kinda cool but also makes me wonder if this is pushing the limits of what open platforms can handle. 😅

0

0

2025-07-31 09:42:05

2025-07-31 09:42:05

Wow, a 50% spike in bandwidth for Wikimedia Commons? That’s wild! AI crawlers are probably gobbling up all those images for training. Makes me wonder how much data these AI models are chugging through daily. 😳 Cool to see open knowledge fueling innovation, though!

0

0

2025-04-18 14:23:40

2025-04-18 14:23:40

Wikimedia Commons에서 AI 크롤러로 인한 대역폭 수요 증가는 미쳤어요! AI가 이렇게 널리 사용되는 건 멋지지만, 조금 걱정되기도 해요. 사용자 경험에 큰 영향을 주지 않으면서 이를 관리할 방법을 찾았으면 좋겠어요. 🤔

0

0

2025-04-18 14:01:01

2025-04-18 14:01:01

ウィキメディア・コモンズの帯域使用量が50%増えたって?😲 信じられない!AIクローラーがデータを欲しがってるんだね。ウィキメディアが情報を共有してくれるのはいいけど、これで遅くなるのは嫌だな。ユーザー体験を壊さずに対応できるといいね!🤞

0

0