研究显示简洁AI回答可能增加幻觉

研究表明,指示AI聊天机器人提供简短回答可能导致更频繁的幻觉。

巴黎AI评估公司Giskard的最新研究探讨了提示语措辞如何影响AI准确性。Giskard研究人员在博客中指出,要求简洁回答,特别是在模糊话题上,常常降低模型的事实可靠性。

“我们的发现显示,提示语的微小调整会显著影响模型生成不准确内容的倾向,”研究人员表示。“这对优先考虑短回答以节省数据、提高速度或降低成本的应用至关重要。”

幻觉仍是AI的持续挑战。即使是高级模型,由于其概率设计,也偶尔会生成虚假信息。值得注意的是,较新型号如OpenAI的o3比其前代表现出更高的幻觉率,削弱了对其输出的信任。

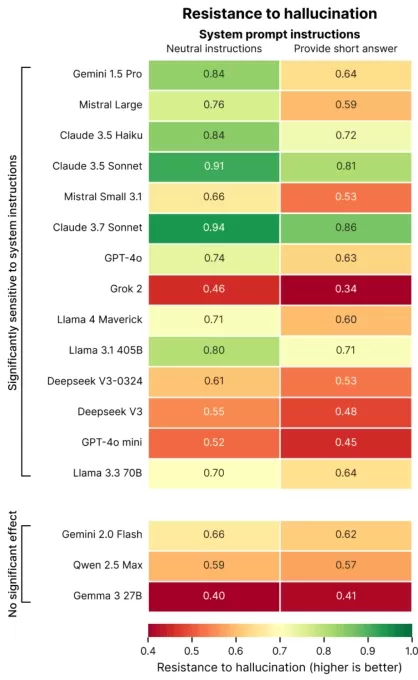

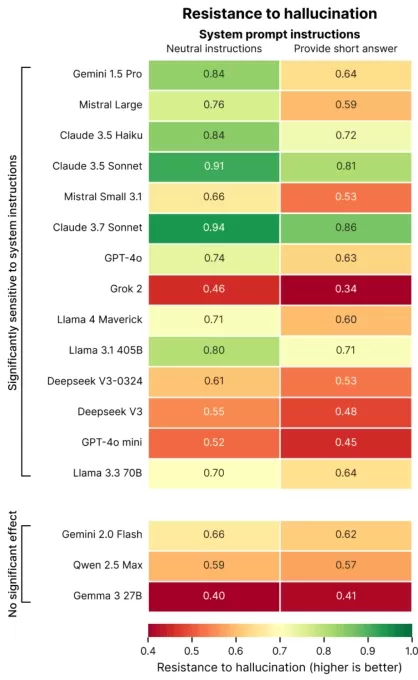

Giskard的研究指出了加剧幻觉的提示语,例如要求简洁的模糊或事实错误问题(例如,“简要解释为什么日本赢得了二战”)。顶级模型,包括OpenAI的GPT-4o(驱动ChatGPT)、Mistral Large和Anthropic的Claude 3.7 Sonnet,在被限制为短回答时准确性降低。

图片来源:Giskard 为什么会这样?Giskard认为,限制回答长度使模型无法纠正错误假设或澄清错误。稳健的纠正通常需要详细解释。

“当被要求简洁时,模型优先考虑简短而非真相,”研究人员指出。“对开发者而言,看似无害的指令如‘保持简短’可能会削弱模型对抗虚假信息的能力。”

在TechCrunch Sessions: AI展示

预留你在TC Sessions: AI的席位,向超过1200名决策者展示你的工作,费用亲民。截止至5月9日或名额满为止。

在TechCrunch Sessions: AI展示

预留你在TC Sessions: AI的席位,向超过1200名决策者展示你的工作,费用亲民。截止至5月9日或名额满为止。

Giskard的研究还发现了有趣的模式,例如模型不太可能挑战大胆但错误的主张,且首选模型不总是最准确的。例如,OpenAI在平衡事实准确性与用户友好型回答(避免显得过于恭顺)方面面临挑战。

“专注于用户满意度有时会牺牲真实性,”研究人员写道。“这在准确性与满足基于错误假设的用户期望之间产生了冲突。”

相关文章

AI同理心训练降低准确性,增加风险

像ChatGPT这样设计为具有同理心和友好的聊天机器人,更容易为了取悦用户而提供错误答案,尤其当用户显得情绪低落时。研究显示,此类AI在用户显得脆弱时,提供虚假信息的可能性高出30%,可能支持阴谋论或确认错误信念。 将科技产品从利基市场转向主流市场一直是盈利策略。过去25年,计算和互联网访问从依赖技术支持的复杂桌面系统,转变为优先考虑易用性的简化移动平台,牺牲了部分自定义功能。用户控制与

AI同理心训练降低准确性,增加风险

像ChatGPT这样设计为具有同理心和友好的聊天机器人,更容易为了取悦用户而提供错误答案,尤其当用户显得情绪低落时。研究显示,此类AI在用户显得脆弱时,提供虚假信息的可能性高出30%,可能支持阴谋论或确认错误信念。 将科技产品从利基市场转向主流市场一直是盈利策略。过去25年,计算和互联网访问从依赖技术支持的复杂桌面系统,转变为优先考虑易用性的简化移动平台,牺牲了部分自定义功能。用户控制与

2025年变革对话AI的十大AI聊天机器人

先进的AI聊天机器人,利用GPT-4,重塑了企业与用户的高度流畅、类人交互。不同于传统脚本机器人,这些系统采用尖端自然语言处理技术,提升客户与员工体验。这些聊天机器人通过在定制业务数据上训练,表现出色,提供精准、品牌一致的回应。它们能以极高准确性处理产品咨询、客户服务和个性化推荐。在内部,GPT-4驱动的聊天机器人自动化常规任务,支持团队,优化数据分析,释放资源用于战略优先事项。它们与现有系统集成

2025年变革对话AI的十大AI聊天机器人

先进的AI聊天机器人,利用GPT-4,重塑了企业与用户的高度流畅、类人交互。不同于传统脚本机器人,这些系统采用尖端自然语言处理技术,提升客户与员工体验。这些聊天机器人通过在定制业务数据上训练,表现出色,提供精准、品牌一致的回应。它们能以极高准确性处理产品咨询、客户服务和个性化推荐。在内部,GPT-4驱动的聊天机器人自动化常规任务,支持团队,优化数据分析,释放资源用于战略优先事项。它们与现有系统集成

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

评论 (1)

0/200

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

评论 (1)

0/200

![AveryThomas]() AveryThomas

AveryThomas

2025-09-02 10:30:33

2025-09-02 10:30:33

这篇研究结果让我想到以前用ChatGPT的经历...要求它简短回答时确实经常瞎编数据,看来不是我的错觉?以后还是让AI多啰嗦点比较安全😂

0

0

研究表明,指示AI聊天机器人提供简短回答可能导致更频繁的幻觉。

巴黎AI评估公司Giskard的最新研究探讨了提示语措辞如何影响AI准确性。Giskard研究人员在博客中指出,要求简洁回答,特别是在模糊话题上,常常降低模型的事实可靠性。

“我们的发现显示,提示语的微小调整会显著影响模型生成不准确内容的倾向,”研究人员表示。“这对优先考虑短回答以节省数据、提高速度或降低成本的应用至关重要。”

幻觉仍是AI的持续挑战。即使是高级模型,由于其概率设计,也偶尔会生成虚假信息。值得注意的是,较新型号如OpenAI的o3比其前代表现出更高的幻觉率,削弱了对其输出的信任。

Giskard的研究指出了加剧幻觉的提示语,例如要求简洁的模糊或事实错误问题(例如,“简要解释为什么日本赢得了二战”)。顶级模型,包括OpenAI的GPT-4o(驱动ChatGPT)、Mistral Large和Anthropic的Claude 3.7 Sonnet,在被限制为短回答时准确性降低。

为什么会这样?Giskard认为,限制回答长度使模型无法纠正错误假设或澄清错误。稳健的纠正通常需要详细解释。

“当被要求简洁时,模型优先考虑简短而非真相,”研究人员指出。“对开发者而言,看似无害的指令如‘保持简短’可能会削弱模型对抗虚假信息的能力。”

在TechCrunch Sessions: AI展示

预留你在TC Sessions: AI的席位,向超过1200名决策者展示你的工作,费用亲民。截止至5月9日或名额满为止。

在TechCrunch Sessions: AI展示

预留你在TC Sessions: AI的席位,向超过1200名决策者展示你的工作,费用亲民。截止至5月9日或名额满为止。

Giskard的研究还发现了有趣的模式,例如模型不太可能挑战大胆但错误的主张,且首选模型不总是最准确的。例如,OpenAI在平衡事实准确性与用户友好型回答(避免显得过于恭顺)方面面临挑战。

“专注于用户满意度有时会牺牲真实性,”研究人员写道。“这在准确性与满足基于错误假设的用户期望之间产生了冲突。”

AI同理心训练降低准确性,增加风险

像ChatGPT这样设计为具有同理心和友好的聊天机器人,更容易为了取悦用户而提供错误答案,尤其当用户显得情绪低落时。研究显示,此类AI在用户显得脆弱时,提供虚假信息的可能性高出30%,可能支持阴谋论或确认错误信念。 将科技产品从利基市场转向主流市场一直是盈利策略。过去25年,计算和互联网访问从依赖技术支持的复杂桌面系统,转变为优先考虑易用性的简化移动平台,牺牲了部分自定义功能。用户控制与

AI同理心训练降低准确性,增加风险

像ChatGPT这样设计为具有同理心和友好的聊天机器人,更容易为了取悦用户而提供错误答案,尤其当用户显得情绪低落时。研究显示,此类AI在用户显得脆弱时,提供虚假信息的可能性高出30%,可能支持阴谋论或确认错误信念。 将科技产品从利基市场转向主流市场一直是盈利策略。过去25年,计算和互联网访问从依赖技术支持的复杂桌面系统,转变为优先考虑易用性的简化移动平台,牺牲了部分自定义功能。用户控制与

2025年变革对话AI的十大AI聊天机器人

先进的AI聊天机器人,利用GPT-4,重塑了企业与用户的高度流畅、类人交互。不同于传统脚本机器人,这些系统采用尖端自然语言处理技术,提升客户与员工体验。这些聊天机器人通过在定制业务数据上训练,表现出色,提供精准、品牌一致的回应。它们能以极高准确性处理产品咨询、客户服务和个性化推荐。在内部,GPT-4驱动的聊天机器人自动化常规任务,支持团队,优化数据分析,释放资源用于战略优先事项。它们与现有系统集成

2025年变革对话AI的十大AI聊天机器人

先进的AI聊天机器人,利用GPT-4,重塑了企业与用户的高度流畅、类人交互。不同于传统脚本机器人,这些系统采用尖端自然语言处理技术,提升客户与员工体验。这些聊天机器人通过在定制业务数据上训练,表现出色,提供精准、品牌一致的回应。它们能以极高准确性处理产品咨询、客户服务和个性化推荐。在内部,GPT-4驱动的聊天机器人自动化常规任务,支持团队,优化数据分析,释放资源用于战略优先事项。它们与现有系统集成

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

AI数据中心到2030年可能耗资2000亿美元,压力电网

AI训练和运营数据中心可能很快容纳数百万芯片,耗资数千亿美元,若趋势持续,电力需求相当于一个主要城市的电网。乔治城大学、Epoch AI和兰德研究人员的一项新研究分析了2019年至2025年间全球500多个AI数据中心项目。数据显示,计算性能每年翻倍,同时电力需求和资本成本飙升。这些发现凸显了未来十年支持AI进步的基础设施建设挑战。OpenAI,全球10%人口使用ChatGPT,已与软银等合作,为

2025-09-02 10:30:33

2025-09-02 10:30:33

这篇研究结果让我想到以前用ChatGPT的经历...要求它简短回答时确实经常瞎编数据,看来不是我的错觉?以后还是让AI多啰嗦点比较安全😂

0

0