긴 맥락 이해 창 : 주요 통찰력

어제, 우리는 Gemini 1.5 모델로 AI 기술의 최신 돌파구를 공개했습니다. 이 새로운 버전은 속도와 효율성에서 상당한 향상을 가져왔지만, 진정한 혁신은 혁신적인 긴 문맥 창입니다. 이 기능은 모델이 전례 없는 수의 토큰 — 단어, 이미지, 또는 비디오를 구성하는 기본 단위 — 을 한 번에 처리할 수 있게 합니다. 이 발전에 대해 더 알아보기 위해, 우리는 긴 문맥 창이 무엇이며 이것이 개발자들의 작업 방식을 어떻게 혁신할 수 있는지에 대한 통찰을 얻기 위해 Google DeepMind 프로젝트 팀에 문의했습니다.

긴 문맥 창을 이해하는 것은 AI 모델이 세션 전반에 걸쳐 정보를 유지하고 회상할 수 있게 하기 때문에 중요합니다. 대화에서 이름이 언급된 지 몇 분 만에 그 이름을 기억하려고 노력하거나, 전화번호를 잊기 전에 급히 적어두려는 상황을 상상해보세요. AI 모델도 비슷한 도전에 직면하며, 몇 번의 상호작용 후에 세부사항을 "잊어버리는" 경우가 많습니다. 긴 문맥 창은 모델이 더 많은 정보를 "메모리"에 유지할 수 있도록 하여 이 문제를 해결합니다.

이전에는 Gemini 모델이 최대 32,000개의 토큰을 동시에 처리할 수 있었습니다. 하지만 1.5 Pro의 초기 테스트용 출시로, 우리는 현재까지 가장 큰 문맥 창인 놀라운 100만 토큰으로 한계를 확장했습니다. 우리의 연구는 심지어 이를 넘어 1,000만 토큰까지 성공적으로 테스트했습니다. 문맥 창이 클수록 모델이 처리할 수 있는 데이터 — 텍스트, 이미지, 오디오, 코드, 또는 비디오 — 의 다양성과 양이 더 많아집니다.

Google DeepMind 연구 과학자이자 긴 문맥 프로젝트의 리더 중 한 명인 Nikolay Savinov는 다음과 같이 말했습니다: "우리의 초기 목표는 128,000 토큰에 도달하는 것이었지만, 더 높은 목표를 설정하는 것이 유익할 것이라고 생각하여 100만 토큰을 제안했습니다. 그리고 이제, 우리의 연구는 이를 10배 초과했습니다."

이 도약을 달성하기 위해 일련의 딥러닝 혁신이 필요했습니다. Pranav Shyam의 초기 탐구는 우리의 연구를 이끄는 중요한 통찰을 제공했습니다. Google DeepMind 엔지니어인 Denis Teplyashin은 "각각의 돌파구가 또 다른 돌파구로 이어져 새로운 가능성을 열었습니다. 이러한 혁신들이 결합되었을 때, 우리는 128,000 토큰에서 512,000, 그리고 100만, 최근에는 내부 연구에서 1,000만 토큰으로 확장된 결과에 놀랐습니다."라고 설명했습니다.

1.5 Pro의 확장된 용량은 흥미로운 새로운 응용 프로그램을 열어줍니다. 예를 들어, 수십 페이지 분량의 문서를 요약하는 대신, 이제 수천 페이지에 달하는 문서를 처리할 수 있습니다. 이전 모델이 수천 줄의 코드를 분석할 수 있었다면, 1.5 Pro는 이제 수만 줄의 코드를 한 번에 처리할 수 있습니다.

또 다른 Google DeepMind 연구 과학자인 Machel Reid는 몇 가지 매력적인 테스트 결과를 공유했습니다: "한 테스트에서는 전체 코드베이스를 모델에 입력했고, 모델은 이에 대한 포괄적인 문서를 생성했는데, 이는 놀라웠습니다. 또 다른 테스트에서는 1924년 영화 Sherlock Jr.을 45분 전체를 '시청'한 후 이에 대한 질문에 정확히 답변했습니다."

1.5 Pro는 또한 프롬프트 내 데이터에 걸친 추론에서 탁월합니다. Machel은 전 세계적으로 200명 미만이 사용하는 희귀 언어 Kalamang을 포함한 예를 강조했습니다. "모델은 자체적으로 Kalamang으로 번역할 수 없지만, 긴 문맥 창을 통해 전체 문법 매뉴얼과 예문들을 포함할 수 있었습니다. 그러자 모델은 동일한 자료로 학습한 사람과 비슷한 수준으로 영어에서 Kalamang으로 번역을 배웠습니다."

Gemini 1.5 Pro는 표준 128K 토큰 문맥 창과 함께 제공되지만, 선택된 개발자 및 기업 고객 그룹은 AI Studio와 Vertex AI를 통해 비공개 프리뷰에서 100만 토큰 문맥 창에 접근할 수 있습니다. 이렇게 큰 문맥 창을 관리하는 것은 계산적으로 매우 집중적이며, 우리는 이를 확장하면서 지연 시간을 줄이기 위해 최적화 작업을 적극적으로 진행 중입니다.

앞으로 팀은 안전을 우선으로 하여 모델을 더 빠르고 효율적으로 만드는 데 집중하고 있습니다. 또한 긴 문맥 창을 더욱 확장하고, 기본 아키텍처를 개선하며, 새로운 하드웨어 개선 사항을 활용하는 방법을 탐구하고 있습니다. Nikolay는 "1,000만 토큰을 한 번에 처리하는 것은 우리의 Tensor Processing Unit의 열 한계에 가까워지고 있습니다. 아직 한계가 어디인지 확실하지 않으며, 하드웨어가 계속 발전함에 따라 모델은 더 많은 것을 처리할 수 있을지도 모릅니다."라고 말했습니다.

팀은 개발자와 더 넓은 커뮤니티가 이 새로운 기능으로 만들어낼 혁신적인 응용 프로그램을 기대하고 있습니다. Machel은 "처음에 100만 토큰 문맥을 보았을 때, '이걸 도대체 어디에 쓰지?'라고 생각했습니다. 하지만 이제는 사람들의 상상력이 확장되어 이 새로운 기능들을 더 창의적으로 사용할 것이라고 믿습니다."

[ttpp][yyxx]

관련 기사

이제 구글의 AI가 전화 통화를 대신 처리합니다.

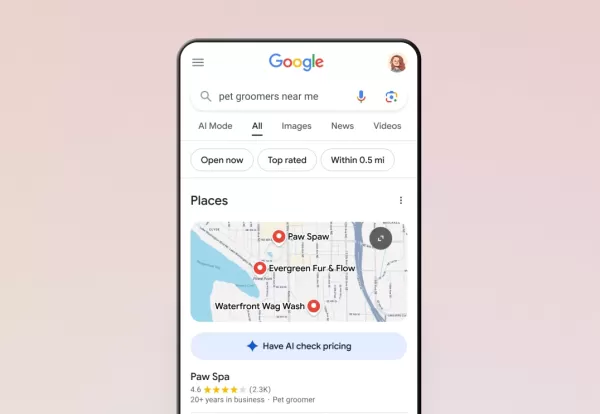

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

"닷 AI 컴패니언 앱, 폐쇄 발표, 개인화 서비스 중단"

금요일 개발자의 발표에 따르면 개인적인 친구이자 친구의 역할을 하도록 설계된 AI 컴패니언 애플리케이션인 Dot이 운영을 중단할 예정입니다. 닷을 개발한 스타트업인 뉴 컴퓨터는 웹사이트를 통해 10월 5일까지 서비스를 계속 이용할 수 있으며, 사용자들이 개인 데이터를 내보낼 수 있는 시간을 제공한다고 밝혔습니다.이 앱은 올해 초 공동 창업자인 샘 휘트모어와

"닷 AI 컴패니언 앱, 폐쇄 발표, 개인화 서비스 중단"

금요일 개발자의 발표에 따르면 개인적인 친구이자 친구의 역할을 하도록 설계된 AI 컴패니언 애플리케이션인 Dot이 운영을 중단할 예정입니다. 닷을 개발한 스타트업인 뉴 컴퓨터는 웹사이트를 통해 10월 5일까지 서비스를 계속 이용할 수 있으며, 사용자들이 개인 데이터를 내보낼 수 있는 시간을 제공한다고 밝혔습니다.이 앱은 올해 초 공동 창업자인 샘 휘트모어와

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

의견 (28)

0/200

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

의견 (28)

0/200

![KeithSmith]() KeithSmith

KeithSmith

2025년 8월 17일 오후 4시 0분 59초 GMT+09:00

2025년 8월 17일 오후 4시 0분 59초 GMT+09:00

Super cool to see Gemini 1.5's long context window in action! 😎 Makes me wonder how it'll handle massive datasets compared to older models.

0

0

![RobertSanchez]() RobertSanchez

RobertSanchez

2025년 7월 31일 오전 10시 41분 19초 GMT+09:00

2025년 7월 31일 오전 10시 41분 19초 GMT+09:00

Wow, the long context window in Gemini 1.5 sounds like a game-changer! I'm curious how it'll handle massive datasets in real-world apps. Excited to see where this takes AI! 🚀

0

0

![DavidGonzález]() DavidGonzález

DavidGonzález

2025년 7월 28일 오전 10시 19분 30초 GMT+09:00

2025년 7월 28일 오전 10시 19분 30초 GMT+09:00

The long context window in Gemini 1.5 sounds like a game-changer! I'm curious how it'll handle massive datasets in real-world apps. Any cool examples out there yet? 🤔

0

0

![RobertRoberts]() RobertRoberts

RobertRoberts

2025년 4월 17일 오전 8시 56분 25초 GMT+09:00

2025년 4월 17일 오전 8시 56분 25초 GMT+09:00

Cửa sổ ngữ cảnh dài của Gemini 1.5 thực sự là một bước tiến lớn! Thật đáng kinh ngạc khi nó có thể xử lý nhiều hơn so với các mô hình cũ. Chỉ mong nó nhanh hơn một chút. Tuy nhiên, đây là một bước tiến lớn! 💪

0

0

![MatthewGonzalez]() MatthewGonzalez

MatthewGonzalez

2025년 4월 17일 오전 12시 41분 59초 GMT+09:00

2025년 4월 17일 오전 12시 41분 59초 GMT+09:00

A janela de contexto longo do Gemini 1.5 é revolucionária, sem dúvida! Mas às vezes parece que está tentando fazer muito de uma vez, o que pode atrasar as coisas. Ainda assim, para processar grandes quantidades de dados, é imbatível. Vale a pena conferir! 🚀

0

0

![NicholasRoberts]() NicholasRoberts

NicholasRoberts

2025년 4월 15일 오전 7시 59분 46초 GMT+09:00

2025년 4월 15일 오전 7시 59분 46초 GMT+09:00

Gemini 1.5's long context window is a game-changer, no doubt! But sometimes it feels like it's trying to do too much at once, which can slow things down. Still, for processing huge chunks of data, it's unbeatable. Worth checking out! 🚀

0

0

어제, 우리는 Gemini 1.5 모델로 AI 기술의 최신 돌파구를 공개했습니다. 이 새로운 버전은 속도와 효율성에서 상당한 향상을 가져왔지만, 진정한 혁신은 혁신적인 긴 문맥 창입니다. 이 기능은 모델이 전례 없는 수의 토큰 — 단어, 이미지, 또는 비디오를 구성하는 기본 단위 — 을 한 번에 처리할 수 있게 합니다. 이 발전에 대해 더 알아보기 위해, 우리는 긴 문맥 창이 무엇이며 이것이 개발자들의 작업 방식을 어떻게 혁신할 수 있는지에 대한 통찰을 얻기 위해 Google DeepMind 프로젝트 팀에 문의했습니다.

긴 문맥 창을 이해하는 것은 AI 모델이 세션 전반에 걸쳐 정보를 유지하고 회상할 수 있게 하기 때문에 중요합니다. 대화에서 이름이 언급된 지 몇 분 만에 그 이름을 기억하려고 노력하거나, 전화번호를 잊기 전에 급히 적어두려는 상황을 상상해보세요. AI 모델도 비슷한 도전에 직면하며, 몇 번의 상호작용 후에 세부사항을 "잊어버리는" 경우가 많습니다. 긴 문맥 창은 모델이 더 많은 정보를 "메모리"에 유지할 수 있도록 하여 이 문제를 해결합니다.

이전에는 Gemini 모델이 최대 32,000개의 토큰을 동시에 처리할 수 있었습니다. 하지만 1.5 Pro의 초기 테스트용 출시로, 우리는 현재까지 가장 큰 문맥 창인 놀라운 100만 토큰으로 한계를 확장했습니다. 우리의 연구는 심지어 이를 넘어 1,000만 토큰까지 성공적으로 테스트했습니다. 문맥 창이 클수록 모델이 처리할 수 있는 데이터 — 텍스트, 이미지, 오디오, 코드, 또는 비디오 — 의 다양성과 양이 더 많아집니다.

Google DeepMind 연구 과학자이자 긴 문맥 프로젝트의 리더 중 한 명인 Nikolay Savinov는 다음과 같이 말했습니다: "우리의 초기 목표는 128,000 토큰에 도달하는 것이었지만, 더 높은 목표를 설정하는 것이 유익할 것이라고 생각하여 100만 토큰을 제안했습니다. 그리고 이제, 우리의 연구는 이를 10배 초과했습니다."

이 도약을 달성하기 위해 일련의 딥러닝 혁신이 필요했습니다. Pranav Shyam의 초기 탐구는 우리의 연구를 이끄는 중요한 통찰을 제공했습니다. Google DeepMind 엔지니어인 Denis Teplyashin은 "각각의 돌파구가 또 다른 돌파구로 이어져 새로운 가능성을 열었습니다. 이러한 혁신들이 결합되었을 때, 우리는 128,000 토큰에서 512,000, 그리고 100만, 최근에는 내부 연구에서 1,000만 토큰으로 확장된 결과에 놀랐습니다."라고 설명했습니다.

1.5 Pro의 확장된 용량은 흥미로운 새로운 응용 프로그램을 열어줍니다. 예를 들어, 수십 페이지 분량의 문서를 요약하는 대신, 이제 수천 페이지에 달하는 문서를 처리할 수 있습니다. 이전 모델이 수천 줄의 코드를 분석할 수 있었다면, 1.5 Pro는 이제 수만 줄의 코드를 한 번에 처리할 수 있습니다.

또 다른 Google DeepMind 연구 과학자인 Machel Reid는 몇 가지 매력적인 테스트 결과를 공유했습니다: "한 테스트에서는 전체 코드베이스를 모델에 입력했고, 모델은 이에 대한 포괄적인 문서를 생성했는데, 이는 놀라웠습니다. 또 다른 테스트에서는 1924년 영화 Sherlock Jr.을 45분 전체를 '시청'한 후 이에 대한 질문에 정확히 답변했습니다."

1.5 Pro는 또한 프롬프트 내 데이터에 걸친 추론에서 탁월합니다. Machel은 전 세계적으로 200명 미만이 사용하는 희귀 언어 Kalamang을 포함한 예를 강조했습니다. "모델은 자체적으로 Kalamang으로 번역할 수 없지만, 긴 문맥 창을 통해 전체 문법 매뉴얼과 예문들을 포함할 수 있었습니다. 그러자 모델은 동일한 자료로 학습한 사람과 비슷한 수준으로 영어에서 Kalamang으로 번역을 배웠습니다."

Gemini 1.5 Pro는 표준 128K 토큰 문맥 창과 함께 제공되지만, 선택된 개발자 및 기업 고객 그룹은 AI Studio와 Vertex AI를 통해 비공개 프리뷰에서 100만 토큰 문맥 창에 접근할 수 있습니다. 이렇게 큰 문맥 창을 관리하는 것은 계산적으로 매우 집중적이며, 우리는 이를 확장하면서 지연 시간을 줄이기 위해 최적화 작업을 적극적으로 진행 중입니다.

앞으로 팀은 안전을 우선으로 하여 모델을 더 빠르고 효율적으로 만드는 데 집중하고 있습니다. 또한 긴 문맥 창을 더욱 확장하고, 기본 아키텍처를 개선하며, 새로운 하드웨어 개선 사항을 활용하는 방법을 탐구하고 있습니다. Nikolay는 "1,000만 토큰을 한 번에 처리하는 것은 우리의 Tensor Processing Unit의 열 한계에 가까워지고 있습니다. 아직 한계가 어디인지 확실하지 않으며, 하드웨어가 계속 발전함에 따라 모델은 더 많은 것을 처리할 수 있을지도 모릅니다."라고 말했습니다.

팀은 개발자와 더 넓은 커뮤니티가 이 새로운 기능으로 만들어낼 혁신적인 응용 프로그램을 기대하고 있습니다. Machel은 "처음에 100만 토큰 문맥을 보았을 때, '이걸 도대체 어디에 쓰지?'라고 생각했습니다. 하지만 이제는 사람들의 상상력이 확장되어 이 새로운 기능들을 더 창의적으로 사용할 것이라고 믿습니다."

[ttpp][yyxx]

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

2025년 8월 17일 오후 4시 0분 59초 GMT+09:00

2025년 8월 17일 오후 4시 0분 59초 GMT+09:00

Super cool to see Gemini 1.5's long context window in action! 😎 Makes me wonder how it'll handle massive datasets compared to older models.

0

0

2025년 7월 31일 오전 10시 41분 19초 GMT+09:00

2025년 7월 31일 오전 10시 41분 19초 GMT+09:00

Wow, the long context window in Gemini 1.5 sounds like a game-changer! I'm curious how it'll handle massive datasets in real-world apps. Excited to see where this takes AI! 🚀

0

0

2025년 7월 28일 오전 10시 19분 30초 GMT+09:00

2025년 7월 28일 오전 10시 19분 30초 GMT+09:00

The long context window in Gemini 1.5 sounds like a game-changer! I'm curious how it'll handle massive datasets in real-world apps. Any cool examples out there yet? 🤔

0

0

2025년 4월 17일 오전 8시 56분 25초 GMT+09:00

2025년 4월 17일 오전 8시 56분 25초 GMT+09:00

Cửa sổ ngữ cảnh dài của Gemini 1.5 thực sự là một bước tiến lớn! Thật đáng kinh ngạc khi nó có thể xử lý nhiều hơn so với các mô hình cũ. Chỉ mong nó nhanh hơn một chút. Tuy nhiên, đây là một bước tiến lớn! 💪

0

0

2025년 4월 17일 오전 12시 41분 59초 GMT+09:00

2025년 4월 17일 오전 12시 41분 59초 GMT+09:00

A janela de contexto longo do Gemini 1.5 é revolucionária, sem dúvida! Mas às vezes parece que está tentando fazer muito de uma vez, o que pode atrasar as coisas. Ainda assim, para processar grandes quantidades de dados, é imbatível. Vale a pena conferir! 🚀

0

0

2025년 4월 15일 오전 7시 59분 46초 GMT+09:00

2025년 4월 15일 오전 7시 59분 46초 GMT+09:00

Gemini 1.5's long context window is a game-changer, no doubt! But sometimes it feels like it's trying to do too much at once, which can slow things down. Still, for processing huge chunks of data, it's unbeatable. Worth checking out! 🚀

0

0