경찰에 의한 범죄보고에 AI 사용 : 잠재적 인 함정 탐험

일부 미국 경찰서에서 AI 챗봇을 사용하여 범죄 보고서를 작성하는 것은 효율성을 약속하지만 잠재적인 문제점으로 가득 찬 양날의 검이다. 오클라호마 시티 경찰관들이 OpenAI의 GPT-4 모델을 활용하는 AI 도구인 Draft One을 사용하여 보고서 작성 시간을 단 몇 초로 줄이는 매력을 상상해 보라. 혁신적으로 들리지 않는가? 하지만 모든 기술적 도약과 마찬가지로, 그 이면에는 위험이 도사리고 있다.

이 기술 중심 접근 방식에서 무엇이 잘못될 수 있는지 살펴보자. 우선, ChatGPT와 같은 AI 시스템은 "환각(hallucinate)" 현상으로 알려져 있으며, 이는 완전히 사실이 아닌 정보를 생성할 수 있다는 뜻이다. Draft One을 만든 Axon사는 "창의성 다이얼"을 조정함으로써 이 문제를 완화했다고 주장하지만, 모든 보고서가 정확할 것이라고 정말 믿을 수 있을까? 이는 도박이며, 법 집행の世界에서 정확성은 타협할 수 없는 요소이다.

현재 오클라호마 시티에서는 Draft One의 사용이 "경미한" 사건에 국한되어 있으며, 중범죄나 폭력 범죄는 AI를 통해 처리되지 않는다. 하지만 콜로라도주 포트콜린스나 인디애나주 라피엣과 같은 다른 경찰서들은 모든 사건에 이를 적용하며 한계를 시험하고 있다. 이는 경고 신호를 불러일으킨다: AI가 모든 사건에 사용된다면, 이 기술이 보고서의 무결성을 손상시키지 않는다고 어떻게 보장할 수 있을까?

전문가들의 우려

법학자 앤드루 퍼거슨은 자동화가 경찰관들의 보고서 작성에서 덜 신중한 태도를 초래할 수 있다고 우려를 표명했다. 이는 타당한 지적이다—기술에 의존하면 안일해질 수 있으며, 경찰 업무에서는 모든 세부 사항이 중요하다. 더 나아가, AI 시스템이 체계적 편견을 영속화할 수 있다는 더 큰 문제가 있다. 연구에 따르면, 신중히 관리되지 않는 AI 기반 도구는 고용을 포함한 다양한 분야에서 차별을 악화시킬 수 있다. 법 집행에서도 같은 일이 일어날 수 있을까?

Axon은 Draft One이 생성한 모든 보고서를 인간 경찰관이 검토하고 승인해야 한다고 주장하며, 오류와 편견에 대한 안전장치를 마련했다고 한다. 하지만 이는 여전히 인간의 실수 가능성을 남기며, 이는 이미 경찰 업무에서 알려진 문제이다. 그리고 AI 자체는 어떠한가? 언어학자들은 GPT-4와 같은 대규모 언어 모델이 은연중에 인종차별을 구현하고, 특히 아프리칸 아메리칸 영어와 같은 소외된 언어에 대한 방언 편견을 영속화할 수 있다는 점을 발견했다. 이는 공정하고 편견 없는 법 집행을 보장하는 데 있어 심각한 우려이다.

테스트와 책임

Axon은 Draft One 보고서에서 인종적 편견을 테스트하기 위해 내부 연구를 진행했으며, AI 생성 보고서와 원본 대화록 간에 큰 차이가 없다고 밝혔다. 하지만 이것으로 충분한가? 이 회사는 또한 컴퓨터 비전을 활용해 비디오 영상을 요약하는 방안을 탐구하고 있지만, CEO 릭 스미스는 경찰 업무와 인종에 대한 민감성을 인정하며 이 기술에 신중한 접근을 하고 있다고 밝혔다.

이러한 노력에도 불구하고, 경찰 업무에서 AI의 더 큰 영향은 여전히 의문으로 남아 있다. Axon의 목표는 경찰과 민간인 간의 총기 관련 사망을 50% 줄이는 것이지만, 워싱턴 포스트의 경찰 총격 데이터베이스 통계에 따르면 2020년 이후 경찰에 의한 사망이 증가했으며, 이는 바디카메라가 널리 채택되었음에도 불구하고이다. 이는 기술만으로는 복잡한 사회적 문제를 해결할 수 없음을 시사한다.

더 많은 경찰서가 Draft One과 같은 도구를 채택하는 것을 고려함에 따라, 잠재적 이익과 위험은 계속 논쟁의 대상이 될 것이다. 이는 가능성으로 가득 찬 매혹적인 시대이지만, 불확실성도 함께한다. 핵심은 혁신과 책임 사이의 균형을 유지하여 AI가 법 집행의 무결성을 훼손하지 않고 향상시키도록 하는 것이다.

관련 기사

다빈치 레졸브에서 오디오 편집 마스터하기: 프로페셔널 사운드를 위한 페어라이트 가이드

선명한 오디오는 아마추어 프로덕션과 전문 비디오 콘텐츠를 구분합니다. 다빈치 Resolve의 페어라이트 페이지에서는 영화 제작자와 콘텐츠 크리에이터가 사운드 디자인을 완성할 수 있는 정교한 도구를 제공합니다. 이 심층 튜토리얼에서는 기본 레코딩부터 세련된 포스트 프로덕션 마스터링까지 오디오를 향상시키기 위한 필수 기술, 최적의 장비 선택, 전문적인 워크플로

다빈치 레졸브에서 오디오 편집 마스터하기: 프로페셔널 사운드를 위한 페어라이트 가이드

선명한 오디오는 아마추어 프로덕션과 전문 비디오 콘텐츠를 구분합니다. 다빈치 Resolve의 페어라이트 페이지에서는 영화 제작자와 콘텐츠 크리에이터가 사운드 디자인을 완성할 수 있는 정교한 도구를 제공합니다. 이 심층 튜토리얼에서는 기본 레코딩부터 세련된 포스트 프로덕션 마스터링까지 오디오를 향상시키기 위한 필수 기술, 최적의 장비 선택, 전문적인 워크플로

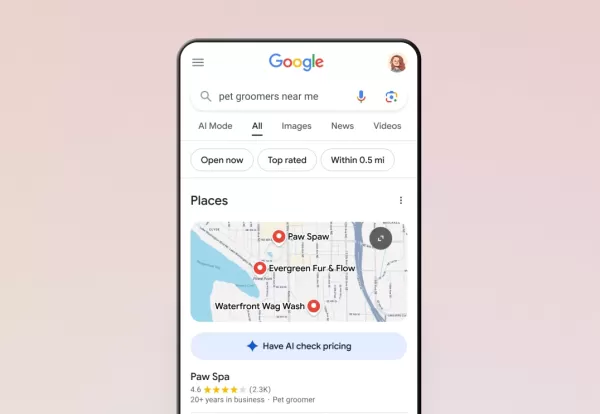

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

트럼프, 스마트폰, 컴퓨터, 칩 관세 인상 면제

블룸버그 통신에 따르면 트럼프 행정부는 스마트폰, 컴퓨터 및 다양한 전자 기기에 대해 중국에서 수입되는 경우에도 최근 관세 인상에서 예외를 인정했습니다. 그러나 이러한 제품은 4월 9일 이전에 시행된 이전 관세의 적용을 받습니다.미국 관세국경보호청은 수요일 늦게 스마트폰, 노트북, 컴퓨터 부품, 반도체 제조 장비 등 주요 기술 제품을 중국산 수입품에 대한

의견 (31)

0/200

트럼프, 스마트폰, 컴퓨터, 칩 관세 인상 면제

블룸버그 통신에 따르면 트럼프 행정부는 스마트폰, 컴퓨터 및 다양한 전자 기기에 대해 중국에서 수입되는 경우에도 최근 관세 인상에서 예외를 인정했습니다. 그러나 이러한 제품은 4월 9일 이전에 시행된 이전 관세의 적용을 받습니다.미국 관세국경보호청은 수요일 늦게 스마트폰, 노트북, 컴퓨터 부품, 반도체 제조 장비 등 주요 기술 제품을 중국산 수입품에 대한

의견 (31)

0/200

![WalterBaker]() WalterBaker

WalterBaker

2025년 8월 27일 오후 12시 1분 27초 GMT+09:00

2025년 8월 27일 오후 12시 1분 27초 GMT+09:00

This AI crime reporting stuff sounds like a game-changer, but I’m skeptical. Can a chatbot really capture the nuance of a crime scene without screwing up details? I mean, efficiency’s great, but if it’s spitting out generic reports, that’s a lawsuit waiting to happen. 😬 Curious to see how they handle the ethical side of this.

0

0

![HarryMartínez]() HarryMartínez

HarryMartínez

2025년 4월 24일 오전 2시 34분 31초 GMT+09:00

2025년 4월 24일 오전 2시 34분 31초 GMT+09:00

Die Idee, dass AI Polizeiberichte schreibt, klingt cool, aber auch ein bisschen beängstigend. Was, wenn das AI die Fakten vermasselt? Die Polizei von Oklahoma City scheint dabei zu sein, aber ich bin mir noch nicht sicher, ob ich es vertraue. Braucht mehr Tests, denke ich! 🤔

0

0

![AnthonyRoberts]() AnthonyRoberts

AnthonyRoberts

2025년 4월 23일 오후 4시 6분 58초 GMT+09:00

2025년 4월 23일 오후 4시 6분 58초 GMT+09:00

Using AI for crime reports sounds cool, but man, the potential for errors is scary! Imagine if the AI messes up and someone gets wrongly accused. Oklahoma City's police are using it, but I'm not sure I trust it yet. Maybe with more testing, it could be safer? 🤔👮♂️

0

0

![PeterMartinez]() PeterMartinez

PeterMartinez

2025년 4월 22일 오후 10시 58분 41초 GMT+09:00

2025년 4월 22일 오후 10시 58분 41초 GMT+09:00

Usar IA para relatórios de crimes parece legal, mas cara, a possibilidade de erros é assustadora! Imagina se a IA erra e alguém é acusado injustamente. A polícia de Oklahoma City está usando, mas não tenho certeza se confio nisso ainda. Talvez com mais testes, possa ser mais seguro? 🤔👮♂️

0

0

![RoyLopez]() RoyLopez

RoyLopez

2025년 4월 22일 오전 11시 56분 0초 GMT+09:00

2025년 4월 22일 오전 11시 56분 0초 GMT+09:00

범죄 보고서에 AI를 사용하는 것이 멋지게 들리지만, 오류의 가능성은 무섭네요! AI가 잘못하면 누군가가 잘못 고발될 수도 있어요. 오클라호마 시티 경찰이 사용하고 있지만, 아직 믿을 수 없어요. 더 많은 테스트를 하면 안전해질까요? 🤔👮♂️

0

0

![EricNelson]() EricNelson

EricNelson

2025년 4월 22일 오전 11시 51분 47초 GMT+09:00

2025년 4월 22일 오전 11시 51분 47초 GMT+09:00

A ideia de um AI escrever relatórios de crimes parece legal, mas também é assustadora. E se o AI errar os fatos? A polícia de Oklahoma City parece estar a bordo, mas eu ainda não confio muito. Precisa de mais testes, acho eu! 🤔

0

0

일부 미국 경찰서에서 AI 챗봇을 사용하여 범죄 보고서를 작성하는 것은 효율성을 약속하지만 잠재적인 문제점으로 가득 찬 양날의 검이다. 오클라호마 시티 경찰관들이 OpenAI의 GPT-4 모델을 활용하는 AI 도구인 Draft One을 사용하여 보고서 작성 시간을 단 몇 초로 줄이는 매력을 상상해 보라. 혁신적으로 들리지 않는가? 하지만 모든 기술적 도약과 마찬가지로, 그 이면에는 위험이 도사리고 있다.

이 기술 중심 접근 방식에서 무엇이 잘못될 수 있는지 살펴보자. 우선, ChatGPT와 같은 AI 시스템은 "환각(hallucinate)" 현상으로 알려져 있으며, 이는 완전히 사실이 아닌 정보를 생성할 수 있다는 뜻이다. Draft One을 만든 Axon사는 "창의성 다이얼"을 조정함으로써 이 문제를 완화했다고 주장하지만, 모든 보고서가 정확할 것이라고 정말 믿을 수 있을까? 이는 도박이며, 법 집행の世界에서 정확성은 타협할 수 없는 요소이다.

현재 오클라호마 시티에서는 Draft One의 사용이 "경미한" 사건에 국한되어 있으며, 중범죄나 폭력 범죄는 AI를 통해 처리되지 않는다. 하지만 콜로라도주 포트콜린스나 인디애나주 라피엣과 같은 다른 경찰서들은 모든 사건에 이를 적용하며 한계를 시험하고 있다. 이는 경고 신호를 불러일으킨다: AI가 모든 사건에 사용된다면, 이 기술이 보고서의 무결성을 손상시키지 않는다고 어떻게 보장할 수 있을까?

전문가들의 우려

법학자 앤드루 퍼거슨은 자동화가 경찰관들의 보고서 작성에서 덜 신중한 태도를 초래할 수 있다고 우려를 표명했다. 이는 타당한 지적이다—기술에 의존하면 안일해질 수 있으며, 경찰 업무에서는 모든 세부 사항이 중요하다. 더 나아가, AI 시스템이 체계적 편견을 영속화할 수 있다는 더 큰 문제가 있다. 연구에 따르면, 신중히 관리되지 않는 AI 기반 도구는 고용을 포함한 다양한 분야에서 차별을 악화시킬 수 있다. 법 집행에서도 같은 일이 일어날 수 있을까?

Axon은 Draft One이 생성한 모든 보고서를 인간 경찰관이 검토하고 승인해야 한다고 주장하며, 오류와 편견에 대한 안전장치를 마련했다고 한다. 하지만 이는 여전히 인간의 실수 가능성을 남기며, 이는 이미 경찰 업무에서 알려진 문제이다. 그리고 AI 자체는 어떠한가? 언어학자들은 GPT-4와 같은 대규모 언어 모델이 은연중에 인종차별을 구현하고, 특히 아프리칸 아메리칸 영어와 같은 소외된 언어에 대한 방언 편견을 영속화할 수 있다는 점을 발견했다. 이는 공정하고 편견 없는 법 집행을 보장하는 데 있어 심각한 우려이다.

테스트와 책임

Axon은 Draft One 보고서에서 인종적 편견을 테스트하기 위해 내부 연구를 진행했으며, AI 생성 보고서와 원본 대화록 간에 큰 차이가 없다고 밝혔다. 하지만 이것으로 충분한가? 이 회사는 또한 컴퓨터 비전을 활용해 비디오 영상을 요약하는 방안을 탐구하고 있지만, CEO 릭 스미스는 경찰 업무와 인종에 대한 민감성을 인정하며 이 기술에 신중한 접근을 하고 있다고 밝혔다.

이러한 노력에도 불구하고, 경찰 업무에서 AI의 더 큰 영향은 여전히 의문으로 남아 있다. Axon의 목표는 경찰과 민간인 간의 총기 관련 사망을 50% 줄이는 것이지만, 워싱턴 포스트의 경찰 총격 데이터베이스 통계에 따르면 2020년 이후 경찰에 의한 사망이 증가했으며, 이는 바디카메라가 널리 채택되었음에도 불구하고이다. 이는 기술만으로는 복잡한 사회적 문제를 해결할 수 없음을 시사한다.

더 많은 경찰서가 Draft One과 같은 도구를 채택하는 것을 고려함에 따라, 잠재적 이익과 위험은 계속 논쟁의 대상이 될 것이다. 이는 가능성으로 가득 찬 매혹적인 시대이지만, 불확실성도 함께한다. 핵심은 혁신과 책임 사이의 균형을 유지하여 AI가 법 집행의 무결성을 훼손하지 않고 향상시키도록 하는 것이다.

다빈치 레졸브에서 오디오 편집 마스터하기: 프로페셔널 사운드를 위한 페어라이트 가이드

선명한 오디오는 아마추어 프로덕션과 전문 비디오 콘텐츠를 구분합니다. 다빈치 Resolve의 페어라이트 페이지에서는 영화 제작자와 콘텐츠 크리에이터가 사운드 디자인을 완성할 수 있는 정교한 도구를 제공합니다. 이 심층 튜토리얼에서는 기본 레코딩부터 세련된 포스트 프로덕션 마스터링까지 오디오를 향상시키기 위한 필수 기술, 최적의 장비 선택, 전문적인 워크플로

다빈치 레졸브에서 오디오 편집 마스터하기: 프로페셔널 사운드를 위한 페어라이트 가이드

선명한 오디오는 아마추어 프로덕션과 전문 비디오 콘텐츠를 구분합니다. 다빈치 Resolve의 페어라이트 페이지에서는 영화 제작자와 콘텐츠 크리에이터가 사운드 디자인을 완성할 수 있는 정교한 도구를 제공합니다. 이 심층 튜토리얼에서는 기본 레코딩부터 세련된 포스트 프로덕션 마스터링까지 오디오를 향상시키기 위한 필수 기술, 최적의 장비 선택, 전문적인 워크플로

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

트럼프, 스마트폰, 컴퓨터, 칩 관세 인상 면제

블룸버그 통신에 따르면 트럼프 행정부는 스마트폰, 컴퓨터 및 다양한 전자 기기에 대해 중국에서 수입되는 경우에도 최근 관세 인상에서 예외를 인정했습니다. 그러나 이러한 제품은 4월 9일 이전에 시행된 이전 관세의 적용을 받습니다.미국 관세국경보호청은 수요일 늦게 스마트폰, 노트북, 컴퓨터 부품, 반도체 제조 장비 등 주요 기술 제품을 중국산 수입품에 대한

트럼프, 스마트폰, 컴퓨터, 칩 관세 인상 면제

블룸버그 통신에 따르면 트럼프 행정부는 스마트폰, 컴퓨터 및 다양한 전자 기기에 대해 중국에서 수입되는 경우에도 최근 관세 인상에서 예외를 인정했습니다. 그러나 이러한 제품은 4월 9일 이전에 시행된 이전 관세의 적용을 받습니다.미국 관세국경보호청은 수요일 늦게 스마트폰, 노트북, 컴퓨터 부품, 반도체 제조 장비 등 주요 기술 제품을 중국산 수입품에 대한

2025년 8월 27일 오후 12시 1분 27초 GMT+09:00

2025년 8월 27일 오후 12시 1분 27초 GMT+09:00

This AI crime reporting stuff sounds like a game-changer, but I’m skeptical. Can a chatbot really capture the nuance of a crime scene without screwing up details? I mean, efficiency’s great, but if it’s spitting out generic reports, that’s a lawsuit waiting to happen. 😬 Curious to see how they handle the ethical side of this.

0

0

2025년 4월 24일 오전 2시 34분 31초 GMT+09:00

2025년 4월 24일 오전 2시 34분 31초 GMT+09:00

Die Idee, dass AI Polizeiberichte schreibt, klingt cool, aber auch ein bisschen beängstigend. Was, wenn das AI die Fakten vermasselt? Die Polizei von Oklahoma City scheint dabei zu sein, aber ich bin mir noch nicht sicher, ob ich es vertraue. Braucht mehr Tests, denke ich! 🤔

0

0

2025년 4월 23일 오후 4시 6분 58초 GMT+09:00

2025년 4월 23일 오후 4시 6분 58초 GMT+09:00

Using AI for crime reports sounds cool, but man, the potential for errors is scary! Imagine if the AI messes up and someone gets wrongly accused. Oklahoma City's police are using it, but I'm not sure I trust it yet. Maybe with more testing, it could be safer? 🤔👮♂️

0

0

2025년 4월 22일 오후 10시 58분 41초 GMT+09:00

2025년 4월 22일 오후 10시 58분 41초 GMT+09:00

Usar IA para relatórios de crimes parece legal, mas cara, a possibilidade de erros é assustadora! Imagina se a IA erra e alguém é acusado injustamente. A polícia de Oklahoma City está usando, mas não tenho certeza se confio nisso ainda. Talvez com mais testes, possa ser mais seguro? 🤔👮♂️

0

0

2025년 4월 22일 오전 11시 56분 0초 GMT+09:00

2025년 4월 22일 오전 11시 56분 0초 GMT+09:00

범죄 보고서에 AI를 사용하는 것이 멋지게 들리지만, 오류의 가능성은 무섭네요! AI가 잘못하면 누군가가 잘못 고발될 수도 있어요. 오클라호마 시티 경찰이 사용하고 있지만, 아직 믿을 수 없어요. 더 많은 테스트를 하면 안전해질까요? 🤔👮♂️

0

0

2025년 4월 22일 오전 11시 51분 47초 GMT+09:00

2025년 4월 22일 오전 11시 51분 47초 GMT+09:00

A ideia de um AI escrever relatórios de crimes parece legal, mas também é assustadora. E se o AI errar os fatos? A polícia de Oklahoma City parece estar a bordo, mas eu ainda não confio muito. Precisa de mais testes, acho eu! 🤔

0

0