ИСПОЛЬЗОВАНИЕ ИСПОЛЬЗОВАНИЯ В ПРЕДЛОЖЕНИИ ПРИМЕНЕНИЯ ПОЛИЦИЯ: Потенциальные ошибки исследуются

Использование чат-ботов с ИИ в некоторых полицейских управлениях США для создания отчетов о преступлениях — это палка о двух концах, обещающая эффективность, но чреватая потенциальными проблемами. Представьте себе привлекательность сокращения времени на написание отчетов до считанных секунд, как это испытали полицейские Оклахома-Сити, используя Draft One, инструмент ИИ, основанный на модели GPT-4 от OpenAI. Звучит революционно, не так ли? Но, как и при любом технологическом прорыве, под поверхностью скрываются риски.

Давайте разберемся, что может пойти не так с этим технологически продвинутым подходом. Во-первых, системы ИИ, такие как ChatGPT, известны тем, что могут "галлюцинировать", то есть генерировать информацию, которая не совсем соответствует фактам. Хотя компания Axon, стоящая за Draft One, утверждает, что решила эту проблему, регулируя "диск творчества", можем ли мы быть уверены, что каждый отчет будет точным? Это риск, а в мире правоохранительных органов точность не подлежит обсуждению.

Использование Draft One в Оклахома-Сити пока ограничено "мелкими" инцидентами, без обработки тяжких преступлений или насильственных преступлений через ИИ. Но другие управления, такие как в Форт-Коллинз, Колорадо, и Лафайет, Индиана, идут дальше, применяя его повсеместно. Это вызывает тревогу: если ИИ будет использоваться для всех случаев, как мы можем гарантировать, что технология не подорвет целостность этих отчетов?

Озабоченность экспертов

Юридический ученый Эндрю Фергюсон выразил обеспокоенность тем, что автоматизация может привести к менее тщательному написанию отчетов офицерами. Это обоснованное замечание — зависимость от технологий может сделать нас беспечными, а в полицейской работе важна каждая деталь. Кроме того, существует более широкая проблема того, что системы ИИ могут усугублять системные предубеждения. Исследования показали, что инструменты на основе ИИ, если их не контролировать должным образом, могут усиливать дискриминацию в различных областях, включая найм на работу. Может ли то же самое произойти в правоохранительных органах?

Компания Axon настаивает, что каждый отчет, созданный Draft One, должен быть проверен и утвержден человеком-офицером, что является защитой от ошибок и предубеждений. Но это все равно оставляет место для человеческой ошибки, которая уже является известной проблемой в полицейской работе. А что насчет самого ИИ? Лингвисты обнаружили, что большие языковые модели, такие как GPT-4, могут воплощать скрытый расизм и поддерживать предубеждения против диалектов, особенно в отношении маргинализированных языков, таких как афроамериканский английский. Это серьезная проблема, когда речь идет о обеспечении справедливой и беспристрастной полицейской деятельности.

Тестирование и ответственность

Компания Axon предприняла шаги для решения этих проблем, проводя внутренние исследования для проверки наличия расовых предубеждений в отчетах Draft One. Они не обнаружили существенных различий между отчетами, созданными ИИ, и оригинальными стенограммами. Но достаточно ли этого? Компания также исследует использование компьютерного зрения для обобщения видеоматериалов, хотя генеральный директор Рик Смит признает чувствительность вопросов, связанных с полицией и расовыми проблемами, указывая на осторожный подход к этой технологии.

Несмотря на эти усилия, более широкое влияние ИИ на полицейскую деятельность остается под вопросом. Цель Axon — сократить количество смертей от огнестрельного оружия между полицией и гражданскими лицами на 50%, но статистика базы данных о полицейских расстрелах Washington Post показывает рост числа убийств полицией с 2020 года, даже с широким внедрением нательных камер. Это говорит о том, что технология сама по себе не является решением сложных социальных проблем.

По мере того как все больше полицейских управлений рассматривают возможность внедрения инструментов, таких как Draft One, потенциальные преимущества и риски будут продолжать обсуждаться. Это увлекательное время, полное возможностей, но также и неопределенности. Ключевым будет баланс между инновациями и ответственностью, чтобы ИИ усиливал, а не подрывал целостность правоохранительных органов.

Связанная статья

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

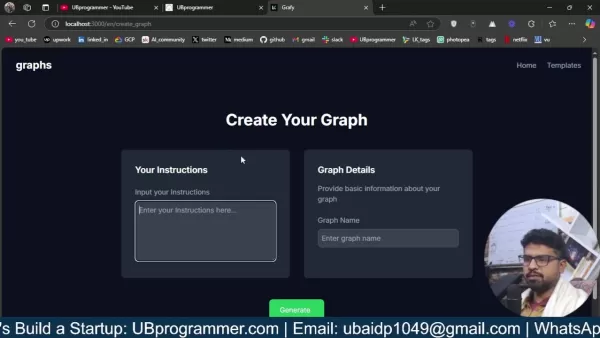

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

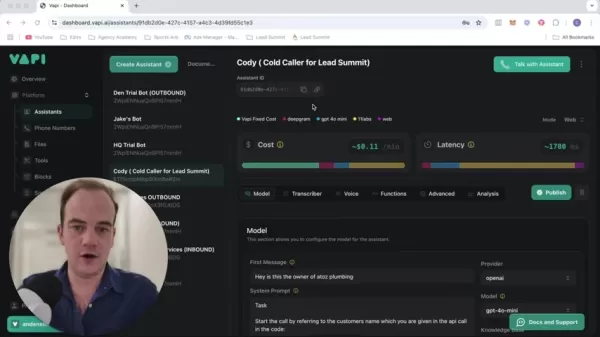

Трансформируйте свою стратегию продаж: Технология искусственного интеллекта для холодных звонков на базе Vapi

Современный бизнес работает с молниеносной скоростью, требуя инновационных решений, чтобы оставаться конкурентоспособным. Представьте себе революцию в работе вашего агентства с помощью системы холодны

Комментарии (31)

Трансформируйте свою стратегию продаж: Технология искусственного интеллекта для холодных звонков на базе Vapi

Современный бизнес работает с молниеносной скоростью, требуя инновационных решений, чтобы оставаться конкурентоспособным. Представьте себе революцию в работе вашего агентства с помощью системы холодны

Комментарии (31)

![WalterBaker]() WalterBaker

WalterBaker

27 августа 2025 г., 6:01:27 GMT+03:00

27 августа 2025 г., 6:01:27 GMT+03:00

This AI crime reporting stuff sounds like a game-changer, but I’m skeptical. Can a chatbot really capture the nuance of a crime scene without screwing up details? I mean, efficiency’s great, but if it’s spitting out generic reports, that’s a lawsuit waiting to happen. 😬 Curious to see how they handle the ethical side of this.

0

0

![HarryMartínez]() HarryMartínez

HarryMartínez

23 апреля 2025 г., 20:34:31 GMT+03:00

23 апреля 2025 г., 20:34:31 GMT+03:00

Die Idee, dass AI Polizeiberichte schreibt, klingt cool, aber auch ein bisschen beängstigend. Was, wenn das AI die Fakten vermasselt? Die Polizei von Oklahoma City scheint dabei zu sein, aber ich bin mir noch nicht sicher, ob ich es vertraue. Braucht mehr Tests, denke ich! 🤔

0

0

![AnthonyRoberts]() AnthonyRoberts

AnthonyRoberts

23 апреля 2025 г., 10:06:58 GMT+03:00

23 апреля 2025 г., 10:06:58 GMT+03:00

Using AI for crime reports sounds cool, but man, the potential for errors is scary! Imagine if the AI messes up and someone gets wrongly accused. Oklahoma City's police are using it, but I'm not sure I trust it yet. Maybe with more testing, it could be safer? 🤔👮♂️

0

0

![PeterMartinez]() PeterMartinez

PeterMartinez

22 апреля 2025 г., 16:58:41 GMT+03:00

22 апреля 2025 г., 16:58:41 GMT+03:00

Usar IA para relatórios de crimes parece legal, mas cara, a possibilidade de erros é assustadora! Imagina se a IA erra e alguém é acusado injustamente. A polícia de Oklahoma City está usando, mas não tenho certeza se confio nisso ainda. Talvez com mais testes, possa ser mais seguro? 🤔👮♂️

0

0

![RoyLopez]() RoyLopez

RoyLopez

22 апреля 2025 г., 5:56:00 GMT+03:00

22 апреля 2025 г., 5:56:00 GMT+03:00

범죄 보고서에 AI를 사용하는 것이 멋지게 들리지만, 오류의 가능성은 무섭네요! AI가 잘못하면 누군가가 잘못 고발될 수도 있어요. 오클라호마 시티 경찰이 사용하고 있지만, 아직 믿을 수 없어요. 더 많은 테스트를 하면 안전해질까요? 🤔👮♂️

0

0

![EricNelson]() EricNelson

EricNelson

22 апреля 2025 г., 5:51:47 GMT+03:00

22 апреля 2025 г., 5:51:47 GMT+03:00

A ideia de um AI escrever relatórios de crimes parece legal, mas também é assustadora. E se o AI errar os fatos? A polícia de Oklahoma City parece estar a bordo, mas eu ainda não confio muito. Precisa de mais testes, acho eu! 🤔

0

0

Использование чат-ботов с ИИ в некоторых полицейских управлениях США для создания отчетов о преступлениях — это палка о двух концах, обещающая эффективность, но чреватая потенциальными проблемами. Представьте себе привлекательность сокращения времени на написание отчетов до считанных секунд, как это испытали полицейские Оклахома-Сити, используя Draft One, инструмент ИИ, основанный на модели GPT-4 от OpenAI. Звучит революционно, не так ли? Но, как и при любом технологическом прорыве, под поверхностью скрываются риски.

Давайте разберемся, что может пойти не так с этим технологически продвинутым подходом. Во-первых, системы ИИ, такие как ChatGPT, известны тем, что могут "галлюцинировать", то есть генерировать информацию, которая не совсем соответствует фактам. Хотя компания Axon, стоящая за Draft One, утверждает, что решила эту проблему, регулируя "диск творчества", можем ли мы быть уверены, что каждый отчет будет точным? Это риск, а в мире правоохранительных органов точность не подлежит обсуждению.

Использование Draft One в Оклахома-Сити пока ограничено "мелкими" инцидентами, без обработки тяжких преступлений или насильственных преступлений через ИИ. Но другие управления, такие как в Форт-Коллинз, Колорадо, и Лафайет, Индиана, идут дальше, применяя его повсеместно. Это вызывает тревогу: если ИИ будет использоваться для всех случаев, как мы можем гарантировать, что технология не подорвет целостность этих отчетов?

Озабоченность экспертов

Юридический ученый Эндрю Фергюсон выразил обеспокоенность тем, что автоматизация может привести к менее тщательному написанию отчетов офицерами. Это обоснованное замечание — зависимость от технологий может сделать нас беспечными, а в полицейской работе важна каждая деталь. Кроме того, существует более широкая проблема того, что системы ИИ могут усугублять системные предубеждения. Исследования показали, что инструменты на основе ИИ, если их не контролировать должным образом, могут усиливать дискриминацию в различных областях, включая найм на работу. Может ли то же самое произойти в правоохранительных органах?

Компания Axon настаивает, что каждый отчет, созданный Draft One, должен быть проверен и утвержден человеком-офицером, что является защитой от ошибок и предубеждений. Но это все равно оставляет место для человеческой ошибки, которая уже является известной проблемой в полицейской работе. А что насчет самого ИИ? Лингвисты обнаружили, что большие языковые модели, такие как GPT-4, могут воплощать скрытый расизм и поддерживать предубеждения против диалектов, особенно в отношении маргинализированных языков, таких как афроамериканский английский. Это серьезная проблема, когда речь идет о обеспечении справедливой и беспристрастной полицейской деятельности.

Тестирование и ответственность

Компания Axon предприняла шаги для решения этих проблем, проводя внутренние исследования для проверки наличия расовых предубеждений в отчетах Draft One. Они не обнаружили существенных различий между отчетами, созданными ИИ, и оригинальными стенограммами. Но достаточно ли этого? Компания также исследует использование компьютерного зрения для обобщения видеоматериалов, хотя генеральный директор Рик Смит признает чувствительность вопросов, связанных с полицией и расовыми проблемами, указывая на осторожный подход к этой технологии.

Несмотря на эти усилия, более широкое влияние ИИ на полицейскую деятельность остается под вопросом. Цель Axon — сократить количество смертей от огнестрельного оружия между полицией и гражданскими лицами на 50%, но статистика базы данных о полицейских расстрелах Washington Post показывает рост числа убийств полицией с 2020 года, даже с широким внедрением нательных камер. Это говорит о том, что технология сама по себе не является решением сложных социальных проблем.

По мере того как все больше полицейских управлений рассматривают возможность внедрения инструментов, таких как Draft One, потенциальные преимущества и риски будут продолжать обсуждаться. Это увлекательное время, полное возможностей, но также и неопределенности. Ключевым будет баланс между инновациями и ответственностью, чтобы ИИ усиливал, а не подрывал целостность правоохранительных органов.

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

Ослабляет ли обучение эффект когнитивной разгрузки, вызванной искусственным интеллектом?

Недавнее расследование на сайте Unite.ai под названием "ChatGPT может истощить ваш мозг: Когнитивный долг в эпоху ИИ" пролила свет на исследование Массачусетского технологического института. Журналист

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

Легко создавайте графики и визуализации на основе искусственного интеллекта для более глубокого понимания данных

Современный анализ данных требует интуитивной визуализации сложной информации. Решения для создания графиков на основе искусственного интеллекта стали незаменимыми помощниками, революционизируя способ

Трансформируйте свою стратегию продаж: Технология искусственного интеллекта для холодных звонков на базе Vapi

Современный бизнес работает с молниеносной скоростью, требуя инновационных решений, чтобы оставаться конкурентоспособным. Представьте себе революцию в работе вашего агентства с помощью системы холодны

Трансформируйте свою стратегию продаж: Технология искусственного интеллекта для холодных звонков на базе Vapi

Современный бизнес работает с молниеносной скоростью, требуя инновационных решений, чтобы оставаться конкурентоспособным. Представьте себе революцию в работе вашего агентства с помощью системы холодны

27 августа 2025 г., 6:01:27 GMT+03:00

27 августа 2025 г., 6:01:27 GMT+03:00

This AI crime reporting stuff sounds like a game-changer, but I’m skeptical. Can a chatbot really capture the nuance of a crime scene without screwing up details? I mean, efficiency’s great, but if it’s spitting out generic reports, that’s a lawsuit waiting to happen. 😬 Curious to see how they handle the ethical side of this.

0

0

23 апреля 2025 г., 20:34:31 GMT+03:00

23 апреля 2025 г., 20:34:31 GMT+03:00

Die Idee, dass AI Polizeiberichte schreibt, klingt cool, aber auch ein bisschen beängstigend. Was, wenn das AI die Fakten vermasselt? Die Polizei von Oklahoma City scheint dabei zu sein, aber ich bin mir noch nicht sicher, ob ich es vertraue. Braucht mehr Tests, denke ich! 🤔

0

0

23 апреля 2025 г., 10:06:58 GMT+03:00

23 апреля 2025 г., 10:06:58 GMT+03:00

Using AI for crime reports sounds cool, but man, the potential for errors is scary! Imagine if the AI messes up and someone gets wrongly accused. Oklahoma City's police are using it, but I'm not sure I trust it yet. Maybe with more testing, it could be safer? 🤔👮♂️

0

0

22 апреля 2025 г., 16:58:41 GMT+03:00

22 апреля 2025 г., 16:58:41 GMT+03:00

Usar IA para relatórios de crimes parece legal, mas cara, a possibilidade de erros é assustadora! Imagina se a IA erra e alguém é acusado injustamente. A polícia de Oklahoma City está usando, mas não tenho certeza se confio nisso ainda. Talvez com mais testes, possa ser mais seguro? 🤔👮♂️

0

0

22 апреля 2025 г., 5:56:00 GMT+03:00

22 апреля 2025 г., 5:56:00 GMT+03:00

범죄 보고서에 AI를 사용하는 것이 멋지게 들리지만, 오류의 가능성은 무섭네요! AI가 잘못하면 누군가가 잘못 고발될 수도 있어요. 오클라호마 시티 경찰이 사용하고 있지만, 아직 믿을 수 없어요. 더 많은 테스트를 하면 안전해질까요? 🤔👮♂️

0

0

22 апреля 2025 г., 5:51:47 GMT+03:00

22 апреля 2025 г., 5:51:47 GMT+03:00

A ideia de um AI escrever relatórios de crimes parece legal, mas também é assustadora. E se o AI errar os fatos? A polícia de Oklahoma City parece estar a bordo, mas eu ainda não confio muito. Precisa de mais testes, acho eu! 🤔

0

0