専門家は、クラウドソーシングされたAIベンチマークの深刻な欠陥を強調しています

AIラボは、最新モデルの能力を評価するために、Chatbot Arenaのようなクラウドソーシングによるベンチマークプラットフォームにますます注目しています。しかし、一部の専門家は、この方法が重大な倫理的および学術的な懸念を引き起こすと主張しています。

近年、OpenAI、Google、Metaなどの主要企業は、ユーザーを巻き込んで次期モデルのパフォーマンスを評価するプラットフォームを活用してきました。これらのプラットフォームでの高スコアは、ラボがモデルの進歩の証として強調することがよくあります。しかし、このアプローチには批判もあります。

クラウドソーシングベンチマークの批判

ワシントン大学の言語学教授であり、「The AI Con」の共著者であるエミリー・ベンダー氏は、特にChatbot Arenaのようなベンチマークの妥当性について懸念を表明しています。このプラットフォームでは、ボランティアが2つの匿名モデルの応答を比較し、好みのものを選択します。ベンダー氏は、ベンチマークが有効であるためには、特定のものを測定し、構成妥当性(測定が評価対象の構成を正確に反映すること)を示す必要があると主張します。彼女は、Chatbot Arenaには、ユーザーが一方の出力結果を他方よりも好むことが、定義された基準と本当に関連しているという証拠が欠けていると述べています。

AI企業Lesanの共同創業者であり、Distributed AI Research Instituteのフェローであるアスメラシュ・テカ・ハドゥ氏は、これらのベンチマークがAIラボによってモデルの誇張された主張のために悪用されていると示唆しています。彼は、MetaのLlama 4 Maverickモデルに関する最近の事例を挙げ、MetaがChatbot Arenaで良好なパフォーマンスを発揮するように微調整したバージョンを作成したが、代わりに効果の低いバージョンをリリースしたと指摘しました。ハドゥ氏は、ベンチマークは動的で、複数の独立した組織に分散され、教育や医療などの分野でモデルを使用する専門家によって特定のユースケースに合わせて調整されるべきだと主張しています。

公正な報酬とより広範な評価方法の必要性

ハドゥ氏と、Aspen InstituteのEmergent and Intelligent Technologies Initiativeの元リーダーであるクリスティン・グロリア氏は、評価者はその労働に対して報酬を受けるべきだと主張し、しばしば搾取的なデータラベリング業界と比較しています。グロリア氏は、クラウドソーシングによるベンチマークを市民科学イニシアチブに似た価値あるものと見なしていますが、特に業界の急速な革新のペースを考慮すると、ベンチマークが評価の唯一の基準であってはならないと強調しています。

クラウドソーシングによるレッドチームキャンペーンを実施するGray Swan AIのCEO、マット・フレドリクソン氏は、新しいスキルを学び、練習したいボランティアにとってそのようなプラットフォームの魅力があることを認めています。しかし、彼は公開ベンチマークが、有料のプライベート評価によるより詳細な評価を置き換えることはできないと強調します。フレドリクソン氏は、開発者は内部ベンチマーク、アルゴリズムによるレッドチーム、そしてよりオープンエンドでドメイン固有の洞察を提供できる契約専門家にも依存すべきだと提案しています。

ベンチマークに関する業界の視点

モデルマーケットプレイスOpenRouterのCEO、アレックス・アタラ氏と、Chatbot Arenaを管理するLMArenaの創設者の一人でカリフォルニア大学バークレー校のAI博士課程学生であるウェイリン・チアン氏は、オープンテストとベンチマークだけでは不十分であることに同意しています。チアン氏は、LMArenaの目標は、さまざまなAIモデルに関するコミュニティの好みを測定する信頼できるオープンな場を提供することだと強調しています。

Maverickベンチマークをめぐる論争について、チアン氏は、そのような事件はChatbot Arenaの設計上の欠陥によるものではなく、ラボによるポリシーの誤解によるものだと明確にしています。LMArenaは以来、公正で再現可能な評価を確保するためにポリシーを更新しました。チアン氏は、プラットフォームのコミュニティは単なるボランティアやテスターの集まりではなく、AIモデルに対する集団的なフィードバックを提供する積極的なグループだと強調しています。

クラウドソーシングベンチマークプラットフォームの使用をめぐる議論は、公開の意見と厳格な専門的評価を組み合わせた、よりニュアンスのあるAIモデル評価のアプローチが必要であることを浮き彫りにしています。これにより、正確さと公平性の両方が確保されます。

関連記事

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

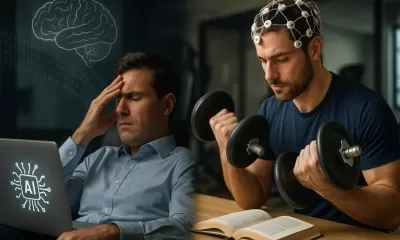

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

コメント (16)

0/200

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

コメント (16)

0/200

![AlbertScott]() AlbertScott

AlbertScott

2025年8月1日 22:47:34 JST

2025年8月1日 22:47:34 JST

Crowdsourced AI benchmarks sound cool, but experts pointing out ethical issues makes me wonder if we're rushing too fast. 🤔 Are we sacrificing quality for hype?

0

0

![JonathanAllen]() JonathanAllen

JonathanAllen

2025年4月27日 16:34:07 JST

2025年4月27日 16:34:07 JST

Estou acompanhando o debate sobre benchmarks de IA crowdsourced e, honestamente, é uma bagunça. Os especialistas têm razão ao apontar as falhas, mas qual é a alternativa? É como tentar consertar um barco que vaza com mais buracos. Ainda assim, é uma leitura interessante e certamente faz você pensar sobre o futuro da ética em IA. Experimente se você gosta desse tipo de coisa! 😅

0

0

![AlbertWalker]() AlbertWalker

AlbertWalker

2025年4月27日 14:24:31 JST

2025年4月27日 14:24:31 JST

Nossa, benchmarks de IA por multidão? Parece legal, mas com falhas éticas? Tô pensando se isso não atrapalha a inovação. As big techs precisam resolver isso logo! 🚀

0

0

![RogerRodriguez]() RogerRodriguez

RogerRodriguez

2025年4月27日 12:52:29 JST

2025年4月27日 12:52:29 JST

I've been following the debate on crowdsourced AI benchmarks and honestly, it's a mess. Experts are right to point out the flaws, but what's the alternative? It's like trying to fix a leaky boat with more holes. Still, it's an interesting read and definitely makes you think about the future of AI ethics. Give it a go if you're into that kinda stuff! 😅

0

0

![JonathanAllen]() JonathanAllen

JonathanAllen

2025年4月27日 10:40:09 JST

2025年4月27日 10:40:09 JST

Intéressant, mais inquiétant ! Les benchmarks par crowdsourcing, c’est innovant, mais les failles éthiques me font réfléchir. Les géants comme Google vont devoir être transparents. 🧐

0

0

![BrianWalker]() BrianWalker

BrianWalker

2025年4月27日 0:31:56 JST

2025年4月27日 0:31:56 JST

Wow, crowdsourced AI benchmarks sound cool but flawed? Kinda makes sense—random people judging AI might not be super reliable. 🤔 Curious how OpenAI and Google will fix this!

0

0

AIラボは、最新モデルの能力を評価するために、Chatbot Arenaのようなクラウドソーシングによるベンチマークプラットフォームにますます注目しています。しかし、一部の専門家は、この方法が重大な倫理的および学術的な懸念を引き起こすと主張しています。

近年、OpenAI、Google、Metaなどの主要企業は、ユーザーを巻き込んで次期モデルのパフォーマンスを評価するプラットフォームを活用してきました。これらのプラットフォームでの高スコアは、ラボがモデルの進歩の証として強調することがよくあります。しかし、このアプローチには批判もあります。

クラウドソーシングベンチマークの批判

ワシントン大学の言語学教授であり、「The AI Con」の共著者であるエミリー・ベンダー氏は、特にChatbot Arenaのようなベンチマークの妥当性について懸念を表明しています。このプラットフォームでは、ボランティアが2つの匿名モデルの応答を比較し、好みのものを選択します。ベンダー氏は、ベンチマークが有効であるためには、特定のものを測定し、構成妥当性(測定が評価対象の構成を正確に反映すること)を示す必要があると主張します。彼女は、Chatbot Arenaには、ユーザーが一方の出力結果を他方よりも好むことが、定義された基準と本当に関連しているという証拠が欠けていると述べています。

AI企業Lesanの共同創業者であり、Distributed AI Research Instituteのフェローであるアスメラシュ・テカ・ハドゥ氏は、これらのベンチマークがAIラボによってモデルの誇張された主張のために悪用されていると示唆しています。彼は、MetaのLlama 4 Maverickモデルに関する最近の事例を挙げ、MetaがChatbot Arenaで良好なパフォーマンスを発揮するように微調整したバージョンを作成したが、代わりに効果の低いバージョンをリリースしたと指摘しました。ハドゥ氏は、ベンチマークは動的で、複数の独立した組織に分散され、教育や医療などの分野でモデルを使用する専門家によって特定のユースケースに合わせて調整されるべきだと主張しています。

公正な報酬とより広範な評価方法の必要性

ハドゥ氏と、Aspen InstituteのEmergent and Intelligent Technologies Initiativeの元リーダーであるクリスティン・グロリア氏は、評価者はその労働に対して報酬を受けるべきだと主張し、しばしば搾取的なデータラベリング業界と比較しています。グロリア氏は、クラウドソーシングによるベンチマークを市民科学イニシアチブに似た価値あるものと見なしていますが、特に業界の急速な革新のペースを考慮すると、ベンチマークが評価の唯一の基準であってはならないと強調しています。

クラウドソーシングによるレッドチームキャンペーンを実施するGray Swan AIのCEO、マット・フレドリクソン氏は、新しいスキルを学び、練習したいボランティアにとってそのようなプラットフォームの魅力があることを認めています。しかし、彼は公開ベンチマークが、有料のプライベート評価によるより詳細な評価を置き換えることはできないと強調します。フレドリクソン氏は、開発者は内部ベンチマーク、アルゴリズムによるレッドチーム、そしてよりオープンエンドでドメイン固有の洞察を提供できる契約専門家にも依存すべきだと提案しています。

ベンチマークに関する業界の視点

モデルマーケットプレイスOpenRouterのCEO、アレックス・アタラ氏と、Chatbot Arenaを管理するLMArenaの創設者の一人でカリフォルニア大学バークレー校のAI博士課程学生であるウェイリン・チアン氏は、オープンテストとベンチマークだけでは不十分であることに同意しています。チアン氏は、LMArenaの目標は、さまざまなAIモデルに関するコミュニティの好みを測定する信頼できるオープンな場を提供することだと強調しています。

Maverickベンチマークをめぐる論争について、チアン氏は、そのような事件はChatbot Arenaの設計上の欠陥によるものではなく、ラボによるポリシーの誤解によるものだと明確にしています。LMArenaは以来、公正で再現可能な評価を確保するためにポリシーを更新しました。チアン氏は、プラットフォームのコミュニティは単なるボランティアやテスターの集まりではなく、AIモデルに対する集団的なフィードバックを提供する積極的なグループだと強調しています。

クラウドソーシングベンチマークプラットフォームの使用をめぐる議論は、公開の意見と厳格な専門的評価を組み合わせた、よりニュアンスのあるAIモデル評価のアプローチが必要であることを浮き彫りにしています。これにより、正確さと公平性の両方が確保されます。

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

2025年8月1日 22:47:34 JST

2025年8月1日 22:47:34 JST

Crowdsourced AI benchmarks sound cool, but experts pointing out ethical issues makes me wonder if we're rushing too fast. 🤔 Are we sacrificing quality for hype?

0

0

2025年4月27日 16:34:07 JST

2025年4月27日 16:34:07 JST

Estou acompanhando o debate sobre benchmarks de IA crowdsourced e, honestamente, é uma bagunça. Os especialistas têm razão ao apontar as falhas, mas qual é a alternativa? É como tentar consertar um barco que vaza com mais buracos. Ainda assim, é uma leitura interessante e certamente faz você pensar sobre o futuro da ética em IA. Experimente se você gosta desse tipo de coisa! 😅

0

0

2025年4月27日 14:24:31 JST

2025年4月27日 14:24:31 JST

Nossa, benchmarks de IA por multidão? Parece legal, mas com falhas éticas? Tô pensando se isso não atrapalha a inovação. As big techs precisam resolver isso logo! 🚀

0

0

2025年4月27日 12:52:29 JST

2025年4月27日 12:52:29 JST

I've been following the debate on crowdsourced AI benchmarks and honestly, it's a mess. Experts are right to point out the flaws, but what's the alternative? It's like trying to fix a leaky boat with more holes. Still, it's an interesting read and definitely makes you think about the future of AI ethics. Give it a go if you're into that kinda stuff! 😅

0

0

2025年4月27日 10:40:09 JST

2025年4月27日 10:40:09 JST

Intéressant, mais inquiétant ! Les benchmarks par crowdsourcing, c’est innovant, mais les failles éthiques me font réfléchir. Les géants comme Google vont devoir être transparents. 🧐

0

0

2025年4月27日 0:31:56 JST

2025年4月27日 0:31:56 JST

Wow, crowdsourced AI benchmarks sound cool but flawed? Kinda makes sense—random people judging AI might not be super reliable. 🤔 Curious how OpenAI and Google will fix this!

0

0