Experten heben schwerwiegende Mängel in Crowdsourced AI -Benchmarks auf

KI-Labore nutzen zunehmend Plattformen für crowdsourced Benchmarking wie Chatbot Arena, um die Fähigkeiten ihrer neuesten Modelle zu bewerten. Einige Experten argumentieren jedoch, dass diese Methode erhebliche ethische und akademische Bedenken aufwirft.

In den letzten Jahren haben große Akteure wie OpenAI, Google und Meta Plattformen genutzt, die Nutzer einbinden, um die Leistung ihrer kommenden Modelle zu bewerten. Ein hoher Score auf diesen Plattformen wird von den Laboren oft als Beweis für den Fortschritt ihres Modells hervorgehoben. Dieser Ansatz ist jedoch nicht ohne Kritiker.

Die Kritik am Crowdsourced Benchmarking

Emily Bender, Linguistikprofessorin an der University of Washington und Mitautorin von "The AI Con", äußert Bedenken hinsichtlich der Validität solcher Benchmarks, insbesondere Chatbot Arena. Diese Plattform lässt Freiwillige Antworten von zwei anonymen Modellen vergleichen und ihr bevorzugtes auswählen. Bender argumentiert, dass ein Benchmark effektiv sein muss, um etwas Spezifisches zu messen und Konstruktvalidität zu zeigen, was bedeutet, dass die Messung das zu bewertende Konstrukt genau widerspiegeln sollte. Sie stellt fest, dass Chatbot Arena keine Beweise dafür liefert, dass Nutzerpräferenzen für eine Antwort gegenüber einer anderen tatsächlich mit definierten Kriterien korrelieren.

Asmelash Teka Hadgu, Mitbegründer der KI-Firma Lesan und Fellow am Distributed AI Research Institute, legt nahe, dass diese Benchmarks von KI-Laboren ausgenutzt werden, um übertriebene Behauptungen über ihre Modelle aufzustellen. Er verwies auf einen kürzlichen Vorfall mit Metas Llama 4 Maverick-Modell, bei dem Meta eine Version optimierte, um auf Chatbot Arena gut abzuschneiden, aber stattdessen eine weniger effektive Version veröffentlichte. Hadgu plädiert für dynamische Benchmarks, die über mehrere unabhängige Einheiten verteilt und auf spezifische Anwendungsfälle in Bereichen wie Bildung und Gesundheitswesen zugeschnitten sind, von Fachleuten, die diese Modelle in ihrer Arbeit nutzen.

Der Ruf nach fairer Vergütung und breiteren Evaluationsmethoden

Hadgu und Kristine Gloria, ehemalige Leiterin der Emergent and Intelligent Technologies Initiative des Aspen Institute, argumentieren, dass Evaluatoren für ihre Arbeit bezahlt werden sollten, in Anlehnung an die oft ausbeuterische Datenkennzeichnungsindustrie. Gloria sieht crowdsourced Benchmarking als wertvoll, ähnlich wie Bürgerwissenschaftsinitiativen, betont jedoch, dass Benchmarks nicht das einzige Bewertungskriterium sein sollten, insbesondere angesichts des schnellen Tempos der Brancheninnovation.

Matt Fredrikson, CEO von Gray Swan AI, das crowdsourced Red-Teaming-Kampagnen durchführt, erkennt den Reiz solcher Plattformen für Freiwillige an, die neue Fähigkeiten lernen und üben möchten. Er betont jedoch, dass öffentliche Benchmarks die tiefergehenden Bewertungen durch bezahlte, private Assessments nicht ersetzen können. Fredrikson schlägt vor, dass Entwickler auch auf interne Benchmarks, algorithmische Red Teams und beauftragte Experten setzen sollten, die offenere und domänenspezifische Einblicke bieten können.

Branchenperspektiven zum Benchmarking

Alex Atallah, CEO des Modellmarktplatzes OpenRouter, und Wei-Lin Chiang, KI-Doktorand an der UC Berkeley und einer der Gründer von LMArena (das Chatbot Arena verwaltet), stimmen zu, dass offenes Testen und Benchmarking allein nicht ausreichen. Chiang betont, dass das Ziel von LMArena darin besteht, einen vertrauenswürdigen, offenen Raum zu bieten, um die Präferenzen der Gemeinschaft für verschiedene KI-Modelle zu ermitteln.

In Bezug auf die Kontroverse um den Maverick-Benchmark stellt Chiang klar, dass solche Vorfälle nicht auf Designfehler von Chatbot Arena zurückzuführen sind, sondern auf Fehlinterpretationen seiner Richtlinien durch Labore. LMArena hat seine Richtlinien seitdem aktualisiert, um faire und reproduzierbare Bewertungen sicherzustellen. Chiang unterstreicht, dass die Community der Plattform nicht nur eine Gruppe von Freiwilligen oder Testern ist, sondern eine engagierte Gruppe, die kollektives Feedback zu KI-Modellen liefert.

Die anhaltende Debatte über die Nutzung von crowdsourced Benchmarking-Plattformen unterstreicht die Notwendigkeit eines nuancierteren Ansatzes für die Bewertung von KI-Modellen, der öffentliche Beiträge mit strengen, professionellen Bewertungen kombiniert, um sowohl Genauigkeit als auch Fairness zu gewährleisten.

Verwandter Artikel

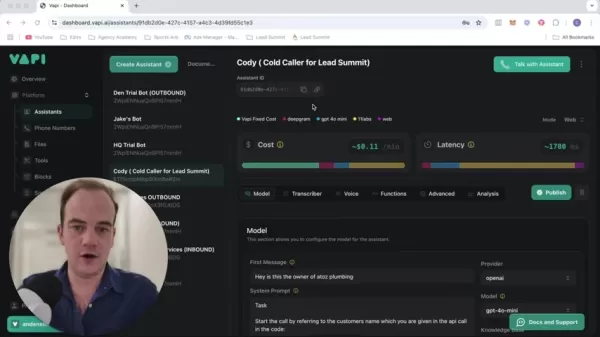

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Kommentare (16)

0/200

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Kommentare (16)

0/200

![AlbertScott]() AlbertScott

AlbertScott

1. August 2025 15:47:34 MESZ

1. August 2025 15:47:34 MESZ

Crowdsourced AI benchmarks sound cool, but experts pointing out ethical issues makes me wonder if we're rushing too fast. 🤔 Are we sacrificing quality for hype?

0

0

![JonathanAllen]() JonathanAllen

JonathanAllen

27. April 2025 09:34:07 MESZ

27. April 2025 09:34:07 MESZ

Estou acompanhando o debate sobre benchmarks de IA crowdsourced e, honestamente, é uma bagunça. Os especialistas têm razão ao apontar as falhas, mas qual é a alternativa? É como tentar consertar um barco que vaza com mais buracos. Ainda assim, é uma leitura interessante e certamente faz você pensar sobre o futuro da ética em IA. Experimente se você gosta desse tipo de coisa! 😅

0

0

![AlbertWalker]() AlbertWalker

AlbertWalker

27. April 2025 07:24:31 MESZ

27. April 2025 07:24:31 MESZ

Nossa, benchmarks de IA por multidão? Parece legal, mas com falhas éticas? Tô pensando se isso não atrapalha a inovação. As big techs precisam resolver isso logo! 🚀

0

0

![RogerRodriguez]() RogerRodriguez

RogerRodriguez

27. April 2025 05:52:29 MESZ

27. April 2025 05:52:29 MESZ

I've been following the debate on crowdsourced AI benchmarks and honestly, it's a mess. Experts are right to point out the flaws, but what's the alternative? It's like trying to fix a leaky boat with more holes. Still, it's an interesting read and definitely makes you think about the future of AI ethics. Give it a go if you're into that kinda stuff! 😅

0

0

![JonathanAllen]() JonathanAllen

JonathanAllen

27. April 2025 03:40:09 MESZ

27. April 2025 03:40:09 MESZ

Intéressant, mais inquiétant ! Les benchmarks par crowdsourcing, c’est innovant, mais les failles éthiques me font réfléchir. Les géants comme Google vont devoir être transparents. 🧐

0

0

![BrianWalker]() BrianWalker

BrianWalker

26. April 2025 17:31:56 MESZ

26. April 2025 17:31:56 MESZ

Wow, crowdsourced AI benchmarks sound cool but flawed? Kinda makes sense—random people judging AI might not be super reliable. 🤔 Curious how OpenAI and Google will fix this!

0

0

KI-Labore nutzen zunehmend Plattformen für crowdsourced Benchmarking wie Chatbot Arena, um die Fähigkeiten ihrer neuesten Modelle zu bewerten. Einige Experten argumentieren jedoch, dass diese Methode erhebliche ethische und akademische Bedenken aufwirft.

In den letzten Jahren haben große Akteure wie OpenAI, Google und Meta Plattformen genutzt, die Nutzer einbinden, um die Leistung ihrer kommenden Modelle zu bewerten. Ein hoher Score auf diesen Plattformen wird von den Laboren oft als Beweis für den Fortschritt ihres Modells hervorgehoben. Dieser Ansatz ist jedoch nicht ohne Kritiker.

Die Kritik am Crowdsourced Benchmarking

Emily Bender, Linguistikprofessorin an der University of Washington und Mitautorin von "The AI Con", äußert Bedenken hinsichtlich der Validität solcher Benchmarks, insbesondere Chatbot Arena. Diese Plattform lässt Freiwillige Antworten von zwei anonymen Modellen vergleichen und ihr bevorzugtes auswählen. Bender argumentiert, dass ein Benchmark effektiv sein muss, um etwas Spezifisches zu messen und Konstruktvalidität zu zeigen, was bedeutet, dass die Messung das zu bewertende Konstrukt genau widerspiegeln sollte. Sie stellt fest, dass Chatbot Arena keine Beweise dafür liefert, dass Nutzerpräferenzen für eine Antwort gegenüber einer anderen tatsächlich mit definierten Kriterien korrelieren.

Asmelash Teka Hadgu, Mitbegründer der KI-Firma Lesan und Fellow am Distributed AI Research Institute, legt nahe, dass diese Benchmarks von KI-Laboren ausgenutzt werden, um übertriebene Behauptungen über ihre Modelle aufzustellen. Er verwies auf einen kürzlichen Vorfall mit Metas Llama 4 Maverick-Modell, bei dem Meta eine Version optimierte, um auf Chatbot Arena gut abzuschneiden, aber stattdessen eine weniger effektive Version veröffentlichte. Hadgu plädiert für dynamische Benchmarks, die über mehrere unabhängige Einheiten verteilt und auf spezifische Anwendungsfälle in Bereichen wie Bildung und Gesundheitswesen zugeschnitten sind, von Fachleuten, die diese Modelle in ihrer Arbeit nutzen.

Der Ruf nach fairer Vergütung und breiteren Evaluationsmethoden

Hadgu und Kristine Gloria, ehemalige Leiterin der Emergent and Intelligent Technologies Initiative des Aspen Institute, argumentieren, dass Evaluatoren für ihre Arbeit bezahlt werden sollten, in Anlehnung an die oft ausbeuterische Datenkennzeichnungsindustrie. Gloria sieht crowdsourced Benchmarking als wertvoll, ähnlich wie Bürgerwissenschaftsinitiativen, betont jedoch, dass Benchmarks nicht das einzige Bewertungskriterium sein sollten, insbesondere angesichts des schnellen Tempos der Brancheninnovation.

Matt Fredrikson, CEO von Gray Swan AI, das crowdsourced Red-Teaming-Kampagnen durchführt, erkennt den Reiz solcher Plattformen für Freiwillige an, die neue Fähigkeiten lernen und üben möchten. Er betont jedoch, dass öffentliche Benchmarks die tiefergehenden Bewertungen durch bezahlte, private Assessments nicht ersetzen können. Fredrikson schlägt vor, dass Entwickler auch auf interne Benchmarks, algorithmische Red Teams und beauftragte Experten setzen sollten, die offenere und domänenspezifische Einblicke bieten können.

Branchenperspektiven zum Benchmarking

Alex Atallah, CEO des Modellmarktplatzes OpenRouter, und Wei-Lin Chiang, KI-Doktorand an der UC Berkeley und einer der Gründer von LMArena (das Chatbot Arena verwaltet), stimmen zu, dass offenes Testen und Benchmarking allein nicht ausreichen. Chiang betont, dass das Ziel von LMArena darin besteht, einen vertrauenswürdigen, offenen Raum zu bieten, um die Präferenzen der Gemeinschaft für verschiedene KI-Modelle zu ermitteln.

In Bezug auf die Kontroverse um den Maverick-Benchmark stellt Chiang klar, dass solche Vorfälle nicht auf Designfehler von Chatbot Arena zurückzuführen sind, sondern auf Fehlinterpretationen seiner Richtlinien durch Labore. LMArena hat seine Richtlinien seitdem aktualisiert, um faire und reproduzierbare Bewertungen sicherzustellen. Chiang unterstreicht, dass die Community der Plattform nicht nur eine Gruppe von Freiwilligen oder Testern ist, sondern eine engagierte Gruppe, die kollektives Feedback zu KI-Modellen liefert.

Die anhaltende Debatte über die Nutzung von crowdsourced Benchmarking-Plattformen unterstreicht die Notwendigkeit eines nuancierteren Ansatzes für die Bewertung von KI-Modellen, der öffentliche Beiträge mit strengen, professionellen Bewertungen kombiniert, um sowohl Genauigkeit als auch Fairness zu gewährleisten.

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

1. August 2025 15:47:34 MESZ

1. August 2025 15:47:34 MESZ

Crowdsourced AI benchmarks sound cool, but experts pointing out ethical issues makes me wonder if we're rushing too fast. 🤔 Are we sacrificing quality for hype?

0

0

27. April 2025 09:34:07 MESZ

27. April 2025 09:34:07 MESZ

Estou acompanhando o debate sobre benchmarks de IA crowdsourced e, honestamente, é uma bagunça. Os especialistas têm razão ao apontar as falhas, mas qual é a alternativa? É como tentar consertar um barco que vaza com mais buracos. Ainda assim, é uma leitura interessante e certamente faz você pensar sobre o futuro da ética em IA. Experimente se você gosta desse tipo de coisa! 😅

0

0

27. April 2025 07:24:31 MESZ

27. April 2025 07:24:31 MESZ

Nossa, benchmarks de IA por multidão? Parece legal, mas com falhas éticas? Tô pensando se isso não atrapalha a inovação. As big techs precisam resolver isso logo! 🚀

0

0

27. April 2025 05:52:29 MESZ

27. April 2025 05:52:29 MESZ

I've been following the debate on crowdsourced AI benchmarks and honestly, it's a mess. Experts are right to point out the flaws, but what's the alternative? It's like trying to fix a leaky boat with more holes. Still, it's an interesting read and definitely makes you think about the future of AI ethics. Give it a go if you're into that kinda stuff! 😅

0

0

27. April 2025 03:40:09 MESZ

27. April 2025 03:40:09 MESZ

Intéressant, mais inquiétant ! Les benchmarks par crowdsourcing, c’est innovant, mais les failles éthiques me font réfléchir. Les géants comme Google vont devoir être transparents. 🧐

0

0

26. April 2025 17:31:56 MESZ

26. April 2025 17:31:56 MESZ

Wow, crowdsourced AI benchmarks sound cool but flawed? Kinda makes sense—random people judging AI might not be super reliable. 🤔 Curious how OpenAI and Google will fix this!

0

0