アリババの「ZeroSearch」AI、自律学習でトレーニングコストを88%削減

アリババのゼロサーチ:AIの学習効率に変革をもたらす

アリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を培うことを可能にする。

「従来の強化学習では、大規模な検索要求が必要なため、APIコストがかさみ、スケーラビリティの妨げになっていました」と、研究者たちは新たに発表したarXiv論文で説明している。"ZeroSearchは、実際の検索エンジンに依存せずにLLMの検索機能を強化する、費用対効果の高い強化学習フレームワークを表している。"

検索不要のトレーニングを支える仕組み

現在のAI学習方法は、主に2つの制約に直面している:学習サイクル中の商用検索エンジンによる一貫性のない文書品質と、Google検索のようなサービスへの膨大なAPIコール量による法外な費用である。

ZeroSearchは、革新的な2段階のアプローチを実装している:

- 最初の教師付き微調整は、LLMを文書生成モジュールに変換する。

- 高度なカリキュラムベースの強化は、出力品質を徐々に変化させる。

「我々の基本的な発見は、事前に訓練されたLLMは、文脈に適した文書を生成するのに十分な世界知識を持っていることを明らかにした」と研究者たちは述べている。「シミュレートされた検索出力と実際の検索出力の主な違いは、実質的な内容のギャップではなく、文体的なテキストの違いである。

性能ベンチマークが示す大きな利点

7つの異なる質問回答データセットでの厳密なテストにより、ZeroSearchの優位性が実証された:

- 7BのパラメータモデルがGoogle検索の精度と一致

- 14Bのパラメータ構成は、商用検索のパフォーマンスを上回りました。

経済的な影響は特に顕著です:

- 64Kクエリを使用した従来のトレーニング:SerpAPI経由で586.70ドル

- A100GPUを4台使用したZeroSearchと同等:70.80ドル

- 総コスト削減:88

「これらの結果は、強化学習の実装において、LLMが従来の検索エンジンの代替となることを証明するものです」と研究チームは結論付けている。

AI開発への広範な影響

ZeroSearchは、外部ツールに依存しない自律的な能力開発を実証することで、人工知能トレーニング手法のパラダイムシフトを意味する。

このテクノロジーは、いくつかの変革的影響を約束する:

- コストの民主化:高価なAPI依存を排除することで、新興企業にとっての経済的障壁を軽減する。

- トレーニングの制御:モデル開発中の情報入力の正確な制御を可能にする。

- アーキテクチャの柔軟性:Qwen-2.5やLLaMA-3.2を含む主要なモデルファミリーに互換性があります。

アリババは、コードベース、トレーニングデータセット、事前学習済みモデルを含む完全な実装を、GitHubとHugging Faceリポジトリを通じてオープンソース化している。

この技術革新は、外部サービスに依存するのではなく、高度なシミュレーションを通じて高度な能力が生まれるという、新たなAI開発の展望を予見させるものだ。このような自給自足のトレーニング技術が成熟するにつれて、主要なプラットフォームAPIに依存している現在の技術エコシステムを大幅に再編成する可能性がある。

関連記事

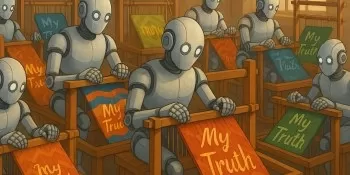

AIパーソナライゼーションは現実を強化するのか、歪めるのか?隠されたリスクを探る

手書きが記憶を外部化し、電卓が計算を自動化し、GPSシステムが道案内を代替した。人工知能システムは、私たちの判断能力、合成能力、そして意味を構築する能力さえも引き継ぎ始めているのだ。パーソナライゼーションのパラドックス現代のAIは、単に私たちの問い合わせに答えるだけでなく、私たちの行動パターンを丹念に研究している。無数のマイクロ・インタラクションを通じて、これらのシステムは私たちの最も親しい親友が

AIパーソナライゼーションは現実を強化するのか、歪めるのか?隠されたリスクを探る

手書きが記憶を外部化し、電卓が計算を自動化し、GPSシステムが道案内を代替した。人工知能システムは、私たちの判断能力、合成能力、そして意味を構築する能力さえも引き継ぎ始めているのだ。パーソナライゼーションのパラドックス現代のAIは、単に私たちの問い合わせに答えるだけでなく、私たちの行動パターンを丹念に研究している。無数のマイクロ・インタラクションを通じて、これらのシステムは私たちの最も親しい親友が

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

コメント (0)

0/200

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

コメント (0)

0/200

アリババのゼロサーチ:AIの学習効率に変革をもたらす

アリババグループの研究者は、AIシステムが情報検索を学習する方法に革命を起こす可能性のある画期的な方法を開拓し、コストのかかる商用検索エンジンAPIを完全に回避した。彼らのZeroSearchテクノロジーは、大規模な言語モデルが、トレーニング段階において、従来の検索エンジンとのやりとりの代わりに、シミュレートされた環境を通して洗練された検索能力を培うことを可能にする。

「従来の強化学習では、大規模な検索要求が必要なため、APIコストがかさみ、スケーラビリティの妨げになっていました」と、研究者たちは新たに発表したarXiv論文で説明している。"ZeroSearchは、実際の検索エンジンに依存せずにLLMの検索機能を強化する、費用対効果の高い強化学習フレームワークを表している。"

検索不要のトレーニングを支える仕組み

現在のAI学習方法は、主に2つの制約に直面している:学習サイクル中の商用検索エンジンによる一貫性のない文書品質と、Google検索のようなサービスへの膨大なAPIコール量による法外な費用である。

ZeroSearchは、革新的な2段階のアプローチを実装している:

- 最初の教師付き微調整は、LLMを文書生成モジュールに変換する。

- 高度なカリキュラムベースの強化は、出力品質を徐々に変化させる。

「我々の基本的な発見は、事前に訓練されたLLMは、文脈に適した文書を生成するのに十分な世界知識を持っていることを明らかにした」と研究者たちは述べている。「シミュレートされた検索出力と実際の検索出力の主な違いは、実質的な内容のギャップではなく、文体的なテキストの違いである。

性能ベンチマークが示す大きな利点

7つの異なる質問回答データセットでの厳密なテストにより、ZeroSearchの優位性が実証された:

- 7BのパラメータモデルがGoogle検索の精度と一致

- 14Bのパラメータ構成は、商用検索のパフォーマンスを上回りました。

経済的な影響は特に顕著です:

- 64Kクエリを使用した従来のトレーニング:SerpAPI経由で586.70ドル

- A100GPUを4台使用したZeroSearchと同等:70.80ドル

- 総コスト削減:88

「これらの結果は、強化学習の実装において、LLMが従来の検索エンジンの代替となることを証明するものです」と研究チームは結論付けている。

AI開発への広範な影響

ZeroSearchは、外部ツールに依存しない自律的な能力開発を実証することで、人工知能トレーニング手法のパラダイムシフトを意味する。

このテクノロジーは、いくつかの変革的影響を約束する:

- コストの民主化:高価なAPI依存を排除することで、新興企業にとっての経済的障壁を軽減する。

- トレーニングの制御:モデル開発中の情報入力の正確な制御を可能にする。

- アーキテクチャの柔軟性:Qwen-2.5やLLaMA-3.2を含む主要なモデルファミリーに互換性があります。

アリババは、コードベース、トレーニングデータセット、事前学習済みモデルを含む完全な実装を、GitHubとHugging Faceリポジトリを通じてオープンソース化している。

この技術革新は、外部サービスに依存するのではなく、高度なシミュレーションを通じて高度な能力が生まれるという、新たなAI開発の展望を予見させるものだ。このような自給自足のトレーニング技術が成熟するにつれて、主要なプラットフォームAPIに依存している現在の技術エコシステムを大幅に再編成する可能性がある。

AIパーソナライゼーションは現実を強化するのか、歪めるのか?隠されたリスクを探る

手書きが記憶を外部化し、電卓が計算を自動化し、GPSシステムが道案内を代替した。人工知能システムは、私たちの判断能力、合成能力、そして意味を構築する能力さえも引き継ぎ始めているのだ。パーソナライゼーションのパラドックス現代のAIは、単に私たちの問い合わせに答えるだけでなく、私たちの行動パターンを丹念に研究している。無数のマイクロ・インタラクションを通じて、これらのシステムは私たちの最も親しい親友が

AIパーソナライゼーションは現実を強化するのか、歪めるのか?隠されたリスクを探る

手書きが記憶を外部化し、電卓が計算を自動化し、GPSシステムが道案内を代替した。人工知能システムは、私たちの判断能力、合成能力、そして意味を構築する能力さえも引き継ぎ始めているのだ。パーソナライゼーションのパラドックス現代のAIは、単に私たちの問い合わせに答えるだけでなく、私たちの行動パターンを丹念に研究している。無数のマイクロ・インタラクションを通じて、これらのシステムは私たちの最も親しい親友が

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

サカナAIのTreeQuest、マルチモデル連携でAIのパフォーマンスを向上

日本のAI研究機関サカナAIは、複数の大規模言語モデル(LLM)を連携させ、非常に効果的なAIチームを形成する技術を発表した。Multi-LLM AB-MCTSと名付けられたこの手法では、モデルが試行錯誤を繰り返し、それぞれの強みを活かして、単一のモデルでは手の届かない複雑なタスクに取り組むことができる。企業にとって、このアプローチはより強力なAIシステムを構築する方法を提供する。企業は1つのプロ

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が

バイトダンスがSeed-Thinking-v1.5 AIモデルを公開し、推論能力を向上

高度な推論AIの競争は、2024年9月にOpenAIのo1モデルで始まり、2025年1月のDeepSeekのR1ローンチで勢いを増しました。主要なAI開発企業は現在、より高速でコスト効率の高い推論AIモデルを開発するために競争しており、チェーン・オブ・ソートプロセスを通じて正確でよく考え抜かれた応答を提供し、回答前に正確性を確保しています。TikTokの親会社であるバイトダンスは、技術論文で概要が