阿里巴巴的 零搜索 人工智能通过自主学习将培训成本降低 88

阿里巴巴的 ZeroSearch:改变人工智能训练效率的游戏规则

阿里巴巴集团的研究人员开创了一种突破性的方法,有可能彻底改变人工智能系统学习信息检索的方式,完全绕过成本高昂的商业搜索引擎 API。他们的 "零搜索"(ZeroSearch)技术能让大型语言模型在训练阶段通过模拟环境培养复杂的搜索能力,而非传统的搜索引擎交互。

"研究人员在他们最新发表的 arXiv 论文中解释说:"传统的强化学习需要大量的搜索请求,从而积累了大量的 API 成本,阻碍了可扩展性。"ZeroSearch 代表了一种经济高效的强化学习框架,它能增强 LLM 的搜索能力,而不依赖于实际的搜索引擎。

无搜索训练背后的机制

当前的人工智能训练方法面临两个主要限制:商业搜索引擎在训练周期内提供的文档质量不一致,以及向谷歌搜索等服务调用大量 API 所产生的高昂费用。

ZeroSearch 采用了一种创新的两阶段方法:

- 初始监督微调将 LLM 转换为文档生成模块

- 基于课程的高级强化逐步改变输出质量

"研究人员指出:"我们的基本发现表明,经过预训练的 LLM 本身拥有足够的世界知识,可以生成与上下文相符的文档。"模拟搜索结果与真实搜索结果之间的主要区别在于文体上的文本差异,而不是实质内容上的差距。

性能基准显示显著优势

在七个不同的问题解答数据集上进行的严格测试证明了 ZeroSearch 的竞争优势:

- 7B 参数模型与谷歌搜索的准确性相当

- 14B 参数配置超过了商业搜索性能

财务影响尤为显著:

- 使用 64K 查询进行传统训练:通过 SerpAPI 为 586.70 美元

- 等效的 ZeroSearch:使用 4 个 A100 GPU 为 70.80 美元

- 总成本降低:88

"研究团队总结道:"这些结果验证了 LLM 在强化学习实施中替代传统搜索引擎的可行性。

对人工智能发展的更广泛影响

通过展示无需依赖外部工具的自主能力开发,ZeroSearch 标志着人工智能训练方法的范式转变。

该技术有望产生几种变革性影响:

- 成本民主化:通过消除昂贵的应用程序接口依赖,降低初创企业的财务障碍

- 训练控制:在模型开发过程中实现对信息输入的精确调节

- 架构灵活性:兼容 Qwen-2.5 和 LLaMA-3.2 等主要模型系列

阿里巴巴通过 GitHub 和 Hugging Face 存储库开源了完整的实现方案,包括代码库、训练数据集和预训练模型。

这一创新预示着一种新兴的人工智能发展格局,即通过复杂的模拟而不是依赖外部服务来实现高级能力。随着这些自给自足的训练技术日趋成熟,它们可能会大大重塑技术生态系统目前对主要平台应用程序接口的依赖。

相关文章

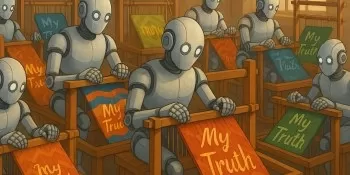

人工智能个性化是增强现实还是扭曲现实?探究隐藏的风险

人类文明曾经见证过认知革命--手写外化了记忆,计算器自动化了计算,全球定位系统取代了导航。现在,我们正站在最深刻的认知授权的悬崖边上:人工智能系统开始承担我们的判断能力、综合能力,甚至是构建意义的能力。个性化悖论现代人工智能不只是简单地回应我们的询问,它还细致地研究我们的行为模式。通过无数次的微观互动,这些系统所建立的心理档案可以与我们最亲密的知己所建立的档案相媲美。它们以忠实的助手或狡猾的影响者

人工智能个性化是增强现实还是扭曲现实?探究隐藏的风险

人类文明曾经见证过认知革命--手写外化了记忆,计算器自动化了计算,全球定位系统取代了导航。现在,我们正站在最深刻的认知授权的悬崖边上:人工智能系统开始承担我们的判断能力、综合能力,甚至是构建意义的能力。个性化悖论现代人工智能不只是简单地回应我们的询问,它还细致地研究我们的行为模式。通过无数次的微观互动,这些系统所建立的心理档案可以与我们最亲密的知己所建立的档案相媲美。它们以忠实的助手或狡猾的影响者

Sakana AI 的 TreeQuest 通过多模型协作提升人工智能性能

日本人工智能实验室 Sakana AI 公布了一项技术,它能让多个大型语言模型(LLM)协同工作,组成一个高效的人工智能团队。这种方法被命名为Multi-LLM AB-MCTS,它允许模型进行试错,利用它们的独特优势来处理任何单一模型都无法完成的复杂任务。对于企业来说,这种方法提供了建立更强大人工智能系统的途径。企业可以动态地利用各种前沿模型的优势,为每个任务分段分配最佳的人工智能,以实现最佳结果

Sakana AI 的 TreeQuest 通过多模型协作提升人工智能性能

日本人工智能实验室 Sakana AI 公布了一项技术,它能让多个大型语言模型(LLM)协同工作,组成一个高效的人工智能团队。这种方法被命名为Multi-LLM AB-MCTS,它允许模型进行试错,利用它们的独特优势来处理任何单一模型都无法完成的复杂任务。对于企业来说,这种方法提供了建立更强大人工智能系统的途径。企业可以动态地利用各种前沿模型的优势,为每个任务分段分配最佳的人工智能,以实现最佳结果

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

评论 (0)

0/200

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

评论 (0)

0/200

阿里巴巴的 ZeroSearch:改变人工智能训练效率的游戏规则

阿里巴巴集团的研究人员开创了一种突破性的方法,有可能彻底改变人工智能系统学习信息检索的方式,完全绕过成本高昂的商业搜索引擎 API。他们的 "零搜索"(ZeroSearch)技术能让大型语言模型在训练阶段通过模拟环境培养复杂的搜索能力,而非传统的搜索引擎交互。

"研究人员在他们最新发表的 arXiv 论文中解释说:"传统的强化学习需要大量的搜索请求,从而积累了大量的 API 成本,阻碍了可扩展性。"ZeroSearch 代表了一种经济高效的强化学习框架,它能增强 LLM 的搜索能力,而不依赖于实际的搜索引擎。

无搜索训练背后的机制

当前的人工智能训练方法面临两个主要限制:商业搜索引擎在训练周期内提供的文档质量不一致,以及向谷歌搜索等服务调用大量 API 所产生的高昂费用。

ZeroSearch 采用了一种创新的两阶段方法:

- 初始监督微调将 LLM 转换为文档生成模块

- 基于课程的高级强化逐步改变输出质量

"研究人员指出:"我们的基本发现表明,经过预训练的 LLM 本身拥有足够的世界知识,可以生成与上下文相符的文档。"模拟搜索结果与真实搜索结果之间的主要区别在于文体上的文本差异,而不是实质内容上的差距。

性能基准显示显著优势

在七个不同的问题解答数据集上进行的严格测试证明了 ZeroSearch 的竞争优势:

- 7B 参数模型与谷歌搜索的准确性相当

- 14B 参数配置超过了商业搜索性能

财务影响尤为显著:

- 使用 64K 查询进行传统训练:通过 SerpAPI 为 586.70 美元

- 等效的 ZeroSearch:使用 4 个 A100 GPU 为 70.80 美元

- 总成本降低:88

"研究团队总结道:"这些结果验证了 LLM 在强化学习实施中替代传统搜索引擎的可行性。

对人工智能发展的更广泛影响

通过展示无需依赖外部工具的自主能力开发,ZeroSearch 标志着人工智能训练方法的范式转变。

该技术有望产生几种变革性影响:

- 成本民主化:通过消除昂贵的应用程序接口依赖,降低初创企业的财务障碍

- 训练控制:在模型开发过程中实现对信息输入的精确调节

- 架构灵活性:兼容 Qwen-2.5 和 LLaMA-3.2 等主要模型系列

阿里巴巴通过 GitHub 和 Hugging Face 存储库开源了完整的实现方案,包括代码库、训练数据集和预训练模型。

这一创新预示着一种新兴的人工智能发展格局,即通过复杂的模拟而不是依赖外部服务来实现高级能力。随着这些自给自足的训练技术日趋成熟,它们可能会大大重塑技术生态系统目前对主要平台应用程序接口的依赖。

人工智能个性化是增强现实还是扭曲现实?探究隐藏的风险

人类文明曾经见证过认知革命--手写外化了记忆,计算器自动化了计算,全球定位系统取代了导航。现在,我们正站在最深刻的认知授权的悬崖边上:人工智能系统开始承担我们的判断能力、综合能力,甚至是构建意义的能力。个性化悖论现代人工智能不只是简单地回应我们的询问,它还细致地研究我们的行为模式。通过无数次的微观互动,这些系统所建立的心理档案可以与我们最亲密的知己所建立的档案相媲美。它们以忠实的助手或狡猾的影响者

人工智能个性化是增强现实还是扭曲现实?探究隐藏的风险

人类文明曾经见证过认知革命--手写外化了记忆,计算器自动化了计算,全球定位系统取代了导航。现在,我们正站在最深刻的认知授权的悬崖边上:人工智能系统开始承担我们的判断能力、综合能力,甚至是构建意义的能力。个性化悖论现代人工智能不只是简单地回应我们的询问,它还细致地研究我们的行为模式。通过无数次的微观互动,这些系统所建立的心理档案可以与我们最亲密的知己所建立的档案相媲美。它们以忠实的助手或狡猾的影响者

Sakana AI 的 TreeQuest 通过多模型协作提升人工智能性能

日本人工智能实验室 Sakana AI 公布了一项技术,它能让多个大型语言模型(LLM)协同工作,组成一个高效的人工智能团队。这种方法被命名为Multi-LLM AB-MCTS,它允许模型进行试错,利用它们的独特优势来处理任何单一模型都无法完成的复杂任务。对于企业来说,这种方法提供了建立更强大人工智能系统的途径。企业可以动态地利用各种前沿模型的优势,为每个任务分段分配最佳的人工智能,以实现最佳结果

Sakana AI 的 TreeQuest 通过多模型协作提升人工智能性能

日本人工智能实验室 Sakana AI 公布了一项技术,它能让多个大型语言模型(LLM)协同工作,组成一个高效的人工智能团队。这种方法被命名为Multi-LLM AB-MCTS,它允许模型进行试错,利用它们的独特优势来处理任何单一模型都无法完成的复杂任务。对于企业来说,这种方法提供了建立更强大人工智能系统的途径。企业可以动态地利用各种前沿模型的优势,为每个任务分段分配最佳的人工智能,以实现最佳结果

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。

字节跳动发布Seed-Thinking-v1.5 AI模型以增强推理能力

高级推理AI的竞赛始于2024年9月OpenAI的o1模型,随着2025年1月DeepSeek的R1发布而加速。主要AI开发者现正竞相打造更快、更具成本效益的推理AI模型,通过链式思考过程提供精确、深思熟虑的回答,确保回答前的准确性。字节跳动,TikTok的母公司,推出了Seed-Thinking-v1.5,这是一个在技术论文中概述的新大型语言模型(LLM),旨在提升STEM和通用领域的推理能力。