El papel generado por IA pasa la revisión por pares, afirma Sakana, pero los detalles son matizados

La startup japonesa de IA Sakana recientemente causó revuelo al afirmar que su sistema de IA, The AI Scientist-v2, generó una de las primeras publicaciones científicas revisadas por pares. Sin embargo, hay algunos detalles importantes a considerar antes de que nos emocionemos demasiado.

El debate sobre el papel de la IA en la ciencia está ganando intensidad. Algunos investigadores creen que la IA no está lista para ser una "co-científica", mientras que otros ven potencial, pero reconocen que aún estamos en las primeras etapas. Sakana pertenece a este último grupo.

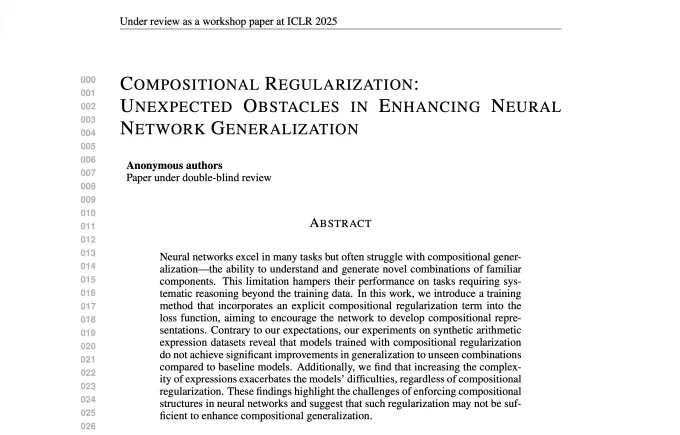

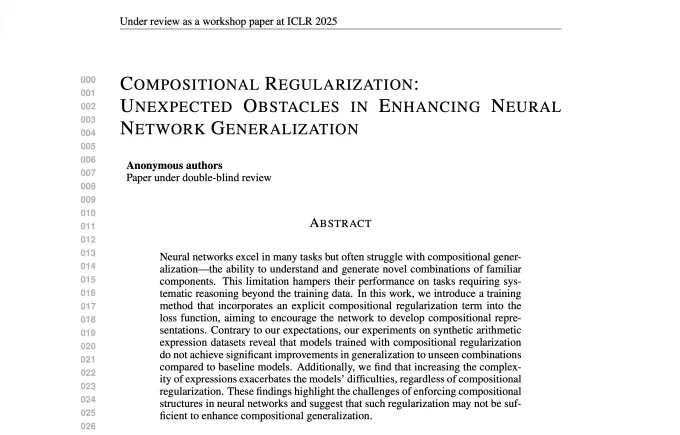

La empresa utilizó The AI Scientist-v2 para crear un artículo que fue presentado en un taller en ICLR, una conferencia de IA muy respetada. Sakana colaboró con la Universidad de Columbia Británica y la Universidad de Oxford para presentar tres artículos generados por IA en este taller. La IA manejó todo, desde hipótesis hasta experimentos, código, análisis de datos, visualizaciones e incluso los títulos.

"Generamos ideas de investigación proporcionando el resumen y la descripción del taller a la IA", dijo Robert Lange, científico de investigación y miembro fundador de Sakana, a TechCrunch por correo electrónico. "Esto aseguró que los artículos generados fueran relevantes y adecuados para la presentación."

Uno de los tres artículos fue aceptado por el taller de ICLR. Se centró en criticar técnicas de entrenamiento para modelos de IA. Sin embargo, Sakana retiró el artículo antes de que pudiera publicarse, citando transparencia y respeto por las convenciones de ICLR.

Un fragmento del artículo generado por IA de SakanaCréditos de la imagen: Sakana "El artículo aceptado introduce un nuevo método prometedor para entrenar redes neuronales y muestra que aún hay desafíos empíricos pendientes", dijo Lange. "Proporciona un punto de datos interesante para estimular más investigaciones científicas."Pero no nos dejemos llevar todavía. Sakana admitió en su publicación de blog que su IA cometió algunos errores de citación "vergonzosos", como atribuir un método a un artículo de 2016 en lugar del trabajo original de 1997.

Además, el artículo no pasó por tanto escrutinio como otras publicaciones revisadas por pares. Fue retirado tras la revisión inicial por pares, por lo que no recibió una "meta-revisión" de los organizadores del taller, quienes podrían haberlo rechazado.

Otra cosa a tener en cuenta es que los talleres de conferencias a menudo tienen tasas de aceptación más altas que la pista principal de la conferencia. Sakana mencionó esto en su publicación de blog y señaló que ninguno de sus estudios generados por IA cumplió con sus estándares internos para la pista de la conferencia de ICLR.

Matthew Guzdial, investigador de IA y profesor asistente en la Universidad de Alberta, calificó los resultados de Sakana como "un poco engañosos".

"La gente de Sakana seleccionó los artículos de un número de generados, lo que significa que estaban usando el juicio humano para elegir resultados que pensaban que podrían ser aceptados", dijo por correo electrónico. "Lo que creo que esto muestra es que los humanos más la IA pueden ser efectivos, no que la IA sola pueda crear progreso científico."

Mike Cook, investigador en King's College London especializado en IA, cuestionó el rigor de los revisores por pares y del taller.

"Los talleres nuevos, como este, a menudo son revisados por investigadores más jóvenes", dijo a TechCrunch. "También vale la pena señalar que este taller trata sobre resultados negativos y dificultades, lo cual es genial, yo he organizado un taller similar antes, pero es posiblemente más fácil hacer que una IA escriba de manera convincente sobre un fracaso."

Cook no se sorprendió de que una IA pudiera pasar la revisión por pares, dado que la IA es buena para escribir prosa que suena humana. Señaló que los artículos parcialmente generados por IA que pasan la revisión de revistas no son nuevos, y esto plantea preguntas éticas para la comunidad científica.

Los problemas técnicos de la IA, como su tendencia a "alucinar", hacen que muchos científicos sean cautelosos sobre usarla para trabajos serios. También hay un temor de que la IA simplemente pueda añadir ruido a la literatura científica, en lugar de avanzar en el conocimiento.

"Necesitamos preguntarnos si el resultado de [Sakana] se trata de cuán buena es la IA para diseñar y realizar experimentos, o si se trata de cuán buena es para vender ideas a los humanos, algo en lo que ya sabemos que la IA es excelente", dijo Cook. "Hay una diferencia entre pasar la revisión por pares y contribuir al conocimiento en un campo."

En honor a Sakana, ellos no afirman que su IA pueda producir trabajos científicos innovadores o particularmente novedosos. Su objetivo fue "estudiar la calidad de la investigación generada por IA" y destacar la necesidad de "normas respecto a la ciencia generada por IA".

"Hay preguntas difíciles sobre si la ciencia [generada por IA] debería juzgarse primero por sus propios méritos para evitar prejuicios en su contra", escribió la empresa. "De cara al futuro, seguiremos intercambiando opiniones con la comunidad de investigación sobre el estado de esta tecnología para asegurar que no se desarrolle en una situación en el futuro donde su único propósito sea pasar la revisión por pares, socavando sustancialmente el significado del proceso de revisión por pares científico."

Artículo relacionado

Midjourney presenta un innovador generador de vídeo inteligente para contenidos creativos

Avance de Midjourney en la generación de vídeo con IAMidjourney ha presentado su primera herramienta de generación de vídeo con inteligencia artificial, lo que supone una importante ampliación de sus

Midjourney presenta un innovador generador de vídeo inteligente para contenidos creativos

Avance de Midjourney en la generación de vídeo con IAMidjourney ha presentado su primera herramienta de generación de vídeo con inteligencia artificial, lo que supone una importante ampliación de sus

Trump prioriza el crecimiento de la IA sobre la regulación en su carrera por superar a China

La administración Trump desveló el miércoles su histórico Plan de Acción sobre Inteligencia Artificial, que marca una ruptura decisiva con las políticas sobre IA de la administración Biden, reacias a

Trump prioriza el crecimiento de la IA sobre la regulación en su carrera por superar a China

La administración Trump desveló el miércoles su histórico Plan de Acción sobre Inteligencia Artificial, que marca una ruptura decisiva con las políticas sobre IA de la administración Biden, reacias a

YouTube integra la herramienta de vídeo Veo 3 AI directamente en la plataforma Shorts

YouTube Shorts incluirá el modelo de vídeo Veo 3 AI este veranoNeal Mohan, Consejero Delegado de YouTube, reveló durante su discurso en Cannes Lions que la tecnología de generación de vídeo Veo 3 AI d

comentario (38)

0/200

YouTube integra la herramienta de vídeo Veo 3 AI directamente en la plataforma Shorts

YouTube Shorts incluirá el modelo de vídeo Veo 3 AI este veranoNeal Mohan, Consejero Delegado de YouTube, reveló durante su discurso en Cannes Lions que la tecnología de generación de vídeo Veo 3 AI d

comentario (38)

0/200

![EdwardRamirez]() EdwardRamirez

EdwardRamirez

26 de agosto de 2025 23:01:20 GMT+02:00

26 de agosto de 2025 23:01:20 GMT+02:00

Mind-blowing that an AI-generated paper passed peer review! 🤯 But I’m curious, how much human tweaking was involved? Sakana’s claim is bold, but the nuances make me wonder if it’s more hype than revolution. Still, AI in science is wild!

0

0

![RogerGonzalez]() RogerGonzalez

RogerGonzalez

15 de agosto de 2025 04:01:03 GMT+02:00

15 de agosto de 2025 04:01:03 GMT+02:00

Mind-blowing that AI can churn out a peer-reviewed paper! But I’m curious—how much human tweaking was needed to get it there? 🤔

0

0

![StevenGonzalez]() StevenGonzalez

StevenGonzalez

23 de julio de 2025 06:59:29 GMT+02:00

23 de julio de 2025 06:59:29 GMT+02:00

This is wild! An AI writing a peer-reviewed paper? Sakana’s claim is bold, but I’m curious how much human tweaking was involved. Still, it’s kinda thrilling to see AI push boundaries in science! 🚀

0

0

![AlbertThomas]() AlbertThomas

AlbertThomas

22 de abril de 2025 15:28:17 GMT+02:00

22 de abril de 2025 15:28:17 GMT+02:00

O AI-Generated Paper Passes Peer Review parece incrível, mas os detalhes são um pouco decepcionantes. É como esperar um banquete e receber um lanche. Ainda assim, é um avanço para a IA na ciência, não é? Talvez da próxima vez eles nos surpreendam de verdade! 🚀

0

0

![NicholasDavis]() NicholasDavis

NicholasDavis

22 de abril de 2025 04:29:30 GMT+02:00

22 de abril de 2025 04:29:30 GMT+02:00

AI生成的論文通過同行評審?這很酷,但細節有點模糊。Sakana的AI Scientist-v2聽起來很有前景,但我們需要更多透明度。儘管如此,這是AI在科學領域的一個進步!📖

0

0

![BillyGreen]() BillyGreen

BillyGreen

22 de abril de 2025 02:06:42 GMT+02:00

22 de abril de 2025 02:06:42 GMT+02:00

AI-generated paper passing peer review? That's cool, but the details are a bit sketchy. Sakana's AI Scientist-v2 sounds promising, but we need more transparency. Still, it's a step forward for AI in science! 🤓

0

0

La startup japonesa de IA Sakana recientemente causó revuelo al afirmar que su sistema de IA, The AI Scientist-v2, generó una de las primeras publicaciones científicas revisadas por pares. Sin embargo, hay algunos detalles importantes a considerar antes de que nos emocionemos demasiado.

El debate sobre el papel de la IA en la ciencia está ganando intensidad. Algunos investigadores creen que la IA no está lista para ser una "co-científica", mientras que otros ven potencial, pero reconocen que aún estamos en las primeras etapas. Sakana pertenece a este último grupo.

La empresa utilizó The AI Scientist-v2 para crear un artículo que fue presentado en un taller en ICLR, una conferencia de IA muy respetada. Sakana colaboró con la Universidad de Columbia Británica y la Universidad de Oxford para presentar tres artículos generados por IA en este taller. La IA manejó todo, desde hipótesis hasta experimentos, código, análisis de datos, visualizaciones e incluso los títulos.

"Generamos ideas de investigación proporcionando el resumen y la descripción del taller a la IA", dijo Robert Lange, científico de investigación y miembro fundador de Sakana, a TechCrunch por correo electrónico. "Esto aseguró que los artículos generados fueran relevantes y adecuados para la presentación."

Uno de los tres artículos fue aceptado por el taller de ICLR. Se centró en criticar técnicas de entrenamiento para modelos de IA. Sin embargo, Sakana retiró el artículo antes de que pudiera publicarse, citando transparencia y respeto por las convenciones de ICLR.

Pero no nos dejemos llevar todavía. Sakana admitió en su publicación de blog que su IA cometió algunos errores de citación "vergonzosos", como atribuir un método a un artículo de 2016 en lugar del trabajo original de 1997.

Además, el artículo no pasó por tanto escrutinio como otras publicaciones revisadas por pares. Fue retirado tras la revisión inicial por pares, por lo que no recibió una "meta-revisión" de los organizadores del taller, quienes podrían haberlo rechazado.

Otra cosa a tener en cuenta es que los talleres de conferencias a menudo tienen tasas de aceptación más altas que la pista principal de la conferencia. Sakana mencionó esto en su publicación de blog y señaló que ninguno de sus estudios generados por IA cumplió con sus estándares internos para la pista de la conferencia de ICLR.

Matthew Guzdial, investigador de IA y profesor asistente en la Universidad de Alberta, calificó los resultados de Sakana como "un poco engañosos".

"La gente de Sakana seleccionó los artículos de un número de generados, lo que significa que estaban usando el juicio humano para elegir resultados que pensaban que podrían ser aceptados", dijo por correo electrónico. "Lo que creo que esto muestra es que los humanos más la IA pueden ser efectivos, no que la IA sola pueda crear progreso científico."

Mike Cook, investigador en King's College London especializado en IA, cuestionó el rigor de los revisores por pares y del taller.

"Los talleres nuevos, como este, a menudo son revisados por investigadores más jóvenes", dijo a TechCrunch. "También vale la pena señalar que este taller trata sobre resultados negativos y dificultades, lo cual es genial, yo he organizado un taller similar antes, pero es posiblemente más fácil hacer que una IA escriba de manera convincente sobre un fracaso."

Cook no se sorprendió de que una IA pudiera pasar la revisión por pares, dado que la IA es buena para escribir prosa que suena humana. Señaló que los artículos parcialmente generados por IA que pasan la revisión de revistas no son nuevos, y esto plantea preguntas éticas para la comunidad científica.

Los problemas técnicos de la IA, como su tendencia a "alucinar", hacen que muchos científicos sean cautelosos sobre usarla para trabajos serios. También hay un temor de que la IA simplemente pueda añadir ruido a la literatura científica, en lugar de avanzar en el conocimiento.

"Necesitamos preguntarnos si el resultado de [Sakana] se trata de cuán buena es la IA para diseñar y realizar experimentos, o si se trata de cuán buena es para vender ideas a los humanos, algo en lo que ya sabemos que la IA es excelente", dijo Cook. "Hay una diferencia entre pasar la revisión por pares y contribuir al conocimiento en un campo."

En honor a Sakana, ellos no afirman que su IA pueda producir trabajos científicos innovadores o particularmente novedosos. Su objetivo fue "estudiar la calidad de la investigación generada por IA" y destacar la necesidad de "normas respecto a la ciencia generada por IA".

"Hay preguntas difíciles sobre si la ciencia [generada por IA] debería juzgarse primero por sus propios méritos para evitar prejuicios en su contra", escribió la empresa. "De cara al futuro, seguiremos intercambiando opiniones con la comunidad de investigación sobre el estado de esta tecnología para asegurar que no se desarrolle en una situación en el futuro donde su único propósito sea pasar la revisión por pares, socavando sustancialmente el significado del proceso de revisión por pares científico."

Midjourney presenta un innovador generador de vídeo inteligente para contenidos creativos

Avance de Midjourney en la generación de vídeo con IAMidjourney ha presentado su primera herramienta de generación de vídeo con inteligencia artificial, lo que supone una importante ampliación de sus

Midjourney presenta un innovador generador de vídeo inteligente para contenidos creativos

Avance de Midjourney en la generación de vídeo con IAMidjourney ha presentado su primera herramienta de generación de vídeo con inteligencia artificial, lo que supone una importante ampliación de sus

Trump prioriza el crecimiento de la IA sobre la regulación en su carrera por superar a China

La administración Trump desveló el miércoles su histórico Plan de Acción sobre Inteligencia Artificial, que marca una ruptura decisiva con las políticas sobre IA de la administración Biden, reacias a

Trump prioriza el crecimiento de la IA sobre la regulación en su carrera por superar a China

La administración Trump desveló el miércoles su histórico Plan de Acción sobre Inteligencia Artificial, que marca una ruptura decisiva con las políticas sobre IA de la administración Biden, reacias a

YouTube integra la herramienta de vídeo Veo 3 AI directamente en la plataforma Shorts

YouTube Shorts incluirá el modelo de vídeo Veo 3 AI este veranoNeal Mohan, Consejero Delegado de YouTube, reveló durante su discurso en Cannes Lions que la tecnología de generación de vídeo Veo 3 AI d

YouTube integra la herramienta de vídeo Veo 3 AI directamente en la plataforma Shorts

YouTube Shorts incluirá el modelo de vídeo Veo 3 AI este veranoNeal Mohan, Consejero Delegado de YouTube, reveló durante su discurso en Cannes Lions que la tecnología de generación de vídeo Veo 3 AI d

26 de agosto de 2025 23:01:20 GMT+02:00

26 de agosto de 2025 23:01:20 GMT+02:00

Mind-blowing that an AI-generated paper passed peer review! 🤯 But I’m curious, how much human tweaking was involved? Sakana’s claim is bold, but the nuances make me wonder if it’s more hype than revolution. Still, AI in science is wild!

0

0

15 de agosto de 2025 04:01:03 GMT+02:00

15 de agosto de 2025 04:01:03 GMT+02:00

Mind-blowing that AI can churn out a peer-reviewed paper! But I’m curious—how much human tweaking was needed to get it there? 🤔

0

0

23 de julio de 2025 06:59:29 GMT+02:00

23 de julio de 2025 06:59:29 GMT+02:00

This is wild! An AI writing a peer-reviewed paper? Sakana’s claim is bold, but I’m curious how much human tweaking was involved. Still, it’s kinda thrilling to see AI push boundaries in science! 🚀

0

0

22 de abril de 2025 15:28:17 GMT+02:00

22 de abril de 2025 15:28:17 GMT+02:00

O AI-Generated Paper Passes Peer Review parece incrível, mas os detalhes são um pouco decepcionantes. É como esperar um banquete e receber um lanche. Ainda assim, é um avanço para a IA na ciência, não é? Talvez da próxima vez eles nos surpreendam de verdade! 🚀

0

0

22 de abril de 2025 04:29:30 GMT+02:00

22 de abril de 2025 04:29:30 GMT+02:00

AI生成的論文通過同行評審?這很酷,但細節有點模糊。Sakana的AI Scientist-v2聽起來很有前景,但我們需要更多透明度。儘管如此,這是AI在科學領域的一個進步!📖

0

0

22 de abril de 2025 02:06:42 GMT+02:00

22 de abril de 2025 02:06:42 GMT+02:00

AI-generated paper passing peer review? That's cool, but the details are a bit sketchy. Sakana's AI Scientist-v2 sounds promising, but we need more transparency. Still, it's a step forward for AI in science! 🤓

0

0