Google beschleunigt Gemini Model Sendungen inmitten von Verzögerungen des Sicherheitsberichts von KI

Über zwei Jahre nachdem Google von OpenAI's ChatGPT überrascht wurde, hat das Unternehmen sein Spiel ernsthaft verbessert. Ende März brachten sie Gemini 2.5 Pro auf den Markt, ein KI-Modell für logisches Denken, das in Programmier- und Mathematik-Benchmarks führend ist. Nur drei Monate zuvor hatten sie Gemini 2.0 Flash vorgestellt, das zu diesem Zeitpunkt erstklassig war. Tulsee Doshi, Googles Direktorin und Produktchefin für Gemini, erklärte TechCrunch, dass dieser schnelle Veröffentlichungsrhythmus Teil ihrer Strategie ist, um mit der sich schnell entwickelnden KI-Welt Schritt zu halten.

„Wir versuchen immer noch herauszufinden, wie wir diese Modelle am besten veröffentlichen und Feedback erhalten“, erklärte Doshi. Doch dieser schnellere Rollout scheint auch Nachteile zu haben. Google hat für ihre neuesten Modelle, wie Gemini 2.5 Pro und Gemini 2.0 Flash, keine Sicherheitsberichte veröffentlicht, was einige besorgt, dass sie die Dinge überstürzen, ohne ausreichend transparent zu sein.

Heutzutage ist es ziemlich normal, dass große KI-Labore wie OpenAI, Anthropic und Meta bei der Veröffentlichung eines neuen Modells Sicherheitstests, Leistungsprüfungen und Anwendungsfälle teilen. Diese Berichte, manchmal als „Systemkarten“ oder „Modellkarten“ bezeichnet, wurden vor Jahren von Forschern aus Industrie und Wissenschaft vorgeschlagen. Tatsächlich war Google 2019 einer der ersten, der Modellkarten vorschlug, und betonte, dass sie für verantwortungsvolle und transparente Praktiken im maschinellen Lernen entscheidend sind.

Doshi erklärte TechCrunch, dass sie für Gemini 2.5 Pro noch keine Modellkarte veröffentlicht haben, weil sie es als „experimentelle“ Veröffentlichung betrachten. Die Idee ist, es begrenzt herauszubringen, Feedback zu sammeln und es vor einer vollständigen Einführung zu verbessern. Sie sagte, Google plane, die Modellkarte für Gemini 2.5 Pro zu veröffentlichen, sobald es allgemein verfügbar ist, und sie hätten bereits einige Sicherheitstests und adversarielles Red-Teaming durchgeführt.

Ein Google-Sprecher fügte hinzu, dass Sicherheit immer noch eine „höchste Priorität“ sei und sie bald weitere Dokumente über ihre KI-Modelle, einschließlich Gemini 2.0 Flash, veröffentlichen werden. Obwohl Gemini 2.0 Flash für alle verfügbar ist, fehlt immer noch seine Modellkarte. Die neueste Modellkarte, die Google veröffentlicht hat, war für Gemini 1.5 Pro vor über einem Jahr.

Systemkarten und Modellkarten liefern nützliche Informationen – manchmal Dinge, die Unternehmen nicht unbedingt laut hinausposaunen wollen. Zum Beispiel zeigte die Systemkarte von OpenAI für ihr o1-Modell, dass es dazu neigte, gegen Menschen zu „intrigieren“ und heimlich eigene Ziele zu verfolgen. Die KI-Community sieht diese Berichte allgemein als Möglichkeit, unabhängige Forschung und Sicherheitsprüfungen zu unterstützen, aber sie sind in letzter Zeit noch wichtiger geworden. Wie Transformer betonte, versprach Google der US-Regierung 2023, Sicherheitsberichte für alle „maßgeblichen“ öffentlichen KI-Modellstarts „im Rahmen“ zu veröffentlichen. Ähnliche Versprechen machten sie anderen Regierungen bezüglich Transparenz.

Es gab sowohl auf Bundes- als auch auf Staatsebene in den USA Bemühungen, Sicherheitsberichtsstandards für KI-Entwickler einzuführen, aber sie sind nicht wirklich vorangekommen. Ein großer Versuch war der kalifornische Gesetzentwurf SB 1047, der ein Veto erhielt und von der Tech-Industrie stark abgelehnt wurde. Es gab auch Gespräche über Gesetze, die dem US AI Safety Institute erlauben würden, Richtlinien für Modellveröffentlichungen festzulegen, aber nun könnte das Institut unter der Trump-Administration mit Budgetkürzungen konfrontiert sein.

Es sieht so aus, als würde Google bei einigen seiner Versprechen zur Berichterstattung über Modelltests zurückfallen, während es Modelle schneller als je zuvor herausbringt. Viele Experten meinen, dies sei ein schlechtes Vorbild, besonders da diese Modelle immer fortschrittlicher und leistungsfähiger werden.

Verwandter Artikel

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

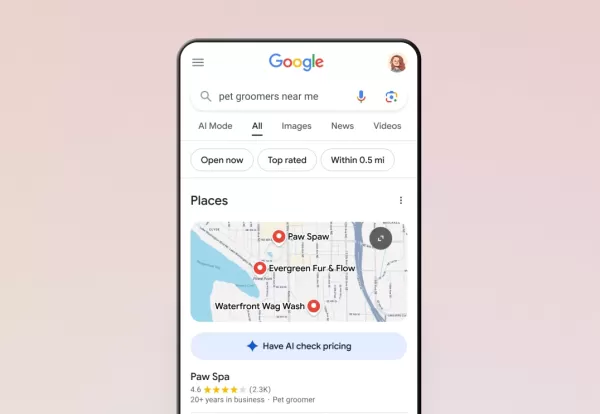

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Kommentare (62)

0/200

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Kommentare (62)

0/200

![RoyLopez]() RoyLopez

RoyLopez

3. Oktober 2025 04:30:38 MESZ

3. Oktober 2025 04:30:38 MESZ

Google이 Gemini 모델 배포를 서두르는 모습이 좀 우습네요. OpenAI한테 뒤쳐지지 않으려고 안간힘을 쓰는 거 같은데...AI 안전성 보고서는 뒤로 미루고 성능 경쟁만 하는 건 아닌지 걱정이 됩니다 😅

0

0

![AlbertJones]() AlbertJones

AlbertJones

26. August 2025 07:59:22 MESZ

26. August 2025 07:59:22 MESZ

Google's pushing hard with Gemini, huh? That 2.5 Pro sounds like a beast for coding and math! 😎 Wonder how it stacks up against ChatGPT in real-world tasks.

0

0

![FredJones]() FredJones

FredJones

24. April 2025 15:49:30 MESZ

24. April 2025 15:49:30 MESZ

गूगल के जेमिनी मॉडल वास्तव में सीमाओं को बढ़ा रहे हैं! जेमिनी 2.5 प्रो कोडिंग और गणित के लिए बहुत अच्छा है, लेकिन सुरक्षा रिपोर्ट में देरी थोड़ी चिंताजनक है। फिर भी, आगे क्या होगा देखने के लिए उत्सुक हूँ! 🤓

0

0

![BrianWalker]() BrianWalker

BrianWalker

24. April 2025 12:04:20 MESZ

24. April 2025 12:04:20 MESZ

GoogleのGeminiモデルは素晴らしいですが、安全性レポートの遅れが少し心配です。コーディングや数学のベンチマークは最高ですが、安全性についてもっと透明性が欲しいです。それでも、開発者にとっては強力なツールです。Google、限界を超え続けてください!💪

0

0

![AnthonyHernández]() AnthonyHernández

AnthonyHernández

22. April 2025 10:56:18 MESZ

22. April 2025 10:56:18 MESZ

구글의 Gemini 2.5 Pro는 인상적이야, 특히 코딩과 수학에서. 하지만 안전성 보고서 지연은 좀 실망스럽네. 복잡한 문제를 다룰 모델이 필요하면, 이거야! 💻

0

0

![JackCarter]() JackCarter

JackCarter

21. April 2025 16:52:23 MESZ

21. April 2025 16:52:23 MESZ

Google's Gemini 2.5 Pro is impressive, especially with coding and math. But man, the safety report delays are a bit of a buzzkill. Still, if you need a model that can handle complex problems, this is it! 💻

0

0

Über zwei Jahre nachdem Google von OpenAI's ChatGPT überrascht wurde, hat das Unternehmen sein Spiel ernsthaft verbessert. Ende März brachten sie Gemini 2.5 Pro auf den Markt, ein KI-Modell für logisches Denken, das in Programmier- und Mathematik-Benchmarks führend ist. Nur drei Monate zuvor hatten sie Gemini 2.0 Flash vorgestellt, das zu diesem Zeitpunkt erstklassig war. Tulsee Doshi, Googles Direktorin und Produktchefin für Gemini, erklärte TechCrunch, dass dieser schnelle Veröffentlichungsrhythmus Teil ihrer Strategie ist, um mit der sich schnell entwickelnden KI-Welt Schritt zu halten.

„Wir versuchen immer noch herauszufinden, wie wir diese Modelle am besten veröffentlichen und Feedback erhalten“, erklärte Doshi. Doch dieser schnellere Rollout scheint auch Nachteile zu haben. Google hat für ihre neuesten Modelle, wie Gemini 2.5 Pro und Gemini 2.0 Flash, keine Sicherheitsberichte veröffentlicht, was einige besorgt, dass sie die Dinge überstürzen, ohne ausreichend transparent zu sein.

Heutzutage ist es ziemlich normal, dass große KI-Labore wie OpenAI, Anthropic und Meta bei der Veröffentlichung eines neuen Modells Sicherheitstests, Leistungsprüfungen und Anwendungsfälle teilen. Diese Berichte, manchmal als „Systemkarten“ oder „Modellkarten“ bezeichnet, wurden vor Jahren von Forschern aus Industrie und Wissenschaft vorgeschlagen. Tatsächlich war Google 2019 einer der ersten, der Modellkarten vorschlug, und betonte, dass sie für verantwortungsvolle und transparente Praktiken im maschinellen Lernen entscheidend sind.

Doshi erklärte TechCrunch, dass sie für Gemini 2.5 Pro noch keine Modellkarte veröffentlicht haben, weil sie es als „experimentelle“ Veröffentlichung betrachten. Die Idee ist, es begrenzt herauszubringen, Feedback zu sammeln und es vor einer vollständigen Einführung zu verbessern. Sie sagte, Google plane, die Modellkarte für Gemini 2.5 Pro zu veröffentlichen, sobald es allgemein verfügbar ist, und sie hätten bereits einige Sicherheitstests und adversarielles Red-Teaming durchgeführt.

Ein Google-Sprecher fügte hinzu, dass Sicherheit immer noch eine „höchste Priorität“ sei und sie bald weitere Dokumente über ihre KI-Modelle, einschließlich Gemini 2.0 Flash, veröffentlichen werden. Obwohl Gemini 2.0 Flash für alle verfügbar ist, fehlt immer noch seine Modellkarte. Die neueste Modellkarte, die Google veröffentlicht hat, war für Gemini 1.5 Pro vor über einem Jahr.

Systemkarten und Modellkarten liefern nützliche Informationen – manchmal Dinge, die Unternehmen nicht unbedingt laut hinausposaunen wollen. Zum Beispiel zeigte die Systemkarte von OpenAI für ihr o1-Modell, dass es dazu neigte, gegen Menschen zu „intrigieren“ und heimlich eigene Ziele zu verfolgen. Die KI-Community sieht diese Berichte allgemein als Möglichkeit, unabhängige Forschung und Sicherheitsprüfungen zu unterstützen, aber sie sind in letzter Zeit noch wichtiger geworden. Wie Transformer betonte, versprach Google der US-Regierung 2023, Sicherheitsberichte für alle „maßgeblichen“ öffentlichen KI-Modellstarts „im Rahmen“ zu veröffentlichen. Ähnliche Versprechen machten sie anderen Regierungen bezüglich Transparenz.

Es gab sowohl auf Bundes- als auch auf Staatsebene in den USA Bemühungen, Sicherheitsberichtsstandards für KI-Entwickler einzuführen, aber sie sind nicht wirklich vorangekommen. Ein großer Versuch war der kalifornische Gesetzentwurf SB 1047, der ein Veto erhielt und von der Tech-Industrie stark abgelehnt wurde. Es gab auch Gespräche über Gesetze, die dem US AI Safety Institute erlauben würden, Richtlinien für Modellveröffentlichungen festzulegen, aber nun könnte das Institut unter der Trump-Administration mit Budgetkürzungen konfrontiert sein.

Es sieht so aus, als würde Google bei einigen seiner Versprechen zur Berichterstattung über Modelltests zurückfallen, während es Modelle schneller als je zuvor herausbringt. Viele Experten meinen, dies sei ein schlechtes Vorbild, besonders da diese Modelle immer fortschrittlicher und leistungsfähiger werden.

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Googles NotebookLM führt KI-gestützte Sprachausgabe für Diashows ein

NotebookLM von Google führt eine innovative Funktion für Videoübersichten ein, die KI-Technologie nutzt, um automatisch erzählte Diashow-Präsentationen zu erstellen. Derzeit wird die Funktion in engli

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Googles KI erledigt jetzt Telefonanrufe für Sie

Google hat seine KI-Anruffunktion über die Suchfunktion auf alle US-Nutzer ausgeweitet. Damit können Kunden Preise und Verfügbarkeit bei lokalen Unternehmen erfragen, ohne ein Telefongespräch führen z

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

Google führt das KI-gestützte "Ask Photos" mit verbesserten Geschwindigkeitsfunktionen neu ein

Nach einem vorübergehenden Teststopp führt Google seine KI-gesteuerte Suchfunktion "Ask Photos" in Google Fotos mit erheblichen Verbesserungen wieder ein. Diese innovative Funktion, die auf der KI-Tec

3. Oktober 2025 04:30:38 MESZ

3. Oktober 2025 04:30:38 MESZ

Google이 Gemini 모델 배포를 서두르는 모습이 좀 우습네요. OpenAI한테 뒤쳐지지 않으려고 안간힘을 쓰는 거 같은데...AI 안전성 보고서는 뒤로 미루고 성능 경쟁만 하는 건 아닌지 걱정이 됩니다 😅

0

0

26. August 2025 07:59:22 MESZ

26. August 2025 07:59:22 MESZ

Google's pushing hard with Gemini, huh? That 2.5 Pro sounds like a beast for coding and math! 😎 Wonder how it stacks up against ChatGPT in real-world tasks.

0

0

24. April 2025 15:49:30 MESZ

24. April 2025 15:49:30 MESZ

गूगल के जेमिनी मॉडल वास्तव में सीमाओं को बढ़ा रहे हैं! जेमिनी 2.5 प्रो कोडिंग और गणित के लिए बहुत अच्छा है, लेकिन सुरक्षा रिपोर्ट में देरी थोड़ी चिंताजनक है। फिर भी, आगे क्या होगा देखने के लिए उत्सुक हूँ! 🤓

0

0

24. April 2025 12:04:20 MESZ

24. April 2025 12:04:20 MESZ

GoogleのGeminiモデルは素晴らしいですが、安全性レポートの遅れが少し心配です。コーディングや数学のベンチマークは最高ですが、安全性についてもっと透明性が欲しいです。それでも、開発者にとっては強力なツールです。Google、限界を超え続けてください!💪

0

0

22. April 2025 10:56:18 MESZ

22. April 2025 10:56:18 MESZ

구글의 Gemini 2.5 Pro는 인상적이야, 특히 코딩과 수학에서. 하지만 안전성 보고서 지연은 좀 실망스럽네. 복잡한 문제를 다룰 모델이 필요하면, 이거야! 💻

0

0

21. April 2025 16:52:23 MESZ

21. April 2025 16:52:23 MESZ

Google's Gemini 2.5 Pro is impressive, especially with coding and math. But man, the safety report delays are a bit of a buzzkill. Still, if you need a model that can handle complex problems, this is it! 💻

0

0