KI -Machtschub: Anthropischer CEO warnt vor Rasse, um zu verstehen

Gleich nach dem AI-Action-Gipfel in Paris hielt sich Anthropics Mitbegründer und CEO Dario Amodei nicht zurück. Er nannte die Veranstaltung eine "verpasste Gelegenheit" und betonte, dass wir den Fokus und die Dringlichkeit auf mehrere wichtige Themen erhöhen müssen, wenn man bedenkt, wie schnell sich die KI -Tech bewegt. Er teilte diese Gedanken in einer am Dienstag veröffentlichten Erklärung mit.

Anthropic hat sich mit dem französischen Startup Dust für ein Entwickler-Event in Paris zusammengetan, bei dem TechCrunch mit Amodei auf der Bühne chatten durfte. Er teilte seine Perspektive und drängte sich auf einen ausgewogenen Ansatz für KI -Innovation und Governance, wobei er sich sowohl vom extremen Optimismus als auch von hartem Kritik fernhielt.

Amodei, der früher ein Neurowissenschaftler war, sagte: "Ich habe im Grunde genommen in echten Gehirnen gesucht. Und jetzt schauen wir in künstlichen Gehirnen für ihren Lebensunterhalt. Also werden wir in den nächsten Monaten einige aufregende Fortschritte im Bereich der Interpretierbarkeit haben - wo wir wirklich beginnen, zu verstehen, wie die Modelle funktionieren." Aber er wies auch darauf hin, dass es ein Rennen ist. "Es ist ein Rennen zwischen den Models mächtiger, was für uns unglaublich schnell ist und für andere unglaublich schnell - Sie können nicht wirklich langsamer werden, oder? ... Unser Verständnis muss mit unserer Fähigkeit, Dinge aufzubauen, Schritt halten. Ich denke, das ist der einzige Weg", fügte er hinzu.

Seit dem ersten KI -Gipfel in Bletchley, Großbritannien, hat sich das Gespräch um die KI -Governance stark verschoben, beeinflusst vom aktuellen geopolitischen Klima. Der US -Vizepräsident JD Vance, der auf dem AI Action Summit sprach, sagte: "Ich bin heute Morgen nicht hier, um über KI -Sicherheit zu sprechen, was vor ein paar Jahren der Titel der Konferenz war. Ich bin hier, um über die Möglichkeiten der KI zu sprechen."

Amodei versucht jedoch, die Lücke zwischen Sicherheit und Chancen zu schließen. Er glaubt, dass es tatsächlich eine Chance sein kann, mehr auf Sicherheit zu konzentrieren. "Auf dem ursprünglichen Gipfel, dem britischen Bletchley Summit, gab es viele Diskussionen über Tests und Messungen für verschiedene Risiken. Und ich glaube nicht, dass diese Dinge die Technologie überhaupt sehr verlangsamt haben", sagte er bei der anthropischen Veranstaltung. "Wenn überhaupt, hat uns unsere Modelle besser verstehen, was uns letztendlich besser zu verstehen, was es uns hilft, bessere Modelle zu produzieren."

Selbst wenn sie die Sicherheit betonte, machte Amodei deutlich, dass Anthropic immer noch alles darin besteht, Frontier -KI -Modelle zu bauen. "Ich möchte nichts tun, um das Versprechen zu verringern. Wir bieten jeden Tag Modelle an, auf denen die Menschen aufbauen können und die verwendet werden, um erstaunliche Dinge zu tun. Und wir sollten definitiv nicht aufhören, das zu tun", sagte er. Später fügte er hinzu: "Wenn die Leute viel über die Risiken sprechen, ärgere ich mich irgendwie und ich sage: 'Oh, Mann, niemand hat wirklich gute Arbeit gelegt, um herauszufinden, wie großartig diese Technologie sein könnte."

Als sich das Thema an die jüngsten Modelle von Chinese LLM-Hersteller Deepseek wandte, spielte Amodei ihre Erfolge herunter und bezeichnete die öffentliche Reaktion als "anorganisch". Er sagte: "Ehrlich gesagt, meine Reaktion war sehr wenig. Wir hatten V3, das Basismodell für Deepseek R1, im Dezember gesehen. Und das war ein beeindruckendes Modell. Das im Dezember veröffentlichte Modell war auf dieser Art von sehr normalen Kostenreduzierungskurve, die wir in unseren Modellen und anderen Modellen gesehen haben." Was seine Aufmerksamkeit auf sich zog, war, dass das Modell nicht aus den üblichen "drei oder vier Grenzlabors" in den USA wie Google, Openai und Anthropic kam. Er äußerte sich besorgt über autoritäre Regierungen, die die Technologie dominieren. Was Deepseeks beanspruchte Schulungskosten betrifft, entließ er sie als "einfach nicht genau und nicht auf Fakten".

Während Amodei bei der Veranstaltung keine neuen Modelle bekannt gab, deutete er auf bevorstehende Veröffentlichungen mit verbesserten Argumentationsfunktionen hin. "Wir konzentrieren uns im Allgemeinen darauf, unsere eigenen Argumentationsmodelle, die besser differenziert sind, zu versuchen, dass wir sicherstellen, dass wir über genügend Kapazitäten verfügen, dass die Modelle schlauer werden, und wir machen uns Sorgen um Sicherheits Dinge", sagte er.

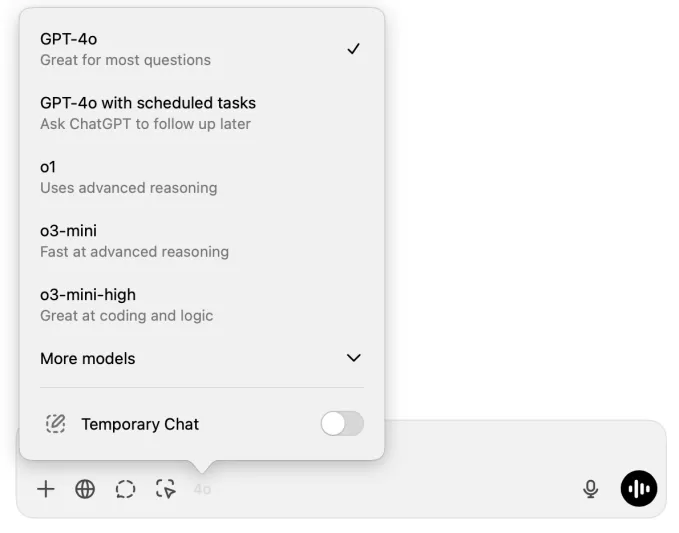

Anthropic stellt auch die Modellauswahlherausforderung an. Wenn Sie beispielsweise ein Chatgpt Plus -Benutzer sind, kann es schwierig sein, zu entscheiden, welches Modell für Ihre nächste Nachricht verwendet werden soll.

Bildnachweis: Screenshot von Chatgpt Gleiches gilt für Entwickler, die APIs mit großer Sprachmodell (LLM) in ihren Apps verwenden, die Genauigkeit, Reaktionsgeschwindigkeit und Kosten in Einklang bringen müssen.

Amodei stellte die Unterscheidung zwischen Normal- und Argumentationsmodellen in Frage. "Wir waren ein bisschen verwirrt von der Idee, dass es normale Modelle gibt und Argumentationsmodelle sind und dass sie sich voneinander unterscheiden", sagte er. "Wenn ich mit dir spreche, hast du nicht zwei Gehirne und einer von ihnen antwortet sofort und mag, der andere wartet eine längere Zeit."

Er glaubt, dass es einen reibungsloseren Übergang zwischen vorgeborenen Modellen wie Claude 3.5 Sonett oder GPT-4O und Modellen geben sollte, die mit Verstärkungslernen ausgebildet sind, die die Kette des Gedanke (COT) wie Openai's O1 oder Deepseeks R1 produzieren können. "Wir denken, dass diese als Teil einer einzigen kontinuierlichen Einheit existieren sollten. Und wir sind vielleicht noch nicht da, aber Anthropic will die Dinge wirklich in diese Richtung bewegen", sagte Amodei. "Wir sollten einen reibungsloseren Übergang von vorbereiteten Modellen haben-und 'Hier ist das Ding und hier ist Ding B.'"

Da KI -Unternehmen wie Anthropic immer bessere Modelle herausschieben, sieht Amodei ein enormes Potenzial für Störungen in der gesamten Branche. "Wir arbeiten mit einigen Pharmaunternehmen zusammen, um Claude zu verwenden, um klinische Studien zu schreiben, und sie konnten die Zeit verkürzen, die für das Schreiben des klinischen Studienberichts von 12 Wochen bis drei Tagen benötigt wird", sagte er.

Er stellt eine "Renaissance disruptiver Innovation" in KI -Anwendungen in Bereichen wie Recht, Finanz, Versicherung, Produktivität, Software und Energie vor. "Ich denke, es wird - im Grunde - eine Renaissance disruptiver Innovationen im AI -Anwendungsraum geben. Und wir möchten ihm helfen, wir wollen alles unterstützen", schloss er.

Lesen Sie unsere vollständige Berichterstattung über den Gipfel der künstlichen Intelligenz in Paris.

TechCrunch hat einen AI-ausgerichteten Newsletter! Melden Sie sich hier an, um es jeden Mittwoch in Ihren Posteingang zu bringen.

Verwandter Artikel

Manus stellt 'Wide Research' AI-Tool mit über 100 Agenten für Web Scraping vor

Der chinesische KI-Innovator Manus, der zuvor durch seine bahnbrechende Multi-Agenten-Orchestrierungsplattform für Verbraucher und professionelle Nutzer auf sich aufmerksam gemacht hat, hat eine bahnb

Manus stellt 'Wide Research' AI-Tool mit über 100 Agenten für Web Scraping vor

Der chinesische KI-Innovator Manus, der zuvor durch seine bahnbrechende Multi-Agenten-Orchestrierungsplattform für Verbraucher und professionelle Nutzer auf sich aufmerksam gemacht hat, hat eine bahnb

Warum LLMs Anweisungen ignorieren und wie man das wirksam beheben kann

Verstehen, warum große Sprachmodelle Anweisungen überspringenGroße Sprachmodelle (Large Language Models, LLMs) haben die Art und Weise, wie wir mit künstlicher Intelligenz interagieren, verändert und

Warum LLMs Anweisungen ignorieren und wie man das wirksam beheben kann

Verstehen, warum große Sprachmodelle Anweisungen überspringenGroße Sprachmodelle (Large Language Models, LLMs) haben die Art und Weise, wie wir mit künstlicher Intelligenz interagieren, verändert und

Pebble erhält nach Rechtsstreit seinen ursprünglichen Markennamen zurück

Die Rückkehr von Pebble: Name und allesPebble-Fans können sich freuen - die beliebte Smartwatch-Marke feiert nicht nur ein Comeback, sondern erhält auch ihren ikonischen Namen zurück. "Wir haben die P

Kommentare (53)

0/200

Pebble erhält nach Rechtsstreit seinen ursprünglichen Markennamen zurück

Die Rückkehr von Pebble: Name und allesPebble-Fans können sich freuen - die beliebte Smartwatch-Marke feiert nicht nur ein Comeback, sondern erhält auch ihren ikonischen Namen zurück. "Wir haben die P

Kommentare (53)

0/200

![ArthurLopez]() ArthurLopez

ArthurLopez

26. August 2025 19:01:20 MESZ

26. August 2025 19:01:20 MESZ

Dario's got a point—AI's zooming ahead, and we're still playing catch-up. Feels like we're in a sci-fi flick, but nobody read the script! 😅 Curious if we'll ever get a grip on this tech race.

0

0

![StephenHernández]() StephenHernández

StephenHernández

26. August 2025 13:01:14 MESZ

26. August 2025 13:01:14 MESZ

Dario's got a point—AI's moving way too fast for these summits to just be talkfests. We need real action, not just fancy speeches. 😤 Curious what Anthropic’s cooking up next to keep up with the race!

0

0

![JasonSanchez]() JasonSanchez

JasonSanchez

20. August 2025 17:01:16 MESZ

20. August 2025 17:01:16 MESZ

Dario's got a point—AI's zooming ahead, and we’re barely keeping up! The Paris summit sounded like a snooze fest. Anyone else worried we’re not ready for what’s coming? 🤔

0

0

![DavidGonzalez]() DavidGonzalez

DavidGonzalez

21. April 2025 10:30:10 MESZ

21. April 2025 10:30:10 MESZ

Anthropic's CEO really laid it out at the AI Summit. It's scary how fast AI is moving, and he's right—we need to take it more seriously. His warning about the race to understand AI hit home. We've gotta step up our game! 🚀

0

0

![EricRoberts]() EricRoberts

EricRoberts

19. April 2025 02:48:00 MESZ

19. April 2025 02:48:00 MESZ

AI 정상회의에서 Anthropic의 CEO가 정말 솔직하게 말했어요. AI가 얼마나 빨리 발전하는지 무섭네요, 그의 말대로 더 진지하게 다뤄야 해요. AI를 이해하기 위한 경쟁에 대한 경고는 마음에 와닿았어요. 우리도 더 노력해야 해요! 🚀

0

0

![JamesMiller]() JamesMiller

JamesMiller

18. April 2025 12:08:01 MESZ

18. April 2025 12:08:01 MESZ

A visão de Dario sobre o AI Action Summit estava certa! Realmente pareceu uma oportunidade perdida para explorar mais profundamente as questões críticas que a IA enfrenta. A urgência dele é exatamente o que precisamos agora. Mal posso esperar para ver quais serão os próximos passos! 🚀

0

0

Gleich nach dem AI-Action-Gipfel in Paris hielt sich Anthropics Mitbegründer und CEO Dario Amodei nicht zurück. Er nannte die Veranstaltung eine "verpasste Gelegenheit" und betonte, dass wir den Fokus und die Dringlichkeit auf mehrere wichtige Themen erhöhen müssen, wenn man bedenkt, wie schnell sich die KI -Tech bewegt. Er teilte diese Gedanken in einer am Dienstag veröffentlichten Erklärung mit.

Anthropic hat sich mit dem französischen Startup Dust für ein Entwickler-Event in Paris zusammengetan, bei dem TechCrunch mit Amodei auf der Bühne chatten durfte. Er teilte seine Perspektive und drängte sich auf einen ausgewogenen Ansatz für KI -Innovation und Governance, wobei er sich sowohl vom extremen Optimismus als auch von hartem Kritik fernhielt.

Amodei, der früher ein Neurowissenschaftler war, sagte: "Ich habe im Grunde genommen in echten Gehirnen gesucht. Und jetzt schauen wir in künstlichen Gehirnen für ihren Lebensunterhalt. Also werden wir in den nächsten Monaten einige aufregende Fortschritte im Bereich der Interpretierbarkeit haben - wo wir wirklich beginnen, zu verstehen, wie die Modelle funktionieren." Aber er wies auch darauf hin, dass es ein Rennen ist. "Es ist ein Rennen zwischen den Models mächtiger, was für uns unglaublich schnell ist und für andere unglaublich schnell - Sie können nicht wirklich langsamer werden, oder? ... Unser Verständnis muss mit unserer Fähigkeit, Dinge aufzubauen, Schritt halten. Ich denke, das ist der einzige Weg", fügte er hinzu.

Seit dem ersten KI -Gipfel in Bletchley, Großbritannien, hat sich das Gespräch um die KI -Governance stark verschoben, beeinflusst vom aktuellen geopolitischen Klima. Der US -Vizepräsident JD Vance, der auf dem AI Action Summit sprach, sagte: "Ich bin heute Morgen nicht hier, um über KI -Sicherheit zu sprechen, was vor ein paar Jahren der Titel der Konferenz war. Ich bin hier, um über die Möglichkeiten der KI zu sprechen."

Amodei versucht jedoch, die Lücke zwischen Sicherheit und Chancen zu schließen. Er glaubt, dass es tatsächlich eine Chance sein kann, mehr auf Sicherheit zu konzentrieren. "Auf dem ursprünglichen Gipfel, dem britischen Bletchley Summit, gab es viele Diskussionen über Tests und Messungen für verschiedene Risiken. Und ich glaube nicht, dass diese Dinge die Technologie überhaupt sehr verlangsamt haben", sagte er bei der anthropischen Veranstaltung. "Wenn überhaupt, hat uns unsere Modelle besser verstehen, was uns letztendlich besser zu verstehen, was es uns hilft, bessere Modelle zu produzieren."

Selbst wenn sie die Sicherheit betonte, machte Amodei deutlich, dass Anthropic immer noch alles darin besteht, Frontier -KI -Modelle zu bauen. "Ich möchte nichts tun, um das Versprechen zu verringern. Wir bieten jeden Tag Modelle an, auf denen die Menschen aufbauen können und die verwendet werden, um erstaunliche Dinge zu tun. Und wir sollten definitiv nicht aufhören, das zu tun", sagte er. Später fügte er hinzu: "Wenn die Leute viel über die Risiken sprechen, ärgere ich mich irgendwie und ich sage: 'Oh, Mann, niemand hat wirklich gute Arbeit gelegt, um herauszufinden, wie großartig diese Technologie sein könnte."

Als sich das Thema an die jüngsten Modelle von Chinese LLM-Hersteller Deepseek wandte, spielte Amodei ihre Erfolge herunter und bezeichnete die öffentliche Reaktion als "anorganisch". Er sagte: "Ehrlich gesagt, meine Reaktion war sehr wenig. Wir hatten V3, das Basismodell für Deepseek R1, im Dezember gesehen. Und das war ein beeindruckendes Modell. Das im Dezember veröffentlichte Modell war auf dieser Art von sehr normalen Kostenreduzierungskurve, die wir in unseren Modellen und anderen Modellen gesehen haben." Was seine Aufmerksamkeit auf sich zog, war, dass das Modell nicht aus den üblichen "drei oder vier Grenzlabors" in den USA wie Google, Openai und Anthropic kam. Er äußerte sich besorgt über autoritäre Regierungen, die die Technologie dominieren. Was Deepseeks beanspruchte Schulungskosten betrifft, entließ er sie als "einfach nicht genau und nicht auf Fakten".

Während Amodei bei der Veranstaltung keine neuen Modelle bekannt gab, deutete er auf bevorstehende Veröffentlichungen mit verbesserten Argumentationsfunktionen hin. "Wir konzentrieren uns im Allgemeinen darauf, unsere eigenen Argumentationsmodelle, die besser differenziert sind, zu versuchen, dass wir sicherstellen, dass wir über genügend Kapazitäten verfügen, dass die Modelle schlauer werden, und wir machen uns Sorgen um Sicherheits Dinge", sagte er.

Anthropic stellt auch die Modellauswahlherausforderung an. Wenn Sie beispielsweise ein Chatgpt Plus -Benutzer sind, kann es schwierig sein, zu entscheiden, welches Modell für Ihre nächste Nachricht verwendet werden soll.

Amodei stellte die Unterscheidung zwischen Normal- und Argumentationsmodellen in Frage. "Wir waren ein bisschen verwirrt von der Idee, dass es normale Modelle gibt und Argumentationsmodelle sind und dass sie sich voneinander unterscheiden", sagte er. "Wenn ich mit dir spreche, hast du nicht zwei Gehirne und einer von ihnen antwortet sofort und mag, der andere wartet eine längere Zeit."

Er glaubt, dass es einen reibungsloseren Übergang zwischen vorgeborenen Modellen wie Claude 3.5 Sonett oder GPT-4O und Modellen geben sollte, die mit Verstärkungslernen ausgebildet sind, die die Kette des Gedanke (COT) wie Openai's O1 oder Deepseeks R1 produzieren können. "Wir denken, dass diese als Teil einer einzigen kontinuierlichen Einheit existieren sollten. Und wir sind vielleicht noch nicht da, aber Anthropic will die Dinge wirklich in diese Richtung bewegen", sagte Amodei. "Wir sollten einen reibungsloseren Übergang von vorbereiteten Modellen haben-und 'Hier ist das Ding und hier ist Ding B.'"

Da KI -Unternehmen wie Anthropic immer bessere Modelle herausschieben, sieht Amodei ein enormes Potenzial für Störungen in der gesamten Branche. "Wir arbeiten mit einigen Pharmaunternehmen zusammen, um Claude zu verwenden, um klinische Studien zu schreiben, und sie konnten die Zeit verkürzen, die für das Schreiben des klinischen Studienberichts von 12 Wochen bis drei Tagen benötigt wird", sagte er.

Er stellt eine "Renaissance disruptiver Innovation" in KI -Anwendungen in Bereichen wie Recht, Finanz, Versicherung, Produktivität, Software und Energie vor. "Ich denke, es wird - im Grunde - eine Renaissance disruptiver Innovationen im AI -Anwendungsraum geben. Und wir möchten ihm helfen, wir wollen alles unterstützen", schloss er.

Lesen Sie unsere vollständige Berichterstattung über den Gipfel der künstlichen Intelligenz in Paris.

TechCrunch hat einen AI-ausgerichteten Newsletter! Melden Sie sich hier an, um es jeden Mittwoch in Ihren Posteingang zu bringen.

Manus stellt 'Wide Research' AI-Tool mit über 100 Agenten für Web Scraping vor

Der chinesische KI-Innovator Manus, der zuvor durch seine bahnbrechende Multi-Agenten-Orchestrierungsplattform für Verbraucher und professionelle Nutzer auf sich aufmerksam gemacht hat, hat eine bahnb

Manus stellt 'Wide Research' AI-Tool mit über 100 Agenten für Web Scraping vor

Der chinesische KI-Innovator Manus, der zuvor durch seine bahnbrechende Multi-Agenten-Orchestrierungsplattform für Verbraucher und professionelle Nutzer auf sich aufmerksam gemacht hat, hat eine bahnb

Warum LLMs Anweisungen ignorieren und wie man das wirksam beheben kann

Verstehen, warum große Sprachmodelle Anweisungen überspringenGroße Sprachmodelle (Large Language Models, LLMs) haben die Art und Weise, wie wir mit künstlicher Intelligenz interagieren, verändert und

Warum LLMs Anweisungen ignorieren und wie man das wirksam beheben kann

Verstehen, warum große Sprachmodelle Anweisungen überspringenGroße Sprachmodelle (Large Language Models, LLMs) haben die Art und Weise, wie wir mit künstlicher Intelligenz interagieren, verändert und

Pebble erhält nach Rechtsstreit seinen ursprünglichen Markennamen zurück

Die Rückkehr von Pebble: Name und allesPebble-Fans können sich freuen - die beliebte Smartwatch-Marke feiert nicht nur ein Comeback, sondern erhält auch ihren ikonischen Namen zurück. "Wir haben die P

Pebble erhält nach Rechtsstreit seinen ursprünglichen Markennamen zurück

Die Rückkehr von Pebble: Name und allesPebble-Fans können sich freuen - die beliebte Smartwatch-Marke feiert nicht nur ein Comeback, sondern erhält auch ihren ikonischen Namen zurück. "Wir haben die P

26. August 2025 19:01:20 MESZ

26. August 2025 19:01:20 MESZ

Dario's got a point—AI's zooming ahead, and we're still playing catch-up. Feels like we're in a sci-fi flick, but nobody read the script! 😅 Curious if we'll ever get a grip on this tech race.

0

0

26. August 2025 13:01:14 MESZ

26. August 2025 13:01:14 MESZ

Dario's got a point—AI's moving way too fast for these summits to just be talkfests. We need real action, not just fancy speeches. 😤 Curious what Anthropic’s cooking up next to keep up with the race!

0

0

20. August 2025 17:01:16 MESZ

20. August 2025 17:01:16 MESZ

Dario's got a point—AI's zooming ahead, and we’re barely keeping up! The Paris summit sounded like a snooze fest. Anyone else worried we’re not ready for what’s coming? 🤔

0

0

21. April 2025 10:30:10 MESZ

21. April 2025 10:30:10 MESZ

Anthropic's CEO really laid it out at the AI Summit. It's scary how fast AI is moving, and he's right—we need to take it more seriously. His warning about the race to understand AI hit home. We've gotta step up our game! 🚀

0

0

19. April 2025 02:48:00 MESZ

19. April 2025 02:48:00 MESZ

AI 정상회의에서 Anthropic의 CEO가 정말 솔직하게 말했어요. AI가 얼마나 빨리 발전하는지 무섭네요, 그의 말대로 더 진지하게 다뤄야 해요. AI를 이해하기 위한 경쟁에 대한 경고는 마음에 와닿았어요. 우리도 더 노력해야 해요! 🚀

0

0

18. April 2025 12:08:01 MESZ

18. April 2025 12:08:01 MESZ

A visão de Dario sobre o AI Action Summit estava certa! Realmente pareceu uma oportunidade perdida para explorar mais profundamente as questões críticas que a IA enfrenta. A urgência dele é exatamente o que precisamos agora. Mal posso esperar para ver quais serão os próximos passos! 🚀

0

0