O CEO da DeepMind Demis Hassabis anuncia a integração futura dos modelos Gemini and Veo AI do Google

Em um recente episódio do podcast Possible, coapresentado pelo cofundador do LinkedIn, Reid Hoffman, o CEO da Google DeepMind, Demis Hassabis, compartilhou algumas notícias empolgantes sobre os planos do Google. Ele revelou que o Google está buscando fundir seus modelos de IA Gemini com os modelos de geração de vídeo Veo. Essa fusão visa aprimorar a compreensão do Gemini sobre o mundo físico, tornando-o mais apto a entender dinâmicas da vida real.

Hassabis enfatizou que, desde o início, o Gemini foi projetado para ser multimodal. "Sempre construímos o Gemini, nosso modelo de fundação, para ser multimodal desde o começo," ele explicou. A motivação por trás dessa abordagem? Uma visão para um assistente digital universal que possa realmente ajudar na vida cotidiana. "Um assistente que … realmente te ajuda no mundo real," Hassabis elaborou.

A indústria de IA está progredindo constantemente em direção ao que você poderia chamar de modelos "omni" — aqueles capazes de lidar e sintetizar vários tipos de mídia. As últimas iterações do Gemini do Google, por exemplo, podem produzir não apenas texto, mas também áudio e imagens. Enquanto isso, o modelo padrão do ChatGPT da OpenAI pode criar imagens na hora, incluindo arte encantadora no estilo Studio Ghibli. A Amazon não está muito atrás, com planos de lançar um modelo "any-to-any" ainda este ano.

Esses modelos omni exigem uma quantidade considerável de dados de treinamento — pense em imagens, vídeos, áudio e texto. Hassabis sugeriu que os dados de vídeo do Veo vêm principalmente do YouTube, um tesouro pertencente ao Google. "Basicamente, ao assistir a vídeos do YouTube — muitos vídeos do YouTube — [Veo 2] pode descobrir, sabe, a física do mundo," ele observou.

O Google havia mencionado anteriormente ao TechCrunch que seus modelos "podem ser" treinados com "algum" conteúdo do YouTube, em conformidade com acordos feitos com criadores do YouTube. Vale notar que, no último ano, o Google expandiu seus termos de serviço, em parte para acessar mais dados para treinar seus modelos de IA.

Artigo relacionado

Google Revela Modo AI e Veo 3 para Revolucionar a Pesquisa e a Criação de Vídeos

A Google lançou recentemente o Modo AI e o Veo 3, duas tecnologias inovadoras destinadas a transformar a pesquisa na web e a criação de conteúdo digital. O Modo AI oferece uma experiência de pesquisa

Google Revela Modo AI e Veo 3 para Revolucionar a Pesquisa e a Criação de Vídeos

A Google lançou recentemente o Modo AI e o Veo 3, duas tecnologias inovadoras destinadas a transformar a pesquisa na web e a criação de conteúdo digital. O Modo AI oferece uma experiência de pesquisa

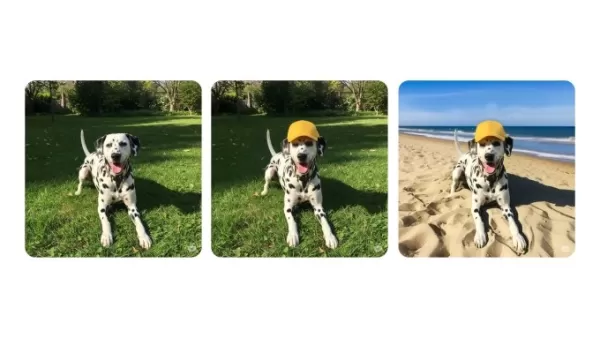

Chatbot Gemini Melhora Capacidades de Edição de Imagens

O aplicativo de chatbot Gemini do Google agora permite que os usuários editem imagens geradas por IA e imagens enviadas a partir de telefones ou computadores, anunciou a empresa em um post de blog na

Chatbot Gemini Melhora Capacidades de Edição de Imagens

O aplicativo de chatbot Gemini do Google agora permite que os usuários editem imagens geradas por IA e imagens enviadas a partir de telefones ou computadores, anunciou a empresa em um post de blog na

Google Revela Deep Think para Melhorar o Desempenho do Gemini AI

Google está avançando seus modelos de IA Gemini de alto nível.Na Google I/O 2025 na terça-feira, a empresa apresentou o Deep Think, um modo de raciocínio avançado para seu principal modelo Gemini 2.5

Comentários (1)

0/200

Google Revela Deep Think para Melhorar o Desempenho do Gemini AI

Google está avançando seus modelos de IA Gemini de alto nível.Na Google I/O 2025 na terça-feira, a empresa apresentou o Deep Think, um modo de raciocínio avançado para seu principal modelo Gemini 2.5

Comentários (1)

0/200

![RalphSanchez]() RalphSanchez

RalphSanchez

1 de Agosto de 2025 à18 03:48:18 WEST

1 de Agosto de 2025 à18 03:48:18 WEST

Wow, merging Gemini with Veo sounds like a game-changer! Can't wait to see how this powers up video creation. But, like, is Google trying to dominate every AI corner now? 😅

0

0

Em um recente episódio do podcast Possible, coapresentado pelo cofundador do LinkedIn, Reid Hoffman, o CEO da Google DeepMind, Demis Hassabis, compartilhou algumas notícias empolgantes sobre os planos do Google. Ele revelou que o Google está buscando fundir seus modelos de IA Gemini com os modelos de geração de vídeo Veo. Essa fusão visa aprimorar a compreensão do Gemini sobre o mundo físico, tornando-o mais apto a entender dinâmicas da vida real.

Hassabis enfatizou que, desde o início, o Gemini foi projetado para ser multimodal. "Sempre construímos o Gemini, nosso modelo de fundação, para ser multimodal desde o começo," ele explicou. A motivação por trás dessa abordagem? Uma visão para um assistente digital universal que possa realmente ajudar na vida cotidiana. "Um assistente que … realmente te ajuda no mundo real," Hassabis elaborou.

A indústria de IA está progredindo constantemente em direção ao que você poderia chamar de modelos "omni" — aqueles capazes de lidar e sintetizar vários tipos de mídia. As últimas iterações do Gemini do Google, por exemplo, podem produzir não apenas texto, mas também áudio e imagens. Enquanto isso, o modelo padrão do ChatGPT da OpenAI pode criar imagens na hora, incluindo arte encantadora no estilo Studio Ghibli. A Amazon não está muito atrás, com planos de lançar um modelo "any-to-any" ainda este ano.

Esses modelos omni exigem uma quantidade considerável de dados de treinamento — pense em imagens, vídeos, áudio e texto. Hassabis sugeriu que os dados de vídeo do Veo vêm principalmente do YouTube, um tesouro pertencente ao Google. "Basicamente, ao assistir a vídeos do YouTube — muitos vídeos do YouTube — [Veo 2] pode descobrir, sabe, a física do mundo," ele observou.

O Google havia mencionado anteriormente ao TechCrunch que seus modelos "podem ser" treinados com "algum" conteúdo do YouTube, em conformidade com acordos feitos com criadores do YouTube. Vale notar que, no último ano, o Google expandiu seus termos de serviço, em parte para acessar mais dados para treinar seus modelos de IA.

Chatbot Gemini Melhora Capacidades de Edição de Imagens

O aplicativo de chatbot Gemini do Google agora permite que os usuários editem imagens geradas por IA e imagens enviadas a partir de telefones ou computadores, anunciou a empresa em um post de blog na

Chatbot Gemini Melhora Capacidades de Edição de Imagens

O aplicativo de chatbot Gemini do Google agora permite que os usuários editem imagens geradas por IA e imagens enviadas a partir de telefones ou computadores, anunciou a empresa em um post de blog na

Google Revela Deep Think para Melhorar o Desempenho do Gemini AI

Google está avançando seus modelos de IA Gemini de alto nível.Na Google I/O 2025 na terça-feira, a empresa apresentou o Deep Think, um modo de raciocínio avançado para seu principal modelo Gemini 2.5

Google Revela Deep Think para Melhorar o Desempenho do Gemini AI

Google está avançando seus modelos de IA Gemini de alto nível.Na Google I/O 2025 na terça-feira, a empresa apresentou o Deep Think, um modo de raciocínio avançado para seu principal modelo Gemini 2.5

1 de Agosto de 2025 à18 03:48:18 WEST

1 de Agosto de 2025 à18 03:48:18 WEST

Wow, merging Gemini with Veo sounds like a game-changer! Can't wait to see how this powers up video creation. But, like, is Google trying to dominate every AI corner now? 😅

0

0