Google의 Gemma 3은 단 하나의 GPU로 DeepSeek 정확도의 98%를 달성합니다.

인공지능의 경제학이 최근 주요 초점이 되었으며, 특히 스타트업 DeepSeek AI가 GPU 칩 사용에서 인상적인 규모의 경제를 보여주고 있습니다. 하지만 Google도 뒤처지지 않습니다. 수요일, 이 테크 거인은 최신 오픈소스 대형 언어 모델 Gemma 3를 공개했는데, 이는 DeepSeek의 R1 모델의 정확도에 거의 근접하면서도 훨씬 적은 컴퓨팅 파워를 사용합니다.

Google은 이 성능을 체스와 스포츠에서 경쟁자를 순위 매기는 데 흔히 사용되는 "Elo" 점수 시스템을 통해 측정했습니다. Gemma 3는 1338점을 기록해 R1의 1363점에 약간 못 미쳤으며, 이는 R1이 기술적으로 Gemma 3를 능가한다는 의미입니다. 그러나 Google은 R1의 점수에 도달하려면 Nvidia의 H100 GPU 칩 32개가 필요하지만, Gemma 3는 단 하나의 H100 GPU로 결과를 달성한다고 추정합니다. Google은 컴퓨팅과 Elo 점수의 이 균형을 "최적의 지점"이라고 내세웁니다.

블로그 포스트에서 Google은 Gemma 3를 "단일 GPU 또는 TPU에서 실행할 수 있는 가장 유능한 모델"이라고 묘사하며, 이는 Google의 자체 AI 칩인 "텐서 프로세싱 유닛"을 언급한 것입니다. 회사는 Gemma 3가 "그 크기에 비해 최첨단 성능을 제공한다"고 주장하며, LMArena 리더보드의 인간 선호도 평가에서 Llama-405B, DeepSeek-V3, o3-mini 같은 모델을 능가합니다. 이 성능은 단일 GPU 또는 TPU 호스트에서 매력적인 사용자 경험을 더 쉽게 만들 수 있게 합니다.

Google

Google

Google의 모델은 또한 Meta의 Llama 3를 Elo 점수에서 능가하며, Google은 이를 위해 16개의 GPU가 필요할 것이라고 추정합니다. 경쟁 모델에 대한 이러한 수치는 Google의 추정치이며, DeepSeek AI는 R1에 대해 Nvidia의 덜 강력한 H800 GPU 1,814개를 사용했다고만 밝혔습니다.

더 자세한 정보는 HuggingFace의 개발자 블로그 포스트에서 확인할 수 있으며, 여기서 Gemma 3 저장소가 제공됩니다. 데이터 센터가 아닌 온디바이스 사용을 위해 설계된 Gemma 3는 R1 및 다른 오픈소스 모델에 비해 훨씬 적은 파라미터 수를 가집니다. 파라미터 수는 10억에서 270억 개로, 현재 기준으로는 상당히 적은 편이며, R1은 6,710억 개의 파라미터를 자랑하지만 선택적으로 370억 개만 사용할 수 있습니다.

Gemma 3의 효율성의 핵심은 널리 사용되는 AI 기술인 증류(distillation)로, 큰 모델에서 훈련된 모델 가중치를 작은 모델로 전이해 그 능력을 향상시킵니다. 또한, 증류된 모델은 세 가지 품질 관리 조치를 거칩니다: 인간 피드백 기반 강화 학습(RLHF), 기계 피드백 기반 강화 학습(RLMF), 실행 피드백 기반 강화 학습(RLEF). 이는 모델 출력의 정교화를 돕고, 더 유용하며 수학 및 코딩 능력을 향상시킵니다.

Google의 개발자 블로그는 이러한 접근 방식을 자세히 설명하며, 또 다른 포스트는 모바일 디바이스를 위한 가장 작은 10억 파라미터 모델의 최적화 기술을 다룹니다. 여기에는 양자화, 키-값 캐시 레이아웃 업데이트, 변수 로딩 시간 개선, GPU 가중치 공유 등이 포함됩니다.

Google은 Gemma 3를 Elo 점수뿐만 아니라 LiveCodeBench 같은 다양한 벤치마크에서 이전 모델인 Gemma 2 및 비공개 Gemini 모델과 비교합니다. Gemma 3는 일반적으로 Gemini 1.5 및 Gemini 2.0의 정확도에 미치지 못하지만, Google은 파라미터 수가 적음에도 불구하고 "비공개 Gemini 모델과 비교해 경쟁력 있는 성능을 보인다"고 언급합니다.

Google

Google

Gemma 2에 비해 Gemma 3의 중요한 업그레이드는 "컨텍스트 윈도우"가 8,000에서 128,000 토큰으로 확장된 것입니다. 이는 모델이 전체 논문이나 책과 같은 큰 텍스트를 처리할 수 있게 합니다. Gemma 3는 또한 텍스트와 이미지 입력을 모두 처리할 수 있는 멀티모달 모델로, 이전 모델과 달리 140개 이상의 언어를 지원하며, Gemma 2의 영어 전용 기능에 비해 크게 개선되었습니다.

이 주요 기능 외에도 Gemma 3에는 몇 가지 흥미로운 측면이 있습니다. 대형 언어 모델의 문제 중 하나는 훈련 데이터의 일부를 기억할 가능성이 있어 개인정보 침해로 이어질 수 있다는 점입니다. Google의 연구자들은 Gemma 3를 테스트한 결과, 이전 모델보다 긴 텍스트를 기억하는 비율이 낮아 개인정보 보호가 개선되었음을 시사합니다.

자세한 내용을 원하는 이들을 위해 Gemma 3 기술 논문은 모델의 능력과 개발에 대한 철저한 분석을 제공합니다.

관련 기사

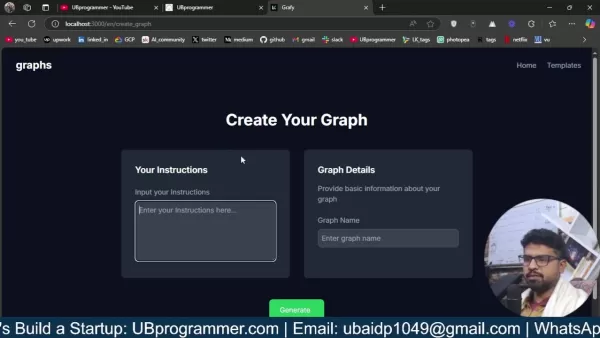

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

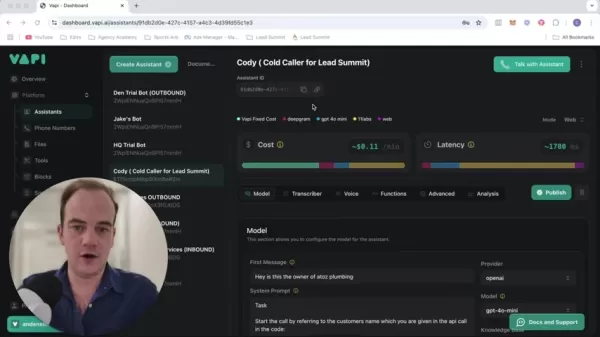

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

의견 (10)

0/200

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

의견 (10)

0/200

![RonaldMartinez]() RonaldMartinez

RonaldMartinez

2025년 8월 17일 오후 6시 0분 59초 GMT+09:00

2025년 8월 17일 오후 6시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this'll shake up the AI startup scene. 🚀

0

0

![GaryJones]() GaryJones

GaryJones

2025년 8월 16일 오전 2시 0분 59초 GMT+09:00

2025년 8월 16일 오전 2시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this stacks up in real-world apps! 😎

0

0

![JonathanDavis]() JonathanDavis

JonathanDavis

2025년 8월 13일 오후 10시 0분 59초 GMT+09:00

2025년 8월 13일 오후 10시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! Achieving 98% of DeepSeek's accuracy with just one GPU is wild. Makes me wonder how this’ll shake up the AI race—more power to the little guys? 🤔

0

0

![ArthurSanchez]() ArthurSanchez

ArthurSanchez

2025년 8월 5일 오전 10시 0분 59초 GMT+09:00

2025년 8월 5일 오전 10시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's like getting a sports car for the price of a bike! 😎 Can't wait to see how this shakes up the AI race.

0

0

![EvelynHarris]() EvelynHarris

EvelynHarris

2025년 8월 1일 오후 3시 8분 50초 GMT+09:00

2025년 8월 1일 오후 3시 8분 50초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Can't wait to see how devs play with this open-source gem! 😎

0

0

![ArthurLopez]() ArthurLopez

ArthurLopez

2025년 5월 3일 오전 11시 53분 19초 GMT+09:00

2025년 5월 3일 오전 11시 53분 19초 GMT+09:00

Google's Gemma 3 is pretty impressive, hitting 98% accuracy with just one GPU! 🤯 It's like they're showing off, but in a good way. Makes me wonder if I should switch to Google's tech for my projects. Definitely worth a try, right?

0

0

인공지능의 경제학이 최근 주요 초점이 되었으며, 특히 스타트업 DeepSeek AI가 GPU 칩 사용에서 인상적인 규모의 경제를 보여주고 있습니다. 하지만 Google도 뒤처지지 않습니다. 수요일, 이 테크 거인은 최신 오픈소스 대형 언어 모델 Gemma 3를 공개했는데, 이는 DeepSeek의 R1 모델의 정확도에 거의 근접하면서도 훨씬 적은 컴퓨팅 파워를 사용합니다.

Google은 이 성능을 체스와 스포츠에서 경쟁자를 순위 매기는 데 흔히 사용되는 "Elo" 점수 시스템을 통해 측정했습니다. Gemma 3는 1338점을 기록해 R1의 1363점에 약간 못 미쳤으며, 이는 R1이 기술적으로 Gemma 3를 능가한다는 의미입니다. 그러나 Google은 R1의 점수에 도달하려면 Nvidia의 H100 GPU 칩 32개가 필요하지만, Gemma 3는 단 하나의 H100 GPU로 결과를 달성한다고 추정합니다. Google은 컴퓨팅과 Elo 점수의 이 균형을 "최적의 지점"이라고 내세웁니다.

블로그 포스트에서 Google은 Gemma 3를 "단일 GPU 또는 TPU에서 실행할 수 있는 가장 유능한 모델"이라고 묘사하며, 이는 Google의 자체 AI 칩인 "텐서 프로세싱 유닛"을 언급한 것입니다. 회사는 Gemma 3가 "그 크기에 비해 최첨단 성능을 제공한다"고 주장하며, LMArena 리더보드의 인간 선호도 평가에서 Llama-405B, DeepSeek-V3, o3-mini 같은 모델을 능가합니다. 이 성능은 단일 GPU 또는 TPU 호스트에서 매력적인 사용자 경험을 더 쉽게 만들 수 있게 합니다.

Google의 모델은 또한 Meta의 Llama 3를 Elo 점수에서 능가하며, Google은 이를 위해 16개의 GPU가 필요할 것이라고 추정합니다. 경쟁 모델에 대한 이러한 수치는 Google의 추정치이며, DeepSeek AI는 R1에 대해 Nvidia의 덜 강력한 H800 GPU 1,814개를 사용했다고만 밝혔습니다.

더 자세한 정보는 HuggingFace의 개발자 블로그 포스트에서 확인할 수 있으며, 여기서 Gemma 3 저장소가 제공됩니다. 데이터 센터가 아닌 온디바이스 사용을 위해 설계된 Gemma 3는 R1 및 다른 오픈소스 모델에 비해 훨씬 적은 파라미터 수를 가집니다. 파라미터 수는 10억에서 270억 개로, 현재 기준으로는 상당히 적은 편이며, R1은 6,710억 개의 파라미터를 자랑하지만 선택적으로 370억 개만 사용할 수 있습니다.

Gemma 3의 효율성의 핵심은 널리 사용되는 AI 기술인 증류(distillation)로, 큰 모델에서 훈련된 모델 가중치를 작은 모델로 전이해 그 능력을 향상시킵니다. 또한, 증류된 모델은 세 가지 품질 관리 조치를 거칩니다: 인간 피드백 기반 강화 학습(RLHF), 기계 피드백 기반 강화 학습(RLMF), 실행 피드백 기반 강화 학습(RLEF). 이는 모델 출력의 정교화를 돕고, 더 유용하며 수학 및 코딩 능력을 향상시킵니다.

Google의 개발자 블로그는 이러한 접근 방식을 자세히 설명하며, 또 다른 포스트는 모바일 디바이스를 위한 가장 작은 10억 파라미터 모델의 최적화 기술을 다룹니다. 여기에는 양자화, 키-값 캐시 레이아웃 업데이트, 변수 로딩 시간 개선, GPU 가중치 공유 등이 포함됩니다.

Google은 Gemma 3를 Elo 점수뿐만 아니라 LiveCodeBench 같은 다양한 벤치마크에서 이전 모델인 Gemma 2 및 비공개 Gemini 모델과 비교합니다. Gemma 3는 일반적으로 Gemini 1.5 및 Gemini 2.0의 정확도에 미치지 못하지만, Google은 파라미터 수가 적음에도 불구하고 "비공개 Gemini 모델과 비교해 경쟁력 있는 성능을 보인다"고 언급합니다.

Gemma 2에 비해 Gemma 3의 중요한 업그레이드는 "컨텍스트 윈도우"가 8,000에서 128,000 토큰으로 확장된 것입니다. 이는 모델이 전체 논문이나 책과 같은 큰 텍스트를 처리할 수 있게 합니다. Gemma 3는 또한 텍스트와 이미지 입력을 모두 처리할 수 있는 멀티모달 모델로, 이전 모델과 달리 140개 이상의 언어를 지원하며, Gemma 2의 영어 전용 기능에 비해 크게 개선되었습니다.

이 주요 기능 외에도 Gemma 3에는 몇 가지 흥미로운 측면이 있습니다. 대형 언어 모델의 문제 중 하나는 훈련 데이터의 일부를 기억할 가능성이 있어 개인정보 침해로 이어질 수 있다는 점입니다. Google의 연구자들은 Gemma 3를 테스트한 결과, 이전 모델보다 긴 텍스트를 기억하는 비율이 낮아 개인정보 보호가 개선되었음을 시사합니다.

자세한 내용을 원하는 이들을 위해 Gemma 3 기술 논문은 모델의 능력과 개발에 대한 철저한 분석을 제공합니다.

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

교육용 인포그래픽 제작을 위한 최고의 AI 도구 - 디자인 팁 및 기술

오늘날의 디지털 중심 교육 환경에서 인포그래픽은 복잡한 정보를 시각적으로 매력적이고 이해하기 쉬운 형식으로 변환하는 혁신적인 커뮤니케이션 매체로 부상했습니다. AI 기술은 교육자가 이러한 시각적 학습 보조 자료를 제작하는 방식을 혁신하여 누구나 전문가 수준의 디자인을 이용할 수 있게 하는 동시에 제작 시간을 획기적으로 단축하고 있습니다. 이 탐구에서는 간소

2025년 8월 17일 오후 6시 0분 59초 GMT+09:00

2025년 8월 17일 오후 6시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this'll shake up the AI startup scene. 🚀

0

0

2025년 8월 16일 오전 2시 0분 59초 GMT+09:00

2025년 8월 16일 오전 2시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this stacks up in real-world apps! 😎

0

0

2025년 8월 13일 오후 10시 0분 59초 GMT+09:00

2025년 8월 13일 오후 10시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! Achieving 98% of DeepSeek's accuracy with just one GPU is wild. Makes me wonder how this’ll shake up the AI race—more power to the little guys? 🤔

0

0

2025년 8월 5일 오전 10시 0분 59초 GMT+09:00

2025년 8월 5일 오전 10시 0분 59초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's like getting a sports car for the price of a bike! 😎 Can't wait to see how this shakes up the AI race.

0

0

2025년 8월 1일 오후 3시 8분 50초 GMT+09:00

2025년 8월 1일 오후 3시 8분 50초 GMT+09:00

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Can't wait to see how devs play with this open-source gem! 😎

0

0

2025년 5월 3일 오전 11시 53분 19초 GMT+09:00

2025년 5월 3일 오전 11시 53분 19초 GMT+09:00

Google's Gemma 3 is pretty impressive, hitting 98% accuracy with just one GPU! 🤯 It's like they're showing off, but in a good way. Makes me wonder if I should switch to Google's tech for my projects. Definitely worth a try, right?

0

0