Googles Gemma 3 erreicht 98% der Genauigkeit von Deepseek mit nur einer GPU

Die Ökonomie der künstlichen Intelligenz steht in letzter Zeit stark im Fokus, insbesondere da das Startup DeepSeek AI beeindruckende Skaleneffekte beim Einsatz von GPU-Chips zeigt. Doch Google lässt sich nicht übertrumpfen. Am Mittwoch stellte der Technologieriese sein neuestes Open-Source-Sprachmodell Gemma 3 vor, das fast die Genauigkeit des R1-Modells von DeepSeek erreicht, jedoch deutlich weniger Rechenleistung benötigt.

Google hat diese Leistung anhand von „Elo“-Werten gemessen, einem System, das üblicherweise im Schach und im Sport zur Rangfolge von Wettbewerbern verwendet wird. Gemma 3 erreichte 1338 Punkte, knapp unter den 1363 Punkten von R1, was bedeutet, dass R1 technisch gesehen besser abschneidet. Google schätzt jedoch, dass 32 von Nvidias H100-GPU-Chips benötigt würden, um den Wert von R1 zu erreichen, während Gemma 3 seine Ergebnisse mit nur einem H100-GPU erzielt. Google preist dieses Gleichgewicht aus Rechenleistung und Elo-Wert als „sweet spot“.

In einem Blogbeitrag beschreibt Google Gemma 3 als „das leistungsfähigste Modell, das auf einem einzigen GPU oder TPU laufen kann“, in Bezug auf seinen eigenen speziell entwickelten AI-Chip, die „Tensor Processing Unit“. Das Unternehmen behauptet, dass Gemma 3 „modernste Leistung für seine Größe bietet“ und Modelle wie Llama-405B, DeepSeek-V3 und o3-mini in menschlichen Präferenzbewertungen auf der Rangliste von LMArena übertrifft. Diese Leistung erleichtert die Schaffung ansprechender Benutzererlebnisse auf einem einzigen GPU- oder TPU-Host.

Google

Google

Googles Modell übertrifft auch Metas Llama 3 im Elo-Wert, für das Google schätzt, dass 16 GPUs erforderlich wären. Es ist zu beachten, dass diese Zahlen für konkurrierende Modelle Schätzungen von Google sind; DeepSeek AI hat nur offengelegt, dass für R1 1.814 von Nvidias weniger leistungsstarken H800-GPUs verwendet wurden.

Weitere detaillierte Informationen finden sich in einem Entwickler-Blogbeitrag auf HuggingFace, wo das Gemma 3-Repository verfügbar ist. Gemma 3 ist für den Einsatz auf Geräten statt in Rechenzentren konzipiert und hat im Vergleich zu R1 und anderen Open-Source-Modellen deutlich weniger Parameter. Mit einer Parameteranzahl von 1 Milliarde bis 27 Milliarden ist Gemma 3 nach heutigen Maßstäben recht bescheiden, während R1 stolze 671 Milliarden Parameter aufweist, obwohl es selektiv nur 37 Milliarden nutzen kann.

Der Schlüssel zur Effizienz von Gemma 3 ist eine weit verbreitete KI-Technik namens Destillation, bei der trainierte Modellgewichte von einem größeren Modell auf ein kleineres übertragen werden, um dessen Fähigkeiten zu verbessern. Zusätzlich durchläuft das destillierte Modell drei Qualitätskontrollmaßnahmen: Reinforcement Learning from Human Feedback (RLHF), Reinforcement Learning from Machine Feedback (RLMF) und Reinforcement Learning from Execution Feedback (RLEF). Diese helfen, die Ausgaben des Modells zu verfeinern, sie hilfreicher zu machen und seine Mathematik- und Programmierfähigkeiten zu verbessern.

Googles Entwickler-Blog erläutert diese Ansätze, und ein weiterer Beitrag diskutiert Optimierungstechniken für das kleinste Modell mit 1 Milliarde Parametern, das für mobile Geräte gedacht ist. Dazu gehören Quantisierung, Aktualisierung der Layouts des Schlüssel-Wert-Caches, Verbesserung der Ladezeiten von Variablen und GPU-Gewichtsteilung.

Google vergleicht Gemma 3 nicht nur anhand von Elo-Werten, sondern auch mit seinem Vorgänger Gemma 2 und seinen Closed-Source-Gemini-Modellen anhand verschiedener Benchmarks wie LiveCodeBench. Während Gemma 3 in der Genauigkeit im Allgemeinen hinter Gemini 1.5 und Gemini 2.0 zurückbleibt, stellt Google fest, dass es „wettbewerbsfähige Leistung im Vergleich zu geschlossenen Gemini-Modellen zeigt“, obwohl es weniger Parameter hat.

Google

Google

Eine bedeutende Verbesserung von Gemma 3 gegenüber Gemma 2 ist das längere „Kontextfenster“, das von 8.000 auf 128.000 Token erweitert wurde. Dies ermöglicht dem Modell, größere Texte wie ganze Papiere oder Bücher zu verarbeiten. Gemma 3 ist auch multimodal und kann sowohl Text- als auch Bildeingaben verarbeiten, im Gegensatz zu seinem Vorgänger. Außerdem unterstützt es über 140 Sprachen, eine enorme Verbesserung gegenüber den rein englischen Fähigkeiten von Gemma 2.

Neben diesen Hauptmerkmalen gibt es mehrere weitere interessante Aspekte von Gemma 3. Ein Problem bei großen Sprachmodellen ist das Potenzial, Teile ihrer Trainingsdaten zu speichern, was zu Datenschutzverletzungen führen könnte. Googles Forscher haben Gemma 3 darauf getestet und festgestellt, dass es Langformtexte in geringerem Maße speichert als seine Vorgänger, was auf einen verbesserten Datenschutz hindeutet.

Für diejenigen, die an den Details interessiert sind, bietet das technische Papier zu Gemma 3 eine gründliche Analyse der Fähigkeiten und Entwicklung des Modells.

Verwandter Artikel

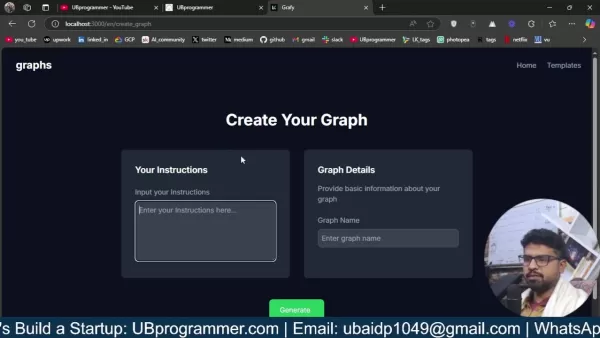

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

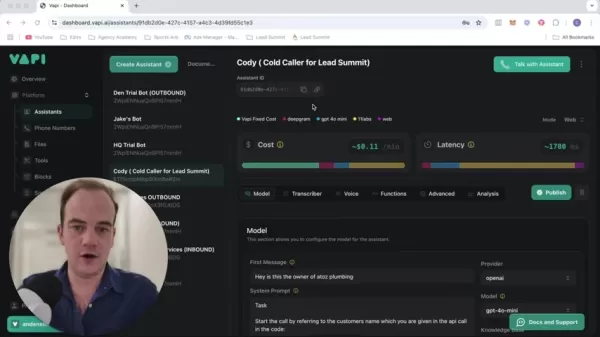

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (10)

0/200

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Kommentare (10)

0/200

![RonaldMartinez]() RonaldMartinez

RonaldMartinez

17. August 2025 11:00:59 MESZ

17. August 2025 11:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this'll shake up the AI startup scene. 🚀

0

0

![GaryJones]() GaryJones

GaryJones

15. August 2025 19:00:59 MESZ

15. August 2025 19:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this stacks up in real-world apps! 😎

0

0

![JonathanDavis]() JonathanDavis

JonathanDavis

13. August 2025 15:00:59 MESZ

13. August 2025 15:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! Achieving 98% of DeepSeek's accuracy with just one GPU is wild. Makes me wonder how this’ll shake up the AI race—more power to the little guys? 🤔

0

0

![ArthurSanchez]() ArthurSanchez

ArthurSanchez

5. August 2025 03:00:59 MESZ

5. August 2025 03:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's like getting a sports car for the price of a bike! 😎 Can't wait to see how this shakes up the AI race.

0

0

![EvelynHarris]() EvelynHarris

EvelynHarris

1. August 2025 08:08:50 MESZ

1. August 2025 08:08:50 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Can't wait to see how devs play with this open-source gem! 😎

0

0

![ArthurLopez]() ArthurLopez

ArthurLopez

3. Mai 2025 04:53:19 MESZ

3. Mai 2025 04:53:19 MESZ

Google's Gemma 3 is pretty impressive, hitting 98% accuracy with just one GPU! 🤯 It's like they're showing off, but in a good way. Makes me wonder if I should switch to Google's tech for my projects. Definitely worth a try, right?

0

0

Die Ökonomie der künstlichen Intelligenz steht in letzter Zeit stark im Fokus, insbesondere da das Startup DeepSeek AI beeindruckende Skaleneffekte beim Einsatz von GPU-Chips zeigt. Doch Google lässt sich nicht übertrumpfen. Am Mittwoch stellte der Technologieriese sein neuestes Open-Source-Sprachmodell Gemma 3 vor, das fast die Genauigkeit des R1-Modells von DeepSeek erreicht, jedoch deutlich weniger Rechenleistung benötigt.

Google hat diese Leistung anhand von „Elo“-Werten gemessen, einem System, das üblicherweise im Schach und im Sport zur Rangfolge von Wettbewerbern verwendet wird. Gemma 3 erreichte 1338 Punkte, knapp unter den 1363 Punkten von R1, was bedeutet, dass R1 technisch gesehen besser abschneidet. Google schätzt jedoch, dass 32 von Nvidias H100-GPU-Chips benötigt würden, um den Wert von R1 zu erreichen, während Gemma 3 seine Ergebnisse mit nur einem H100-GPU erzielt. Google preist dieses Gleichgewicht aus Rechenleistung und Elo-Wert als „sweet spot“.

In einem Blogbeitrag beschreibt Google Gemma 3 als „das leistungsfähigste Modell, das auf einem einzigen GPU oder TPU laufen kann“, in Bezug auf seinen eigenen speziell entwickelten AI-Chip, die „Tensor Processing Unit“. Das Unternehmen behauptet, dass Gemma 3 „modernste Leistung für seine Größe bietet“ und Modelle wie Llama-405B, DeepSeek-V3 und o3-mini in menschlichen Präferenzbewertungen auf der Rangliste von LMArena übertrifft. Diese Leistung erleichtert die Schaffung ansprechender Benutzererlebnisse auf einem einzigen GPU- oder TPU-Host.

Googles Modell übertrifft auch Metas Llama 3 im Elo-Wert, für das Google schätzt, dass 16 GPUs erforderlich wären. Es ist zu beachten, dass diese Zahlen für konkurrierende Modelle Schätzungen von Google sind; DeepSeek AI hat nur offengelegt, dass für R1 1.814 von Nvidias weniger leistungsstarken H800-GPUs verwendet wurden.

Weitere detaillierte Informationen finden sich in einem Entwickler-Blogbeitrag auf HuggingFace, wo das Gemma 3-Repository verfügbar ist. Gemma 3 ist für den Einsatz auf Geräten statt in Rechenzentren konzipiert und hat im Vergleich zu R1 und anderen Open-Source-Modellen deutlich weniger Parameter. Mit einer Parameteranzahl von 1 Milliarde bis 27 Milliarden ist Gemma 3 nach heutigen Maßstäben recht bescheiden, während R1 stolze 671 Milliarden Parameter aufweist, obwohl es selektiv nur 37 Milliarden nutzen kann.

Der Schlüssel zur Effizienz von Gemma 3 ist eine weit verbreitete KI-Technik namens Destillation, bei der trainierte Modellgewichte von einem größeren Modell auf ein kleineres übertragen werden, um dessen Fähigkeiten zu verbessern. Zusätzlich durchläuft das destillierte Modell drei Qualitätskontrollmaßnahmen: Reinforcement Learning from Human Feedback (RLHF), Reinforcement Learning from Machine Feedback (RLMF) und Reinforcement Learning from Execution Feedback (RLEF). Diese helfen, die Ausgaben des Modells zu verfeinern, sie hilfreicher zu machen und seine Mathematik- und Programmierfähigkeiten zu verbessern.

Googles Entwickler-Blog erläutert diese Ansätze, und ein weiterer Beitrag diskutiert Optimierungstechniken für das kleinste Modell mit 1 Milliarde Parametern, das für mobile Geräte gedacht ist. Dazu gehören Quantisierung, Aktualisierung der Layouts des Schlüssel-Wert-Caches, Verbesserung der Ladezeiten von Variablen und GPU-Gewichtsteilung.

Google vergleicht Gemma 3 nicht nur anhand von Elo-Werten, sondern auch mit seinem Vorgänger Gemma 2 und seinen Closed-Source-Gemini-Modellen anhand verschiedener Benchmarks wie LiveCodeBench. Während Gemma 3 in der Genauigkeit im Allgemeinen hinter Gemini 1.5 und Gemini 2.0 zurückbleibt, stellt Google fest, dass es „wettbewerbsfähige Leistung im Vergleich zu geschlossenen Gemini-Modellen zeigt“, obwohl es weniger Parameter hat.

Eine bedeutende Verbesserung von Gemma 3 gegenüber Gemma 2 ist das längere „Kontextfenster“, das von 8.000 auf 128.000 Token erweitert wurde. Dies ermöglicht dem Modell, größere Texte wie ganze Papiere oder Bücher zu verarbeiten. Gemma 3 ist auch multimodal und kann sowohl Text- als auch Bildeingaben verarbeiten, im Gegensatz zu seinem Vorgänger. Außerdem unterstützt es über 140 Sprachen, eine enorme Verbesserung gegenüber den rein englischen Fähigkeiten von Gemma 2.

Neben diesen Hauptmerkmalen gibt es mehrere weitere interessante Aspekte von Gemma 3. Ein Problem bei großen Sprachmodellen ist das Potenzial, Teile ihrer Trainingsdaten zu speichern, was zu Datenschutzverletzungen führen könnte. Googles Forscher haben Gemma 3 darauf getestet und festgestellt, dass es Langformtexte in geringerem Maße speichert als seine Vorgänger, was auf einen verbesserten Datenschutz hindeutet.

Für diejenigen, die an den Details interessiert sind, bietet das technische Papier zu Gemma 3 eine gründliche Analyse der Fähigkeiten und Entwicklung des Modells.

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Einfaches Generieren von KI-gestützten Grafiken und Visualisierungen für bessere Dateneinblicke

Die moderne Datenanalyse erfordert eine intuitive Visualisierung komplexer Informationen. KI-gestützte Lösungen zur Diagrammerstellung haben sich als unverzichtbare Hilfsmittel erwiesen und revolution

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

17. August 2025 11:00:59 MESZ

17. August 2025 11:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this'll shake up the AI startup scene. 🚀

0

0

15. August 2025 19:00:59 MESZ

15. August 2025 19:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this stacks up in real-world apps! 😎

0

0

13. August 2025 15:00:59 MESZ

13. August 2025 15:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! Achieving 98% of DeepSeek's accuracy with just one GPU is wild. Makes me wonder how this’ll shake up the AI race—more power to the little guys? 🤔

0

0

5. August 2025 03:00:59 MESZ

5. August 2025 03:00:59 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's like getting a sports car for the price of a bike! 😎 Can't wait to see how this shakes up the AI race.

0

0

1. August 2025 08:08:50 MESZ

1. August 2025 08:08:50 MESZ

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Can't wait to see how devs play with this open-source gem! 😎

0

0

3. Mai 2025 04:53:19 MESZ

3. Mai 2025 04:53:19 MESZ

Google's Gemma 3 is pretty impressive, hitting 98% accuracy with just one GPU! 🤯 It's like they're showing off, but in a good way. Makes me wonder if I should switch to Google's tech for my projects. Definitely worth a try, right?

0

0