Google的Gemma 3仅使用一个GPU实现了DeepSeek准确性的98%

人工智能经济学近期备受关注,尤其是初创公司DeepSeek AI展示的GPU芯片规模经济令人印象深刻。但Google不甘示弱。周三,这家科技巨头发布了最新的开源大型语言模型Gemma 3,其准确性几乎与DeepSeek的R1模型相当,但计算资源消耗显著减少。

Google使用“Elo”评分衡量性能,这是一种常用于国际象棋和体育的排名系统。Gemma 3得分1338,略低于R1的1363,意味着R1技术上优于Gemma 3。然而,Google估计达到R1的得分需要32个Nvidia H100 GPU芯片,而Gemma 3仅用一个H100 GPU即可实现。Google称这种计算与Elo评分的平衡为“最佳点”。

在博客文章中,Google描述Gemma 3为“可在单一GPU或TPU上运行的最强大模型”,指的是其定制AI芯片“张量处理单元”。公司宣称Gemma 3“在其规模下提供顶尖性能”,在LMArena排行榜的人类偏好评估中超越Llama-405B、DeepSeek-V3和o3-mini等模型。这种性能使其更容易在单一GPU或TPU主机上创建引人入胜的用户体验。

Google

Google

Google的模型在Elo评分上也超越了Meta的Llama 3,Google估计后者需16个GPU。值得注意的是,这些竞争模型的数据是Google的估计;DeepSeek AI仅透露R1使用了1814个性能较低的Nvidia H800 GPU。

更多详细信息可在HuggingFace的开发者博客文章中找到,Gemma 3仓库也已开放。Gemma 3专为设备端使用而非数据中心设计,参数数量远少于R1和其他开源模型。Gemma 3的参数从10亿到270亿不等,相比当前标准较为适中,而R1拥有高达6710亿参数,尽管可选择性使用370亿参数。

Gemma 3效率的关键在于广泛使用的AI技术——蒸馏,即将大模型的训练权重转移到较小的模型以提升其能力。此外,蒸馏模型经过三项质量控制措施:基于人类反馈的强化学习(RLHF)、基于机器反馈的强化学习(RLMF)和基于执行反馈的强化学习(RLEF)。这些措施优化模型输出,使其更实用,并提升数学和编码能力。

Google的开发者博客详细介绍了这些方法,另一篇文章讨论了针对最小10亿参数模型的优化技术,面向移动设备,包括量化、更新键值缓存布局、改进变量加载时间和GPU权重共享。

Google不仅基于Elo评分比较Gemma 3,还与前代Gemma 2及其闭源Gemini模型在LiveCodeBench等基准测试中进行对比。虽然Gemma 3在准确性上通常不及Gemini 1.5和Gemini 2.0,但Google指出,尽管参数较少,其“与闭源Gemini模型相比表现出色”。

Google

Google

Gemma 3相较Gemma 2的重大升级是其“上下文窗口”从8000个令牌扩展到128000个令牌,可处理整篇论文或书籍等大型文本。Gemma 3还支持多模态,可处理文本和图像输入,不同于前代。此外,它支持超过140种语言,远超Gemma 2的仅英语能力。

除主要功能外,Gemma 3还有其他有趣特点。大型语言模型可能记住训练数据部分内容,导致隐私泄露风险。Google的研究人员测试发现,Gemma 3对长文本的记忆率低于前代,表明隐私保护有所改进。

对细节感兴趣的用户可参阅Gemma 3技术论文,全面了解模型能力和开发过程。

相关文章

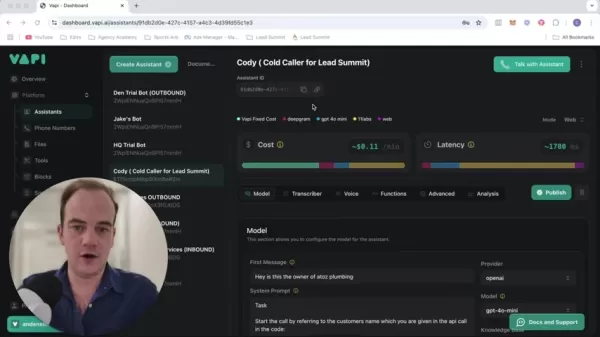

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

评论 (10)

0/200

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

评论 (10)

0/200

![RonaldMartinez]() RonaldMartinez

RonaldMartinez

2025-08-17 17:00:59

2025-08-17 17:00:59

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this'll shake up the AI startup scene. 🚀

0

0

![GaryJones]() GaryJones

GaryJones

2025-08-16 01:00:59

2025-08-16 01:00:59

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this stacks up in real-world apps! 😎

0

0

![JonathanDavis]() JonathanDavis

JonathanDavis

2025-08-13 21:00:59

2025-08-13 21:00:59

Google's Gemma 3 sounds like a game-changer! Achieving 98% of DeepSeek's accuracy with just one GPU is wild. Makes me wonder how this’ll shake up the AI race—more power to the little guys? 🤔

0

0

![ArthurSanchez]() ArthurSanchez

ArthurSanchez

2025-08-05 09:00:59

2025-08-05 09:00:59

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's like getting a sports car for the price of a bike! 😎 Can't wait to see how this shakes up the AI race.

0

0

![EvelynHarris]() EvelynHarris

EvelynHarris

2025-08-01 14:08:50

2025-08-01 14:08:50

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Can't wait to see how devs play with this open-source gem! 😎

0

0

![ArthurLopez]() ArthurLopez

ArthurLopez

2025-05-03 10:53:19

2025-05-03 10:53:19

Google's Gemma 3 is pretty impressive, hitting 98% accuracy with just one GPU! 🤯 It's like they're showing off, but in a good way. Makes me wonder if I should switch to Google's tech for my projects. Definitely worth a try, right?

0

0

人工智能经济学近期备受关注,尤其是初创公司DeepSeek AI展示的GPU芯片规模经济令人印象深刻。但Google不甘示弱。周三,这家科技巨头发布了最新的开源大型语言模型Gemma 3,其准确性几乎与DeepSeek的R1模型相当,但计算资源消耗显著减少。

Google使用“Elo”评分衡量性能,这是一种常用于国际象棋和体育的排名系统。Gemma 3得分1338,略低于R1的1363,意味着R1技术上优于Gemma 3。然而,Google估计达到R1的得分需要32个Nvidia H100 GPU芯片,而Gemma 3仅用一个H100 GPU即可实现。Google称这种计算与Elo评分的平衡为“最佳点”。

在博客文章中,Google描述Gemma 3为“可在单一GPU或TPU上运行的最强大模型”,指的是其定制AI芯片“张量处理单元”。公司宣称Gemma 3“在其规模下提供顶尖性能”,在LMArena排行榜的人类偏好评估中超越Llama-405B、DeepSeek-V3和o3-mini等模型。这种性能使其更容易在单一GPU或TPU主机上创建引人入胜的用户体验。

Google的模型在Elo评分上也超越了Meta的Llama 3,Google估计后者需16个GPU。值得注意的是,这些竞争模型的数据是Google的估计;DeepSeek AI仅透露R1使用了1814个性能较低的Nvidia H800 GPU。

更多详细信息可在HuggingFace的开发者博客文章中找到,Gemma 3仓库也已开放。Gemma 3专为设备端使用而非数据中心设计,参数数量远少于R1和其他开源模型。Gemma 3的参数从10亿到270亿不等,相比当前标准较为适中,而R1拥有高达6710亿参数,尽管可选择性使用370亿参数。

Gemma 3效率的关键在于广泛使用的AI技术——蒸馏,即将大模型的训练权重转移到较小的模型以提升其能力。此外,蒸馏模型经过三项质量控制措施:基于人类反馈的强化学习(RLHF)、基于机器反馈的强化学习(RLMF)和基于执行反馈的强化学习(RLEF)。这些措施优化模型输出,使其更实用,并提升数学和编码能力。

Google的开发者博客详细介绍了这些方法,另一篇文章讨论了针对最小10亿参数模型的优化技术,面向移动设备,包括量化、更新键值缓存布局、改进变量加载时间和GPU权重共享。

Google不仅基于Elo评分比较Gemma 3,还与前代Gemma 2及其闭源Gemini模型在LiveCodeBench等基准测试中进行对比。虽然Gemma 3在准确性上通常不及Gemini 1.5和Gemini 2.0,但Google指出,尽管参数较少,其“与闭源Gemini模型相比表现出色”。

Gemma 3相较Gemma 2的重大升级是其“上下文窗口”从8000个令牌扩展到128000个令牌,可处理整篇论文或书籍等大型文本。Gemma 3还支持多模态,可处理文本和图像输入,不同于前代。此外,它支持超过140种语言,远超Gemma 2的仅英语能力。

除主要功能外,Gemma 3还有其他有趣特点。大型语言模型可能记住训练数据部分内容,导致隐私泄露风险。Google的研究人员测试发现,Gemma 3对长文本的记忆率低于前代,表明隐私保护有所改进。

对细节感兴趣的用户可参阅Gemma 3技术论文,全面了解模型能力和开发过程。

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

改变您的销售策略:由 Vapi 支持的人工智能冷呼叫技术

现代企业以闪电般的速度运作,需要创新的解决方案来保持竞争力。想象一下,使用人工智能驱动的冷呼叫系统,同时与数十个潜在客户进行接触,并全天候自主运行,从而彻底改变公司的外联工作。像 Vapi 这样的平台使这一转变成为可能,它使您能够构建可进行自然对话的定制拨号器,同时将您的团队解放出来从事高价值的工作。本综合指南揭示了如何实施尖端的人工智能呼叫技术,以实现大规模的个性化推广、显著提高潜在客户生成率,

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

创建教育信息图表的最佳人工智能工具 - 设计技巧与技术

在当今数字驱动的教育环境中,信息图表已成为一种变革性的交流媒介,它能将复杂的信息转换成具有视觉吸引力、易于理解的格式。人工智能技术正在彻底改变教育工作者制作这些可视化学习辅助工具的方式,使所有人都能获得专业级的设计,同时大幅缩短制作时间。本讲座将深入探讨 ChatGPT 等尖端人工智能解决方案,这些解决方案通过简化工作流程、创意自动化和智能设计辅助,使教师和内容创作者能够制作出引人入胜的教育信息图

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

Topaz DeNoise AI:2025 年最佳降噪工具 - 完整指南

在竞争激烈的数码摄影领域,图像清晰度仍然是最重要的。各种技术水平的摄影师都要面对数码噪点的问题,这些噪点影响了原本出色的拍摄效果。Topaz DeNoise AI 是一种先进的解决方案,它利用人工智能解决降噪问题,同时保留关键细节。本深度评论将探讨这款创新软件如何在 2025 年改变您的摄影工作流程,研究其主要功能、实际应用和工作流程集成。要点Topaz DeNoise AI 利用人工智能有效消除

2025-08-17 17:00:59

2025-08-17 17:00:59

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this'll shake up the AI startup scene. 🚀

0

0

2025-08-16 01:00:59

2025-08-16 01:00:59

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Curious how this stacks up in real-world apps! 😎

0

0

2025-08-13 21:00:59

2025-08-13 21:00:59

Google's Gemma 3 sounds like a game-changer! Achieving 98% of DeepSeek's accuracy with just one GPU is wild. Makes me wonder how this’ll shake up the AI race—more power to the little guys? 🤔

0

0

2025-08-05 09:00:59

2025-08-05 09:00:59

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's like getting a sports car for the price of a bike! 😎 Can't wait to see how this shakes up the AI race.

0

0

2025-08-01 14:08:50

2025-08-01 14:08:50

Google's Gemma 3 sounds like a game-changer! 98% of DeepSeek's accuracy with just one GPU? That's some serious efficiency. Can't wait to see how devs play with this open-source gem! 😎

0

0

2025-05-03 10:53:19

2025-05-03 10:53:19

Google's Gemma 3 is pretty impressive, hitting 98% accuracy with just one GPU! 🤯 It's like they're showing off, but in a good way. Makes me wonder if I should switch to Google's tech for my projects. Definitely worth a try, right?

0

0