COSAI 발사 : 창립 멤버는 Secure AI를 위해 연합합니다

AI의 급속한 성장에는 이를 따라갈 수 있는 강력한 보안 프레임워크와 표준이 필요합니다. 그래서 우리는 작년에 Secure AI Framework(SAIF)를 도입했으며, 이것이 시작에 불과하다는 것을 알았습니다. 산업 프레임워크가 작동하려면 팀워크와 협업할 장소가 필요합니다. 바로 그 지점에 우리가 있습니다.

아스펜 보안 포럼에서, 우리는 업계 동료들과 함께 Coalition for Secure AI(CoSAI)의 출범을 발표하게 되어 기쁩니다. 지난 1년 동안 우리는 이 연합을 구성하기 위해 열심히 노력해왔으며, AI가 현재와 미래에 가져오는 독특한 보안 과제를 해결하는 것을 목표로 하고 있습니다.

CoSAI의 창립 멤버로는 Amazon, Anthropic, Chainguard, Cisco, Cohere, GenLab, IBM, Intel, Microsoft, NVIDIA, OpenAI, PayPal, Wiz와 같은 큰 이름들이 포함됩니다. 우리는 국제 표준 및 오픈소스 그룹인 OASIS Open 아래에서 활동을 시작합니다.

CoSAI의 최초 워크스트림 소개

개별 개발자부터 대기업까지 모두가 공통 보안 표준과 모범 사례를 채택하기 위해 노력하는 가운데, CoSAI는 AI 보안에 대한 이러한 집단적 노력을 지원할 것입니다. 오늘 우리는 연합이 산업 및 학계와 손잡고 초점을 맞출 첫 세 가지 영역을 시작합니다:

- AI 시스템의 소프트웨어 공급망 보안: Google은 SLSA Provenance를 AI 모델로 확장하려고 노력해왔으며, AI 소프트웨어가 공급망을 통해 생성되고 처리되는 과정을 추적하여 안전한지 판단하는 데 도움을 줍니다. 이 워크스트림은 출처 확인, 제3자 모델의 위험 관리, 그리고 AI 및 전통 소프트웨어 모두에 대한 기존 SSDF 및 SLSA 보안 원칙을 기반으로 전체 AI 애플리케이션 출처를 평가하는 지침을 제공하여 AI 보안을 강화하는 것을 목표로 합니다.

- 변화하는 사이버 보안 환경에 대비한 방어자 준비: AI 거버넌스를 매일 다루는 것은 보안 담당자들에게 큰 골칫거리가 될 수 있습니다. 이 워크스트림은 방어자들이 투자할 곳을 파악하고 AI의 보안 영향을 해결하기 위해 사용할 완화 기법을 찾을 수 있도록 돕는 방어자 프레임워크를 만들 것입니다. 이 프레임워크는 AI 모델의 공격적 사이버 보안 발전과 함께 성장할 것입니다.

- AI 보안 거버넌스: AI 보안을 관리하려면 새로운 자원과 AI 보안의 독특함을 이해해야 합니다. CoSAI는 실무자들이 준비 상태를 평가하고, AI 제품의 보안을 관리, 모니터링, 보고할 수 있도록 위험 및 통제 목록, 체크리스트, 스코어카드를 개발할 것입니다.

또한, CoSAI는 Frontier Model Forum, Partnership on AI, Open Source Security Foundation, ML Commons와 같은 그룹들과 협력하여 책임 있는 AI를 추진할 것입니다.

다음 단계는?

AI가 계속 발전함에 따라, 우리는 위험 관리 전략이 그 속도를 따라갈 수 있도록 전념하고 있습니다. 지난 1년 동안 AI를 안전하고 안전하게 만들기 위한 업계의 큰 지지를 보았습니다. 더 나아가, 우리는 개발자, 전문가, 다양한 규모의 기업들이 조직이 AI를 안전하게 사용할 수 있도록 돕는 실제 행동을 보고 있습니다.

AI 개발자는 도전에 맞는 보안 프레임워크가 필요하며, 최종 사용자는 앞서 있는 기회를 책임감 있게 활용하는 프레임워크를 받을 자격이 있습니다. CoSAI는 이 여정의 다음 큰 단계이며, 곧 더 많은 업데이트가 있을 것입니다. CoSAI를 지원할 수 있는 방법을 알아보려면 coalitionforsecureai.org를 확인하세요. 그동안 Google의 AI 보안 작업에 대해 더 알아보려면 Secure AI Framework 페이지를 방문하세요.

관련 기사

이제 구글의 AI가 전화 통화를 대신 처리합니다.

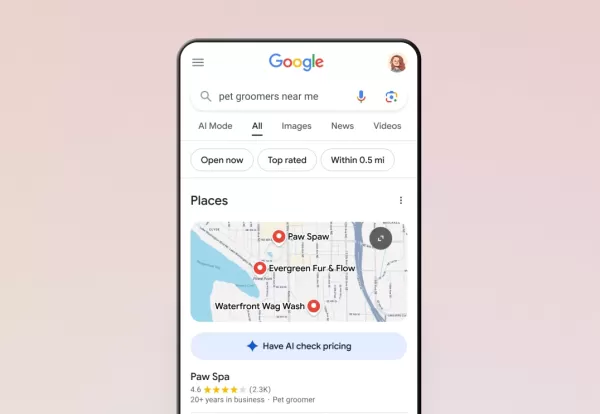

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

"닷 AI 컴패니언 앱, 폐쇄 발표, 개인화 서비스 중단"

금요일 개발자의 발표에 따르면 개인적인 친구이자 친구의 역할을 하도록 설계된 AI 컴패니언 애플리케이션인 Dot이 운영을 중단할 예정입니다. 닷을 개발한 스타트업인 뉴 컴퓨터는 웹사이트를 통해 10월 5일까지 서비스를 계속 이용할 수 있으며, 사용자들이 개인 데이터를 내보낼 수 있는 시간을 제공한다고 밝혔습니다.이 앱은 올해 초 공동 창업자인 샘 휘트모어와

"닷 AI 컴패니언 앱, 폐쇄 발표, 개인화 서비스 중단"

금요일 개발자의 발표에 따르면 개인적인 친구이자 친구의 역할을 하도록 설계된 AI 컴패니언 애플리케이션인 Dot이 운영을 중단할 예정입니다. 닷을 개발한 스타트업인 뉴 컴퓨터는 웹사이트를 통해 10월 5일까지 서비스를 계속 이용할 수 있으며, 사용자들이 개인 데이터를 내보낼 수 있는 시간을 제공한다고 밝혔습니다.이 앱은 올해 초 공동 창업자인 샘 휘트모어와

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

의견 (33)

0/200

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

의견 (33)

0/200

![JonathanRamirez]() JonathanRamirez

JonathanRamirez

2025년 8월 27일 오후 4시 1분 30초 GMT+09:00

2025년 8월 27일 오후 4시 1분 30초 GMT+09:00

Wow, CoSAI sounds like a game-changer for AI security! It's cool to see big players teaming up for SAIF. Curious how this'll shape AI ethics debates. 🤔

0

0

![BillyAdams]() BillyAdams

BillyAdams

2025년 8월 14일 오전 10시 0분 59초 GMT+09:00

2025년 8월 14일 오전 10시 0분 59초 GMT+09:00

This CoSAI initiative sounds promising! 😊 It's cool to see big players teaming up for AI security, but I wonder how they'll balance innovation with strict standards. Could be a game-changer if done right!

0

0

![RobertMartinez]() RobertMartinez

RobertMartinez

2025년 7월 23일 오후 1시 59분 47초 GMT+09:00

2025년 7월 23일 오후 1시 59분 47초 GMT+09:00

Wow, CoSAI sounds like a game-changer! Finally, some serious teamwork to lock down AI security. I’m curious how SAIF will evolve with all these big players collaborating. 🛡️

0

0

![GaryWilson]() GaryWilson

GaryWilson

2025년 4월 24일 오후 7시 18분 4초 GMT+09:00

2025년 4월 24일 오후 7시 18분 4초 GMT+09:00

CoSAI의 런치는 AI 보안에 큰 진전입니다. 많은 창립 멤버들이 함께하는 것을 보는 것이 좋습니다. 프레임워크는 견고해 보이지만, 아직 어떻게 작동하는지 잘 모르겠어요. 더 명확한 가이드가 있으면 좋겠어요! 🤔

0

0

![AnthonyJohnson]() AnthonyJohnson

AnthonyJohnson

2025년 4월 24일 오후 3시 42분 2초 GMT+09:00

2025년 4월 24일 오후 3시 42분 2초 GMT+09:00

El lanzamiento de CoSAI es un gran paso adelante para la seguridad en IA. Es genial ver a tantos miembros fundadores unidos. El marco parece sólido, pero aún estoy un poco confundido sobre cómo funciona todo. ¡Guías más claras serían útiles! 🤔

0

0

![FredLewis]() FredLewis

FredLewis

2025년 4월 24일 오전 1시 23분 37초 GMT+09:00

2025년 4월 24일 오전 1시 23분 37초 GMT+09:00

CoSAI's launch is a big step forward for AI security. It's great to see so many founding members coming together. The framework seems solid, but I'm still a bit confused about how it all works. More clear guides would be helpful! 🤔

0

0

AI의 급속한 성장에는 이를 따라갈 수 있는 강력한 보안 프레임워크와 표준이 필요합니다. 그래서 우리는 작년에 Secure AI Framework(SAIF)를 도입했으며, 이것이 시작에 불과하다는 것을 알았습니다. 산업 프레임워크가 작동하려면 팀워크와 협업할 장소가 필요합니다. 바로 그 지점에 우리가 있습니다.

아스펜 보안 포럼에서, 우리는 업계 동료들과 함께 Coalition for Secure AI(CoSAI)의 출범을 발표하게 되어 기쁩니다. 지난 1년 동안 우리는 이 연합을 구성하기 위해 열심히 노력해왔으며, AI가 현재와 미래에 가져오는 독특한 보안 과제를 해결하는 것을 목표로 하고 있습니다.

CoSAI의 창립 멤버로는 Amazon, Anthropic, Chainguard, Cisco, Cohere, GenLab, IBM, Intel, Microsoft, NVIDIA, OpenAI, PayPal, Wiz와 같은 큰 이름들이 포함됩니다. 우리는 국제 표준 및 오픈소스 그룹인 OASIS Open 아래에서 활동을 시작합니다.

CoSAI의 최초 워크스트림 소개

개별 개발자부터 대기업까지 모두가 공통 보안 표준과 모범 사례를 채택하기 위해 노력하는 가운데, CoSAI는 AI 보안에 대한 이러한 집단적 노력을 지원할 것입니다. 오늘 우리는 연합이 산업 및 학계와 손잡고 초점을 맞출 첫 세 가지 영역을 시작합니다:

- AI 시스템의 소프트웨어 공급망 보안: Google은 SLSA Provenance를 AI 모델로 확장하려고 노력해왔으며, AI 소프트웨어가 공급망을 통해 생성되고 처리되는 과정을 추적하여 안전한지 판단하는 데 도움을 줍니다. 이 워크스트림은 출처 확인, 제3자 모델의 위험 관리, 그리고 AI 및 전통 소프트웨어 모두에 대한 기존 SSDF 및 SLSA 보안 원칙을 기반으로 전체 AI 애플리케이션 출처를 평가하는 지침을 제공하여 AI 보안을 강화하는 것을 목표로 합니다.

- 변화하는 사이버 보안 환경에 대비한 방어자 준비: AI 거버넌스를 매일 다루는 것은 보안 담당자들에게 큰 골칫거리가 될 수 있습니다. 이 워크스트림은 방어자들이 투자할 곳을 파악하고 AI의 보안 영향을 해결하기 위해 사용할 완화 기법을 찾을 수 있도록 돕는 방어자 프레임워크를 만들 것입니다. 이 프레임워크는 AI 모델의 공격적 사이버 보안 발전과 함께 성장할 것입니다.

- AI 보안 거버넌스: AI 보안을 관리하려면 새로운 자원과 AI 보안의 독특함을 이해해야 합니다. CoSAI는 실무자들이 준비 상태를 평가하고, AI 제품의 보안을 관리, 모니터링, 보고할 수 있도록 위험 및 통제 목록, 체크리스트, 스코어카드를 개발할 것입니다.

또한, CoSAI는 Frontier Model Forum, Partnership on AI, Open Source Security Foundation, ML Commons와 같은 그룹들과 협력하여 책임 있는 AI를 추진할 것입니다.

다음 단계는?

AI가 계속 발전함에 따라, 우리는 위험 관리 전략이 그 속도를 따라갈 수 있도록 전념하고 있습니다. 지난 1년 동안 AI를 안전하고 안전하게 만들기 위한 업계의 큰 지지를 보았습니다. 더 나아가, 우리는 개발자, 전문가, 다양한 규모의 기업들이 조직이 AI를 안전하게 사용할 수 있도록 돕는 실제 행동을 보고 있습니다.

AI 개발자는 도전에 맞는 보안 프레임워크가 필요하며, 최종 사용자는 앞서 있는 기회를 책임감 있게 활용하는 프레임워크를 받을 자격이 있습니다. CoSAI는 이 여정의 다음 큰 단계이며, 곧 더 많은 업데이트가 있을 것입니다. CoSAI를 지원할 수 있는 방법을 알아보려면 coalitionforsecureai.org를 확인하세요. 그동안 Google의 AI 보안 작업에 대해 더 알아보려면 Secure AI Framework 페이지를 방문하세요.

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

이제 구글의 AI가 전화 통화를 대신 처리합니다.

Google은 검색을 통해 모든 미국 사용자에게 AI 통화 기능을 확대하여 고객이 전화 통화 없이도 현지 비즈니스에 가격 및 이용 가능 여부를 문의할 수 있도록 했습니다. 1월에 처음 테스트된 이 기능은 현재 애완동물 미용사, 세탁 서비스, 자동차 수리점 등 서비스 중심 비즈니스를 지원합니다.검색자는 적격 업체 목록 아래에 'AI에게 가격 확인' 옵션이 표

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

앤트로픽, AI로 생성된 도서 불법 복제에 대한 법적 소송 해결

앤트로픽은 미국 작가들과의 저작권 분쟁에서 잠재적으로 비용이 많이 드는 재판을 피할 수 있는 집단 소송 합의안에 동의하며 합의에 도달했습니다. 이번 화요일에 법원 문서로 제출된 이 합의는 AI 회사가 불법 복제된 문학 작품을 사용하여 클로드 모델을 훈련시켰다는 주장에서 비롯되었습니다.합의 세부 사항은 기밀로 유지되지만, 이 사건은 저자 Andrea Bart

2025년 8월 27일 오후 4시 1분 30초 GMT+09:00

2025년 8월 27일 오후 4시 1분 30초 GMT+09:00

Wow, CoSAI sounds like a game-changer for AI security! It's cool to see big players teaming up for SAIF. Curious how this'll shape AI ethics debates. 🤔

0

0

2025년 8월 14일 오전 10시 0분 59초 GMT+09:00

2025년 8월 14일 오전 10시 0분 59초 GMT+09:00

This CoSAI initiative sounds promising! 😊 It's cool to see big players teaming up for AI security, but I wonder how they'll balance innovation with strict standards. Could be a game-changer if done right!

0

0

2025년 7월 23일 오후 1시 59분 47초 GMT+09:00

2025년 7월 23일 오후 1시 59분 47초 GMT+09:00

Wow, CoSAI sounds like a game-changer! Finally, some serious teamwork to lock down AI security. I’m curious how SAIF will evolve with all these big players collaborating. 🛡️

0

0

2025년 4월 24일 오후 7시 18분 4초 GMT+09:00

2025년 4월 24일 오후 7시 18분 4초 GMT+09:00

CoSAI의 런치는 AI 보안에 큰 진전입니다. 많은 창립 멤버들이 함께하는 것을 보는 것이 좋습니다. 프레임워크는 견고해 보이지만, 아직 어떻게 작동하는지 잘 모르겠어요. 더 명확한 가이드가 있으면 좋겠어요! 🤔

0

0

2025년 4월 24일 오후 3시 42분 2초 GMT+09:00

2025년 4월 24일 오후 3시 42분 2초 GMT+09:00

El lanzamiento de CoSAI es un gran paso adelante para la seguridad en IA. Es genial ver a tantos miembros fundadores unidos. El marco parece sólido, pero aún estoy un poco confundido sobre cómo funciona todo. ¡Guías más claras serían útiles! 🤔

0

0

2025년 4월 24일 오전 1시 23분 37초 GMT+09:00

2025년 4월 24일 오전 1시 23분 37초 GMT+09:00

CoSAI's launch is a big step forward for AI security. It's great to see so many founding members coming together. The framework seems solid, but I'm still a bit confused about how it all works. More clear guides would be helpful! 🤔

0

0