YouTube 비디오 용 AI 구동 Q & A 시스템을 구축하십시오

유튜브 동영상을 몇 시간 동안 힘들게 살펴보며, 끝없는 오디오 스트림 속에 숨겨진 지혜의 조각을 찾은 적이 있나요? 이런 상황을 상상해보세요: 여러 튜토리얼 영상을 재생하며 클릭을 반복하면서, 필요한 그 한 가지 중요한 정보를 우연히 발견하기를 바라는 모습. 이제, 모든 콘텐츠를 즉시 훑어보고, 필요한 정보를 정확히 추출하며, 손가락 하나 까딱하는 것만으로 특정 질문에 대한 답을 얻을 수 있는 세상을 상상해보세요. 이 글에서는 최신 AI 도구를 사용해 유튜브 동영상용 Q&A 시스템을 만드는 방법을 보여줍니다. Chroma, LangChain, 그리고 OpenAI의 Whisper를 결합하면, 몇 시간 분량의 오디오를 실행 가능한 통찰로 바꿀 수 있습니다. 긴 강의를 요약하거나 중요한 순간의 정확한 타임스탬프를 찾는 것부터, 이 시스템은 당신이 동영상 콘텐츠를 소비하는 방식을 영원히 바꿀 수 있습니다.

AI 도구, 코딩 팁에 대한 궁금한 질문이 있거나, 그냥 열정을 공유할 공간이 필요하다면? Discord 커뮤니티에 가입하세요—같은 관심사를 가진 사람들과 연결하기에 완벽한 장소입니다!

유튜브 동영상용 Q&A 시스템 구축하기

시작하기 전에, 왜 이것이 시간을 투자할 가치가 있는지 이야기해보겠습니다. 오늘날의 빠르게 변화하는 디지털 세상에서, 사람들은 끊임없이 정보의 홍수에 시달립니다. 복잡한 개념을 익히려는 학생이든, 최신 트렌드를 따라가려는 전문가든, 긴 유튜브 동영상에서 효율적으로 지식을 추출하는 것은 필수적입니다. Q&A 시스템은 몇 시간 분량의 콘텐츠를 소화 가능한 요약으로 압축해, 필요한 정보를 정확히 찾아내도록 도와줍니다. 좋아하는 동영상을 모든 궁금증을 해결해주는 치트 시트로 바꾸는 것이라고 생각하세요.

작동 방식은 다음과 같습니다: “벡터 데이터베이스와 관계형 데이터베이스의 차이점은 무엇인가요?”라고 묻는다고 상상해보세요. 동영상을 몇 시간 동안 시청하는 대신, 시스템은 관련 섹션을 찾아내 답을 제공하고, 정확한 타임스탬프까지 알려줍니다. 더 이상 목적 없이 스크롤하며 시간을 낭비할 필요가 없습니다—순수하고 집중된 학습만 가능해집니다. 게다가, 이는 학문적 용도에만 국한되지 않습니다. 비즈니스 통화, 팟캐스트 에피소드, 또는 기타 오디오 콘텐츠를 분석하려는 누구에게나 똑같이 유용합니다.

핵심 구성 요소: Chroma, LangChain, 그리고 OpenAI의 Whisper

이 Q&A 시스템을 구축하려면, 서로 손을 맞잡고 작동하는 세 가지 강력한 도구에 의존하게 됩니다:

Chroma

Chroma는 벡터 저장소에서 당신의 믿음직한 조수입니다. 텍스트 데이터를 검색 가능한 벡터로 정리하는 매우 똑똑한 파일 캐비닛이라고 생각하세요. 왜 이것이 중요한가요? 페이지 단위의 텍스트를 헤매는 대신, Chroma는 번개처럼 빠른 유사성 검색을 가능하게 합니다. 질문을 하면, Chroma는 당신의 질문을 동영상 대본의 가장 관련 있는 부분과 빠르게 매칭합니다. Chroma의 효율성은 대본과 같은 대규모 데이터셋을 처리하는 데 이상적이며, 답변을 순식간에 얻을 수 있도록 보장합니다.

LangChain

LangChain은 작업의 두뇌 역할을 합니다. 대본을 가져오는 것부터 답변을 생성하는 것까지 모든 것을 조율하는 지휘자입니다. 모듈식 설계로, LangChain은 다양한 AI 구성 요소를 원활하게 연결해 조화롭게 작동하도록 합니다. 예를 들어, 여러 상호작용에서 맥락을 유지해 대화가 자연스럽게 흐르도록 관리합니다. LangChain의 유연성은 간결한 요약이나 자세한 설명을 원하는지에 따라 시스템을 조정할 수 있게 해줍니다.

OpenAI의 Whisper

오디오를 텍스트로 변환할 때, Whisper는 최고입니다. 이 오픈소스 도구는 미묘한 억양부터 시끄러운 환경까지 모든 것을 처리하며, 음성을 텍스트로 변환하는 데 탁월합니다. 그 신뢰성은 생성된 텍스트가 가능한 한 정확하도록 보장해, 효과적인 분석의 기반을 제공합니다. Whisper가 없다면, 시스템은 원시 오디오 데이터를 해석하는 데 어려움을 겪을 것입니다.

당신의 Q&A 시스템 구축을 위한 단계별 가이드

소매를 걷어붙이고 멋진 것을 만들 준비가 되셨나요? 다음 단계를 따라 개인화된 유튜브 Q&A 시스템을 만들어 보세요:

1단계: 필요한 라이브러리 설치

필요한 라이브러리를 설치하는 것부터 시작하세요. 각 라이브러리는 프로세스에서 중요한 역할을 합니다:

- whisper: 오디오를 텍스트로 변환합니다.

- pytube: 유튜브 동영상을 다운로드합니다.

- langchain: Q&A 로직을 처리합니다.

- chromadb: 효율적인 검색을 위해 임베딩을 저장합니다.

- openai: OpenAI의 모델과 상호작용합니다.

터미널에서 다음 명령어를 실행하세요:

textpip install git+https://github.com/openai/whisper.git

pip install pytube

pip install langchain

pip install chromadb

pip install openai각 라이브러리가 올바르게 설치되었는지 확인한 후 다음 단계로 진행하세요.

2단계: 필요한 모듈 가져오기

라이브러리가 설치되면, 스크립트에 이를 가져옵니다:

textimport whisper

import torch

import os

from pytube import YouTube

from langchain.text_splitter import CharacterTextSplitter

from langchain.document_loaders import DataFrameLoader

from langchain.vectorstores import Chroma

from langchain.chains import RetrievalQAWithSourcesChain

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.llms import OpenAI

import pandas as pd이 모듈들은 필요한 모든 기능을 제공합니다.

3단계: 장치 설정 및 Whisper 모델 로드

GPU를 사용할지(사용 가능한 경우) 아니면 CPU를 사용할지 결정하세요:

textdevice = "cuda" if torch.cuda.is_available() else "cpu"

whisper_model = whisper.load_model("large", device=device)하드웨어에 따라 적절한 모델 크기를 선택하세요. 더 큰 모델은 더 높은 정확도를 제공하지만 더 많은 리소스가 필요합니다.

4단계: 유튜브 동영상에서 오디오 추출

오디오를 다운로드하고 저장하는 함수를 만드세요:

textdef extract_and_save_audio(video_url, destination, final_filename):

video = YouTube(video_url)

audio = video.streams.filter(only_audio=True).first()

output_path = audio.download(output_path=destination)

ext = os.path.splitext(output_path)[1]

new_file = final_filename + '.mp3'

os.rename(output_path, new_file)

return new_file이 함수는 유튜브 동영상에서 오디오 스트림을 가져와 MP3 파일로 저장합니다. 정확한 전사를 위해 깨끗한 오디오가 중요합니다.

5단계: 오디오 전사 및 조각으로 나누기

Whisper를 사용해 오디오를 전사하세요:

textaudio_file = 'geek_avenue.mp3'

result = whisper_model.transcribe(audio_file)

transcription = pd.DataFrame(result['segments'])이제 전사를 관리 가능한 조각으로 나눕니다:

textdef chunk_clips(transcription, clip_size):

texts = []

sources = []

for i in range(0, len(transcription), clip_size):

clip_df = transcription.iloc[i:i + clip_size]

text = '. '.join(clip_df['text'].to_list())

sources.append(text)

text = '. '.join(clip_df['text'].to_list())

source = str(round(clip_df.iloc[0]['start'] / 60, 2)) + "--" + str(round(clip_df.iloc[-1]['end'] / 60, 2)) + " 분"

texts.append(text)

sources.append(source)

return texts, sourcestexts, sources = chunk_clips(transcription, clip_size=4)

조각으로 나누는 것은 시스템이 토큰 제한에 걸리지 않도록 하고 관리를 용이하게 합니다.

6단계: 임베딩 생성 및 Chroma 설정

텍스트 조각에 대한 임베딩을 생성하세요:

textembeddings = OpenAIEmbeddings()

df = pd.DataFrame({'text': texts, 'sources': sources})

document_loader = DataFrameLoader(df, page_content_column="text")

documents = document_loader.load()이 문서들로 Chroma를 초기화하세요:

textvectorstore = Chroma.from_documents(documents=documents, embedding=embeddings, persist_directory="./chroma_db")

vectorstore.persist()이렇게 하면 Chroma가 임베딩된 텍스트 조각을 저장하는 로컬 데이터베이스가 설정됩니다.

7단계: Q&A 체인 구축

LangChain으로 모든 것을 결합하세요:

textchain = RetrievalQAWithSourcesChain.from_chain_type(

llm=OpenAI(temperature=0.5),

chain_type="stuff",

retriever=vectorstore.as_retriever()

)이 체인은 언어 모델과 검색기를 결합해 효과적으로 질문을 가져오고 답변합니다.

8단계: 시스템 테스트

샘플 쿼리로 Q&A 시스템을 테스트해보세요

관련 기사

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

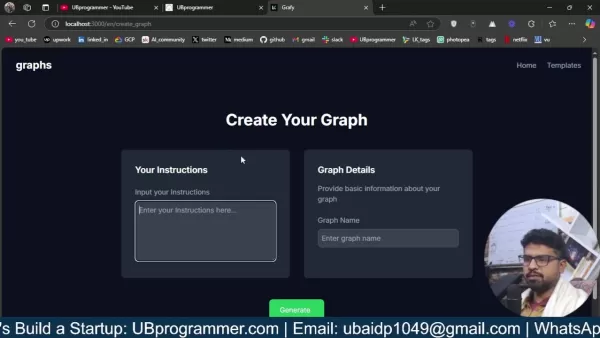

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

의견 (5)

0/200

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

의견 (5)

0/200

![JoseAdams]() JoseAdams

JoseAdams

2025년 6월 5일 오전 3시 52분 25초 GMT+09:00

2025년 6월 5일 오전 3시 52분 25초 GMT+09:00

Un système de Q&A par IA pour YouTube ? Génial ! Fini les heures à chercher une info précise. Hâte de voir ça en action ! 😊

0

0

![GregoryClark]() GregoryClark

GregoryClark

2025년 6월 4일 오후 2시 22분 17초 GMT+09:00

2025년 6월 4일 오후 2시 22분 17초 GMT+09:00

Классная идея с ИИ для YouTube! Теперь не придется часами искать нужный момент в видео. Надеюсь, оно справится с длинными лекциями! 🚀

0

0

![WalterWalker]() WalterWalker

WalterWalker

2025년 6월 4일 오전 11시 11분 19초 GMT+09:00

2025년 6월 4일 오전 11시 11분 19초 GMT+09:00

YouTubeの動画から欲しい情報だけ取れるなんて、めっちゃ便利そう!AIの進化に驚きしかないね😲

0

0

![JohnHernández]() JohnHernández

JohnHernández

2025년 6월 3일 오전 8시 24분 29초 GMT+09:00

2025년 6월 3일 오전 8시 24분 29초 GMT+09:00

This AI Q&A system for YouTube sounds like a game-changer! No more skipping through endless videos to find what I need. Excited to try it out! 😎

0

0

유튜브 동영상을 몇 시간 동안 힘들게 살펴보며, 끝없는 오디오 스트림 속에 숨겨진 지혜의 조각을 찾은 적이 있나요? 이런 상황을 상상해보세요: 여러 튜토리얼 영상을 재생하며 클릭을 반복하면서, 필요한 그 한 가지 중요한 정보를 우연히 발견하기를 바라는 모습. 이제, 모든 콘텐츠를 즉시 훑어보고, 필요한 정보를 정확히 추출하며, 손가락 하나 까딱하는 것만으로 특정 질문에 대한 답을 얻을 수 있는 세상을 상상해보세요. 이 글에서는 최신 AI 도구를 사용해 유튜브 동영상용 Q&A 시스템을 만드는 방법을 보여줍니다. Chroma, LangChain, 그리고 OpenAI의 Whisper를 결합하면, 몇 시간 분량의 오디오를 실행 가능한 통찰로 바꿀 수 있습니다. 긴 강의를 요약하거나 중요한 순간의 정확한 타임스탬프를 찾는 것부터, 이 시스템은 당신이 동영상 콘텐츠를 소비하는 방식을 영원히 바꿀 수 있습니다.

AI 도구, 코딩 팁에 대한 궁금한 질문이 있거나, 그냥 열정을 공유할 공간이 필요하다면? Discord 커뮤니티에 가입하세요—같은 관심사를 가진 사람들과 연결하기에 완벽한 장소입니다!

유튜브 동영상용 Q&A 시스템 구축하기

시작하기 전에, 왜 이것이 시간을 투자할 가치가 있는지 이야기해보겠습니다. 오늘날의 빠르게 변화하는 디지털 세상에서, 사람들은 끊임없이 정보의 홍수에 시달립니다. 복잡한 개념을 익히려는 학생이든, 최신 트렌드를 따라가려는 전문가든, 긴 유튜브 동영상에서 효율적으로 지식을 추출하는 것은 필수적입니다. Q&A 시스템은 몇 시간 분량의 콘텐츠를 소화 가능한 요약으로 압축해, 필요한 정보를 정확히 찾아내도록 도와줍니다. 좋아하는 동영상을 모든 궁금증을 해결해주는 치트 시트로 바꾸는 것이라고 생각하세요.

작동 방식은 다음과 같습니다: “벡터 데이터베이스와 관계형 데이터베이스의 차이점은 무엇인가요?”라고 묻는다고 상상해보세요. 동영상을 몇 시간 동안 시청하는 대신, 시스템은 관련 섹션을 찾아내 답을 제공하고, 정확한 타임스탬프까지 알려줍니다. 더 이상 목적 없이 스크롤하며 시간을 낭비할 필요가 없습니다—순수하고 집중된 학습만 가능해집니다. 게다가, 이는 학문적 용도에만 국한되지 않습니다. 비즈니스 통화, 팟캐스트 에피소드, 또는 기타 오디오 콘텐츠를 분석하려는 누구에게나 똑같이 유용합니다.

핵심 구성 요소: Chroma, LangChain, 그리고 OpenAI의 Whisper

이 Q&A 시스템을 구축하려면, 서로 손을 맞잡고 작동하는 세 가지 강력한 도구에 의존하게 됩니다:

Chroma

Chroma는 벡터 저장소에서 당신의 믿음직한 조수입니다. 텍스트 데이터를 검색 가능한 벡터로 정리하는 매우 똑똑한 파일 캐비닛이라고 생각하세요. 왜 이것이 중요한가요? 페이지 단위의 텍스트를 헤매는 대신, Chroma는 번개처럼 빠른 유사성 검색을 가능하게 합니다. 질문을 하면, Chroma는 당신의 질문을 동영상 대본의 가장 관련 있는 부분과 빠르게 매칭합니다. Chroma의 효율성은 대본과 같은 대규모 데이터셋을 처리하는 데 이상적이며, 답변을 순식간에 얻을 수 있도록 보장합니다.

LangChain

LangChain은 작업의 두뇌 역할을 합니다. 대본을 가져오는 것부터 답변을 생성하는 것까지 모든 것을 조율하는 지휘자입니다. 모듈식 설계로, LangChain은 다양한 AI 구성 요소를 원활하게 연결해 조화롭게 작동하도록 합니다. 예를 들어, 여러 상호작용에서 맥락을 유지해 대화가 자연스럽게 흐르도록 관리합니다. LangChain의 유연성은 간결한 요약이나 자세한 설명을 원하는지에 따라 시스템을 조정할 수 있게 해줍니다.

OpenAI의 Whisper

오디오를 텍스트로 변환할 때, Whisper는 최고입니다. 이 오픈소스 도구는 미묘한 억양부터 시끄러운 환경까지 모든 것을 처리하며, 음성을 텍스트로 변환하는 데 탁월합니다. 그 신뢰성은 생성된 텍스트가 가능한 한 정확하도록 보장해, 효과적인 분석의 기반을 제공합니다. Whisper가 없다면, 시스템은 원시 오디오 데이터를 해석하는 데 어려움을 겪을 것입니다.

당신의 Q&A 시스템 구축을 위한 단계별 가이드

소매를 걷어붙이고 멋진 것을 만들 준비가 되셨나요? 다음 단계를 따라 개인화된 유튜브 Q&A 시스템을 만들어 보세요:

1단계: 필요한 라이브러리 설치

필요한 라이브러리를 설치하는 것부터 시작하세요. 각 라이브러리는 프로세스에서 중요한 역할을 합니다:

- whisper: 오디오를 텍스트로 변환합니다.

- pytube: 유튜브 동영상을 다운로드합니다.

- langchain: Q&A 로직을 처리합니다.

- chromadb: 효율적인 검색을 위해 임베딩을 저장합니다.

- openai: OpenAI의 모델과 상호작용합니다.

터미널에서 다음 명령어를 실행하세요:

pip install git+https://github.com/openai/whisper.git

pip install pytube

pip install langchain

pip install chromadb

pip install openai각 라이브러리가 올바르게 설치되었는지 확인한 후 다음 단계로 진행하세요.

2단계: 필요한 모듈 가져오기

라이브러리가 설치되면, 스크립트에 이를 가져옵니다:

import whisper

import torch

import os

from pytube import YouTube

from langchain.text_splitter import CharacterTextSplitter

from langchain.document_loaders import DataFrameLoader

from langchain.vectorstores import Chroma

from langchain.chains import RetrievalQAWithSourcesChain

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.llms import OpenAI

import pandas as pd이 모듈들은 필요한 모든 기능을 제공합니다.

3단계: 장치 설정 및 Whisper 모델 로드

GPU를 사용할지(사용 가능한 경우) 아니면 CPU를 사용할지 결정하세요:

device = "cuda" if torch.cuda.is_available() else "cpu"

whisper_model = whisper.load_model("large", device=device)하드웨어에 따라 적절한 모델 크기를 선택하세요. 더 큰 모델은 더 높은 정확도를 제공하지만 더 많은 리소스가 필요합니다.

4단계: 유튜브 동영상에서 오디오 추출

오디오를 다운로드하고 저장하는 함수를 만드세요:

def extract_and_save_audio(video_url, destination, final_filename):

video = YouTube(video_url)

audio = video.streams.filter(only_audio=True).first()

output_path = audio.download(output_path=destination)

ext = os.path.splitext(output_path)[1]

new_file = final_filename + '.mp3'

os.rename(output_path, new_file)

return new_file이 함수는 유튜브 동영상에서 오디오 스트림을 가져와 MP3 파일로 저장합니다. 정확한 전사를 위해 깨끗한 오디오가 중요합니다.

5단계: 오디오 전사 및 조각으로 나누기

Whisper를 사용해 오디오를 전사하세요:

audio_file = 'geek_avenue.mp3'

result = whisper_model.transcribe(audio_file)

transcription = pd.DataFrame(result['segments'])이제 전사를 관리 가능한 조각으로 나눕니다:

def chunk_clips(transcription, clip_size):

texts = []

sources = []

for i in range(0, len(transcription), clip_size):

clip_df = transcription.iloc[i:i + clip_size]

text = '. '.join(clip_df['text'].to_list())

sources.append(text)

text = '. '.join(clip_df['text'].to_list())

source = str(round(clip_df.iloc[0]['start'] / 60, 2)) + "--" + str(round(clip_df.iloc[-1]['end'] / 60, 2)) + " 분"

texts.append(text)

sources.append(source)

return texts, sourcestexts, sources = chunk_clips(transcription, clip_size=4)

조각으로 나누는 것은 시스템이 토큰 제한에 걸리지 않도록 하고 관리를 용이하게 합니다.

6단계: 임베딩 생성 및 Chroma 설정

텍스트 조각에 대한 임베딩을 생성하세요:

embeddings = OpenAIEmbeddings()

df = pd.DataFrame({'text': texts, 'sources': sources})

document_loader = DataFrameLoader(df, page_content_column="text")

documents = document_loader.load()이 문서들로 Chroma를 초기화하세요:

vectorstore = Chroma.from_documents(documents=documents, embedding=embeddings, persist_directory="./chroma_db")

vectorstore.persist()이렇게 하면 Chroma가 임베딩된 텍스트 조각을 저장하는 로컬 데이터베이스가 설정됩니다.

7단계: Q&A 체인 구축

LangChain으로 모든 것을 결합하세요:

chain = RetrievalQAWithSourcesChain.from_chain_type(

llm=OpenAI(temperature=0.5),

chain_type="stuff",

retriever=vectorstore.as_retriever()

)이 체인은 언어 모델과 검색기를 결합해 효과적으로 질문을 가져오고 답변합니다.

8단계: 시스템 테스트

샘플 쿼리로 Q&A 시스템을 테스트해보세요

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

영업 전략을 혁신하세요: Vapi 기반의 AI 콜드 콜 기술

현대의 비즈니스는 빠른 속도로 운영되며 경쟁력을 유지하기 위해 혁신적인 솔루션을 요구합니다. 연중무휴 24시간 자율적으로 운영되는 AI 기반 콜드 콜 시스템을 통해 수십 명의 잠재 고객과 동시에 소통하며 대행사의 홍보 활동을 혁신하는 모습을 상상해 보세요. Vapi와 같은 플랫폼은 이러한 혁신을 가능하게 하여 자연스러운 대화를 수행하는 맞춤형 다이얼러를 구

2025년 6월 5일 오전 3시 52분 25초 GMT+09:00

2025년 6월 5일 오전 3시 52분 25초 GMT+09:00

Un système de Q&A par IA pour YouTube ? Génial ! Fini les heures à chercher une info précise. Hâte de voir ça en action ! 😊

0

0

2025년 6월 4일 오후 2시 22분 17초 GMT+09:00

2025년 6월 4일 오후 2시 22분 17초 GMT+09:00

Классная идея с ИИ для YouTube! Теперь не придется часами искать нужный момент в видео. Надеюсь, оно справится с длинными лекциями! 🚀

0

0

2025년 6월 4일 오전 11시 11분 19초 GMT+09:00

2025년 6월 4일 오전 11시 11분 19초 GMT+09:00

YouTubeの動画から欲しい情報だけ取れるなんて、めっちゃ便利そう!AIの進化に驚きしかないね😲

0

0

2025년 6월 3일 오전 8시 24분 29초 GMT+09:00

2025년 6월 3일 오전 8시 24분 29초 GMT+09:00

This AI Q&A system for YouTube sounds like a game-changer! No more skipping through endless videos to find what I need. Excited to try it out! 😎

0

0