为YouTube视频构建AI驱动的问答系统

你是否曾花费数小时浏览YouTube视频,试图在无尽的音频流中寻找智慧的珍珠?想象一下:你坐在那里,一个接一个地点击播放教程视频,希望能偶然发现你所需的关键信息。现在,想象一个世界,你可以瞬间浏览所有内容,提取你需要的部分,甚至能针对特定问题得到答案——只需轻轻一挥手指。本文将向你展示如何使用最新的AI工具为YouTube视频构建你自己的问答系统。通过结合Chroma、LangChain和OpenAI的Whisper,你可以将数小时的音频转化为可操作的见解。从总结长篇讲座到找到关键时刻的精确时间戳,这个系统将彻底改变你消费视频内容的方式。

对AI工具、编程技巧有迫切问题,或者只是需要一个可以尽情探讨的空间?加入我们的Discord社区——这是与志同道合的人连接的完美场所!

为YouTube视频构建问答系统

在深入之前,我们先谈谈为什么这值得你花时间。在当今快节奏的数字世界,人们不断被信息轰炸。无论你是试图掌握复杂概念的学生,还是渴望保持领先的专业人士,高效地从冗长的YouTube视频中提取知识至关重要。问答系统通过将数小时的内容浓缩为易于消化的摘要,让你能够精准定位所需信息。把它想象成将你喜爱的视频变成一张能回答所有迫切问题的备忘单。

它的工作原理是这样的:想象你提问,“向量数据库和关系数据库有什么区别?”系统无需你花费数小时观看视频,就能提取相关片段,给你答案,甚至告诉你精确的时间戳。不再浪费时间漫无目的地滑动——只有纯粹、专注的学习。此外,这不仅限于学术用途;对于分析商业通话、播客片段或任何其他形式的音频内容同样有用。

核心组件:Chroma、LangChain和OpenAI的Whisper

要构建这个问答系统,你将依赖三个协同工作的强大工具:

Chroma

Chroma是向量存储的可靠助手。把它想象成一个超级智能的文件柜,将文本数据组织成可搜索的向量。为什么这很重要?因为Chroma让你无需翻阅大量文本,就能进行闪电般的相似性搜索。当你提问时,它会快速将你的问题与视频转录中最相关的部分匹配。Chroma的高效使其非常适合处理大型数据集,如转录文本,确保你能迅速得到答案。

LangChain

LangChain是整个操作的大脑。它像指挥家一样协调一切——从提取转录到生成答案。凭借其模块化设计,LangChain无缝连接不同的AI组件,确保它们和谐协作。例如,它负责保持多次交互的上下文,让对话自然流畅。LangChain的灵活性意味着你可以根据需求调整系统,无论是追求简洁的摘要还是详细的解释。

OpenAI的Whisper

在将音频转化为文本方面,Whisper是王者。这款开源工具擅长将口语转化为书面形式,处理从细微口音到嘈杂环境的一切。其可靠性确保生成的文本尽可能准确,为有效分析奠定基础。没有Whisper,系统将难以解读原始音频数据。

构建问答系统的分步指南

准备好卷起袖子打造一个很棒的东西了吗?按照以下步骤创建你的个性化YouTube问答系统:

步骤1:安装所需库

首先安装必要的库。每个库在流程中都扮演着重要角色:

- whisper:将音频转化为文本。

- pytube:下载YouTube视频。

- langchain:处理问答逻辑。

- chromadb:存储嵌入以实现高效搜索。

- openai:与OpenAI的模型交互。

在终端运行以下命令:

textpip install git+https://github.com/openai/whisper.git

pip install pytube

pip install langchain

pip install chromadb

pip install openai确保每个库正确安装后再继续。

步骤2:导入必要模块

安装好库后,将它们导入你的脚本:

textimport whisper

import torch

import os

from pytube import YouTube

from langchain.text_splitter import CharacterTextSplitter

from langchain.document_loaders import DataFrameLoader

from langchain.vectorstores import Chroma

from langchain.chains import RetrievalQAWithSourcesChain

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.llms import OpenAI

import pandas as pd这些模块为所需功能提供了支持。

步骤3:配置设备并加载Whisper模型

决定是使用GPU(如果可用)还是CPU:

textdevice = "cuda" if torch.cuda.is_available() else "cpu"

whisper_model = whisper.load_model("large", device=device)选择合适的模型大小取决于你的硬件。较大的模型提供更高准确性,但需要更多资源。

步骤4:从YouTube视频提取音频

创建一个函数来下载并保存音频:

textdef extract_and_save_audio(video_url, destination, final_filename):

video = YouTube(video_url)

audio = video.streams.filter(only_audio=True).first()

output_path = audio.download(output_path=destination)

ext = os.path.splitext(output_path)[1]

new_file = final_filename + '.mp3'

os.rename(output_path, new_file)

return new_file此函数从YouTube视频中提取音频流并保存为MP3文件。干净的音频对于准确转录至关重要。

步骤5:转录音频并将其分成块

使用Whisper转录音频:

textaudio_file = 'geek_avenue.mp3'

result = whisper_model.transcribe(audio_file)

transcription = pd.DataFrame(result['segments'])现在,将转录分成可管理的块:

textdef chunk_clips(transcription, clip_size):

texts = []

sources = []

for i in range(0, len(transcription), clip_size):

clip_df = transcription.iloc[i:i + clip_size]

text = '. '.join(clip_df['text'].to_list())

sources.append(text)

text = '. '.join(clip_df['text'].to_list())

source = str(round(clip_df.iloc[0]['start'] / 60, 2)) + "--" + str(round(clip_df.iloc[-1]['end'] / 60, 2)) + " 分钟"

texts.append(text)

sources.append(source)

return texts, sourcestexts, sources = chunk_clips(transcription, clip_size=4)

分块可以防止系统超出令牌限制,并保持内容可管理。

步骤6:创建嵌入并设置Chroma

为文本块生成嵌入:

textembeddings = OpenAIEmbeddings()

df = pd.DataFrame({'text': texts, 'sources': sources})

document_loader = DataFrameLoader(df, page_content_column="text")

documents = document_loader.load()使用这些文档初始化Chroma:

textvectorstore = Chroma.from_documents(documents=documents, embedding=embeddings, persist_directory="./chroma_db")

vectorstore.persist()这将设置一个本地数据库,Chroma在其中存储嵌入的文本块。

步骤7:构建问答链

使用LangChain将所有内容整合在一起:

textchain = RetrievalQAWithSourcesChain.from_chain_type(

llm=OpenAI(temperature=0.5),

chain_type="stuff",

retriever=vectorstore.as_retriever()

)这个链结合了语言模型和检索器,以高效地获取和回答问题。

步骤8:测试系统

使用示例查询测试你的问答系统

相关文章

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

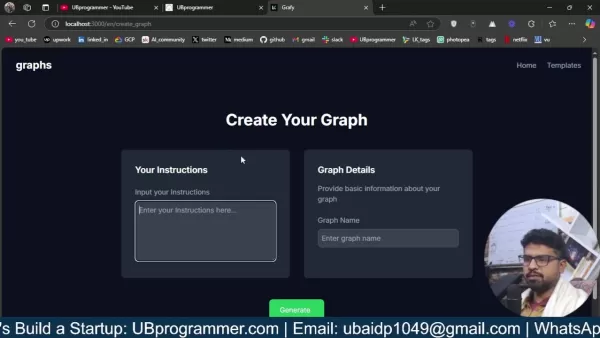

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

评论 (5)

0/200

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

评论 (5)

0/200

![JoseAdams]() JoseAdams

JoseAdams

2025-06-05 02:52:25

2025-06-05 02:52:25

Un système de Q&A par IA pour YouTube ? Génial ! Fini les heures à chercher une info précise. Hâte de voir ça en action ! 😊

0

0

![GregoryClark]() GregoryClark

GregoryClark

2025-06-04 13:22:17

2025-06-04 13:22:17

Классная идея с ИИ для YouTube! Теперь не придется часами искать нужный момент в видео. Надеюсь, оно справится с длинными лекциями! 🚀

0

0

![JohnHernández]() JohnHernández

JohnHernández

2025-06-03 07:24:29

2025-06-03 07:24:29

This AI Q&A system for YouTube sounds like a game-changer! No more skipping through endless videos to find what I need. Excited to try it out! 😎

0

0

你是否曾花费数小时浏览YouTube视频,试图在无尽的音频流中寻找智慧的珍珠?想象一下:你坐在那里,一个接一个地点击播放教程视频,希望能偶然发现你所需的关键信息。现在,想象一个世界,你可以瞬间浏览所有内容,提取你需要的部分,甚至能针对特定问题得到答案——只需轻轻一挥手指。本文将向你展示如何使用最新的AI工具为YouTube视频构建你自己的问答系统。通过结合Chroma、LangChain和OpenAI的Whisper,你可以将数小时的音频转化为可操作的见解。从总结长篇讲座到找到关键时刻的精确时间戳,这个系统将彻底改变你消费视频内容的方式。

对AI工具、编程技巧有迫切问题,或者只是需要一个可以尽情探讨的空间?加入我们的Discord社区——这是与志同道合的人连接的完美场所!

为YouTube视频构建问答系统

在深入之前,我们先谈谈为什么这值得你花时间。在当今快节奏的数字世界,人们不断被信息轰炸。无论你是试图掌握复杂概念的学生,还是渴望保持领先的专业人士,高效地从冗长的YouTube视频中提取知识至关重要。问答系统通过将数小时的内容浓缩为易于消化的摘要,让你能够精准定位所需信息。把它想象成将你喜爱的视频变成一张能回答所有迫切问题的备忘单。

它的工作原理是这样的:想象你提问,“向量数据库和关系数据库有什么区别?”系统无需你花费数小时观看视频,就能提取相关片段,给你答案,甚至告诉你精确的时间戳。不再浪费时间漫无目的地滑动——只有纯粹、专注的学习。此外,这不仅限于学术用途;对于分析商业通话、播客片段或任何其他形式的音频内容同样有用。

核心组件:Chroma、LangChain和OpenAI的Whisper

要构建这个问答系统,你将依赖三个协同工作的强大工具:

Chroma

Chroma是向量存储的可靠助手。把它想象成一个超级智能的文件柜,将文本数据组织成可搜索的向量。为什么这很重要?因为Chroma让你无需翻阅大量文本,就能进行闪电般的相似性搜索。当你提问时,它会快速将你的问题与视频转录中最相关的部分匹配。Chroma的高效使其非常适合处理大型数据集,如转录文本,确保你能迅速得到答案。

LangChain

LangChain是整个操作的大脑。它像指挥家一样协调一切——从提取转录到生成答案。凭借其模块化设计,LangChain无缝连接不同的AI组件,确保它们和谐协作。例如,它负责保持多次交互的上下文,让对话自然流畅。LangChain的灵活性意味着你可以根据需求调整系统,无论是追求简洁的摘要还是详细的解释。

OpenAI的Whisper

在将音频转化为文本方面,Whisper是王者。这款开源工具擅长将口语转化为书面形式,处理从细微口音到嘈杂环境的一切。其可靠性确保生成的文本尽可能准确,为有效分析奠定基础。没有Whisper,系统将难以解读原始音频数据。

构建问答系统的分步指南

准备好卷起袖子打造一个很棒的东西了吗?按照以下步骤创建你的个性化YouTube问答系统:

步骤1:安装所需库

首先安装必要的库。每个库在流程中都扮演着重要角色:

- whisper:将音频转化为文本。

- pytube:下载YouTube视频。

- langchain:处理问答逻辑。

- chromadb:存储嵌入以实现高效搜索。

- openai:与OpenAI的模型交互。

在终端运行以下命令:

pip install git+https://github.com/openai/whisper.git

pip install pytube

pip install langchain

pip install chromadb

pip install openai确保每个库正确安装后再继续。

步骤2:导入必要模块

安装好库后,将它们导入你的脚本:

import whisper

import torch

import os

from pytube import YouTube

from langchain.text_splitter import CharacterTextSplitter

from langchain.document_loaders import DataFrameLoader

from langchain.vectorstores import Chroma

from langchain.chains import RetrievalQAWithSourcesChain

from langchain.embeddings.openai import OpenAIEmbeddings

from langchain.llms import OpenAI

import pandas as pd这些模块为所需功能提供了支持。

步骤3:配置设备并加载Whisper模型

决定是使用GPU(如果可用)还是CPU:

device = "cuda" if torch.cuda.is_available() else "cpu"

whisper_model = whisper.load_model("large", device=device)选择合适的模型大小取决于你的硬件。较大的模型提供更高准确性,但需要更多资源。

步骤4:从YouTube视频提取音频

创建一个函数来下载并保存音频:

def extract_and_save_audio(video_url, destination, final_filename):

video = YouTube(video_url)

audio = video.streams.filter(only_audio=True).first()

output_path = audio.download(output_path=destination)

ext = os.path.splitext(output_path)[1]

new_file = final_filename + '.mp3'

os.rename(output_path, new_file)

return new_file此函数从YouTube视频中提取音频流并保存为MP3文件。干净的音频对于准确转录至关重要。

步骤5:转录音频并将其分成块

使用Whisper转录音频:

audio_file = 'geek_avenue.mp3'

result = whisper_model.transcribe(audio_file)

transcription = pd.DataFrame(result['segments'])现在,将转录分成可管理的块:

def chunk_clips(transcription, clip_size):

texts = []

sources = []

for i in range(0, len(transcription), clip_size):

clip_df = transcription.iloc[i:i + clip_size]

text = '. '.join(clip_df['text'].to_list())

sources.append(text)

text = '. '.join(clip_df['text'].to_list())

source = str(round(clip_df.iloc[0]['start'] / 60, 2)) + "--" + str(round(clip_df.iloc[-1]['end'] / 60, 2)) + " 分钟"

texts.append(text)

sources.append(source)

return texts, sourcestexts, sources = chunk_clips(transcription, clip_size=4)

分块可以防止系统超出令牌限制,并保持内容可管理。

步骤6:创建嵌入并设置Chroma

为文本块生成嵌入:

embeddings = OpenAIEmbeddings()

df = pd.DataFrame({'text': texts, 'sources': sources})

document_loader = DataFrameLoader(df, page_content_column="text")

documents = document_loader.load()使用这些文档初始化Chroma:

vectorstore = Chroma.from_documents(documents=documents, embedding=embeddings, persist_directory="./chroma_db")

vectorstore.persist()这将设置一个本地数据库,Chroma在其中存储嵌入的文本块。

步骤7:构建问答链

使用LangChain将所有内容整合在一起:

chain = RetrievalQAWithSourcesChain.from_chain_type(

llm=OpenAI(temperature=0.5),

chain_type="stuff",

retriever=vectorstore.as_retriever()

)这个链结合了语言模型和检索器,以高效地获取和回答问题。

步骤8:测试系统

使用示例查询测试你的问答系统

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

人工智能通过令人惊叹的数字转换,在元宇宙中重塑迈克尔-杰克逊的形象

人工智能正在从根本上重塑我们对创造力、娱乐和文化遗产的理解。对人工智能生成的迈克尔-杰克逊演绎的探索,揭示了尖端技术如何为传奇文化人物注入新的生命。从超级英雄的化身到奇幻境界的战士,这些突破性的转变展示了人工智能重塑流行音乐之王的非凡能力,同时也拓展了数字艺术和虚拟世界体验的视野。主要见解人工智能通过富有想象力的角色转换重新定义迈克尔-杰克逊戏剧性的可视化包括超级英雄、绝地武士和装甲骑士角色探索数

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

训练能否减轻人工智能引发的认知卸载效应?

最近,Unite.ai 网站发表了一篇题为《ChatGPT 可能正在耗尽你的大脑》的调查文章:人工智能时代的认知债务",揭示了麻省理工学院的相关研究。记者亚历克斯-麦克法兰(Alex McFarland)详细列举了令人信服的证据,证明过度依赖人工智能会侵蚀人的基本认知能力,尤其是批判性思维和判断能力。虽然这些发现与许多其他研究结果一致,但目前的紧迫挑战是制定切实可行的解决方案,让企业在利用人工智能

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

轻松生成人工智能驱动的图表和可视化效果,以获得更好的数据洞察力

现代数据分析要求复杂信息的直观可视化。人工智能驱动的图表生成解决方案已成为不可或缺的资产,彻底改变了专业人员将原始数据转化为引人入胜的可视化故事的方式。这些智能系统无需手动创建图表,同时还能保持精确性,使技术用户和非技术用户都能通过自动可视化发现可行的见解。主要亮点自动可视化:立即将结构化和非结构化数据转换为专业级图表。自然语言处理:通过对话命令生成可视化,无需编码。全面的图表支持:生成条形图、饼

2025-06-05 02:52:25

2025-06-05 02:52:25

Un système de Q&A par IA pour YouTube ? Génial ! Fini les heures à chercher une info précise. Hâte de voir ça en action ! 😊

0

0

2025-06-04 13:22:17

2025-06-04 13:22:17

Классная идея с ИИ для YouTube! Теперь не придется часами искать нужный момент в видео. Надеюсь, оно справится с длинными лекциями! 🚀

0

0

2025-06-03 07:24:29

2025-06-03 07:24:29

This AI Q&A system for YouTube sounds like a game-changer! No more skipping through endless videos to find what I need. Excited to try it out! 😎

0

0