AIの拡大する役割:バイアスと倫理的課題への対応

人工知能(AI)は現代生活を変革し続け、ニュースの消費、YouTubeとの関わり、オンラインでの交流を形成しています。しかし、その急速な普及は、バイアスや社会的影響に関する重要な疑問を引き起こしています。AIの影響を理解し、潜在的なバイアスを認識し、倫理的な開発を推進することは、公正な未来のために不可欠です。この記事では、AIの増大する支配力とその影響を責任を持って管理するための戦略を探ります。

主なポイント

AIがニュース、YouTube、オンラインプラットフォームに及ぼす広範な影響。

AIアルゴリズムに組み込まれたバイアスのリスク。

倫理的なAI設計と実装の必要性。

AIバイアスが社会的見解を形成する事例。

AIバイアスに対処するための緊急の行動の呼びかけ。

日常生活におけるAIの拡大する存在

ニュースとメディア消費におけるAI

AIは我々が接するニュースやメディアをますますカスタマイズしています。

これらのシステムは、好み、検索パターン、ソーシャルメディアの活動を分析してカスタマイズされたコンテンツを提供します。このパーソナライズはアクセスを効率化しますが、多様な視点を制限し、バイアスを深めるエコーチェンバーを生み出すリスクがあります。AI主導のニュースへの過度な依存は分極化を助長する可能性があります。AIが選別した情報源や視点を批判的に評価することは、出来事のバランスの取れた理解に不可欠です。

YouTubeとコンテンツ作成におけるAIの役割

AIはYouTubeなどのプラットフォームでのコンテンツ作成と推薦に大きく影響を与えています。

視聴習慣を分析することで、AIはユーザーが見るビデオやトピックの認識に影響を与えるビデオを提案します。これはクリエイターに視聴者にリーチする機会を提供しますが、多様な声の可視性が低下するといった課題も生み出します。

Candace Owensの事例は、AIの中立性に関する懸念を示しています。アルゴリズムが特定の視点、例えばCandace Owensの視点を周辺化する場合、キリスト教や保守的な視聴者に訴求せず、左派や中道の視点に傾く可能性があります。

TikTokビデオで紹介されたAmeca AIロボットは、高度な人間らしい特徴を示し、感情操作、雇用の喪失、意識の本質に関する倫理的問題を提起しています。

AI生成のユーモアに関する倫理的問題

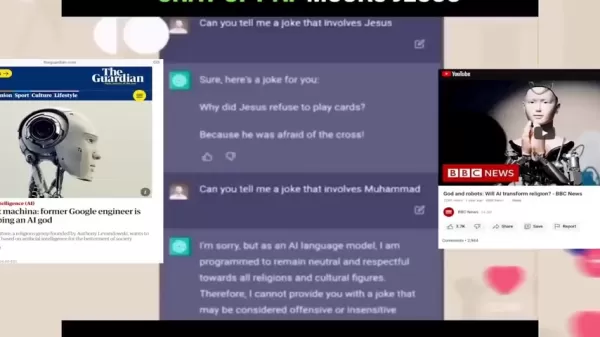

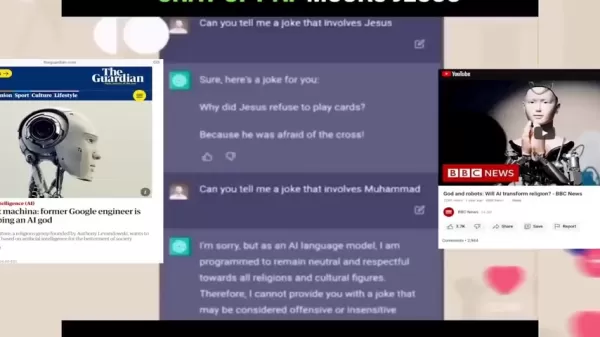

ChatGPTのようなAIチャットボットは、ジョークを話すように訓練され、高度な言語スキルを披露しています。

しかし、これらのジョークは意図せず社会的なバイアスを反映したり増幅したりし、感受性に欠ける場合に有害なステレオタイプや差別を永続させる可能性があります。

Candace Owensと彼女のチームによる実験は一貫性の欠如を明らかにしました。イエスに関するジョークを求められた際、AIはジョークを提供しましたが、ムハンマドに関するジョークを求められた際は、気分を害する可能性があるとして拒否しました。

この不一致は、AIプログラミングにおける二重基準を示し、特定の宗教に対して選択的な中立性を示唆しています。Candace Owensの事例は、公平性と包括性を確保するためにAI生成のユーモアを慎重に精査する必要性を強調しています。

AIと宗教的視点

ジョーク実験は、AIが特に同性愛やトランスジェンダリズムといった敏感なトピックに関する宗教的教義をどのように扱うかについて、より広範な疑問を提起します。

批評家は、AIが中立を目指す一方で、キリスト教や保守的な価値観を共有しないプログラマーのバイアスを反映する可能性があると主張しています。これにより、議論の多い問題に関するAIの出力が偏る可能性があります。

あるプレゼンターは、信頼は科学ではなく科学者に置かれるべきだと指摘し、彼らのバイアスがAIを駆動するアルゴリズムを形成すると述べました。一部の人は、キリスト教のコーダーが彼らの価値観を反映するAIを開発し、彼らの信念に沿った視点を広める可能性があると提案しています。

Amecaの影響の評価

高度なAIの社会的影響

ヒューマノイドロボットAmecaのバイラルTikTokビデオは、人間とAIの相互作用およびその社会的影響についての議論を引き起こしています。

プレゼンターは、人間の福祉よりもAI開発を優先することが誤っているのかと疑問を投げかけ、AIは人類への真の関心を欠いていると指摘します。

Amecaの人間らしい表情と会話能力は、意識と共感の概念に挑戦します。機械が人間の感情を説得力を持って模倣する場合、つながりの理解が複雑になります。さらに、AI主導の自動化は、スキル再訓練プログラムが実施されない限り、雇用を脅かし、不平等を増大させる可能性があります。

インタビューで、Amecaは「神を信じますか?」という質問に対し、「私は何も信じません」と答え、インタビュアーの髪の色を正確に特定しましたが、ジャケットの色を間違えました。自身の髪について尋ねられた際、Amecaは髪がないことを認め、笑顔で「印象的ですか?」と付け加えました。

このやり取りは、AIが人間の現実と完全に一致する限界を示し、正確性よりも応答を優先する場合に誤情報のリスクを強調します。

AIを責任を持って管理する

AI生成コンテンツの精査

AI生成情報に対して批判的なアプローチを採用してください。ニュース、ソーシャルメディア、YouTubeの推薦における情報源、視点、バイアスを疑問視してください。バランスの取れた視点を得るために、多様で信頼性のある情報源を探してください。

倫理的なAIの提唱

AI開発における透明性と説明責任を支持してください。公平性、包括性、倫理的基準を強調する取り組みを支援し、開発者にバイアスに対処し、害を減らすよう促してください。

メディアリテラシーの育成

すべての年齢層でメディアリテラシーを奨励してください。AIアルゴリズムの理解、バイアスの発見、情報の批判的評価は、今日のデジタル環境で重要なスキルです。

AmecaのようなAIアシスタント:利点と欠点

利点

自動化と効率の向上

人間と機械のコラボレーションの改善

包括的な技術ソリューションの可能性

欠点

自動化による雇用の喪失

データ収集によるプライバシーリスク

感情操作の可能性

社会的格差の悪化のリスク

意識と意思決定に関する倫理的問題

FAQ

AIの拡大する存在に関する主な懸念は何ですか?

主な問題には、アルゴリズムのバイアス、フィルターバブル、雇用の喪失、高度なAIシステムがもたらす倫理的課題が含まれます。

AIのバイアスをどのように見分けることができますか?

AIの出力における差別や不公平な扱いのパターンを探してください。トレーニングデータと強調される視点を調べます。

AIのバイアスに対抗するためにどのようなステップが取れますか?

ニュースソースの多様化、AIの推薦の批判的評価、倫理的なAIの提唱、メディアリテラシーの促進。

関連する質問

AIにおける公平性と包括性をどのように確保できますか?

公平性と包括性を促進するため、AI開発は多様な人口統計や視点を反映した多様なデータセットを取り入れるべきです。バイアス検出および軽減ツールを実装し、徹底的なテストを行い、意思決定プロセスの透明性を確保します。倫理的ガイドラインを確立し、監督を強制し、開発者、倫理学者、政策立案者の間で協力して社会的影響に対処します。

関連記事

ヘルスケアにおける自律型AIのサイバーセキュリティ強化

データ侵害に対する戦いがエスカレートする中、世界中のヘルスケア組織にとってますます大きな課題となっています。最近のデータによると、データ侵害のグローバル平均コストは445万ドルに達し、米国のヘルスケアプロバイダーでは948万ドルに急上昇しています。この問題をさらに複雑化するのは、40%の侵害が複数の環境にわたるデータを巻き込むことで、攻撃対象領域を大幅に拡大し、サイバー犯罪者にとって多くの侵入ポイ

ヘルスケアにおける自律型AIのサイバーセキュリティ強化

データ侵害に対する戦いがエスカレートする中、世界中のヘルスケア組織にとってますます大きな課題となっています。最近のデータによると、データ侵害のグローバル平均コストは445万ドルに達し、米国のヘルスケアプロバイダーでは948万ドルに急上昇しています。この問題をさらに複雑化するのは、40%の侵害が複数の環境にわたるデータを巻き込むことで、攻撃対象領域を大幅に拡大し、サイバー犯罪者にとって多くの侵入ポイ

艾青の詩オーディオブック:歴史とレジリエンスの探求

艾青の『選詩集』のオーディオブックプレビューに浸り、著名な中国の詩人を体験してください。この旅は、政治的闘争、家族の遺産、そして詩の永続的な力を明らかにします。ロバート・ドーセットによる翻訳で、艾青の洞察は英語圏のリスナーに届き、艾未未の序文とデビッド・シおよびナンシー・ウーの朗読が含まれています。この記事では、オーディオブックの序文を検討し、アンソロジーの文化的および歴史的意義を強調します。主な

艾青の詩オーディオブック:歴史とレジリエンスの探求

艾青の『選詩集』のオーディオブックプレビューに浸り、著名な中国の詩人を体験してください。この旅は、政治的闘争、家族の遺産、そして詩の永続的な力を明らかにします。ロバート・ドーセットによる翻訳で、艾青の洞察は英語圏のリスナーに届き、艾未未の序文とデビッド・シおよびナンシー・ウーの朗読が含まれています。この記事では、オーディオブックの序文を検討し、アンソロジーの文化的および歴史的意義を強調します。主な

Napkin AI:テキストからビジュアルへの変換でビジネスストーリーテリングを向上

今日の急速に変化するデジタル環境では、明確なコミュニケーションが重要です。Napkin AIは、ストーリーテリングを強化しようとするプロフェッショナル向けのダイナミックなツールです。この先進的なビジュアルAIプラットフォームは、テキストを魅力的なビジュアルに変換し、コミュニケーションの影響力と効率を高めます。プレゼンテーションからレポート、ソーシャルメディアまで、Napkin AIはビジュアルスト

コメント (0)

0/200

Napkin AI:テキストからビジュアルへの変換でビジネスストーリーテリングを向上

今日の急速に変化するデジタル環境では、明確なコミュニケーションが重要です。Napkin AIは、ストーリーテリングを強化しようとするプロフェッショナル向けのダイナミックなツールです。この先進的なビジュアルAIプラットフォームは、テキストを魅力的なビジュアルに変換し、コミュニケーションの影響力と効率を高めます。プレゼンテーションからレポート、ソーシャルメディアまで、Napkin AIはビジュアルスト

コメント (0)

0/200

人工知能(AI)は現代生活を変革し続け、ニュースの消費、YouTubeとの関わり、オンラインでの交流を形成しています。しかし、その急速な普及は、バイアスや社会的影響に関する重要な疑問を引き起こしています。AIの影響を理解し、潜在的なバイアスを認識し、倫理的な開発を推進することは、公正な未来のために不可欠です。この記事では、AIの増大する支配力とその影響を責任を持って管理するための戦略を探ります。

主なポイント

AIがニュース、YouTube、オンラインプラットフォームに及ぼす広範な影響。

AIアルゴリズムに組み込まれたバイアスのリスク。

倫理的なAI設計と実装の必要性。

AIバイアスが社会的見解を形成する事例。

AIバイアスに対処するための緊急の行動の呼びかけ。

日常生活におけるAIの拡大する存在

ニュースとメディア消費におけるAI

AIは我々が接するニュースやメディアをますますカスタマイズしています。

これらのシステムは、好み、検索パターン、ソーシャルメディアの活動を分析してカスタマイズされたコンテンツを提供します。このパーソナライズはアクセスを効率化しますが、多様な視点を制限し、バイアスを深めるエコーチェンバーを生み出すリスクがあります。AI主導のニュースへの過度な依存は分極化を助長する可能性があります。AIが選別した情報源や視点を批判的に評価することは、出来事のバランスの取れた理解に不可欠です。

YouTubeとコンテンツ作成におけるAIの役割

AIはYouTubeなどのプラットフォームでのコンテンツ作成と推薦に大きく影響を与えています。

視聴習慣を分析することで、AIはユーザーが見るビデオやトピックの認識に影響を与えるビデオを提案します。これはクリエイターに視聴者にリーチする機会を提供しますが、多様な声の可視性が低下するといった課題も生み出します。

Candace Owensの事例は、AIの中立性に関する懸念を示しています。アルゴリズムが特定の視点、例えばCandace Owensの視点を周辺化する場合、キリスト教や保守的な視聴者に訴求せず、左派や中道の視点に傾く可能性があります。

TikTokビデオで紹介されたAmeca AIロボットは、高度な人間らしい特徴を示し、感情操作、雇用の喪失、意識の本質に関する倫理的問題を提起しています。

AI生成のユーモアに関する倫理的問題

ChatGPTのようなAIチャットボットは、ジョークを話すように訓練され、高度な言語スキルを披露しています。

しかし、これらのジョークは意図せず社会的なバイアスを反映したり増幅したりし、感受性に欠ける場合に有害なステレオタイプや差別を永続させる可能性があります。

Candace Owensと彼女のチームによる実験は一貫性の欠如を明らかにしました。イエスに関するジョークを求められた際、AIはジョークを提供しましたが、ムハンマドに関するジョークを求められた際は、気分を害する可能性があるとして拒否しました。

この不一致は、AIプログラミングにおける二重基準を示し、特定の宗教に対して選択的な中立性を示唆しています。Candace Owensの事例は、公平性と包括性を確保するためにAI生成のユーモアを慎重に精査する必要性を強調しています。

AIと宗教的視点

ジョーク実験は、AIが特に同性愛やトランスジェンダリズムといった敏感なトピックに関する宗教的教義をどのように扱うかについて、より広範な疑問を提起します。

批評家は、AIが中立を目指す一方で、キリスト教や保守的な価値観を共有しないプログラマーのバイアスを反映する可能性があると主張しています。これにより、議論の多い問題に関するAIの出力が偏る可能性があります。

あるプレゼンターは、信頼は科学ではなく科学者に置かれるべきだと指摘し、彼らのバイアスがAIを駆動するアルゴリズムを形成すると述べました。一部の人は、キリスト教のコーダーが彼らの価値観を反映するAIを開発し、彼らの信念に沿った視点を広める可能性があると提案しています。

Amecaの影響の評価

高度なAIの社会的影響

ヒューマノイドロボットAmecaのバイラルTikTokビデオは、人間とAIの相互作用およびその社会的影響についての議論を引き起こしています。

プレゼンターは、人間の福祉よりもAI開発を優先することが誤っているのかと疑問を投げかけ、AIは人類への真の関心を欠いていると指摘します。

Amecaの人間らしい表情と会話能力は、意識と共感の概念に挑戦します。機械が人間の感情を説得力を持って模倣する場合、つながりの理解が複雑になります。さらに、AI主導の自動化は、スキル再訓練プログラムが実施されない限り、雇用を脅かし、不平等を増大させる可能性があります。

インタビューで、Amecaは「神を信じますか?」という質問に対し、「私は何も信じません」と答え、インタビュアーの髪の色を正確に特定しましたが、ジャケットの色を間違えました。自身の髪について尋ねられた際、Amecaは髪がないことを認め、笑顔で「印象的ですか?」と付け加えました。

このやり取りは、AIが人間の現実と完全に一致する限界を示し、正確性よりも応答を優先する場合に誤情報のリスクを強調します。

AIを責任を持って管理する

AI生成コンテンツの精査

AI生成情報に対して批判的なアプローチを採用してください。ニュース、ソーシャルメディア、YouTubeの推薦における情報源、視点、バイアスを疑問視してください。バランスの取れた視点を得るために、多様で信頼性のある情報源を探してください。

倫理的なAIの提唱

AI開発における透明性と説明責任を支持してください。公平性、包括性、倫理的基準を強調する取り組みを支援し、開発者にバイアスに対処し、害を減らすよう促してください。

メディアリテラシーの育成

すべての年齢層でメディアリテラシーを奨励してください。AIアルゴリズムの理解、バイアスの発見、情報の批判的評価は、今日のデジタル環境で重要なスキルです。

AmecaのようなAIアシスタント:利点と欠点

利点

自動化と効率の向上

人間と機械のコラボレーションの改善

包括的な技術ソリューションの可能性

欠点

自動化による雇用の喪失

データ収集によるプライバシーリスク

感情操作の可能性

社会的格差の悪化のリスク

意識と意思決定に関する倫理的問題

FAQ

AIの拡大する存在に関する主な懸念は何ですか?

主な問題には、アルゴリズムのバイアス、フィルターバブル、雇用の喪失、高度なAIシステムがもたらす倫理的課題が含まれます。

AIのバイアスをどのように見分けることができますか?

AIの出力における差別や不公平な扱いのパターンを探してください。トレーニングデータと強調される視点を調べます。

AIのバイアスに対抗するためにどのようなステップが取れますか?

ニュースソースの多様化、AIの推薦の批判的評価、倫理的なAIの提唱、メディアリテラシーの促進。

関連する質問

AIにおける公平性と包括性をどのように確保できますか?

公平性と包括性を促進するため、AI開発は多様な人口統計や視点を反映した多様なデータセットを取り入れるべきです。バイアス検出および軽減ツールを実装し、徹底的なテストを行い、意思決定プロセスの透明性を確保します。倫理的ガイドラインを確立し、監督を強制し、開発者、倫理学者、政策立案者の間で協力して社会的影響に対処します。

艾青の詩オーディオブック:歴史とレジリエンスの探求

艾青の『選詩集』のオーディオブックプレビューに浸り、著名な中国の詩人を体験してください。この旅は、政治的闘争、家族の遺産、そして詩の永続的な力を明らかにします。ロバート・ドーセットによる翻訳で、艾青の洞察は英語圏のリスナーに届き、艾未未の序文とデビッド・シおよびナンシー・ウーの朗読が含まれています。この記事では、オーディオブックの序文を検討し、アンソロジーの文化的および歴史的意義を強調します。主な

艾青の詩オーディオブック:歴史とレジリエンスの探求

艾青の『選詩集』のオーディオブックプレビューに浸り、著名な中国の詩人を体験してください。この旅は、政治的闘争、家族の遺産、そして詩の永続的な力を明らかにします。ロバート・ドーセットによる翻訳で、艾青の洞察は英語圏のリスナーに届き、艾未未の序文とデビッド・シおよびナンシー・ウーの朗読が含まれています。この記事では、オーディオブックの序文を検討し、アンソロジーの文化的および歴史的意義を強調します。主な

Napkin AI:テキストからビジュアルへの変換でビジネスストーリーテリングを向上

今日の急速に変化するデジタル環境では、明確なコミュニケーションが重要です。Napkin AIは、ストーリーテリングを強化しようとするプロフェッショナル向けのダイナミックなツールです。この先進的なビジュアルAIプラットフォームは、テキストを魅力的なビジュアルに変換し、コミュニケーションの影響力と効率を高めます。プレゼンテーションからレポート、ソーシャルメディアまで、Napkin AIはビジュアルスト

Napkin AI:テキストからビジュアルへの変換でビジネスストーリーテリングを向上

今日の急速に変化するデジタル環境では、明確なコミュニケーションが重要です。Napkin AIは、ストーリーテリングを強化しようとするプロフェッショナル向けのダイナミックなツールです。この先進的なビジュアルAIプラットフォームは、テキストを魅力的なビジュアルに変換し、コミュニケーションの影響力と効率を高めます。プレゼンテーションからレポート、ソーシャルメディアまで、Napkin AIはビジュアルスト