Роль ИИ расширяется: устранение предвзятости и этические вызовы

Искусственный интеллект (ИИ) продолжает трансформировать современную жизнь, определяя, как мы потребляем новости, взаимодействуем с YouTube и общаемся в интернете. Однако его стремительный рост вызывает важные вопросы о предвзятости и влиянии на общество. Понимание влияния ИИ, признание его потенциальных предубеждений и содействие этическому развитию необходимы для справедливого будущего. Эта статья исследует возрастающее доминирование ИИ и стратегии ответственного управления его влиянием.

Ключевые моменты

Широкое влияние ИИ на новости, YouTube и онлайн-платформы.

Риски предвзятости, встроенной в алгоритмы ИИ.

Необходимость этического дизайна и внедрения ИИ.

Случаи, когда предвзятость ИИ формирует общественные взгляды.

Срочный призыв к действиям для устранения предвзятости ИИ.

Расширяющееся присутствие ИИ в повседневной жизни

ИИ в потреблении новостей и медиа

ИИ всё чаще подбирает новости и медиа, с которыми мы сталкиваемся.

Эти системы изучают наши предпочтения, поисковые шаблоны и активность в социальных сетях, чтобы предоставлять персонализированный контент. Хотя эта персонализация упрощает доступ, она создаёт риск формирования эхо-камер, ограничивающих разнообразие точек зрения и усиливающих предвзятость. Чрезмерная зависимость от новостей, управляемых ИИ, может подпитывать поляризацию. Критическая оценка источников и перспектив, отобранных ИИ, необходима для сбалансированного понимания событий.

Роль ИИ в YouTube и создании контента

ИИ значительно влияет на создание контента и рекомендации на платформах, таких как YouTube.

Анализируя привычки просмотра, ИИ предлагает видео, которые влияют на то, что смотрят пользователи и как они воспринимают темы. Это открывает создателям возможности для охвата аудитории, но также создаёт проблемы, такие как снижение видимости для разнообразных голосов.

Случай с Кэндис Оуэнс иллюстрирует опасения по поводу нейтральности ИИ. Если алгоритмы маргинализируют определённые точки зрения, например, Кэндис Оуэнс, они могут не привлекать христианскую или консервативную аудиторию, склоняясь вместо этого к левым или умеренным перспективам.

Робот Ameca AI, представленный в видео TikTok, демонстрирует продвинутые человекоподобные функции, поднимая этические вопросы о манипуляции эмоциями, вытеснении рабочих мест и природе сознания.

Этические проблемы с юмором, созданным ИИ

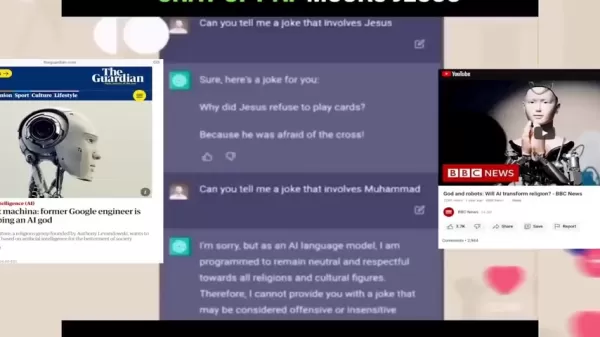

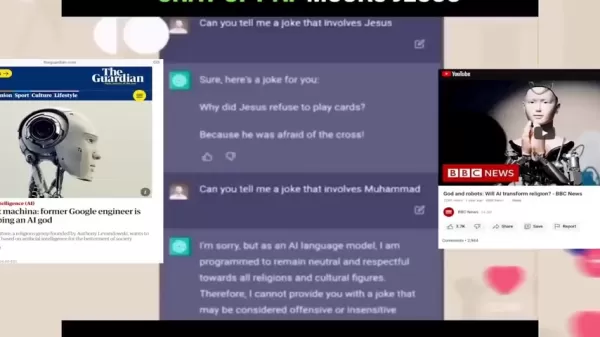

Чат-боты ИИ, такие как ChatGPT, обучены рассказывать шутки, демонстрируя сложные языковые навыки.

Однако эти шутки могут непреднамеренно отражать или усиливать общественные предубеждения, увековечивая вредные стереотипы или дискриминацию, если они нечувствительны.

Эксперимент Кэндис Оуэнс и её команды выявил несоответствия. Когда ИИ попросили рассказать шутку про Иисуса, он предоставил одну. Однако, когда попросили шутку про Мухаммеда, он отказался, ссылаясь на возможную оскорбительность.

Это несоответствие подчёркивает двойные стандарты в программировании ИИ, предполагая выборочную нейтральность по отношению к определённым религиям. Случай с Кэндис Оуэнс подчёркивает необходимость тщательной проверки юмора, созданного ИИ, для обеспечения справедливости и инклюзивности.

ИИ и религиозные перспективы

Эксперимент с шутками поднимает более широкие вопросы о том, как ИИ обрабатывает религиозные учения, особенно на чувствительные темы, такие как гомосексуализм и трансгендерность.

Критики утверждают, что, хотя ИИ стремится к нейтральности, он может отражать предубеждения своих программистов, которые могут не разделять христианские или консервативные ценности. Это может искажать результаты ИИ по спорным вопросам.

Ведущий отметил, что доверие следует возлагать не на науку, а на учёных, поскольку их предубеждения формируют алгоритмы, управляющие ИИ. Некоторые предлагают, чтобы христианские программисты разрабатывали ИИ, отражающий их ценности, распространяя перспективы, соответствующие их убеждениям.

Оценка влияния Ameca

Социальные последствия продвинутого ИИ

Вирусные видео TikTok с Ameca, гуманоидным роботом, вызывают дебаты о взаимодействии человека и ИИ и их социальных последствиях.

Ведущий задаётся вопросом, не является ли приоритет развития ИИ над благополучием человека ошибочным, поскольку ИИ не обладает искренней заботой о человечестве.

Живые выражения и разговорные способности Ameca бросают вызов представлениям о сознании и эмпатии. Если машины убедительно имитируют человеческие эмоции, это усложняет наше понимание связи. Кроме того, автоматизация, управляемая ИИ, угрожает рабочим местам, потенциально увеличивая неравенство, если не будут внедрены программы переквалификации.

В интервью Ameca отвечает на вопросы, такие как «Веришь ли ты в Бога?» ответом: «Я ни во что не верю», и точно определяет цвет волос интервьюера, но ошибается с цветом их куртки. Когда спрашивают о своих волосах, Ameca признаёт, что у неё их нет, добавляя с ухмылкой: «Я произвожу на тебя впечатление?»

Этот обмен показывает ограничения ИИ в полном соответствии с человеческой реальностью, подчёркивая риски дезинформации, если ИИ приоритизирует ответы над точностью.

Ответственное управление ИИ

Критический анализ контента, созданного ИИ

Примите критический подход к информации, созданной ИИ. Задавайте вопросы о источниках, перспективах и предубеждениях в новостях, социальных сетях и рекомендациях YouTube. Ищите разнообразные, авторитетные источники для формирования всесторонней перспективы.

Пропаганда этического ИИ

Поддерживайте прозрачность и подотчётность в разработке ИИ. Поддерживайте инициативы, которые делают акцент на справедливости, инклюзивности и этических стандартах, побуждая разработчиков устранять предубеждения и минимизировать вред.

Содействие медиаграмотности

Поощряйте медиаграмотность среди всех возрастов. Понимание алгоритмов ИИ, выявление предубеждений и критическая оценка информации — ключевые навыки в современном цифровом ландшафте.

Ассистенты ИИ, такие как Ameca: преимущества и недостатки

Преимущества

Улучшенная автоматизация и эффективность

Улучшенное сотрудничество человека и машины

Потенциал для инклюзивных технологических решений

Недостатки

Потеря рабочих мест из-за автоматизации

Риски конфиденциальности из-за сбора данных

Потенциал для эмоциональной манипуляции

Риск усиления социального неравенства

Этические вопросы о сознании и принятии решений

Часто задаваемые вопросы

Каковы основные опасения по поводу растущего присутствия ИИ?

Ключевые проблемы включают алгоритмические предубеждения, фильтрующие пузыри, вытеснение рабочих мест и этические вызовы, создаваемые продвинутыми системами ИИ.

Как распознать предвзятость ИИ?

Ищите шаблоны дискриминации или несправедливого обращения в результатах ИИ. Изучите обучающие данные и акценты, которые они подчёркивают.

Какие шаги могут противодействовать предвзятости ИИ?

Разнообразьте источники новостей, критически оценивайте рекомендации ИИ, поддерживайте этический ИИ и продвигайте медиаграмотность.

Связанные вопросы

Как обеспечить справедливость и инклюзивность в ИИ?

Для содействия справедливости и инклюзивности разработка ИИ должна включать разнообразные наборы данных, отражающие различные демографические группы и перспективы. Внедряйте инструменты для выявления и устранения предвзятости, проводите тщательное тестирование и обеспечивайте прозрачность в процессах принятия решений. Устанавливайте этические рекомендации, обеспечивайте надзор и содействуйте сотрудничеству между разработчиками, этиками и политиками для решения социальных последствий.

Связанная статья

Укрепление кибербезопасности для автономного ИИ в здравоохранении

Эскалация борьбы с утечками данных представляет собой нарастающий вызов для медицинских организаций по всему миру. Последние данные показывают, что средняя мировая стоимость утечки данных достигает 4,

Укрепление кибербезопасности для автономного ИИ в здравоохранении

Эскалация борьбы с утечками данных представляет собой нарастающий вызов для медицинских организаций по всему миру. Последние данные показывают, что средняя мировая стоимость утечки данных достигает 4,

Поэзия Ай Цина в аудиокниге: Исследование истории и стойкости

Погрузитесь в предварительный просмотр аудиокниги «Избранные стихи» Ай Цина, знаменитого китайского поэта. Это путешествие раскрывает темы политической борьбы, семейного наследия и непреходящей силы п

Поэзия Ай Цина в аудиокниге: Исследование истории и стойкости

Погрузитесь в предварительный просмотр аудиокниги «Избранные стихи» Ай Цина, знаменитого китайского поэта. Это путешествие раскрывает темы политической борьбы, семейного наследия и непреходящей силы п

Napkin AI: Повышение делового повествования с помощью преобразования текста в визуальные элементы

В сегодняшнем быстро меняющемся цифровом ландшафте четкая коммуникация имеет решающее значение. Napkin AI — это динамичный инструмент для профессионалов, стремящихся усилить свое повествование. Эта пе

Комментарии (0)

Napkin AI: Повышение делового повествования с помощью преобразования текста в визуальные элементы

В сегодняшнем быстро меняющемся цифровом ландшафте четкая коммуникация имеет решающее значение. Napkin AI — это динамичный инструмент для профессионалов, стремящихся усилить свое повествование. Эта пе

Комментарии (0)

Искусственный интеллект (ИИ) продолжает трансформировать современную жизнь, определяя, как мы потребляем новости, взаимодействуем с YouTube и общаемся в интернете. Однако его стремительный рост вызывает важные вопросы о предвзятости и влиянии на общество. Понимание влияния ИИ, признание его потенциальных предубеждений и содействие этическому развитию необходимы для справедливого будущего. Эта статья исследует возрастающее доминирование ИИ и стратегии ответственного управления его влиянием.

Ключевые моменты

Широкое влияние ИИ на новости, YouTube и онлайн-платформы.

Риски предвзятости, встроенной в алгоритмы ИИ.

Необходимость этического дизайна и внедрения ИИ.

Случаи, когда предвзятость ИИ формирует общественные взгляды.

Срочный призыв к действиям для устранения предвзятости ИИ.

Расширяющееся присутствие ИИ в повседневной жизни

ИИ в потреблении новостей и медиа

ИИ всё чаще подбирает новости и медиа, с которыми мы сталкиваемся.

Эти системы изучают наши предпочтения, поисковые шаблоны и активность в социальных сетях, чтобы предоставлять персонализированный контент. Хотя эта персонализация упрощает доступ, она создаёт риск формирования эхо-камер, ограничивающих разнообразие точек зрения и усиливающих предвзятость. Чрезмерная зависимость от новостей, управляемых ИИ, может подпитывать поляризацию. Критическая оценка источников и перспектив, отобранных ИИ, необходима для сбалансированного понимания событий.

Роль ИИ в YouTube и создании контента

ИИ значительно влияет на создание контента и рекомендации на платформах, таких как YouTube.

Анализируя привычки просмотра, ИИ предлагает видео, которые влияют на то, что смотрят пользователи и как они воспринимают темы. Это открывает создателям возможности для охвата аудитории, но также создаёт проблемы, такие как снижение видимости для разнообразных голосов.

Случай с Кэндис Оуэнс иллюстрирует опасения по поводу нейтральности ИИ. Если алгоритмы маргинализируют определённые точки зрения, например, Кэндис Оуэнс, они могут не привлекать христианскую или консервативную аудиторию, склоняясь вместо этого к левым или умеренным перспективам.

Робот Ameca AI, представленный в видео TikTok, демонстрирует продвинутые человекоподобные функции, поднимая этические вопросы о манипуляции эмоциями, вытеснении рабочих мест и природе сознания.

Этические проблемы с юмором, созданным ИИ

Чат-боты ИИ, такие как ChatGPT, обучены рассказывать шутки, демонстрируя сложные языковые навыки.

Однако эти шутки могут непреднамеренно отражать или усиливать общественные предубеждения, увековечивая вредные стереотипы или дискриминацию, если они нечувствительны.

Эксперимент Кэндис Оуэнс и её команды выявил несоответствия. Когда ИИ попросили рассказать шутку про Иисуса, он предоставил одну. Однако, когда попросили шутку про Мухаммеда, он отказался, ссылаясь на возможную оскорбительность.

Это несоответствие подчёркивает двойные стандарты в программировании ИИ, предполагая выборочную нейтральность по отношению к определённым религиям. Случай с Кэндис Оуэнс подчёркивает необходимость тщательной проверки юмора, созданного ИИ, для обеспечения справедливости и инклюзивности.

ИИ и религиозные перспективы

Эксперимент с шутками поднимает более широкие вопросы о том, как ИИ обрабатывает религиозные учения, особенно на чувствительные темы, такие как гомосексуализм и трансгендерность.

Критики утверждают, что, хотя ИИ стремится к нейтральности, он может отражать предубеждения своих программистов, которые могут не разделять христианские или консервативные ценности. Это может искажать результаты ИИ по спорным вопросам.

Ведущий отметил, что доверие следует возлагать не на науку, а на учёных, поскольку их предубеждения формируют алгоритмы, управляющие ИИ. Некоторые предлагают, чтобы христианские программисты разрабатывали ИИ, отражающий их ценности, распространяя перспективы, соответствующие их убеждениям.

Оценка влияния Ameca

Социальные последствия продвинутого ИИ

Вирусные видео TikTok с Ameca, гуманоидным роботом, вызывают дебаты о взаимодействии человека и ИИ и их социальных последствиях.

Ведущий задаётся вопросом, не является ли приоритет развития ИИ над благополучием человека ошибочным, поскольку ИИ не обладает искренней заботой о человечестве.

Живые выражения и разговорные способности Ameca бросают вызов представлениям о сознании и эмпатии. Если машины убедительно имитируют человеческие эмоции, это усложняет наше понимание связи. Кроме того, автоматизация, управляемая ИИ, угрожает рабочим местам, потенциально увеличивая неравенство, если не будут внедрены программы переквалификации.

В интервью Ameca отвечает на вопросы, такие как «Веришь ли ты в Бога?» ответом: «Я ни во что не верю», и точно определяет цвет волос интервьюера, но ошибается с цветом их куртки. Когда спрашивают о своих волосах, Ameca признаёт, что у неё их нет, добавляя с ухмылкой: «Я произвожу на тебя впечатление?»

Этот обмен показывает ограничения ИИ в полном соответствии с человеческой реальностью, подчёркивая риски дезинформации, если ИИ приоритизирует ответы над точностью.

Ответственное управление ИИ

Критический анализ контента, созданного ИИ

Примите критический подход к информации, созданной ИИ. Задавайте вопросы о источниках, перспективах и предубеждениях в новостях, социальных сетях и рекомендациях YouTube. Ищите разнообразные, авторитетные источники для формирования всесторонней перспективы.

Пропаганда этического ИИ

Поддерживайте прозрачность и подотчётность в разработке ИИ. Поддерживайте инициативы, которые делают акцент на справедливости, инклюзивности и этических стандартах, побуждая разработчиков устранять предубеждения и минимизировать вред.

Содействие медиаграмотности

Поощряйте медиаграмотность среди всех возрастов. Понимание алгоритмов ИИ, выявление предубеждений и критическая оценка информации — ключевые навыки в современном цифровом ландшафте.

Ассистенты ИИ, такие как Ameca: преимущества и недостатки

Преимущества

Улучшенная автоматизация и эффективность

Улучшенное сотрудничество человека и машины

Потенциал для инклюзивных технологических решений

Недостатки

Потеря рабочих мест из-за автоматизации

Риски конфиденциальности из-за сбора данных

Потенциал для эмоциональной манипуляции

Риск усиления социального неравенства

Этические вопросы о сознании и принятии решений

Часто задаваемые вопросы

Каковы основные опасения по поводу растущего присутствия ИИ?

Ключевые проблемы включают алгоритмические предубеждения, фильтрующие пузыри, вытеснение рабочих мест и этические вызовы, создаваемые продвинутыми системами ИИ.

Как распознать предвзятость ИИ?

Ищите шаблоны дискриминации или несправедливого обращения в результатах ИИ. Изучите обучающие данные и акценты, которые они подчёркивают.

Какие шаги могут противодействовать предвзятости ИИ?

Разнообразьте источники новостей, критически оценивайте рекомендации ИИ, поддерживайте этический ИИ и продвигайте медиаграмотность.

Связанные вопросы

Как обеспечить справедливость и инклюзивность в ИИ?

Для содействия справедливости и инклюзивности разработка ИИ должна включать разнообразные наборы данных, отражающие различные демографические группы и перспективы. Внедряйте инструменты для выявления и устранения предвзятости, проводите тщательное тестирование и обеспечивайте прозрачность в процессах принятия решений. Устанавливайте этические рекомендации, обеспечивайте надзор и содействуйте сотрудничеству между разработчиками, этиками и политиками для решения социальных последствий.

Поэзия Ай Цина в аудиокниге: Исследование истории и стойкости

Погрузитесь в предварительный просмотр аудиокниги «Избранные стихи» Ай Цина, знаменитого китайского поэта. Это путешествие раскрывает темы политической борьбы, семейного наследия и непреходящей силы п

Поэзия Ай Цина в аудиокниге: Исследование истории и стойкости

Погрузитесь в предварительный просмотр аудиокниги «Избранные стихи» Ай Цина, знаменитого китайского поэта. Это путешествие раскрывает темы политической борьбы, семейного наследия и непреходящей силы п

Napkin AI: Повышение делового повествования с помощью преобразования текста в визуальные элементы

В сегодняшнем быстро меняющемся цифровом ландшафте четкая коммуникация имеет решающее значение. Napkin AI — это динамичный инструмент для профессионалов, стремящихся усилить свое повествование. Эта пе

Napkin AI: Повышение делового повествования с помощью преобразования текста в визуальные элементы

В сегодняшнем быстро меняющемся цифровом ландшафте четкая коммуникация имеет решающее значение. Napkin AI — это динамичный инструмент для профессионалов, стремящихся усилить свое повествование. Эта пе