FEI-FEI LIのグループは、先制AIの安全法を促します

カリフォルニアの政策グループが、AIのパイオニアであるフェイフェイ・リー氏が共同で主導する新しい報告書によると、議員はAI規制政策を作成する際に、現実世界でまだ見られていないAIのリスクを考慮すべきだとされています。この41ページの中間報告書は、火曜日に公開され、ギャビン・ニューサム知事がカリフォルニアの物議を醸したAI安全法案SB 1047を拒否した後、設立された「AIフロンティアモデルに関するカリフォルニア共同政策作業グループ」によるものです。ニューサム知事はSB 1047が目標に十分に合致していないと感じましたが、AIのリスクを深く調査し、立法者を導く必要性を認識しました。

報告書では、リー氏と共同著者のジェニファー・チェイズ(カリフォルニア大学バークレー校計算機科学部の学部長)、マリアーノ・フロレンティーノ・クエヤル(カーネギー国際平和財団の会長)が、OpenAIのようなフロンティアAIラボの活動を明確にする法律を求めています。報告書が公開される前に、チューリング賞受賞者のヨシュア・ベンジオのようなAI安全の強力な支持者や、Databricksの共同創業者イオン・ストイカのようなSB 1047に反対する業界関係者など、さまざまな立場の人々が報告書をレビューしました。

報告書は、AIシステムによる新たなリスクに対応するため、AIモデル開発者が安全性テスト、データの取得方法、セキュリティ対策を公開する必要がある法律が必要かもしれないと指摘しています。また、第三者によるこれらの項目や企業ポリシーのチェックのためのより高い基準や、AI企業の従業員や契約者が内部告発をする際の保護強化も求めています。

リー氏と共同著者は、AIがサイバー攻撃を支援したり、生物兵器を作成したり、その他の「極端な」危険を引き起こす可能性についての証拠がまだ十分でないと述べています。しかし、AI政策は現在起こっていることだけを扱うのではなく、十分な安全対策がなければ将来起こりうることについても考えるべきだとしています。

報告書は核兵器を例に挙げ、「核兵器が爆発しなくても、それが大きな害を引き起こす可能性があることはわかっています」と述べています。さらに、「最悪のリスクについて語る人々が正しい場合――それが本当になるかどうかはわかりませんが――今、フロンティアAIについて何もしなければ、非常に大きなコストを払うことになるかもしれません」と続けています。

AIモデルの開発をより透明にするため、報告書は「信頼しつつ検証する」アプローチを提案しています。AIモデル開発者とその従業員が、内部安全性テストなど、公共にとって重要な事柄を報告する方法を持つべきであり、テストの主張を第三者に検証させる必要があると述べています。

2025年6月に最終化されるこの報告書は、特定の法律を支持するものではありませんが、AI政策議論の両側にいる専門家から好評を得ています。

SB 1047に反対していたジョージ・メイソン大学のAIに焦点を当てた研究員ディーン・ボール氏は、Xでこの報告書がカリフォルニアのAI安全規則にとって良い一歩だと述べました。また、昨年SB 1047を提出したカリフォルニア州上院議員スコット・ウィーナー氏によると、これはAI安全の擁護者にとって勝利です。ウィーナー氏はプレスリリースで、報告書が「2024年に議会で始めたAIガバナンスに関する緊急の議論に貢献する」と述べました。

報告書は、SB 1047やウィーナー氏の次の法案SB 53の一部に同意しており、AIモデル開発者に安全性テスト結果の報告を義務付けることを支持しています。大きな視点で見ると、これは過去1年間で勢いを失っていたAI安全の擁護者にとって、非常に必要な勝利のように見えます。

関連記事

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

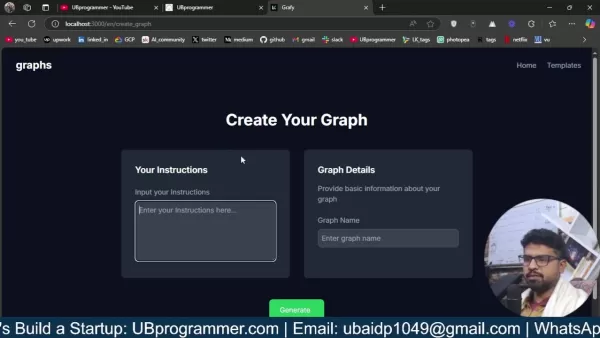

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

コメント (37)

0/200

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

コメント (37)

0/200

![HarrySmith]() HarrySmith

HarrySmith

2025年8月28日 6:01:36 JST

2025年8月28日 6:01:36 JST

This report sounds like a bold move! 😎 Fei-Fei Li’s team pushing for proactive AI laws is smart, but I wonder if lawmakers can keep up with tech’s pace. Preemptive rules could spark innovation or just create red tape. What do you all think?

0

0

![PaulHill]() PaulHill

PaulHill

2025年8月26日 0:01:14 JST

2025年8月26日 0:01:14 JST

Fei-Fei Li’s group is onto something big here! Proactive AI safety laws sound smart, but I wonder if lawmakers can keep up with tech’s pace. 🤔 Risky moves need bold rules!

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

2025年4月17日 21:14:46 JST

2025年4月17日 21:14:46 JST

O grupo de Fei-Fei Li sugerindo leis de segurança para IA antes mesmo de vermos os riscos? Parece proativo, mas também meio assustador! 🤔 Como se preparar para uma tempestade que pode nunca chegar. Ainda assim, melhor prevenir do que remediar, certo? Talvez devessem focar nos problemas atuais também? Só um pensamento! 😅

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

2025年4月17日 1:17:56 JST

2025年4月17日 1:17:56 JST

¿El grupo de Fei-Fei Li proponiendo leyes de seguridad para la IA antes de que veamos los riesgos? Suena proactivo pero también un poco aterrador! 🤔 Como prepararse para una tormenta que tal vez nunca llegue. Sin embargo, más vale prevenir que lamentar, ¿verdad? Tal vez deberían enfocarse también en los problemas actuales? Solo es un pensamiento! 😅

0

0

![AnthonyJohnson]() AnthonyJohnson

AnthonyJohnson

2025年4月16日 13:13:53 JST

2025年4月16日 13:13:53 JST

El grupo de Fei-Fei Li está realmente empujando por leyes de seguridad de IA proactivas, lo cual es genial. Pero, hombre, ¿ese informe de 41 páginas? Un poco difícil de digerir, ¿no crees? Aún así, es importante considerar los riesgos de IA no vistos. ¿Quizás podrían haberlo hecho un poco más conciso? 🤓📚

0

0

![WillieRodriguez]() WillieRodriguez

WillieRodriguez

2025年4月16日 8:01:01 JST

2025年4月16日 8:01:01 JST

Die Gruppe von Fei-Fei Li setzt sich wirklich für proaktive KI-Sicherheitsgesetze ein, das ist toll. Aber Mann, dieser 41-seitige Bericht? Ein bisschen viel zum Verdauen, findest du nicht? Trotzdem ist es wichtig, ungesehene KI-Risiken zu berücksichtigen. Vielleicht hätten sie es etwas kürzer fassen können? 🤓📚

0

0

カリフォルニアの政策グループが、AIのパイオニアであるフェイフェイ・リー氏が共同で主導する新しい報告書によると、議員はAI規制政策を作成する際に、現実世界でまだ見られていないAIのリスクを考慮すべきだとされています。この41ページの中間報告書は、火曜日に公開され、ギャビン・ニューサム知事がカリフォルニアの物議を醸したAI安全法案SB 1047を拒否した後、設立された「AIフロンティアモデルに関するカリフォルニア共同政策作業グループ」によるものです。ニューサム知事はSB 1047が目標に十分に合致していないと感じましたが、AIのリスクを深く調査し、立法者を導く必要性を認識しました。

報告書では、リー氏と共同著者のジェニファー・チェイズ(カリフォルニア大学バークレー校計算機科学部の学部長)、マリアーノ・フロレンティーノ・クエヤル(カーネギー国際平和財団の会長)が、OpenAIのようなフロンティアAIラボの活動を明確にする法律を求めています。報告書が公開される前に、チューリング賞受賞者のヨシュア・ベンジオのようなAI安全の強力な支持者や、Databricksの共同創業者イオン・ストイカのようなSB 1047に反対する業界関係者など、さまざまな立場の人々が報告書をレビューしました。

報告書は、AIシステムによる新たなリスクに対応するため、AIモデル開発者が安全性テスト、データの取得方法、セキュリティ対策を公開する必要がある法律が必要かもしれないと指摘しています。また、第三者によるこれらの項目や企業ポリシーのチェックのためのより高い基準や、AI企業の従業員や契約者が内部告発をする際の保護強化も求めています。

リー氏と共同著者は、AIがサイバー攻撃を支援したり、生物兵器を作成したり、その他の「極端な」危険を引き起こす可能性についての証拠がまだ十分でないと述べています。しかし、AI政策は現在起こっていることだけを扱うのではなく、十分な安全対策がなければ将来起こりうることについても考えるべきだとしています。

報告書は核兵器を例に挙げ、「核兵器が爆発しなくても、それが大きな害を引き起こす可能性があることはわかっています」と述べています。さらに、「最悪のリスクについて語る人々が正しい場合――それが本当になるかどうかはわかりませんが――今、フロンティアAIについて何もしなければ、非常に大きなコストを払うことになるかもしれません」と続けています。

AIモデルの開発をより透明にするため、報告書は「信頼しつつ検証する」アプローチを提案しています。AIモデル開発者とその従業員が、内部安全性テストなど、公共にとって重要な事柄を報告する方法を持つべきであり、テストの主張を第三者に検証させる必要があると述べています。

2025年6月に最終化されるこの報告書は、特定の法律を支持するものではありませんが、AI政策議論の両側にいる専門家から好評を得ています。

SB 1047に反対していたジョージ・メイソン大学のAIに焦点を当てた研究員ディーン・ボール氏は、Xでこの報告書がカリフォルニアのAI安全規則にとって良い一歩だと述べました。また、昨年SB 1047を提出したカリフォルニア州上院議員スコット・ウィーナー氏によると、これはAI安全の擁護者にとって勝利です。ウィーナー氏はプレスリリースで、報告書が「2024年に議会で始めたAIガバナンスに関する緊急の議論に貢献する」と述べました。

報告書は、SB 1047やウィーナー氏の次の法案SB 53の一部に同意しており、AIモデル開発者に安全性テスト結果の報告を義務付けることを支持しています。大きな視点で見ると、これは過去1年間で勢いを失っていたAI安全の擁護者にとって、非常に必要な勝利のように見えます。

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

AIがマイケル・ジャクソンをメタバースで再構築、驚異的なデジタル変換を実現

人工知能は、創造性、エンターテインメント、文化的遺産に対する我々の理解を根本的に作り変えつつある。AIが生成したマイケル・ジャクソンの解釈を探求することで、最先端のテクノロジーが伝説的な文化人にいかに新たな命を吹き込むことができるかが明らかになる。スーパーヒーローの化身からファンタジーの世界の戦士まで、画期的な変身は、デジタル・アートと仮想世界体験の地平を広げながら、キング・オブ・ポップを再発明す

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

トレーニングはAIによる認知オフロード効果を軽減するか?

Unite.aiの最近の調査記事「ChatGPTはあなたの脳を消耗させているかもしれない:AI時代の認知負債」と題されたUnite.iの最近の調査記事で、MITの研究に光が当てられた。ジャーナリストのアレックス・マクファーランドは、過度のAI依存がいかに本質的な認知能力、特に批判的思考や判断力を蝕むかについて、説得力のある証拠を詳述した。これらの知見は他の多くの研究と一致しているが、現在の喫緊の課

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

AIを活用したグラフやビジュアライゼーションを簡単に作成し、より優れたデータインサイトを実現

現代のデータ分析では、複雑な情報を直感的に視覚化することが求められています。AIを活用したグラフ生成ソリューションは、生データを説得力のあるビジュアルストーリーに変換する専門家の方法に革命をもたらし、不可欠な資産として登場しました。これらのインテリジェントなシステムは、精度を保ちながら手作業によるグラフ作成を排除し、技術的なユーザーにもそうでないユーザーにも、自動化された視覚化を通じて実用的な洞察

2025年8月28日 6:01:36 JST

2025年8月28日 6:01:36 JST

This report sounds like a bold move! 😎 Fei-Fei Li’s team pushing for proactive AI laws is smart, but I wonder if lawmakers can keep up with tech’s pace. Preemptive rules could spark innovation or just create red tape. What do you all think?

0

0

2025年8月26日 0:01:14 JST

2025年8月26日 0:01:14 JST

Fei-Fei Li’s group is onto something big here! Proactive AI safety laws sound smart, but I wonder if lawmakers can keep up with tech’s pace. 🤔 Risky moves need bold rules!

0

0

2025年4月17日 21:14:46 JST

2025年4月17日 21:14:46 JST

O grupo de Fei-Fei Li sugerindo leis de segurança para IA antes mesmo de vermos os riscos? Parece proativo, mas também meio assustador! 🤔 Como se preparar para uma tempestade que pode nunca chegar. Ainda assim, melhor prevenir do que remediar, certo? Talvez devessem focar nos problemas atuais também? Só um pensamento! 😅

0

0

2025年4月17日 1:17:56 JST

2025年4月17日 1:17:56 JST

¿El grupo de Fei-Fei Li proponiendo leyes de seguridad para la IA antes de que veamos los riesgos? Suena proactivo pero también un poco aterrador! 🤔 Como prepararse para una tormenta que tal vez nunca llegue. Sin embargo, más vale prevenir que lamentar, ¿verdad? Tal vez deberían enfocarse también en los problemas actuales? Solo es un pensamiento! 😅

0

0

2025年4月16日 13:13:53 JST

2025年4月16日 13:13:53 JST

El grupo de Fei-Fei Li está realmente empujando por leyes de seguridad de IA proactivas, lo cual es genial. Pero, hombre, ¿ese informe de 41 páginas? Un poco difícil de digerir, ¿no crees? Aún así, es importante considerar los riesgos de IA no vistos. ¿Quizás podrían haberlo hecho un poco más conciso? 🤓📚

0

0

2025年4月16日 8:01:01 JST

2025年4月16日 8:01:01 JST

Die Gruppe von Fei-Fei Li setzt sich wirklich für proaktive KI-Sicherheitsgesetze ein, das ist toll. Aber Mann, dieser 41-seitige Bericht? Ein bisschen viel zum Verdauen, findest du nicht? Trotzdem ist es wichtig, ungesehene KI-Risiken zu berücksichtigen. Vielleicht hätten sie es etwas kürzer fassen können? 🤓📚

0

0