Die Gruppe von Fei-Fei Li fordert die vorbeugende KI-Sicherheitsgesetzgebung auf

Ein neuer Bericht einer kalifornischen Politikgruppe, geleitet von der KI-Pionierin Fei-Fei Li, schlägt vor, dass Gesetzgeber bei der Erstellung von KI-Regulierungspolitiken auch KI-Risiken berücksichtigen sollten, die in der realen Welt noch nicht aufgetreten sind. Dieser 41-seitige Zwischenbericht, am Dienstag veröffentlicht, stammt von der Joint California Policy Working Group on AI Frontier Models, die von Gouverneur Gavin Newsom eingerichtet wurde, nachdem er das umstrittene kalifornische KI-Sicherheitsgesetz SB 1047 abgelehnt hatte. Newsom war der Ansicht, dass SB 1047 nicht ganz ins Schwarze traf, erkannte jedoch die Notwendigkeit einer tiefergehenden Untersuchung von KI-Risiken, um die Gesetzgeber zu leiten.

In dem Bericht fordern Li, zusammen mit den Mitautoren Jennifer Chayes, Dekanin des College of Computing der UC Berkeley, und Mariano-Florentino Cuéllar, Präsident der Carnegie Endowment for International Peace, Gesetze, die klarer machen, was KI-Labore wie OpenAI tun. Vor der Veröffentlichung des Berichts wurde er von Branchenvertretern aus verschiedenen Bereichen geprüft, darunter starke Befürworter der KI-Sicherheit wie der Turing-Preisträger Yoshua Bengio und Gegner von SB 1047 wie der Databricks-Mitgründer Ion Stoica.

Der Bericht weist darauf hin, dass neue Risiken von KI-Systemen Gesetze erforderlich machen könnten, die Entwickler von KI-Modellen dazu verpflichten, ihre Sicherheitstests, Datenquellen und Sicherheitsmaßnahmen öffentlich zu teilen. Er fordert zudem bessere Standards für unabhängige Überprüfungen dieser Aspekte und Unternehmensrichtlinien sowie mehr Schutz für Mitarbeiter und Auftragnehmer von KI-Unternehmen, die Missstände melden.

Li und ihre Mitautoren erwähnen, dass es noch nicht genügend Beweise für das Potenzial von KI gibt, Cyberangriffe zu unterstützen, biologische Waffen herzustellen oder andere „extreme“ Gefahren zu verursachen. Sie betonen jedoch, dass KI-Politik nicht nur auf aktuelle Ereignisse reagieren sollte, sondern auch zukünftige Risiken berücksichtigen muss, wenn keine ausreichenden Sicherheitsmaßnahmen vorhanden sind.

Der Bericht verwendet das Beispiel einer Atomwaffe und sagt: „Wir müssen keine Atomwaffe explodieren sehen, um zu wissen, dass sie großen Schaden anrichten könnte.“ Er fährt fort: „Wenn diejenigen, die von den schlimmsten Risiken sprechen, recht haben – und wir sind uns nicht sicher, ob sie es sein werden –, dann könnte es sehr kostspielig sein, jetzt nichts in Bezug auf Frontier-KI zu unternehmen.“

Um die Entwicklung von KI-Modellen transparenter zu gestalten, schlägt der Bericht einen „Vertrauen, aber überprüfen“-Ansatz vor. Er besagt, dass KI-Modellentwickler und ihre Mitarbeiter Möglichkeiten haben sollten, über für die Öffentlichkeit relevante Dinge wie interne Sicherheitstests zu berichten, und dass ihre Testaussagen von Dritten überprüft werden müssen.

Obwohl der Bericht, der im Juni 2025 abgeschlossen wird, keine spezifischen Gesetze unterstützt, wurde er von Experten auf beiden Seiten der KI-Politikdebatte positiv aufgenommen.

Dean Ball, ein auf KI fokussierter Forschungsfellow an der George Mason University, der SB 1047 ablehnte, sagte auf X, dass der Bericht ein guter Schritt für die KI-Sicherheitsregeln Kaliforniens sei. Es ist auch ein Erfolg für KI-Sicherheitsbefürworter, laut dem kalifornischen Staatssenator Scott Wiener, der SB 1047 im letzten Jahr eingebracht hatte. Wiener sagte in einer Pressemitteilung, dass der Bericht zu den „dringenden Gesprächen über KI-Governance beiträgt, die wir 2024 im Gesetzgeber begonnen haben.“

Der Bericht stimmt teilweise mit SB 1047 und Wieners nächstem Gesetz, SB 53, überein, wie der Forderung, dass KI-Modellentwickler ihre Sicherheitstestresultate berichten. Insgesamt scheint es ein dringend benötigter Erfolg für KI-Sicherheitsbefürworter zu sein, deren Ideen im vergangenen Jahr an Boden verloren haben.

Verwandter Artikel

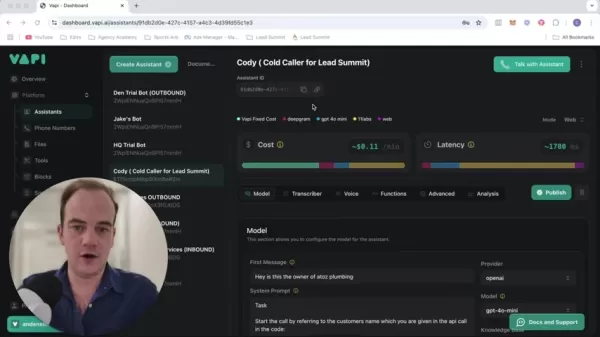

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Kommentare (37)

0/200

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Kommentare (37)

0/200

![HarrySmith]() HarrySmith

HarrySmith

27. August 2025 23:01:36 MESZ

27. August 2025 23:01:36 MESZ

This report sounds like a bold move! 😎 Fei-Fei Li’s team pushing for proactive AI laws is smart, but I wonder if lawmakers can keep up with tech’s pace. Preemptive rules could spark innovation or just create red tape. What do you all think?

0

0

![PaulHill]() PaulHill

PaulHill

25. August 2025 17:01:14 MESZ

25. August 2025 17:01:14 MESZ

Fei-Fei Li’s group is onto something big here! Proactive AI safety laws sound smart, but I wonder if lawmakers can keep up with tech’s pace. 🤔 Risky moves need bold rules!

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

17. April 2025 14:14:46 MESZ

17. April 2025 14:14:46 MESZ

O grupo de Fei-Fei Li sugerindo leis de segurança para IA antes mesmo de vermos os riscos? Parece proativo, mas também meio assustador! 🤔 Como se preparar para uma tempestade que pode nunca chegar. Ainda assim, melhor prevenir do que remediar, certo? Talvez devessem focar nos problemas atuais também? Só um pensamento! 😅

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

16. April 2025 18:17:56 MESZ

16. April 2025 18:17:56 MESZ

¿El grupo de Fei-Fei Li proponiendo leyes de seguridad para la IA antes de que veamos los riesgos? Suena proactivo pero también un poco aterrador! 🤔 Como prepararse para una tormenta que tal vez nunca llegue. Sin embargo, más vale prevenir que lamentar, ¿verdad? Tal vez deberían enfocarse también en los problemas actuales? Solo es un pensamiento! 😅

0

0

![AnthonyJohnson]() AnthonyJohnson

AnthonyJohnson

16. April 2025 06:13:53 MESZ

16. April 2025 06:13:53 MESZ

El grupo de Fei-Fei Li está realmente empujando por leyes de seguridad de IA proactivas, lo cual es genial. Pero, hombre, ¿ese informe de 41 páginas? Un poco difícil de digerir, ¿no crees? Aún así, es importante considerar los riesgos de IA no vistos. ¿Quizás podrían haberlo hecho un poco más conciso? 🤓📚

0

0

![WillieRodriguez]() WillieRodriguez

WillieRodriguez

16. April 2025 01:01:01 MESZ

16. April 2025 01:01:01 MESZ

Die Gruppe von Fei-Fei Li setzt sich wirklich für proaktive KI-Sicherheitsgesetze ein, das ist toll. Aber Mann, dieser 41-seitige Bericht? Ein bisschen viel zum Verdauen, findest du nicht? Trotzdem ist es wichtig, ungesehene KI-Risiken zu berücksichtigen. Vielleicht hätten sie es etwas kürzer fassen können? 🤓📚

0

0

Ein neuer Bericht einer kalifornischen Politikgruppe, geleitet von der KI-Pionierin Fei-Fei Li, schlägt vor, dass Gesetzgeber bei der Erstellung von KI-Regulierungspolitiken auch KI-Risiken berücksichtigen sollten, die in der realen Welt noch nicht aufgetreten sind. Dieser 41-seitige Zwischenbericht, am Dienstag veröffentlicht, stammt von der Joint California Policy Working Group on AI Frontier Models, die von Gouverneur Gavin Newsom eingerichtet wurde, nachdem er das umstrittene kalifornische KI-Sicherheitsgesetz SB 1047 abgelehnt hatte. Newsom war der Ansicht, dass SB 1047 nicht ganz ins Schwarze traf, erkannte jedoch die Notwendigkeit einer tiefergehenden Untersuchung von KI-Risiken, um die Gesetzgeber zu leiten.

In dem Bericht fordern Li, zusammen mit den Mitautoren Jennifer Chayes, Dekanin des College of Computing der UC Berkeley, und Mariano-Florentino Cuéllar, Präsident der Carnegie Endowment for International Peace, Gesetze, die klarer machen, was KI-Labore wie OpenAI tun. Vor der Veröffentlichung des Berichts wurde er von Branchenvertretern aus verschiedenen Bereichen geprüft, darunter starke Befürworter der KI-Sicherheit wie der Turing-Preisträger Yoshua Bengio und Gegner von SB 1047 wie der Databricks-Mitgründer Ion Stoica.

Der Bericht weist darauf hin, dass neue Risiken von KI-Systemen Gesetze erforderlich machen könnten, die Entwickler von KI-Modellen dazu verpflichten, ihre Sicherheitstests, Datenquellen und Sicherheitsmaßnahmen öffentlich zu teilen. Er fordert zudem bessere Standards für unabhängige Überprüfungen dieser Aspekte und Unternehmensrichtlinien sowie mehr Schutz für Mitarbeiter und Auftragnehmer von KI-Unternehmen, die Missstände melden.

Li und ihre Mitautoren erwähnen, dass es noch nicht genügend Beweise für das Potenzial von KI gibt, Cyberangriffe zu unterstützen, biologische Waffen herzustellen oder andere „extreme“ Gefahren zu verursachen. Sie betonen jedoch, dass KI-Politik nicht nur auf aktuelle Ereignisse reagieren sollte, sondern auch zukünftige Risiken berücksichtigen muss, wenn keine ausreichenden Sicherheitsmaßnahmen vorhanden sind.

Der Bericht verwendet das Beispiel einer Atomwaffe und sagt: „Wir müssen keine Atomwaffe explodieren sehen, um zu wissen, dass sie großen Schaden anrichten könnte.“ Er fährt fort: „Wenn diejenigen, die von den schlimmsten Risiken sprechen, recht haben – und wir sind uns nicht sicher, ob sie es sein werden –, dann könnte es sehr kostspielig sein, jetzt nichts in Bezug auf Frontier-KI zu unternehmen.“

Um die Entwicklung von KI-Modellen transparenter zu gestalten, schlägt der Bericht einen „Vertrauen, aber überprüfen“-Ansatz vor. Er besagt, dass KI-Modellentwickler und ihre Mitarbeiter Möglichkeiten haben sollten, über für die Öffentlichkeit relevante Dinge wie interne Sicherheitstests zu berichten, und dass ihre Testaussagen von Dritten überprüft werden müssen.

Obwohl der Bericht, der im Juni 2025 abgeschlossen wird, keine spezifischen Gesetze unterstützt, wurde er von Experten auf beiden Seiten der KI-Politikdebatte positiv aufgenommen.

Dean Ball, ein auf KI fokussierter Forschungsfellow an der George Mason University, der SB 1047 ablehnte, sagte auf X, dass der Bericht ein guter Schritt für die KI-Sicherheitsregeln Kaliforniens sei. Es ist auch ein Erfolg für KI-Sicherheitsbefürworter, laut dem kalifornischen Staatssenator Scott Wiener, der SB 1047 im letzten Jahr eingebracht hatte. Wiener sagte in einer Pressemitteilung, dass der Bericht zu den „dringenden Gesprächen über KI-Governance beiträgt, die wir 2024 im Gesetzgeber begonnen haben.“

Der Bericht stimmt teilweise mit SB 1047 und Wieners nächstem Gesetz, SB 53, überein, wie der Forderung, dass KI-Modellentwickler ihre Sicherheitstestresultate berichten. Insgesamt scheint es ein dringend benötigter Erfolg für KI-Sicherheitsbefürworter zu sein, deren Ideen im vergangenen Jahr an Boden verloren haben.

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Transformieren Sie Ihre Vertriebsstrategie: AI Cold Calling Technologie von Vapi

Moderne Unternehmen arbeiten blitzschnell und benötigen innovative Lösungen, um wettbewerbsfähig zu bleiben. Stellen Sie sich vor, Sie revolutionieren die Kontaktaufnahme Ihrer Agentur mit einem KI-ge

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Die besten AI-Tools für die Erstellung von Infografiken im Bildungsbereich - Design-Tipps und -Techniken

In der heutigen digital geprägten Bildungslandschaft haben sich Infografiken zu einem transformativen Kommunikationsmedium entwickelt, das komplexe Informationen in visuell ansprechende, leicht verstä

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

Topaz DeNoise AI: Das beste Tool zur Rauschunterdrückung im Jahr 2025 - Vollständige Anleitung

In der wettbewerbsintensiven Welt der Digitalfotografie ist die Bildschärfe nach wie vor von größter Bedeutung. Fotografen aller Erfahrungsstufen haben mit digitalem Rauschen zu kämpfen, das ansonsten

27. August 2025 23:01:36 MESZ

27. August 2025 23:01:36 MESZ

This report sounds like a bold move! 😎 Fei-Fei Li’s team pushing for proactive AI laws is smart, but I wonder if lawmakers can keep up with tech’s pace. Preemptive rules could spark innovation or just create red tape. What do you all think?

0

0

25. August 2025 17:01:14 MESZ

25. August 2025 17:01:14 MESZ

Fei-Fei Li’s group is onto something big here! Proactive AI safety laws sound smart, but I wonder if lawmakers can keep up with tech’s pace. 🤔 Risky moves need bold rules!

0

0

17. April 2025 14:14:46 MESZ

17. April 2025 14:14:46 MESZ

O grupo de Fei-Fei Li sugerindo leis de segurança para IA antes mesmo de vermos os riscos? Parece proativo, mas também meio assustador! 🤔 Como se preparar para uma tempestade que pode nunca chegar. Ainda assim, melhor prevenir do que remediar, certo? Talvez devessem focar nos problemas atuais também? Só um pensamento! 😅

0

0

16. April 2025 18:17:56 MESZ

16. April 2025 18:17:56 MESZ

¿El grupo de Fei-Fei Li proponiendo leyes de seguridad para la IA antes de que veamos los riesgos? Suena proactivo pero también un poco aterrador! 🤔 Como prepararse para una tormenta que tal vez nunca llegue. Sin embargo, más vale prevenir que lamentar, ¿verdad? Tal vez deberían enfocarse también en los problemas actuales? Solo es un pensamiento! 😅

0

0

16. April 2025 06:13:53 MESZ

16. April 2025 06:13:53 MESZ

El grupo de Fei-Fei Li está realmente empujando por leyes de seguridad de IA proactivas, lo cual es genial. Pero, hombre, ¿ese informe de 41 páginas? Un poco difícil de digerir, ¿no crees? Aún así, es importante considerar los riesgos de IA no vistos. ¿Quizás podrían haberlo hecho un poco más conciso? 🤓📚

0

0

16. April 2025 01:01:01 MESZ

16. April 2025 01:01:01 MESZ

Die Gruppe von Fei-Fei Li setzt sich wirklich für proaktive KI-Sicherheitsgesetze ein, das ist toll. Aber Mann, dieser 41-seitige Bericht? Ein bisschen viel zum Verdauen, findest du nicht? Trotzdem ist es wichtig, ungesehene KI-Risiken zu berücksichtigen. Vielleicht hätten sie es etwas kürzer fassen können? 🤓📚

0

0