Fei-Fei Li의 그룹은 선제 적 AI 안전법을 촉구합니다

캘리포니아 정책 그룹의 새로운 보고서에 따르면, AI 개척자 페이-페이 리(Fei-Fei Li)가 공동으로 이끄는 이 그룹은 법률 제정자들이 AI 규제 정책을 만들 때 아직 실세계에서 관찰되지 않은 AI 위험을 고려해야 한다고 제안했다. 화요일에 발표된 이 41페이지 분량의 중간 보고서는 캘리포니아 주지사 개빈 뉴섬(Gavin Newsom)이 논란이 되었던 캘리포니아 AI 안전 법안 SB 1047을 거부한 후 설립한 AI 프론티어 모델에 관한 캘리포니아 정책 워킹 그룹(Joint California Policy Working Group on AI Frontier Models)에서 나왔다. 뉴섬은 SB 1047이 목표에 정확히 부합하지 않는다고 느꼈지만, 입법자들을 안내하기 위해 AI 위험에 대한 더 깊은 조사가 필요하다는 점을 인식했다.

보고서에서 리는 UC 버클리 컴퓨팅 학부 학장 제니퍼 체이스(Jennifer Chayes)와 카네기 국제평화재단 회장 마리아노-플로렌티노 쿠에야르(Mariano-Florentino Cuéllar)와 함께, OpenAI 같은 프론티어 AI 연구소들이 무엇을 하고 있는지 더 명확히 하기 위한 법률을 추진했다. 보고서가 공개되기 전에, 튜링상 수상자 요슈아 벤지오(Yoshua Bengio)와 같은 강력한 AI 안전 지지자들과 Databricks 공동 설립자 이온 스토이카(Ion Stoica)처럼 SB 1047에 반대한 다양한 업계 관계자들이 보고서를 검토했다.

보고서는 AI 시스템의 새로운 위험으로 인해 AI 모델 개발자들이 안전 테스트, 데이터 획득 방법, 보안 조치를 대중과 공유하도록 하는 법률이 필요할 수 있다고 지적했다. 또한, 이에 대한 제3자 검증과 회사 정책에 대한 더 나은 기준, 그리고 AI 회사 직원 및 계약자들이 내부 고발을 할 때 더 많은 보호를 요구했다.

리와 공동 저자들은 AI가 사이버 공격을 돕거나, 생물학 무기를 만들거나, 기타 "극단적인" 위험을 초래할 가능성에 대한 증거가 아직 충분하지 않다고 언급했다. 하지만 그들은 AI 정책이 현재 일어나고 있는 일만 다루는 것이 아니라, 충분한 안전 조치가 마련되지 않을 경우 미래에 일어날 수 있는 일도 고려해야 한다고 말했다.

보고서는 핵무기를 예로 들며, "핵무기가 터지는 것을 보지 않아도 그것이 큰 해를 끼칠 수 있다는 것을 안다"고 밝혔다. 이어서, "최악의 위험을 이야기하는 사람들이 옳다면 — 그리고 그들이 옳을지 확실하지 않지만 — 지금 프론티어 AI에 대해 아무 조치도 취하지 않는다면 매우 큰 대가를 치를 수 있다"고 덧붙였다.

AI 모델 개발을 더 투명하게 하기 위해 보고서는 "신뢰하되 검증하라"는 접근 방식을 제안했다. AI 모델 개발자와 그들의 직원들이 내부 안전 테스트와 같은 대중에게 중요한 사항을 보고할 수 있는 방법을 마련해야 하며, 테스트 주장도 제3자에 의해 검증받아야 한다고 밝혔다.

2025년 6월에 최종화될 이 보고서는 특정 법률을 지지하지 않지만, AI 정책 논쟁의 양측 전문가들에게 좋은 평가를 받았다.

SB 1047을 좋아하지 않았던 조지 메이슨 대학교의 AI 중심 연구원 딘 볼(Dean Ball)은 X에서 이 보고서가 캘리포니아의 AI 안전 규칙에 좋은 진전이라고 말했다. 또한, 작년에 SB 1047을 발의한 캘리포니아 주 상원의원 스콧 위너(Scott Wiener)에 따르면, 이는 AI 안전 옹호자들에게도 승리라고 한다. 위너는 보도자료에서 이 보고서가 "2024년에 주의회에서 시작한 AI 거버넌스에 대한 긴급한 논의를 강화한다"고 말했다.

보고서는 SB 1047과 위너의 다음 법안 SB 53의 일부, 예를 들어 AI 모델 개발자들이 안전 테스트 결과를 보고하도록 하는 부분과 일치하는 것으로 보인다. 더 큰 그림을 보면, 이는 지난 1년 동안 지지를 잃어왔던 AI 안전 옹호자들에게 매우 필요한 승리로 보인다.

관련 기사

놀라운 디지털 혁신으로 메타버스에서 마이클 잭슨을 재창조하는 AI

인공지능은 창의성, 엔터테인먼트, 문화 유산에 대한 우리의 이해를 근본적으로 바꾸고 있습니다. 마이클 잭슨에 대한 인공지능의 해석을 통해 최첨단 기술이 어떻게 전설적인 문화 인물에 새로운 생명을 불어넣을 수 있는지 살펴봅니다. 슈퍼 히어로의 화신에서 판타지 세계의 전사에 이르기까지 획기적인 변신은 디지털 아트와 가상 세계 경험의 지평을 넓히는 동시에 팝의

놀라운 디지털 혁신으로 메타버스에서 마이클 잭슨을 재창조하는 AI

인공지능은 창의성, 엔터테인먼트, 문화 유산에 대한 우리의 이해를 근본적으로 바꾸고 있습니다. 마이클 잭슨에 대한 인공지능의 해석을 통해 최첨단 기술이 어떻게 전설적인 문화 인물에 새로운 생명을 불어넣을 수 있는지 살펴봅니다. 슈퍼 히어로의 화신에서 판타지 세계의 전사에 이르기까지 획기적인 변신은 디지털 아트와 가상 세계 경험의 지평을 넓히는 동시에 팝의

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

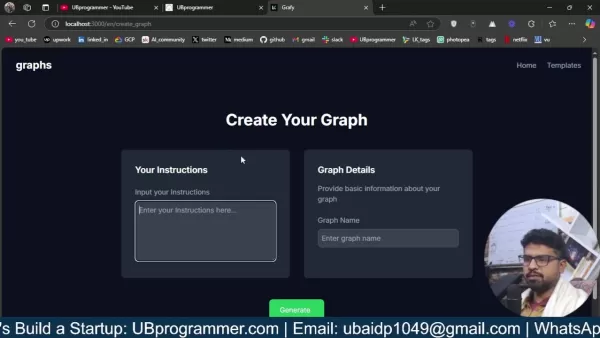

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

의견 (37)

0/200

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

의견 (37)

0/200

![HarrySmith]() HarrySmith

HarrySmith

2025년 8월 28일 오전 6시 1분 36초 GMT+09:00

2025년 8월 28일 오전 6시 1분 36초 GMT+09:00

This report sounds like a bold move! 😎 Fei-Fei Li’s team pushing for proactive AI laws is smart, but I wonder if lawmakers can keep up with tech’s pace. Preemptive rules could spark innovation or just create red tape. What do you all think?

0

0

![PaulHill]() PaulHill

PaulHill

2025년 8월 26일 오전 12시 1분 14초 GMT+09:00

2025년 8월 26일 오전 12시 1분 14초 GMT+09:00

Fei-Fei Li’s group is onto something big here! Proactive AI safety laws sound smart, but I wonder if lawmakers can keep up with tech’s pace. 🤔 Risky moves need bold rules!

0

0

![MichaelDavis]() MichaelDavis

MichaelDavis

2025년 4월 17일 오후 9시 14분 46초 GMT+09:00

2025년 4월 17일 오후 9시 14분 46초 GMT+09:00

O grupo de Fei-Fei Li sugerindo leis de segurança para IA antes mesmo de vermos os riscos? Parece proativo, mas também meio assustador! 🤔 Como se preparar para uma tempestade que pode nunca chegar. Ainda assim, melhor prevenir do que remediar, certo? Talvez devessem focar nos problemas atuais também? Só um pensamento! 😅

0

0

![JasonRoberts]() JasonRoberts

JasonRoberts

2025년 4월 17일 오전 1시 17분 56초 GMT+09:00

2025년 4월 17일 오전 1시 17분 56초 GMT+09:00

¿El grupo de Fei-Fei Li proponiendo leyes de seguridad para la IA antes de que veamos los riesgos? Suena proactivo pero también un poco aterrador! 🤔 Como prepararse para una tormenta que tal vez nunca llegue. Sin embargo, más vale prevenir que lamentar, ¿verdad? Tal vez deberían enfocarse también en los problemas actuales? Solo es un pensamiento! 😅

0

0

![AnthonyJohnson]() AnthonyJohnson

AnthonyJohnson

2025년 4월 16일 오후 1시 13분 53초 GMT+09:00

2025년 4월 16일 오후 1시 13분 53초 GMT+09:00

El grupo de Fei-Fei Li está realmente empujando por leyes de seguridad de IA proactivas, lo cual es genial. Pero, hombre, ¿ese informe de 41 páginas? Un poco difícil de digerir, ¿no crees? Aún así, es importante considerar los riesgos de IA no vistos. ¿Quizás podrían haberlo hecho un poco más conciso? 🤓📚

0

0

![WillieRodriguez]() WillieRodriguez

WillieRodriguez

2025년 4월 16일 오전 8시 1분 1초 GMT+09:00

2025년 4월 16일 오전 8시 1분 1초 GMT+09:00

Die Gruppe von Fei-Fei Li setzt sich wirklich für proaktive KI-Sicherheitsgesetze ein, das ist toll. Aber Mann, dieser 41-seitige Bericht? Ein bisschen viel zum Verdauen, findest du nicht? Trotzdem ist es wichtig, ungesehene KI-Risiken zu berücksichtigen. Vielleicht hätten sie es etwas kürzer fassen können? 🤓📚

0

0

캘리포니아 정책 그룹의 새로운 보고서에 따르면, AI 개척자 페이-페이 리(Fei-Fei Li)가 공동으로 이끄는 이 그룹은 법률 제정자들이 AI 규제 정책을 만들 때 아직 실세계에서 관찰되지 않은 AI 위험을 고려해야 한다고 제안했다. 화요일에 발표된 이 41페이지 분량의 중간 보고서는 캘리포니아 주지사 개빈 뉴섬(Gavin Newsom)이 논란이 되었던 캘리포니아 AI 안전 법안 SB 1047을 거부한 후 설립한 AI 프론티어 모델에 관한 캘리포니아 정책 워킹 그룹(Joint California Policy Working Group on AI Frontier Models)에서 나왔다. 뉴섬은 SB 1047이 목표에 정확히 부합하지 않는다고 느꼈지만, 입법자들을 안내하기 위해 AI 위험에 대한 더 깊은 조사가 필요하다는 점을 인식했다.

보고서에서 리는 UC 버클리 컴퓨팅 학부 학장 제니퍼 체이스(Jennifer Chayes)와 카네기 국제평화재단 회장 마리아노-플로렌티노 쿠에야르(Mariano-Florentino Cuéllar)와 함께, OpenAI 같은 프론티어 AI 연구소들이 무엇을 하고 있는지 더 명확히 하기 위한 법률을 추진했다. 보고서가 공개되기 전에, 튜링상 수상자 요슈아 벤지오(Yoshua Bengio)와 같은 강력한 AI 안전 지지자들과 Databricks 공동 설립자 이온 스토이카(Ion Stoica)처럼 SB 1047에 반대한 다양한 업계 관계자들이 보고서를 검토했다.

보고서는 AI 시스템의 새로운 위험으로 인해 AI 모델 개발자들이 안전 테스트, 데이터 획득 방법, 보안 조치를 대중과 공유하도록 하는 법률이 필요할 수 있다고 지적했다. 또한, 이에 대한 제3자 검증과 회사 정책에 대한 더 나은 기준, 그리고 AI 회사 직원 및 계약자들이 내부 고발을 할 때 더 많은 보호를 요구했다.

리와 공동 저자들은 AI가 사이버 공격을 돕거나, 생물학 무기를 만들거나, 기타 "극단적인" 위험을 초래할 가능성에 대한 증거가 아직 충분하지 않다고 언급했다. 하지만 그들은 AI 정책이 현재 일어나고 있는 일만 다루는 것이 아니라, 충분한 안전 조치가 마련되지 않을 경우 미래에 일어날 수 있는 일도 고려해야 한다고 말했다.

보고서는 핵무기를 예로 들며, "핵무기가 터지는 것을 보지 않아도 그것이 큰 해를 끼칠 수 있다는 것을 안다"고 밝혔다. 이어서, "최악의 위험을 이야기하는 사람들이 옳다면 — 그리고 그들이 옳을지 확실하지 않지만 — 지금 프론티어 AI에 대해 아무 조치도 취하지 않는다면 매우 큰 대가를 치를 수 있다"고 덧붙였다.

AI 모델 개발을 더 투명하게 하기 위해 보고서는 "신뢰하되 검증하라"는 접근 방식을 제안했다. AI 모델 개발자와 그들의 직원들이 내부 안전 테스트와 같은 대중에게 중요한 사항을 보고할 수 있는 방법을 마련해야 하며, 테스트 주장도 제3자에 의해 검증받아야 한다고 밝혔다.

2025년 6월에 최종화될 이 보고서는 특정 법률을 지지하지 않지만, AI 정책 논쟁의 양측 전문가들에게 좋은 평가를 받았다.

SB 1047을 좋아하지 않았던 조지 메이슨 대학교의 AI 중심 연구원 딘 볼(Dean Ball)은 X에서 이 보고서가 캘리포니아의 AI 안전 규칙에 좋은 진전이라고 말했다. 또한, 작년에 SB 1047을 발의한 캘리포니아 주 상원의원 스콧 위너(Scott Wiener)에 따르면, 이는 AI 안전 옹호자들에게도 승리라고 한다. 위너는 보도자료에서 이 보고서가 "2024년에 주의회에서 시작한 AI 거버넌스에 대한 긴급한 논의를 강화한다"고 말했다.

보고서는 SB 1047과 위너의 다음 법안 SB 53의 일부, 예를 들어 AI 모델 개발자들이 안전 테스트 결과를 보고하도록 하는 부분과 일치하는 것으로 보인다. 더 큰 그림을 보면, 이는 지난 1년 동안 지지를 잃어왔던 AI 안전 옹호자들에게 매우 필요한 승리로 보인다.

놀라운 디지털 혁신으로 메타버스에서 마이클 잭슨을 재창조하는 AI

인공지능은 창의성, 엔터테인먼트, 문화 유산에 대한 우리의 이해를 근본적으로 바꾸고 있습니다. 마이클 잭슨에 대한 인공지능의 해석을 통해 최첨단 기술이 어떻게 전설적인 문화 인물에 새로운 생명을 불어넣을 수 있는지 살펴봅니다. 슈퍼 히어로의 화신에서 판타지 세계의 전사에 이르기까지 획기적인 변신은 디지털 아트와 가상 세계 경험의 지평을 넓히는 동시에 팝의

놀라운 디지털 혁신으로 메타버스에서 마이클 잭슨을 재창조하는 AI

인공지능은 창의성, 엔터테인먼트, 문화 유산에 대한 우리의 이해를 근본적으로 바꾸고 있습니다. 마이클 잭슨에 대한 인공지능의 해석을 통해 최첨단 기술이 어떻게 전설적인 문화 인물에 새로운 생명을 불어넣을 수 있는지 살펴봅니다. 슈퍼 히어로의 화신에서 판타지 세계의 전사에 이르기까지 획기적인 변신은 디지털 아트와 가상 세계 경험의 지평을 넓히는 동시에 팝의

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

훈련이 AI로 인한 인지 오프로딩 효과를 완화할 수 있나요?

최근 Unite.ai의 'ChatGPT가 뇌를 고갈시킬 수 있습니다: 인공지능 시대의 인지적 부채'라는 제목의 기사에서 MIT의 연구 결과를 조명했습니다. 저널리스트 알렉스 맥팔랜드는 과도한 AI 의존도가 어떻게 필수적인 인지 능력, 특히 비판적 사고와 판단력을 약화시킬 수 있는지에 대한 설득력 있는 증거를 자세히 설명했습니다. 이러한 연구 결과는 다른 수

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

더 나은 데이터 인사이트를 위한 AI 기반 그래프 및 시각화를 쉽게 생성하기

최신 데이터 분석에는 복잡한 정보를 직관적으로 시각화할 수 있어야 합니다. AI 기반 그래프 생성 솔루션은 전문가들이 원시 데이터를 매력적인 시각적 스토리로 변환하는 방법에 혁신을 일으키며 필수적인 자산으로 부상했습니다. 이러한 지능형 시스템은 정밀도를 유지하면서 수동 차트 생성을 제거하여 기술 및 비기술 사용자 모두 자동화된 시각화를 통해 실행 가능한 인

2025년 8월 28일 오전 6시 1분 36초 GMT+09:00

2025년 8월 28일 오전 6시 1분 36초 GMT+09:00

This report sounds like a bold move! 😎 Fei-Fei Li’s team pushing for proactive AI laws is smart, but I wonder if lawmakers can keep up with tech’s pace. Preemptive rules could spark innovation or just create red tape. What do you all think?

0

0

2025년 8월 26일 오전 12시 1분 14초 GMT+09:00

2025년 8월 26일 오전 12시 1분 14초 GMT+09:00

Fei-Fei Li’s group is onto something big here! Proactive AI safety laws sound smart, but I wonder if lawmakers can keep up with tech’s pace. 🤔 Risky moves need bold rules!

0

0

2025년 4월 17일 오후 9시 14분 46초 GMT+09:00

2025년 4월 17일 오후 9시 14분 46초 GMT+09:00

O grupo de Fei-Fei Li sugerindo leis de segurança para IA antes mesmo de vermos os riscos? Parece proativo, mas também meio assustador! 🤔 Como se preparar para uma tempestade que pode nunca chegar. Ainda assim, melhor prevenir do que remediar, certo? Talvez devessem focar nos problemas atuais também? Só um pensamento! 😅

0

0

2025년 4월 17일 오전 1시 17분 56초 GMT+09:00

2025년 4월 17일 오전 1시 17분 56초 GMT+09:00

¿El grupo de Fei-Fei Li proponiendo leyes de seguridad para la IA antes de que veamos los riesgos? Suena proactivo pero también un poco aterrador! 🤔 Como prepararse para una tormenta que tal vez nunca llegue. Sin embargo, más vale prevenir que lamentar, ¿verdad? Tal vez deberían enfocarse también en los problemas actuales? Solo es un pensamiento! 😅

0

0

2025년 4월 16일 오후 1시 13분 53초 GMT+09:00

2025년 4월 16일 오후 1시 13분 53초 GMT+09:00

El grupo de Fei-Fei Li está realmente empujando por leyes de seguridad de IA proactivas, lo cual es genial. Pero, hombre, ¿ese informe de 41 páginas? Un poco difícil de digerir, ¿no crees? Aún así, es importante considerar los riesgos de IA no vistos. ¿Quizás podrían haberlo hecho un poco más conciso? 🤓📚

0

0

2025년 4월 16일 오전 8시 1분 1초 GMT+09:00

2025년 4월 16일 오전 8시 1분 1초 GMT+09:00

Die Gruppe von Fei-Fei Li setzt sich wirklich für proaktive KI-Sicherheitsgesetze ein, das ist toll. Aber Mann, dieser 41-seitige Bericht? Ein bisschen viel zum Verdauen, findest du nicht? Trotzdem ist es wichtig, ungesehene KI-Risiken zu berücksichtigen. Vielleicht hätten sie es etwas kürzer fassen können? 🤓📚

0

0