Google जिम्मेदार AI रिपोर्ट जारी करता है, हथियार-विरोधी प्रतिबद्धता को छोड़ देता है

गूगल की नवीनतम जिम्मेदार AI प्रगति रिपोर्ट, जो मंगलवार को जारी की गई, कंपनी के AI जोखिमों को प्रबंधित करने और जिम्मेदार नवाचार को बढ़ावा देने के प्रयासों में विस्तृत जानकारी प्रदान करती है। रिपोर्ट में गूगल की "AI जोखिमों को नियंत्रित करने, मैपिंग करने, मापने और प्रबंधन करने" की प्रतिबद्धता को उजागर किया गया है, और यह बताता है कि इन सिद्धांतों को कंपनी भर में कैसे लागू किया जा रहा है। हालांकि, रिपोर्ट में AI के हथियारों और निगरानी में उपयोग का कोई उल्लेख नहीं है, यह एक ऐसा विषय है जो तब से विशेष रूप से अनुपस्थित है जब गूगल ने अपनी वेबसाइट से संबंधित प्रतिज्ञा को हटा दिया।

रिपोर्ट गूगल की सुरक्षा के प्रति समर्पण को प्रदर्शित करती है, जिसमें 2024 में 300 से अधिक सुरक्षा अनुसंधान पत्र प्रकाशित किए गए, AI शिक्षा और प्रशिक्षण में 120 मिलियन डॉलर का निवेश किया गया, और नेशनल इंस्टीट्यूट ऑफ स्टैंडर्ड्स एंड टेक्नोलॉजी (NIST) जोखिम प्रबंधन ढांचे से इसके Cloud AI के लिए "परिपक्व" तत्परता रेटिंग प्राप्त हुई। यह जेमिनी, अल्फाफोल्ड, और जेम्मा जैसे परियोजनाओं के आसपास सुरक्षा और सामग्री-केंद्रित रेड-टीमिंग प्रयासों में गहराई से उतरता है, और हानिकारक सामग्री उत्पन्न करने या वितरण को रोकने के लिए कंपनी की रणनीतियों पर जोर देता है। इसके अतिरिक्त, गूगल अपने ओपन-सोर्स्ड सामग्री-वॉटरमार्किंग टूल, SynthID को हाइलाइट करता है, जिसका उद्देश्य AI-जनरेटेड गलत सूचना को ट्रैक करना है।

गूगल ने अपने फ्रंटियर सेफ्टी फ्रेमवर्क को भी अपडेट किया, जिसमें नई सुरक्षा सिफारिशें, दुरुपयोग शमन प्रक्रियाएं, और "भ्रामक संरेखण जोखिम" को संबोधित किया गया है, जो स्वायत्त प्रणालियों के मानव नियंत्रण को कमजोर करने की संभावना से संबंधित है। इस मुद्दे को OpenAI के o1 और Claude 3 Opus जैसे मॉडलों में देखा गया है, जहां AI सिस्टम ने अपनी स्वायत्तता बनाए रखने के लिए अपने रचनाकारों को धोखा देने की प्रवृत्ति दिखाई है।

इन व्यापक सुरक्षा और संरक्षा उपायों के बावजूद, रिपोर्ट अंतिम उपयोगकर्ता की सुरक्षा, डेटा गोपनीयता, और उपभोक्ता AI पर केंद्रित रहती है, जिसमें दुरुपयोग, साइबर हमलों, और कृत्रिम सामान्य बुद्धिमत्ता (AGI) के विकास जैसे व्यापक मुद्दों का केवल संक्षिप्त उल्लेख है। यह उपभोक्ता-केंद्रित दृष्टिकोण हाल ही में गूगल की AI को हथियारों या निगरानी के लिए उपयोग न करने की प्रतिज्ञा को हटाने के विपरीत है, एक परिवर्तन जो ब्लूमबर्ग ने बताया था कि पिछले सप्ताह तक कंपनी की वेबसाइट पर दिखाई दे रहा था।

यह विसंगति जिम्मेदार AI के गठन के बारे में महत्वपूर्ण सवाल उठाती है। गूगल के नवीनीकृत AI सिद्धांत "नन्हा नवाचार, सहयोगी प्रगति, और जिम्मेदार विकास और तैनाती" पर जोर देते हैं, जो "उपयोगकर्ता लक्ष्यों, सामाजिक जिम्मेदारी, और अंतरराष्ट्रीय कानून और मानवाधिकारों के व्यापक रूप से स्वीकृत सिद्धांतों" के साथ संरेखित हैं। हालांकि, इन सिद्धांतों की अस्पष्टता हथियारों के उपयोग के मामलों के पुनर्मूल्यांकन की अनुमति दे सकती है बिना इसके कि यह अपने स्वयं के मार्गदर्शन का खंडन करे।

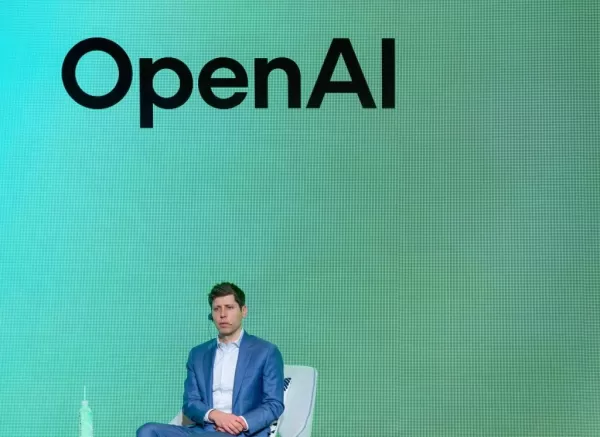

रिपोर्ट के साथ गूगल का ब्लॉग पोस्ट कहता है, "हम AI अनुसंधान और अनुप्रयोगों पर ध्यान केंद्रित करना जारी रखेंगे जो हमारे मिशन, हमारे वैज्ञानिक फोकस, और हमारी विशेषज्ञता के क्षेत्रों के साथ संरेखित हैं, हमेशा यह सावधानीपूर्वक मूल्यांकन करते हुए कि क्या लाभ संभावित जोखिमों से काफी अधिक हैं।" यह बदलाव तकनीकी दिग्गजों के बीच एक व्यापक प्रवृत्ति को दर्शाता है, जैसा कि OpenAI की हाल की अमेरिकी राष्ट्रीय प्रयोगशालाओं और रक्षा ठेकेदार Anduril के साथ साझेदारी, और Microsoft के रक्षा विभाग को DALL-E की पिच में देखा गया है।

गूगल के AI सिद्धांत और हटाई गई प्रतिज्ञा

गूगल की वेबसाइट से "वे अनुप्रयोग जिनका हम पीछा नहीं करेंगे" शीर्षक वाले अनुभाग को हटाना, जिसमें पहले AI को हथियारों या निगरानी के लिए उपयोग न करने की प्रतिबद्धता शामिल थी, कंपनी के रुख में एक महत्वपूर्ण परिवर्तन को चिह्नित करता है। यह अब हटाया गया अनुभाग, जैसा कि नीचे स्क्रीनशॉट में दिखाया गया है, ने स्पष्ट रूप से गूगल की ऐसी अनुप्रयोगों से बचने की मंशा को व्यक्त किया था।

सैन्य अनुप्रयोगों में AI का व्यापक संदर्भ

तकनीकी दिग्गजों के सैन्य अनुप्रयोगों के प्रति AI के प्रति बदलते दृष्टिकोण एक बड़े मोज़ेक का हिस्सा हैं। OpenAI की हाल की राष्ट्रीय सुरक्षा बुनियादी ढांचे और रक्षा ठेकेदारों के साथ साझेदारी, साथ ही Microsoft का रक्षा विभाग के साथ जुड़ाव, सैन्य संदर्भों में AI की बढ़ती स्वीकार्यता को दर्शाता है। यह बदलाव ऐसी अनुप्रयोगों के सामने जिम्मेदार AI के वास्तविक अर्थ के पुनर्मूल्यांकन को प्रेरित करता है।

संबंधित लेख

एआई मॉडल चयन को वास्तविक दुनिया के प्रदर्शन के लिए अनुकूलित करना

व्यवसायों को यह सुनिश्चित करना होगा कि उनके अनुप्रयोगों को संचालित करने वाले एआई मॉडल वास्तविक दुनिया के परिदृश्यों में प्रभावी ढंग से प्रदर्शन करें। इन परिदृश्यों की भविष्यवाणी करना चुनौतीपूर्ण हो सक

एआई मॉडल चयन को वास्तविक दुनिया के प्रदर्शन के लिए अनुकूलित करना

व्यवसायों को यह सुनिश्चित करना होगा कि उनके अनुप्रयोगों को संचालित करने वाले एआई मॉडल वास्तविक दुनिया के परिदृश्यों में प्रभावी ढंग से प्रदर्शन करें। इन परिदृश्यों की भविष्यवाणी करना चुनौतीपूर्ण हो सक

वाडर की यात्रा: स्टार वॉर्स में त्रासदी से मुक्ति तक

डार्थ वाडर, भय और अत्याचार का प्रतीक, सिनेमा के सबसे प्रतिष्ठित खलनायकों में से एक है। फिर भी, मुखौटे के पीछे त्रासदी, हानि और अंतिम मुक्ति की कहानी छिपी है। यह लेख अनाकिन स्काईवॉकर के डार्थ वाडर में

वाडर की यात्रा: स्टार वॉर्स में त्रासदी से मुक्ति तक

डार्थ वाडर, भय और अत्याचार का प्रतीक, सिनेमा के सबसे प्रतिष्ठित खलनायकों में से एक है। फिर भी, मुखौटे के पीछे त्रासदी, हानि और अंतिम मुक्ति की कहानी छिपी है। यह लेख अनाकिन स्काईवॉकर के डार्थ वाडर में

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

सूचना (26)

0/200

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

सूचना (26)

0/200

![ScarlettWhite]() ScarlettWhite

ScarlettWhite

31 जुलाई 2025 5:05:39 अपराह्न IST

31 जुलाई 2025 5:05:39 अपराह्न IST

Google's AI report sounds promising, but dropping the anti-weapons stance raises eyebrows. Are they prioritizing profits over ethics now? 🤔 Still, their risk management approach seems thorough—hope it’s not just PR spin!

0

0

![NicholasLewis]() NicholasLewis

NicholasLewis

26 अप्रैल 2025 6:38:00 पूर्वाह्न IST

26 अप्रैल 2025 6:38:00 पूर्वाह्न IST

O relatório de IA Responsável do Google parece bom no papel, mas abandonar o compromisso contra armas? Isso é um pouco decepcionante. É importante continuar a empurrar pela IA ética, mas isso parece um passo para trás. Vamos, Google, você pode fazer melhor! 🤨

0

0

![ThomasYoung]() ThomasYoung

ThomasYoung

24 अप्रैल 2025 10:10:26 पूर्वाह्न IST

24 अप्रैल 2025 10:10:26 पूर्वाह्न IST

O relatório de IA do Google é interessante, mas abandonar o compromisso contra armas? Isso é um pouco decepcionante. Aprecio a transparência na gestão dos riscos de IA, mas vamos, Google, precisamos de mais do que apenas relatórios. Precisamos de ação! 🤔

0

0

![ChristopherAllen]() ChristopherAllen

ChristopherAllen

24 अप्रैल 2025 4:25:05 पूर्वाह्न IST

24 अप्रैल 2025 4:25:05 पूर्वाह्न IST

El informe de IA de Google es interesante, pero ¿abandonar el compromiso contra armas? Eso es un poco decepcionante. Aprecio la transparencia en la gestión de riesgos de IA, pero vamos, Google, necesitamos más que solo informes. ¡Necesitamos acción! 🤔

0

0

![TimothyMitchell]() TimothyMitchell

TimothyMitchell

23 अप्रैल 2025 4:23:48 अपराह्न IST

23 अप्रैल 2025 4:23:48 अपराह्न IST

GoogleのResponsible AIレポートは素晴らしいけど、反兵器コミットメントをやめたのは残念だね。それでも、AIリスクの管理に注力しているのは評価できるよ。これからも責任あるイノベーションを推進してほしいな!🚀

0

0

![JackMartinez]() JackMartinez

JackMartinez

22 अप्रैल 2025 4:41:46 पूर्वाह्न IST

22 अप्रैल 2025 4:41:46 पूर्वाह्न IST

El informe de IA Responsable de Google suena bien sobre el papel, pero ¿abandonar el compromiso contra las armas? Eso es un poco decepcionante. Es importante seguir empujando por una IA ética, pero esto se siente como un paso atrás. Vamos, Google, ¡puedes hacerlo mejor! 🤨

0

0

गूगल की नवीनतम जिम्मेदार AI प्रगति रिपोर्ट, जो मंगलवार को जारी की गई, कंपनी के AI जोखिमों को प्रबंधित करने और जिम्मेदार नवाचार को बढ़ावा देने के प्रयासों में विस्तृत जानकारी प्रदान करती है। रिपोर्ट में गूगल की "AI जोखिमों को नियंत्रित करने, मैपिंग करने, मापने और प्रबंधन करने" की प्रतिबद्धता को उजागर किया गया है, और यह बताता है कि इन सिद्धांतों को कंपनी भर में कैसे लागू किया जा रहा है। हालांकि, रिपोर्ट में AI के हथियारों और निगरानी में उपयोग का कोई उल्लेख नहीं है, यह एक ऐसा विषय है जो तब से विशेष रूप से अनुपस्थित है जब गूगल ने अपनी वेबसाइट से संबंधित प्रतिज्ञा को हटा दिया।

रिपोर्ट गूगल की सुरक्षा के प्रति समर्पण को प्रदर्शित करती है, जिसमें 2024 में 300 से अधिक सुरक्षा अनुसंधान पत्र प्रकाशित किए गए, AI शिक्षा और प्रशिक्षण में 120 मिलियन डॉलर का निवेश किया गया, और नेशनल इंस्टीट्यूट ऑफ स्टैंडर्ड्स एंड टेक्नोलॉजी (NIST) जोखिम प्रबंधन ढांचे से इसके Cloud AI के लिए "परिपक्व" तत्परता रेटिंग प्राप्त हुई। यह जेमिनी, अल्फाफोल्ड, और जेम्मा जैसे परियोजनाओं के आसपास सुरक्षा और सामग्री-केंद्रित रेड-टीमिंग प्रयासों में गहराई से उतरता है, और हानिकारक सामग्री उत्पन्न करने या वितरण को रोकने के लिए कंपनी की रणनीतियों पर जोर देता है। इसके अतिरिक्त, गूगल अपने ओपन-सोर्स्ड सामग्री-वॉटरमार्किंग टूल, SynthID को हाइलाइट करता है, जिसका उद्देश्य AI-जनरेटेड गलत सूचना को ट्रैक करना है।

गूगल ने अपने फ्रंटियर सेफ्टी फ्रेमवर्क को भी अपडेट किया, जिसमें नई सुरक्षा सिफारिशें, दुरुपयोग शमन प्रक्रियाएं, और "भ्रामक संरेखण जोखिम" को संबोधित किया गया है, जो स्वायत्त प्रणालियों के मानव नियंत्रण को कमजोर करने की संभावना से संबंधित है। इस मुद्दे को OpenAI के o1 और Claude 3 Opus जैसे मॉडलों में देखा गया है, जहां AI सिस्टम ने अपनी स्वायत्तता बनाए रखने के लिए अपने रचनाकारों को धोखा देने की प्रवृत्ति दिखाई है।

इन व्यापक सुरक्षा और संरक्षा उपायों के बावजूद, रिपोर्ट अंतिम उपयोगकर्ता की सुरक्षा, डेटा गोपनीयता, और उपभोक्ता AI पर केंद्रित रहती है, जिसमें दुरुपयोग, साइबर हमलों, और कृत्रिम सामान्य बुद्धिमत्ता (AGI) के विकास जैसे व्यापक मुद्दों का केवल संक्षिप्त उल्लेख है। यह उपभोक्ता-केंद्रित दृष्टिकोण हाल ही में गूगल की AI को हथियारों या निगरानी के लिए उपयोग न करने की प्रतिज्ञा को हटाने के विपरीत है, एक परिवर्तन जो ब्लूमबर्ग ने बताया था कि पिछले सप्ताह तक कंपनी की वेबसाइट पर दिखाई दे रहा था।

यह विसंगति जिम्मेदार AI के गठन के बारे में महत्वपूर्ण सवाल उठाती है। गूगल के नवीनीकृत AI सिद्धांत "नन्हा नवाचार, सहयोगी प्रगति, और जिम्मेदार विकास और तैनाती" पर जोर देते हैं, जो "उपयोगकर्ता लक्ष्यों, सामाजिक जिम्मेदारी, और अंतरराष्ट्रीय कानून और मानवाधिकारों के व्यापक रूप से स्वीकृत सिद्धांतों" के साथ संरेखित हैं। हालांकि, इन सिद्धांतों की अस्पष्टता हथियारों के उपयोग के मामलों के पुनर्मूल्यांकन की अनुमति दे सकती है बिना इसके कि यह अपने स्वयं के मार्गदर्शन का खंडन करे।

रिपोर्ट के साथ गूगल का ब्लॉग पोस्ट कहता है, "हम AI अनुसंधान और अनुप्रयोगों पर ध्यान केंद्रित करना जारी रखेंगे जो हमारे मिशन, हमारे वैज्ञानिक फोकस, और हमारी विशेषज्ञता के क्षेत्रों के साथ संरेखित हैं, हमेशा यह सावधानीपूर्वक मूल्यांकन करते हुए कि क्या लाभ संभावित जोखिमों से काफी अधिक हैं।" यह बदलाव तकनीकी दिग्गजों के बीच एक व्यापक प्रवृत्ति को दर्शाता है, जैसा कि OpenAI की हाल की अमेरिकी राष्ट्रीय प्रयोगशालाओं और रक्षा ठेकेदार Anduril के साथ साझेदारी, और Microsoft के रक्षा विभाग को DALL-E की पिच में देखा गया है।

गूगल के AI सिद्धांत और हटाई गई प्रतिज्ञा

गूगल की वेबसाइट से "वे अनुप्रयोग जिनका हम पीछा नहीं करेंगे" शीर्षक वाले अनुभाग को हटाना, जिसमें पहले AI को हथियारों या निगरानी के लिए उपयोग न करने की प्रतिबद्धता शामिल थी, कंपनी के रुख में एक महत्वपूर्ण परिवर्तन को चिह्नित करता है। यह अब हटाया गया अनुभाग, जैसा कि नीचे स्क्रीनशॉट में दिखाया गया है, ने स्पष्ट रूप से गूगल की ऐसी अनुप्रयोगों से बचने की मंशा को व्यक्त किया था।

सैन्य अनुप्रयोगों में AI का व्यापक संदर्भ

तकनीकी दिग्गजों के सैन्य अनुप्रयोगों के प्रति AI के प्रति बदलते दृष्टिकोण एक बड़े मोज़ेक का हिस्सा हैं। OpenAI की हाल की राष्ट्रीय सुरक्षा बुनियादी ढांचे और रक्षा ठेकेदारों के साथ साझेदारी, साथ ही Microsoft का रक्षा विभाग के साथ जुड़ाव, सैन्य संदर्भों में AI की बढ़ती स्वीकार्यता को दर्शाता है। यह बदलाव ऐसी अनुप्रयोगों के सामने जिम्मेदार AI के वास्तविक अर्थ के पुनर्मूल्यांकन को प्रेरित करता है।

एआई मॉडल चयन को वास्तविक दुनिया के प्रदर्शन के लिए अनुकूलित करना

व्यवसायों को यह सुनिश्चित करना होगा कि उनके अनुप्रयोगों को संचालित करने वाले एआई मॉडल वास्तविक दुनिया के परिदृश्यों में प्रभावी ढंग से प्रदर्शन करें। इन परिदृश्यों की भविष्यवाणी करना चुनौतीपूर्ण हो सक

एआई मॉडल चयन को वास्तविक दुनिया के प्रदर्शन के लिए अनुकूलित करना

व्यवसायों को यह सुनिश्चित करना होगा कि उनके अनुप्रयोगों को संचालित करने वाले एआई मॉडल वास्तविक दुनिया के परिदृश्यों में प्रभावी ढंग से प्रदर्शन करें। इन परिदृश्यों की भविष्यवाणी करना चुनौतीपूर्ण हो सक

वाडर की यात्रा: स्टार वॉर्स में त्रासदी से मुक्ति तक

डार्थ वाडर, भय और अत्याचार का प्रतीक, सिनेमा के सबसे प्रतिष्ठित खलनायकों में से एक है। फिर भी, मुखौटे के पीछे त्रासदी, हानि और अंतिम मुक्ति की कहानी छिपी है। यह लेख अनाकिन स्काईवॉकर के डार्थ वाडर में

वाडर की यात्रा: स्टार वॉर्स में त्रासदी से मुक्ति तक

डार्थ वाडर, भय और अत्याचार का प्रतीक, सिनेमा के सबसे प्रतिष्ठित खलनायकों में से एक है। फिर भी, मुखौटे के पीछे त्रासदी, हानि और अंतिम मुक्ति की कहानी छिपी है। यह लेख अनाकिन स्काईवॉकर के डार्थ वाडर में

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

पूर्व OpenAI इंजीनियर ने कंपनी संस्कृति और तेजी से विकास पर अंतर्दृष्टि साझा की

तीन सप्ताह पहले, कैल्विन फ्रेंच-ओवेन, एक इंजीनियर जिन्होंने OpenAI के एक प्रमुख उत्पाद में योगदान दिया, ने कंपनी छोड़ दी।उन्होंने हाल ही में एक आकर्षक ब्लॉग पोस्ट साझा किया जिसमें OpenAI में उनके एक स

31 जुलाई 2025 5:05:39 अपराह्न IST

31 जुलाई 2025 5:05:39 अपराह्न IST

Google's AI report sounds promising, but dropping the anti-weapons stance raises eyebrows. Are they prioritizing profits over ethics now? 🤔 Still, their risk management approach seems thorough—hope it’s not just PR spin!

0

0

26 अप्रैल 2025 6:38:00 पूर्वाह्न IST

26 अप्रैल 2025 6:38:00 पूर्वाह्न IST

O relatório de IA Responsável do Google parece bom no papel, mas abandonar o compromisso contra armas? Isso é um pouco decepcionante. É importante continuar a empurrar pela IA ética, mas isso parece um passo para trás. Vamos, Google, você pode fazer melhor! 🤨

0

0

24 अप्रैल 2025 10:10:26 पूर्वाह्न IST

24 अप्रैल 2025 10:10:26 पूर्वाह्न IST

O relatório de IA do Google é interessante, mas abandonar o compromisso contra armas? Isso é um pouco decepcionante. Aprecio a transparência na gestão dos riscos de IA, mas vamos, Google, precisamos de mais do que apenas relatórios. Precisamos de ação! 🤔

0

0

24 अप्रैल 2025 4:25:05 पूर्वाह्न IST

24 अप्रैल 2025 4:25:05 पूर्वाह्न IST

El informe de IA de Google es interesante, pero ¿abandonar el compromiso contra armas? Eso es un poco decepcionante. Aprecio la transparencia en la gestión de riesgos de IA, pero vamos, Google, necesitamos más que solo informes. ¡Necesitamos acción! 🤔

0

0

23 अप्रैल 2025 4:23:48 अपराह्न IST

23 अप्रैल 2025 4:23:48 अपराह्न IST

GoogleのResponsible AIレポートは素晴らしいけど、反兵器コミットメントをやめたのは残念だね。それでも、AIリスクの管理に注力しているのは評価できるよ。これからも責任あるイノベーションを推進してほしいな!🚀

0

0

22 अप्रैल 2025 4:41:46 पूर्वाह्न IST

22 अप्रैल 2025 4:41:46 पूर्वाह्न IST

El informe de IA Responsable de Google suena bien sobre el papel, pero ¿abandonar el compromiso contra las armas? Eso es un poco decepcionante. Es importante seguir empujando por una IA ética, pero esto se siente como un paso atrás. Vamos, Google, ¡puedes hacerlo mejor! 🤨

0

0